十一、填充和步幅、多通道输入输出、池化层作用(3.7学习笔记2)

填充和步幅

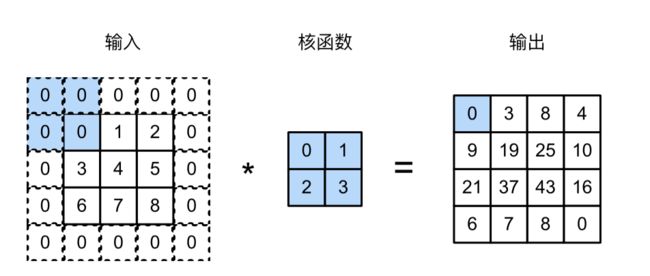

填充解决原始图像的边界丢失了许多有用信息的问题。

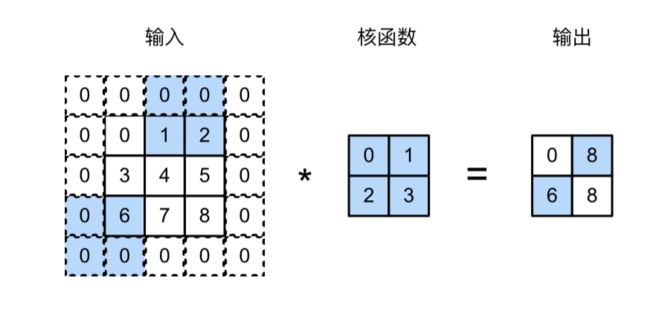

步幅则可以快速大幅降低图像宽度和高度。

填充

(其中像素可以理解为数据)

在应用多层卷积时,常常丢失边缘像素。由于通常使用小卷积核,因此对于任何单个卷积,我们可能只会丢失几个像素。但随着应用许多连续卷积层,累积丢失的像素数就多了。

解决这个问题的简单方法即为填充(padding):在输入图像的边界填充元素(通常填充元素是0)。

而根据输入和核函数计算输出形状很容易了就。

此外,卷积神经网络中卷积核的高度和宽度通常为奇数,例如1、3、5或7。选择奇数的好处是,保持空间维度的同时,可以在顶部和底部填充相同数量的行,在左侧和右侧填充相同数量的列。

此外,使用奇数的核大小和填充大小也提供了书写上的便利。对于任何二维张量X,当满足:

卷积核的大小是奇数;

所有边的填充行数和列数相同;

输出与输入具有相同高度和宽度则可以得出:输出Y[i, j]是通过以输入X[i, j]为中心,与卷积核进行互相关计算得到的。

比如,在下面的例子中,我们创建一个高度和宽度为3的二维卷积层,并(在所有侧边填充1个像素)。给定高度和宽度为8的输入,则输出的高度和宽度也是8。

import torch

from torch import nn

# 为了方便起见,我们定义了一个计算卷积层的函数。

# 此函数初始化卷积层权重,并对输入和输出提高和缩减相应的维数

def comp_conv2d(conv2d, X):

# 这里的(1,1)表示批量大小和通道数都是1

X = X.reshape((1, 1) + X.shape)

Y = conv2d(X)

# 省略前两个维度:批量大小和通道

return Y.reshape(Y.shape[2:])

# 请注意,这里每边都填充了1行或1列,因此总共添加了2行或2列

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1)

X = torch.rand(size=(8, 8))

comp_conv2d(conv2d, X).shapetorch.Size([8, 8])

当卷积核的高度和宽度不同时,我们可以[填充不同的高度和宽度],使输出和输入具有相同的高度和宽度。在如下示例中,我们使用高度为5,宽度为3的卷积核,高度和宽度两边的填充分别为2和1。

conv2d = nn.Conv2d(1, 1, kernel_size=(5, 3), padding=(2, 1))

comp_conv2d(conv2d, X).shapetorch.Size([8, 8])

步幅

可以看到,为了计算输出中第一列的第二个元素和第一行的第二个元素,卷积窗口分别向下滑动三行和向右滑动两列。但是,当卷积窗口继续向右滑动两列时,没有输出,因为输入元素无法填充窗口(除非我们添加另一列填充)。

下面,我们[将高度和宽度的步幅设置为2],从而将输入的高度和宽度减半。

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1, stride=2)

comp_conv2d(conv2d, X).shapetorch.Size([4, 4])

conv2d = nn.Conv2d(1, 1, kernel_size=(3, 5), padding=(0, 1), stride=(3, 4))

comp_conv2d(conv2d, X).shapetorch.Size([2, 2])

小结

填充可以增加输出的高度和宽度。这常用来使输出与输入具有相同的高和宽。

填充和步幅可用于有效地调整数据的维度。

多通道输入输出

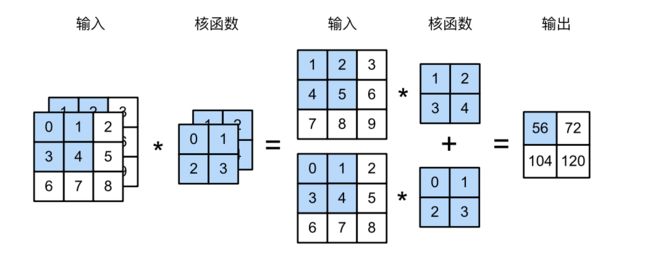

彩色图像具有标准的RGB通道来代表红、绿和蓝。所以经常会遇到多通道输入情况

多输入通道

当输入包含多个通道时,需要构造一个与输入数据具有相同输入通道数的卷积核,以便与输入数据进行互相关运算。

多输出通道

增加输出通道的维数,通过减少空间分辨率以获得更大的通道深度。

直观地说,我们可以将每个通道看作对不同特征的响应。而现实可能更为复杂一些,因为每个通道不是独立学习的,而是为了共同使用而优化的。因此,多输出通道并不仅是学习多个单通道的检测器。

如下所示,我们实现一个[计算多个通道的输出的互相关函数]。

1*1卷积层

小结

多输入多输出通道可以用来扩展卷积层的模型。

1*1卷积层通常用于调整网络层的通道数量和控制模型复杂性。

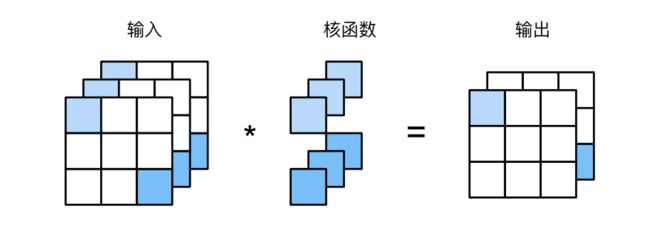

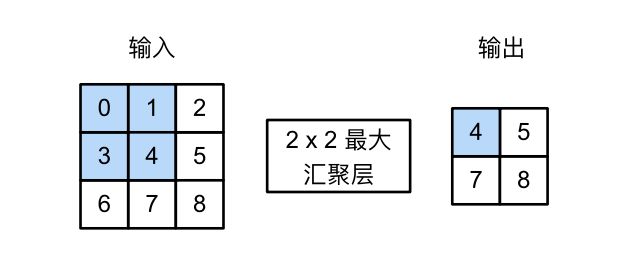

池化层(也叫汇聚层)

汇聚层

:label:sec_pooling

通常当处理图像时,希望逐渐降低隐藏表示的空间分辨率、聚集信息,这样随着我们在神经网络中层叠的上升,每个神经元对其敏感的感受野(输入)就越大。

而机器学习任务通常会跟全局图像的问题有关(例如,“图像是否包含一只猫呢?”),所以我们最后一层的神经元应该对整个输入的全局敏感。通过逐渐聚合信息,生成越来越粗糙的映射,最终实现学习全局表示的目标,同时将卷积图层的所有优势保留在中间层。

池化层,具有双重目的:降低卷积层对位置的敏感性,同时降低对空间降采样表示的敏感性。(学习的是样子而不是位置)