基于Centos7安装k8s集群

参考文章:部署k8s集群(k8s集群搭建详细实践版)

k8s Github地址: https://github.com/kubernetes/kubernetes

k8s组件简介: k8s集群概念组件简介

1、部署k8s的两种方式:

目前生产部署Kubernetes集群主要有两种方式:

kubeadm

Kubeadm是一个K8s部署工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

二进制包

从github下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。

本实验采用kubeadm的方式搭建集群。

2、环境准备

2.1 服务器要求:

建议最小硬件配置:2核CPU、2G内存、20G硬盘

服务器最好可以访问外网,会有从网上拉取镜像需求,如果服务器不能上网,需要提前下载对应镜像并导入节点

2.2 软件环境:

操作系统:centos7.9_x64(mini)

Docker:20-ce

K8s:1.23

2.3 服务器规划:(本实验采用虚拟机)

k8s-master:192.168.178.171

k8s-node1:192.168.178.172

k8s-node2:192.168.178.173

3、初始化配置

3.1、安装环境准备:

下面的操作需要在所有的节点上执行。

# 1. 关闭防火墙 (全部节点)

$. systemctl stop firewalld

$. systemctl disable firewalld

$. systemctl status firewalld

# 2. 关闭selinux (全部节点)

$. sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

$. setenforce 0 # 临时

$. sestatus -v # 查看状态

# 3. 关闭 swap (全部节点)

$. swapoff -a # 临时

$. sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久

# 4. 根据规划设置主机名

# 更改四台机器的名称,分别是:k8s-master、k8s-node1、k8s-node2

$. hostnamectl set-hostname

$. hostname k8s-node1

$. bash

# 5.集群每个节点添加 hosts

$. cat >> /etc/hosts << EOF

192.168.178.171 k8s-master

192.168.178.172 k8s-node1

192.168.178.173 k8s-node2

EOF

# 6. 修改内核参数, 将桥接的IPv4流量传递到iptables的链

$. cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

# 生效

$. sysctl --system

# 7. 时间同步 (全部节点)

$. yum install ntpdate -y

$. ntpdate time.windows.com

# 或者采用 chrony

$. yum install chrony -y

$. systemctl start chronyd

$. systemctl enable chronyd

$. chronyc sources

# 注意:虚拟机不管关机还是挂起,每次重新操作都需要更新时间进行同步。 3.2、安装容器运行时

容器运行时可以安装 Docker 或 CRI-O.

3.2.1 安装CRI-O 容器运行时【所有节点】

3.2.1.1 准备

$. VERSION=1.23

$. sudo curl -L -o /etc/yum.repos.d/devel:kubic:libcontainers:stable.repo https://download.opensuse.org/repositories/devel:kubic:libcontainers:stable/CentOS_7/devel:kubic:libcontainers:stable.repo

$. sudo curl -L -o /etc/yum.repos.d/devel:kubic:libcontainers:stable:cri-o:${VERSION}.repo https://download.opensuse.org/repositories/devel:kubic:libcontainers:stable:cri-o:${VERSION}/CentOS_7/devel:kubic:libcontainers:stable:cri-o:${VERSION}.repo3.2.1.2 安装

$. yum update -y

$. yum install cri-o cri-tools -y注意:从 1.24.0 开始, cri-o 包不再依赖 containernetworking-plugins 包,已删除此依赖项,允许用户在不删除文件的情况下,就能安装自己的 CNI 插件。

如果想要使用以前提供的那些 CNI 插件,还应运行:

3.2.1.3 查看cri-o版本

[root@node1 systemd]# rpm -qi cri-o

Name : cri-o

Epoch : 0

Version : 1.22.5

Release : 2.2.el7

Architecture: x86_64

Install Date: 2022年07月13日 星期三 01时36分47秒

Group : Unspecified

Size : 236845729

License : ASL 2.0

Signature : RSA/SHA256, 2022年07月10日 星期日 12时53分28秒, Key ID 4d64390375060aa4

Source RPM : cri-o-1.22.5-2.2.el7.src.rpm

Build Date : 2022年07月10日 星期日 12时53分00秒

Build Host : sheep87

Relocations : (not relocatable)

Vendor : obs://build.opensuse.org/devel:kubic

URL : https://github.com/cri-o/cri-o

Summary : Open Container Initiative-based implementation of Kubernetes Container Runtime Interface

Description :

Open Container Initiative-based implementation of Kubernetes Container Runtime

Interface.3.2.1.4 设置开机启动, 并启动cri-o

$. systemctl enable crio --now 3.2.1.5 查看cri-o状态

[root@node1 systemd]# systemctl status crio

● crio.service - Container Runtime Interface for OCI (CRI-O)

Loaded: loaded (/usr/lib/systemd/system/crio.service; enabled; vendor preset: disabled)

Active: active (running) since 三 2022-07-13 01:41:06 CST; 16h ago

Docs: https://github.com/cri-o/cri-o

Main PID: 24127 (crio)

Tasks: 15

Memory: 13.7M

CGroup: /system.slice/crio.service

└─24127 /usr/bin/crio三台机都安装cri-o并启动。

CRI-O常用命令参考: CRI-O常用命令详解

3.2.2 安装docker 容器运行时【所有节点】

如果安装了 CRI-O, 则不需要再安装 Docker 了。

3.2.2.1 docker 容器运行时安装

# 1. 设置稳定的安装源(存储库)

$. yum install yum-utils -y

$. yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# 2. 导入证书

$. rpm --import http://mirror.centos.org/centos/RPM-GPG-KEY-CentOS-7

# 3. 安装

$. yum list docker-ce --showduplicates | sort -r

$. yum install -y docker-ce-20.10.10 docker-ce-cli-20.10.10 containerd.io

# 4. 启动和验证

$. systemctl enable docker --now

$. docker version

# or

$. docker -v

$. docker run hello-world3.2.2.2 配置镜像下载加速器:

$. vi /etc/docker/daemon.json

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

$. systemctl restart docker

$. docker info #查看docker信息,进行确认3.3 安装kubeadm、kubelet、kubectl【所有节点】

Kubelet:运行在cluster所有节点上,负责启动POD和容器;

Kubeadm:用于初始化cluster的一个工具;

Kubectl:kubectl是kubenetes命令行工具,通过kubectl可以部署和管理应用,查看各种资源,创建,删除和更新组件;

3.3.1 添加阿里云软件源(所有节点)

$. cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF3.3.2 yum安装kubeadm、kubelet、kubectl组件(所有节点)

$. yum list kubelet --showduplicates | sort -r

$. yum list kubeadm --showduplicates | sort -r

$. yum list kubectl --showduplicates | sort -r

$. yum install -y kubelet-1.23.16 kubeadm-1.23.16 kubectl-1.23.16

$. systemctl enable kubelet --now

$. systemctl status kubelet

# 如果 kubelet 运行失败, 可用下面命令查看日志

$. journalctl -u kubelet --no-pager

# 配置kubelet的cgroup

$. vim /etc/sysconfig/kubelet

# 添加下面的配置

KUBELET_CGROUP_ARGS="--cgroup-driver=systemd"

KUBE_PROXY_MODE="ipvs"4、部署k8s-master【master执行】

4.1、初始化k8s

kubeadm部署(需要等上一会)

$. kubeadm init \

--apiserver-advertise-address=192.168.178.171 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.23.16 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16 \

--ignore-preflight-errors=all

# 初始化之后,会输出一个join命令,先复制出来,node节点加入master会使用。:

kubeadm join 10.122.32.2:6443 --token 206c1m.4rs3nl232gme92mu \

--discovery-token-ca-cert-hash sha256:c5ecb1edd7aaf5253e0002e4cb396fd83d3455012c216a4ef30c4ffd92d289dc--apiserver-advertise-address 集群master地址, 使用的是master和node间能互相ping通的ip

--image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址

--kubernetes-version K8s版本,与上面安装的一致

--service-cidr 集群内部虚拟网络,Pod统一访问入口

--pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

4.2、拷贝k8s认证文件

$. mkdir -p $HOME/.kube

$. sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

$. sudo chown $(id -u):$(id -g) $HOME/.kube/config4.3 查看工作节点:

$. kubectl get nodes注:以上,安装master节点完毕。可以使用kubectl get nodes查看一下,由于网络插件还没有部署,此时master处于NotReady状态。

5、配置k8s的node节点【node节点操作】

5.1、node节点加入集群

执行在kubeadm init输出的kubeadm join命令, 在node节点运行刚才记录的最后一行:

$. kubeadm join 10.122.32.2:6443 --token 206c1m.4rs3nl232gme92mu \

--discovery-token-ca-cert-hash sha256:c5ecb1edd7aaf5253e0002e4cb396fd83d3455012c216a4ef30c4ffd92d289dc

# 如果忘记token, 查看token

$. kubeadm token list

# 默认token有效期为24小时,当过期之后,该token会过期,

# 需要重新创建token,可以直接使用命令快捷生成:

$. kubeadm token create --print-join-command

# 查看discovery-token-ca-cert-hash

$. openssl x509 -pubkey \

-in /etc/kubernetes/pki/ca.crt \

| openssl rsa -pubin -outform der 2>/dev/null \

| openssl dgst -sha256 -hex | sed 's/^.* //'

# 加入成功后,在master节点查看到加入的Node节点

$. kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master Ready control-plane,master 15m v1.23.16

k8s-node1 Ready 4m14s v1.23.16

k8s-node2 Ready 117s v1.23.16

k8s-node3 Ready 2m1s v1.23.16 6、部署容器网络

6.1 安装Calico 网络(master执行)

Calico是一个纯三层的数据中心网络方案,是目前Kubernetes主流的网络方案。

下载YAML:

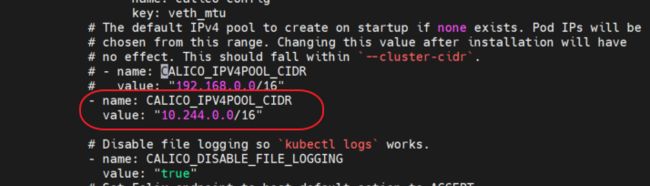

$. wget https://docs.projectcalico.org/v3.14/manifests/calico.yaml注意:

下载完后还需要修改里面定义Pod网络(CALICO_IPV4POOL_CIDR),与前面kubeadm init的 --pod-network-cidr指定的一样。

修改完后文件后,进行部署:

$. kubectl apply -f calico.yaml

# 执行结束要等上一会才全部running

$. kubectl get pods -n kube-system 待Calico Pod都Running后,节点也会准备就绪。

注:以后所有yaml文件都只在Master节点执行。

安装目录:/etc/kubernetes/

组件配置文件目录:/etc/kubernetes/manifests/

6.2 安装flannel(master机器)(这里不做部署, 仅做参考)

创建网络flannel

# 1. 下载官方fannel配置文件

$. kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 2. 安装fannel

$. kubectl apply -f kube-flannel.yml

# 查看组件运行,发现flannel已经在运行

$. kubectl get pods -n kube-system

# 查看node是否ready

$. kubectl get nodes

# 节点监控

# 查看pod资源,类似于docker中的容器,确保返回的信息都是running

# “-n kube-system”:是k8s的名称空间

$. kubectl get pod -n kube-system

$. watch kubectl get pod -n kube-system -o wide7、部署Dashboard

Dashboard是官方提供的一个UI,可用于基本管理K8s资源。

7.1 YAML下载地址:

$. wget https://raw.githubusercontent.com/kubernetes/dashboard/v2.4.0/aio/deploy/recommended.yaml7.2 配置Dashboard

默认Dashboard只能集群内部访问,修改Service为NodePort类型,暴露到外部:

$. vi recommended.yaml

...

kind: Service

apiVersion: v1

metadata:

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kubernetes-dashboard

spec:

ports:

- port: 443

targetPort: 8443

nodePort: 30001

selector:

k8s-app: kubernetes-dashboard

type: NodePort # 修改Service为NodePort类型

...$. kubectl apply -f recommended.yaml

$. kubectl get pods -n kubernetes-dashboard7.3 访问 Dashboard

访问地址:https://NodeIP:30001

7.4 Dashboard账户管理

创建service account并绑定默认cluster-admin管理员集群角色:

# 1.创建用户

$. kubectl create serviceaccount dashboard-admin -n kube-system

# 2.用户授权

$. kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

# 3.获取用户Token

$. kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')7.5 登录Dashboard

使用输出的token登录Dashboard。

8、使用kubectl命令行进行服务管理

8.1 创建demo yaml文件

编写文件a.yaml

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: my-app

spec:

replicas: 2

template:

metadata:

labels:

app: my-app

spec:

containers:

- name: my-app

image: registry.alauda.cn/yubang/paas_base_test

ports:

- containerPort: 80

command: ["/bin/bash", "/var/start.sh"]

resources:

limits:

cpu: 0.5

memory: 64Mi 编写文件b.yaml

apiVersion: v1

kind: Service

metadata:

name: my-app-svc

labels:

app: my-app

spec:

ports:

- port: 80

targetPort: 80

nodePort: 30964

type: NodePort

selector:

app: my-app8.2创建服务

$. kubectl create -f a.yaml --validate

$. kubectl create -f b.yaml --validate8.3 删除服务

$. kubectl delete-f a.yaml

$. kubectl delete-f b.yaml8.4增加子节点

安装软件(以docker容器运行时为例):

yum-config-manager --add-repo https://docs.docker.com/v1.13/engine/installation/linux/repo_files/centos/docker.repo

yum makecache fast

yum -y install docker-engine-1.13.1

yum install epel-release -y

yum remove-y docker-engine*

yum install -y kubernetes docker flannel 修改配置文件(10.135.163.237为主节点ip,139.199.0.29为当前节点ip):

sed -i "s/--hostname-override=127.0.0.1/--hostname-override=139.199.0.29/g" /etc/kubernetes/kubelet

sed -i "s/127.0.0.1:8080/10.135.163.237:8080/g" /etc/kubernetes/kubelet

sed -i "s/--address=127.0.0.1/--address=0.0.0.0/g" /etc/kubernetes/kubelet

sed -i "s/127.0.0.1:8080/10.135.163.237:8080/g" /etc/kubernetes/config

sed -i "s/127.0.0.1:2379/10.135.163.237:2379/g" /etc/sysconfig/flanneld

sed -i "s/--admission-control=NamespaceLifecycle,NamespaceExists,LimitRanger,SecurityContextDeny,ServiceAccount,ResourceQuota/--admission_control=NamespaceLifecycle,NamespaceExists,LimitRanger,ResourceQuota/g" /etc/kubernetes/apiserver

8.5 启动服务(docker示例)

$. service docker start

for SERVICES in kube-proxy kubelet docker flanneld; do

systemctl restart $SERVICES

systemctl enable $SERVICES

systemctl status $SERVICES

done;8.6 主服务器查看节点

$. kubectl get node8.7 重启服务(重新加入集群)

$. systemctl restart kube-apiserver.service8.8 删除节点

$. kubectl delete node 节点ip