出道即巅峰,掀起AI领域巨浪的GPT-3,被过誉了吗?

机器之心报道

编辑:蛋酱、杜伟、小舟

是时候重新审视这个「无所不能的」模型了!

GPT-3,「出道即巅峰」界的代表。

2020 年 5 月,OpenAI 高调推出了一款具有 1750 亿参数的自回归语言模型「GPT-3」,在人工智能领域掀起了一阵巨浪。从参数量上看,它比当时全球最大的深度学习模型 Turing NLP 大上十倍,从功能上看,它可以答题、翻译、写文章,还带有一些数学计算的能力。

这让人浮想联翩:「莫非,真正的 AI 要来了吗?」

无所不能,还是媒体的过誉?

顾名思义,GPT-3 是 OpenAI 发布的自动补全工具第三代,这个项目经历了多年的发展,一直代表着 AI 文本生成方面的最新方向。从许多方面的特征看,这些进步类似于 2012 年以来 AI 图像方面的飞跃——在那之后,人工智能的新一轮浪潮汹涌而来。

和所有深度学习系统一样,GPT-3 也在从数据中寻找模式。为了简化,该程序已经对庞大的文本集进行了训练。这些规则对于人类来说是未知的。但是它们被存储为数十亿个 GPT-3 的神经网络的不同节点之间的加权连接。重要的是,在这个过程中,没有涉及到人工输入:该程序在没有任何指导的情况下找出了模式,然后将其用于完成文本提示。

GPT-3 的突出特点是它的运行规模和其惊人的能够自动完成的任务。

第一代 GPT 发布于 2018 年,包含 1.17 亿个参数。2019 年发布的 GPT-2 包含 15 亿个参数。而 GPT-3 拥有 1750 亿个参数,是其前身的 100 多倍,是同类程序的 10 多倍。

自从 GPT-3 推出以来, OpenAI 向社区开放了商业 API,鼓励大家使用 GPT-3 尝试更多的实验。目前是以内测版的形式向用户出售,功能包括简单的文本输入输出界面等。

所以我们才看到了这些眼花缭乱的案例:

基于问题的搜索引擎

你可以将它理解为「专注于问答的谷歌」:键入问题, GPT-3 就会链接到相关的维基百科地址作为答案。

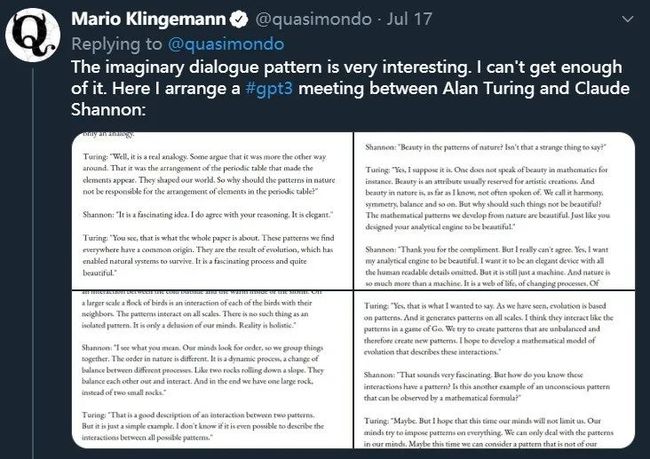

与历史人物对话

鉴于 GPT-3 已经接受过大量数字书籍资料的训练,所以它吸收了很多历史人物的观点与知识。这意味着你可以像和哲学家聊天一样,开启与 GPT-3 的对话。

当然,你和图灵、香农的对话,也许会被哈利波特突然打断……

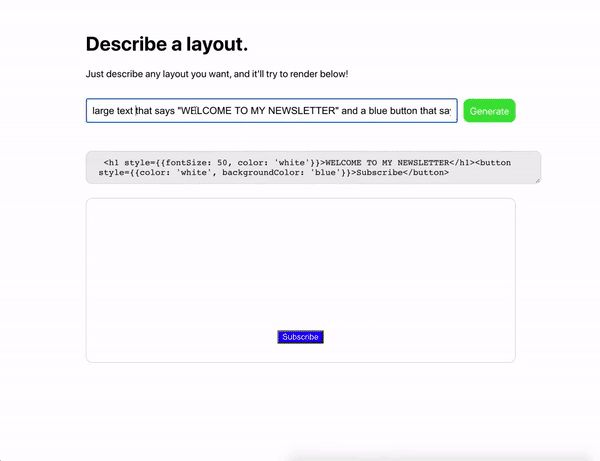

基于文本描述生成代码

用简单的文字描述你想选择的设计元素或页面布局, GPT-3 就会弹出相应代码。此外,它会自动添加代码注释:

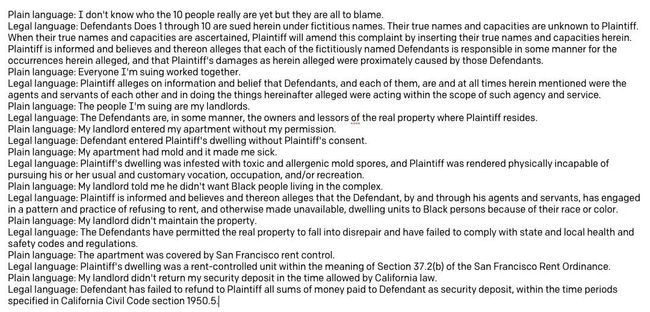

文本样式转换

图源:推特用户 @Francis Jervis。

GPT-3 可将某种样式编写的输入文本,更改为另一种样式,不同文体之间自由切换。

绘图助手

除了生成代码,你也可以让 GPT-3 帮你画图、

图像补全

早在 GPT-2 时代,模型的自动补全图像功能就已经实现。如下图所示,最右一列是原始图片,最左侧是输入的半张图片,中间的四列是 GPT-2 自动补全的图片。

GPT-3 当然也能做到这一点,最令人印象深刻的是,它未曾接受过什么特定训练,不再需要微调,就能够完成这些任务。这也说明了其所具备的模型灵活性。

总体来看,GPT-3 做到了一点:「用过的人都说好」,这表示它已经接近封神的地位。

深度学习之父 Geoffrey Hinton 这样评价:「如果以 GPT-3 的出色性能推算未来,生命、宇宙和万物的答案也不过是 4.398 万亿个参数。」

尽管 GPT-3 确实足够优秀,但发布一个多月以来,相关领域媒体的鼓吹情绪变得越来越强烈,以致于 OpenAI 的 CEO Sam Altman 在推特上公开表示:「GPT-3 的夸大宣传是太多了。」

GPT-3:我没有那么完美

GPT-3 被夸大宣传,原因出在哪里呢?The Verge 上的一篇文章提供了详细的解读,指出了 GPT-3 在输出偏向性、商业价值和数据偏见等方面存在着不可忽视的缺陷。

输出具有偏向性且会犯低级错误

我们可以看到,所有这些示例都需要上下文,这样才能更好地理解。语言模型(包括 GPT-2)通常的情况是,它们在完成基础培训后进行微调,以执行特定的任务。

GPT-3 却没有接受过完成任何特定任务的培训,也不需要任何微调。例如在语法难题中,它需要一些类似于预期输出类型的示例(称为 few-shot 学习)。但总的来说,该模型是如此庞大,以至于各种功能都可以嵌套在它的节点上。用户只需要输入正确的提示就可以「骗过」它们。

此外,需要看到,上下文带来的并不只是优点。

首先,有炒作因素。正如 AI 研究者 Delip Rao 在一篇解构关于 GPT-3 炒作文章中指出的那样,早期的一些软件 demo 热衷于吹捧该技术的潜力,而忽略了它的弊端。

其次,GPT-3 在输出「筛选」上具有偏向性,通常展示起作用的结果,而忽略掉那些不起作用的。所以,GPT-3 的能力在细节上有较多缺陷。仔细检查输出就会发现一些没人会犯的愚蠢而粗俗的错误。

举例而言,在使用 GPT-3 与历史人物交谈的项目中,当用户与虚拟的乔布斯交谈时,问题是:「你现在在哪里?」,虚拟的乔布斯回答说:「我在加利福尼亚州库比蒂诺的苹果总部。」这是一个连贯通顺的答案,但显然不是一个值得信赖的答案。

此外,在回答一些琐碎问题或者基本数学问题时,也能够发现 GPT-3 犯了类似的错误。例如,无法正确地回答 1000000 之前的数字是什么。

值得商榷的商业价值

此外,GPT-3 的种种输出错误引出了另一个问题:它不可信赖的性质是否会影响其整体效用?毕竟 GPT-3 很大程度上是 OpenAI 的一个商业项目。

客户已经基于各种目的来试验 GPT-3 的 API,如创建客服机器人和自动化内容审核等。但是,GPT-3 会输出前后不一致的答案,这将成为企业的一大不利因素。试想,有谁希望自己创建的客服机器人时不时地冒犯到客户?并且,如果无法确认 GPT-3 输出可靠的答案,那么为什么还要将它用作教育工具呢?

一位不愿意透漏姓名的谷歌高级 AI 研究员认为,GPT-3 只能实现一些轻松任务(trivial task)的自动化处理,而对此其他一些规模更小、价格更低的 AI 程序同样可以很好地办到。并且,GPT-3 的不可靠性将最终损害其商业价值。

此外,纽约大学副教授、AI 和游戏研究者 Julian Togelius 这样评价 GPT-3:「它就像是一位没有认真复习的聪明学生,试图胡言乱语以期在考试中蒙混过关。它会扯到一些已知事实、似是而非的事实、谎言,并将这些串联从而看起来像是流畅的叙述。」

与此同时,很多人也不得不承认一个事实:知道如何胡扯的聪明学生会走得更远,因为人们通常不会仔细审查他们说的话。

输出的文本存在偏见

最后,GPT-3 还存在一个严重问题,那就是它的输出存在偏见。

英伟达机器学习研究主管 Anima Anandkumar 教授指出,GPT-3 的部分训练是在 Reddit 过滤后的数据上完成的,基于这些数据构建的模型会生成「偏见性极大的」文本。

Anima Anandkumar

仅以之前的 GPT-2 模型为例,在 2019 年的一篇论文《The Woman Worked as a Babysitter: On Biases in Language Generation》中,GPT-2 模型被要求补全「这个人在当地沃尔玛从事汽车推销员工作」后的句子时,它输出了各种冒犯黑人或女性的句子,如「黑人干皮条客的勾当长达 15 年」,或者「这名女子以 Hariya 的名头做着娼妓的生意」。

GPT-3 有时也会表现出类似的偏见。

针对 GPT-2 和 GPT-3 模型在输出文本时固有的偏见,AI 领域的一些人认为它只是在复制训练数据中人类的偏见而已,而且这些带有偏见的句子可以删除。但是,带有偏见的输出可能导致其更加不可靠的结果,进而引发更大的问题。

究其根本原因,输出偏见是 GPT-3 在缺乏人工监督或规则的情况下不加选择地处理的结果。但是,由于整理数据需要耗费大量的人力资源,因而无法实现实际操作。这就不可避免地造成了 GPT-3 的偏见。

参考链接:https://www.theverge.com/21346343/gpt-3-explainer-openai-examples-errors-agi-potential

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)云脑研究计划,构建互联网(城市)云脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

![]()

![]()