AI计算行业巨震:英伟达发布全球最大GPU【黄仁勋GTC 2018演讲干货汇总】

【网易智能讯 3月28日消息】北京时间3月28日凌晨,人工智能计算公司英伟达(NVIDIA)在美国加州圣何塞召开GTC大会。在会上,英伟达CEO黄仁勋穿着熟悉的黑皮衣登场,又宣布了一系列针对人工智能计算的新技术与新合作。网易智能将重点梳理如下:

![]()

推出RTX实时光线追踪技术

![]()

RTX(ray-tracing)实时光线追踪技术,能够在运行专业设计及内容创作类应用程序的同时,提供实时光线追踪。这项技术在不久前的游戏开发者大会(GDC)上推出。

具体来说,传媒娱乐领域的专业人士将能够在准确的光影环境下浏览自己的作品,并与之交互,并在负责渲染时,可享受拥有 10 倍于单独使用 CPU 的渲染速度。产品设计师和建筑师能够实时创建交互式、照片级写实的大型 3D 模型的可视化。

英伟达CEO黄仁勋称,自推出可编程着色器以来,NVIDIA RTX是计算机图形领域近 20 年来取得的最显著进展。

![]()

发布Quadro GV100 GPU

![]()

英伟达正式宣布推出第一款采用Volta架构的GPU Quadro GV100,搭载NVIDIA RTX技术。GV100具有 32GB 内存,且可通过并联两块 Quadro GPU扩展至 64GB。GV100的性能比去年9月推出的DGX-1性能提高了10倍,售价达到惊人的39.9万美元(约合250万人民币)。

说到性能,GV100可提供每秒 7.4 万亿次浮点运算的双精度性能、每秒 14.8 万亿次浮点运算的单精度性能、以及每秒 118.5 万亿次浮点运算的深度学习性能。NVIDIA RTX 内置的 NVIDIA OptiX AI-denoiser 可实现实时的 AI 去噪。

据悉,Quadro GV100将于4月通过工作站制造商及授权分销合作伙伴进行供货。

![]()

Tesla V100 GPU实现内存翻倍

![]()

与旧版相比,Tesla V100 GPU升级到了32GB 内存,是之前的两倍,将内存受限的 HPC 应用性能提升高达 50%,使其能够处理大部分内存密集型深度学习和高性能计算工作负载。

英伟达介绍称,Tesla V100 32GB GPU 目前可用于所有 NVIDIA DGX 系统。此外,各大计算机制造商也宣布将于第二季度内推出各自全新的 Tesla V100 32GB 系统。

![]()

推出全新GPU互联结构NVSwitch

![]()

英伟达在此次GTC大会上还推出了NVSwitch互联结构,这个结构的带宽比最好的 PCIe 交换机高出 5 倍,NVSwitch 在 NVIDIA NVLink的基础上实现了进一步扩展,让系统设计人员能够构建更高级的系统,灵活地连接任何基于 NVLink 的 GPU 的拓扑结构。

黄仁勋称,NVSwitch将帮助开发者突破早前系统的限制并运行更大的数据集。它也为更大规模、更复杂的工作负载开启了可能,包括神经网络并行训练的建模。

![]()

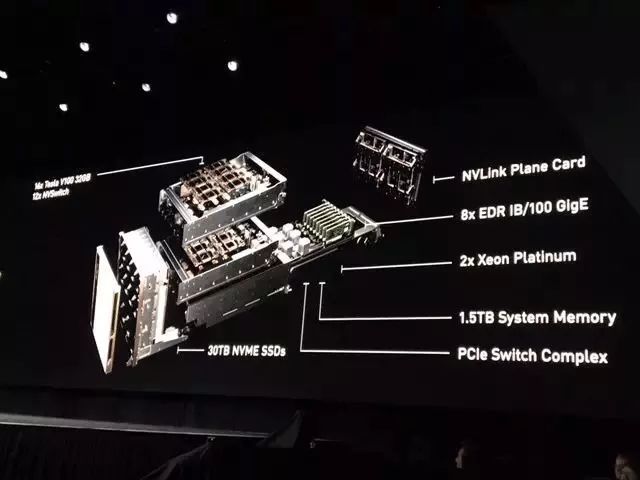

推出NVIDIA DGX-2服务器

![]()

英伟达在发布会上重磅推出了NVIDIA DGX-2,这是全球首款能够提供每秒两千万亿次浮点运算能力的单点服务器。DGX-2 搭载 16 个 GPU,具有 300 台服务器的深度学习处理能力,占用 15 个数据中心机架空间,而体积则缩小60倍,能效提升18倍。

DGX-2 是首款采用 NVSwitch 的系统,其中采用的 16 个 GPU 均共享统一的内存空间。结合了最新的 NVIDIA 深度学习软件套件,让开发者能处理更大规模的数据集和更复杂的深度学习模型。

英伟达宣称,DGX-2 能够在不到两天的时间内完成对 FAIRSeq(一种采用最新技术的神经网络机器翻译模型的训练,其性能相较于去年 9 月份推出的基于 Volta 架构的 DGX-1 提高了 10 倍。

![]()

推出新的TensorRT 4推理软件

![]()

英伟达发布了TensorRT 4软件,并且集成至谷歌的TensorFlow 1.7开发系统。开发者可利用Volta Tensor Core 技术将 NVIDIA 深度学习平台的推理吞吐量提高 8 倍(相比低延迟目标下的普通 GPU 执行),从而让 GPU 在 TensorFlow 内的推理实现了最高性能。

TensorRT 4提供高度精确的 INT8 与 FP16网络执行,可用于快速优化、验证及部署在超大规模数据中心、嵌入式与汽车 GPU 平台中经过训练的神经网络。

与此同时,语音识别框架 Kaldi 针对 GPU 进行了优化。GPU 语音加速意味着消费者将获得更加准确与实用的虚拟助手,并降低数据中心运营商的部署成本。

![]()

推出DRIVE Constellation自动驾驶仿真系统

![]()

据悉,DRIVE Constellation是一款基于两种不同服务器的计算平台。第一台服务器运行 NVIDIA DRIVE Sim 软件,用以模拟自动驾驶汽车的传感器,如摄像头、激光雷达和雷达。第二台服务器搭载了NVIDIA DRIVE Pegasus AI 汽车计算平台,可运行完整的自动驾驶汽车软件堆栈,并能够处理模拟数据,这些模拟数据如同来自路面行驶汽车上的传感器。

英伟达称,DRIVE Constellation提供了一种能够在数十亿英里的行驶中进行测试和验证的解决方案,借助虚拟仿真,可进行数十亿英里的自定义场景和极端情况进行测试,从而提高算法的稳定性,加速实现自动驾驶汽车的量产部署。

![]()

与ARM达成合作,布局物联网设备

![]()

英伟达在本次GTC上还宣布了与ARM的合作,英伟达深度学习加速器NVDLA架构将集成到ARM的 Project Trillium 平台中,以便于构建深度学习 IoT 芯片。此次合作将使物联网芯片公司能够轻松地将 AI 集成到它们的设计中。

NVDLA 是一个免费的开放式架构,它基于自主机器系统级芯片 NVIDIA Xavier设计,旨在推广设计深度学习推理加速器的标准方法。NVDLA 的模块化架构具有可扩展性和高度可配置性,专门为简化集成和便携性而设计。

![]()

最后

![]()

这次GTC英伟达还宣布了一个坏消息,就是宣布暂停自动驾驶测试。外界猜测,这或许与Uber自动驾驶汽车撞人致死事故有关(Uber自2016年首次部署自动驾驶测试车队以来,一直使用的是英伟达的技术)。随后,英伟达股价应声下跌3.8%。

不过,这并不影响英伟达在AI计算领域的地位。在今年2月8日公布的英伟达2017年全年财报中,英伟达总收入高达97.1亿美元,同比增长41%,利润增长83%。在过去的一年时间,英伟达的股价上涨了200%,市值已经达到1400亿美元,成为名符其实的计算行业巨头。(小羿)