远程扫描iPhone相册?苹果的好心网友不领情

????????关注后回复 “进群” ,拉你进程序员交流群????????

明敏 晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

苹果即将推出的新功能可扫描用户所有照片。

这一消息刚刚宣布,就让广大用户们集体炸锅了!

最近苹果宣布,为了让儿童能够更加安全地上网,他们决定在iOS 15、iPadOS 15、macOS Monterey系统中加入一个可以扫描用户照片的功能。

只需通过一个自动系统,苹果就能扫描用户的照片,以检查其中是否涉及虐童、儿童色情(CSAM)的内容。

一旦检测到相关照片,他们就会上报美国失踪与受虐儿童中心,甚至会联系执法部门。

与此同时,未成年人账户的iMessage也会受到重点监测。

如果他们的iMessage中有色情照片,苹果也会发出警告并通知其父母。

能够扫描用户的所有照片?

那还有隐私可言吗???

这一计划刚刚宣布就引起了用户们的巨大担忧,库克说好的iPhone无后门呢?

苹果:放心绝对安全

为了打消用户的疑虑,苹果在官方公告中表示,他们绝不是直接扫描用户的图像,而是使用了一种叫做NeuralHash的加密技术,是无法直接看到用户照片的。

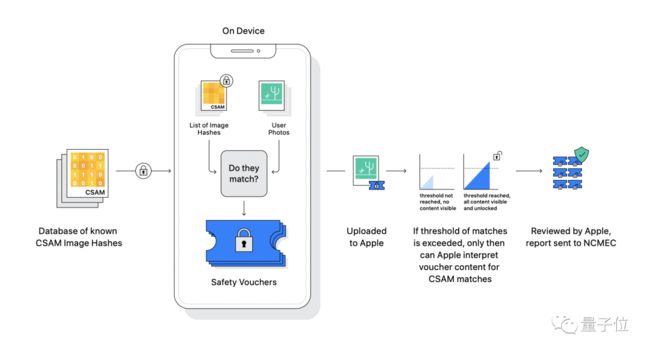

首先,苹果具有美国失踪和受虐儿童中心(NCMEC)和其他儿童保护组织提供的CSAM图像,由这些图像得出一组“哈希值”。

这组哈希值数据库经过加密后存储在苹果设备上,防止用户获取哈希值绕过系统检测。

然后,用户的图像也会被计算出一组哈希值,在上传到iCloud之前,这些哈希值会在设备上与数据库进行匹配。

这样无需解密,通过哈希值是否匹配就可以知道图像内容是否违规。

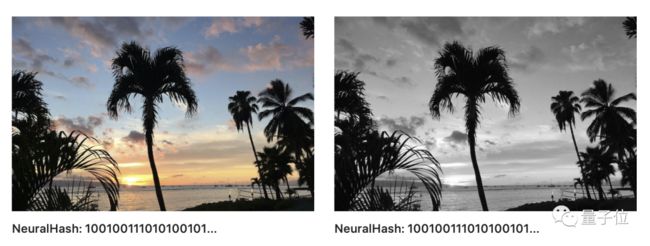

NeuralHash能够确保相同且视觉上相似的图像具有相同的哈希值,即使图像经过裁剪或者其他颜色处理。

△ 经过黑白处理的图片和原图片具有相同哈希值

符合条件的图片会上传给苹果,苹果使用另一种称为阈值秘密共享的加密技术,低于一定阈值的照片是无法被还原的。

仅当用户照片超过某个阈值时,才可以被解密内容并进入人工审核,而且系统识别错误几率低于万亿分之一。

苹果认为,这些保护措施可以防止其儿童色情检测机制被滥用,而不会看到用户的任何其他图像。

而且苹果也给用户提供了申诉机会,如果用户认为自己的帐户被错误标记,可以申诉恢复帐户。

安全专家:我要转投Android了

想通过技术来保护儿童的苹果,结果却让舆论一片哗然:“苹果,你变了!”

多年来,苹果顶住了美国政府要求在iPhone中安装“后门”的压力,表示这样做会破坏用户的隐私安全。

苹果的这一立场受到了安全专家的称赞,但如今苹果却被看做是“美国政府的监视工具”。

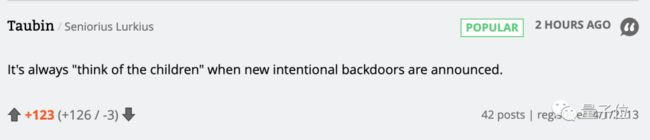

一位美国网友表示:监控后门总是打着“为孩子着想”的幌子。

爆出“棱镜门”事件的斯诺登也对苹果此举表示不安,他引用另一位安全专家的话说:“这将导致对我们的手机和笔记本电脑被分布式批量监控。”

过去苹果一直以保护隐私的形象而被用户青睐,但今天之后,一些人的观念恐怕要产生动摇了。

著名密码学专家Nadim Kobeissi说:

我不是在为虐待儿童辩护,但是这种根据某些不良内容的标准,不断在本地扫描和监控你的个人设备,并有条件地向当局报告的想法是非常非常危险的。

如果这种情况继续下去,我肯定会改用 Android 手机。

不过也有一些专家对苹果表示赞赏,以色列密码学家Benny Pinkas说:

我相信苹果的系统在隐私和实用性之间提供了极好的平衡,并且将非常有助于识别儿童色情内容,同时保持高度的用户隐私并将误报降至最低。

网友:发生泄露事件怎么办?

目前,这个功能只在美国使用。

其中带有这项功能的iOS 15预计会在下个月推出。

不久后也会陆续引入其他国家,这也让我国的用户们感到了担忧。

有人简洁明了说出了关键:

能查违法图片,也就能查别的内容。

要知道,相册往往是存有一个人隐私最多的地方,现在苹果说看就看,这算侵犯隐私吗?

用户们也更关心,如果数据发生泄露……那就可怕了。

同样会监测用户上传内容的网盘,此前也发生过不止一次的隐私泄露事件。

从用户的个人照片、证件信息到机密的商业资料,2017年发生的严重数据泄露事件曾让大众感到非常恐慌。

而苹果现在的计划,和网盘非常类似。

这也让人们对其是否能保护好用户隐私,打上了一个大大的问号。

苹果公告:

https://www.apple.com/child-safety/

技术资料:

https://www.apple.com/child-safety/pdf/CSAM_Detection_Technical_Summary.pdf

https://www.apple.com/child-safety/pdf/Apple_PSI_System_Security_Protocol_and_Analysis.pdf

-End-

最近有一些小伙伴,让我帮忙找一些 面试题 资料,于是我翻遍了收藏的 5T 资料后,汇总整理出来,可以说是程序员面试必备!所有资料都整理到网盘了,欢迎下载!

点击????卡片,关注后回复【面试题】即可获取