GPT-4的前世、今生和未来!

文章目录

- 一、前言

- 二、前世

- 三、今生

- 四、未来

转载地址:

https://mp.weixin.qq.com/s/Tw7A4OedDKrcaZMVZhHwrg

一、前言

诚然,从关系数据库到互联网信息检索,每一次知识表示和调用方式的跃迁都会在科技史引起一场巨大的技术变革。当ChatGPT发布之后,生成式AI成了新的技术范式,这场变革从微软、Google、百度这一众搜索引擎开始,星火燎原,越来越多的工作将会发生不可逆转的改变,有研究声称至少80%的工作都将或多或少受其影响。

在这场狂欢之中,有声称5000万美金入局的投资者,有李沐等技术大牛离职做大模型创业,声音越来越嘈杂,大有风雨欲来之势。主流的声音慢慢从技术的探讨变成了“AI取代人类”的惶恐不安,警告人们‘不要温和地走入那个良夜’,更不乏有人开始去思考人类是否可以创造一个全知全能的神这样的终极命题。

有人狂喜,声称自己是ChatGPT的忠实拥趸;有人毫不关心,认为又是一个资本鼓吹的泡沐。无论哪种视角,这都将是一场势不可挡的技术浪潮,在这里,我们追溯从GPT-1到GPT-4的时间线,挑拨缕析地探讨一下GPT-4的前世、今生和未来!

二、前世

如果追溯GPT系列发展的时间线,我们会发现这是一项横跨五年的技术探索,从GPT-2到GPT-3,其实也只是在几乎不改变模型框架的基础上从15亿的参数量迭代到1750亿,不同于Google推出T5、Switch Transformer和PaLM等一系列大模型的赛马机制,OpenAI‘矢志不渝’地坚持着GPT路线。

这种坚持在现在看来也尤为不易。2020年,OpenAI提出了大模型的缩放法则(Scaling Laws),增大参数规模可以极大提升模型性能一时成为了“金科玉律”,由此也开启了炼大模型的‘狂飙’时代。1760亿参数的BLOOM、5300亿的MT-NLG、5400亿的PaLM、更有‘贪心者’用MoE(Mixture of Experts)架构强行将参数量堆叠到了万亿,当时关于GPT-4模型参数量将达到100万亿的谣言一时甚嚣尘上。

但如果把视角拉到22年年中,我们会发现国内几乎所有人都在造大模型狂刷SOTA之后迷茫了,学术界‘fine-tune’和‘promot’的百般招式皆已用上,工业界又难以对大模型落地,‘顶不了天,立不了地’,留下的只是盲目跟风追求大模型之后的“一地鸡毛”。一方面Epoch AI 发文称语言数据将在2026年耗尽,另一方面越来越多的inverse scaling现象(逆向缩放,即模型规模越大,效果越差)不断被发现,超大模型的前进道路似乎弥漫着茫茫迷雾。

然而,当继续加大模型规模并在超过某个阈值之后,模型性能出现了井喷式的能力提升,这种神奇的现象被称作大模型的涌现性。例如,随着模型规模的进一步提升,研究人员发现模型准确率会呈现“ U 型”曲线,超大规模的模型似乎在某个临界点之后不可预料得表现出极为强大的能力。新的进步与发现似乎完全改变了游戏规则,很多提示增强(augmented prompting)技术在小模型上并没有效果,但在模型达到某个规模之后会突然有效。

在此背景下,OpenAI将RLHF(人类反馈强化学习,Reinforcement Learning from Human Feedback)技术应用到GPT-3模型中,简而言之,RLHF 将预训练语言模型按照人类反馈进一步微调以符合人类偏好。看似简单,RLHF这条道路,OpenAI同样走了五年。

- 2017年,OpenAI提出该技术,少量人类反馈作为奖励函数得以让系统处理复杂任务,在Atari游戏上表现出不错的效果,‘小火柴棍’学会了后空翻。

- 2021年,OpenAI利用该技术进行摘要生成,雇佣了80

位人工标注者生成了6.48万条数据对模型进行调校,粗略计算仅标注数据的成本就在300万左右。这一工作证明了RLHF确实能够在语言模型上奏效,可以针对人类价值观等模糊的目标进行优化。 - 2022年,OpenAI将RLHF应用于GPT-3并开发出InstructGPT,相对于GPT-3更善于遵循用户意图,虽然参数量只有1.3B,比175BGPT-3模型参数少了100多倍,但更加遵循指令和事实,并大幅度减少有毒输出(toxic generation),微调成本更是只有GPT-3的2%。

上图是RLHF应用开发ChatGPT的技术路线。

OpenAI宣称RLHF是一种“有效提升AGI(通用人工智能系统)与人类意图对齐的技术”,但OpenAI对齐团队负责人Jan Leike坦言,优越对齐能力的出现并未有坚实的理论基础,换言之,该方法只是秉持着“评估比生成更容易”的动机而不是正式的理论。

回归主题,基于RLHF技术,OpenAI构造了ChatGPT。当然,更重磅的新闻是所有人翘首以盼的GPT-4来了,OpenAI创始人Sam Altman开门见山的简绍说这是我们迄今为止功能最强大的模型,一个史上最强大的多模态模型!

一场技术革命似乎开始了。《财富》杂志描述其为Netscape Navigator(网景)时刻:在一代人的时间中总有一种产品的出现,它将工程技术从昏暗的地下室、书呆子们臭气熏天的卧室和爱好者们孤独的洞穴中发射出来,变成了你的祖母都知道如何使用的东西。早在1990年就诞生了网络浏览器,但直到1994年Netscape Navigator(网景浏览器)的出现,大多数人才发现了互联网。我们现在迎来了AI的Netscape Navigator 时刻!

三、今生

- 3月14日,GPT-4发布,OpenAI给出了技术报告和3分钟的预告片。GPT-4支持多模态,能够识图、生成歌词、做网站,并且刷爆了人类社会各个领域的考试,已经达到了哈佛、斯坦福等顶尖高校的水平。现已集成到微软New Bing和ChatGPT Plus。

- 3月16日,OpenAI 的首席科学家兼联合创始人Ilya

Sutskever表示OpenAI不会分享更多关于GPT-4的信息。Sutskever表示出于竞争和安全的考量,当然主要是同行的竞争,当被问及为什么OpenAI 改变了分享其研究成果的方式时,Sutskever简单地回答说:坦率地说,我们错了。如果你像我们一样相信,在某个时候,人工智能将变得极其强大,那么开源就没有意义了,我完全希望在几年内,每个人都会完全清楚开源AI 是不明智的。 - 3月17日,微软Microsoft365全面引入生成式AI助手Copilot,将GPT-4集成到了Word、Excel、PowerPoint、Outlook和Teams等应用中,用户可以提出问题并提示AI撰写草稿、制作演示文稿、编辑电子邮件、制作演示文稿、总结会议等。

- 3月20日,OpenAI发布了GPT模型和技术对劳动力市场潜在影响的论文,预计将影响80%的工作岗位。

已构建好技术壁垒的OpenAI开始拒绝技术开源,甚至DeepMind 首席执行官 Demis Hassabis也同样表示:我们正在进入一个时代,我们必须开始考虑贪图便宜的人,或者那些正在阅读但没有为该信息库做出贡献的人,这也包括民族国家,这很明显,你可能会想到谁。他表示人工智能行业公开发布其发现的文化可能很快需要结束。

不知道大家对此作何感想?

这里OpenAI 的前政策主管 Jack Clark 做了我的嘴替,Clark强烈反对GPT-4,他表示:事情变得越来越奇怪,这更像是一个政治时刻,而不是技术时刻,GPT-4 基本上是通过计算呈现的硬实力政治,GPT-4 无疑会引起社会变革,但同样会因垄断引发重大的政治反弹。

回归到技术本身,OpenAI表示在发布GPT-4之前,他们花费了八个月进行安全研究、风险评估和迭代,因此,GPT-4的初始可用日期是在2022年8月。GPT-4是包括视觉语言模型组件的大型语言模型,类似于DeepMind的Flamingo模型,输入可以是文本或图像,但所有的输出都是文本。

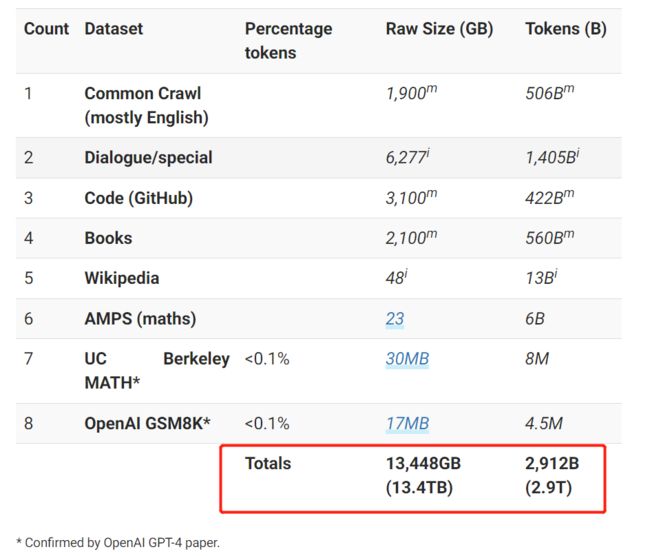

GPT-4 的数据收集是由 Wojciech Zaremba(数据集团队经理)和 Qiming Yuan(数据集采购和处理负责人)领导的一项艰巨任务。数据集贡献来自一个由 35 名 OpenAI 员工组成的团队。在预训练阶段,OpenAI过滤了 GPT-4 的数据集组合,以专门减少不适当的色情文本内容的数量。通过结合内部训练的分类器和基于词典的方法来识别被标记为极有可能包含不当色情内容的文档。

OpenAI 拥有利用来自包括谷歌在内的竞争对手的其他数据集的经验[15], 依赖最先进的 DeepMind MassiveText 和 Google Infiniset数据集,且OpenAI 与 Microsoft 的合作伙伴关系允许访问 GitHub 等大型数据集,我们可以推测GPT-4可能是在1.7T-2.9T的文本tokens上进行的训练,模型参数量包括800-1400亿的语言模型参数+200亿的视觉模型参数。

此外,GPT-4的文本生成长度被显著提高,一个token通常对应大约 4 个字符,而1个汉字大致是2~2.5个token,在GPT-4之前,token的限制大约在4096左右,大约相当于3072个英文单词,一旦对话的长度超过这个限制,模型就会生成不连贯且无意义的内容,到了GPT-4其最大的token数是32768个,大约相当于24576个单词,相当于48页文本,生成长度被扩大了八倍。

GPT-1到GPT-4的上下文窗口数量,注:目前GPT-4限制的上下文长度限制为8192个token,允许32768个token的版本名为GPT-4-32K,目前暂时限制了访问权限。

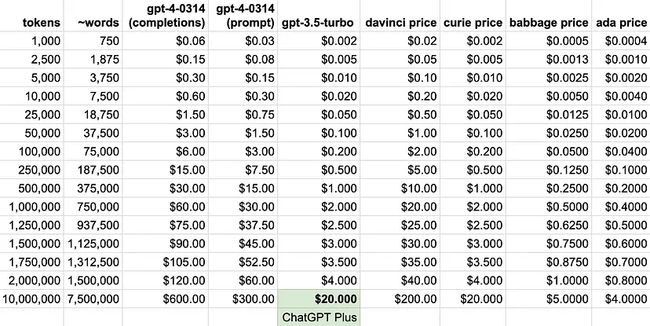

就价格而言,GPT-4 比 ChatGPT 贵大约 30 倍,比 GPT-3 davinci 贵大约 3 倍。

四、未来

我们可以从GPT-4的结果就可以看到其巨大的潜力,美国高考SAT:1410(满分1600,前6%),美国大学预科考试AP:100%(5/5)。有人在去年8月就获得了GPT-4的访问权限,并用其写了一本书-----Amplifying our Humanity through AI(通过人工智能放大我们的人性)。

当然未来的潜力远不止如此,我们可以从和GPT-4的合作企业管中窥豹。

- 和教育行业合作,去一探学习的未来,和可汗学院(khan academy,教育性非盈利组织)合作推出Khanmigo,和多邻国(Duolingo,语言学习软件)推出Duolingo Max,让AI去辅导学生作业和学习外语。

- 和IT行业合作,集成到微软Bing和Microsoft 365全家桶上,重新定义了生产力;发布AI聊天机器人Fin等,这将会是第一个最懂你的AI机器人;集成到笔记软件Mem中,辅助我们去畅想未来,探索未知。

- 和专业服务公司合作,联合波士顿咨询公司合作推出BCGX,汇集了先进的技术知识和雄心勃勃的企业家精神,可帮助组织开展下一次重大投资并实现大规模创新。

- 在其合作名单中,甚至有可口可乐公司,摩根士丹利等金融服务公司和冰岛等政府机构。

这一次,工作范式将要改变,我们可以将越来越多的事务托付给AI完成,人类将会有更多的自由和可能,甚至某一天人类可能会将思考的权力也让渡给了AI,那个时候我们就要去重新追寻人类的价值,而这对于我们而言,依然有很长的路要走!