从ChatGPT到ChatCAD:基于大型语言模型的医学图像交互式计算机辅助诊断

基本信息

1. 标题:ChatCAD: Interactive Computer-Aided Diagnosis on Medical Image using Large Language Models.

2. 期刊:arXiv

3. IF/JCR/分区:无

4. DOI:arXiv:2302.07257

5. 作者:沈定刚教授团队

1. 导读

2023年年初最火热的话题之一就是OpenAI的ChatGPT1,给人类带来了巨大的冲击。1月底,美国《财富》杂志2/3月合刊的封面文章《全球爆红的ChatGPT是如何诞生的?》引爆了创投圈。在这巨大的浪潮冲击下,如何让其在医疗领域发挥其强大的作用呢?沈定刚教授团队给出了初步的答案。在本文中,作者提出了一种将大型语言模型(LLMs)集成到医学影像计算机辅助诊断网络中的初步方法。

2. 背景动机

2.1 计算机辅助诊断(CAD)

传统的计算机辅助诊断网络模型是基于各种计算机视觉的先进算法在大量数据上进行训练,使他们能够学习识别特定于医学领域的视觉信息中的复杂模式和关系,在医学领域的各个任务中已取得了显著性地效果。

2.2 大型语言模型(LLMs)

大型语言模型(如ChatGPT)是经过大量文本数据训练的高级人工智能系统,在自然语言处理方面取得了显著成果,并有可能彻底改变各个行业。ChatGPT已经成功通过了部分美国医疗执照考试,展示了其在增加医疗专业人员提供护理方面的潜力。然而LLMs目前难以从医学影像中解释和提取信息,从而限制了他们全面支持临床决策过程的能力。但医学影像在临床决策中发挥着巨大的作用,如何整合 LLM 以理解计算机视觉任务中的视觉信息是一个有趣的问题。

2.3 视觉语言模型

一种流行的将视觉信息转换为语言的方法是通过图像描述。通过训练大量的数据,基于深度学习的图像描述模型可以生成连贯的描述。

在医学图像分析中,研究人员使用异质图、知识图谱和自监督算法等方法对图像进行描述来生成影像报告。

近年来,随着模型规模的增大,该领域的进展已转向视觉语言预训练和利用预训练模型,如:CLIP2、Frozen3和Flamingo4等。

3. 研究目的

本文目标是将 LLM 的医学领域知识和逻辑推理的优势与现有医学图像 CAD 模型的视觉理解能力相结合,为患者创建一个比传统 CAD 系统更加用户友好和易于理解的系统。这样患者就可以更好地理解病情,减少患者的咨询开销,增强在线医疗服务的可行性。

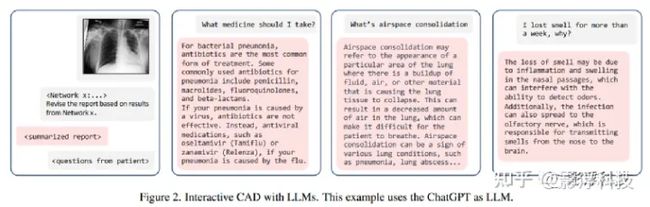

图2:使用LLMS的交互式CAD。本例使用ChatGPT作为LLM。例如,基于图像和生成的报告,患者可以询问适当的治疗方案(第二个面板)或定义医学术语,如"空域整合" (第三个面板)。或者以患者的主诉(第四小组),LLMs可以解释为什么会出现这样的症状。

4. 模型构建

图1:模型策略总览。

4.1 图像和文本的连接

为了将医学影像转为文本内容输入到LLM中,作者采用了以下策略:

1. 将影像输入到训练好的CAD模型中产生输出。

2. 将该输出转为自然语言。

3. 使用语言模型总结结果并作出最总的总结。

4. 基于以上结果和语言模型(基于医学知识预训练),参与关于症状、诊断和治疗的谈话。

以图3为例:

图3:提示张量和文本之间的桥梁。我们展示了三种不同的提示设计。

1. CAD模型的分类输出为一个含有5个概率值的向量。(即判别为五种类别的可能性)。

2. 将上述结果转为一个用以用于LLM的提示性语句。一种自然的提示方式是显示所有五种病理及其相应的分数。

① 为了避免一些误解,规定“疾病得分越高,患病的可能性就越大”作为基本规则。② 将每种疾病的分数表示为“{疾病}分数:{分数}”(Prompt#1)。但这种表示不符合临床报告需求。③ 为了和临床报告形式一致,作者又将概率分数转为定性描述疾病的严重程度。“没有迹象”[0.0-0.2],“可能性很小”[0.2-0.5],“可能”[0.5-0.9],“肯定”[0.9 及以上)。(Prompt#2)④ 为了使报告更简洁,报告诊断分数高于 0.5 的疾病。(Prompt#3)如果没有预测在这五种类别中,则显示“未发现”。

4.2 数据集和实验设定

模型:

● CvT2DistilGPT25

● R2GenCMN6

● 本文提出的模型(基于GPT-3)

● 本文提出的模型(基于ChatGPT)

数据:

● 用于报告生成的数据:MIMIC-CXR7

● 用于疾病分类器训练的数据:CheXpert8

5. 实验结果

5.1 报告生成

5.1.1 改进后的报告的质量

表1:模型诊断正确率对比。

图5:四种模型在五次观测上的F1分数。

5.1.2 LLMs是如何影响报告质量

语言模型的诊断能力与其大小成正比,这突显了LLMS的逻辑推理能力的关键作用。

表2:比较不同大小的GPT-3模型的性能。参数大的模型更好些。

越有效的模型会产生更长的报告。

图6:不同模型生成报告的长度。

5.2 交互的、可理解的CAD

ChatCAD能够利用LLM广泛而可靠的医学知识来提供交互式的解释和建议。通过这种方法,患者可以更清楚地了解自己的症状、诊断和治疗方案,从而更高效、更具成本效益地咨询医疗专家。

随着语言模型的不断进步,随着对更可信的医疗培训数据的访问,ChatCAD变得更加准确,ChatCAD有潜力显著提高在线医疗服务的质量。

图7:两个ChatCAD案例。一个讨论胸腔积液,另一篇讨论水肿及其与肿胀的关系。

图8:基于ChatGPT的模型生成的报告。

6. 局限不足

目前这个方向是个比较新的领域,还是有很多工作需要去完善:

● LLM生成的报告在某种程度上不像人类。ChatCAD 提高了诊断准确性,但降低了 BLEU 分数9。

● ChatCAD只给出了三种prompts,还需要继续完善。

● ChatCAD中不包含患者的主诉信息,因为没有相应的数据库。需要更好的数据集和基准。

● 视觉分类器的作用尚未得到探索,需要进行额外的研究以确定具有更大参数的ViT或 SwinTransformer等模型是否可以提供改进的结果。

● LLMs也可以用来帮助视觉模型的训练,比如利用在LLMs中学到的相关医学知识来修正视觉模型的输出。

● 对prompt设计只是进行定性分析,应该进行更准确的定量评估。

● ChatCAD的内容没有和临床医生进行专业的讨论,需要进一步完善。

7. 一些想法

● 虽然本文不那么完善(毕竟只是preprint,说不定作者已经在改进的路上了),但作者团队相当于挖了一个坑给大家,大家快冲!。(大佬们的动作真的快啊!)

● 基于现有的通用人工智能ChatGPT,给其输入医学知识学习构建ChatMedicine是一个很有意思的研究。(毕竟人工智能和人最大的区别是:你给他知识他是真的学啊!)

▎脚注列表

[1] 关于ChatGPT的解读互联网很多,推荐两个:通向AGI之路:大型语言模型(LLM)技术精要 - 知乎;https://mp.weixin.qq.com/s/IF43iCk4v3qwIBjMdljtJA

[2] Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, et al. Learning transferable visual models from natural language supervision. In International Conference on Machine Learning, pages 8748–8763. PMLR, 2021.

[3] Maria Tsimpoukelli, Jacob L Menick, Serkan Cabi, SM Eslami, Oriol Vinyals, and Felix Hill. Multimodal few-shot learning with frozen language models. Advances in Neural Information Processing Systems, 34:200–212, 2021.

[4] Jean-Baptiste Alayrac, Jeff Donahue, Pauline Luc, Antoine Miech, Iain Barr, Yana Hasson, Karel Lenc, Arthur Mensch, Katie Millican, Malcolm Reynolds, et al. Flamingo: a visual language model for few-shot learning. arXiv preprint arXiv:2204.14198, 2022.

[5] Aaron Nicolson, Jason Dowling, and Bevan Koopman. Improving chest x-ray report generation by leveraging warmstarting. arXiv preprint arXiv:2201.09405, 2022.

[6] Zhihong Chen, Yaling Shen, Yan Song, and Xiang Wan. Generating radiology reports via memory-driven transformer. In Proceedings of the Joint Conference of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing, Aug. 2021.

[7] Alistair EW Johnson, Tom J Pollard, Seth J Berkowitz, Nathaniel R Greenbaum, Matthew P Lungren, Chih-ying Deng, Roger G Mark, and Steven Horng. Mimic-cxr, a deidentified publicly available database of chest radiographs with free-text reports. Scientific data, 6(1):317, 2019.

[8] Jeremy Irvin, Pranav Rajpurkar, Michael Ko, Yifan Yu, Silviana Ciurea-Ilcus, Chris Chute, Henrik Marklund, Behzad Haghgoo, Robyn Ball, Katie Shpanskaya, et al. Chexpert: A large chest radiograph dataset with uncertainty labels and expert comparison. In Proceedings of the AAAI conference on artificial intelligence, volume 33, pages 590–597, 2019.

[9] Kishore Papineni, Salim Roukos, Todd Ward, and Wei-Jing Zhu. Bleu: a method for automatic evaluation of machine translation. In Proceedings of the 40th annual meeting of the Association for Computational Linguistics, pages 311–318, 2002.