论文复现-1:ConSERT: A Contrastive Framework for Self-Supervised Sentence Representation Transfer

论文题目: ConSERT: A Contrastive Framework for Self-Supervised Sentence

Representation Transfer

文章目录

- 论文内容回顾

-

- 论文做了什么?

- 一、问题发现

- 二、related work

- 三、论文工作

-

- 3.1 模型架构

- 3.2 模型详解

- 3.3 数据增强手段

- 3.4 融入supervision信号

- 3.5 模型实验

- 四、Ablation study

论文内容回顾

论文做了什么?

为了解决bert得到的语言表示的崩塌问题 collapse 问题,这个问题也导致模型在语义相似度判断任务中表现不良。

论文采用对比学习框架解决自监督语言模型的学习问题,是在unsupervised方式下实现对PLM的改进的。

论文在小样本情景下,也具有不错的表现,提到在1000个samples上,也可以得到comparable results。

一、问题发现

1、当直接使用bert-based sentence的representation进行语义文本相似性(STS)任务时,几乎所有的句子对都达到了0.6到1.0的相似性分数,即使有些句子对被人类注释者认为是完全不相关的,也认为相似度是较大的。

almost all sentences are mapped into a small area and therefore produce high similarity

2、BERT的词表示空间是各向异性的,高频词聚集在一起并靠近原点,而低频词则稀疏地分散开来。

BERT is anisotropic

二、related work

在supervised approach 方法上,多数是使用NLI 任务来训练以得到更加的semantic representation。

在self-supervise的 approach 方法上,以Bert最为经典,是采用的MLM objective 和 NSP 同时做了training objective。

在constractive learning 上,起源是来自于CV领域,也有比较经典的双塔模型,比如SimCLR

三、论文工作

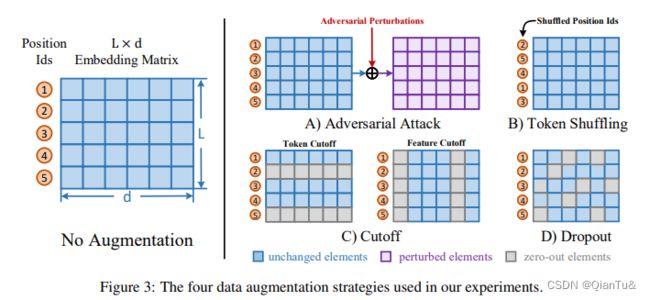

这篇论文做了sentence-level training objective based on constractive learning+multiple data argumentation strategy,在multiple data argumentation stategy策略上,作者尝试了adversarial attack、token shuffling、cutoff 和dropout

3.1 模型架构

3.2 模型详解

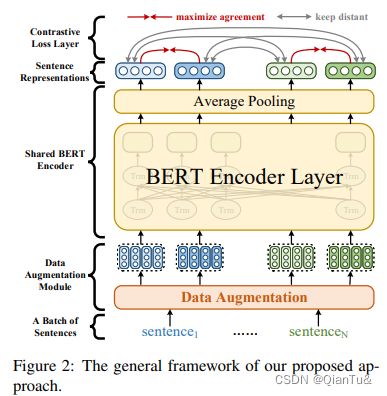

整个模型的结构包括三个部分:data argumentation、bert encoder、constractive loss module

在encoder选择中,使用的类似于bert的这种PLM模型。数据集采用的unsupervised dataset。

训练过程是在unsupervised dataset上,finetune M.

1.在数据增强模块,是采用transformation,进而能够生成同一个sample的positive pair。如果在一个batch中有N个sample,经过数据增强后,可以得到2N个samples。

2、在bert编码模块,是采用bert模型的最后一层的average pooling 作为了参与loss计算的semantic representation

3、在constractive loss layer,是要保持similarity 的samples的距离尽可能的近,而dissimilar的samples的距离尽可能的远。在这篇论文中:正例是通过data transformation得到的samples,负例是在一个batch中的其他的samples

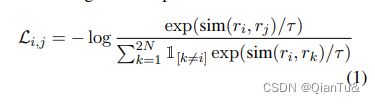

4、在损失函数设置,采用的是temperature-scaled cross-entropy loss .其中,temperature是为了控制控制logits的分布形状。对于既定的logits分布的形状,当温度系数变大,则 1/温度系数就变小, q·k/温度系数则会使得原来logits分布里的数值更加平滑,从而使得模型更加鲁棒。模型最终的损失函数时将一个batch中loss的average作为了final constractive loss。

3.3 数据增强手段

1)adversarial attack :在input samples 的embedding matricx空间内加入扰动,这种策略一般使用在监督条件下。

2)token shuffling: pass the shuffled position ids to the emdding layer while keep the order of the token ids unchanged

3) cutoff :有三种不同的情况,第一种是token cutoff ,random erase some tokens,第二种是feature dimensions (feature cutoff),第三种是token spans(span cutoff)。这个策略是直接在n*d的embedding space中使用的。

4)dropout:random drop elements in the token embedding layer by a specific probabiility and set their value to zero.

3.4 融入supervision信号

上述过程是在介绍模型如何在UNsupervision 情况下工作的,下面这部分是介绍模型在supervision机制下,怎么得到更加的semantic representation,进而更好用于下游任务。

以NLI 任务为例:

1.joint training:

Ljoint = Lce + αLcon

2.supervised training then unsupervised transfer

first train the model with Lce on NLI dataset, then use Lcon to fine tune it on the target dataset.

3.Joint training then unsupervised transfer

first train the model with the Ljoint on NLI dataset, then use Lcon to fine-tune it on the target dataset

3.5 模型实验

first obtain the representation of sentences by averaging the token embeddings at the last two layers, then we report the spearman correlation

实验模型:bert-base / bert-large

实验设置:max_seq_length_64

remove the dropout layer of bert but considering the cutoff 和dropout . ratio of token cutoff and feature cutoff is set to 0.15 and 0.2

The temperature τ of NT-Xent loss is set to 0.1, and the α is set to 0.15

optimizer :Adam

learning rate: 5e-7

batch size: 96

四、Ablation study

1、frequency的影响

2、data argumention strategy 的影响

3、few-shot setting下的结果

4、模型中参数的影响