企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)

目录

- 一、lamp架构

- 二、nginx的安装与配置

- 三、nginx的worker管理

- 四、nginx平滑升级

-

- 1.版本升级

- 2.版本回退

- 五、nginx负载均衡

-

- 1.配置nginx负载均衡

- 2.配置nginx备用服务器

- 3.配置nginx基于ip_hash的负载均衡模式

- 4.配置nginx基于cookie的负载均衡

一、lamp架构

1、lamp其实就是一组通常一起使用来运行动态网站或者服务器的自由软件,包括Linux(操作系统)、Apache(HTTP服务器)、MySQL(也指MariaDB,数据库软件)和PHP(有时也是指Perl或Python)的第一个字母,一般用来建立web应用平台;

2、除Linux外其它各部件本身都是各自独立的程序,但是因为经常被放在一起使用,拥有了越来越高的兼容度,共同组成了一个强大的Web应用程序平台。本次实验我们使用Nginx替代Apache, nginx相比较apache最明显的优势是轻量级、高并发,配置也较apache更简洁。

二、nginx的安装与配置

为了便于后续实验,给server1添加一个172.25.0网段的ip

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第1张图片](http://img.e-com-net.com/image/info8/927248604a964ddda4f18c10f5c2028a.jpg)

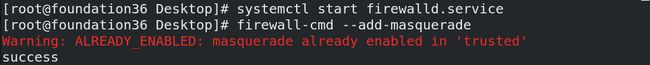

真机(172.25.254.36)打开火墙,开启地址伪装功能,使得虚拟机能够上网

真机添加一条iptables规则;

MASQUERADE的作用:从服务器的网卡上,自动获取当前ip地址来做NAT,这样不用指定SNAT的目标ip,不管现在eth0的出口获得了怎样的动态ip,MASQUERADE会自动读取eth0现在的ip地址然后做SNAT出去,这样就实现了很好的动态SNAT地址转换。

![]()

查看nat表所有链及所有规则,可以看到添加成功

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第2张图片](http://img.e-com-net.com/image/info8/ef7088eb76ff4bffafadceff7d065a6d.jpg)

此时server1就可以直接从服务器上获取所需文件

![]()

server1从服务器上下载nginx的源码压缩包nginx-1.20.1.tar.gz,解压后进入到nginx源码目录;

src/core存放着nginx的主干部分、基础数据结构和基础设施的源码

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第3张图片](http://img.e-com-net.com/image/info8/fce174a9674f46aea4018e44882fe7f8.jpg)

conf目录下由nginx的主配置文件nginx.conf

![]()

源码编译三部曲:配置(configure)、编译(make)、安装(make install);

配置:通过./configure --help查看配置选项

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第4张图片](http://img.e-com-net.com/image/info8/d4fb8cc447154a7e931a8871a0059cf0.jpg)

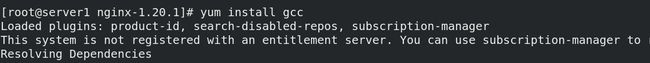

nginx源码文件,需要gcc等依赖文件进行编译

设置安装的路径为/usr/local/nginx,加上需要的功能模块;

运行后可以看到提示缺少PCRE

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第5张图片](http://img.e-com-net.com/image/info8/09b7e39c4f474a91a542f3450963f78b.jpg)

开发包以devel结尾

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第6张图片](http://img.e-com-net.com/image/info8/5aabf5344b8b48b1b29a8faa1e0f9999.jpg)

提示缺少openssl

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第7张图片](http://img.e-com-net.com/image/info8/fd76ab7d5f7842b3ab3b681b047d9305.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第8张图片](http://img.e-com-net.com/image/info8/11d829f5dbb14dbf8fb2eefe0edf0b23.jpg)

再次配置,显示成功

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第9张图片](http://img.e-com-net.com/image/info8/6956c5bd0b184d9b99d710770b1c1ccb.jpg)

在configure执行完后,它会生成一些中间文件,中间文件会放在objs目录下;

Makefile是一种配置文件,定义了一系列的规则来指定,哪些文件需要先编译,哪些文件需要后编译,哪些文件需要重新编译,甚至于进行更复杂的功能操作

![]()

执行编译(静态编译)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第10张图片](http://img.e-com-net.com/image/info8/fcf0259e3dcd4436b754fe5790995bb3.jpg)

编译成功

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第11张图片](http://img.e-com-net.com/image/info8/578377cc24af4c7cbeb93ba1ad3d0973.jpg)

将编译好的文件安装到指定路径

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第12张图片](http://img.e-com-net.com/image/info8/bc7ca043e0b14ebba4437e481b7bbbfc.jpg)

此时objs目录下可以看到 nginx文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第13张图片](http://img.e-com-net.com/image/info8/5f8a3ccac056463d8d5d1f39591125e5.jpg)

在我们指定的路径下也能看到编译好的nginx文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第14张图片](http://img.e-com-net.com/image/info8/7213ca6366f54b2fa94d32481056aa3a.jpg)

为方便nginx启动,设定软链接到/usr/local/sbin/(这样在开启nginx服务的时候就不需要进到目录下开启,软连接的方式可以方便开启全局nginx);

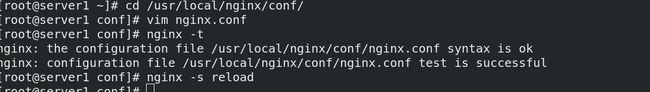

nginx -t:检查配置脚本是否运行正常

nginx:启动nginx,并查看端口

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第15张图片](http://img.e-com-net.com/image/info8/0190fc4e3720469fb47ccdef4160b2de.jpg)

测试:成功访问到nginx的默认发布目录

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第16张图片](http://img.e-com-net.com/image/info8/d2e9b790c5de4b09a5fbe864a8a6959a.jpg)

客户端访问测试

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第17张图片](http://img.e-com-net.com/image/info8/973ac623213949899f5e495bba788281.jpg)

注意当nginx进程已经启动时,再次启动就会出现以下提示

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第18张图片](http://img.e-com-net.com/image/info8/fe68bd6269d9408fabc617aaddc57bd4.jpg)

停止nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第19张图片](http://img.e-com-net.com/image/info8/e975cd0ed4224637962123eaeb4ad666.jpg)

当需要二次编译nginx时,必须先执行make clean(清除上次的make命令所产生的object文件(后缀为“.o”的文件)及可执行文件);

最后执行make install(因为文件已经复制过去,不需要再次复制)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第20张图片](http://img.e-com-net.com/image/info8/91e2a1460d954bee8d37130b268aa199.jpg)

关闭c语言编译debug(轻量化编译文件)

在此Debug模式模式会插入许多追踪和ASSERT之类的信息,在正常编译过程中结束,会产生几兆大小的包,我们可以在编译之前关闭debug模式,这样在编译结束,只会产生几百K左右的包大小。

#CFLAGS=“$CFLAGS -g” ##本行注释掉,关闭debug日志模式,

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第21张图片](http://img.e-com-net.com/image/info8/c033c046ac24493885d519949bcfe373.jpg)

显示 http response 的头信息,可以看到当前nginx版本

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第22张图片](http://img.e-com-net.com/image/info8/ef904a1b46f343baa438998713f5235d.jpg)

修改解压目录中的src/core/nginx.h

![]()

修改#define NGINX_VER(去掉版本)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第23张图片](http://img.e-com-net.com/image/info8/264b9ececb2347f1ae21710a4554b6a7.jpg)

重新进行配置、编译

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第24张图片](http://img.e-com-net.com/image/info8/00fb5528d74f4c3690018bcc4a01c7d7.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第25张图片](http://img.e-com-net.com/image/info8/e1a061bb83ff4557aa6f19bd352e1d6b.jpg)

执行编译,为了构建更加纯净的nginx脚本,不需要执行make install;

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第26张图片](http://img.e-com-net.com/image/info8/4f5af47ecafd48d5b0186e8de282a62d.jpg)

编译完成后,此时nginx大小为928k;

出现以下问题是因为没有关闭nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第27张图片](http://img.e-com-net.com/image/info8/06569072b63e47dc878970757256ce41.jpg)

alias,则可列出目前所有的别名设置,在cp指令前面加反斜杠可以不弹出是否覆盖的询问而直接覆盖;

关闭nginx后,将新生成的文件更换安装目录中的文件;

再次启动nginx,并查看头信息,可以看到头信息已经更改(看不到当前nginx版本号)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第28张图片](http://img.e-com-net.com/image/info8/1161748803624cc1bb951b840179c96f.jpg)

如果想要使用systemctl来控制nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第29张图片](http://img.e-com-net.com/image/info8/9283a87290a44a47b60e7e2f02d074ea.jpg)

首先需要在服务器上获取nginx.service文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第30张图片](http://img.e-com-net.com/image/info8/e10717e400324e77948124eeec63f2b9.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第31张图片](http://img.e-com-net.com/image/info8/17e04a9db5684d6489fce0679a443aa7.jpg)

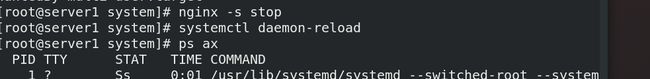

首先确保nginx没启动,如果启动,需要关闭nginx;

刷新服务列表

启动nginx并设置服务开机自启,此时就可以通过systemctl来控制nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第32张图片](http://img.e-com-net.com/image/info8/74a2c39df7334068adc0e3167c41f14d.jpg)

网页访问成功

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第33张图片](http://img.e-com-net.com/image/info8/e691bd520bd84dffa7c5b1b4bae4ae30.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第34张图片](http://img.e-com-net.com/image/info8/8e888090b0134cdf975cd40b268440ee.jpg)

三、nginx的worker管理

为了便于实验效果,首先修改server1的cpu的个数为2,内存为2048;

用cpu的个数控制nginx的work进程个数;

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第35张图片](http://img.e-com-net.com/image/info8/08b1fc46a7404a179b0b2075633f1f23.jpg)

增加一个nginx用户

![]()

修改nginx主配置文件nginx.conf,设定用户为nginx,worker进程数为1

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第36张图片](http://img.e-com-net.com/image/info8/8b0631072e3043d493f81b52a3ff24bc.jpg)

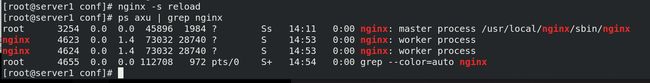

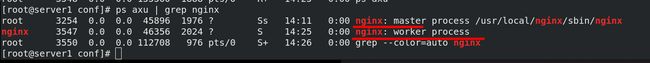

nginx -s reload :平滑重启,不会强制结束正在工作的连接,需要等所有连接都结束才会重启

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第37张图片](http://img.e-com-net.com/image/info8/50eea53f3ab34f179b77db9be02de712.jpg)

可以看到nginx的一个主控制端和被控制的一个worker

nginx并发优化:继续修改主配置文件,设定工作进程数为2

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第38张图片](http://img.e-com-net.com/image/info8/8f54f26821a648f2b0cb15c000df3ef0.jpg)

重启nginx后,查看nginx的worker进程;

当我们kill掉其中一个worker进程后,由于配置文件设定的worker进程数为2 ,因此会自动再运行一个新的worker进程

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第39张图片](http://img.e-com-net.com/image/info8/ca2eab8974604b45b9e02ecfc9d720d9.jpg)

当设定worker进程数为auto后,会自动根据系统cpu的数量管理worker进程数

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第40张图片](http://img.e-com-net.com/image/info8/b266ffc13ac14f3ca05df2a3cbcbbf80.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第41张图片](http://img.e-com-net.com/image/info8/838468bb417b4eb0bc06c5b42a264e48.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第42张图片](http://img.e-com-net.com/image/info8/e07843e7294643ed80b4ae6deae9a014.jpg)

查看server1 cpu的详细信息

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第43张图片](http://img.e-com-net.com/image/info8/0aa4ce7dc74441c4b6797affdddbe07c.jpg)

Nginx默认没有开启利用多核cpu,我们可以通过增加worker_cpu_affinity配置参数来充分利用多核cpu的性能;

cpu是任务处理,计算最关键的资源,cpu核越多,性能就越好;

2核cpu,开启2个进程 设定worker_cpu_affinity 01 10(将cpu和worker数目绑定);

4个cpu,开启4个进程 设定worker_cpu_affinity 0001 0010 0100 1000;

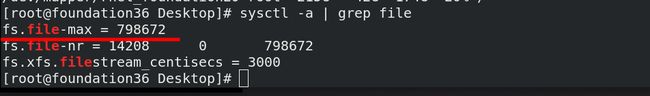

worker_connections:设定每一个worker进程能并发处理(发起)的最大连接数为65535(包含所有连接数),不能超过最大文件打开数;

要求内核支持最大文件打开数>系统支持最大文件打开数>Worker支持最大文件打开数

![]()

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第44张图片](http://img.e-com-net.com/image/info8/b7da4affb6554252ae05f9ad50438491.jpg)

查看server1内核支持的最大文件打开数

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第45张图片](http://img.e-com-net.com/image/info8/bc7f623c55754608b2664218d3c267b3.jpg)

查看真机内核支持的最大文件打开数

显示系统目前资源限制的设定,可以看到系统支持的最大文件打开数为1024

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第46张图片](http://img.e-com-net.com/image/info8/19ba3dc89a29430b8d899838b1cf2e72.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第47张图片](http://img.e-com-net.com/image/info8/593fcd4df3864330949b2192aef1f660.jpg)

![]()

修改系统的最大文件打开数

![]()

*: 表示所有的用户,也可以指定指定的用户或用户组

soft: 表示应用软件级别限制的最大可打开的文件数的限制

hard: 表示操作系统级别限制的最大可打开的文件数的限制

四、nginx平滑升级

1.版本升级

使用nginx1.21进行版本升级,为避免升级时掉线,采用平滑升级;

首先server1连接服务器,下载nginx1.21.1版本的源代码编译包

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第49张图片](http://img.e-com-net.com/image/info8/bf072238a3674c17acb36f5edbf8ed43.jpg)

同样的关闭gcc的debug

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第50张图片](http://img.e-com-net.com/image/info8/f42c072851384577bc83819d5167b471.jpg)

进行源代码安装第一步,同样的对即将安装的软件进行配置

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第51张图片](http://img.e-com-net.com/image/info8/86f2ed7bd2434fcc85c9b46e29e7430a.jpg)

编译,不执行make install

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第52张图片](http://img.e-com-net.com/image/info8/b5527304561e42e6931f64df43e20c1d.jpg)

此时objs目录就会生成新的nginx二进制文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第53张图片](http://img.e-com-net.com/image/info8/c140769f5bc94b9eb5e30d52c3f26928.jpg) 将nginx旧版本文件进行备份

将nginx旧版本文件进行备份

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第54张图片](http://img.e-com-net.com/image/info8/b4f68bec324f4bc6b5358bd98e1e1a58.jpg)

将新生成的nginx文件覆盖安装目录下的旧的nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第55张图片](http://img.e-com-net.com/image/info8/4713efb90924469dba9524e295d239c7.jpg)

此时curl查看发现仍然是旧版本的nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第56张图片](http://img.e-com-net.com/image/info8/13854ed445a44ba4ad195245177f7857.jpg)

需要用kill -USR2 老版本的进程号 ,升级新程序,从而产生新版本的master和worker

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第57张图片](http://img.e-com-net.com/image/info8/e6807166b0314ae0aae5682803c3779b.jpg)

kill -WINCH 老版本的进程号,可以关闭旧版本的worker进程但保留主进程:为了回退;

测试,已经升级到1.20版本

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第58张图片](http://img.e-com-net.com/image/info8/e8f4cd3c254645d194f1dac940e6186d.jpg)

2.版本回退

版本回退:

还原nginx程序:# cp -f nginx.old nginx

唤醒原进程:# kill -HUP 旧版本id

回收新版本的worker进程: kill -WINCH 新版本id

关闭新版本主进程: kill -QUIT 29761

首先将备份的旧版本nginx文件覆盖执行目录的nginx;

kill -HUP 旧版本id:唤醒原进程;

kill -WINCH 新版本id:回收新版本的worker进程;

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第59张图片](http://img.e-com-net.com/image/info8/462d9206d5b744029cae4860543980c6.jpg)

curl测试,成功完成平滑回退

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第60张图片](http://img.e-com-net.com/image/info8/e88a7839291c4bf28651149c0d2e6ce9.jpg)

最后关闭新版本主进程

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第61张图片](http://img.e-com-net.com/image/info8/736f0c70fd94432ab8f61bd271b4219c.jpg)

五、nginx负载均衡

1.配置nginx负载均衡

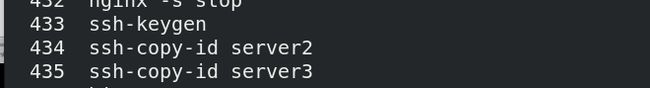

server1对server2/3进行免密认证,便于后续操作

将server1的nginx目录传输给server2/3

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第62张图片](http://img.e-com-net.com/image/info8/21b5d4bbd7c8448d97acd23b8d2c15a9.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第63张图片](http://img.e-com-net.com/image/info8/dfee24cd05db40c284b43df7fb34811e.jpg)

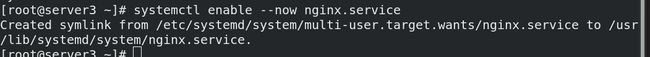

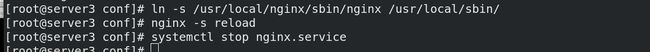

将server1的nginx.service文件传输给server2/3,使得server2/3也可以使用systemctl 命令来方便操作nginx的启动、停止和重启命令

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第64张图片](http://img.e-com-net.com/image/info8/dc2ad54c47a248fc869a049d5e684996.jpg)

server2/3分别执行:创建nginx用户、刷新服务列表、启动并设置nginx服务开机自启

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第65张图片](http://img.e-com-net.com/image/info8/a09ff5b5f1d8400aa9fcb0a7bd3dbb23.jpg)

![]()

server2/3修改默认发布页面

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第66张图片](http://img.e-com-net.com/image/info8/1b7ebbc715a640b9b49fd503eea43a7a.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第67张图片](http://img.e-com-net.com/image/info8/79afc73a6106475599288431bdb0f5ba.jpg)

server1测试访问server2/3成功;

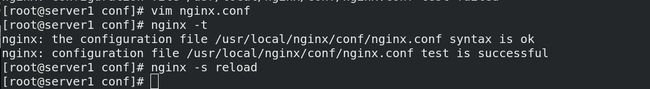

server1编辑nginx主配置文件,将均衡负载模块加入

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第68张图片](http://img.e-com-net.com/image/info8/3a738d8cd69d490ea1533469c1b709d7.jpg)

在http加入upstream模块,设定反向代理负载均衡器westos;

upstream表示负载服务器池

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第69张图片](http://img.e-com-net.com/image/info8/271b418b400b4686beba60c309862899.jpg)

location 指令的作用:根据用户请求的URI来执行不同的应用,URI就是根据用户请求到的网址URL进行匹配;

server_name :代理的服务域名;

location:设定当外部访问www.westos.org这个域名时,nginx会把所有请求都发送到upstream定义的服务器节点池(westos)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第70张图片](http://img.e-com-net.com/image/info8/6486f0ef52394ddb894e4b29bcb14700.jpg)

检测语法无误后,刷新服务使设定生效

在真机进行地址解析

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第71张图片](http://img.e-com-net.com/image/info8/2f87a4c7fd634395a6a64bf55b9d7028.jpg)

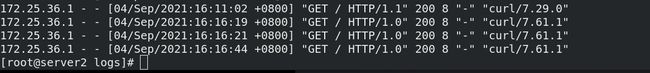

测试,可以看到访问可以实现负载均衡

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第72张图片](http://img.e-com-net.com/image/info8/eca8431dc95b43a488336539ee7f54e6.jpg)

查看nginx日志

继续编辑nginx主配置文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第73张图片](http://img.e-com-net.com/image/info8/4ce625a444fb4444bb036607d1fbe0f6.jpg)

设定服务器server2的权重为2

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第74张图片](http://img.e-com-net.com/image/info8/85788b7d9fad4027a3f7b7c6c1cf1f5d.jpg)

可以看到,访问时server2出现的次数大概是server3的两倍

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第75张图片](http://img.e-com-net.com/image/info8/05eca900cef84f3aa60c8057656f96ab.jpg)

2.配置nginx备用服务器

继续修改配置文件,设定server1为backup。只有当其他节点全部无法连接的时候,nginx才会启用这个节点。一旦有可用的节点恢复服务,该节点则不再使用,又进入后备状态。

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第76张图片](http://img.e-com-net.com/image/info8/3a8d6ff14a51474bbeb6e3d22e069326.jpg)

server1测试访问

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第77张图片](http://img.e-com-net.com/image/info8/1914aa8207ff4d6ea053cdcdc9aea1c0.jpg)

更改server1默认发布页面

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第78张图片](http://img.e-com-net.com/image/info8/8fda896966214ec48a15bbf11e933280.jpg)

测试访问

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第79张图片](http://img.e-com-net.com/image/info8/de1d07beeecd4e1d857fcacc4009e353.jpg)

关闭server2的nginx服务

![]()

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第80张图片](http://img.e-com-net.com/image/info8/20afbe3a80cc4f35bc4c6355bd37516f.jpg)

关闭server3的nginx服务

可以看到备用机server1启动成功

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第81张图片](http://img.e-com-net.com/image/info8/e6d93c88b78e457891bb150da5e2ef6a.jpg)

当server2的nginx服务开启后

![]()

备用节点server1将不再提供服务

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第82张图片](http://img.e-com-net.com/image/info8/eac61f31d21046afbc1b7c9620b6dee9.jpg)

![]()

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第83张图片](http://img.e-com-net.com/image/info8/bd418b7e13874f1eacbbe95aee01a98c.jpg)

3.配置nginx基于ip_hash的负载均衡模式

ip_hash:通过客户端请求ip进行hash,再通过hash值选择后端server;

当你服务端的一个特定url路径会被同一个用户连续访问时,如果负载均衡策略还是轮询的话,那该用户的多次访问会被打到各台服务器上,这显然并不高效(会建立多次http链接等问题)。所以,此类场景可以考虑采用nginx提供的ip_hash策略。既能满足每个用户请求到同一台服务器,又能满足不同用户之间负载均衡。

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第84张图片](http://img.e-com-net.com/image/info8/13f3e48069334aca9598cc5b00998813.jpg)

语法检测出错,这是因为ip_hash不能与backup一起用

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第85张图片](http://img.e-com-net.com/image/info8/fba2fdc4423a4a529764e0cdabe2a6fd.jpg)

可以看到当客户端对指定域名进行多次服务请求时, 只有server3对该客户端提供服务

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第86张图片](http://img.e-com-net.com/image/info8/f765e17af5544db2af471c721af389d2.jpg)

4.配置nginx基于cookie的负载均衡

Cookie是某些网站为了辨别用户身份,进行Session跟踪而储存在用户本地终端上的数据(通常经过加密),由用户客户端计算机暂时或永久保存的信息;

在多台后台服务器的环境下,为了确保一个客户只和一台服务器通信,势必使用长连接。常见的有使用nginx自带的ip_hash来做,,但如果前端是CDN,或者说一个局域网的客户同时访问服务器,导致出现服务器分配不均衡,以及不能保证每次访问都粘滞在同一台服务器。因此可以采用基于cookie负载均衡,能保证每次都锁定同一台服务器;

server1从服务器下载额外的压缩包辅助cookie算法;

下载unzip压缩工具

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第87张图片](http://img.e-com-net.com/image/info8/3003e34d3dcb4acba4daa63e7c2f8a52.jpg)

解压文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第88张图片](http://img.e-com-net.com/image/info8/cfc596f1468c4ef0a66e2c8750a99ace.jpg)

修改配置文件

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第89张图片](http://img.e-com-net.com/image/info8/0ea16339800144aeb9588a9a26737a8b.jpg)

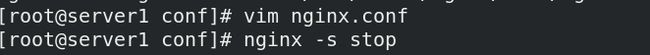

语法检测失败,因为此时并没有cookie软件模块

所以先将sticky注释

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第90张图片](http://img.e-com-net.com/image/info8/9ab5feb903704553abf1bc645a3e5d38.jpg)

停止nginx服务

重新配置,加上所需模块

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第91张图片](http://img.e-com-net.com/image/info8/88a35852c3bb42c9939155590ee452cf.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第92张图片](http://img.e-com-net.com/image/info8/9c4e6367f1fd4a8fb0b588d2de6b6c5a.jpg)

make编译,将新的nginx覆盖旧的nginx

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第93张图片](http://img.e-com-net.com/image/info8/d40f20c43d294e2682f63eafd2d6fd84.jpg)

打开sticky设定

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第94张图片](http://img.e-com-net.com/image/info8/f532af16d1314413bab6abbe9a3ab76c.jpg)

刷新服务

网页访问www.westos.org,按F12,即可查看到cookie访问记录,且采用cookie的方式访问时会锁定服务器

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第95张图片](http://img.e-com-net.com/image/info8/c81c0dba550d419c98d85bd5a740e38e.jpg)

再按F5刷新页面,或者手动删除当前session,即可看到server2的cookie访问记录

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第96张图片](http://img.e-com-net.com/image/info8/0971dee371f440bf914acd4078323e4c.jpg)

![企业运维 --- LAMP架构(nginx [1] 源码编译安装、平滑升级、负载均衡)_第48张图片](http://img.e-com-net.com/image/info8/3e125f2f9be143a2aef8e53d4157cef9.jpg)