浅谈Stable-Diffusion(AI绘图)的基础和使用

文章目录

- (零)AI绘图

- (一)简单介绍

-

- (1.1)Stable-Diffusion

- (1.2)Stable-Diffusion WEB UI

- (1.3)SD-WebUI启动器和整合包

- (二)使用

-

- (2.1)启动 & 控制台 & WEBUI

- (2.2)基础模型(stable-diffusion模型)

-

- (2.2.1)模型文件位置

- (2.2.2)模型选择 & 模型预览图

- (2.3)小模型(LoRA模型)

-

- (2.3.1)模型文件位置

- (2.3.2)模型选择 & 模型预览图

- (2.4)小模型(嵌入式模型/Embedding/Textual Inversion)

- (2.5)小模型(超网络模型/Hypernetwork)

- (2.6)提示词 & 模板风格

-

- (2.6.1)提示词

- (2.6.2)模板风格

- (2.7)图片文件输出

- (2.6)参数和其它

-

- (2.6.1)分辨率

- (2.6.2)随机种子

- (2.6.3)采样方法

- (2.6.4)其它

(零)AI绘图

最近比较热门,就是可以单纯通过输入一段文字(提示词),或者通过一张图片,生成新的绘图作品。

根据基础模型和人物模型的不同,可以生成动漫,Q版,3D,仿真各种类型的任意图片。

例子太多了,可以自行在网上搜出一大把。

上面例子还是习惯的替换成我老婆的脸,至少不重复。

(一)简单介绍

(1.1)Stable-Diffusion

稳定扩散(Stable Diffusion)原名是潜扩散模型(Latent Diffusion Model, LDM)。

引用:”扩散模型的兴起可以被视为人工智能生成艺术领域最近取得突破的主要因素……”

感兴趣可以参考这篇: 《Diffusion 和Stable Diffusion的数学和工作原理详细解释》

当然,我们通常谈到这个名字时,指的是具体的项目:https://github.com/CompVis/stable-diffusion

这类Python对不搞计算机和人工智能的同学来说太繁琐了,

其实对于研究人员和科学家也繁琐,要不怎么有Anaconda和Jupyter Notebook这类工具呢……

这个是开源项目,有兴趣的可以自己研究。

(1.2)Stable-Diffusion WEB UI

所以不通过命令行,不去管各种环境,对普通大众才是最简单的使用方式。

于是我们一般用的都是 Stable-Diffusion WEB UI :浏览器的Stable-Diffusion用户界面(基于Gradio库)。

项目位置:https://github.com/AUTOMATIC1111/stable-diffusion-webui

(1.3)SD-WebUI启动器和整合包

估计是考虑到WEBUI也需要简单的配置,以及需要模型,以及各种懒人的懒是无下限的。

所以居然还有大神制作了启动器,这下真的可以”一键使用“了。

SD-WebUI启动器 的官网……呃

作者自己写的唯一发布途径嘛:https://www.bilibili.com/video/BV1ne4y1V7QU

从里面你可以找到启动器本身,以及作者自己推荐的:NovelAI模型(7GB)整合包的下载连接。

简单说通过整合包,你可以不懂任何原理,就开始AI作图了。

启动器还可以管理SD-WebUI的版本,各种模型,以及插件。

(二)使用

(2.1)启动 & 控制台 & WEBUI

假设你是通过上面的启动器的,选择了适合自己的显卡显存,至少有一个Stable-Diffusion模型(比如整合包那个)。

然后点击”一键启动“了,则会出现一个控制台(CMD窗口)。

控制台中如果没有出错的信息,默认会自动打开浏览器,出现Stable-Diffusion的页面。

由于我们用了整合包里面的扩展插件,所以这里页面是中文的了。

文生图这页里面,简单输入提示词,就可以成功生成图片了。

PS:图生图也是一样的,只是需要选一张已有的图片作为参考。

OK,大功告成,洗洗睡觉了……

(2.2)基础模型(stable-diffusion模型)

啊嘞嘞!等一下,你会说左上角能选的,根本没有我用的这个模型,OK?

是的,如果你下载的是整合包,则只有NovelAI模型。

因为是个动漫模型不能生成上面例子里面的仿真的猫猫狗狗。

基础模型(stable-diffusion模型)决定了生成图片的最基本风格,

所以你可以多找几个基础模型来生成动漫/真实的不同风格的图片。

需要注意的是,在你决定商用之前需要仔细看这些模型的协议和模型内容,是否版权完善。

关于模型和下载,你可以参考这里:https://openai.wiki/painting/sd

或者在抱脸一类模型网站上下载优秀的模型,比如国风3:https://huggingface.co/xiaolxl/GuoFeng3

(2.2.1)模型文件位置

请注意这一步提到的是基础模型(stable-diffusion模型),通常都是几个GB大小。

通常名称是 xxx.ckpt 或者 xxx.safetensors(如果有.safetensors可优先选它)。

将下载的模型放入{你的项目位置}\models\Stable-diffusion 目录当中,

刷新一下或者下次打开就可以看到了。

(2.2.2)模型选择 & 模型预览图

One more thing……

可以点击这个红色,呃粉色?的(Show extra networks)按钮。

然后选择 模型(ckpt) 这一页,通过点击预览图也可以切换基础模型。

作用和在左上角下拉列表选择基础模型是一样的。

最开始也许没有预览图,你可以选个模型生成一张图。

然后鼠标指向这个模型预览图名字那里,点击出现的”用当前生成图片替换预览“,这样就有预览图了。

(2.3)小模型(LoRA模型)

LoRA: Low-Rank Adaptation (of Large Language Models)是一种使用少量图像来训练模型的方法。

我们简称它为小模型,因为它是对基础模型(大模型)的微调,不用改变整个大模型就能改变人物和风格。

可以参考:https://zhuanlan.zhihu.com/p/612992813 或其他资料,这里咱先不讨论原理。

最近的SD-WEB UI已经原生支持了LoRA模型,不再需要插件了。

- LoRA模型大小从几MB到100多MB。

- 可以加载多个不同的LoRA模型配合不同的权重叠加使用。

- 训练比较快(几到几十分钟),使用少量图像(10多张),效果比较好。

- 目前SD-WEB UI不能训练LoRA模型。

- 适合训练人物。

训练请参考下面的项目,训练本身内容也很多,这里不详细写。

脚本训练:https://github.com/Akegarasu/lora-scripts

GUI训练:https://github.com/bmaltais/kohya_ss

我们可以简单理解为,这是个性化的人物模型。

没有或不使用LoRA模型也是可以生成图片的,所以这一章节可以跳过。

下载LoRA模型同样可以参考这里:https://openai.wiki/painting/sd

或者国风3也提供了LoRA模型:https://huggingface.co/xiaolxl/GuoFeng3

(2.3.1)模型文件位置

请注意这一步提到的是loRA模型,一般几十到几百MB大小。

文字里面通常包括lora字样,以便区别基础模型。

通常名称是xxx.safetensors。

将LoRA模型放入{你的项目位置}\models\Lora 目录当中,

同理刷新一下或者下次打开就可以看到了。

(2.3.2)模型选择 & 模型预览图

和基础模型一样击这个粉色的(Show extra networks)按钮。

然后选择 LoRA 这一页。

生成预览图的方式和基础模型一样,这里就不重复说了。

选用模型的方式是点击模型,这时提示词(prompt)中就会加入这个LoRA模型的提示词,

比如吉卜力风格的LoRA就是加入 ,再点击一下同一个模型,提示词中就会取消它。

可以用多个LoRA模型的提示词噢!

(2.4)小模型(嵌入式模型/Embedding/Textual Inversion)

【抄的】是一种使用文本提示来训练模型的方法。它根据模型引用给定的图像并选择最匹配的图像。

现在有了LoRA模型,大家应该不会再用它来训练了吧。

- Embedding模型大小只有几十KB。

- 可不能设置权重,似乎关键词位置也会影响效果。

- 训练很慢(整天),效果……可能我不太会吧,和LoRA用同样的资源图片训练20000多迭代后,人物依然怪异得很。

- 在SD-WEB UI里可以直接训练Embedding模型,

- 适合训练人物。

- 将Embedding模型放入

{你的项目位置}\embeddings目录当中,

(2.5)小模型(超网络模型/Hypernetwork)

(抄的)是一种使用神经网络来生成模型参数的方法。它可以用来从模型内部找到更多相似的东西,使得生成为近似内容图像。

- Hypernetwork模型大小大约几十MB。

- 我没试过训练它,抱歉……

- 在SD-WEB UI里可以直接训练Hypernetwork模型,

- 适合训练风格,画风。

- 将Hypernetwork模型放入

{你的项目位置}\models\Hypernetwork目录当中,

(2.6)提示词 & 模板风格

(2.6.1)提示词

提示词是核心,选择合适的提示词才能生成更好的图片。

提示词需要用英文的,当然也有中文提示词的相关项目,有兴趣可以自己研究。

输入提示词时候,有时可以看到联想的内容,这也是插件的功劳。

提示词 prompt(上面的框框)是生成什么样的图片,

反向提示词 negative prompt(下面的框框)则是避免什么内容。

我们也可以通过 图片信息 这一页,查看一张AI生成的图片(原图)是用哪些提示词,哪些参数生成的。

以此来了解别人生成的很不错的图片的信息,自己用来参考。

(2.6.2)模板风格

模板风格就是一组有名字的提示词+反向提示词。

我们可以保存多组提示词切换着用。

选择模板风格后,点一下这个小本子一样的图标,就可以把选中的模板风格的提示词内容,加入到左边的输入框中。

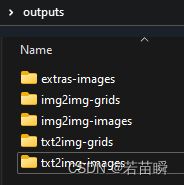

(2.7)图片文件输出

输出的图片会保存到{你的项目位置}\outputs的子目录中。

比如文生图就是txt2img,图生图就是img2img。

单张图片在xxx-images下面。

批量图片会合成一张大的网格图放在xxx-grids下面。

(2.6)参数和其它

(2.6.1)分辨率

分辨率好像没什么可以说的……

分辨率低生成比较快,分辨率高则比较慢,做墙纸一般需要1920x1080。

有些模型有分辨率的上限和下限,看说明,最好不要超过。

没办法生成太大的图,需要大图可以再次缩放,这里没必要写了噢。

(2.6.2)随机种子

通常是-1。

如果你生成了一张很满意的图片,但是想继续微调,可以固定用上次的随机种子再次生成。

(2.6.3)采样方法

似乎模型都推荐用DPM++ SDE Karras 呢。

(2.6.4)其它

AI作图经常手脚不对,其实也是可以调整的。

这些等我搞懂后,再另外记录一篇吧,好累啊,先这样了。