- spark电影数据分析系统 Springboot协同过滤-余弦函数推荐系统 爬虫2万+数据 大屏数据展示 + [手把手视频教程 和 开发文档]

QQ-1305637939

毕业设计大数据毕设计算机毕业设计sparkspringboot爬虫大数据电影推荐电影分析

spark电影数据分析系统Springboot协同过滤-余弦函数推荐系统爬虫2万+数据大屏数据展示+[手把手视频教程和开发文档【功能介绍】1.java爬取【豆瓣电影】网站中电影数据,保存为data.csv文件,数据量2万+2.data.csv上传到hadoop集群环境3.MR数据清洗data.csv4.Spark汇总处理,将Spark处理的结果数据保存到本地Mysql数据库中5.Springboo

- 玩转至轻云大数据平台-docker部署篇

fanciNate454

大数据docker

产品介绍至轻云是一款超轻量级、企业级大数据计算平台,基于Spark生态打造。一键部署,开箱即用。快速实现大数据离线ETL、Spark计算、实时计算、可视化调度、自定义接口、数据大屏以及自定义表单等多种功能,为企业提供高效便捷的大数据解决方案。至轻云有什么特点呢?又能怎么玩呢?产品特点开源轻量化云原生架构:兼容云原生架构,支持Docker、Rancher平台的快速部署。国内镜像下载:可直接从阿里云镜

- hadoop常用命令

我要用代码向我喜欢的女孩表白

hadoopnpm大数据

Yarn查看提交到资源调度器的任务(任何用yarn资源的都可以看,比如spark、tez、mapreduce)看正在运行的yarn任务yarnapplication-list杀死对应的yarn任务yarnapplication-kill{application_Id}(id可以通过-list看到)hdfs查看hdfs目录hdfsdfs-ls/(查看本集群的目录)hdfsdfs-lshdfs://i

- 厦门租房信息分析展示(pycharm+python爬虫+pyspark+pyecharts)(踩坑记录)

吃西红柿的鸡蛋

大数据hadoopsparkpython

厦门租房信息分析展示(pycharm+python爬虫+pyspark+pyecharts)(踩坑记录)项目地址http://dblab.xmu.edu.cn/blog/2307/踩坑:Spark分析文件rent_analyse.py改变Spark读取csv文件的写法sparkContext=SparkContext("local","rent_analyse")sqlContext=SQLCon

- Hadoop 和 Spark 的内存管理机制分析

王子良.

经验分享hadoopspark大数据

欢迎来到我的博客!非常高兴能在这里与您相遇。在这里,您不仅能获得有趣的技术分享,还能感受到轻松愉快的氛围。无论您是编程新手,还是资深开发者,都能在这里找到属于您的知识宝藏,学习和成长。博客内容包括:Java核心技术与微服务:涵盖Java基础、JVM、并发编程、Redis、Kafka、Spring等,帮助您全面掌握企业级开发技术。大数据技术:涵盖Hadoop(HDFS)、Hive、Spark、Fli

- 大数据学习(五):如何使用 Livy提交spark批量任务--转载

zuoseve01

livy

Livy是一个开源的REST接口,用于与Spark进行交互,它同时支持提交执行代码段和完整的程序。Livy封装了spark-submit并支持远端执行。启动服务器执行以下命令,启动livy服务器。./bin/livy-server这里假设spark使用yarn模式,所以所有文件路径都默认位于HDFS中。如果是本地开发模式的话,直接使用本地文件即可(注意必须配置livy.conf文件,设置livy.

- Spark Livy 指南及livy部署访问实践

house.zhang

大数据-Spark大数据

背景:ApacheSpark是一个比较流行的大数据框架、广泛运用于数据处理、数据分析、机器学习中,它提供了两种方式进行数据处理,一是交互式处理:比如用户使用spark-shell,编写交互式代码编译成spark作业提交到集群上去执行;二是批处理,通过spark-submit提交打包好的spark应用jar到集群中进行执行。这两种运行方式都需要安装spark客户端配置好yarn集群信息,并打通集群网

- 大数据学习(四):Livy的安装配置及pyspark的会话执行

猪笨是念来过倒

大数据pyspark

一个基于Spark的开源REST服务,它能够通过REST的方式将代码片段或是序列化的二进制代码提交到Spark集群中去执行。它提供了以下这些基本功能:提交Scala、Python或是R代码片段到远端的Spark集群上执行;提交Java、Scala、Python所编写的Spark作业到远端的Spark集群上执行;提交批处理应用在集群中运行。从Livy所提供的基本功能可以看到Livy涵盖了原生Spar

- 探索数据科学新边界:Apache Livy 开源项目详解

毕艾琳

探索数据科学新边界:ApacheLivy开源项目详解incubator-livyApacheLivyisanopensourceRESTinterfaceforinteractingwithApacheSparkfromanywhere.项目地址:https://gitcode.com/gh_mirrors/in/incubator-livyApacheLivy是一个为ApacheSpark提供的

- 大数据公司 Databricks 详解

Bj陈默

大数据

Databricks是一家在大数据和人工智能领域具有重要影响力的美国企业软件公司,以下是关于它的详细技术解析:1.起源与背景:Databricks成立于2013年,由来自加州大学伯克利分校AMP实验室的Spark大数据处理系统的多位创始人联合创立,包括AliGhodsi、AndyKonwinski、IonStoica、PatrickWendell、ReynoldXin、MateiZaharia、A

- 全面解读 Databricks:从架构、引擎到优化策略

克里斯蒂亚诺罗纳尔多阿维罗

架构spark大数据

导语:Databricks是一家由ApacheSpark创始团队成员创立的公司,同时也是一个统一分析平台,帮助企业构建数据湖与数据仓库一体化(Lakehouse)的架构。在Databricks平台上,数据工程、数据科学与数据分析团队能够协作使用Spark、DeltaLake、MLflow等工具高效处理数据与构建机器学习应用。本文将深入介绍Databricks的平台概念、架构特点、优化机制、功能特性

- 使用 Hadoop 实现大数据的高效存储与查询

王子良.

经验分享大数据hadoop分布式

欢迎来到我的博客!非常高兴能在这里与您相遇。在这里,您不仅能获得有趣的技术分享,还能感受到轻松愉快的氛围。无论您是编程新手,还是资深开发者,都能在这里找到属于您的知识宝藏,学习和成长。博客内容包括:Java核心技术与微服务:涵盖Java基础、JVM、并发编程、Redis、Kafka、Spring等,帮助您全面掌握企业级开发技术。大数据技术:涵盖Hadoop(HDFS)、Hive、Spark、Fli

- Spark 源码分析(一) SparkRpc中序列化与反序列化Serializer的抽象类解读 (正在更新中~)别人能写出来的,你也能行!多学习别人的思路,形成自己的思路,高薪工作奔你而来!

小白的大数据历程

Spark源码解析开发语言spark大数据分布式scala

后一篇链接在这接上一章请先看解读序列化抽象类第一部分(这是一个链接)目录接上一章请先看解读序列化抽象类第一部分2.Java序列化实现类JavaSerializer(1)JavaSerializationStream类代码实际例子1:序列化(2)JavaDeserializationStream代码实际例子2:反序列化Spark源码下类图在学习过程中,抓住主要问题,请思考问题为什么Kryo序列化更加

- Spark 源码分析(一) SparkRpc中序列化与反序列化Serializer的抽象类解读 (java序列化部分完结,正在更新RpcEnv部分~)

小白的大数据历程

Spark源码解析sparkjavapython

目录(3)JavaSerializerInstance定义了一个Java序列化实例(1)构造方法参数(2)方法1:serializeStream(3)方法2:deserializeStreamdefaultClassLoader(4)方法3:deserializeStreamloader(5)方法4:serialize(6)方法5:deserializeloader(7)方法6:deseriali

- 大数据-257 离线数仓 - 数据质量监控 监控方法 Griffin架构

武子康

大数据离线数仓大数据数据仓库java后端hadoophive

点一下关注吧!!!非常感谢!!持续更新!!!Java篇开始了!目前开始更新MyBatis,一起深入浅出!目前已经更新到了:Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume(已更完)Sqoop(已更完)Zookeeper(已更完)HBase(已更完)Redis(已更完)Kafka(已更完)Spark(已更完)Flink(已更完)ClickHouse(已

- pyspark 中删除hdfs的文件夹

TDengine (老段)

大数据sparkhadoophdfsmapreduce

在pyspark中保存rdd的内存到文件的时候,会遇到文件夹已经存在而失败,所以如果文件夹已经存在,需要先删除。搜索了下资料,发现pyspark并没有提供直接管理hdfs文件系统的功能。寻找到一个删除的方法,是通过调用shell命令hadoopfs-rm-f来删除,这个方法感觉不怎么好,所以继续找。后来通过查找hadoophdfs的源代码发现hdfs是通过java的包org.appache.had

- Python 爬虫:获取网页数据的 5 种方法

王子良.

经验分享pythonpython开发语言爬虫

欢迎来到我的博客!非常高兴能在这里与您相遇。在这里,您不仅能获得有趣的技术分享,还能感受到轻松愉快的氛围。无论您是编程新手,还是资深开发者,都能在这里找到属于您的知识宝藏,学习和成长。博客内容包括:Java核心技术与微服务:涵盖Java基础、JVM、并发编程、Redis、Kafka、Spring等,帮助您全面掌握企业级开发技术。大数据技术:涵盖Hadoop(HDFS)、Hive、Spark、Fli

- python捕获异常

青云游子

python

try:name="aaa"id="aaa"exceptExceptionase:print("任务报错")print(str(e))print(str(traceback.print_exc()))spark.sql("""insertintotabledim.aaaselect'1','666','{name}','{id}',null,null,null,null,current_times

- Spark任务提交流程

尘世壹俗人

大数据Spark技术大数据

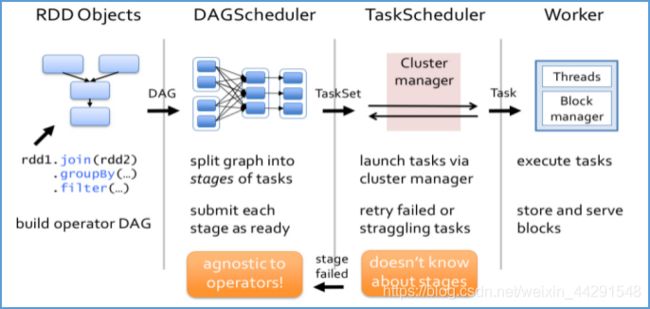

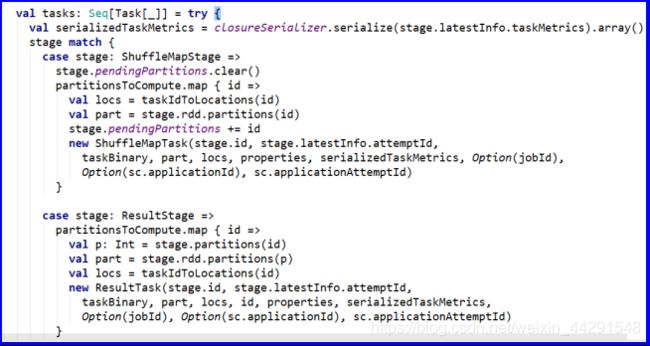

当包含在applicationmaster中的spark-driver启动后,会与资源调度平台交互获取其他执行器资源,并通过反向注册通知对应的node节点启动执行容器。此外,还会根据程序的执行规划生成两个非常重要的东西,一个是根据spark任务执行计划生成n个ADG有向无环图,另一个是根据有向无环图生成对应的taskset,也可以统称为stage,ADG和taskset由于宽窄依赖以及程序的复杂度

- spark读取、写入Clickhouse以及遇到的问题

Alex_81D

大数据基础大数据从入门到精通clickhousespark

最近需要处理Clickhouse里面的数据,经过上网查找总结一下spark读写Clickhouse的工具类已经遇到的问题点。具体Clickhouse的讲解本篇不做讲解,后面专门讲解这个。一、clickhouse代码操作话不多说直接看代码1.引入依赖:ru.yandex.clickhouseclickhouse-jdbc0.2.40.2.4这个版本用的比较多一点2.spark对象创建valspark

- 2024年最新Python:Page Object设计模式_python page object,BTAJ大厂最新面试题汇集

m0_60707708

程序员python设计模式开发语言

最后硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是

- 2024年总结:大转向

年度总结

本文于2025年1月2号首发于公众号“狗哥琐话”。2024年是个打工人苦命年,我看到几乎每个人都比以往辛苦。这让我想起了六字真言,钱难赚屎难吃。职业转向今年我在职业上尝试做了一个转向,具体的结果可能需要比较长的时间来检验我选择是否正确,所以转向的细节我就不全部展开了,可以确定是我依然会专注在Infra和BigData,比如今年我发布了SparkSQL和FlinkSQL的IDEA提效插件。那么我为什

- Java爬虫——使用Spark进行数据清晰

Future_yzx

java爬虫spark

1.依赖引入 org.apache.spark spark-core_2.13 3.5.3 org.apache.spark spark-sql_2.13 3.5.32.数据加载从MySQL数据库中加载jobTest表中的数据,使用Spark的JDBC功能连接到数据库。代码片段://数据库连接信息StringjdbcUrl="jdbc:mysql://82.157.185.251:3306/

- 万字详解数仓分层设计架构 ODS-DWD-DWS-ADS

_Jordan

自己写的数据仓库

参考:万字详解数仓分层设计架构ODS-DWD-DWS-ADS数据分层的意义1、清晰数据结构2、数据血缘追踪3、数据复用,减少重复开发4、把复杂问题简单化5、屏蔽原始数据的(影响),屏蔽业务的影响ETL操作1、数据抽取2、数据清洗3、数据转换4、数据加载数据中台包含的内容很多,对应到具体工作中的话,它可以包含下面的这些内容:系统架构:以Hadoop、Spark等组件为中心的架构体系数据架构:顶层设计

- Java 大视界 -- Java 开发 Spark 应用:RDD 操作与数据转换

一只蜗牛儿

javaspark开发语言

ApacheSpark是一个强大的分布式计算框架,提供了高效的数据处理能力,广泛应用于大数据分析与机器学习。Spark提供了多种高级API,支持批处理和流处理。Spark提供了两种主要的数据抽象:RDD(弹性分布式数据集)和DataFrame。本文将重点介绍如何使用Java开发Spark应用,并深入探讨RDD的操作与数据转换。一、Spark环境搭建首先,确保您的环境中安装了Java和Spark。您

- Spring Boot 和微服务:快速入门指南

王子良.

Java经验分享springboot微服务后端

欢迎来到我的博客!非常高兴能在这里与您相遇。在这里,您不仅能获得有趣的技术分享,还能感受到轻松愉快的氛围。无论您是编程新手,还是资深开发者,都能在这里找到属于您的知识宝藏,学习和成长。博客内容包括:Java核心技术与微服务:涵盖Java基础、JVM、并发编程、Redis、Kafka、Spring等,帮助您全面掌握企业级开发技术。大数据技术:涵盖Hadoop(HDFS)、Hive、Spark、Fli

- CDP中的Hive3之Hive Metastore(HMS)

对许

#Hive#Sparkhivecdp

CDP中的Hive3之HiveMetastore(HMS)1、CDP中的HMS2、HMS表的存储(转换)3、HWC授权1、CDP中的HMSCDP中的HiveMetastore(HMS)是一种服务,用于在后端RDBMS(例如MySQL或PostgreSQL)中存储与ApacheHive和其他服务相关的元数据。Impala、Spark、Hive和其他服务共享元存储。与HMS的连接包括HiveServe

- 【YashanDB知识库】Hive 命令工具insert崖山数据库报错

数据库

本文内容来自YashanDB官网,原文内容请见https://www.yashandb.com/newsinfo/7919217.html?templateId=171...【问题分类】功能兼容【关键字】spark30041、不兼容【问题描述】本项目的架构是hadoop+hive+yashandb使用崖山数据库,初始化所有的原数据表和数据新建表之后,插入数据时候报错,hadoopcode30041

- 初学者如何用 Python 写第一个爬虫?

王子良.

python经验分享python开发语言爬虫

欢迎来到我的博客!非常高兴能在这里与您相遇。在这里,您不仅能获得有趣的技术分享,还能感受到轻松愉快的氛围。无论您是编程新手,还是资深开发者,都能在这里找到属于您的知识宝藏,学习和成长。博客内容包括:Java核心技术与微服务:涵盖Java基础、JVM、并发编程、Redis、Kafka、Spring等,帮助您全面掌握企业级开发技术。大数据技术:涵盖Hadoop(HDFS)、Hive、Spark、Fli

- Apache PAIMON 学习

潇锐killer

学习

参考:ApachePAIMON:实时数据湖技术框架及其实践数据湖不仅仅是一个存储不同类数据的技术手段,更是提高数据分析效率、支持数据驱动决策、加速AI发展的基础设施。新一代实时数据湖技术,ApachePAIMON兼容ApacheFlink、Spark等主流计算引擎,并支持流批一体化处理、快速查询和性能优化,成为加速AI转型的重要工具。ApachePAIMON是一个支持大规模实时数据更新的存储和分析

- 安装数据库首次应用

Array_06

javaoraclesql

可是为什么再一次失败之后就变成直接跳过那个要求

enter full pathname of java.exe的界面

这个java.exe是你的Oracle 11g安装目录中例如:【F:\app\chen\product\11.2.0\dbhome_1\jdk\jre\bin】下的java.exe 。不是你的电脑安装的java jdk下的java.exe!

注意第一次,使用SQL D

- Weblogic Server Console密码修改和遗忘解决方法

bijian1013

Welogic

在工作中一同事将Weblogic的console的密码忘记了,通过网上查询资料解决,实践整理了一下。

一.修改Console密码

打开weblogic控制台,安全领域 --> myrealm -->&n

- IllegalStateException: Cannot forward a response that is already committed

Cwind

javaServlets

对于初学者来说,一个常见的误解是:当调用 forward() 或者 sendRedirect() 时控制流将会自动跳出原函数。标题所示错误通常是基于此误解而引起的。 示例代码:

protected void doPost() {

if (someCondition) {

sendRedirect();

}

forward(); // Thi

- 基于流的装饰设计模式

木zi_鸣

设计模式

当想要对已有类的对象进行功能增强时,可以定义一个类,将已有对象传入,基于已有的功能,并提供加强功能。

自定义的类成为装饰类

模仿BufferedReader,对Reader进行包装,体现装饰设计模式

装饰类通常会通过构造方法接受被装饰的对象,并基于被装饰的对象功能,提供更强的功能。

装饰模式比继承灵活,避免继承臃肿,降低了类与类之间的关系

装饰类因为增强已有对象,具备的功能该

- Linux中的uniq命令

被触发

linux

Linux命令uniq的作用是过滤重复部分显示文件内容,这个命令读取输入文件,并比较相邻的行。在正常情 况下,第二个及以后更多个重复行将被删去,行比较是根据所用字符集的排序序列进行的。该命令加工后的结果写到输出文件中。输入文件和输出文件必须不同。如 果输入文件用“- ”表示,则从标准输入读取。

AD:

uniq [选项] 文件

说明:这个命令读取输入文件,并比较相邻的行。在正常情况下,第二个

- 正则表达式Pattern

肆无忌惮_

Pattern

正则表达式是符合一定规则的表达式,用来专门操作字符串,对字符创进行匹配,切割,替换,获取。

例如,我们需要对QQ号码格式进行检验

规则是长度6~12位 不能0开头 只能是数字,我们可以一位一位进行比较,利用parseLong进行判断,或者是用正则表达式来匹配[1-9][0-9]{4,14} 或者 [1-9]\d{4,14}

&nbs

- Oracle高级查询之OVER (PARTITION BY ..)

知了ing

oraclesql

一、rank()/dense_rank() over(partition by ...order by ...)

现在客户有这样一个需求,查询每个部门工资最高的雇员的信息,相信有一定oracle应用知识的同学都能写出下面的SQL语句:

select e.ename, e.job, e.sal, e.deptno

from scott.emp e,

(se

- Python调试

矮蛋蛋

pythonpdb

原文地址:

http://blog.csdn.net/xuyuefei1988/article/details/19399137

1、下面网上收罗的资料初学者应该够用了,但对比IBM的Python 代码调试技巧:

IBM:包括 pdb 模块、利用 PyDev 和 Eclipse 集成进行调试、PyCharm 以及 Debug 日志进行调试:

http://www.ibm.com/d

- webservice传递自定义对象时函数为空,以及boolean不对应的问题

alleni123

webservice

今天在客户端调用方法

NodeStatus status=iservice.getNodeStatus().

结果NodeStatus的属性都是null。

进行debug之后,发现服务器端返回的确实是有值的对象。

后来发现原来是因为在客户端,NodeStatus的setter全部被我删除了。

本来是因为逻辑上不需要在客户端使用setter, 结果改了之后竟然不能获取带属性值的

- java如何干掉指针,又如何巧妙的通过引用来操作指针————>说的就是java指针

百合不是茶

C语言的强大在于可以直接操作指针的地址,通过改变指针的地址指向来达到更改地址的目的,又是由于c语言的指针过于强大,初学者很难掌握, java的出现解决了c,c++中指针的问题 java将指针封装在底层,开发人员是不能够去操作指针的地址,但是可以通过引用来间接的操作:

定义一个指针p来指向a的地址(&是地址符号):

- Eclipse打不开,提示“An error has occurred.See the log file ***/.log”

bijian1013

eclipse

打开eclipse工作目录的\.metadata\.log文件,发现如下错误:

!ENTRY org.eclipse.osgi 4 0 2012-09-10 09:28:57.139

!MESSAGE Application error

!STACK 1

java.lang.NoClassDefFoundError: org/eclipse/core/resources/IContai

- spring aop实例annotation方法实现

bijian1013

javaspringAOPannotation

在spring aop实例中我们通过配置xml文件来实现AOP,这里学习使用annotation来实现,使用annotation其实就是指明具体的aspect,pointcut和advice。1.申明一个切面(用一个类来实现)在这个切面里,包括了advice和pointcut

AdviceMethods.jav

- [Velocity一]Velocity语法基础入门

bit1129

velocity

用户和开发人员参考文档

http://velocity.apache.org/engine/releases/velocity-1.7/developer-guide.html

注释

1.行级注释##

2.多行注释#* *#

变量定义

使用$开头的字符串是变量定义,例如$var1, $var2,

赋值

使用#set为变量赋值,例

- 【Kafka十一】关于Kafka的副本管理

bit1129

kafka

1. 关于request.required.acks

request.required.acks控制者Producer写请求的什么时候可以确认写成功,默认是0,

0表示即不进行确认即返回。

1表示Leader写成功即返回,此时还没有进行写数据同步到其它Follower Partition中

-1表示根据指定的最少Partition确认后才返回,这个在

Th

- lua统计nginx内部变量数据

ronin47

lua nginx 统计

server {

listen 80;

server_name photo.domain.com;

location /{set $str $uri;

content_by_lua '

local url = ngx.var.uri

local res = ngx.location.capture(

- java-11.二叉树中节点的最大距离

bylijinnan

java

import java.util.ArrayList;

import java.util.List;

public class MaxLenInBinTree {

/*

a. 1

/ \

2 3

/ \ / \

4 5 6 7

max=4 pass "root"

- Netty源码学习-ReadTimeoutHandler

bylijinnan

javanetty

ReadTimeoutHandler的实现思路:

开启一个定时任务,如果在指定时间内没有接收到消息,则抛出ReadTimeoutException

这个异常的捕获,在开发中,交给跟在ReadTimeoutHandler后面的ChannelHandler,例如

private final ChannelHandler timeoutHandler =

new ReadTim

- jquery验证上传文件样式及大小(好用)

cngolon

文件上传jquery验证

<!DOCTYPE html>

<html>

<head>

<meta http-equiv="Content-Type" content="text/html; charset=utf-8" />

<script src="jquery1.8/jquery-1.8.0.

- 浏览器兼容【转】

cuishikuan

css浏览器IE

浏览器兼容问题一:不同浏览器的标签默认的外补丁和内补丁不同

问题症状:随便写几个标签,不加样式控制的情况下,各自的margin 和padding差异较大。

碰到频率:100%

解决方案:CSS里 *{margin:0;padding:0;}

备注:这个是最常见的也是最易解决的一个浏览器兼容性问题,几乎所有的CSS文件开头都会用通配符*来设

- Shell特殊变量:Shell $0, $#, $*, $@, $?, $$和命令行参数

daizj

shell$#$?特殊变量

前面已经讲到,变量名只能包含数字、字母和下划线,因为某些包含其他字符的变量有特殊含义,这样的变量被称为特殊变量。例如,$ 表示当前Shell进程的ID,即pid,看下面的代码:

$echo $$

运行结果

29949

特殊变量列表 变量 含义 $0 当前脚本的文件名 $n 传递给脚本或函数的参数。n 是一个数字,表示第几个参数。例如,第一个

- 程序设计KISS 原则-------KEEP IT SIMPLE, STUPID!

dcj3sjt126com

unix

翻到一本书,讲到编程一般原则是kiss:Keep It Simple, Stupid.对这个原则深有体会,其实不仅编程如此,而且系统架构也是如此。

KEEP IT SIMPLE, STUPID! 编写只做一件事情,并且要做好的程序;编写可以在一起工作的程序,编写处理文本流的程序,因为这是通用的接口。这就是UNIX哲学.所有的哲学真 正的浓缩为一个铁一样的定律,高明的工程师的神圣的“KISS 原

- android Activity间List传值

dcj3sjt126com

Activity

第一个Activity:

import java.util.ArrayList;import java.util.HashMap;import java.util.List;import java.util.Map;import android.app.Activity;import android.content.Intent;import android.os.Bundle;import a

- tomcat 设置java虚拟机内存

eksliang

tomcat 内存设置

转载请出自出处:http://eksliang.iteye.com/blog/2117772

http://eksliang.iteye.com/

常见的内存溢出有以下两种:

java.lang.OutOfMemoryError: PermGen space

java.lang.OutOfMemoryError: Java heap space

------------

- Android 数据库事务处理

gqdy365

android

使用SQLiteDatabase的beginTransaction()方法可以开启一个事务,程序执行到endTransaction() 方法时会检查事务的标志是否为成功,如果程序执行到endTransaction()之前调用了setTransactionSuccessful() 方法设置事务的标志为成功则提交事务,如果没有调用setTransactionSuccessful() 方法则回滚事务。事

- Java 打开浏览器

hw1287789687

打开网址open浏览器open browser打开url打开浏览器

使用java 语言如何打开浏览器呢?

我们先研究下在cmd窗口中,如何打开网址

使用IE 打开

D:\software\bin>cmd /c start iexplore http://hw1287789687.iteye.com/blog/2153709

使用火狐打开

D:\software\bin>cmd /c start firefox http://hw1287789

- ReplaceGoogleCDN:将 Google CDN 替换为国内的 Chrome 插件

justjavac

chromeGooglegoogle apichrome插件

Chrome Web Store 安装地址: https://chrome.google.com/webstore/detail/replace-google-cdn/kpampjmfiopfpkkepbllemkibefkiice

由于众所周知的原因,只需替换一个域名就可以继续使用Google提供的前端公共库了。 同样,通过script标记引用这些资源,让网站访问速度瞬间提速吧

- 进程VS.线程

m635674608

线程

资料来源:

http://www.liaoxuefeng.com/wiki/001374738125095c955c1e6d8bb493182103fac9270762a000/001397567993007df355a3394da48f0bf14960f0c78753f000 1、Apache最早就是采用多进程模式 2、IIS服务器默认采用多线程模式 3、多进程优缺点 优点:

多进程模式最大

- Linux下安装MemCached

字符串

memcached

前提准备:1. MemCached目前最新版本为:1.4.22,可以从官网下载到。2. MemCached依赖libevent,因此在安装MemCached之前需要先安装libevent。2.1 运行下面命令,查看系统是否已安装libevent。[root@SecurityCheck ~]# rpm -qa|grep libevent libevent-headers-1.4.13-4.el6.n

- java设计模式之--jdk动态代理(实现aop编程)

Supanccy2013

javaDAO设计模式AOP

与静态代理类对照的是动态代理类,动态代理类的字节码在程序运行时由Java反射机制动态生成,无需程序员手工编写它的源代码。动态代理类不仅简化了编程工作,而且提高了软件系统的可扩展性,因为Java 反射机制可以生成任意类型的动态代理类。java.lang.reflect 包中的Proxy类和InvocationHandler 接口提供了生成动态代理类的能力。

&

- Spring 4.2新特性-对java8默认方法(default method)定义Bean的支持

wiselyman

spring 4

2.1 默认方法(default method)

java8引入了一个default medthod;

用来扩展已有的接口,在对已有接口的使用不产生任何影响的情况下,添加扩展

使用default关键字

Spring 4.2支持加载在默认方法里声明的bean

2.2

将要被声明成bean的类

public class DemoService {