【项目实战25】k8s(11)—k8s容器资源限制(内存,cpu限制)

k8s容器资源限制

- 一、基础知识

-

- (1)、资源限制

- (2)、资源类型

- 二、内存限制

- 三、cpu限制

- 四、namespace设置资源限制

-

- (1)、设置namespace资源限制

- (2)、为namespace设置资源配额

- (3)、为namespace配置Pod配额

一、基础知识

(1)、资源限制

在K8s中定义Pod中运行容器有两个维度的限制:

资源需求:即运行Pod的节点必须满足运行Pod的最基本需求才能运行Pod。如: Pod运行至少需要2G内存,1核CPU

资源限额:即运行Pod期间,可能内存使用量会增加,那最多能使用多少内存,这就是资源限额。

Kubernetes采用request和limit两种限制类型来对资源进行分配:

request(资源需求):即运行Pod的节点必须满足运行Pod的最基本需求才能运行Pod。

limit(资源限额):即运行Pod期间,可能内存使用量会增加,那最多能使用多少内存,这就是资源限额。

(2)、资源类型

资源类型:

CPU 的单位是核心数,内存的单位是字节。

一个容器申请0.5个CPU,就相当于申请1个CPU的一半,你也可以加个后缀m 表示千分之一的概念。比如说100m的CPU,100m的CPU和0.1个CPU都是一样的。

内存单位:

K、M、G、T、P、E #通常是以1000为换算标准的。

Ki、Mi、Gi、Ti、Pi、Ei #通常是以1024为换算标准的。

二、内存限制

如果容器超过其内存限制,则会被终止。如果可重新启动,则与所有其他类型的运行时故障一样,kubelet 将重新启动它。

如果一个容器超过其内存请求,那么当节点内存不足时,它的 Pod 可能被逐出

1、server1获取stress.tar包,上传至harbor仓库。

[root@server1 ~] docker load -i stress.tar

[root@server1 harbor] docker push reg.westos.org/library/stress

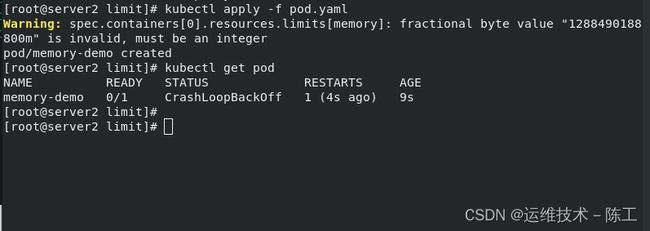

2、在server2上建立yaml文件,进行资源限制

[root@server2 limit] mkdir limit

[root@server2 limit] mkdir limit

[root@server2 limit] vim pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

args:

- --vm

- "1"

- --vm-bytes

- 200M 本pod要求200M的内存

resources: 这里对资源限制位50-100M

requests:

memory: 50Mi

limits:

memory: 100Mi

[root@server2 limit] cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

args:

- --vm

- "1"

- --vm-bytes

- 200M

resources:

requests:

memory: 50Mi

limits:

memory: 300Mi 这里最高设置为300M

三、cpu限制

[root@server2 limit] vim pod1.yaml

[root@server2 limit] cat pod1.yaml

/

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo

spec:

containers:

- name: cpu-demo

image: stress

args:

- -c 设置cpu的数量为2

- "2"

resources: 限制cpu的数量为5-10之间

requests:

memory: "5"

limits:

memory: "10"

//

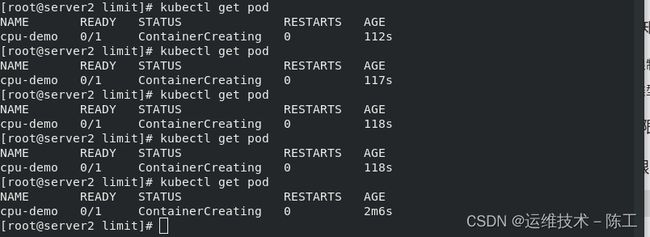

[root@server2 limit] kubectl apply -f pod1.yaml

2、查看效果

发现一直创建不了,没有正常运行的原因是容器使用的cpu数量要在设定的上限和下限之间

3、修改限制条件

删除上一个pod,重新编辑pod1.yaml,将上下限分别修改为2和0.5

[root@server2 limit] kubectl apply -f pod1.yaml

[root@server2 limit] cat pod1.yaml

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo

spec:

containers:

- name: cpu-demo

image: stress

args:

- -c 设置cpu的数量为1

- "1"

resources: 限制cpu的数量为0.2-2之间

requests:

memory: "0.2"

limits:

memory: "2"

四、namespace设置资源限制

(1)、设置namespace资源限制

1、编辑文件

编辑limitrange.yaml,在该配置文件中编辑最大最小内存和cpu限制以及默认运行参数限制

[root@server2 limit] kubectl apply -f pod2.yaml

[root@server2 limit] cat pod2.yaml

apiVersion: v1

kind: LimitRange

metadata:

name: limitrange-memory

spec:

limits:

- default:

cpu: 0.5

memory: 512Mi

defaultRequest:

cpu: "0.1"

memory: 256Mi

max:

cpu: 1

memory: 1Gi

min:

cpu: 0.1

memory: 100Mi

type: Container

2、结果

LimitRange 在 namespace 中施加的最小和最大内存限制只有在创建和更新 Pod 时才会被应用。改变 LimitRange 不会对之前创建的 Pod 造成影响。

3、新建pod应用,查看结果

[root@server2 limit] kubectl apply -f pod.yaml

[root@server2 limit] cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

资源限制变成了我们在limitrange.yaml中设置的默认限制

4、修改pod容器内的资源限制,查看结果

[root@server2 limit] kubectl apply -f pod.yaml

[root@server2 limit] cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

# args:

# - --vm

# - "1"

# - --vm-bytes

# - 200M

resources:

requests:

memory: 50Mi

limits:

memory: 300Mi

pod里资源要求内存最小要求是50M,小于我们上面设置的资源文件里最小内存100M,创建失败。

删除之前创建的资源限制文件pod2.yaml

(2)、为namespace设置资源配额

编辑limitrange.yaml配置文件

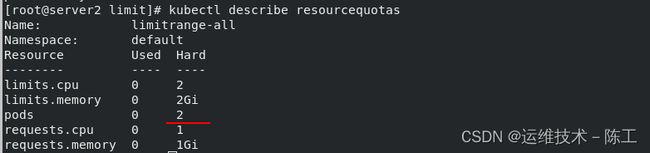

创建的ResourceQuota对象将在default名字空间中添加以下限制:

每个容器必须设置内存请求(memoryrequest),内存限额(memorylimit),cpu请求(cpu request)和cpu限额(cpulimit)。

每个容器的内存请求总额不得超过1GiB。

所有容器的内存限额总额不得超过2GiB。

每个容器的CPU请求总额不得超过1 CPU。

所有容器的CPU限额总额不得超过2 CPU。

1、设置总的配置文件

[root@server2 limit] kubectl apply -f limitrange.yaml

resourcequota/limitrange-all created

[root@server2 limit] cat limitrange.yaml

apiVersion: v1

kind: ResourceQuota

metadata:

name: limitrange-all

spec:

hard:

requests.cpu: "1"

requests.memory: 1Gi

limits.cpu: "2"

limits.memory: 2Gi

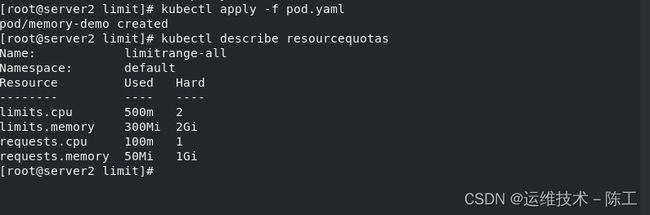

[root@server2 limit] kubectl apply -f pod.yaml

[root@server2 limit] cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

resources:

requests:

memory: 50Mi

cpu: 0.1

limits:

memory: 300Mi

cpu: 0.5

发现创建成功

5、测试3

删除之前pod.yaml,重新设置

[root@server2 limit] cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

resources:

requests:

memory: 50M

cpu: 0.1

limits:

memory: 1.2Gi

cpu: 0.5

创建失败,因为它最大的要求内存为1.2G,超过了每个资源的1G的内存限制。

(3)、为namespace配置Pod配额

1、设置Pod配额以限制可以在namespace中运行的Pod数量

[root@server2 limit] kubectl delete -f limitrange.yaml

[root@server2 limit] cat limitrange.yaml

apiVersion: v1

kind: ResourceQuota

metadata:

name: limitrange-all

spec:

hard:

requests.cpu: "1"

requests.memory: 1Gi

limits.cpu: "2"

limits.memory: 2Gi

pods: "2"

[root@server2 limit] kubectl apply -f limitrange.yaml