Android 音视频开发——录屏直播,android开发蓝牙传数据

timeStamp = System.currentTimeMillis();

}

// 接下来就是 MediaCodec 常规操作,获取 Buffer 可用索引,这里不需要获取输出索引,内部已经操作了

int outputBufferIndex = mediaCodec.dequeueOutputBuffer(bufferInfo,100_000);

if (outputBufferIndex >=0){

// 获取到了

ByteBuffer byteBuffer = mediaCodec.getOutputBuffer(outputBufferIndex);

byte[] outData = new byte[bufferInfo.size];

byteBuffer.get(outData);

}

}

}

Rtmp 数据包

经过上面两步,我们获得了编码好的 h264 数据,接下来封装 Rtmp 就比较头疼了(Ndk 的知识都忘得差不多了)

首先我们在项目的 cpp 文件中,把 Rtmpdump 的源代码导入,我们使用 rtmpdump 连接服务器,以及传输 Rtmp 数据,要知道目前手里的数据还是 h264 码流,是无法直接传输,需要封装成 Rtmp 数据包

使用第三方库 Rtmpdump 来实现推流到直播服务器,由于 Rtmpdump 的代码量不是很多,我们直接拷贝源代码到 Android 的 cpp 文件,如果需要用到 Ffmpeg 不能才用该种调用方式了,需要提前编译好 so 库文件

对 Rtmp 暂时不需要做太深刻的理解,因为很容易给自己绕进去,用 Rtmp 传输 h264 数据,那么 sps,pps ,以及关键帧怎么摆放,Rtmp 都已经规定好了,我们就需要使用 NDK 的方式,实现 rtmp 数据的填充

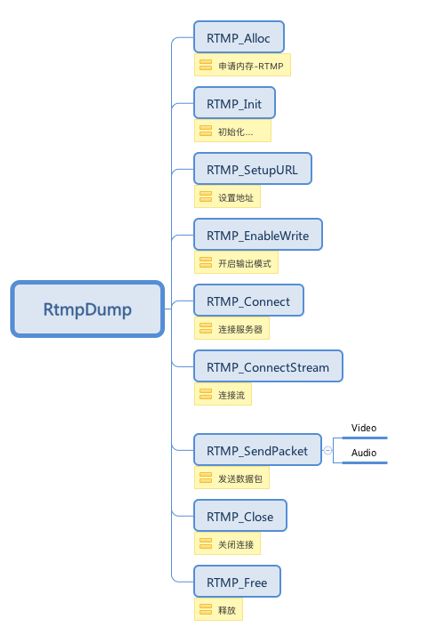

RtmpDump 的使用

- 连接服务器

-

RTMP_Init(RTMP *r) 初始化

-

RTMP_EnableWrite(RTMP *r) 配置开启数据写入

-

RTMP_Connect(RTMP *r, RTMPPacket *cp)

-

RTMP_ConnectStream(RTMP *r, int seekTime)

- 发送数据

-

RTMPPacket_Alloc(RTMPPacket *p, int nSize)

-

RTMP_SendPacket(RTMP *r, RTMPPacket *packet, int queue)

-

RTMPPacket_Free(RTMPPacket *p)

连接直播服务器

这一步中,需要预先准备直播推流地址,然后实现 native 方法

extern “C” JNIEXPORT jboolean JNICALL

Java_com_bailun_kai_rtmplivedemo_RtmpPack2Remote_connectLiveServer(JNIEnv *env, jobject thiz,

jstring url) {

// 首先 Java 的转成 C 的字符串,不然无法使用

const char *live_url = env->GetStringUTFChars(url,0);

int result;

do {

// 结构体对象分配内存

livePack = (LivePack *)(malloc(sizeof(LivePack)));

// 清空内存上的脏数据

memset(livePack,0,sizeof(LivePack));

// Rtmp 申请内存

livePack->rtmp = RTMP_Alloc();

RTMP_Init(livePack->rtmp);

// 设置 rtmp 初始化参数,比如超时时间、url

livePack->rtmp->Link.timeout = 10;

LOGI(“connect %s”, url);

if (!(result = RTMP_SetupURL(livePack->rtmp,(char *)live_url))){

break;

}

// 开启 Rtmp 写入

RTMP_EnableWrite(livePack->rtmp);

LOGI(“RTMP_Connect”);

if (!(result = RTMP_Connect(livePack->rtmp,0))){

break;

}

LOGI("RTMP_ConnectStream ");

if (!(result = RTMP_ConnectStream(livePack->rtmp, 0)))

break;

LOGI(“connect success”);

}while (0);

if (!result && livePack){

free(livePack);

livePack = nullptr;

}

env->ReleaseStringUTFChars(url,live_url);

return result;

}

发送数据到直播服务器

有意思的是,Rtmp 协议中不需要传递分隔符(h264 分隔符为 0 0 0 1),并且推流的第一个 Rtmp 包的内容为 sps、pps 等

// 发送 rtmp 数据到服务器

extern “C”

JNIEXPORT jboolean JNICALL

Java_com_bailun_kai_rtmplivedemo_RtmpPack2Remote_sendData2Server(JNIEnv *env, jobject thiz,

jbyteArray buffer, jint length,

jlong tms) {

int result;

// 拷贝数据

jbyte *bufferArray = env->GetByteArrayElements(buffer, 0);

result = sendDataInner(bufferArray,length,tms);

//释放内存

env->ReleaseByteArrayElements(buffer,bufferArray,0);

return result;

}

int sendDataInner(jbyte *array, jint length, jlong tms) {

int result = 0;

//处理 sps、pps

if (array[4] == 0x67){

// 读取 sps,pps 数据,保存到结构体中

readSpsPps(array,length,livePack);

return result;

}

//处理 I帧,其他帧

if(array[4] == 0x65){

RTMPPacket * spsPpsPacket = createRtmpSteramPack(livePack);

sendPack(spsPpsPacket);

}

RTMPPacket* rtmpPacket = createRtmpPack(array,length,tms,livePack);

result = sendPack(rtmpPacket);

return result;

}

int sendPack(RTMPPacket *pPacket) {

int result = RTMP_SendPacket(livePack->rtmp,pPacket,1);

RTMPPacket_Free(pPacket);

free(pPacket);

return result;

}

// 发送 sps ,pps 对应的 Rtmp 包

RTMPPacket *createRtmpSteramPack(LivePack *pack) {

// 创建 Rtmp 数据包,对应 RtmpDump 库的 RTMPPacket 结构体

int body_size = 16 + pack->sps_len + pack->pps_len;

RTMPPacket *rtmpPacket = static_cast

RTMPPacket_Alloc(rtmpPacket,body_size);

int index = 0;

rtmpPacket->m_body[index++] = 0x17;

//AVC sequence header 设置为0x00

rtmpPacket->m_body[index++] = 0x00;

//CompositionTime

rtmpPacket->m_body[index++] = 0x00;

rtmpPacket->m_body[index++] = 0x00;

rtmpPacket->m_body[index++] = 0x00;

//AVC sequence header

rtmpPacket->m_body[index++] = 0x01;

// 原始 操作

rtmpPacket->m_body[index++] = pack->sps[1]; //profile 如baseline、main、 high

rtmpPacket->m_body[index++] = pack->sps[2]; //profile_compatibility 兼容性

rtmpPacket->m_body[index++] = pack->sps[3]; //profile level

rtmpPacket->m_body[index++] = 0xFF;//已经给你规定好了

rtmpPacket->m_body[index++] = 0xE1; //reserved(111) + lengthSizeMinusOne(5位 sps 个数) 总是0xe1

//高八位

rtmpPacket->m_body[index++] = (pack->sps_len >> 8) & 0xFF;

// 低八位

rtmpPacket->m_body[index++] = pack->sps_len & 0xff;

// 拷贝sps的内容

memcpy(&rtmpPacket->m_body[index], pack->sps, pack->sps_len);

index +=pack->sps_len;

// pps

rtmpPacket->m_body[index++] = 0x01; //pps number

//rtmp 协议

//pps length

rtmpPacket->m_body[index++] = (pack->pps_len >> 8) & 0xff;

rtmpPacket->m_body[index++] = pack->pps_len & 0xff;

// 拷贝pps内容

memcpy(&rtmpPacket->m_body[index], pack->pps, pack->pps_len);

//packaet

//视频类型

rtmpPacket->m_packetType = RTMP_PACKET_TYPE_VIDEO;

//

rtmpPacket->m_nBodySize = body_size;

// 视频 04

rtmpPacket->m_nChannel = 0x04;

rtmpPacket->m_nTimeStamp = 0;

rtmpPacket->m_hasAbsTimestamp = 0;

rtmpPacket->m_headerType = RTMP_PACKET_SIZE_LARGE;

rtmpPacket->m_nInfoField2 = livePack->rtmp->m_stream_id;

return rtmpPacket;

}

RTMPPacket *createRtmpPack(jbyte *array, jint length, jlong tms, LivePack *pack) {

array += 4;

RTMPPacket *packet = (RTMPPacket *) malloc(sizeof(RTMPPacket));

int body_size = length + 9;

RTMPPacket_Alloc(packet, body_size);

if (array[0] == 0x65) {

packet->m_body[0] = 0x17;

LOGI(“发送关键帧 data”);

} else{

packet->m_body[0] = 0x27;

LOGI(“发送非关键帧 data”);

}

// 固定的大小

packet->m_body[1] = 0x01;

packet->m_body[2] = 0x00;

packet->m_body[3] = 0x00;

packet->m_body[4] = 0x00;

//长度

packet->m_body[5] = (length >> 24) & 0xff;

packet->m_body[6] = (length >> 16) & 0xff;

最后

代码真的是重质不重量,质量高的代码,是当前代码界提倡的,当然写出高质量的代码肯定需要一个相当高的专业素养,这需要在日常的代码书写中逐渐去吸收掌握,谁不是每天都在学习呀,目的还不是为了一个,为实现某个功能写出高质量的代码。

所以,长征路还长,大家还是好好地做个务实的程序员吧。

最后,小编这里有一系列Android提升学习资料,有兴趣的小伙伴们可以来看下哦~

我的 Android 学习,面试文档,视频收集大整理