CVPR 2023|UniDetector:7000类通用目标检测算法(港大&清华)

作者 | CV君 编辑 | 极市平台

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【目标检测】技术交流群

导读

论文中仅用了500个类别参与训练,就可以使UniDetector检测超过7k个类别!

向大家介绍一篇今天新出的非常有意思的 CVPR 2023 的论文,相比于传统的目标检测算法,训练时标注了几个类别,就只能检测几个类别,这篇论文属于通用目标检测的范畴。

通过在训练过程中图像和文本对齐,它可以自动扩展到检测那些视觉标注中没有出现的类别。

这将有效帮助视觉系统目标检测能力的迁移,感觉是非常有前途的技术方向。

论文信息:

论文作者:Zhenyu Wang,Yali Li,Xi Chen,Ser-Nam Lim,Antonio Torralba,Hengshuang Zhao,Shengjin Wang

作者单位:北京信息科学与技术国家研究中心;清华大学;香港大学;Meta AI;MIT

论文链接:http://arxiv.org/abs/2303.11749v1

开源地址:https://github.com/zhenyuw16/UniDetector(尚未开源)

这篇论文作者大多数是国内学者。

传统的物体检测算法受限于繁琐的人工标注,在开放世界中出现新类别后往往需要“从头来过”,即使只增加一个新类别,也要完整过一遍标注、训练、部署整个流程,严重限制了其通用性,这显然不“科学”。

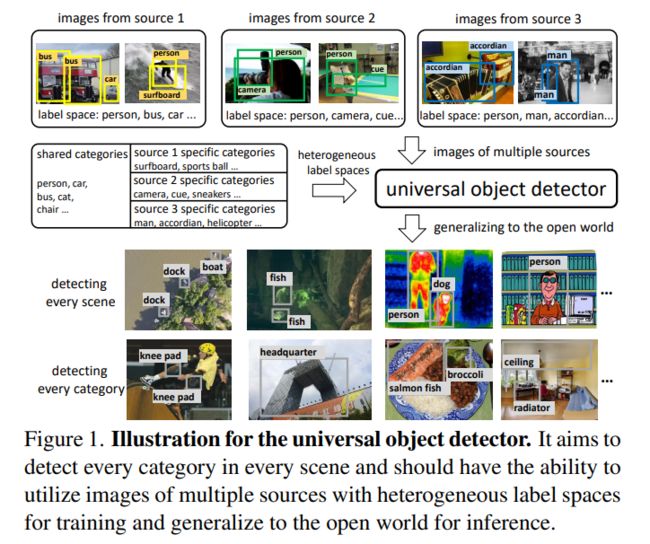

该论文作者提出了UniDetector,就是要让目标检测器具有识别开放世界中大量类别的能力。

其核心关键点:

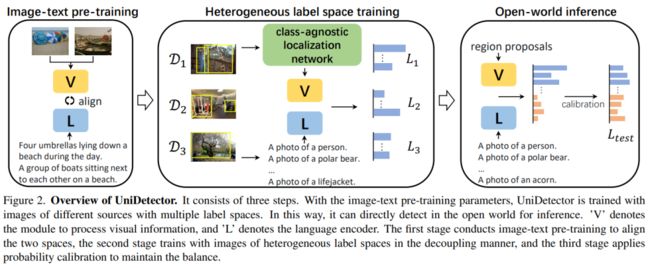

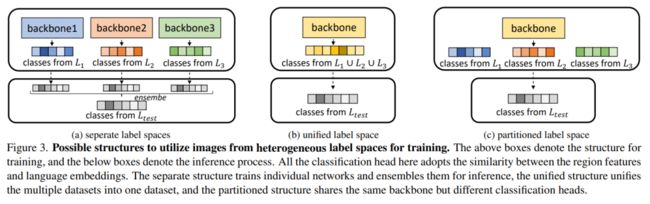

1)基于图像和文本空间的对齐,利用多个来源和异构标签空间的图像进行训练,保证了通用表示的充分信息。

2)由于视觉和语言模态的丰富信息,使其易于推广到开放世界,同时保持已知和未知类别之间的平衡。

3)为了应对训练中的新挑战,作者还提出了提出的解耦训练方式和概率校准,进一步提高了对新类别的泛化能力。

论文中仅用了500个类别参与训练,就可以使UniDetector检测超过7k个类别!而这并不是代表UniDetector只能检测7K个类别,而是现有公开数据集只能让这项研究最多在7K个类别上进行检测和评估!

(好吧,这个世界限制了UniDetector的发挥~)

UniDetector算法示意:

UniDetector算法流程:

训练过程中的异构标签空间:

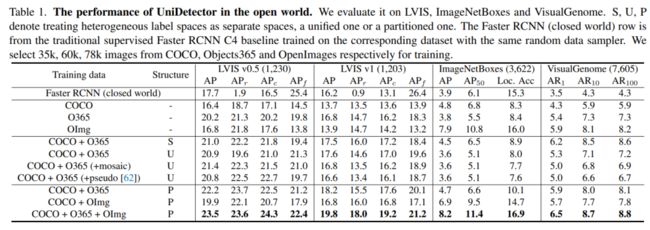

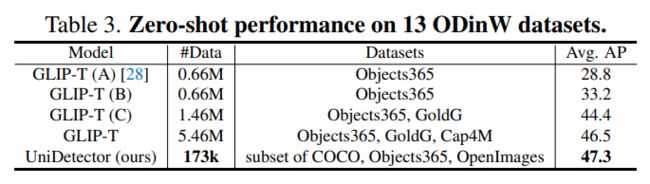

通过实验发现,在具有大量类别的目标检测数据集LVIS、ImageNetBoxes和VisualGenome上,UniDetector表现出强大的零样本泛化能力(也就是数据集中参与训练的图像样本为0个),超过传统监督算法平均4%以上!而在另外13个具有不同场景的目标检测数据集上,UniDetector仅使用3%的训练数据就实现了最先进的性能!

在开放世界数据集上的检测性能:

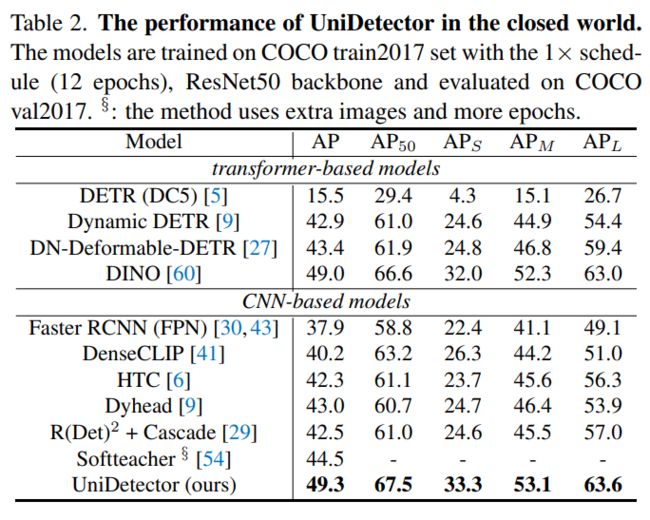

在COCO数据集上的性能:

零样本设置下 在 13 个开放世界数据集上的检测性能:

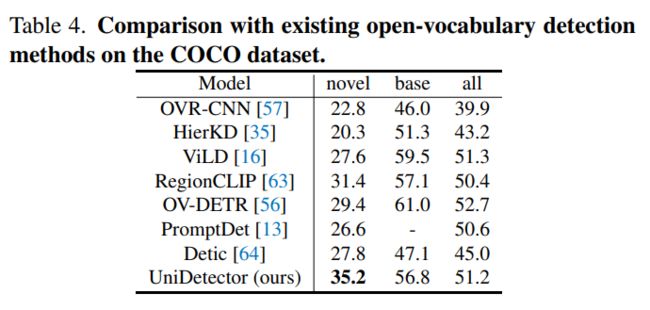

在COCO数据集上与其他开放类别的目标检测方法的比较:

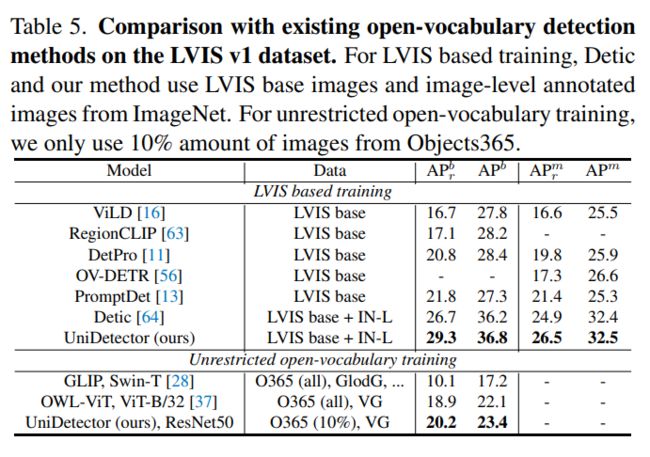

在LVIS 数据集上与其他开放类别的目标检测方法的比较:

往期回顾

史上最全综述 | 3D目标检测算法汇总!(单目/双目/LiDAR/多模态/时序/半弱自监督)

视频课程来了!

自动驾驶之心为大家汇集了毫米波雷达视觉融合、高精地图、BEV感知、传感器标定、传感器部署、自动驾驶协同感知、语义分割、自动驾驶仿真、L4感知、决策规划、轨迹预测等多个方向学习视频,欢迎大家自取(扫码进入学习)

(扫码学习最新视频)

国内首个自动驾驶学习社区

近1000人的交流社区,和20+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、Occpuancy、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称