AI学术交流——“人工智能”和“神经网络学习”

作者简介:一名云计算网络运维人员、每天分享网络与运维的技术与干货。

座右铭:低头赶路,敬事如仪

个人主页:网络豆的主页

目录

前言

一.人工智能

1.“人工智能之父”

2.达特茅斯会议(人工智能起源)

3.人工智能重要节点

二.神经网络

1.什么是神经网络

2.神经网络简单结构

3.为什么要学习人类的神经网络

(1)人类大脑:

(2)人类大脑与人工智能神经网络相似之处

(3)人类大脑与人工智能神经网络不同之处

4.不同类型的神经网络

(1)前馈神经网络

(2) 反馈神经网络

(3) 卷积神经网络

(4)递归神经网络

前言

本章将会讲解AI中人工智能与神经网络的学习,了解人工智能的发展史,与神经网络。

一.人工智能

1.“人工智能之父”

艾伦·麦席森·图灵

英国数学家、逻辑学家,被称为计算机科学之父,人工智能之父。

图灵对于人工智能的发展有诸多贡献,提出了一种用于判定机器是否具有智能的试验方法,即图灵试验,每年都有试验的比赛。此外,图灵提出的著名的图灵机模型为现代计算机的逻辑工作方式奠定了基础。

约翰·麦卡锡

他因在人工智能领域的贡献而在1971年获得图灵奖。他在1956年的达特矛斯会议上提出了“人工智能”一词,并被誉为人工智能之父,并将数学逻辑应用到了人工智能的早期形成中。麦卡锡在1958年发明了LISP语言(该语言至今仍在人工智能领域广泛使用)并于1960年将其设计发表在《美国计算机学会通讯》上。

马文·明斯基

“人工智能之父”和框架理论的创立者。1956年,和麦卡锡(J.McCarthy)一起发起“达特茅斯会议”并提出人工智能(Artificial Intelligence)概念的计算机科学家马文·明斯基(Marvin Lee Minsky)被授予了1969年度图灵奖,是第一位获此殊荣的人工智能学者。

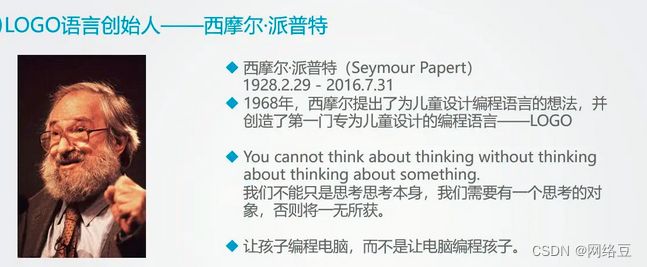

西摩尔·派普特

人工智能发展的其中一位先驱。他对智力的观点主要来自让·皮亚杰的影响。他在1968年从LISP语言的基础里创立Logo程序语言。

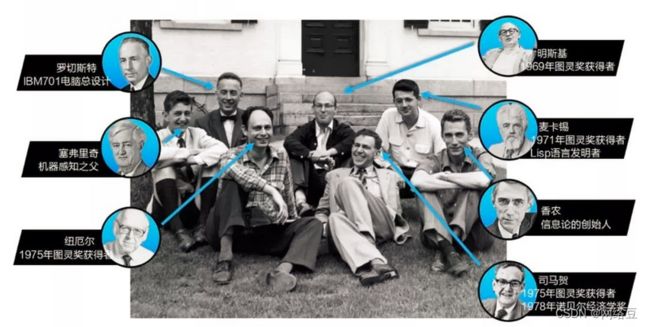

2.达特茅斯会议(人工智能起源)

人工智能的诞生,可以追溯到1956年的达特茅斯会议。

在这次会议生,聚集了计算机科学领域的一些顶尖科学家,包括约翰 ・麦卡锡,马文・闵斯基,克劳德・香农等。

这些人视图研究一种东西,这种东西能够思考和学习,甚至是超过人类的智慧。他们将这种东西定义为“人工智能”。

在这个会议完成后,一场关于人工智能的革命就开始了。

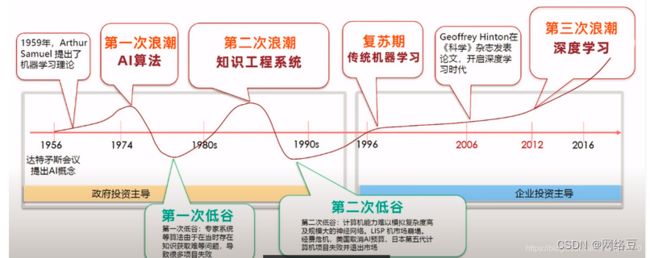

人工智能一路走来,经历了多次高潮和低谷,特别是20世纪80年代的“AI寒冬”。但是随着计算能力的提高和算法的进步,人工智能再次得以发展。

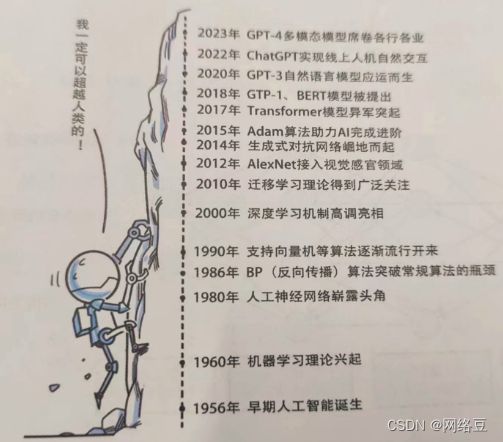

3.人工智能重要节点

直到2023年,有一些人类说AI已经拥有了超越他们的智慧,但是AI无非就是在某些方面比人类更加高效罢了。

二.神经网络

让以chatGPT为代表的硅基能够前进到今天,有两个技术至关重要:一个是神经网络,另一个就是深度学习。两种的结合,奠定了硅基发展的走向。接下来我们就先来讲一下神经网络。

1.什么是神经网络

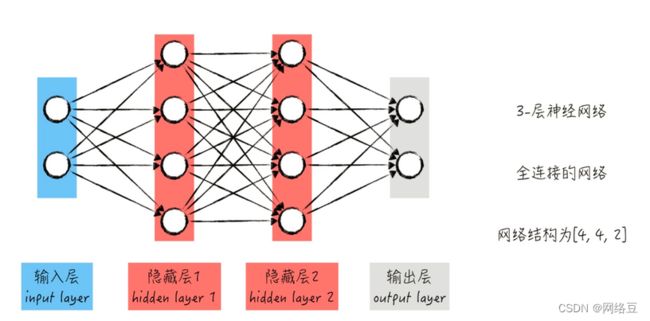

神经网络又称人工神经网络 (ANN) 或模拟神经网络 (SNN),是机器学习的子集,同时也是深度学习算法的核心。其名称和结构均受到人脑的启发,可模仿生物神经元相互传递信号的方式。

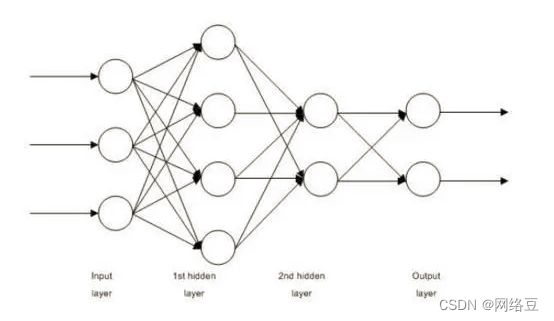

人工神经网络 (ANN) 由节点层组成,包含一个输入层、一个或多个隐藏层和一个输出层。每个节点也称为一个人工神经元,它们连接到另一个节点,具有相关的权重和阈值。如果任何单个节点的输出高于指定的阈值,那么会激活该节点,并将数据发送到网络的下一层。否则,不会将数据传递到网络的下一层。神经网络依靠训练数据来学习,并随时间推移提高自身准确性。

2.神经网络简单结构

3.为什么要学习人类的神经网络

人工智能研究者们认为,人类的大脑就是世界上最大的计算机。那么,人类大脑这台计算机到底有多强大?

(1)人类大脑:

- (1)人类大脑的总重量为1.3-1.4千克

- (2)大脑包含约1000亿个神经元,神经元之间形成数以千计的神经网络。

- (3)人脑每秒可以处理约10的16次方个操作。

- (4)人脑能耗非常低,仅为20瓦左右,相当于一盏电灯泡的功率。

(2)人类大脑与人工智能神经网络相似之处

- (1)都是由神经元构成

- (2)可以进行学习适应新环境

- (3)可以处理大量信息

- (4)有记忆和预测功能

(3)人类大脑与人工智能神经网络不同之处

- (1)神经网络学习速度快于大脑。

- (2)神经网络存储容量小于大脑。

- (3)神经网络决策过程通过计算大脑通过综合决策。

- (4)神经网络存储通过硬盘大脑存储通过神经元。

4.不同类型的神经网络

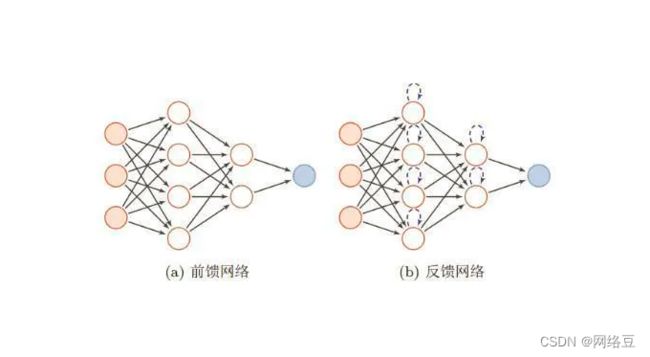

(1)前馈神经网络

前馈神经网络(feedforward neural network)是一种最简单的神经网络结构,由最基本的神经元堆叠而成,信息从输入层开始,逐层向一个方向传递,即单向传递,一直到输出层结束。前馈神经网络由一个或多个线性变换和非线性激活函数组成。前馈神经网络是应用最广泛、发展最迅速的人工神经网络之一。

(2) 反馈神经网络

反馈神经网络是一种将输出经过一步时移再接入到输入层的神经网络系统。

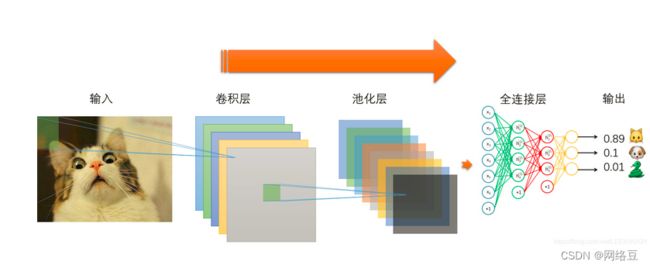

(3) 卷积神经网络

卷积神经网络(Convolutional Neural Network,CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现。卷积神经网络由一个或多个卷积层和顶端的全连通层(对应经典的神经网络)组成,同时也包括关联权重和池化层(pooling layer)。这一结构使得卷积神经网络能够利用输入数据的二维结构。与其他深度学习结构相比,卷积神经网络需要考虑的参数更少,使之成为一种颇具吸引力的深度学习结构 。

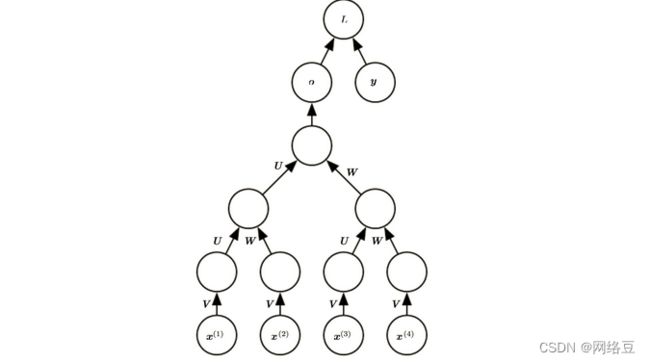

(4)递归神经网络

递归神经网络(Recurrent Neural Network,RNN)是一种前馈神经网络,它的神经元可以响应先前的状态和输入信息,对于序列数据处理有出色表现。递归神经网络由循环层构成,每个循环层的输出被送到下一个循环层的输入中。这使得递归神经网络可以利用序列信息。与其他深度学习结构相比,递归神经网络需要考虑的参数更少,使之成为一种颇具吸引力的深度学习结构。

创作不易,求关注,点赞,收藏,谢谢~