本地化部署是GPT发展的一个趋势。

本地化部署指的是将大模型部署在用户自己的设备上,而不是依赖于云服务商提供的接口。本地化部署有以下几个优势:

- 数据完全私有化,降低数据丢失和泄露风险,对数据安全性和私密性有保障。

- 降低使用成本,不需要支付云服务商的订阅费用或按量计费。

- 提高使用灵活性,可以根据自己的需求定制大模型的功能和参数。

- 提高使用效率,不受网络延迟和稳定性的影响。

由于大模型实在是太耗费服务器资源,注定了可以提供大模型服务的只能是大厂。大厂也不是慈善家,参考openai的定价策略,每月20美元的订阅费用并不是一笔小数目,因此本地化部署,将庞大的算力分摊到用户侧,是未来大模型发展的一个分支。

目前已经有许多支持本地化部署的大模型:像Chat GLM、LLAMA、Alpaca、Vicuna等需要具备一定的编程经验才可以本地化部署一个私有的大模型。

而gpt4all、text-generation-webui等已经可以像安装软件一样方便的本地化部署一个大模型了。

随着谷歌将WebGPU带入浏览器,通过浏览器使用用户本地GPU也成为了可能,web-llm也应运而生。

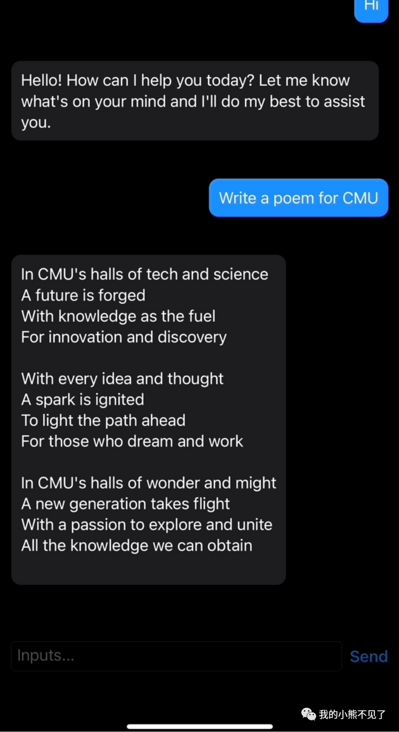

但以上的大模型都需要使用电脑才能实现本地化大模型,而近期开源的mlc-llm已经支持在移动设备上部署大模型。

链接:https://github.com/mlc-ai/mlc-llm

每个人都拥有一个私人助理的时代就要来了。[机智]