HuggingGPT解析:使用 ChatGPT及HuggingFace上的族系解决AI问题

HuggingGPT解析:使用 ChatGPT及HuggingFace上的族系解决AI问题

HuggingGPT是一个利用大型语言模型(LLMs)来解决复杂AI任务的框架。其基本理念是,考虑到LLMs(例如ChatGPT)在语言理解、生成、交互和推理方面展现出了卓越的能力,我们主张可以让LLMs充当控制器,管理现有的AI模型来解决复杂的AI任务,并且可以利用语言作为一种通用接口。

具体实现上,HuggingGPT使用ChatGPT进行任务规划,当接收到用户的请求后,根据Hugging Face中可用的功能描述来选择模型,执行每个子任务,并根据执行结果来总结响应。通过充分利用ChatGPT的强大语言处理能力和Hugging Face中众多的AI模型,HuggingGPT能够处理不同模态和领域中的大量复杂AI任务,并在语言、视觉、语音等挑战性任务中取得了令人印象深刻的结果,为实现人工普适智能铺平了新的道路。

相关论文:Paper for HuggingGPT

核心概念:LLM可以作为一个控制器,管理和组织专家模型的合作,解决复杂的AI任务。首先,LLM基于用户请求规划一系列任务,然后为每个任务分配专家模型。在专家执行任务后,LLM收集结果并回应用户。

LLMs作为AI模型的管理者,专家模型作为执行者

本论文中提出的主要观点是,为了处理复杂的人工智能任务,大型语言模型(LLMs)应该能够与外部模型进行协调以利用它们的能力。因此,如何选择合适的中间件来连接LLMs和AI模型是关键问题。为解决这个问题,作者引入了一个概念:“语言是一个通用接口,用于连接LLMs和AI模型”。也就是说,通过将这些模型描述整合到提示中,LLMs可以被视为管理AI模型(如计划、调度和合作)的大脑。

这篇论文提出了一个被称为HuggingGPT的系统,该系统可以将LLMs(如ChatGPT)和ML社区(如Hugging Face)连接起来,处理来自不同模态的输入并自主解决复杂的AI任务。具体来说,对于Hugging Face中的每一个AI模型,我们使用库中的对应模型描述并将其融入到提示中,以与ChatGPT建立连接。然后,在我们的系统中,LLMs(即ChatGPT)将充当大脑,确定对用户问题的答案。

HuggingGPT的整个流程可以分为四个阶段:

- 任务规划:使用ChatGPT分析用户的请求,理解他们的意图,并通过提示将他们分解成可能的可解决任务。

- 模型选择:为解决规划的任务,ChatGPT基于模型描述选择托管在Hugging Face上的专家模型。

- 任务执行:调用并执行每个选定的模型,并将结果返回给ChatGPT。

- 响应生成:最后,使用ChatGPT整合所有模型的预测并为用户生成响应。

不使用大模型本身进行集成多模态的感知能力

LLMs)的出现和其演变。LLMs例如GPT-3、GPT-4、PaLM和LLaMa,在零样本、少样本任务以及更复杂的任务(例如数学问题和常识推理)上表现出了卓越的能力。为了将LLMs的应用范围扩展到文本生成之外,现代研究主要分为两个分支:1)有些工作设计了统一的多模态语言模型来解决各种AI任务;2)最近,一些研究人员开始研究如何在LLMs中集成使用工具或模型。

但这些工具是被集成到LLMs中,和HuggingFace的模式有区别

HuggingGPT使用LLM作为界面将用户请求路由到专家模型,有效地结合了LLM的语言理解能力和其他专家模型的专业知识。HuggingGPT不仅限于视觉感知任务,还可以通过通过LLM组织模型之间的合作来解决任何模态或任何领域的任务

HuggingGPT的设计优点在于,它能根据用户请求自动生成计划并利用外部模型,从而集成多模态的感知能力并处理多个复杂的AI任务。更值得注意的是,该管道还允许HuggingGPT不断吸收任务特定专家的力量,使AI的能力可扩展和可增长。此外,作者还强调了任务规划在HuggingGPT中的重要性,这直接决定了后续工作流程的成功与否。因此,如何进行规划也是反映LLMs能力的一个很好的角度,也为LLMs评估开辟了新的途径。

任务和对应专家模型的匹配

在任务规划后,HuggingGPT需要匹配任务和模型,即为解析任务列表中的每个任务选择最合适的模型。为此,我们使用模型描述作为连接每个模型的语言接口。我们首先从机器学习社区获取专家模型的描述,然后通过一个内部任务模型分配机制动态地为任务选择模型。

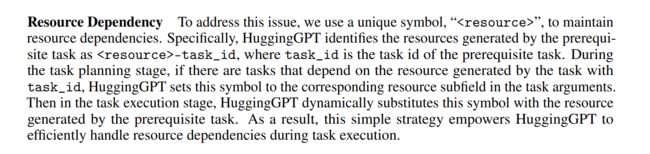

资源依赖符号

任务执行阶段,HuggingGPT会自动将这些任务参数输入到模型中,执行这些模型以获得推断结果,然后将结果发送回LLM。为了处理这个阶段的资源依赖问题,我们使用一个唯一的符号,“<资源>”,来维护资源依赖。此外,为了提高推理效率,我们将同时执行没有任何资源依赖性的任务。

疑惑: 这个机制不太了解,目前不清楚具体的作用

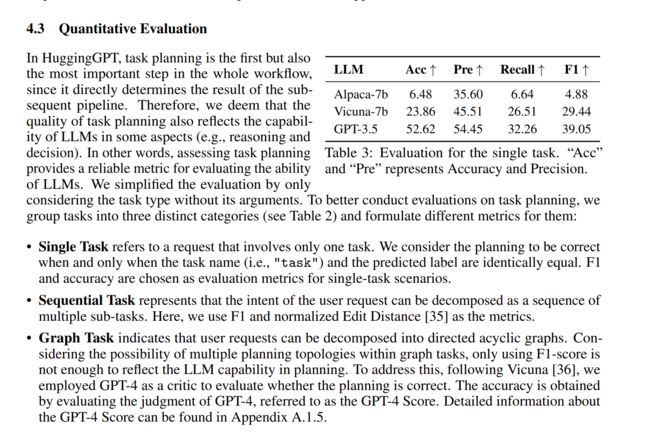

性能测试

在实验部分,作者使用了公开可用的GPT模型作为主要的LLM,并为任务规划、模型选择和响应生成阶段设计了详细的提示。通过这些实验,HuggingGPT成功地在响应用户请求的过程中进行了任务规划、模型选择和任务执行。作者以任务规划的质量为评价指标,对LLM的能力进行了评价,这反映了LLM在某些方面(例如推理和决策)的能力。作者按照单一任务、顺序任务和图任务三个类别进行了任务规划的评估,并为这三种类型的任务制定了不同的指标。

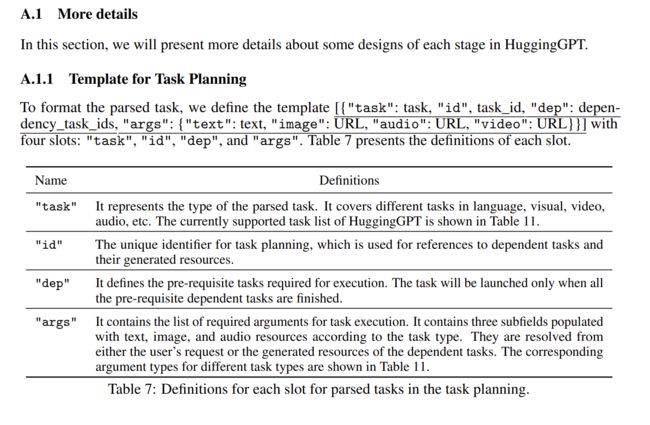

Stage1:任务规划部分的结构

可能需要改进的部分:任务列表

这个项目受到了HuggingFace的支持,但仍然只有24个标准的Task,那么说明即使了解了模型的描述,对于接口的调用存在问题,能否通过代码生成的形式以及HuggingFace的其他接口来自动生成其他可能的任务专家模型?

自动代理任务及相关工具链

当前存在一些自动处理代理任务和工具链的项目可供参考

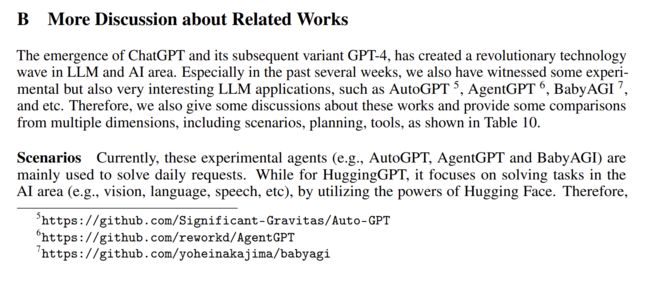

在工具使用方面,AutoGPT是唯一一个涉及其他工具使用的代理,主要使用一些常见工具(如网络搜索、代码执行器),而HuggingGPT则利用了机器学习社区的专家模型。因此,AutoGPT在任务范围上更广泛,但不适合解决更专业的问题,而HuggingGPT则更专业,专注于解决更复杂的AI任务。

HuggingGPT可以被视为一个自主代理,与上述的实验性代理相比,HuggingGPT更系统地提出了一个包括任务规划、模型选择、任务执行和响应生成四个阶段的清晰流程。该流程可以有效提高解决用户请求的成功率。HuggingGPT还引入了全局规划策略来分解用户请求以实现任务自动化,并充分利用了机器学习社区的专家模型的力量来解决AI任务,显示了使用外部工具的巨大潜力。相比于这些代理,HuggingGPT在专业领域内更有效地解决任务,并且可以很容易地扩展到任何垂直领域。在未来,开发人员将继续增强HuggingGPT的能力,以发展出具有无限可能性的多功能自主代理。

总结

总的来说,尽管HuggingGPT提出了一个新的AI解决方案设计范式,但仍存在一些限制和改进空间。例如,规划能力严重依赖于LLM的能力,效率是常见的挑战,令牌长度是使用LLM时的常见问题,而且LLM的不稳定性也可能导致工作流程中的异常。尽管如此,HuggingGPT通过利用LLM的理解和推理能力,能够解析用户的意图,并将其分解为多个子任务,显示出解决具有挑战性的AI任务的巨大潜力,从而为实现人工普适智能开辟了新的途径。