从上周的这篇教程中继续hadoop的安装过程:http://dblab.xmu.edu.cn/blog/install-hadoop-in-centos/

上节课安装到对hadoop中的输出的文件夹的进行了清空操作,现在接着对hadoop中的配置进行设置

(这里设置的是伪分布式的过程)

首先打开虚拟机吧centos 6.4开机

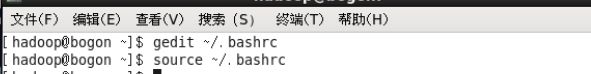

在终端中输入相应命令用gedit配置 ~/.bashrc 中的设置

添加教程中所给的命令到文件的末尾位置

输入命令使刚刚添加进去的内容生效

继续将对应的内容添加进hdfs-site.xml和core-site.xml中,保存

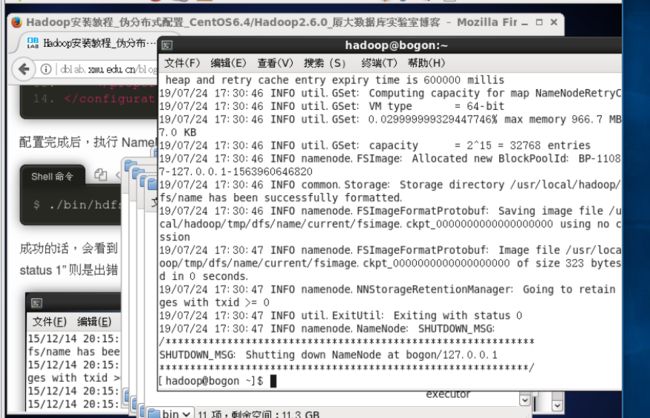

配置完成之后,执行NameNode的格式化

再根据教程中所给的命令,输入对应的命令之后,出现了一个错误

在其中的bin文件夹中确实没有找到相对应的文件,因此,在格式化的地址估计出现了错误,为了找到究竟是在什么位置。进行了百度一番,发现了这篇博客https://blog.csdn.net/tiankong_12345/article/details/80551930

其中我发现了他的bin/hdfs前面加了个

$HADOOP_HOME

这是刚刚在设置配置文件和配置环境变量的过程中使用到的一个环境变量

属于根据这篇博客中提供的这个位置,进行了大胆的尝试。

执行完之后

格式化的过程相当成功。

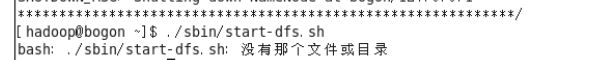

接着根据教程开启NameNode和DataNode的守护进程:

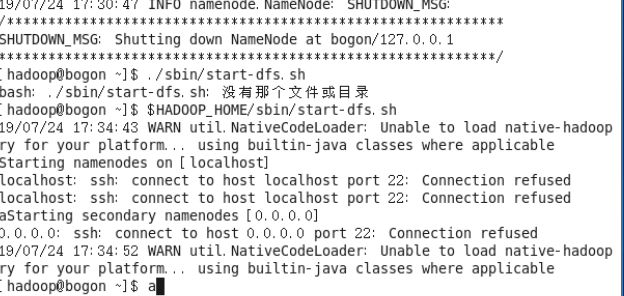

开启的过程中发现了相同的错误提示,因此,大致都是前面要加个$HADOOP_HOME才是正确的地址位置

启动的过程中发现并没有输出最后的选项让我们选择继续操作,但是首先得验证是否启动成功,输入jps

发现了新问题:

由于OPENJDK在centos中已经是自动被安装了,前面的安装jdk的过程导致系统出现了多个jdk的版本,因此在安装之后,系统无法判断究竟要使用哪个jdk导致出现了

无法找到运行环境的提示。

根据网上的教程,删除了其中一个java的jdk,发现删除成安装的那个jdk了,而前面的教程说道系统自带的jdk是有问题的,因此,重新安装前面的jdk

过程省略,最终安装完毕

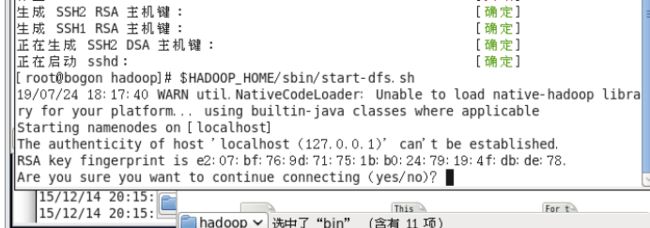

继续查看为什么会导致无法启动进程,进行百度后发现,其原因是没有启动ssh服务导致的

输入service sshd restart后再次启动守护程序,成功执行

输入yes

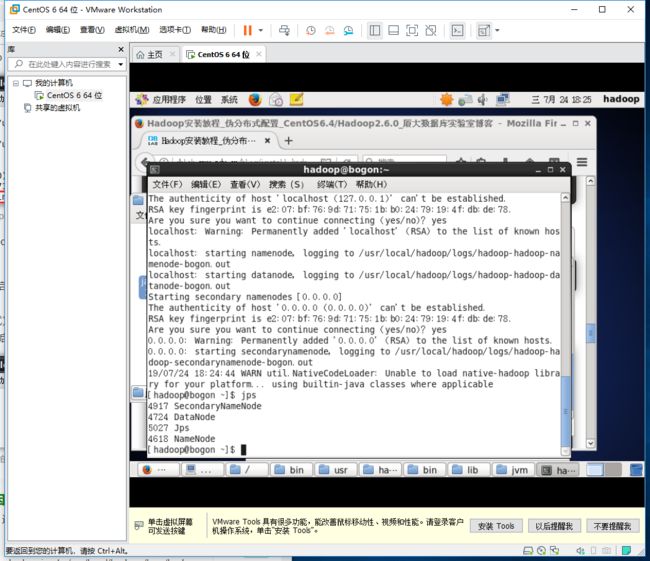

之后成功启动

输入jps检测如下:

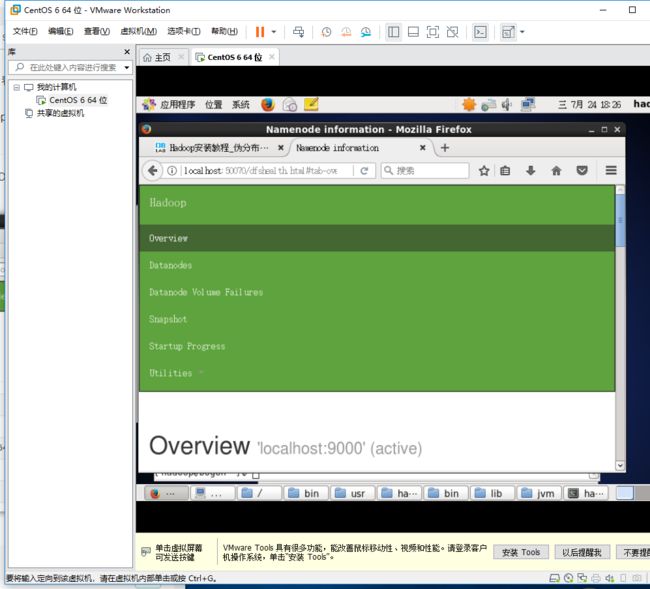

通过网址Web 界面 http://localhost:50070 查看 NameNode 和 Datanode 信息

运行伪分布式实例:

关闭hadoop及其运行的命令:

./sbin/stop-dfs.sh

./sbin/start-dfs.sh(下次启动时无需再次进行NameNode的初始化)

最后关闭hadoop: