Multimodal emotion recognition with capsule graph convolutional based representation fusion

| 题目 | Multimodal emotion recognition with capsule graph convolutional based representation fusion |

|---|---|

| 译题 | 基于胶囊图卷积表示融合的多模态情感识别 |

| 时间 | 2021年 |

| 期刊/会议 | ICASSP |

Multimodal emotion recognition with capsule graph convolutional based representation fusion

摘要:音视频多模态情感识别由于具有比单模态更强的鲁棒性,受到了广泛的关注。表示融合算法的效率往往决定着聚合矩阵的性能。虽然有许多融合算法,但通常忽略了信息冗余和信息互补性。本文提出了一种新的表示融合方法——Capsule Graph Convolutional Network (CapsGCN)。首先,经过单模态表示学习,将提取的音频和视频表示分别用胶囊网络进行提炼,封装成多模态胶囊;多模态胶囊通过动态路由算法可以有效地减少数据冗余。其次,将多式联运胶囊及其相互关系和内部关系视为一个图结构。利用图卷积网络(GCN)对图结构进行学习,得到隐藏表示,是对信息互补性的良好补充。最后,将 CapsGCN 学习到的多模态胶囊和隐式关系表示馈送到多头自注意中,以平衡源表示和关系表示的贡献。为了验证所提出的 CapsGCN 的性能、表征的可视化、常用融合方法的结果和消融研究。我们提出的融合方法在 eNTERFACE05’ 上的准确率达到 80.83%,F1-score 达到 80.23%。

1 Introduction

情绪表达在人际交往中起着至关重要的作用[1],成功地检测情绪状态对人工智能( AI )具有重要的现实意义。情感识别在社交机器人、医疗、教育质量评价等许多人机交互系统中具有相当大的应用前景[2]。特别是在当前新冠疫情的情况下,上述工作更有意义。

人类表达情绪的方式多种多样,如语音[3,4]、肢体动作[5]、面部表情[6]、文字[7]等。单峰信号不能完全传达真实意图。不同的情态描述了同一情感的不同方面。因此,多模态信号鲁棒性更强,更符合人类的表达习惯。在这项工作中,我们研究了音频和视频模式,这是人类最常见和最有效的方式。

多模态情感识别成功的关键是多模态信息的融合。信息融合方法主要分为两类[8]。一个是早期融合(特征级融合)。在早期阶段,将源信号或提取的表示连接为融合表示。Tripathi 等[9]使用双向长短期记忆( Bidirectional Long - Short Term Memory, BLSTM )提取特征,并将提取的表征直接合并。虽然早期的融合方法计算复杂度较低,但冗余的存在降低了信息的有效性。另一种类型的融合是晚期融合(决策级融合)[10,11]。提取的表示或单峰结果在后期进行融合。Zhang 等[12]在分类器之前引入了深度信念网络( Deep Belief Networks, DBN )来融合音频和视频表示。Atmaja 等[13]采用支持向量回归( support vector regression, SVR )将早期和晚期融合结果合并,是一种多步评分级融合。后期融合的缺点是两种模态之间缺乏代表性的互补性。一种混合融合方法被称为 模型级融合,它得益于强大的模型来提高性能。Huang 等[14]引入 Transformer 来融合音频和视频表示。然而,现有的融合方法往往忽略了不同模态之间信息的冗余性和互补性。

胶囊网络( Capsule network, CapsNet )由 Sabour 等人[15]提出,并迅速引入各个研究领域[16,17,18]。在保证信息不丢失的前提下,CapsNet 使用路由算法将信息提炼成“胶囊”。引入图卷积网络( Graph Convolutional Network, GCN )[19]对关系数据进行建模,在自然语言处理( Natural Language Processing, NLP )领域取得了良好的效果[20,21,22]。为了减少冗余和增强互补性,我们提出了一种新的融合方法,胶囊图卷积网络( CapsGCN ),如图 2 所示。首先,引入 CapsNet 将音频和视频表示分别封装到胶囊中。通过动态路由减少了胶囊中信息的冗余。其次,将提取的音视频胶囊及其相互关系和内部关系组成关系图。然后,引入 GCN 来学习音视频胶囊之间的隐藏表示。隐藏表示是对信息互补性的一种很好的补充。最后,将视听胶囊和习得的隐藏表示馈送给多头自注意[23]。

本文的主要工作总结如下:

1) 提出了一种考虑多模态信息冗余和信息互补性的 CapsGCN ;

2) 引入注意机制,平衡不同表示的贡献,进一步减少冗余。

2 基于 caps GCN 的多模态情感表示融合

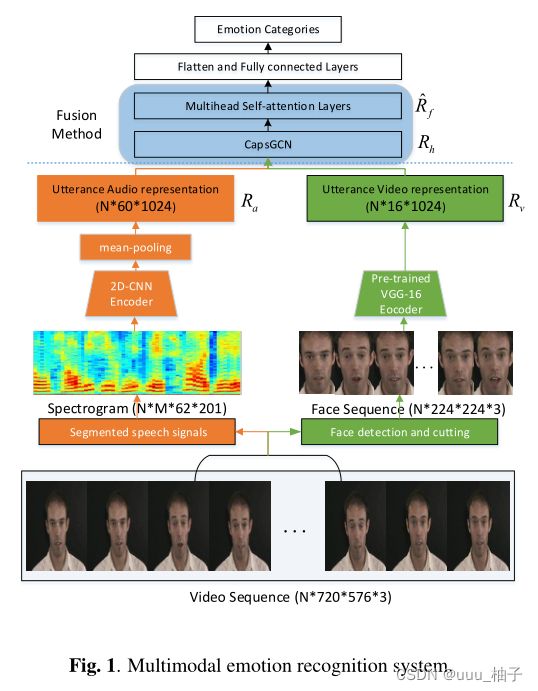

2.1 多模态情感识别系统

所提出的系统如图 1 所示,主要由单模态表示学习和多模态表示融合两部分组成。通过系统的第一部分的两个流来学习表示 R a R_a Ra 和 R v R_v Rv 。多模态表示融合部分是我们提出的整合注意力的 CapsGCN ,具体如图 2 所示。学习到的融合表示 R f ^ \hat{R_f} Rf^之后是 Flatten 层和 fully connected 层。

2.2 单模态表示学习

在这一部分中,我们使用两个流来学习单峰表示。我们将视频序列划分为音频数据和图像数据,帧数为 N N N。对于音频数据,语音信号被划分为重叠 40 m s 40ms 40ms 的 M M M 个片段。然后将语音信号转换为声谱图。我们引入了通用的 2 D − C N N 2D-CNN 2D−CNN 来学习音频表示,并最终得到音频表示 R a R_a Ra( N ∗ 60 ∗ 1024 N*60*1024 N∗60∗1024)。对于图像序列,我们使用 OpenCV 工具包来检测人脸并裁剪人脸图像,其样本如图 1 所示。由于数据缺乏考虑,在视频表示步骤中,我们引入了一个由 ImageNet 训练的预训练模型 VGG-16 [24]。在每个微调 epoch 中,随机选择 16 个人脸图像作为微调数据。这种训练策略是为了防止相邻人脸图像的冗余。最后,我们得到了视频表示 R v R_v Rv( N ∗ 16 ∗ 1024 N*16*1024 N∗16∗1024)。在实验中验证了所学习的表示 R a R_a Ra 和 R v R_v Rv 的有效性。

2.3 基于表示融合的 CapsGCN

CapsNet 输出一个向量而不是单个标量值,这使得它能够学习更明显和复杂的信息。动态路由方法不仅减少了信息冗余,而且避免了有用的情感信息的丢失。

c i j c_{ij} cij 是由“路由 softmax ”确定的耦合系数,如等式(1)所示。

c i j = e x p ( d i j ) ∑ k e x p ( d i k ) ( 1 ) c_{ij} = \dfrac{exp(d_{ij})} {\displaystyle\sum_{k} exp(d_{ik})} \kern10em(1) cij=k∑exp(dik)exp(dij)(1)

其中, l o g i t s d i j logits \kern1em d_{ij} logitsdij 是胶囊 i i i 耦合到胶囊 j j j 的对数先验概率。

u ^ j ∣ i = W i j u i ( 2 ) s j = ∑ i c i j u ^ j ∣ i ( 3 ) \hat{u}_{j|i} = W_{ij} u_i \kern10em(2)\\ s_j = \displaystyle\sum_{i} c_{ij} \hat{u}_{j|i} \kern10em(3) u^j∣i=Wijui(2)sj=i∑ciju^j∣i(3)

在等式 4 中, v j v_j vj 是第 l l l 层中胶囊 j j j 的矢量输出, s j s_j sj 是其总输入。

v j = ∣ ∣ s j ∣ ∣ 2 1 + ∣ ∣ s j ∣ ∣ 2 s j ∣ ∣ s j ∣ ∣ ( 4 ) v_j = \dfrac { ||s_j||^2 } {1 + ||s_j||^2 } \dfrac{s_j} { ||s_j|| } \kern10em(4) vj=1+∣∣sj∣∣2∣∣sj∣∣2∣∣sj∣∣sj(4)

我们使用 CapsNet 对表示 R a R_a Ra 和 R v R_v Rv 进行建模,并获得音频数字帽 D a D_a Da 和 D v D_v Dv:

D a = [ v 0 a , v 1 a , . . . , v k − 1 a , v k a ] D v = [ v 0 v , v 1 v , . . . , v k − 1 v , v k v ] ( 5 ) D_a = [v_0^a, v_1^a, ... , v_{k-1}^a, v_k^a ] \kern 10em \\ D_v = [v_0^v, v_1^v, ... , v_{k-1}^v, v_k^v ] \kern 10em (5) Da=[v0a,v1a,...,vk−1a,vka]Dv=[v0v,v1v,...,vk−1v,vkv](5)

在等式(5)中,在考虑六种情绪类别的情况下,我们设置 k = 6 k=6 k=6 来捕捉简单而明显的信息。GCN 的输入数据是多模态胶囊 R a v R_{av} Rav :

R a v = [ v 0 a , v 1 a , . . . , v k − 1 a , v k a , v 0 v , v 1 v , . . . , v k − 1 v , v k v ] v i ∈ v ( 6 ) R_{av} = [ v_0^a, v_1^a, ... , v_{k-1}^a, v_k^a, v_0^v, v_1^v, ... , v_{k-1}^v, v_k^v ] \kern2em v_i \in v \kern3em(6) Rav=[v0a,v1a,...,vk−1a,vka,v0v,v1v,...,vk−1v,vkv]vi∈v(6)

在等式(6)中, v i v_i vi 表示结点,有向图 G = ( v , ϵ ) G = (v, \epsilon ) G=(v,ϵ),边为 ( v i , r , v j ) ∈ ϵ (v_i, r, v_j) \in \epsilon (vi,r,vj)∈ϵ 。第 t t t 层中的隐藏状态:

h i ( t ) = σ ( G i T ( h i ( t − 1 ) W + b ) ∑ G i ) ( 7 ) h_i^{(t)} = \sigma \bigl ( \dfrac {G_i^T(h_i^{(t-1)} W+b) } {\displaystyle\sum G_i } \bigr ) \kern10em(7) hi(t)=σ(∑GiGiT(hi(t−1)W+b))(7)

σ ( ) \sigma() σ() 是一个 元素激活函数,我们在本文中使用 R e L U ( ) ReLU() ReLU() 。 W W W 是权重矩阵, b b b 是偏差。最后我们得到了隐藏表示 R h R_h Rh。

2.4 注意力机制和情感识别

在多模态表示中,音频和视频模态的原始独立性也很重要。在提出 CapsGCN 之后,我们将 R a v R_{av} Rav 和 R h R_h Rh 连接作为融合表示 R f R_f Rf。融合表示 R f R_f Rf 之后是多头自注意。

A t t ( Q , K , V ) = s o f t m a x ( Q K T D K ) V ( 8 ) Att( Q, K, V ) = softmax \bigl ( \dfrac{QK^T} {\sqrt{D_K} } \bigr) V \kern10em (8) Att(Q,K,V)=softmax(DKQKT)V(8)

在等式(8)中,输入矩阵由 Q , K , V Q, K, V Q,K,V 组成,分别表示是 queries,keys, values,keys 的维度是 D K D_K DK。与其执行 Q、K、V 的单个计算,不如用不同的学习线性投影将查询、键和值线性投影 h 次。h 个结果被级联并一旦投影,产生最终输出 M h ( Q , K , V ) M_h(Q, K, V) Mh(Q,K,V) ,如等式(9)所示。

M h ( Q , K , V ) = W ( A t t 1 + . . . + A t t h ) ( 9 ) M_h \bigl( Q, K, V \bigr) = W \bigl( Att_1 + ... +Att_h \bigr) \kern10em(9) Mh(Q,K,V)=W(Att1+...+Atth)(9)

在等式(9)中, Q = = K = = V = = R f Q == K == V == R_f Q==K==V==Rf 。 R f R_f Rf 在没有共享参数的情况下计算 h h h 次,并且 h h h 个结果被映射到如等式(10)所示的 R f ^ \hat{R_f} Rf^ 上。

R f ^ = M h ( R f ) ( 10 ) \hat{R_f} = M_h(R_f) \kern10em(10) Rf^=Mh(Rf)(10)

这种注意力机制可以在源表示和隐藏表征之间找到平衡,防止个体情绪过于突出,进一步减少冗余。

3 实验

3.1 实验设计

3.1.1 数据集

本文中的所有实验都是在 eENTERFACE05’ [25]上进行的,这是一个英文视听数据库。该数据库包含六个原型情绪类别,即愤怒、厌恶、恐惧、幸福、悲伤和惊讶,由来自 14 个不同国家的 42 名受试者记录。每个受试者被要求连续听六个与情感有关的短篇故事。只有那些对每种情况都有口头和视频反应的受试者,根据两位专家的判断,他们的情绪是以明确的方式表达的,才会被纳入数据库。音频数据以 48kHz 的频率记录。视频数据使用720x576 AVI 格式进行处理,每秒 25 帧。

3.1.2 音频和视频数据预处理

音频数据被划分为重叠 40ms 的等长片段,每个片段被转换为 62×201 的频谱图。因为每个音频样本可以生成多个片段,这将放大训练数据。我们使用 OpenCV 工具包进行人脸检测和切割工作,并获得 224×224 个人脸序列。

3.1.3 音频和视频表示学习

我们使用常用的 2D-CNN [26]作为音频表示学习方法,并使用下面的均值池化层来获得每个话语的表示。对于视频表示学习,我们引入了由 ImageNet 训练的预训练 VGG-16 。我们还设置了两个层来遵循 VGG-16 模型。视频数据对 VGG 模型进行微调,并提取视频表示。所有实验都是在独立于说话者的方案下进行的。

3.2 实验结果与分析

为了验证提取的音频和视频表示以及所提出的融合方法的有效性,我们建立了两组实验来验证其有效性。建立第一组实验的目的是,一是验证预处理和表示学习的有效性,二是展示单峰信息的特征。第二组是展示所提出的融合方法的细节。

3.2.1 音频和视频表示的有效性

为了观察提取的音频和视频表示,引入了 t t t 分布随机邻近嵌入(t-SNE)[27]来可视化六个情绪类别,如图3所示。

我们可以发现这两种分布中的内在关系是不同的。例如,在音频分布中,有很多点在中心混淆在一起,而在视频分布中,Fear(绿色点)非常接近 Suprise(紫色点)。

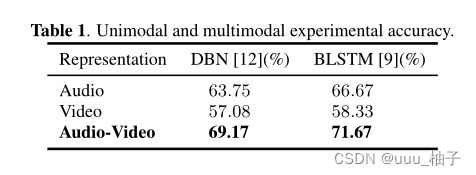

为了验证定量分类性能,我们引入了 DBN [12]和 BLSTM [9]作为最先进的比较实验。在这两个比较实验中,DBN 是以分数级融合的方式引入的,BLSTM 是以特征级融合的形式引入的。单模态和多模态实验的实验结果如表 1 所示:

图 3 和表 1 中的可视化和实验结果验证了我们通过 2D-CNN 和预训练的 VGG-16 提取的表示的有效性。此外,无论是分数级融合还是特征级融合,音频和视频表示的融合都可以带来改进。尽管表示已经被证明是有效的,但这两种最先进的融合方法并没有带来很好的改进。比较算法的性能比较算法由于忽略了信息冗余和信息互补的重要性而受到限制。

3.2.2 所提出的融合方法的验证

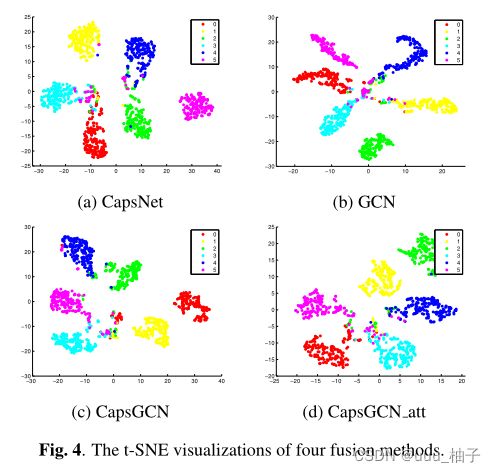

图 4 中的以下四个 t-SNE 可视化:(a)CapsNet、(b)GCN、(c)CapsGCN 和(d)CapsGCN_att 后的音频视频表示。

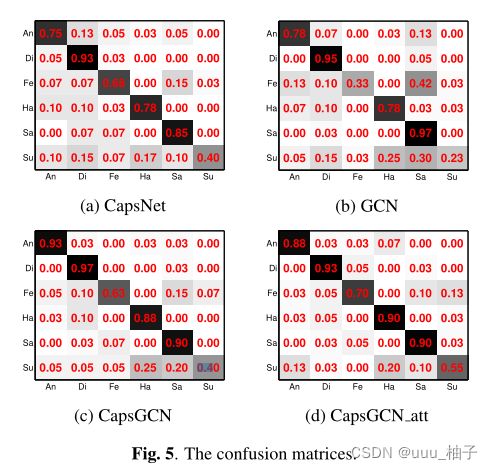

(c)CaspGCN 和(d)CapsGCN_att 中的分布更加清晰。为了定量分析所提出的融合方法,我们在表 2 中提供了消融研究的结果,评估标准为 F1-score 和准确率。同时,消融研究的四个混淆矩阵如图 5 所示。

观察表 2 和图 5 ,可以发现三种现象。第一个原因是 CapsNet 的性能优于 GCN 。这种现象反映了源音频和视频表示具有高冗余度。在不减少冗余的情况下,相互关系和内部关系的计算变得复杂。源音频和视频表示的互补性不能很好地表达。第二个现象是 CapsGCN 的准确率得到了很大的提高。这种情况充分反映了多模态胶囊的互补性得到了很好的释放。同时,对人际关系和内部关系的计算会影响对一些情绪的敏感性,例如恐惧。第三个现象是 CapsGCN_att 实现了最佳性能。引入的注意力机制缓解了某些因素对融合的过度影响,如恐惧和惊讶,这些因素被认为是最困难的。此外,由于注意力权重的增加,冗余度进一步被重新设置。

4 总结

在本文中,我们研究了信息冗余和信息互补在 MER 多模态融合方法中的重要性。所提出的融合方法 CapsGCN 的有效性已在 eNTERFACE05’ 的对比实验和消融研究中得到验证。与传统的融合方法相比,分类准确率达到 80.83% ,绝对增量分别超过 11.66% 和9.16% 。该方法对所有六种情绪都表现出很高的敏感性,尤其是对恐惧、幸福和至上。所提出的融合方法在学习和建模文本信息方面也显示出巨大的潜力。未来,我们计划研究所提出的模型在其他一些多模态数据集上的性能。