【深度学习】日常笔记10

loss_fn = nn.MSELoss(reduction='none')这行代码,在这个上下文中,loss_fn实际上是一个损失函数对象而不是返回的具体值。

使用nn.MSELoss(reduction='none')创建的loss_fn是一个均方误差损失函数对象,而不是计算后的结果。要计算具体的损失值,您需要将输入数据传递给该损失函数并调用它来获取最终的损失值。MSE全称是Mean Squared Error,意为均方误差。

假设你有预测值张量pred和目标值张量target,你可以使用以下代码来计算损失值:

loss_fn = nn.MSELoss(reduction='none')

loss = loss_fn(pred, target)

参数reduction用于指定损失的缩减方式,其中'reduction'的默认值是'reduce_mean'。但在这种情况下,通过设置'reduction'为'none',可以禁用任何缩减操作,返回每个样本的独立损失值。

在这个例子中,loss将是一个张量,其中每个元素表示对应样本的均方误差损失值。这些值的计算将根据输入的pred和target进行。

net = nn.Sequential(nn.Linear(4, 1, bias=False))

这行代码构建了一个神经网络模型net,它是一个序列化的神经网络模型。让我们逐步解释代码的每部分:

- nn.Sequential:这是一个PyTorch提供的类,用于创建序列化的神经网络模型。它允许我们按顺序组合不同层和操作。

- nn.Linear(4, 1, bias=False):这里创建了一个线性层(全连接层),通过指定输入特征维度和输出特征维度来定义该层。参数解释如下:

- 4:表示输入特征的维度为4。在神经网络中,这表示每个输入样本有4个特征。

- 1:表示输出特征的维度为1。这意味着该线性层将把输入特征转换为一个标量输出。

- bias=False:表示不使用偏置项。偏置项通常用于模型学习数据中的平移性质,但在此模型中被设置为False,即不使用偏置项。以下是一些情况下可能希望使用偏置项的示例:①. 数据中存在明显的偏移或基准值,例如图像中的亮度值。②. 在某些问题中,特征向量经过线性变换后添加偏差可以使得模型更好地拟合训练数据。③. 偏置项可以增加模型的容量,使其能够更好地适应复杂的数据分布。

net[0]表示访问nn.Sequential容器中的第一个子模块。在这种情况下,nn.Linear(4, 1, bias=False)是nn.Sequential的唯一一个子模块,因此net[0]就是指代该线性模块。

综上,该代码创建了一个具有单个线性层的简单神经网络模型。输入特征维度为4,输出特征维度为1,并且没有使用偏置项。

欠拟合(underfitting)指的是机器学习模型无法很好地适应训练数据,表现为模型对训练数据和新样本都不能提供良好的拟合效果。简单来说,欠拟合就是模型在训练集上表现不够好,无法捕捉到数据中的规律和模式。

当模型出现欠拟合时,通常会导致以下情况:

- 在训练集上表现较差:模型无法很好地拟合训练数据,预测结果与实际结果之间存在较大的误差。

- 模型过于简单:欠拟合通常是由于模型的复杂度不足所造成的。例如,在线性模型中使用了过少的特征或过低的多项式次数。

- 欠学习:模型没有充分学习到数据中的关键特征和模式,导致预测能力有限。

解决欠拟合问题的一些方法包括:

- 增加模型复杂度:可以增加模型的参数数量、层数或引入更复杂的模型结构,以提高其学习能力。

- 提供更多的训练数据:通过增加样本数量,模型可以更好地学习数据中的规律和模式。

- 特征工程:对输入数据进行适当的特征工程,提取更好的特征表示,以帮助模型更好地学习。

在机器学习中,既要避免模型过于简单而导致欠拟合,也要避免模型过于复杂而导致过拟合。在实践中,需要根据具体问题和数据集的特点来选择合适的模型和调整参数,以获得更好的拟合效果。

我感觉下来就是:要根据数据选模型,数据少了但是选了个超复杂的神经网络模型最终的表现效果也不佳。就是量体裁衣的感觉,少量数据选小模型,大量数据选大模型。

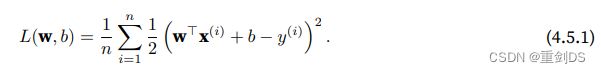

完成最小二乘法(Least Squares Method)的目标可以使用均方误差(Mean Squared Error,MSE)作为其模型的损失函数。均方误差是指将每个样本的预测值与真实值之间的差异平方化,并对所有样本进行求和后再取平均。最小二乘法的目标就是通过调整模型参数使得损失函数(即均方误差)最小化。

最小二乘法适用于线性回归模型和许多其他的回归问题,它通过最小化均方误差来寻找最佳的模型参数。当均方误差最小时,说明预测值与真实值之间的误差较小,模型拟合效果较好。

p151练习

1. 这个多项式回归问题可以准确地解出吗?提⽰:使⽤线性代数。

答:这个问题的答案取决于多项式回归模型的复杂度和数据集的大小。如果模型足够复杂并且数据集足够大,那么多项式回归问题可以准确地解出。但是,如果模型过于简单或者数据集太小,那么多项式回归问题可能会出现过拟合或欠拟合的情况,导致预测结果不准确。

因此,在实际应用中,需要根据具体情况选择合适的模型和算法,并进行交叉验证等方法来评估模型的性能。

3. 如果不对多项式特征x i进⾏标准化(1/i!),会发⽣什么事情?能⽤其他⽅法解决这个问题吗?

答:如果不对多项式特征 x_i 进行标准化(1/i!),会导致训练模型时出现数值不稳定的情况,因为每个特征的尺度不同,可能会导致某些特征对模型的影响更大,从而影响模型的性能。

为了解决这个问题,可以使用标准化方法将特征缩放到相同的尺度上。常用的标准化方法包括最小-最大标准化、Z-score标准化等。这些方法可以将每个特征缩放到均值为0,标准差为1的范围内,使得不同特征之间的尺度差异不会对模型的性能产生太大影响。

除了标准化方法外,还可以使用其他方法来解决这个问题,例如使用正则化方法(如L1或L2正则化)来惩罚模型中的复杂度,或者使用核函数将非线性关系转换为线性关系。这些方法都可以有效地解决多项式回归中的特征尺度问题。

4. 泛化误差可能为零吗?

答:在理论上,泛化误差可以为零。但是,在实际应用中,由于数据的随机性和模型的复杂性,很难达到完全的泛化误差为零。

解决过拟合问题可以通过增加更多的训练数据,不过如果原本的数据都是高质量的,那我们便可以使用正则化技术要解决过拟合。

较小的L2范数值(即下图中的||x||2的公式照搬下,其中,在L2范数中常常省略下标2,也就是说||x||等同于||x||2。)

说明权重向量的长度较短,表示模型的参数规模相对较小。这可能有助于控制模型的复杂度,并提高模型的泛化能力。那要使得权重向量的L2范式值小,那常⽤⽅法是将其范数作为惩罚项加到最⼩化损失的问题中,将原来的训练⽬标

说明权重向量的长度较短,表示模型的参数规模相对较小。这可能有助于控制模型的复杂度,并提高模型的泛化能力。那要使得权重向量的L2范式值小,那常⽤⽅法是将其范数作为惩罚项加到最⼩化损失的问题中,将原来的训练⽬标

最⼩化训练标签上的预测损失,调整为最⼩化预测损失和惩罚项之和

最⼩化训练标签上的预测损失,调整为最⼩化预测损失和惩罚项之和

。这就是防止模型过拟合的正则化技术中的一种:权重衰减(weight decay)。上式的λ是正则化非负常数,为超参数。权重衰减顾名思义,优化算法在训练的每一步都会衰减权重。较小的λ值对权重w的约束小,较大的λ值对权重w的约束大。

。这就是防止模型过拟合的正则化技术中的一种:权重衰减(weight decay)。上式的λ是正则化非负常数,为超参数。权重衰减顾名思义,优化算法在训练的每一步都会衰减权重。较小的λ值对权重w的约束小,较大的λ值对权重w的约束大。

L2正则化线性模型构成经典的岭回归(ridge regression)算法,L1正则化线性回归是统计学中类似的 基本模型,通常被称为套索回归(lasso regression)。常常使⽤L2范数的⼀个原因是它对权重向量的⼤分量施加了巨⼤的惩罚,因为开了平方,那大分量开平方会更大,那么惩罚力度也就越大,这使得学习算法偏向于训练出一个在大量特征上均匀分布权重的模型。相⽐之下,L1惩罚会导致模型将权重集中在⼀⼩部分特征上,⽽将其他权重清除为零。L1正则化会将某些权重变为0的几何解释:在几何上来看,L1正则化在权重空间中对应着一个以坐标轴为边界的菱形区域(L1范数等于常数C定义的曲面)。当进行优化时,为了使目标函数同时满足损失函数的要求和L1正则化的限制条件,权重向量的取值点实际上是与此菱形区域的交点。因为菱形的顶点处对应着某些权重为零的情况,优化算法有可能找到这样的交点,使得某些权重变为零。综上所述,L1正则化惩罚项会促使模型将一部分权重置为零,从而实现特征选择和提高模型的解释性,这可能在某些场景下被需要。

正则化的L2正则化能提升泛化能力的解释:L2正则化通过在损失函数中添加一个正则化项,对模型参数进行惩罚,从而减少模型的复杂度。具体来说,L2正则化通过对参数的平方和进行惩罚,使得模型趋向于选择较小的参数值。这就相当于在损失函数中引入了一个力度较强的约束,要求模型尽量使用较小的参数值来进行拟合。

这种约束的作用是什么呢?可以这样想象:在拟合训练数据时,如果没有正则化项,模型可能会不受约束地选择很大的参数值来使得训练数据拟合得非常好。但这些大型参数值对应于较复杂的模型,容易过度适应训练数据中的噪声和特殊情况,导致泛化能力较差。当模型具有很多参数,且这些参数没有受到约束时,它可以寻找一些非常细微的规律和噪声,并将这些细节也纳入考虑。在拟合训练数据时,它可以通过增加参数值来放大各种细节特征,甚至将噪声也进行拟合。这样做虽然会使得模型在训练集上的表现非常好,但它对于未见过的测试数据可能并不具备良好的泛化能力。而L2正则化通过惩罚大型参数,迫使模型在进行优化时更倾向于选择较小的参数值,从而限制了模型的复杂度,减少了过拟合的风险。

简而言之,L2正则化通过惩罚大型参数,迫使模型选择较小的参数值,从而控制模型的复杂度,减少过拟合的发生,提升模型的泛化能力。