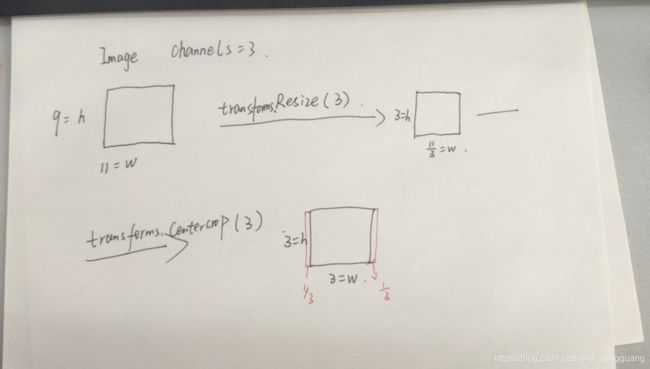

【笔记】transforms 的 Resize 和 CenterCrop:Resize 按比例缩小img得到new_img,CenterCrop在new_img上面截取主要的图片部分

Code1:

from torch.utils.data import Dataset,DataLoader,TensorDataset

import os

import PIL.Image as Image

from torchvision import transforms

import matplotlib.pyplot as plt

import torch as t

class Cudata(Dataset):

def __init__(self):

super(Cudata,self).__init__()

self.data_dir=r"./image_folder"

self.datalist=os.listdir(self.data_dir)

self.cu_transform1=transforms.Compose([

transforms.ToTensor(),

])

self.cu_transform2=transforms.Compose([

transforms.Resize(96),

])

self.cu_transform3=transforms.Compose([

transforms.CenterCrop(96),

])

def __getitem__(self,index):

id=self.datalist[index]

img_path=os.path.join(self.data_dir,id)

img=Image.open(img_path)

img=self.cu_transform1(img)

print(img.shape[1],img.size()[2])

print(img.shape[1]/96,img.size()[2]/96)

print(img.shape[1]/96,img.size()[2]/(img.shape[1]/96))

print(img.shape)

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

img=self.cu_transform2(img)

print(img.shape[1]/96,img.size()[2]/96)

print(img.size())

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

img=self.cu_transform3(img)

print(img.size())

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

input()

print(img)

return img

def __len__(self):

return len(self.datalist)

cu_data=Cudata()

for idx,x in enumerate(cu_data):

print(x.shape)Code2:

from torch.utils.data import Dataset,DataLoader,TensorDataset

import os

import PIL.Image as Image

from torchvision import transforms

import matplotlib.pyplot as plt

import torch as t

class Cudata(Dataset):

def __init__(self):

super(Cudata,self).__init__()

self.data_dir=r"./image_folder"

self.datalist=os.listdir(self.data_dir)

self.cu_transform1=transforms.Compose([

transforms.ToTensor(),

])

self.cu_transform2=transforms.Compose([

transforms.Resize(96),

])

self.cu_transform3=transforms.Compose([

transforms.CenterCrop(96),

])

def __getitem__(self,index):

id=self.datalist[index]

img_path=os.path.join(self.data_dir,id)

img=Image.open(img_path)

img=self.cu_transform1(img)

print(img.shape[1],img.size()[2])

print(img.shape[1]/96,img.size()[2]/96)

print(img.shape[1]/96,img.size()[2]/(img.shape[1]/96))

print(img.shape)

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

print(img)

print(img[2,-3,:])

input()

img=self.cu_transform2(img)

print(img.shape[1]/96,img.size()[2]/96)

print(img.size())

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

print(img)

print(img[2, -3, :])

input()

img=self.cu_transform3(img)

print(img.size())

print(img)

print(img[2, -3, :])

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

input()

return img

def __len__(self):

return len(self.datalist)

cu_data=Cudata()

for idx,x in enumerate(cu_data):

print(x.shape)355 411

3.6979166666666665 4.28125

3.6979166666666665 111.143661971831

torch.Size([3, 355, 411])

/home/wangbin/.config/JetBrains/PyCharmCE2020.3/scratches/scratch_13.py:33: UserWarning: To copy construct from a tensor, it is recommended to use sourceTensor.clone().detach() or sourceTensor.clone().detach().requires_grad_(True), rather than torch.tensor(sourceTensor).

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

tensor([[[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 0., 0., 0.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]],

[[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]],

[[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 0., 0., 0.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]]])

tensor([1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 1., 1., 1.])

/home/wangbin/.config/JetBrains/PyCharmCE2020.3/scratches/scratch_13.py:42: UserWarning: To copy construct from a tensor, it is recommended to use sourceTensor.clone().detach() or sourceTensor.clone().detach().requires_grad_(True), rather than torch.tensor(sourceTensor).

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

1.0 1.15625

torch.Size([3, 96, 111])

tensor([[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]]])

tensor([1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 0.0690, 0.0000, 0.1006, 0.7448, 1.0000,

1.0000, 1.0000, 0.0000])

torch.Size([3, 96, 96])

tensor([[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0690],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0690],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]]])

tensor([1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 0.0690])

Code3:

from torch.utils.data import Dataset,DataLoader,TensorDataset

import os

import PIL.Image as Image

from torchvision import transforms

import matplotlib.pyplot as plt

import torch as t

class Cudata(Dataset):

def __init__(self):

super(Cudata,self).__init__()

self.data_dir=r"./image_folder"

self.datalist=os.listdir(self.data_dir)

self.cu_transform1=transforms.Compose([

transforms.ToTensor(),

])

self.cu_transform2=transforms.Compose([

transforms.Resize([96,111]),

])

self.cu_transform3=transforms.Compose([

transforms.CenterCrop([96,111]),

])

def __getitem__(self,index):

id=self.datalist[index]

img_path=os.path.join(self.data_dir,id)

img=Image.open(img_path)

img=self.cu_transform1(img)

print(img.shape[1],img.size()[2])

print(img.shape[1]/96,img.size()[2]/96)

print(img.shape[1]/96,img.size()[2]/(img.shape[1]/96))

print(img.shape)

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

print(img)

print(img[2,-3,:])

input()

img=self.cu_transform2(img)

print(img.shape[1]/96,img.size()[2]/96)

print(img.size())

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

print(img)

print(img[2, -3, :])

input()

img=self.cu_transform3(img)

print(img.size())

print(img)

print(img[2, -3, :])

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

plt.show()

input()

return img

def __len__(self):

return len(self.datalist)

cu_data=Cudata()

for idx,x in enumerate(cu_data):

print(x.shape)355 411

3.6979166666666665 4.28125

3.6979166666666665 111.143661971831

torch.Size([3, 355, 411])

tensor([[[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 0., 0., 0.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]],

[[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]],

[[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 1., 0., 0.],

[1., 1., 1., ..., 0., 0., 0.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]]])

tensor([1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 1., 1., 1.])

/home/wangbin/.config/JetBrains/PyCharmCE2020.3/scratches/scratch_13.py:42: UserWarning: To copy construct from a tensor, it is recommended to use sourceTensor.clone().detach() or sourceTensor.clone().detach().requires_grad_(True), rather than torch.tensor(sourceTensor).

plt.imshow(t.tensor(img,dtype=t.float32).permute(1,2,0))

1.0 1.15625

torch.Size([3, 96, 111])

tensor([[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]]])

tensor([1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 0.0690, 0.0000, 0.1006, 0.7448, 1.0000,

1.0000, 1.0000, 0.0000])

torch.Size([3, 96, 111])

tensor([[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 1.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]],

[[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.2287],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

...,

[1.0000, 1.0000, 1.0000, ..., 1.0000, 1.0000, 0.0000],

[1.0000, 1.0000, 1.0000, ..., 0.0469, 0.0443, 0.6487],

[1.0000, 1.0000, 1.0000, ..., 0.0000, 0.0000, 1.0000]]])

tensor([1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000, 1.0000,

1.0000, 1.0000, 1.0000, 1.0000, 0.0690, 0.0000, 0.1006, 0.7448, 1.0000,

1.0000, 1.0000, 0.0000])