28.SpringCloud

艾编程架构课程第五十八节笔记未完待续

- SpringCloud服务治理(一)

-

- 1. 什么是服务治理

- 2. 服务治理组件选型比较

- 3. 构建Eureka-Server模块

- 4. 构建Eureka-Client模块

- 5. 构建Eureka-Consumer模型

- 6. Eureka心跳检测与服务剔除

-

- 6.1. 心跳检测的机制

- 6.2. 服务剔除

- 7. Eureka服务续约机制

-

- 7.1. 续约和心跳的关系

- 7.2. 发送Renew续约请求

- 7.3. 续约校验

- 8. Eureka服务自保机制

- 9. Eureka启用心跳和健康检查验证

- 10. 服务注册中心的高可用架构

- SpringCloud负载均衡和远程调用(二)

-

- 1. Ribbon体系架构分析

- 2. 基于Ribbon的应用

- 3. Ribbon负载均衡策略配置

-

- 3.1. 负载均衡的策略

- 3.2. 负载均衡配置

- 3.3. 负载均衡的选择

- 4. Feign进行远程调用的机制

- 5. Feign远程调用实例

- 6. 理想的Feign风格项目结构

-

- 6.1. 抽取一个公共接口层

- 6.2. 新建服务提供者

- 6.3. 改进版的消费者

- 7. Feign服务调用超时重试机制

- 8. 配置Feign超时重试验证

- SpringCloud服务降级熔断(三)

-

- 1. 服务故障场景分析

-

- 1.1. 服务雪崩的场景分析

- 1.2. 线程池耗尽场景分析

- 1.3. 生产环境故障发生流程

- 2. Hystrix体系架构核心功能解析

-

- 2.1. 服务降级(舍)

- 2.2. 服务熔断(断)

- 2.3. 线程隔离(离)

- 3. 服务降级的常用方案

-

- 3.1. 静默处理

- 3.2. 默认值处理

- 3.3. 恢复服务才是王道

- 3.4. 一错再错-多次降级

- 3.5. Request Cache

- 4. Feign+Hystrix实现fallback降级方案

- 5. Hystrix实现timeout降级

- 6. Requet Cache降压实现

- 7. 多级降级实现

- 8. Hystrix超时配置和Ribbon超时重试共用的问题

- 9. 熔断器核心机制理解分析

- 10. Feign集成Hystrix熔断器

- 11. 主链路降级熔断规划

- 12. 线程隔离机制

- 13. Turbine聚合信息服务

- 14. Turbine集成Dashboard

- SpringCloud服务熔断详解(四)

-

- 1. 熔断器核心机制理解分析

- 2. Feign集成Hystrix熔断器

- 3. Turbine聚合信息服务集成Dashboard

-

- 3.1. 创建Turbine服务

- 3.2. Turbine集成Hystrix-dashboard

- SpringCloud配置中心服务

-

- 1. 配置中心在微服务中的应用

-

- 1.1. 系统中常用的文件配置都是如何设置的

- 1.2. 这些配置有什么缺点和不足

- 1.3. 在进行配置统一管理前先对配置项进行一下分类

-

- 1.3.1. 配置项的静态内容

- 1.3.2. 配置项的动态内容

- 1.4. 配置项的功能定义

- 1.5. Config Server核心功能

- 2. 直连式配置中心实施

-

- 2.1. 配置文件设置

- 2.2. 搭建config-server

- 2.3. Client直连配置中心

- 3. 配置中心配置项动态刷新

- 4. 配置中心高可用架构实现

- SpringCloud配置中心&消息总线(五)

- 1. 配置中心的信息加密方式

- 2. 总线式配置架构思考

- 3. 消息总线在微服务中的应用

- 4. BUS和消息队列的集成方式

-

- 4.1. 集成方式

- 4.2. 接入RabbitMQ

- 4.3. 接入Kafka

- 5. 实现总线式架构的配置中心

-

- 5.1. Config Server搭建

- 5.2. Config Client搭建

- 6. GitHub配置更改后自动同步更新

- SpringCloud服务网关(六)

- 1. 服务网关在微服务中的应用

-

- 1.1. 对外服务的难题

- 1.2. 微服务的传达室

-

- 1.2.1. 访问控制

- 1.2.2. 路由规则

- 2. 第二代网关Gateway

- 3. Gateway快速落地实施

- 4. 路由功能详解

-

- 4.1. 路由的组成结构

- 4.2. 负载均衡

- 4.3. 工作流程

- 5. 断言功能详解

-

- 5.1. Path匹配

- 5.2. Method断言

- 5.3. RequestParam断言

- 5.4. Header断言

- 5.5. Cookie断言

- 5.6. 时间片匹配

- 6. 实现断言的配置

- 7. 通过After断言实现定时秒杀

- 8. 过滤器原理和生命周期

- 9. 自定义过滤器实现接口计时功能

- 10. 权限认证方案分析

-

- 10.1. 传统单应用的用户鉴权

- 10.2. 分布式环境下的解决方案

-

- 10.2.1. 同步Session

- 10.2.2. 反向代理:绑定IP或一致性Hash

- 10.2.3. Redis解决方案

- 10.3. 分布式Session的解决方案

-

- 10.3.1. OAuth 2.0

- 10.3.2. JWT鉴权

- SpringCloud服务网关&调用链追踪(七)

- 1. 实现服务网关层JWT鉴权

- 2. 实现服务网关层统一异常返回

-

- 2.1. 异常的种类

- 2.2. 自定义异常封装

- 3. 实现服务网关限流

- 4. 链路追踪在微服务中的作用

- 5. 链路追踪的基本功能

- 6. Sleuth的链路追踪介绍

- SpringCloud服务调用链追踪(八)

- 1. Sleuth的体系架构设计原则

- 2. 调用链路数据模型

- 3. 整合Sleuth追踪调用链路

- 4. 什么是Zipkin

- 5. 搭建配置Zipkin服务

-

- 5.1. zipkin基础服务搭建

- 5.2. 服务集成zipkin

- 6. 实现Zipkin服务高可用

- 7. Sleuth集成ELK实现日志检索

- SpringCloud消息组件-Stream(九)

- 1. 消息驱动在微服务中的应用

- 2. Stream体系结构

- 3. Stream快速落地

- 4. 实现Stream的消息发布订阅

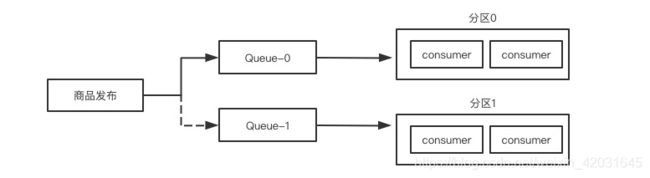

- 5. 消费组和消息分区详解

-

- 5.1. 消费组

- 5.2. 消费分区

- 5.3. 基于消息组实现轮询单播

- 6. Stream实现延时消息

- 7. Stream实现本地重试

- 8. Stream实现消息重新入队

- 9. 异常情况导致消息无法消费的解决方案

- 10. Stream借助死信队列实现异常处理

- 11. 消息驱动中的降级和接口升版

SpringCloud服务治理(一)

1. 什么是服务治理

- 高可用性:除了服务本身要可用,服务治理的框架也要高可用

- 分布式调用:异地灾备,服务治理框架还需要在复杂网络环境下做到精确服务的定位

- 生命周期的管理:服务治理的框架还要管理好服务的上下线

- 健康度检查:对于服务的是否能够正常工作要能定期检查

服务治理的解决方案:

- 服务注册:服务提供方自报家门

- 服务发现:服务消费者需要拉取服务注册列表

- 心跳检测、服务续约、服务剔除:由服务注册中心和服务提供方配合实现

- 服务下线:服务提供方发起主动下线

2. 服务治理组件选型比较

Eureka:Netflix公司

Consul:Spring开源组织直接贡献

Nacos:阿里服务治理中间件

| Eureka | Consul | Nacos | |

|---|---|---|---|

| 一致性 | 弱一致性(AP) | 弱一致性(AP) | AP/CP |

| 性能 | 快 | 慢(RAFT协议Leader选举) | 快 |

| 网络协议 | HTTP | HTTP&DNS | HTTP/DNS/UDP |

| 应用广度 | 主流 | 小众一些 | 发展中 |

3. 构建Eureka-Server模块

spring-cloud-learn父工程的POM

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0modelVersion>

<groupId>com.icodingedu.springcloudgroupId>

<artifactId>spring-cloud-learnartifactId>

<version>1.0-SNAPSHOTversion>

<packaging>pompackaging>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-dependenciesartifactId>

<version>Hoxton.SR3version>

<type>pomtype>

<scope>importscope>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-parentartifactId>

<version>2.2.5.RELEASEversion>

<type>pomtype>

<scope>importscope>

dependency>

dependencies>

dependencyManagement>

<dependencies>

<dependency>

<groupId>org.projectlombokgroupId>

<artifactId>lombokartifactId>

<version>1.18.12version>

dependency>

dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.pluginsgroupId>

<artifactId>maven-compiler-pluginartifactId>

<version>3.6.0version>

<configuration>

<source>1.8source>

<target>1.8target>

<encoding>UTF-8encoding>

configuration>

plugin>

plugins>

build>

project>

创建子项目eureka-server的POM文件

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-learnartifactId>

<groupId>com.icodingedu.springcloudgroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>eureka-serverartifactId>

<name>eureka-servername>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-serverartifactId>

dependency>

dependencies>

project>

application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.netflix.eureka.server.EnableEurekaServer;

@SpringBootApplication

//注册中心的服务

@EnableEurekaServer

public class EurekaServerApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(EurekaServerApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

properties的设置

# 切记一定要加

spring.application.name=eureka-server

server.port=20001

eureka.instance.hostname=localhost

# 是否发起服务器注册,服务端关闭

eureka.client.register-with-eureka=false

# 是否拉取服务注册表,服务端是生成端不用拉取

eureka.client.fetch-registry=false

4. 构建Eureka-Client模块

创建Eureka-Client的项目模块

引入POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-learnartifactId>

<groupId>com.icodingedu.springcloudgroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>eureka-clientartifactId>

<name>eureka-clientname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

dependencies>

project>

application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

@SpringBootApplication

@EnableDiscoveryClient

public class EurekaClientApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(EurekaClientApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

controller服务提供内容

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.pojo.PortInfo;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.stereotype.Controller;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

@RestController

@Slf4j

public class EurekaClientController {

@Value("${server.port}")

private String port;

@GetMapping("/sayhello")

public String sayHello(){

return "my port is "+port;

}

@PostMapping("/sayhello")

public PortInfo sayPortInfo(@RequestBody PortInfo portInfo){

log.info("you are "+portInfo.getName()+" is "+portInfo.getPort() );

return portInfo;

}

}

pojo

package com.icodingedu.springcloud.pojo;

import lombok.Data;

@Data

public class PortInfo {

private String name;

private String port;

}

application配置

spring.application.name=eureka-client

server.port=20002

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

5. 构建Eureka-Consumer模型

创建一个Eureka-Consumer的模块

引入POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-learnartifactId>

<groupId>com.icodingedu.springcloudgroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>eureka-consumerartifactId>

<name>eureka-consumername>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

dependencies>

project>

启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.context.annotation.Bean;

import org.springframework.web.client.RestTemplate;

@SpringBootApplication

@EnableDiscoveryClient

public class EurekaConsumerApplication {

@Bean

public RestTemplate restTemplate(){

return new RestTemplate();

}

public static void main(String[] args) {

new SpringApplicationBuilder(EurekaConsumerApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

controller实现调用

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.pojo.PortInfo;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.loadbalancer.LoadBalancerClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

@RestController

@Slf4j

public class ConsumerController {

//Consumenr+RestTemplate

@Autowired

private RestTemplate restTemplate;

//Eureka+Ribbon

@Autowired

private LoadBalancerClient client;

@GetMapping("/hello")

public String hello(){

ServiceInstance instance = client.choose("eureka-client");

if(instance==null){

return "No available instance";

}

String target = String.format("http://%s:%s/sayhello",instance.getHost(),instance.getPort());

log.info("url is {}",target);

return restTemplate.getForObject(target,String.class);

}

@PostMapping("/hello")

public PortInfo portInfo(){

ServiceInstance instance = client.choose("eureka-client");

if(instance==null){

return null;

}

String target = String.format("http://%s:%s/sayhello",instance.getHost(),instance.getPort());

log.info("url is {}",target);

PortInfo portInfo = new PortInfo();

portInfo.setName("gavin");

portInfo.setPort("8888");

return restTemplate.postForObject(target,portInfo,PortInfo.class);

}

}

pojo

package com.icodingedu.springcloud.pojo;

import lombok.Data;

@Data

public class PortInfo {

private String name;

private String port;

}

application的配置文件

spring.application.name=eureka-consumer

server.port=20003

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

启动进行consumer测试:server、client、consumer

6. Eureka心跳检测与服务剔除

6.1. 心跳检测的机制

- 客户端发起:心跳是由服务节点根据配置时间主动发起

- 同步状态:还要告知注册中心自己的状态(UP、DOWN、STARTING、OUT_OF_SERVICE,UNKNOW)

- 服务剔除:服务中心剔除,主动剔除长时间没有发心跳的节点

- 服务续约

# 两个核心的Eureka-Client配置

# 每隔10秒向Eureka-Server发送一次心跳包

eureka.instance.lease-renewal-interval-in-seconds=10

# 如果Eureka-Server在这里配置的20秒没有心跳接收,就代表这个节点挂了

eureka.instance.lease-expiration-duration-in-seconds=20

# 这两个参数是配置在服务提供节点

6.2. 服务剔除

-

1、启动定时任务来轮询节点是否正常,默认60秒触发一次剔除任务,可以修改间隔

# 配置在Eureka-Server上 eureka.server.eviction-interval-timer-in-ms=30000 -

2、调用evict方法来进行服务剔除

如果自保开启,注册中心就会中断服务剔除操作

-

3、遍历过期服务,如和判断服务是否过期,以下任意一点满足即可

- 已被标记为过期

- 最后一次心跳时间+服务端配置的心跳间隔<当前时间

-

4、计算可剔除的服务总数,所有的服务是否能被全部剔除?当然不能!设定了一个稳定系数(默认0.85),这个稳定系数就是只在注册的服务总数里只能剔除:总数*85%个,比如当前100个服务,99个已经over了,只能剔除85个over,剩下的14个over的不会剔除

eureka.server.renewal-percent-threshold=0.85 -

5、乱序剔除服务:随机到哪个过期服务就把他踢下线

7. Eureka服务续约机制

7.1. 续约和心跳的关系

**同步时间:**心跳、续约、剔除

我们先来说说续约和心跳的关系,服务续约分为两步

- 第一步 是将服务节点的状态同步到注册中心,意思是通知注册中心我还可以继续工作,这一步需要借助客户端的心跳功能来主动发送。

- 第二步 当心跳包到达注册中心的时候,那就要看注册中心有没有心动的感觉了,他有一套判别机制,来判定当前的续约心跳是否合理。并根据判断结果修改当前instance在注册中心记录的同步时间。

接下来,服务剔除并不会和心跳以及续约直接打交道,而是通过查验服务节点在注册中心记录的同步时间,来决定是否剔除这个节点。

所以说心跳,续约和剔除是一套相互协同,共同作用的一套机制

7.2. 发送Renew续约请求

接下来,就是服务节点向注册中心发送续约请求的时候了

-

服务续约请求 在前面的章节里我们讲到过,客户端有一个DiscoverClient类,它是所有操作的门面入口。所以续约服务就从这个类的renew方法开始

-

发送心跳

服务续约借助心跳来实现,因此发给注册中心的参数和上一小节的心跳部分写到的一样,两个重要参数分别是服务的状态(UP)和lastDirtyTimeStamp

- 如果续约成功,注册中心则会返回200的HTTP code

- 如果续约不成功,注册中心返回404,这里的404并不是说没有找到注册中心的地址,而是注册中心认为当前服务节点并不存在。这个时候再怎么续约也不灵验了,客户端需要触发一次重新注册操作。

-

在重新注册之前,客户端会做下面两个小操作,然后再主动调用服务册流程。

- 设置lastDirtyTimeStamp 由于重新注册意味着服务节点和注册中心的信息不同步,因此需要将当前系统时间更新到“lastDirtyTimeStamp”

- 标记自己为脏节点

-

当注册成功的时候,清除脏节点标记,但是lastDirtyTimeStamp不会清除,因为这个属性将会在后面的服务续约中作为参数发给注册中心,以便服务中心判断节点的同步状态。

7.3. 续约校验

注册中心开放了一系列的HTTP接口,来接受四面八方的各种请求,他们都放在com.netflix.eureka.resources这个包下。只要客户端路径找对了,注册中心什么都能帮你办到

-

接受请求 InstanceResource下的renewLease方法接到了服务节点的续约请求。

-

尝试续约

服务节点发起续约请求。注册中心进行校验,从现在算到下一次心跳间隔时间,如果你没来renew,就当你已经死掉了。注册中心此时会做几样简单的例行检查,如果没有通过,则返回404,不接受反驳

- 你以前来注册过吗?没有?续约失败!带齐资料工作日前来办理注册!

- 你是Unknown状态?回去回去,重新注册!

-

脏数据校验 如果续约校验没问题,接下来就要进行脏数据检查。到了服务续约最难的地方了,脏数据校验逻辑之复杂,如同这皇冠上的明珠。往细了说,就是当客户端发来的lastDirtyTimeStamp,晚于注册中心保存的lastDirtyTimeStamp时(每个节点在中心都有一个脏数据时间),说明在从服务节点上次注册到这次续约之间,发生了注册中心不知道的事儿(数据不同步)。这可不行,这搞得我注册中心的工作不好有序开展,回去重新注册吧。续约不通过,返回404。

8. Eureka服务自保机制

- 以下两个Eureka的服务机制是不能共存的,注册中心在统一时刻只能实行以下一种方法

- 服务剔除

- 服务自保

服务自保:把当前系统所有的节点保留,一个都不能少,即便服务节点挂了也不剔除

服务自保的触发机关

- 服务自保由两个机关来触发

- 自保机制在服务启动的15分钟内自动触发检查,如果成功续约的节点低于限定值(默认85%)就开启自保服务,自保服务开启就中断服务剔除操作

手动关闭服务自保

配置强行关闭服务自保,即便上面的自动开关被触发,也不能开启自保功能了

eureka.server.enable-self-preservation=false

9. Eureka启用心跳和健康检查验证

在eureka-client里配置

# 测试设置,生产环境第一个值要比第二个小

eureka.instance.lease-renewal-interval-in-seconds=30

eureka.instance.lease-expiration-duration-in-seconds=5

在eureka-server配置

# 测试设置

eureka.server.enable-self-preservation=false

eureka.server.eviction-interval-timer-in-ms=10000

10. 服务注册中心的高可用架构

微服务架构中每一个较大业务领域都有自己的注册中心

eureka-server如果挂了,consumer依然可以使用server挂掉前的服务列表进行访问,但新的服务无法进行治理了

如何确保服务中心的高可用呢

如果要实现HA,就是通过镜像节点,我们再copy一个eureka-server

# eureka-server配置互相注册的节点即可

eureka.client.service-url.defaultZone=http://eurekaserver2:20011/eureka/

# eureka-client和eureka-consumer调用可以用csv确保调用的HA

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/,http://localhost:20002/eureka/

SpringCloud负载均衡和远程调用(二)

1. Ribbon体系架构分析

负载均衡(Load Balance)

- 客户端负载均衡

- 由调用方进行负载判断,这就需要一个服务的注册列表来进行选择和访问

- 通过本地指定的负载均衡策略来调用服务列表中的哪个服务

- 对开发人员友好,完全由开发来控制,运维成本低,但强强依赖服务注册中心

- 客户端一般使用微服务框架实现(Ribbon)

- 服务端负载均衡

- 在客户端和服务端之间架设了一个负载均衡服务组件。通过这个服务组件进行负载均衡

- 通过是在一个服务应用,进行负载均衡的配置,通常不依赖服务注册中心

- 通过使用Nginx、HAProxy、Lvs、F5这些负载均衡器来实现

Ribbon的体系结构分析

- IPing:是Ribbon的一套健康检查机制

- IRule:这就是Ribbon负载均衡的组件库,所有经过Ribbon的请求都会经过IRule获取负载均衡的机器

2. 基于Ribbon的应用

创建一个带ribbon的eureka-consumer应用,可以直接复制之前的eureka-consumer项目

POM里加入ribbon的依赖功能

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-ribbonartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

dependencies>

在Application里给RestTemplate增加LoadBalance的注解

@SpringBootApplication

@EnableDiscoveryClient

public class RibbonConsumerApplication {

@Bean

@LoadBalanced

public RestTemplate restTemplate(){

return new RestTemplate();

}

public static void main(String[] args) {

new SpringApplicationBuilder(RibbonConsumerApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

Controller进行一下修改,直接调用client服务即可

package com.icodingedu.springcloud.controller;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.web.client.RestTemplate;

@RestController

@Slf4j

public class ConsumerController {

@Autowired

private RestTemplate restTemplate;

@GetMapping("/hello")

public String hello(){

return restTemplate.getForObject("http://eureka-client/sayhello",String.class);

}

}

Properties的配置

spring.application.name=ribbon-consumer

server.port=30099

# 服务提供者连接的注册中心

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

Ribbon是在第一次加载的时候才会去初始化LoadBanlancer,第一次不仅包好HTTP连接和业务请求还包含LoadBanlancer的创建耗时,假如你的方法本身就比较耗时,并且你设置的超时时间不是很长,就很有可能导致第一次HTTP调用失败,这是ribbon的懒加载模式导致的,默认就是懒加载的

# ribbon开启饥饿加载模式,在启动时就加载LoadBanlancer配置

ribbon.eager-load.enabled=true

# 指定饥饿加载的服务名称

ribbon.eager-load.clents=ribbon-consumer

3. Ribbon负载均衡策略配置

3.1. 负载均衡的策略

- 1、轮询(RoundRobinRule):轮询有一个上限,当轮询了10个服务节点都不可用,轮询个结束

- 2、随机(RandomRule):使用jdk自带的随机数生产工具,生成一个随机数,当前节点不可用继续随机,直到随机到可用服务为止

- 3、可用过滤策略(AvailabilityFilteringRule):过滤掉连接失败的和高并发的,然后从健康的节点中使用轮询策略选出一个节点

- 4、轮询失败重试(RetryRule):使用轮询策略,如果第一个节点失败,会retry下一个节点,如果还失败就返回失败

- 5、并发量最小可用策略(BestAvailableRule):会轮询所有节点获取并发量,在其中选择一个最小的进行服务调用,优点:将服务打到最小并发节点,缺点:需要获取所有节点的并发量,比较耗时

- 6、响应时间权重策略(WeightedResponseTimeRule):根据响应时间,分配一个weight权重,最长权重越小,被选中的可能性就越低,服务刚启动由于信息量不足,会使用轮询方式,待信息充足后切换

- 7、ZoneAvoidanceRule:复合判断server所在区域的性能和server可用性来选择server

3.2. 负载均衡配置

全局的负载均衡策略

package com.icodingedu.springcloud.config;

import com.netflix.loadbalancer.IRule;

import com.netflix.loadbalancer.RoundRobinRule;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class RibbonConfiguration {

@Bean

public IRule defaultLBStrategy(){

return new RoundRobinRule();

}

}

指定服务的负载均衡配置

方法一:properites里指定服务名对应的负载均衡策略

eureka-client.ribbon.NFLoadBalancerRuleClassName=com.netflix.loadbalancer.RandomRule

方法二:在configuration上注解实现

@Configuration

@RibbonClient(name = "eureka-client",configuration = com.netflix.loadbalancer.RandomRule.class)

public class RibbonConfiguration {

}

3.3. 负载均衡的选择

在Ribbon里有两个时间和空间密切相关的负载均衡策略:BestAvailableRule(BA)、WeightedResponseTimeRule(WRT)共同目标都是需要负载选择压力小的服务节点,BA选择并发量最小的机器也就是空间选择,WRT根据时间选择响应最快的服务

对于连接敏感型的服务模型,使用BestAvailableRule策略最合适

对于响应时间敏感的服务模型,使用WeightedResponseTimeRule策略最合适

如果使用了熔断器,用AvailabilityFilteringRule进行负载均衡

4. Feign进行远程调用的机制

Eureka:http://ip:port/path

Ribbon:http://serviceName/path

引入Fegin组件来进行远程调用,这两个组件也一并被引入

-

Ribbon:利用负载均衡策略进行目标机器选择

-

Hystrix:根据熔断状态的开启状态,决定是否发起远程调用

-

发送请求时有两个核心的点

- 重试

- 降级

5. Feign远程调用实例

建立一个feign的文件夹并创建一个feign-consumer的应用

添加POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>feign-consumerartifactId>

<name>feign-consumername>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-openfeignartifactId>

dependency>

dependencies>

project>

启动类实现

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableDiscoveryClient

@EnableFeignClients

public class FeignConsumerApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(FeignConsumerApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

创建调用的Service接口引用实现

package com.icodingedu.springcloud.service;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.web.bind.annotation.GetMapping;

//eureka服务提供者的service-name

//这个注解的意思是IService这个接口的调用都发到eureka-client这个服务提供者上

@FeignClient("eureka-client")

public interface IService {

@GetMapping("/sayhello")

String sayHello();

}

创建一个controller实现

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.service.IService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class FeignController {

@Autowired

private IService service;

@GetMapping("/sayhi")

public String sayHi(){

return service.sayHello();

}

}

创建配置properties

spring.application.name=feigon-consumer

server.port=40001

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

6. 理想的Feign风格项目结构

6.1. 抽取一个公共接口层

在feigon目录下创建项目feigon-client-intf

POM里仅保持最低限度依赖,不要添加过多依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>feign-client-intfartifactId>

<name>feign-client-intfname>

<dependencies>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-openfeignartifactId>

dependency>

dependencies>

project>

建立接口层,并将实体对象放进来

package com.icodingedu.springcloud.service;

import com.icodingedu.springcloud.pojo.PortInfo;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

//这里不能再使用eureka-client的了,需要使用自己的

//如果提供给的下游应用没有使用feign就不加注解@FeignClient,@GetMapping,@PostMapping,就是一个简单的接口,让下游自己实现即可

@FeignClient("feign-client")

public interface IService {

@GetMapping("/sayhello")

String sayHello();

@PostMapping("/sayhello")

PortInfo sayHello(@RequestBody PortInfo portInfo);

}

pojo实体对象

package com.icodingedu.springcloud.pojo;

import lombok.Data;

@Data

public class PortInfo {

private String name;

private String port;

}

6.2. 新建服务提供者

在feign目录中创建项目feign-client-advanced

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>feign-client-advancedartifactId>

<name>feign-client-advancedname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>com.icodingedugroupId>

<artifactId>feign-client-intfartifactId>

<version>${project.version}version>

dependency>

dependencies>

project>

创建application的启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

@EnableDiscoveryClient

@SpringBootApplication

public class FeignClientAdvancedApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(FeignClientAdvancedApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

在Controller里实现feign-client-intf里的IService

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.pojo.PortInfo;

import com.icodingedu.springcloud.service.IService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.web.bind.annotation.RestController;

@RestController

@Slf4j

public class FeignController implements IService {

@Value("${server.port}")

private String port;

@Override

public String sayHello() {

return "my port is "+port;

}

@Override

public PortInfo sayHello(@RequestBody PortInfo portInfo) {

log.info("you are "+portInfo.getName());

portInfo.setName(portInfo.getName());

portInfo.setPort(portInfo.getPort());

return portInfo;

}

}

配置Properties

spring.application.name=feign-client

server.port=40002

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

6.3. 改进版的消费者

创建feign-consumer-advanced

设置POM文件,可以从feign-client-advanced里取

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>feign-consumer-advancedartifactId>

<name>feign-consumer-advancedname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>com.icodingedugroupId>

<artifactId>feign-client-intfartifactId>

<version>${project.version}version>

dependency>

dependencies>

project>

创建启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableDiscoveryClient

//这个地方要注意IService所在包路径,默认是扫当前包com.icodingedu.springcloud

//如果接口不在同一个包下就需要把包路径扫进来

//@EnableFeignClients(basePackages = "com.icodingedu.*")

@EnableFeignClients

public class FeignConsumerAdvancedApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(FeignConsumerAdvancedApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

controller实现

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.pojo.PortInfo;

import com.icodingedu.springcloud.service.IService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RestController;

@RestController

@Slf4j

public class FeignController {

@Autowired

private IService service;

@GetMapping("/sayhi")

public String sayHi(){

return service.sayHello();

}

@PostMapping("/sayhi")

public PortInfo sayHello(@RequestBody PortInfo portInfo){

return service.sayHello(portInfo);

}

}

properties的实现配置

spring.application.name=feign-consumer-advanced

server.port=40003

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

7. Feign服务调用超时重试机制

# feign的调用超时重试机制是由Ribbon提供的

# feign-server-proivder是指你的服务名

feign-server-proivder.ribbon.OkToRetryOnAllOperations=true

feign-server-proivder.ribbon.ConnectTimeout=1000

feign-server-proivder.ribbon.ReadTimeout=2000

feign-server-proivder.ribbon.MaxAutoRetries=2

feign-server-proivder.ribbon.MaxAutoRetriesNextServer=2

上面的参数设置了feign服务的超时重试策略

OkToRetryOnAllOperations:比如POST、GET、DELETE这些HTTP METHOD哪些可以Retry,设置为true表示都可以,这个参数是为幂等性设计的,默认是GET可以重试

ConnectTimeout:单位ms,创建会话的连接时间

ReadTimeout:单位ms,服务的响应时间

MaxAutoRetries:当前节点重试次数,访问次数等于首次访问+这里配置的重试次数

MaxAutoRetriesNextServer:当前机器重试超时后Feign将连接新的机器节点访问的次数

按照上面配置的参数,最大超时时间是?

(1000+2000) x (1+2) x (1+2) = 27000ms

总结一下极值函数

MAX(Response Time)=(ConnectTimeout+ReadTimeout)*(MaxAutoRetries+1)*(MaxAutoRetriesNextServer+1)

8. 配置Feign超时重试验证

在feign-consumer-advanced里进行配置即可

# feign-client:这个是自己定义的服务名

# 每台机器最大的重试次数

feign-client.ribbon.MaxAutoRetries=2

# 可以重试的机器数量

feign-client.ribbon.MaxAutoRetriesNextServer=2

# 连接请求超时的时间限制ms

feign-client.ribbon.ConnectTimeout=1000

# 业务处理的超时时间ms

feign-client.ribbon.ReadTimeout=2000

# 默认是false,默认是在get上允许重试

# 这里是在所有HTTP Method进行重试,这里要谨慎开启,因为POST,PUT,DELETE如果涉及重试就会出现幂等问题

feign-client.ribbon.OkToRetryOnAllOperations=true

配置完毕后进行测试验证

在feign-client-intf里增加接口retry接口

@GetMapping("/retry")

String retry(@RequestParam(name = "timeout") int timeout);

在feign-client-advanced里实现这个接口

@Override

public String retry(@RequestParam(name="timeout") int timeout) {

try {

while (timeout-- > 0) {

Thread.sleep(1000);

}

}catch (Exception ex){

ex.printStackTrace();

}

log.info("retry is "+port);

return port;

}

在feign-consumer-advanced的controller里实现

@GetMapping("/retry")

public String retry(@RequestParam(name = "timeout") Integer timeout){

return service.retry(timeout);

}

启动三个feign-client-advanced

进行超时验证并看控制台数据是是每个节点输出三次,重试三个机器

SpringCloud服务降级熔断(三)

1. 服务故障场景分析

缓存雪崩我们在之前的课程中都已经掌握过了,我们看一下另一个雪崩,那就服务雪崩

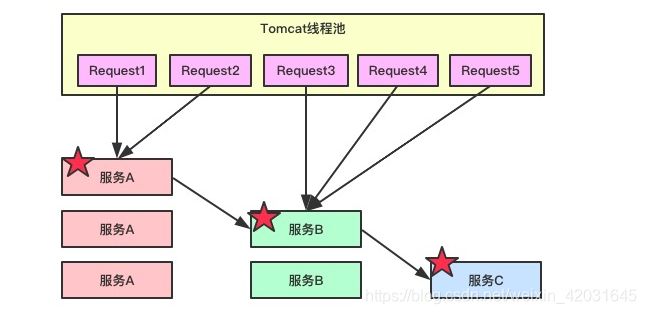

1.1. 服务雪崩的场景分析

先来看一下这个场景:

- 首先我们有三组服务对外提供服务,服务C的业务压力最小所以只有一个节点

- 从访问的线程池中来了5个请求到达服务,互相的调用关系如图所示,直接访问服务或间接调用

目前异常场景出现了:

- 如果我们的服务C由于代码原因或数据库连接池耗光导致访问非常慢,那么调用服务C的业务就会收到timeout的响应

- 这是所有到服务C的业务都timeout了,如果我们不做管控,这个timeout就会蔓延到服务B,进而到服务A,整条链路就会蔓延整个服务集群,所有请求的5个request直接团灭

- 这个时候如果不对服务做任何处理,新进来的业务请求也只是送人头而已

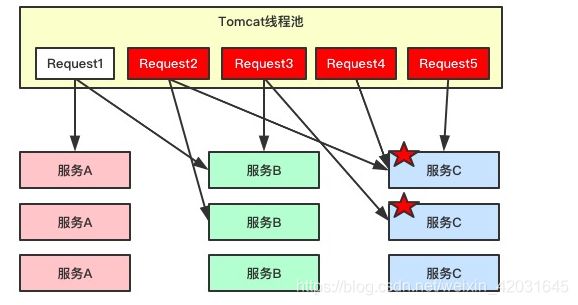

1.2. 线程池耗尽场景分析

场景分析:

- 请求从Tomcat中发起进行服务调用,会同时调用多个

- 这个时候服务C的应用处于一种时好时坏的状态,调用他的请求就会被夯在那里进行等待

- 虽然在调用C的同时也会调用其他服务,但由于C调用等待时间较长,这就导致请求一直挂起

- 挂起的请求多了后,并发的连接增大,Tomcat的连接池资源就会耗尽

这个时候如何处理,就需要通过线程隔离来解决

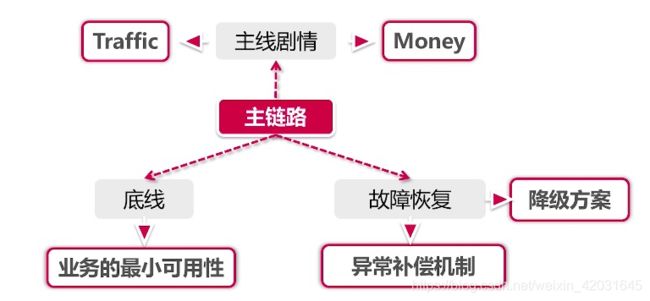

1.3. 生产环境故障发生流程

在生产环境中系统故障发生的严重状态一般有以下几步

- 访问延迟

- 服务不可用404/503/504

- 造成资损

这里就要再次提到主链路的概念了,如果商品详情页的评价模块挂了几分钟,这没有问题,但如果商品下单流程挂了几分钟,那就会导致资金损失了

熔断和降级的核心目的就是为了保障系统的主链路稳定

如何降低故障影响

- 隔离异常服务:降低串联影响做到线程级隔离

- 服务减压:服务快速失败触发熔断机制

- 备选方案:通过降级机制确保主链路可用的情况下实现系统最小可用性

2. Hystrix体系架构核心功能解析

《断舍离》,是日本作家山下英子的著作,这本书传达了一种生活理念。断=不买、不收取不需要的东西。舍=处理掉堆放在家里没用的东西。离=舍弃对物质的迷恋,让自己处于宽敞舒适,自由自在的空间。

对过往不迷恋,拿得起放得下,这样的生活哲学确实可以帮助人们度过一些困难时期。我们知道Hystrix也是为了帮服务节点度过他们的困难时期(缓解异常、雪崩带来的影响),它也有同样一套佛系的设计理念,分别对应Hystrix中三个特色功能

- 断 - 熔断

- 舍 - 降级

- 离 - 线程隔离

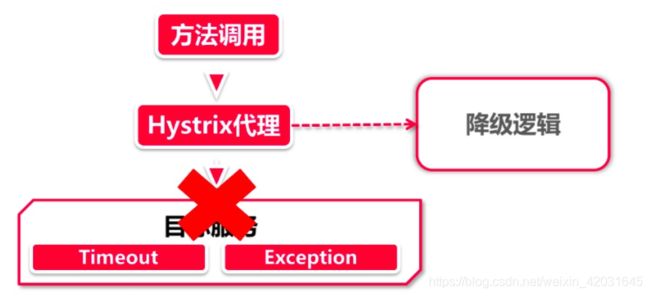

2.1. 服务降级(舍)

微服务架构强调高可用,但并非高一致性,在一致性方面远比不上银行的大型机系统。也就是说,在日常服务调用阶段会出现一系列的调用异常,最常见的就是服务下线。举个例子:重启服务节点的时候,服务下线指令发送到注册中心后,这时还没来得及通过服务发现机制同步到客户端,因此某些服务调用请求依然会发送到这台机器,但由于服务已经下线,最终调用方只能无功而返,404 Not Found。

再举一个破坏力更大的例子。前面我们讲到了服务的雪崩效应,大家可能只听说过缓存雪崩,其实雪崩效应不仅仅针对缓存,它更大的危害是在大规模分布式应用上。我们举一个真实的案例,电商系统很多模块都依赖营销优惠服务,比如商品详情页、搜索列表页、购物车页和下单页面都依赖营销服务来计算优惠价格,因此这个服务承载的负载压力可谓非常之高。我们设想,假如这个服务出现了异常,导致响应超时,那么所有依赖它的下游系统的响应时间都会被拉长,这就引发了一个滚雪球的雪崩效应,由最上游的系统问题,引发了一系列下游系统响应超时,最终导致整个系统被拖垮。

服务降级用来应对上面的几种情况再合适不过了,假如HystrixClient调用目标请求的时候发生异常(exception),这时Hystrix会自动把这个请求转发到降级逻辑中,由服务调用方来编写异常处理逻辑。对响应超时的场景来说,我们可以通过配置Hystrix的超时等待时间(和Ribbon的timeout是两个不同配置),把超时响应的服务调用也当做是异常情况,转发到fallback逻辑中进行处理。

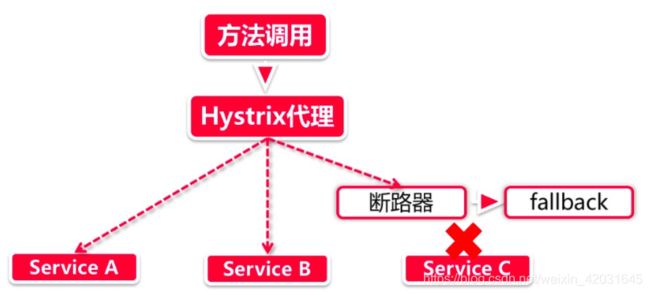

2.2. 服务熔断(断)

服务熔断是建立在服务降级之上的一个异常处理措施,你可以将它看做是服务降级的升级版。服务降级需要等待HTTP请求从服务节点返回异常或超时,再转向fallback逻辑,但是服务熔断引入了一种叫“断路器/熔断器”的机制,当断路器打开的时候,对服务的调用请求不会发送到目标服务节点,直接转向fallback逻辑。

断路器的打开/关闭有很多的判断标准,我们在服务熔断小节里再深入探讨。(好吧,这里我先剧透一点好了,比如我们可以这样设置:每10个请求,失败数量达到8个的时候打开断路器)。

同学可能会问了,假如断路器打开之后,就这么一直开着吗?当然不是了,一直开着多浪费电啊。服务一时失败,不代表一直失败,Hystrix也有一些配置规则,会主动去判断断路器关闭的时机。在后续章节,我们再来深入学习断路器的状态流转过程,我会带大家通过Turbine监控大盘,查看Hystrix断路器的开启关闭。

断路器可以显著缓解由QPS(Query Per Second,每秒访问请求,用来衡量系统当前压力)激增导致的雪崩效应,由于断路器打开后,请求直接转向fallback而不会发起服务调用,因此会大幅降低承压服务的系统压力。

2.3. 线程隔离(离)

大家知道Web容器通常有一个线程池来接待来访请求,如果并发量过高,线程池被打满了就会影响后面请求的响应。在我们应用内部,假如我们提供了3个微服务,分别是A,B,C。如果请求A服务的调用量过多,我们会发现所有可用线程都会逐渐被Service A占用,接下来的现象就是服务B和服务C没有系统资源可供调用。

Hystrix通过线程隔离的方案,将执行服务调用的代码与容器本身的线程池(比如tomcat thread pool)进行隔离,我们可以配置每个服务所需线程的最大数量,这样一来,即便一个服务的线程池被吃满,也不会影响其他服务。

与线程隔离相类似的还有“信号量”技术,稍后的小节我们会对两个技术做一番对比,看看这两个技术方案适合在哪些业务场景里应用。

3. 服务降级的常用方案

3.1. 静默处理

所谓的静默处理,就是什么也不干,在fallback逻辑中直接返回一个空值Null。

同学们可能会问,那我用try-catch捕捉异常不也是能达到一样的效果吗?其实不然,首先try-catch只能处理异常抛出的情况,并不能做超时判定。其次,使用try-catch就要在代码里包含异常处理块,我们在程序设计时讲究单一职责和开闭原则。既然有了专门的fallback处理类,这个工作还是交给fallback来吧,这样你的业务代码也会很清爽。

3.2. 默认值处理

默认值处理实际上就是说个谎话,在并不确定真实结果的情况下返回一个默认值

假如在商品详情页调用营销优惠接口时发生了故障,无法返回正确的计算结果,这里我们就可以在fallback逻辑中返回商品原价,作为打折后的价格,这样就相当于返回了一个没有打折优惠的计算结果。

这种方式下接口的返回值并不是真实的,因此不能应用在某些核心主链路中。举个例子,比如下单页面就是核心主链路,是最终确定订单价格的关键步骤。假如我们对订单优惠计算采用了默认值的方式,那么就会实际造成用户损失。因此,这里面的优惠计算决不能返回默认值,一定要得出真实结果,如果无法获取那么宁可返回异常中断下单操作。

同学们可能会问,那为什么商品详情页可以用默认值降级,而下单页面不能呢?这就要讲到主链路的规划,简单来说,电商平台的用户购物行为是一个漏斗模型,上宽下窄,用户流量在漏斗口最多,在尾部最少,越接近尾部的流量被转化为购物行为的比例就越高,因此越到后面对降级的容忍度就越低。商品搜索和商品详情页处于漏斗的上部,主要是导流端,在没有发生金钱往来的情况下我们可以容忍一定程度的降级误差。但对于下单页,这是整个漏斗模型的尾部,直接发生交易的环节,绝不能容忍任何金钱上的误差。老师在实际工作里设计商品详情页服务的时候,计算优惠访问返回的上限是1000ms,超过这个数字则自动降级为0优惠进行返回。

3.3. 恢复服务才是王道

这才称得上是正经的积极措施,fallback会尝试用各种方法获取正确的返回值,有这么几个常用场景。

- 缓存异常:假如因为缓存故障无法获取数据,在fallback逻辑中可以转而访问底层数据库(这个方法不能用在热点数据上,否则可能把数据库打挂,或者引发更大范围的服务降级和熔断,要谨慎使用)。反过来如果数据库发生故障,也可以在fallback里访问缓存,但要注意数据一致性

- 切换备库:一般大型应用都会采用主从+备库的方式做灾备,假如我们的主从库都发生了故障,往往需要人工将数据源切换到备份数据库,我们在fallback中可以先于人工干预之前自动访问备库数据。这个场景尽量限定在核心主链路接口上,不要动不动就去访问备库,以免造成脏读幻读。

- 重试:Ribbon可以处理超时重试,但对于异常情况来说(比如当前资源被暂时锁定),我们可以在fallback中自己尝试重新发起接口调用

- 人工干预:有些极其重要的接口,对异常不能容忍,这里可以借助fallback启动人工干预流程,比如做日志打点,通过监控组件触发报警,通知人工介入

3.4. 一错再错-多次降级

在某种情况下,fallback里由于各种问题又出现一个异常来。这时我们可以做二次降级,也就是在fallback中再引入一个fallback。当然,你也可以引入三四五六七八更多层的降级,对应一些复杂的大型应用,比如淘系很多核心系统,多级降级是很常见的,根据系统故障的严重程度采取更精细粒度的降级方案。

那假如这一连串降级全部都失败了,难道要牢底坐穿不成?对这种一错再错无药可救的顽固分子,Hystrix也没有办法,只好放你走了,将异常抛到最外层。

3.5. Request Cache

Request Cache并不是让你在fallback里访问缓存,它是Hystrix的一个特殊功能。我们可以通过@CacheResult和@CacheKey两个注解实现,配置如下

@CacheResult

@HystrixCommand

public Friend requestCache(@CacheKey Integer id) {

}

@CacheResult注解的意思是该方法的结果可以被Hystrix缓存起来,@CacheKey指定了这个缓存结果的业务ID是什么。在一个Hystrix上下文范围内,如果使用相同的参数对@CacheResult修饰的方法发起了多次调用,Hystrix只会在首次调用时向服务节点发送请求,后面的几次调用实际上是从Hystrix的本地缓存里读取数据。

Request Cache并不是由调用异常或超时导致的,而是一种主动的可预知的降级手段,严格的说,这更像是一种性能优化而非降级措施。

4. Feign+Hystrix实现fallback降级方案

创建一个新的目录hystrix,在该目录下创建hystrix-fallback项目模块

我们这个新的模块还是一个服务调用者,参考前面的feign-consumer-advanced的引入POM依赖,注意要添加hystrix的依赖包了

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>hystrix-fallbackartifactId>

<name>hystrix-fallbackname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>com.icodingedugroupId>

<artifactId>feign-client-intfartifactId>

<version>${project.version}version>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrixartifactId>

dependency>

dependencies>

project>

我们需要定义一个可以抛出异常的Feign接口调用

先去Feign-client-intf里新建立一个error接口

@GetMapping("/error")

String error();

再去feign-client-advanced里实现这个方法

@Override

public String error() {

throw new RuntimeException("mouse droppings");

}

再回到hystrix-fallback里进行applicaiton代码的编写

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.circuitbreaker.EnableCircuitBreaker;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableDiscoveryClient

@EnableFeignClients

//断路器

@EnableCircuitBreaker

public class HystrixFallbackApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(HystrixFallbackApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

在hystrix-fallback中新建一个service包,在里面创建一个MyService的Interface

package com.icodingedu.springcloud.service;

import org.springframework.cloud.openfeign.FeignClient;

@FeignClient(name = "feign-client")

public interface MyService extends IServiceAdvanced {

}

在hystrix-fallback中新建一个业务包hystrix,在里面创建一个业务类Fallback

package com.icodingedu.springcloud.hystrix;

import com.icodingedu.springcloud.pojo.PortInfo;

import com.icodingedu.springcloud.service.MyService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.stereotype.Component;

//Fallback其实就是我们的容错类

@Slf4j

@Component

public class Fallback implements MyService {

@Override

public String error() {

log.info("********* sorry ********");

return "I am so sorry!";

}

//下面的方法都暂时不管,只针对error方法做实现

@Override

public String sayHello() {

return null;

}

@Override

public PortInfo sayHello(PortInfo portInfo) {

return null;

}

@Override

public String retry(int timeout) {

return null;

}

}

再回到MyService接口里加上降级处理的实现类

package com.icodingedu.springcloud.service;

import com.icodingedu.springcloud.hystrix.Fallback;

import org.springframework.cloud.openfeign.FeignClient;

//这是一个整体容错方案,接口里的所有方法都进行了容错管理都需要在上面的Fallback类里实现容错

@FeignClient(name = "feign-client",fallback = Fallback.class)

public interface MyService extends IServiceAdvanced {

}

创建controller调用实现

package com.icodingedu.springcloud.controller;

import com.icodingedu.springcloud.service.MyService;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@RestController

public class HystrixController {

@Resource

private MyService myService;

@GetMapping("/fallback")

public String fallback(){

return myService.error();

}

}

配置properties文件

spring.application.name=hystrix-consumer

server.port=50001

# 允许bean的注解重载

spring.main.allow-bean-definition-overriding=true

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

# 开启feign下的hystrix功能

feign.hystrix.enabled=true

# 是服务开启服务降级

hystrix.command.default.fallback.enabled=true

测试启动顺序

eureka-server、feign-client-advanced、hystrix-fallback

测试结果是feign-client-advanced出现:java.lang.RuntimeException: mouse droppings 异常

而hystrix-fallback则返回降级后的返回 I am so sorry !

测试结果:调用产生异常后就会返回降级的实现内容

5. Hystrix实现timeout降级

在controller里加入一个timeout的方法,还是用之前的retry方法

@GetMapping("/timeout")

public String timeout(int second){

return myService.retry(second);

}

在Fallback类里将降级方法实现了

@Override

public String retry(int timeout) {

return "Yout are late !";

}

properties里配置超时降级机制

# 配置全局超时

hystrix.command.default.execution.timeout.enabled=true

# 全局超时时间,默认是1000ms

hystrix.command.default.execution.isolation.thread.timeoutInMilliseconds=2000

# 超时以后终止线程

hystrix.command.default.execution.isolation.thread.interruptOnTimeout=true

# 取消的时候终止线程

hystrix.command.default.execution.isolation.thread.interruptOnFutureCancel=true

# 这里把ribbon的超时重试机制也拿进来

# 每台机器最大的重试次数

feign-client.ribbon.MaxAutoRetries=0

# 可以重试的机器数量

feign-client.ribbon.MaxAutoRetriesNextServer=0

# 连接请求超时的时间限制ms

feign-client.ribbon.ConnectTimeout=1000

# 业务处理的超时时间ms

feign-client.ribbon.ReadTimeout=5000

# 默认是false,默认是在get上允许重试

# 这里是在所有HTTP Method进行重试,这里要谨慎开启,因为POST,PUT,DELETE如果涉及重试就会出现幂等问题

feign-client.ribbon.OkToRetryOnAllOperations=false

重启hystrix-fallback进行测试,发现超时没有返回达到配置的2秒就直接降级了

刚刚是对全局进行的超时配置,如果想要对具体方法实现如下

# 将default替换成MyService

# 具体方法的超时时间

hystrix.command.MyService#retry(int).execution.isolation.thread.timeoutInMilliseconds=4000

这块如果不知到这个参数怎么写的可以在main里输出一下:MyService#retry(int)

public static void main(String[] args) throws NoSuchMethodException {

System.out.println(Feign.configKey(MyService.class,

MyService.class.getMethod("retry",int.class)

));

}

也可以通过注解的方式实现具体方法的超时降级,下面会讲到

6. Requet Cache降压实现

Request Cache并不是由调用异常或超时导致的,而是一种主动的可预知的降级手段,严格的说,这更像是一种性能优化而非降级措施

代码直接开撸,在hytrix-fallback里创建一个RequestCacheService

package com.icodingedu.springcloud.service;

import com.icodingedu.springcloud.pojo.PortInfo;

import com.netflix.hystrix.contrib.javanica.cache.annotation.CacheKey;

import com.netflix.hystrix.contrib.javanica.cache.annotation.CacheResult;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

@Service

@Slf4j

public class RequestCacheService {

@Resource

private MyService service;

//这里就是将结果缓存并根据参数值来进行k-v的缓存对应

@CacheResult

@HystrixCommand(commandKey = "cacheKey")

public PortInfo requestCache(@CacheKey String name){

log.info("request cache name "+ name);

PortInfo portInfo = new PortInfo();

portInfo.setName(name);

portInfo.setPort("2020");

portInfo = service.sayHello(portInfo);

log.info("after request cache name "+name);

return portInfo;

}

}

超时降级的方法key另一种配置方式

注意这里的@HystrixCommand(commandKey = "cacheKey")

这个cacheKey就可以用在上面的具体方法超时时间上,但还要配套fallbackMethod的方法

hystrix.command.cacheKey.execution.isolation.thread.timeoutInMilliseconds=2000

编写controller的实现

@Autowired

private RequestCacheService requestCacheService;

@GetMapping("/cache")

public PortInfo requestCache(String name){

//缓存存放在hystrix的上下文中,需要初始化上下文,上下文打开后执行完还要关闭context.close();

//使用try-catch-finally里去context.close();掉

//或者使用lombok的@Cleanup注解,默认调用close方法,如果默认不是close方法而是其他方法关闭

//可以这样来设置@Cleanup("shutup")

@Cleanup HystrixRequestContext context = HystrixRequestContext.initializeContext();

//我们在这里调用两次看看执行过程

PortInfo portInfo = requestCacheService.requestCache(name);

portInfo = requestCacheService.requestCache(name);

return portInfo;

}

properties里可以配置也可以不配置

# 默认requestCache是打开状态

hystrix.command.default.requestCache.enabled=true

重启后进行测试发现,feign-client-advanced的控制台只被调用了一次,这样就可以将远程调用需要K-V缓存的内容放到一个hystrix上下文中进行调用,只要调用参数值一样,无论调用多少次返回值都是从缓存中取这样就能提升一定的性能不用每次都进行远程调用了

7. 多级降级实现

去到Fallback类里再创建两个降级的实现方法

@Override

//降级方法的参数要保持一致

@HystrixCommand(fallbackMethod = "fallback2")

public String error() {

log.info("********* sorry ********");

throw new RuntimeException("first fallback");

}

@HystrixCommand(fallbackMethod = "fallback3")

public String fallback2(){

log.info("********* sorry again ********");

throw new RuntimeException("first fallback again");

}

public String fallback3(){

log.info("********* sorry again 2 ********");

return "success sorry again 2!";

}

通过注解配置实现timeout超时降级

去到controller里添加一个方法

@GetMapping("/timeout2")

@HystrixCommand(

fallbackMethod = "timeoutfallback",

//可以忽略不进行降级的异常

ignoreExceptions = {IllegalArgumentException.class},

//这个commandProperties是一个数组,所以可以配置多个HystrixProperty

commandProperties = {

@HystrixProperty(name = "execution.isolation.thread.timeoutInMilliseconds",value = "6000")

}

)

public String timeout2(int second){

return myService.retry(second);

}

//这个是降级的实现方法

public String timeoutfallback(int second){

return "timeout success "+second;

}

这里需要注意的是在注解上添加的超时和配置文件里配置的全局超时设置之间的时间关系

8. Hystrix超时配置和Ribbon超时重试共用的问题

Feign集成了Ribbon和Hystrix两个组件,它俩都各自有一套超时配置,那到底哪个超时配置是最终生效的那个呢

我们先来复习一下Ribbon的超时时间计算公式:

最大超时时间=(连接超时时间+接口超时时间)*(当前节点重试次数+1)*(换节点重试次数+1)

假如经过上述计算,Ribbon的超时时间是2000ms,那么Hystrix的超时时间应该设置成多少才合理呢?我们先来看看Hystrix的默认全局配置

hystrix.command.default.execution.isolation.thread.timeoutInMilliseconds=1000

以上全局配置设置了Hystrix的熔断时间为1000ms。这里Hystrix的超时时间设置比Ribbon配置的时间短,那么不等Ribbon重试结束,Hystrix判定超时后就会直接执行熔断逻辑。因此,Hystrix和Ribbon是一个共同作用的关系,谁先到达超时指标就会率先起作用。

通常来讲,Hystrix的熔断时间要比Ribbon的最长超时时间设置的略长一些,这样就可以让Ribbon的重试机制充分发挥作用,以免出现还没来得及重试就进入fallback逻辑的情况发生。

那如果我们有一些接口对响应时间的要求特别高,比如说商品详情页接口,元数据必须在2s以内加载返回,那我们怎么针对方法设置更细粒度的Hystrix超时限制?

-

这个时候我们就需要以方法为维度来设置服务降级时间而不是直接应用全局配置了

-

方法级别的降级时间优先级是高于全局应用级别的,即便是方法超时时长>全局超时时长,也是走方法级别的超时时间

# 具体方法的超时时间 hystrix.command.MyService#retry(int).execution.isolation.thread.timeoutInMilliseconds=6000 # 超时时间 hystrix.command.default.execution.isolation.thread.timeoutInMilliseconds=3000 -

方法上实现超时时间配置有三种方法

- 通过方法签名配置:MyService#retry(int)

- 通过commandKey配置

- 通过注解配置@HystrixProperty

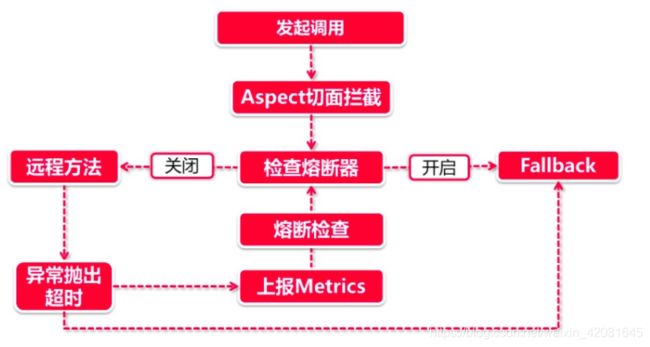

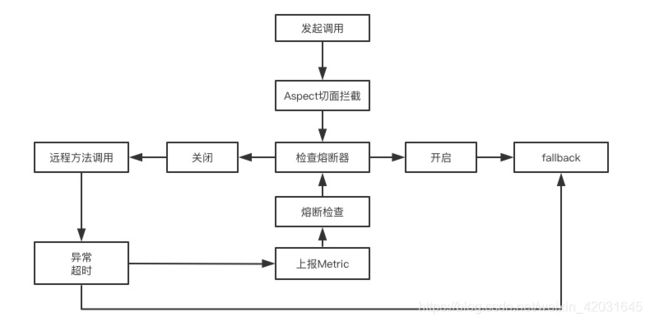

9. 熔断器核心机制理解分析

服务熔断是建立在降级之上的强力手段,是进击的降级,对于调用后进入降级处理的业务反复fallback就需要启用熔断机制了,不再进行远程调用,待什么时候服务恢复了再恢复远程调用访问

以上流程中省略了服务降级部分的业务,我们只关注熔断部分。

- 发起调用-切面拦截:由于熔断器是建立在服务降级的基础上,因此在前面的触发机制上和服务降级流程一模一样。在向@HystrixCommand注解修饰的方法发起调用时,将会触发由Aspect切面逻辑

- 检查熔断器:当熔断状态开启的时候,直接执行进入fallback,不执行远程调用

- 发起远程调用-异常情况:还记得前面服务降级小节里讲到的,服务降级是由一系列的回调函数构成的,当远程方法调用抛出异常或超时的时候,这个异常情况将被对应的回调函数捕捉到

- 计算Metrics:这里的Metrics指的是衡量指标,在异常情况发生后,将会根据断路器的配置计算当前服务健康程度,如果达到熔断标准,则开启断路开关,后续的请求将直接进入fallback流程里

熔断器有三个状态阶段:

- 熔断器open状态:远程服务关闭状态,服务在一定时间内不得发起外部调用,访问服务调用者直接进入fallback里处理

- 熔断器half-open状态:在fallback里待的也够久了,给一个改过自新的机会,可以尝试发起真实的服务调用,但这一切都在监视下进行,一旦远程调用不成功无论是否达到熔断的阈值则直接熔断,等待下次尝试调用的机会

- 熔断器closed:上一步尝试进行远程调用成功了,那便关闭熔断,开始正常远程访问

熔断器的判断阀值:

主要从两个维度判断熔断器是否开启:

- 在一定时间窗口内,发生异常的请求数量达到临界值

- 在一定时间窗口内,发生异常的请求数量占请求总数量达到一定比例

其中时间窗口的大小也是可以配置的,而且我们还可以指定half-open判定的时间间隔,比如说熔断开启10秒以后进入half-open状态,此时就会让一个请求发起调用,如果成功就关闭熔断器。

10. Feign集成Hystrix熔断器

这一节比较轻松,只需要通过配置来进行熔断设置即可

# 熔断的前提条件(请求的数量),在一定的时间窗口内,请求达到5个以后,才开始进行熔断判断

hystrix.command.default.circuitBreaker.requestVolumeThreshold=5

# 失败请求数达到50%则熔断开关开启

hystrix.command.default.circuitBreaker.errorThresholdPercentage=50

# 当熔断开启后经过多少秒再进入半开状态,放出一个请求进行远程调用验证,通过则关闭熔断不通过则继续熔断

hystrix.command.default.circuitBreaker.sleepWindowInMilliseconds=15000

# 配置时间窗口

hystrix.command.default.metrics.rollingStats.timeInMilliseconds=20000

# 开启或关闭熔断的功能

hystrix.command.default.circuitBreaker.enabled=true

# 强制开启熔断开关

hystrix.command.default.circuitBreaker.forceOpen=false

# 强制关闭熔断开关

hystrix.command.default.circuitBreaker.forceClosed=false

要把retry的全局延时降级时间调整成2秒进行测试

1秒正常,2秒降级进行测试,验证阈值的百分比触发条件

作业:

上面配置的是基于全局的熔断器,如何配置基于某个方法的熔断机制

可以参考超时降级的配置方法,将配置文件中default换成具体key,通过注解实现的方式

11. 主链路降级熔断规划

- 首先是识别主链路

- 根据主链路分析主线流程和业务底线以及故障恢复

12. 线程隔离机制

-

线程池拒绝

这一步是线程隔离机制直接负责的,假如当前商品服务分配了10个线程,那么当线程池已经饱和的时候就可以拒绝服务,调用请求会收到Thread Pool Rejects,然后将被转到对应的fallback逻辑中。其实控制线程池中线程数量是由多个参数共同作用的,我们分别看一下

- coreSize:核心线程数(默认为10)

- maximumSize:设置最大允许的线程数(默认也是10),这个属性需要打开allowMaximumSizeToDivergeFromCoreSize之后才能生效,后面这个属性允许线程池中的线程数扩展到maxinumSize个

- queueSizeRejectionThreshold:这个属性经常会被忽略,这是控制队列最大阈值的,Hystrix默认设置了5。即便把maximumSize改大,但因为线程队列阈值的约束,你的程序依然无法承载很多并发量。所以当你想改大线程池的时候,需要这两个属性一同增大

- keepAliveTimeMinutes:这个属性和线程回收有关,我们知道线程池可以最大可以扩展到maximumSize,当线程池空闲的时候,多余的线程将会被回收,这个属性就指定了线程被回收前存活的时间。默认2分钟,如果设置的过小,可能会导致系统频繁回收/新建线程,造成资源浪费

-

线程Timeout:我们通常情况下认为延迟只会发生在网络请求上,其实不然,在Netflix设计Hystrix的时候,就有一个设计理念:调用失败和延迟也可能发生在远程调用之前(比如说一次超长的Full GC导致的超时,或者方法只是一个本地业务计算,并不会调用外部方法),这个设计理念也可以在Hystrix的Github文档里也有提到。因此在方法调用过程中,如果同样发生了超时,则会产生Thread Timeout,调用请求被流转到fallback

-

服务异常/超时:这就是我们前面学习的的服务降级,在调用远程方法后发生异常或者连接超时等情况,直接进入fallback

**代码实现:**在service包下创建一个业务类来做测试

package com.icodingedu.springcloud.service;

import com.icodingedu.springcloud.pojo.PortInfo;

import com.netflix.hystrix.*;

import lombok.extern.slf4j.Slf4j;

@Slf4j

public class GetPortInfoCommand extends HystrixCommand<PortInfo> {

private String name;

public GetPortInfoCommand(String name) {

super(Setter.withGroupKey(HystrixCommandGroupKey.Factory.asKey("GetPortInfoCommandPool"))

.andCommandKey(HystrixCommandKey.Factory.asKey("GetPortInfoCommandKey"))

.andThreadPoolKey(HystrixThreadPoolKey.Factory.asKey(name))

.andCommandPropertiesDefaults(

HystrixCommandProperties.Setter()

.withExecutionIsolationStrategy(HystrixCommandProperties.ExecutionIsolationStrategy.THREAD)

.withExecutionTimeoutInMilliseconds(25000)

//.withExecutionIsolationSemaphoreMaxConcurrentRequests(3)

)

.andThreadPoolPropertiesDefaults(

HystrixThreadPoolProperties.Setter()

.withCoreSize(3)

.withQueueSizeRejectionThreshold(1)

)

);

this.name = name;

}

@Override

protected PortInfo run() throws Exception {

log.info("********进入线程池******");

Thread.sleep(20000);

PortInfo portInfo = new PortInfo();

portInfo.setName(name);

portInfo.setPort("99999");

log.info("********执行完毕******");

return portInfo;

}

}

controller层进行验证,创建一个方法

@GetMapping("/command")

public String portInfoCommand(){

com.netflix.hystrix.HystrixCommand<PortInfo> hystrixCommand = new GetPortInfoCommand("gavin.huang");

PortInfo portInfo = hystrixCommand.execute();

return "success "+portInfo.getName()+" --- "+portInfo.getPort();

}

线程隔离原理

- 线程池技术:它使用Hystrix自己内建的线程池去执行方法调用,而不是使用Tomcat的容器线程

- 信号量技术:它直接使用Tomcat的容器线程去执行方法,不会另外创建新的线程,信号量只充当开关和计数器的作用。获取到信号量的线程就可以执行方法,没获取到的就转到fallback

从性能角度看

- 线程池技术:涉及到线程的创建、销毁和任务调度,而且CPU在执行多线程任务的时候会在不同线程之间做切换,我们知道在操作系统层面CPU的线程切换是一个相对耗时的操作,因此从资源利用率和效率的角度来看,线程池技术会比信号量慢

- 信号量技术:由于直接使用Tomcat容器线程去访问方法,信号量只是充当一个计数器的作用,没有额外的系统资源消费,所以在性能方面具有明显的优势

信号量实现只需要修改service 的两个地方

//在service的构造方法里将THREAD改成SEMAPHORE

//增加信号量控制.withExecutionIsolationSemaphoreMaxConcurrentRequests(3)

//下面线程池的内容注释掉即可

public GetPortInfoCommand(String name) {

super(Setter.withGroupKey(HystrixCommandGroupKey.Factory.asKey("GetPortInfoCommandPool"))

.andCommandKey(HystrixCommandKey.Factory.asKey("GetPortInfoCommandKey"))

.andThreadPoolKey(HystrixThreadPoolKey.Factory.asKey(name))

.andCommandPropertiesDefaults(

HystrixCommandProperties.Setter()

.withExecutionIsolationStrategy(HystrixCommandProperties.ExecutionIsolationStrategy.SEMAPHORE)

.withExecutionTimeoutInMilliseconds(25000)

.withExecutionIsolationSemaphoreMaxConcurrentRequests(3)

)

// .andThreadPoolPropertiesDefaults(

// HystrixThreadPoolProperties.Setter()

// .withCoreSize(3)

// .withQueueSizeRejectionThreshold(1)

// )

);

this.name = name;

}

13. Turbine聚合信息服务

Turbine需要连接了服务注册中心获取服务提供者列表以便进行相应信息聚合

在hystrix目录下创建一个hystrix-turbine的module

导入POM依赖,和hystrix-fallback基本一样,只需要把feign-client-intf依赖去掉并加入turbine的依赖即可

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>hystrix-turbineartifactId>

<name>hystrix-turbinename>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrixartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-turbineartifactId>

dependency>

dependencies>

project>

编写application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.EnableAutoConfiguration;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.netflix.hystrix.EnableHystrix;

import org.springframework.cloud.netflix.turbine.EnableTurbine;

@EnableDiscoveryClient

@EnableHystrix

@EnableTurbine

@EnableAutoConfiguration

public class HystrixTurbineApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(HystrixTurbineApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

配置propertie的配置文件

spring.application.name=hystrix-turbine

server.port=50002

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

# 指定需要监控的服务名

turbine.app-config=hystrix-consumer

turbine.cluster-name-expression="default"

# 将端口和hostname作为区分不同服务的条件,默认只用hostname,默认方式在本地一个IP下就区分不开了

turbine.combine-host-port=true

# turbine通过这个路径获取监控数据,所以监控的服务也要开放这个路径监控

turbine.instanceUrlSuffix.default=actuator/hystrix.stream

turbine.aggregtor.clusterConfig=default

去到hystrix-fallback项目中打开actuator的配置

# actuator暴露接口

management.security.enabled=false

management.endpoints.web.exposure.include=*

management.endpoint.health.show-details=always

去到浏览打开项目hystrix-fallback的actuator路径进行查看

http://localhost:50001/actuator 可以看到所有监控的信息

http://localhost:50001/actuator/hystrix.stream 可以看到一个长连接的ping在不断返回结果

现在启动hystrix-turbine项目

http://localhost:50002/turbine.stream 访问这个路径

从这个页面发现turbine自己并不生产数据,只是将数据进行收集

14. Turbine集成Dashboard

创建一个hystrix-dashboard的module

导入POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>hystrix-dashboardartifactId>

<name>hystrix-dashboardname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrixartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrix-dashboardartifactId>

dependency>

dependencies>

project>

创建application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.netflix.hystrix.dashboard.EnableHystrixDashboard;

@EnableHystrixDashboard

@SpringBootApplication

public class HystrixDashboardApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(HystrixDashboardApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

创建properties配置文件

spring.application.name=hystrix-dashboard

server.port=50003

# hystrix监控路径:这个是一台服务的监控检查

# http://localhost:50001/actuator/hystrix.stream

# turbine监控路径:这是整合多台服务的监控检查

# http://localhost:50002/turbine.stream

分别启动eureka-server、feign-client-advanced、hystrix-fallback、hystrix-turbine、hystrix-dashboard

按照顺序启动完毕后登录:http://localhost:50003/hystrix

SpringCloud服务熔断详解(四)

1. 熔断器核心机制理解分析

频繁出错的应用,应该快速失败,不要占用系统,快速失败后不再进行远程调用了,直接进行本地访问,待远程恢复后再进行访问

以上流程中省略了服务降级部分的业务,我们只关注熔断部分。

- 发起调用-切面拦截:由于熔断器是建立在服务降级的基础上,因此在前面的触发机制上和服务降级流程一模一样。在向@HystrixCommand注解修饰的方法发起调用时,将会触发由Aspect切面逻辑

- 检查熔断器:当熔断状态开启的时候,直接执行进入fallback,不执行远程调用

- 发起远程调用-异常情况:还记得前面服务降级小节里讲到的,服务降级是由一系列的回调函数构成的,当远程方法调用抛出异常或超时的时候,这个异常情况将被对应的回调函数捕捉到

- 计算Metrics:这里的Metrics指的是衡量指标,在异常情况发生后,将会根据断路器的配置计算当前服务健康程度,如果达到熔断标准,则开启断路开关,后续的请求将直接进入fallback流程里

熔断器有三个状态阶段:

- 熔断器open状态:远程服务关闭状态,服务在一定时间内不得发起外部调用,访问服务调用者直接进入fallback里处理

- 熔断器half-open状态:在fallback里待的也够久了,给一个改过自新的机会,可以尝试发起真实的服务调用,但这一切都在监视下进行,一旦远程调用不成功无论是否达到熔断的阈值则直接熔断,等待下次尝试调用的机会

- 熔断器closed:上一步尝试进行远程调用成功了,那便关闭熔断,开始正常远程访问

熔断器的判断阀值:

主要从两个维度判断熔断器是否开启:

- 在一定时间窗口内,发生异常的请求数量达到临界值

- 在一定时间窗口内,发生异常的请求数量占请求总数量达到一定比例

其中时间窗口的大小也是可以配置的,而且我们还可以指定half-open判定的时间间隔,比如说熔断开启10秒以后进入half-open状态,此时就会让一个请求发起调用,如果成功就关闭熔断器。

2. Feign集成Hystrix熔断器

纯粹的properties配置,在hystrix-fallback里配置

# 熔断的前提条件(请求数量),在一定时间窗口内,请求达到5个以后,才开始熔断判读

hystrix.command.default.circuitBreaker.requestVolumeThreshold=5

# 失败请求数达到50%熔断开关开启

hystrix.command.default.circuitBreaker.errorThresholdPercentage=50

# 当熔断开启后经过多少秒进入半开判断,单位ms

hystrix.command.default.circuitBreaker.sleepWindowInMilliseconds=15000

# 发生异常的时间窗口,单位ms

hystrix.command.default.metrics.rollingStats.timeInMilliseconds=20000

# 开启熔断功能

hystrix.command.default.circuitBreaker.enabled=true

# 关闭强制开启和强制关闭熔断器开关

hystrix.command.default.circuitBreaker.forceOpen=false

hystrix.command.default.circuitBreaker.forceClosed=false

3. Turbine聚合信息服务集成Dashboard

3.1. 创建Turbine服务

Turbine需要连接了服务注册中心获取服务提供者列表以便进行相应信息聚合

在hystrix目录下创建一个hystrix-turbine的module

导入POM依赖,和hystrix-fallback基本一样,只需要把feign-client-intf依赖去掉并加入turbine的依赖即可

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>hystrix-turbineartifactId>

<name>hystrix-turbinename>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-eureka-clientartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-actuatorartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrixartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-turbineartifactId>

dependency>

dependencies>

project>

编写application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.EnableAutoConfiguration;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.client.discovery.EnableDiscoveryClient;

import org.springframework.cloud.netflix.hystrix.EnableHystrix;

import org.springframework.cloud.netflix.turbine.EnableTurbine;

@EnableDiscoveryClient

@EnableHystrix

@EnableTurbine

@EnableAutoConfiguration

public class HystrixTurbineApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(HystrixTurbineApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

配置propertie的配置文件

spring.application.name=hystrix-turbine

server.port=50002

eureka.client.serviceUrl.defaultZone=http://localhost:20001/eureka/

# 指定需要监控的服务名

turbine.app-config=hystrix-consumer

turbine.cluster-name-expression="default"

# 将端口和hostname作为区分不同服务的条件,默认只用hostname,默认方式在本地一个IP下就区分不开了

turbine.combine-host-port=true

# turbine通过这个路径获取监控数据,所以监控的服务也要开放这个路径监控

turbine.instanceUrlSuffix.default=actuator/hystrix.stream

turbine.aggregtor.clusterConfig=default

去到hystrix-fallback项目中打开actuator的配置

# actuator暴露接口

management.security.enabled=false

management.endpoints.web.exposure.include=*

management.endpoint.health.show-details=always

去到浏览打开项目hystrix-fallback的actuator路径进行查看

http://localhost:50001/actuator 可以看到所有监控的信息

http://localhost:50001/actuator/hystrix.stream 可以看到一个长连接的ping在不断返回结果

现在启动hystrix-turbine项目

http://localhost:50002/turbine.stream 访问这个路径

从这个页面发现turbine自己并不生产数据,只是将数据进行收集

3.2. Turbine集成Hystrix-dashboard

创建一个hystrix-dashboard的module

导入POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>hystrix-dashboardartifactId>

<name>hystrix-dashboardname>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrixartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-netflix-hystrix-dashboardartifactId>

dependency>

dependencies>

project>

创建application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.netflix.hystrix.dashboard.EnableHystrixDashboard;

@EnableHystrixDashboard

@SpringBootApplication

public class HystrixDashboardApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(HystrixDashboardApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

创建properties配置文件

spring.application.name=hystrix-dashboard

server.port=50003

# hystrix监控路径:这个是一台服务的监控检查

# http://localhost:50001/actuator/hystrix.stream

# turbine监控路径:这是整合多台服务的监控检查

# http://localhost:50002/turbine.stream

分别启动eureka-server、feign-client-advanced、hystrix-fallback、hystrix-turbine、hystrix-dashboard

按照顺序启动完毕后登录:http://localhost:50003/hystrix

SpringCloud配置中心服务

1. 配置中心在微服务中的应用

1.1. 系统中常用的文件配置都是如何设置的

-

程序中硬编码

- 在代码中写死一个文件的配置项

- 如果使用绝对路径,更换了开发电脑会出现地址无法使用的问题

- 如果代码在windows上开发,部署到linux上就要在上线前修改配置文件路径

-

配置文件

- 一般将不经常修改的内容放到配置文件中

- 比如将端口号配置到yaml或properties文件中

-

环境变量

- 比如JDK的环境变量就是操作系统层面的配置

- 线上启动tomcat时会加入一下启动参数来启动服务

-

数据库/缓存存储

- 将属性配置到数据库或缓存中

- 在数据库或缓存中进行灵活设置

1.2. 这些配置有什么缺点和不足

-

格式不统一

- yaml

- json

- properties

- 使用哪种根据个人选择即可

-

没有版本控制

- 如果在yaml或properties中还能依赖git/svn进行版本控制

- 如果是配置在数据库中则脱离了版本控制的束缚,修改则完全没有轨迹

-

基于静态配置

- 如果是hardcode方式或配置文件方式则需要先修改再发布完成修改实现

-

分布零散

- 从架构的层面考虑,各个微服务团队放飞自我百花齐放,方式不同格式不同,出现问题也不同

- 没有统一的管理,比如几个项目都要连接数据库,如果数据库产生一些连接改变,就要修改所有项目的驱动串,通知所有的项目方进行修改

1.3. 在进行配置统一管理前先对配置项进行一下分类

1.3.1. 配置项的静态内容

- 环境配置

- 数据库连接

- Eureka的注册中心

- MQ的连接串

- 搜索引擎连接串

- 应用命,端口

- 安全配置

- 连接的密码

- 公钥私钥

- 对这些配置还要进行加解密

1.3.2. 配置项的动态内容

- 功能控制

- 在代码里配置开关,传统的灰度发布方法,很灰度发布对应的就是灰度测试(金丝雀测试)

- 人工熔断开关

- 蓝绿发布

- 数据源切换

- 业务规则

- 当日汇率

- 动态文案

- 规则引擎参数:当前折扣系数,国际物流费用(drools规则引擎)

- 应用参数

- 网关层要访问的黑白名单

- 缓存过期时间配置

1.4. 配置项的功能定义

- 高可用

- 版本管理

- 访问权限控制

- 动态推送变更

- 内容加密

- 配置分离的中心化管理思想

1.5. Config Server核心功能

- 统一配置:提供了一个中心化配置方案,将各个项目中的配置内容集中在Config Server端进行管理

- 环境隔离:Config Server提供了多种环境隔离机制,可以根据需要进行配置加载

- 动态刷新:支持运行期改变配置进行业务动态配置,以及功能的动态开关

- 配置加密解密,定向推送等功能

2. 直连式配置中心实施

2.1. 配置文件设置

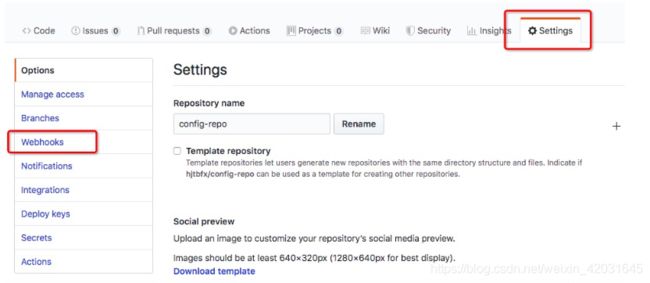

直连配置中心的工作模式非常简单,Config Server直接从配置库(GitHub)中拉取配置同步到各个Server中来进行直连式配置

首先在GitHub上创建repo然后创建两个配置文件

命名规则:

应用名-环境名.yaml / 应用名-环境名.properties

我们创建开发环境的文件名为:config-consumer-dev.yaml

info:

profile: dev

name: config-dev

words: this is a development environment

创建生产环境的文件名:config-consumer-prod.yaml

info:

profile: prod

name: config-prod

words: this is a production environment

2.2. 搭建config-server

创建一个config目录,在目录中创建一个config-sever的module

指定POM导入config-server

config-server和eureka-server很像就是一个中心化配置服务所以加入的依赖就一个

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>config-serverartifactId>

<name>config-servername>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-config-serverartifactId>

dependency>

dependencies>

project>

创建application启动类

package com.icodingedu.springcloud;

import org.springframework.boot.WebApplicationType;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.builder.SpringApplicationBuilder;

import org.springframework.cloud.config.server.EnableConfigServer;

@SpringBootApplication

@EnableConfigServer

public class ConfigServerApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(ConfigServerApplication.class)

.web(WebApplicationType.SERVLET)

.run(args);

}

}

这次我们设置yaml配置文件

spring:

application:

name: config-server

cloud:

config:

server:

git:

uri: https://github.com/hjtbfx/config-repo.git

force-pull: true # 强制拉取资源文件

# search-paths: dev,prod* 支持csv格式配置多个路径同时获取,还支持*作为通配符

# username:

# password:

server:

port: 60001

启动config-server使用PostMan拉取配置文件

# GET

# config-consumer/dev 就是我们的命名规范application-profile

http://localhost:60001/config-consumer/dev

返回数据内容

{

"name": "config-consumer",

"profiles": [

"dev"

],

"label": null,

"version": "598ccaf69010b4ebbf13558fc3cb21f0212ceb3a",

"state": null,

"propertySources": [

{

"name": "https://github.com/hjtbfx/config-repo.git/config-consumer-dev.yaml",

"source": {

"info.profile": "dev",

"name": "config-dev",

"words": "this is a development environment"

}

}

]

}

并且在config-server的控制台还会输出一个本地资源的路径

2020-04-06 23:56:56.262 INFO 4610 --- [io-60001-exec-2] o.s.c.c.s.e.NativeEnvironmentRepository : Adding property source: file:/var/folders/bs/t5hqbzl52r18nfyx3v0dc0k80000gn/T/config-repo-6888460700345550079/config-consumer-dev.yaml

如果要获取repo仓库中不同路径下的文件,可以这样访问

http://localhost:60001/config-consumer/dev/master

如果只想获得文件内容

# 其实这也是一个通配符方式,返回yaml格式数据

http://localhost:60001/config-consumer-dev.yaml

# 同理可得,返回properties格式数据

http://localhost:60001/config-consumer-dev.properties

# 返回json格式数据

http://localhost:60001/config-consumer-dev.json

# 这里就说明config并不要求你在github要把所有格式保存了,他会按照你的要求进行统一

如果我们的文件不在repo的根目录下,可以在前面加上路径

http://localhost:60001/master/config-consumer-dev.yaml

通配的格式如下

http://localhost:60001/{application}/{profile}/{label}

http://localhost:60001/{application}-{profile}.json(.yaml .properties)

2.3. Client直连配置中心

在config目录下创建config-client的module

引入POM依赖

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>spring-cloud-projectartifactId>

<groupId>com.icodingedugroupId>

<version>1.0-SNAPSHOTversion>

<relativePath>../../pom.xmlrelativePath>

parent>

<modelVersion>4.0.0modelVersion>

<packaging>jarpackaging>

<artifactId>config-clientartifactId>

<name>config-clientname>

<dependencies>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-webartifactId>

dependency>

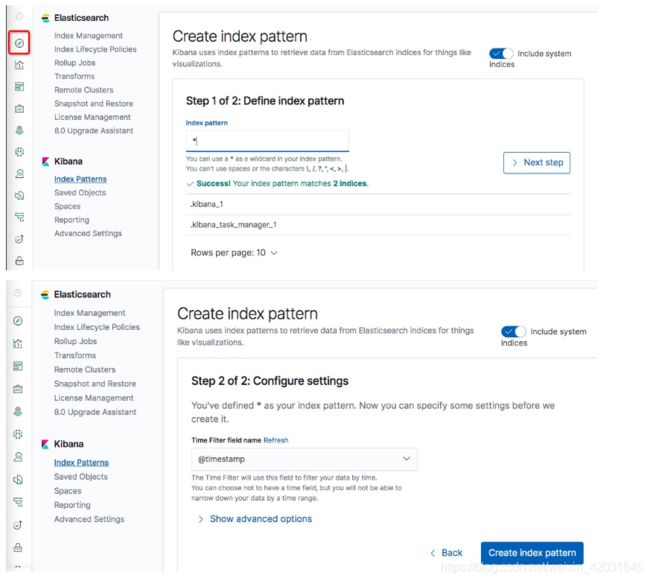

<dependency>