[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略

论文原文标题

AlphaStock:A Buying-Winners-and-Selling-Losers Investment Strategy using Interpretable Deep Reinforcement Attention Networks

发表日期:2019年8月

1 主要贡献

主要贡献:

1、将深度注意力网络和夏普率导向的强化学习框架结合,去实现风险回报均衡的投资策略。

2、提出利用资产之间的相互关系进行建模,去避免选择偏差和创建一种跨资产的注意力机制。

2 前情概要

2.1 金融术语

- 持有期(holding period):投资资产的最小时间单位。

- 序列投资(sequential investment):序列投资是一系列的持有期。

- 资产价格(asset price): p(i)={ p1(i), p2(i),… pi(i),…},其中, p1(i)是股票i在时刻t的价格,文中,使用股票作为资产来描述模型。

- 多仓(long position):多仓是先在 t 1 t_1 t1 时刻买入股票后面 t 2 t_2 t2 时刻卖掉平仓的操作,利润: u i u_i ui( pt2(i) - pt1(i)),其中 u i u_i ui是购买股票i 的量。

- 空仓(short position):空仓是先在 t 1 t_1 t1 时刻借入股票卖掉后面 t 2 t_2 t2 时刻买入还回股票的操作,利润: u i u_i ui( pt1(i) - pt2(i)),其中 u i u_i ui是卖出股票i 的量。

- 投资组合(portfolio):如果有I只股票,一个投资组合为一个向量b=(b(1),…b(i),…b(I)),这里b(i)是股票i的资金占比, ∑ i = 1 I \sum_{i=1}^I ∑i=1Ib(i) =1

- 零-投资组合:资产组合b(j)的资金记为M(j),多仓的M(j)>0,而空仓M(j)<0,对于有J个资产组合的投资组合来说,如果 ∑ j = 1 J \sum_{j=1}^J ∑j=1JM(j) =0。

例如:投资者借一种组合具有1000元价值的股票卖掉作为空仓,然后使用这个收益去购买另一组1000元的股票作为多仓,空仓和多仓的结合就是一种零-投资组合。

2.2 BWSL策略

策略的关键是买入预测价格会有高涨幅股票(winners)和卖出预测价格涨幅较低的股票(losers)。文中将BWSL策略作为一个零投资组合,由两个投资组合来执行:一个买入winners的多仓投资组合和一个卖出losers的空仓投资组合。

bt+:在第T个时期,多仓投资组合

bt-:在第T个T时期,空仓投资组合

具体执行流程:

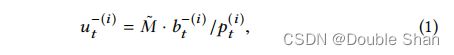

(1)首先,在时间t,给出 M ~ \widetilde{M} M 预算限制,向代理商借“loser”股票,可以借到的股票i的数量为

其中,bt-(i)是股票i在空仓组合bt-的比例。

(2)其次,买掉借的“loser”股票,从而得到 M ~ \widetilde{M} M 。通过bt+,使用 M ~ \widetilde{M} M 去买入“winner”的股票,可以在时间t,买入的股票i的数量为

使用买winner股票的预算 M ~ \widetilde{M} M 是卖空交易的收益,所以在投资组合{bt+,bt-}的净资产是0。

(3)在第t个持有期结束的时候,我们卖出多仓组合,使用在t+1时刻的新价格,我们卖出股票可以得到的收益是

(4)然后,我们在做空投资组合中的股票买回来,然后还给代理商,花费的钱为

(5)总的收益

总收益为Mt=Mt+-Mt-,让Zt(i)=pt+1(i) / pt(i) 代表 第t个持有期内股票i的价格增长率。

集成投资组合的回报率计算为

(5)目标

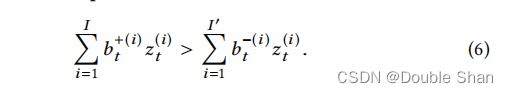

如果我们想要Rt >0 ,那么需要

意味着投资组合b+要比b-拥有更好的平均价格上升速率。即使市场全部的股票价格在回落,只要确保投资组合b+要比b-价格回落慢一些,我们就可以获利。这体现了股票之间的相对价格的重要性。

2.3 优化目标

夏普比率(sharpe ratio):夏普比率是每单位波动率,超过无风险回报的平均回报率,表示投资者每承受一单位总风险,会产生多少额外的收益,给定一个包含T个持有期的连续投资,以使投资的夏普比最大化,其夏普比计算为

AT是投资每个时期的平均回报速率,VT是用来衡量投资风险的波动性,Θ是一种无风险的回报率,如银行的回报率。

给定一个有T个持有期的连续投资,AT为

其中TCt是第t个时期的交易成本,VT为

对于t期投资,我们的策略的优化目标是生成多仓和空仓的投资组合序列B+={b1+,…,bT+}和B-={b1-,…,bT-}来最大化投资的夏普比率。

夏普比率从利润和风险的角度来评估战略的表现。这种利润-风险平衡特征要求我们的模型不仅关注每个时期的回报率最大化Rt,而且还考虑了Rt在投资中所有时期的长期波动性。换句话说,设计一个有远见的稳定投资策略比一个具有短期高利润的短见投资策略更有价值。

3 Alphastock 模型

3.1 组成部分

Alphastock 包含了三个部分

- LSTM-HA:对于每个股票i,利用LSTM-HA模型从历史状态中X(i),提取股票特征r(i) 。

- CAAN:描述股票的相对关系,输入所有股票特征r(i),评估每个股票的winner的分数。

- portfolio generator:通过全部股票的分数计算出做多和做空的投资比例b+,b-。

最后,利用强化学习来端到端优化这三个组件作为一个整体,其中一个顺序投资的夏普比率通过一种有远见的方式最大化。

3.2 原始特征

技术面因子

- 价格增长速率(PR)

- 细粒度波动率(VOL):一个持有期可以进一步划分为许多子期。在我们的实验中,我们将一个月设置为一个持有期,因此一个子期可以是一个交易日。VOL定义为从t−1到t的所有子周期价格的标准差。

- 交易量(TV):从t−1到t的股票交易总量。它反映了一只股票的市场活动。

基本面因子

- 市场资本总值(MC):对于股票i,它被定义为价格Pt(i)和已发行流通股的乘积。

- 价格与获利比率 (PE):一个公司的市值与其年收益的比率。

- 账面与市场的比率(BM):一个公司的账面价值与其市场价值的比率。

3.3 股票特征提取

在LSTM-HA网络中,使用 x ~ \widetilde{x} x t去代表在时间t的股票历史状态。其中包括给出的股票特征。我们在t时刻命名最后的K个历史持有期,等同于,从时间t−K到时间t的周期,作为t的回顾窗口。在回顾窗口中,一个股票的历史状态被表示为一个序列X={x1,…,xk,…,xK},模型使用长短期记忆网络把X编码成向量为

其中hk是LSTM在第k步编码的隐藏状态,将最后一步的hK作为股票的表示,它包含X中元素之间的顺序依赖关系。

为了让X之间的全局依赖关系和长期依赖关系能有效被建模,因此,采用历史状态关注来利用所有中间隐藏状态hk来增强hK,根据标准的注意力机制,对历史状态的关注增强了代表性,表示而r

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第2张图片](http://img.e-com-net.com/image/info8/67f821f829974795b7c3b7779190fc2b.jpg)

其中,ATT(… , …)是注意力函数,公式为![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第3张图片](http://img.e-com-net.com/image/info8/d55f2e0093934332afb4eee2c54f1680.jpg)

这里,w,W(i)和W(2)是可以被学到的参数。对于t时刻的第i只股票,历史状态注意增强表示记为r t(i)。

3.4 Winners 和 Losers 选择(股票相互关系分数计算)

基础的CAAN模型

CAAN模型采用自注意力机制描述股票间的关系,给定股票的特征r(i),为股票i计算一个查询向量q(i),一个关键向量k(i)和一个值向量v(i)

其中,W(Q),W(k)和W(V)是可以被学到的参数。

股票j和i的相互关系建模为:使用股票i的q(i)去查询股票j的k(i),Dk是缩放参数。

然后,将归一化的相互关系βij作为权重,与其他股票的v(j)相加作为衰减分数。

自注意力函数SATT(… , …)是一个βij的softmax标准化相互关系 :

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第4张图片](http://img.e-com-net.com/image/info8/0faf072cec16474eab9ca6011b0b4143.jpg)

我们使用一个完全连接的层来将注意力向量a(i)转换为一个winner 得分:

得分较高的股票更有可能成为winner。

对β的改进

使用历史的股票上涨率排名的先验知识对β进行改进,在最后的从t-1到t时间的持有期Ct-1(i)来代表历史的股票上涨率排名。受NLP领域位置信息建模方法的启发,我们使用Ct-1(i)坐标轴上的相对位置作为股票相互关系的先验知识。给定两个股票i和j,我们计算它们在坐标轴上的离散相对距离。

Q是一个预设量化系数。

我们使用一个查找矩阵L =(l1,……,lL)来表示dij的每个离散值,以dij为索引,对应的列向量ldij是相对距离dij的嵌入向量。

对于一对股票i和j,我们使用ldij 作为来计算先验关系系数ψij :

股票i和j的关系可以被重写为

这样,就引入了价格上涨率等级中的相对股票头寸作为权重来增强或削弱注意系数。股票有相似的历史价格上涨率将有更强的相互关系,然后有相似的winner得分。

3.5 投资组合生成

给定I个股票的winner分数{s(1),…,s(i),…,s(I)},首先根据股票的赢家分数按降序排序,然后得到每个股票i的序列号o (i),设G表示投资组合b+和b-的预设大小。

如果o (i)∈ [1,G],股票i会进入投资者b+(i),投资比例为

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第5张图片](http://img.e-com-net.com/image/info8/5170d141741b457fa035a3564ae2729d.jpg)

如果o (i)∈ (I-G,I],股票i会进入投资者b-(i),投资比例为![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第6张图片](http://img.e-com-net.com/image/info8/27c010da282c47ae9dfcec8294191611.jpg)

其余的股票因缺乏明确的买入/卖出信号而未被选择,为了简单起见,使用一个向量来记录两个投资组合的全部信息,使用长度I的向量bc,如果o (i)∈ [1,G],b c(i) = b +(i),如果o (i)∈ (I-G,I],b c(i) = b -(i),其余维度为0,i=1,…, I,在下面的内容中,我们交替使用bc和{b+,b-}作为 AlphaStock模型的返回。

3.6 RL优化

RL模型优化目标:找到最优参数θ*=argmaxθJ(θ)

将AlphaStock策略框架为一个具有离散智能体动作的RL游戏来优化模型参数。其中,一个t期投资被建模为一个RL智能体的状态-行动-奖励轨迹π,π={state1,action1,reward1, …,statet,actiont,rewardt, …, stateT,actionT,rewardT},statet是在t时间观察到的历史市场状态,actiont是I 维二元向量,在t时的智能体投资股票i,statet(i)=1 ,反之为0。

通过状态statet,智能体投资股票i的可能为

让Hπ代表π的夏普比率,然后rewardt是actiont对Hπ的贡献, ∑ t = 1 T \sum_{t=1}^T ∑t=1Trewardt =Hπ。

目标函数:

对于所有可能的π,RL智能体的平均奖励是![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第7张图片](http://img.e-com-net.com/image/info8/21f2f6849dc249a8beff5333ae21ce64.jpg)

我们使用梯度上升的方法迭代 τ \tau τ轮去优化θ。![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第8张图片](http://img.e-com-net.com/image/info8/89d63118efa5434a956599f680c61820.jpg)

η \eta η是学习率,被给的训练集包含N个轨迹{π1,…,πn,…πN}, ∇ \nabla ∇J(θ)近似计算为:![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第9张图片](http://img.e-com-net.com/image/info8/67bb93ac28dd448d939db51f7ec43afc.jpg)

梯度由反向传播算法计算更新。以确保所提出的模型能够击败市场,在强化学习中引入了阈值方法,梯度 ∇ \nabla ∇J(θ)被重写为

阈值H0被设置为整体市场的夏普比率。梯度上升只会促使能够超越市场的参数。

4 实验

在本节中,我们通过在美国市场的数据对我们的阿尔法股票模型进行了实证评估。中国股市的数据也被用于稳健性检验。

4.1 数据和实验设置

实验中使用的美国股票市场数据来自于沃顿商学院研究数据服务中心(WRDS),数据采集的时间范围为1970年1月至2016年12月。这一长期范围涵盖了几个众所周知的市场事件,如1995年至2000年的互联网泡沫和2007年至2009年的次贷危机,这使对不同市场状态的评估成为可能。这些股票来自四个市场:纽约证券交所、纽交所美国证券交易所、纳斯达克和纽交所Arca。每年有效股票的数量超过1000只。我们使用从1970年1月到1990年1月的数据作为训练和验证集,其余的作为测试集。

在实验中,持有期设置为一个月,投资的持有期T设置为12,即RL每12个月计算一次夏普比奖励。回顾窗口大小K被设置为12,也就是说,我们回顾了12个月的股票历史状态。投资组合的规模G被设置为所有股票数量的1/4。

4.2 baseline 方法

AlphaStock与大量的baseline方法相比较:

- Market:统一的买入并持有策略

- Cross Sectional Momentum (CSM) and Time Series Momentum (TSM):两种经典动量策略

- Robust Median Reversion (RMR):一种最新报道的回归策略

- Fuzzy Deep Direct Reinforcement (FDDR):一种最新报道的基于rl的BWSL策略

- AlphaStock-NC (AS-NC):没有CAAN的阿尔法股票模型,其中LSTM-HA的输出被直接用作投资组合生成器的输入。

- AlphaStock-NP (AS-NP):没有价格上升的模型,在我们的模型中使用基本的CAAN

基本的TSM/CSM/RMR代表传统的金融策略,TSM和CSM是基于动量逻辑和RMR是基于回归逻辑,以AS-NC和AS-NP作为对比,验证了CAAN和价格上涨排名先验的有效性。市场是用来表示市场的状态的。

4.3 评价措施

对投资策略最标准的评估标准是累积财富,公式为:![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第10张图片](http://img.e-com-net.com/image/info8/5fc33fed0e084e579496f680e5fea9f4.jpg)

Rt是收益率,TC是交易花费,实验中设置为0.1%,不同投资者的偏好各不相同。因此,我们也使用了其他一些评价措施,包括:

- Annualized Percentage Rate (APR):年度百分利率,是平均收益率的年化平均水平。APRT=AT * NY,NY是一年内持有期限的数量

- Annualized Volatility (AVOL):年化波动率,是一个波动率的年化平均水平AVOLT=VT * N \sqrt{N} N衡量一个策略在一个单位时间段内的平均风险。

- Annualized Sharpe Ratio (ASR):年化夏普比率,基于APR和AVOL的风险调整年化回报率ASRT=APRT/AVOLT

- Maximum DrawDown (MDD):最大下降幅度,是投资组合从达到峰值到低谷的最大损失。这是衡量投资风险的另一种方法。公式为

- Calmar Ratio (CR):是基于最大递减的风险调整年利率。CRT=APRT/MDDT

- Downside Deviation Ratio (DDR):下行偏差比,衡量策略的下行风险为低于最低可接受回报(MAR)时的回报平均值,它是基于下行偏差的风险调整后的APR,公式为

在我们的实验中,MAR被设为零。

4.4 在美国市场的表现

(1)总收益

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第11张图片](http://img.e-com-net.com/image/info8/739cd337adcd469c96af7e0bbd884fec.jpg)

说明:

(1)AlphaStock的性能优于AlphaStock-NP,AlphaStock-NP优于AlphaStock,这表明CAAN建模的股票等级先验和相互关系对BWSL策略有很大的帮助。

(2)FDDR也是一种深度RL投资策略,它利用递归深度神经网络提取股票的模糊表示。在我们的实验中,AlphaStockNC的性能优于FDDR,说明了我们的LSTM-HA网络在股票表示学习方面具有优势

(3)TSM策略在牛市中表现良好,但在熊市(2003年和2008年的金融危机)中表现非常差,而RMR的表现则相反。这意味着传统的金融策略只能适应某种类型的市场状态,而没有一个有效的前瞻性机制。RL策略极大地解决了这一缺陷,包括AlphaStock和FDDR,它们在不同的市场状态下表现非常稳定。

(2)其他评价指标![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第12张图片](http://img.e-com-net.com/image/info8/259ba44f8ca24e789c3fbb41eaa6725e.jpg)

对于下划线的度量(AVOL,MDD),值越低表示性能越好,而其他指标则相反AlphaStock、AlphaStock-NP和AlphaStock-NC的性能都优于其他基线,证实了我们的策略的有效性和稳健性。AlphaStock、AlphaStock-NP和AlphaStock-NC在ASR方面的性能非常接近,这可能是因为所有这些模型都进行了优化,以使夏普比最大化。以APR衡量的AlphaStock和AlphaStock-NP的利润高于AlphaStock-NC的利润,但其波动性略高。

更有趣的是,用MDD、CR和DDR测量的性能比AlphaStock好得多。通过比较AlphaStock-NP和AlphaStock-NC的MDD、CR和DDR,可以观察到相似的结果。这三种指标用于表示投资的极端损失,即最大减少额和低于最低可接受阈值的回报。结果表明,三种模型的极端损失控制能力是AlphaStock>AlphaStock-NP>AlphaStock-nc,这突出了CAAN组件的贡献和价格的上涨。事实上,之前价格上涨的CAAN充分利用了股票之间的排名关系。这种机制可以保护我们的策略不受“buying losers and selling winners”的错误,从而可以极大地避免投资的极端损失。总之,对于不同偏好的投资者来说,AlphaStock是一种非常具竞争力的策略。

4.5 在中国市场的表现

在中国股票市场上对我们的模型和基线进行了回测实验,其中包括两个交易所:上海证券交易所(SSE)和深圳证券交易所(SZSE)。数据来自WIND数据库。股票为人民币定价的普通股(A股),实验使用的股票总数为1131只。我们的数据的时间范围是从六月开始的。2005年至2018年12月,期间自6月起。2005-2011年12月作为训练/验证集,其余作为测试集。由于中国市场不能卖空,所以我们在实验中只使用b+投资组合。实验结果为

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第13张图片](http://img.e-com-net.com/image/info8/f446077044c9470ea335e9550918da0c.jpg)

从表中可以看出,AlphaStock、AlphaStock-np和AlphaStock-nc的性能再次优于其他基线。这验证了我们的模型在中国市场上的有效性。通过进一步比较表2和表1,我们可以发现,我们用AVOL和MDD测量的模型在中国市场的风险高于美国市场。这可能是由于中国等新兴国家的市场低迷,投机资本更多,但治理效率较低。卖空机制的缺乏也导致了市场力量的不平衡。中国市场和其他基线的AVOL和MDD也高于美国市场。与这些基线相比,我们的模型的风险控制能力仍然具有竞争力。综上所述,表2中的实验结果表明了我们的模型对新兴市场的稳健性。

4.6 投资策略的解释

以下四个图描述了历史交易特征对winner 分数的影响,图3(a)-3(b)绘制了来自交易特征的影响。

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第14张图片](http://img.e-com-net.com/image/info8/d8733d89013245cf90f7566931f4c1df.jpg)

如图3(a)所示,历史价格上涨率的影响沿时间轴是不均匀的。在长期月,即前9至11个月的公共关系,对winner得分有积极影响,但在短期月,即前1至8个月,影响变为消极。这一结果表明,我们的模型倾向于购买那些价格长期快速上涨(有效的卓越)或短期快速价格回撤(过度低估)的股票。这意味着AlphaStock的行为像长期动量但短期逆转混合策略,此外,由于价格上涨通常伴随着频繁的股票交易。图3(b)显示,交易量(TV)与价格增长率(PR)有相似的趋势。![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第15张图片](http://img.e-com-net.com/image/info8/0cdc6f8b8a724fd6bd1942b7c45eb426.jpg)

最后,如图3©所示,波动率(VOL)对所有历史月份的winner得分都有负影响。这意味着我们的模型倾向于选择低波动率的股票作为winner,这确实解释了为什么AlphaStock能够适应不同的市场状态,图3(d)进一步展示了不同公司特征对winner得分的平均影响。结果表明,市值(MC)、价格收益率(PE)和账面市场比率(BM)有积极的影响。这三个特征是上市公司的重要估值因素,这表明AlphaStock倾向于选择具有良好基本价值的公司。相比之下,股息意味着公司价值的一部分会返还给股东,并可能会降低股票的内在价值。这就是为什么股息(DIV)的影响在我们的模型中是负的。具体来说,AlphaStock建议选择那些长期增长高、低波动性、高内在价值和最近被低估的股票作为winner。

5 总结

在本文中,我们提出了一个基于RL的深度注意网络来设计一种称为BWSL的阿尔法策略。我们还设计了一种敏感性分析方法来解释我们的模型的投资逻辑。与现有的基于rl的投资策略相比,AlphaStock充分利用了股票之间的相互关系,为解决在金融市场中使用深度学习模型的“黑盒”问题打开了一扇门。在美国和中国股市上进行的反向测试和模拟实验表明,阿尔法股票的表现比其他竞争策略要好得多。有趣的是,AlphaStock建议购买长期增长高、波动性低、内在价值高、最近被低估的股票。

![[论文阅读]AlphaStock:使用可以解释性的深度强化学习注意力网络的买入Winners和卖出Losers投资策略_第1张图片](http://img.e-com-net.com/image/info8/e305d5841cb442dc9796be127704724b.jpg)