部署安装nginx和负载均衡

克隆服务器

修改IP地址 vim /etc/sysconfig/network-scripts/ifcfg-ens33

修改主机名称 vim /etc/hostname //改名

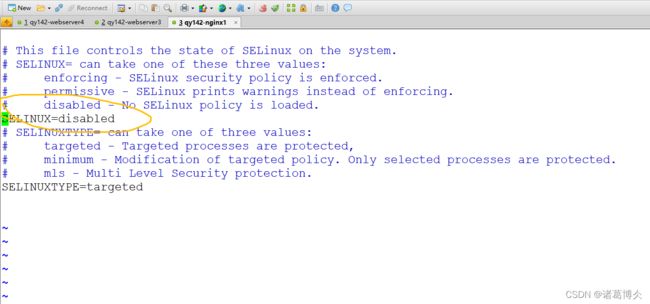

修改子安全系统 (下图) vim /etc/sysconfig/selinux

安装前的准备

1)确保进行了安装了linux常用必备支持库。(windows vs编译写好的c和c++,在linux下用g++和gcc编译c)

检查是否安装了g++、gcc。rpm -qa | grep gcc 之后需要出现3个包如下图所示。如果没有出现。需要安装g++、gcc。 检查是否安装gcc-c++ rpm -qa|grep gcc

–有的已经安装但版本低,检查时仍然出错

如果有就不需要安装

安装:yum install -y gcc-c++

2)准备和安装 pcre-8.38.tar.gz:

该文件为正则表达式库。让nginx支持rewrite需要安装这个库(rewrite :和apache等web服务软件一样,rewrite的组要功能是实现RUL地址的重定向。Nginx的rewrite功能需要PCRE软件的支持,即通过perl兼容正则表达式语句进行规则匹配的。)。

下载pcre: http://www.pcre.org/

pcre安装:

解压pcre-8.12.tar.gz

tar -xzvf /root/software/pcre-8.44.tar.gz -C /usr 解压

进入解压后的目录

cd /usr/pcre-8.44/ 配置

./configure 检测你的安装平台的目标特征的

编译 make(是用来编译的,它从Makefile中读取指令,然后编译。)

安装 make install(用来安装的,它也从Makefile中读取指令,安装到指定的位置。)

make && make install

检查是否安装 pcre-config --version

安装gzip模块需要 zlib 库

yum install -y zlib-devel

nginx安装

tar -xzvf /root/software/nginx-1.18.0.tar.gz -C /usr/ 解压

进入目录 cd /usr/nginx-1.18.0/

配置 ./configure

编译 #make

安装 # make install

查看是否安装成功 ls /usr/local/nginx/

进入安装目录 cd /usr/local/nginx/

启动 ./sbin/nginx

测试http://这台虚拟机的ip地址/

启动服务: /usr/local/nginx/sbin/nginx

重启服务: /usr/local/nginx/sbin/nginx -s reload

反向代理配置

用于通过nginx访问webserver1上的tomcat

vim /usr/local/nginx/conf/nginx.conf 修改配置

在43 3yy->p 重新配置一个可以访问指定web服务器的路径

在46下面加入(注意要自己IP):

location /qy141/ {

proxy_pass http://web服务器的路径:8080/;

}

查看nginx进程是否启动: ps -ef|grep nginx |grep -v grep

存在进程,重启nginx : /usr/local/nginx/sbin/nginx -s reload

不存在进程,直接启动nginx: /usr/local/nginx/sbin/nginx

重要配置解释:

main(全局设置,设置的指令将影响其他所有设置)

server(主机设置,用于指定主机和端口)

upstream(负载均衡服务器设置,设置一系列的后端服务器)

location(URL匹配特定位置的设置,用于匹配网页位置)。

负载均衡:

为了保证服务的高可用,服务单元往往都是集群化部署的,当服务消费者消费服务时,负载均衡组件(nginx)获取服务提供者所有实例的注册信息,并通过一定的负载均衡策略(可以自己配置)选择一个服务提供者实例,向该实例进行服务消费,这样就实现了负载均衡。

具体实现:

克隆一台web服务器名字为webserver2:

1,修改网卡配置文件,修改ipaddr

vim /etc/sysconfig/network-scripts/ifcfg-ens33

2,修改主机名称 vim /etc/hostname //改名

3,重启系统:reboot

4,使用xshell连接

在webserver1进行配置:

一个虚拟机复制3个tomcat

cp -r /usr/apache-tomcat-9.0.52/ /usr/tomcat1

cp -r /usr/apache-tomcat-9.0.52/ /usr/tomcat2

cp -r /usr/apache-tomcat-9.0.52/ /usr/tomcat3

修改tomcat底层接口和端口:

vim /usr/tomcat1/conf/server.xml

:22 8001

:69 8081

修改一下tomcat的首页面,方便体现nginx的负载均衡

vim /usr/tomcat1/webapps/ss

依次类推进行两台服务器的六个tomcat配置

把六个web服务器主机的tomcat跑起来

负载均衡配置:

upstream是Nginx的HTTP Upstream模块,这个模块通过一个简单的调度算法来实现客户端IP到后端服务器的负载均衡。

轮询round robin(默认):每个请求按时间顺序逐一分配到不同的后端服务器,如果后端某台服务器宕机,故障系统被自动剔除,使用户访问不受影响;

vim /usr/local/nginx/conf/nginx.conf

server 中配置: location /qy142lb/ {

proxy_pass http://loadbalanceserver/;

}

在http{}里面和server配置并列位置

upstream loadbalanceserver {

server 192.168.170.31:8081;

server 192.168.170.31:8082;

server 192.168.170.31:8083;

server 192.168.170.32:8084;

server 192.168.170.32:8085;

server 192.168.170.32:8086;

}

重启nginx服务: /usr/local/nginx/sbin/nginx -s reload

刷新查看

weight:

指定轮询权值,Weight值越大,分配到的访问机率越高,主要用于后端每个服务器性能不均的情况下,weight:默认值为1,最大255;

upstream myapp{

server 192.168.23.30:8080 weight=5;

server 192.168.23.31:8080 weight=10;

}

ip_hash:

每个请求按访问IP的hash结果分配,这样来自同一个IP的访客固定访问一个后端服务器,有效解决了动态网页存在的session共享问题; //获取访问的IP地址信息

request.getSession(false);

//获取已经存在session,如果不存在直接返回空request.getSession() /request.getSession(true) //不存在会创建

upstream favresin{

ip_hash;

server 192.168.23.30:8080;

server 192.168.23.31:8080;

}

fair(公平)

比上面两个更加智能的负载均衡算法。此种算法可以依据页面大小和加载时间长短智能地进行负载均衡,也就是根据后端服务器的响应时间来分配请求,响应时间短的优先分配。Nginx本身是不支持fair的,如果需要使用这种调度算法,必须下载Nginx的

url_hash:

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,可以进一步提高后端缓存服务器的效率。Nginx本身是不支持url_hash的,如果需要使用这种调度算法,必须安装Nginx 的hash软件包。

在HTTP Upstream模块中,可以通过server指令指定后端服务器的IP地址和端口,同时还可以设定每个后端服务器在负载均衡调度中的状态。常用的状态有:

down:表示当前的server暂时不参与负载均衡;

backup:预留的备份机器。当其他所有的非backup机器出现故障或者忙的时候,才会请求backup机器,因此这台机器的压力最轻;

max_fails:允许请求失败的次数,默认为1。当超过最大次数时,返回proxy_next_upstream 模块定义的错误;

fail_timeout:在经历了max_fails次失败后,暂停服务的时间,默认10秒。max_fails可以和fail_timeout一起使用。