Nebula Graph数据库 学习笔记

Nebula Graph 是一款开源的、分布式的、易扩展的原生图数据库,能够承载数千亿个点和数万亿条边的超大规模数据集,并且提供毫秒级查询。

一、图数据库简介

图数据库是以点、边为基础存储单元,以高效存储、查询图数据为设计原理的数据管理系统。

图数据库的概念:

图:一组点和边的集合,”点“表示实体,”边“表示实体间的关系。

在图数据库中,数据间的关系和数据同样重要,他们被作为数据的一部分存储起来,这样图数据库就能够快速响应复杂的关联查询。

图数据库可以直观地可视化关系,是存储、查询、分析高度互联的最优办法。

图数据库属于非关系型数据库(NoSQL)。图数据库把数据间的关系作为数据的一部分进行存储,关联上可添加标签、方向、属性,这就是图数据库的性能优势所在。

1.1、数据模型

Nebula Graph支持6种基本数据模型:

图空间(Space)

图空间用于隔离不同团队或者项目的数据。不同图空间的数据是相互隔离的,可以指定不同的存储副本数、权限、分片等。

点(Vertex)

点用来保存实体对象,特点如下:

1)点是用点标识符(VID)标识的。VID在同一图空间中唯一。VID 是一个 int64,或者 fixed_string(N)。

2)点可以有 多个 Tag。

边(Edge)

边是用来连接点的,表示两个点之间的关系或行为,特点如下:

1)两点之间可以有多条边。

2)边是有方向的,不存在无向边。

3)四元组 <起点 VID、Edge type、边排序值 (rank)、终点 VID> 用于唯一标识一条边。边没有 EID。

4)一条边有且仅有一个 Edge type。

5)一条边有且仅有一个 Rank,类型为 int64,默认值为 0。

标签(Tag)

Tag 由一组事先预定义的属性构成。

边类型(Edge type)

Edge type 由一组事先预定义的属性构成。

属性(Property)

属性是指以键值对(Key-value pair)形式表示的信息。

Tag 和 Edge type 的作用,类似于关系型数据库中“点表”和“边表”的表结构。

1.2、有向属性图

Nebula Graph 使用有向属性图模型,点和边构成的图,这些边是有方向的,点和边都可以有属性。

下表为篮球运动员数据集的结构示例,包括两种类型的点(player、team)和两种类型的边(serve、follow)。

1.3、路径

路径是指一个有限或无限的边序列,这些边连接着一系列点。

路径的类型分为三种:walk、trail、path。

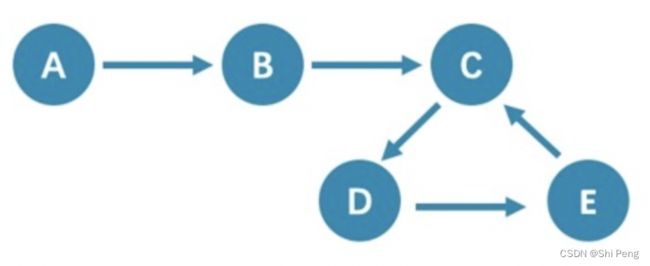

walk

walk类型的路径由有限或无限的边序列构成。遍历时点和边可以重复。

由于 C、D、E 构成了一个环,因此该图包含无限个路径

trail

trail类型的路径由有限的边序列构成。遍历时只有点可以重复,边不可以重复。

在 trail 类型中,还有cycle和circuit两种特殊的路径类型:

1、cycle

cycle 是封闭的 trail 类型的路径,遍历时边不可以重复,起点和终点重复,并且没有其他点重复。在此示例图中,最长路径由三条边组成:A->B->C->A或C->D->E->C

2、circuit

circuit 也是封闭的 trail 类型的路径,遍历时边不可以重复,除起点和终点重复外,可能存在其他点重复。在此示例图中,最长路径为:A->B->C->D->E->C->A。

path

path类型的路径由有限的边序列构成。遍历时点和边都不可以重复。

由于点和边都不可以重复,所以该图包含有限个路径,最长路径由 4 条边组成:A->B->C->D->E

1.4、VID

在 Nebula Graph 中,一个点由点的 ID 唯一标识,即 VID 或 Vertex ID。

VID特点:

1)VID 数据类型只可以为定长字符串FIXED_STRING()或INT64;一个图空间只能选用其中一种 VID 类型。

2)VID 在一个图空间中必须唯一,其作用类似于关系型数据库中的主键(索引+唯一约束)

3)点 VID 的生成方式必须由用户自行指定,系统不提供自增 ID 或者 UUID。

4)VID 相同的点,会被认为是同一个点。例如:

- VID 相当于一个实体的唯一标号:例如一个人的身份证号。Tag 相当于实体所拥有的类型,例如"滴滴司机"和"老板"。不同的 Tag 又相应定义了两组不同的属性,例如"驾照号、驾龄、接单量、接单小号"和"工号、薪水、债务额度、商务电话"。

- 同时操作相同 VID 并且相同 Tag 的两条INSERT语句(均无IF NOT EXISTS参数),晚写入的INSERT会覆盖先写入的。

- 同时操作包含相同 VID 但是两个不同TAG A和TAG B的两条INSERT语句,对TAG A的操作不会影响TAG B。

5)VID 通常会被(LSM-tree 方式)索引并缓存在内存中,因此直接访问 VID 的性能最高。

1.5、Nebula Graph架构

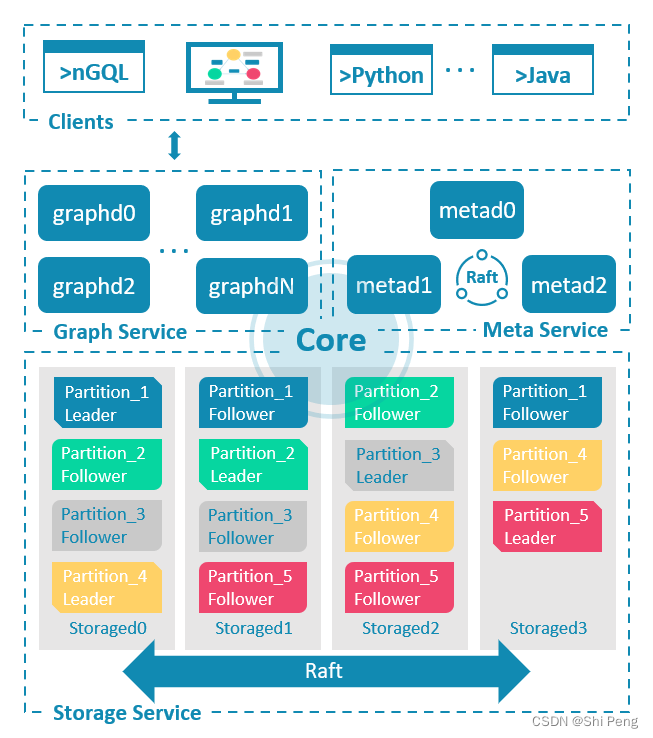

Nebula Graph 由三种服务构成:Graph 服务、Meta 服务和 Storage 服务,是一种存储与计算分离的架构。

每个服务都有可执行的二进制文件和对应进程,用户可以使用这些二进制文件在一个或多个计算机上部署 Nebula Graph 集群。

Meta服务

meta服务负责数据管理,例如 Schema 操作、集群管理和用户权限管理等。

Graph 服务

Graph 服务负责处理计算请求

Storage 服务

Storage 服务负责存储数据

二、Nebula Graph的安装部署

2.1、安装nebula graph

Step1、在mac系统上安装docker

参考:https://zhuanlan.zhihu.com/p/504604050

mac os 版本:12.1

docker版本:20.10.14, build a224086

% docker info

Client:

Context: default

Debug Mode: false

Plugins:

buildx: Docker Buildx (Docker Inc., v0.8.2)

compose: Docker Compose (Docker Inc., v2.5.1)

sbom: View the packaged-based Software Bill Of Materials (SBOM) for an image (Anchore Inc., 0.6.0)

scan: Docker Scan (Docker Inc., v0.17.0)

Server:

Containers: 0

Running: 0

Paused: 0

Stopped: 0

Images: 0

Server Version: 20.10.14

Storage Driver: overlay2

Backing Filesystem: extfs

Supports d_type: true

Native Overlay Diff: true

userxattr: false

Logging Driver: json-file

Cgroup Driver: cgroupfs

Cgroup Version: 2

Plugins:

Volume: local

Network: bridge host ipvlan macvlan null overlay

Log: awslogs fluentd gcplogs gelf journald json-file local logentries splunk syslog

Swarm: inactive

Runtimes: io.containerd.runc.v2 io.containerd.runtime.v1.linux runc

Default Runtime: runc

Init Binary: docker-init

containerd version: 3df54a852345ae127d1fa3092b95168e4a88e2f8

runc version: v1.0.3-0-gf46b6ba

init version: de40ad0

Security Options:

seccomp

Profile: default

cgroupns

Kernel Version: 5.10.104-linuxkit

Operating System: Docker Desktop

OSType: linux

Architecture: aarch64

CPUs: 5

Total Memory: 7.667GiB

Name: docker-desktop

ID: AM6Z:I27L:Z4GP:LQMH:YEIL:T5UD:CVDO:2SN2:6J74:ZIWB:6H4Z:RGS5

Docker Root Dir: /var/lib/docker

Debug Mode: false

HTTP Proxy: http.docker.internal:3128

HTTPS Proxy: http.docker.internal:3128

No Proxy: hubproxy.docker.internal

Registry: https://index.docker.io/v1/

Labels:

Experimental: false

Insecure Registries:

hubproxy.docker.internal:5000

127.0.0.0/8

Live Restore Enabled: false

Step2、配置Docker加速:

修改原配置为新的配置:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://hub-mirror.c.163.com/",

"https://reg-mirror.qiniu.com",

"https://docker.mirrors.ustc.edu.cn/",

"https://wh9z3wm8.mirror.aliyuncs.com"

]

}

Step3、Docker网络配置

% docker network create nebula-net

6d9219819496c2aea8d7c8d61fa0edab950965b70ceef7b98cf9156c3ee41c64

peng.shi@H7HT0YWMTC ~ % docker network ls

NETWORK ID NAME DRIVER SCOPE

4451ad142c9a bridge bridge local

5fed9c0933af host host local

6d9219819496 nebula-net bridge local

066f578ac097 none null local

Step4、安装nebula-graph

1、Git 克隆 nebula-docker-compose 仓库

peng.shi@H7HT0YWMTC ~ % git clone -b master https://github.com/vesoft-inc/nebula-docker-compose.git

Cloning into 'nebula-docker-compose'...

remote: Enumerating objects: 440, done.

remote: Counting objects: 100% (154/154), done.

remote: Compressing objects: 100% (42/42), done.

remote: Total 440 (delta 138), reused 112 (delta 112), pack-reused 286

Receiving objects: 100% (440/440), 143.52 KiB | 296.00 KiB/s, done.

Resolving deltas: 100% (258/258), done.

2、修改 docker-compose.yaml

docker-compose.yaml在刚下载的nebula-docker-compose目录中

在docker-compose.yaml中增加:

external: true

Step4、docker-compose 部署 Nebula(此处需要开VPN,否则下载超时)

docker-compose up -d

peng.shi@H7HT0YWMTC nebula-docker-compose % docker-compose up -d

Pulling metad0 (vesoft/nebula-metad:nightly)...

nightly: Pulling from vesoft/nebula-metad

nightly: Pulling from vesoft/nebula-metad

nightly: Pulling from vesoft/nebula-metad

6717b8ec66cd: Pull complete

fdd65c4c2d5c: Pull complete

733069f6a7fa: Pull complete

4f4fb700ef54: Pull complete

7df18b9cd98f: Pull complete

Digest: sha256:7485b2fd39b02694b7f9edb32d8f0d684afe403f9ff5c330a33e8f36d1255133

Status: Downloaded newer image for vesoft/nebula-metad:nightly

Pulling storaged0 (vesoft/nebula-storaged:nightly)...

nightly: Pulling from vesoft/nebula-storaged

nightly: Pulling from vesoft/nebula-storaged

nightly: Pulling from vesoft/nebula-storaged

6717b8ec66cd: Already exists

f332d3f370bb: Pull complete

cf87f019d5b8: Pull complete

4f4fb700ef54: Pull complete

b5945490aa54: Pull complete

Digest: sha256:c39eed30f41e6ed876b03e6df1d092c349823f20589f3a75c8bd553d7258d576

Status: Downloaded newer image for vesoft/nebula-storaged:nightly

Pulling graphd (vesoft/nebula-graphd:nightly)...

nightly: Pulling from vesoft/nebula-graphd

2d473b07cdd5: Downloading [=============> ] 19.95MB/76.1MB

2d473b07cdd5: Downloading [=======> ] 11.02MB/76.1MB

39a4c7f32b8c: Retrying in 1 second

6fef0e3258c2: Download complete

6de84f84c10e: Downloading [===============================> ] 12.85MB/20.61MB

nightly: Pulling from vesoft/nebula-graphd

6717b8ec66cd: Already exists

fe7880d7abed: Pull complete

0d816d217636: Pull complete

4f4fb700ef54: Pull complete

4e16df01237b: Pull complete

Digest: sha256:e7a83d0aef7d7a9188fe6d5740011e0ea9ca6c3b4d69adeaad21653be61bb67f

Status: Downloaded newer image for vesoft/nebula-graphd:nightly

Pulling console (vesoft/nebula-console:nightly)...

nightly: Pulling from vesoft/nebula-console

97518928ae5f: Pull complete

201f3554b694: Pull complete

a7d9596279dc: Pull complete

Digest: sha256:e14bed97d0fd13b0d46bc01ac67fed6759f6387a048e19bbe7974bda068d0203

Status: Downloaded newer image for vesoft/nebula-console:nightly

Creating nebula-docker-compose_metad2_1 ... done

Creating nebula-docker-compose_metad0_1 ... done

Creating nebula-docker-compose_metad1_1 ... done

Creating nebula-docker-compose_storaged0_1 ... done

Creating nebula-docker-compose_storaged2_1 ... done

Creating nebula-docker-compose_storaged1_1 ... done

Creating nebula-docker-compose_graphd_1 ... done

Creating nebula-docker-compose_graphd2_1 ... done

Creating nebula-docker-compose_graphd1_1 ... done

Creating nebula-docker-compose_console_1 ... done

Step5、Nebula Studio安装

1、下载 Nebula Studio 部署配置文件

wget https://oss-cdn.nebula-graph.com.cn/nebula-graph-studio/3.2.2/nebula-graph-studio-v3.2.2.tar.gz

peng.shi@H7HT0YWMTC nebula-docker-compose % wget https://oss-cdn.nebula-graph.com.cn/nebula-graph-studio/3.2.2/nebula-graph-studio-v3.2.2.tar.gz

--2022-05-24 12:14:50-- https://oss-cdn.nebula-graph.com.cn/nebula-graph-studio/3.2.2/nebula-graph-studio-v3.2.2.tar.gz

正在解析主机 oss-cdn.nebula-graph.com.cn (oss-cdn.nebula-graph.com.cn)... 124.200.113.113, 124.200.113.110, 124.200.113.114, ...

正在连接 oss-cdn.nebula-graph.com.cn (oss-cdn.nebula-graph.com.cn)|124.200.113.113|:443... 已连接。

已发出 HTTP 请求,正在等待回应... 200 OK

长度:5533480 (5.3M) [application/gzip]

正在保存至: “nebula-graph-studio-v3.2.2.tar.gz”

nebula-graph-studio-v3.2.2.tar.g 100%[=========================================================>] 5.28M 1.50MB/s 用时 4.1s

2022-05-24 12:14:55 (1.27 MB/s) - 已保存 “nebula-graph-studio-v3.2.2.tar.gz” [5533480/5533480])

2、创建 nebula-graph-studio-v3.2.2 目录,并将安装包解压至目录中

mkdir nebula-graph-studio-v3.2.2 && tar -zxvf nebula-graph-studio-v3.2.2.tar.gz -C nebula-graph-studio-v3.2.2

3、修改 docker-compose.yaml

将原有nebula-web改为nebula-net, 并添加external: true:

version: '3.4'

services:

web:

image: vesoft/nebula-graph-studio:v3.2.2

environment:

USER: root

UPLOAD_DIR: ${MAPPING_DOCKER_DIR}

ports:

- 7001:7001

networks:

- nebula-net

networks:

nebula-net:

external: true

4、构建并启动 Nebula Studio 服务(需要开VPN)

在nebula-graph-studio-v3.2.2 目录下执行:

docker-compose up -d

peng.shi@H7HT0YWMTC nebula-graph-studio-v3.2.2 % docker-compose up -d

WARNING: The MAPPING_DOCKER_DIR variable is not set. Defaulting to a blank string.

Pulling web (vesoft/nebula-graph-studio:v3.2.2)...

v3.2.2: Pulling from vesoft/nebula-graph-studio

59bf1c3509f3: Downloading

bd8aa6907987: Download complete

59bf1c3509f3: Pull complete

bd8aa6907987: Pull complete

79b600fbf12a: Pull complete

9e028fd00ce7: Pull complete

Digest: sha256:ee8e9551a0f10c8e4fe03312131fb53f885dc4a7bf15157e0d500607fbaa1508

Status: Downloaded newer image for vesoft/nebula-graph-studio:v3.2.2

Creating nebula-graph-studio-v322_web_1 ... done

登录本地安装的nebula数据库:http://127.0.0.1:7001/

Host: graphd:9669

用户名:root

密码:nebula

可登录至主界面:

5、Nebula Console 安装 & 访问

下载地址:https://github.com/vesoft-inc/nebula-console/releases

mac系统下载第一个

下载nebula-console-darwin-amd64-v3.0.0后,改名为nebula-console,此文件为二进制文件,在此文件所在路径执行下述命令:

chmod 777 nebula-console

./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

此时如果弹出macOS不信任此nebula-console,则点击问号,在设置->安全与隐私中设置信任后即可。

peng.shi@H7HT0YWMTC Downloads % chmod 777 nebula-console

peng.shi@H7HT0YWMTC Downloads % ./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

zsh: killed ./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

peng.shi@H7HT0YWMTC Downloads % ./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

zsh: killed ./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

peng.shi@H7HT0YWMTC Downloads % ./nebula-console -addr=127.0.0.1 -port 9669 -u root -p nebula

Welcome to Nebula Graph!

(root@nebula) [(none)]>

2.2、安装完成后测试验证

通过Nebula Studio 服务访问

接下来就可以使用nebula数据库了。

三、Nebula工具

3.1、Nebula Importer

Importer工具,支持把本地的csv文件导入到Nebula gragh数据库中。

3.2、Nebula Exchange

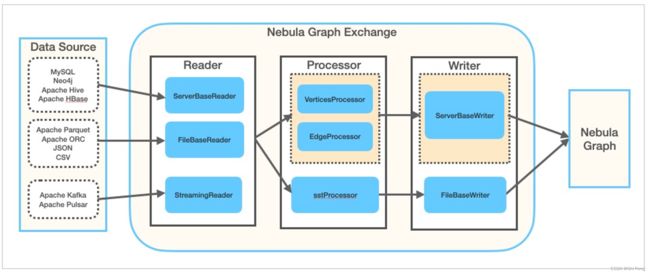

Nebula Exchange用于把spark中的多种不同格式的数据迁移到nebula graph中,支持批量数据和流式数据的迁移。

Exchange工具由Reader、Processor、Writer三部分组成:

1、Reader:读取不同来源的数据,返回DataFrame

2、Processor:遍历DataFrame每行,根据配置文件中fields的映射关系,按列名获取对应的值。

3、Writer:在遍历指定批处理的行数后,Writer将这些批处理的数据一次性写入到nebula graph中。

3.2.1、Exchange适用场景

1)来自Kafka, Pulsar的流式数据

2)从关系型数据库(如MySQL)或分布式文件系统(如HDFS)中获取的批式数据,如某个时间段的数据

3)要将大批量生成Nebula Graph能识别的SST文件,再导入到Nebula Graph数据库

4)需要导出Nebula Graph中保存的数据

总结:把spark中的数据导入到nebula(流式);把MySQL/HDFS中的数据导入到nebula(批量);把nebula的SST文件导入到nebula;把nebula的数据导出。

Exchange的优点:

1)支持多种来源的数据导入到nebula

2)支持不同来源的数据转为SST文件后导入

3)支持SSL加密

4)支持断点续传(目前仅Neo4j数据迁移时支持断点续传)

5)异步操作:在数据源中生成一条插入语句,发给graph服务,最后再执行插入操作

6)支持同时导入多个tag和edge type,不同tag和edge type可以是不同数据来源或格式

7)可使用spark中的累加器统计插入操作成功和失败的次数

8)采用HOCON(Human-Optimized Config Object Notation)配置文件格式,具有面向对象风格

3.3.2、Nebula Exchange支持的数据源

Exchange 3.0.0 支持通过 nGQL 语句的形式导入 Nebula:

1、存储在 HDFS 或本地的数据:

Apache Parquet

Apache ORC

JSON

CSV

2、HBase

3、数据仓库:

Hive

MaxCompute

4、图数据库:Neo4j

5、关系型数据库:

MySQL

PostgreSQL

6、列式数据库:ClickHouse

7、流处理软件平台:Kafka

8、发布/订阅消息平台:Pulsar

除了用 nGQL 语句的形式导入数据,Exchange 还支持将数据源的数据生成 SST 文件,然后通过 Console 导入 SST 文件。

以 Nebula Graph 为源,将数据导出到 CSV 文件 (仅企业版支持此功能)