注册spark UDF实例1【入门必修第一篇,简单函数注册,scala,python】

写在前面:

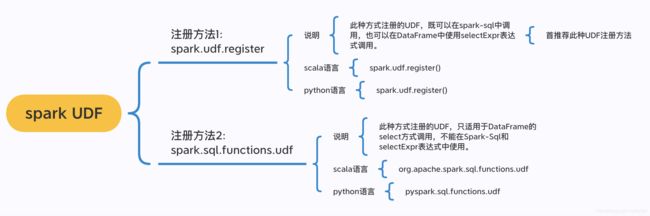

关于spark的UDF你不得不清楚的区分和理解它适用的范围(spark-Sql 还是DataFrame)和不同语言下的使用方法(scala还是python)。

1、注册SQL的 UDF自定义函数。

使用spark.udf.register进行UDF注册,这样注册的函数既可以在SQL中使用,也可以在DataFrame的selectExpr表达式中使用。

(1)scala语言

第一步,注册UDF

- 方法1:先定义函数,再进行注册

// in scala

//先定义一个函数

def power3(number:Double):Double = number * number * number

//将函数注册成spark-sql的UDF

spark.udf.register("power3", power3(_:Double):Double)

- 方法2:直接在注册的时候写函数

//in scala

//直接在注册UDF的时候写函数

spark.udf.register("power3",(number:Double) => {

var result = number * number * number

result

})

第二步,调用UDF函数

- 在Spark-Sql中调用:

--in sql ,调用UDF

SELECT power3(num) from table - 在DataFrame的selectExpr表达式中使用

// in scala, 在DataFrame中使用selectExpr调用UDF

df.selectExpr("power3(num)").show()(2) python语言

第一步,注册UDF

- 方法1:先定义函数,再进行注册

#in python

#先定义一个函数

def power2(num1,num2):

return num1 * num2

#将函数注册成spark-sql的UDF

spark.udf.register("power2py", power2)

当然也可以在注册函数的时候,对函数的输出类型进行强制转换:比如这样注册

# in Python 注册UDF,并强制输出类型

from pyspark.sql.types import IntegerType, DoubleType

spark.udf.register("power2py", power2, DoubleType())- 方法2:直接在注册的时候写函数

#直接在注册UDF的时候写函数

第二步,调用UDF函数

- 在Spark-Sql中调用:

--in sql

SELECT power2py(num1,num2) from table - 在DataFrame的selectExpr表达式中使用

#in python 对DataFrame调用UDF

df.selectExpr("power2py(num1,num2)").show()

2、注册Spark DataFrame UDF自定义函数。

使用 org.apache.spark.sql.functions.udf (scala语言) ,pyspark.sql.functions.udf (python语言)注册UDF,

这样注册的函数只能在DataFrame中使用,不能用在Spark-SQL中,也不能在DataFrame的selectExpr表达式中使用。

(1)scala语言

第一步,注册UDF

- 方法1:先定义函数,再进行注册

// in Scala

//先定义一个函数

def power3(number:Double):Double = number * number * number

// 先导入udf所在的包,再将函数注册成DataFrame的UDF

import org.apache.spark.sql.functions.udf

val power3udf = udf(power3(_:Double):Double)

- 方法2:直接在注册的时候写函数

第二步,调用UDF函数

- 在DataFrame的select中结合col函数进行调用

//in scala 调用UDF

df.select(power3udf(col("num"))).show()(2) python语言

第一步,注册UDF

- 方法1:先定义函数,再进行注册

#in python

#先定义一个函数

def power2(num1,num2):

return num1 * num2

#导入UDF所在的包,并将函数注册成DataFrame的UDF

from pyspark.sql.functions import udf

power2udf = udf(power2)- 方法2:直接在注册的时候写函数

#直接在注册UDF的时候写函数

第二步,调用UDF函数

- 在DataFrame的select中结合col函数进行调用

# in Python 导入col包,结合UDF一起使用

from pyspark.sql.functions import col

df.select(power2udf(col("num1"),col("num2"))).show()