Redis集群三种模式---主从复制、哨兵、集群

目录

redis主从复制

主从复制的作用:

主从复制的流程

搭建主从复制

哨兵模式

哨兵模式原理:

哨兵模式作用

哨兵结构组成

故障转移机制

搭建哨兵模式

集群模式

Redis Cluster 工作原理

Redis cluster 基本架构

搭建集群

测试集群

redis主从复制

主从复制,是指将一台redis服务器的数据,复制到其他的redis服务器。前者称为主节点 (master),后者称为从节点(slave);数据复制是单向的,只能由主节点到从节点。

默认情况下,每台redis服务器都是主节点;且一个主节点可以有多个从节点(或者没有从节点),但是每一个从节点只能有一个主节点。

主从复制的作用:

-

数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

-

故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

-

负载均衡:在主从复制的基础.上,配合读写分离,可以让主节点提供写服务,由从节点提供读服务〈即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

-

高可用基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础。

主从复制的流程

-

若启动一个Slave机器,则它会向Master机器发送一个"sync command"命令,请求同步连接。从发给主

-

无论是第一次连接还是重新连接,Master机器都会启动一个后台进程,将数据快照保存到数据文件中(执行rdb操作),同时Master还会记录修改数据的所有命令并缓存在数据文件中。

-

后台进程完成缓存操作之后,Master机器就会向Slave机器发送数据文件存储,接着Master机器就会将修改数据的所有操作一并发送给Slave端机器。若slave出现故障导致宕机,则恢复正常后会自动重新连接。

-

Master机器收到Slave端机器的连接后,将其完整的数据文件发送给slave端机器,如果Master同时收到多个slave发来的同步请求,则Master会在后台启动一个进程以保存数据文件,然后将其发送给所有的Slave端机器,确保所有的Slave端机器都正常。

搭建主从复制

实验环境:

master节点:192.168.241.128

slave1节点:192.168.241.129

slave2节点:192.168.241.134

systemctl stop firewalld

setenforce 0

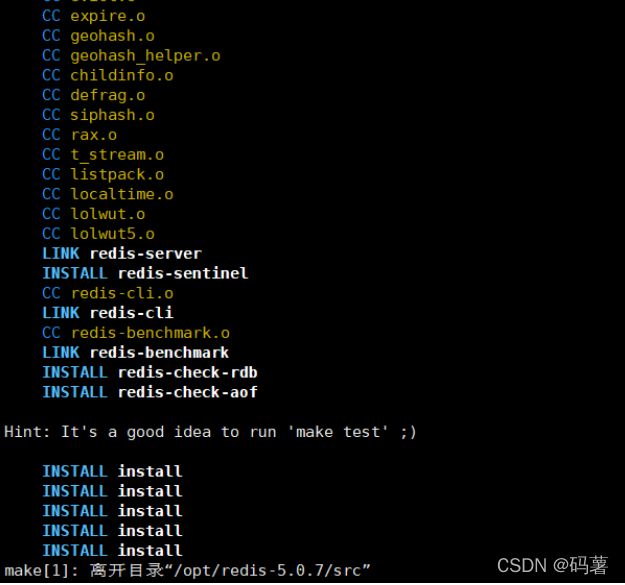

安装redis

yum install -y gcc gcc-c++ make

#安装前依赖包

#将redis-5.0.7.tar.gz 压缩包上传到/opt 目录中

tar zxvf redis-5.0.7.tar.gz -C /opt/

cd /opt/redis-5.0.7/

make PREFIX=/usr/local/redis install

#由于Redis源码包中直接提供了Makefile 文件,所以在解压完软件包后,不用先执行./configure 进行配置,可直接执行make与make install命令进行安装

#执行软件包提供的 install_server.sh 脚本文件设置Redis服务所需要的相关配置文件cd /opt/redis-5.0.7/utils

./install_server.sh

....... #一直回车.

Please select the redis executable path [/usr/local/bin/redis-server] /usr/local/redis/bin/redis-server

#需要手动修改为 /usr/local/redis/bin/redis-server 注意要一次性正确输入ss -natp |grep redis

#查看是否启动vim /etc/redis/6379.conf

70 bind 127.0.0.1 192.168.241.128

#70 行加入自己的IP地址

/etc/init.d/redis_6379 restart

ss -natp |grep redis

#再查看下

#把redis的可执行程序文件放入路径环境变量的目录中便于系统识别

ln -s /usr/local/redis/bin/* /usr/local/bin/主从服务器操作

#############主节点#############

[root@localhost ~]#vim /etc/redis/6379.conf

70 bind 0.0.0.0

#将监听端口改为任意端口

137 daemonize yes

#开启守护进程

172 logfile /var/log/redis_6379.log

#指定日志文件目录

264 dir /var/lib/redis/6379

#指定工作目录

700 appendonly yes

#开启AOF持久化功能

[root@localhost ~]#/etc/init.d/redis_6379 restart

#重启服务

################从节点######################

[root@localhost ~]#vim /etc/redis/6379.conf

70 bind 0.0.0.0

#将监听端口改为任意端口

137 daemonize yes

#开启守护进程

172 logfile /var/log/redis_6379.log

#指定日志文件目录

264 dir /var/lib/redis/6379

#指定工作目录

288 replicaof 192.168.91.100 6379

#指定主节点的ip 和端口

701 appendonly yes

#开启 AOF持久化验证效果

在master节点上看日志:

[root@localhost ~]#tail -f /var/log/redis_6379.log [root@localhost ~]#redis-cli

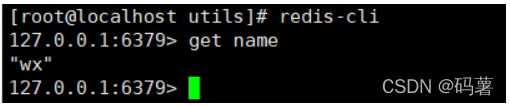

info replication#创建数据验证

##在master创建数据

set name wx

##在从节点上查看

get name哨兵模式

哨兵的核心功能:

在主从复制的基础上,哨兵引入了主节点的自动故障转移。

哨兵模式原理:

哨兵(sentinel):是一个分布式系统,用于对主从结构中的每台服务器进行监控,当出现故障时通过投票机制选择新的Master并将所有Slave连接到新的 Master。所以整个运行哨兵的集群的数量不得少于3个节点。

哨兵模式作用

-

监控:哨兵会不断地检查主节点和从节点是否运作正常。

-

自动故障转移:当主节点不能正常工作时,哨兵会开始自动故障转移操作,它会将失效主节点的其中一个从节点升级为新的主节点,并让其他从节点改为复制新的主节点。

-

通知提醒:哨兵可以将故障转移的结果发送给客户端。

哨兵结构组成

-

哨兵节点:哨兵系统由一个或多个哨兵节点组成,哨兵节点就是特殊的redis节点,不存储数据

-

数据节点:主节点和从节点都是数据节点。

哨兵的启动依赖于主从模式,所以须把主从模式安装好的情况下再去做哨兵模式,所有节点上.都需要部署哨兵模式,哨兵模式会监控所有的Redis工作节点是否正常,当Master出现问题的时候,因为其他节点与主节点失去联系,因此会投票,投票过半就认为这个Master的确出现问题,然后会通知哨兵间,然后从Slaves中选取一个作为新的 Master。

需要特别注意的是,客观下线是主节点才有的概念:如果从节点和哨兵节点发生故障,被哨兵主观下线后,不会再有后续的客观下线和故障转移操作。

故障转移机制

1.由哨兵节点定期监控发现主节点是否出现了故障,每个哨兵节点每隔1秒会向主节点、从节点及其它哨兵节点发送一次ping命令做一次心跳检测。如果主节点在一定时间范围内不回复或者是回复一个错误消息,那么这个哨兵就会认为这个主节点主观下线了(单方面的),当超过半数哨兵节点认为该主节点下线了,这样就客观下线了。

2.当主节点出现故障,此时哨兵节点会通过Raft算法〈选举算法)实现选举机制共同选举出一个哨兵节点为leader,来负责处理主节点的故障转移和通知。所以整个运行哨兵的集群的数量不得少于3个节点。

3.由leader哨兵节点执行故障转移,过程如下:

●将某一个从节点升级为新的主节点,让其它从节点指向新的主节点;

●若原主节点恢复也变成从节点,并指向新的主节点;

●通知客户端主节点已经更换。

需要特别注意的是,客观下线是主节点才有的概念:如果从节点和哨兵节点发生故障,被哨兵主观下线后,不会再有后续的客观线和故障转移操作

主节点的选举:

1过滤掉不健康的(已下线的),没有回复哨兵ping响应的从节点

2选择配置文件中从节点优先级最高的(replication-priority,默认值为100)

3选择复制偏移量最大的,也就是复制最完整的从节点。

sentinel中的三个定时任务

-

每10秒每个sentinel对master和slave执行info发现slave节点

-

每2秒确认主从关系:每2秒每个sentinel通过master节点的channel交换信息(pub/sub)通过sentinel__:hello频道交互交互对节点的“看法”和自身信息

-

每1秒每个sentinel对其他sentinel和redis执行ping

Sentinel 进程是用于监控redis集群中Master主服务器工作的状态,在Master主服务器发生故障的时候,可以实现Master和Slave服务器的切换,保证系统的高可用,此功能在redis2.6+的版本已引用,Redis的哨兵模式到了2.8版本之后就稳定了下来。一般在生产环境也建议使用Redis的2.8版本的以后版本。

哨兵(Sentinel) 是一个分布式系统,可以在一个架构中运行多个哨兵(sentinel) 进程,这些进程使用流言协议(gossip protocols)来接收关于Master主服务器是否下线的信息,并使用投票协议 (Agreement Protocols)来决定是否执行自动故障迁移,以及选择哪个Slave作为新的Master有主观宕机,对应的有客观宕机。

当“哨兵群”中的多数Sentinel进程在对Master主服务器做出SDOWN 的判断,并且通过 SENTINEL is-master-down-by-addr 命令互相交流之后,得出的Master Server下线判断,这种方式就是“客观宕机”(客观:是不依赖于某种意识而已经实际存在的一切事物),英文名称是:Objectively Down, 简称 ODOWN通过一定的vote算法,从剩下的slave从服务器节点中,选一台提升为Master服务器节点,然后自动修改相关配置,并开启故障转移(failover)Sentinel 机制可以解决master和slave角色的自动切换问题,但单个 Master 的性能瓶颈问题无法解决,类似于MySQL中的MHA功能Redis Sentinel中的Sentinel节点个数应该为大于等于3且最好为奇数客户端初始化时连接的是Sentinel节点集合,不再是具体的Redis节点,但Sentinel只是配置中心不是代理。Redis Sentinel 节点与普通redis 没有区别,要实现读写分离依赖于客户端程序redis 3.0 之前版本中,生产环境一般使用哨兵模式,但3.0后推出redis cluster功能后,可以支持更大规模的生产环境

搭建哨兵模式

实验环境

master节点:192.168.241.128

slave1节点:192.168.241.129

slave2节点:192.168.241.134

systemctl stop firewalld

setenforce 0

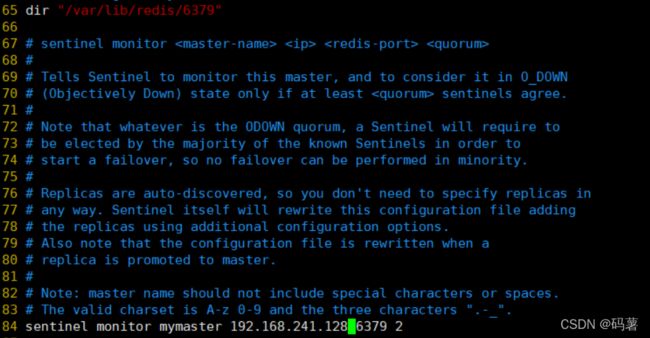

修改哨兵模式的配置文件(所有节点操作)

[root@localhost ~]#vim /opt/redis-5.0.7/sentinel.conf

#修改配置文件

17 protected-mode no

#关闭保护模式

21 port 26379

#端口号 26379

26 daemonize yes

#开启后台运行

36 logfile "/var/log/sentinel.log

#指定日志目录

65 dir "/var/lib/redis/6379"

#数据文件

84 sentinel monitor mymaster 192.168.91.100 6379 2

#改变master节点地址

113 sentinel down-after-milliseconds mymaster 30000

#可以修改时间

146 sentinel failover-timeout mymaster 180000

#故障切换时间#注意:先启master,再启slave

cd /opt/redis-5.0.7/

redis-sentinel sentinel.conf &查看哨兵信息

redis-cli -p 26379 info Sentinel模拟故障

#在Master 上查看redis-server进程号:

ps -ef | grep redis

#杀死 Master 节点上redis-server的进程号

kill -9 79522 #Master节点上redis-server的进程号

#验证master是转换至从服务器

tail -f /var/log/sentinel.log

#在Slave上查看是否转换成功

redis-cli -p 26379 INFO Sentinel集群模式

集群,即Redis Cluster,是Redis 3.0开始引入的分布式存储方案。

集群由多个节点(Node)组成,Redis的数据分布在这些节点中。集群中的节点分为主节点和从节点:只有主节点负责读写请求和集群信息的维护;从节点只进行主节点数据和状态信息的复制。

集群的作用,可以归纳为两点:

(1)数据分区:数据分区(或称数据分片)是集群最核心的功能。集群将数据分散到多个节点,一方面突破了Redis单机内存大小的限制,存储容量大大增加;另一方面每个主节点都可以对外提供读服务和写服务,大大提高了集群的响应能力。Redis单机内存大小受限问题,在介绍持久化和主从复制时都有提及:例如,如果单机内存太大,bgsave和bgrewriteaof 的:保存操作可能导致主进程阻塞,主从环境下主机切换时可能导致从节点长时间无法提供服务,全量复制阶段主节点的复制缓冲区可能溢出。

(2)高可用:集群支持主从复制和主节点的自动故障转移(与哨兵类似)﹔当任一节点发生故障时,集群仍然可以对外提供服务。

#Redis集群的数据分片:

Redis集群引入了哈希槽的概念

Redis集群有16384个哈希槽(编号0-16383)集群的每个节点负责部分哈希槽

每个Key通过CRc16校验后对16384取余来决定放置哪个哈希槽,通过这个值,去找到对应的插槽所对应的节点,然后直接自动跳转到这个对应的节点上进行存取操作

#以3个节点组成的集群为例:

节点A包含0到5460号哈希槽

节点B包含5461到10922号哈希槽

节点C包含10923到16383号哈希槽

#Redis集群的主从复制模型

集群中具有A、B、C三个节点,如果节点B失败了,整个集群就会因缺少5461-10922这个范围的槽而不可以用。

为每个节点添加一个从节点A1、B1、C1整个集群便有三个Master节点和三个slave 节点组成,在节点B失败后,集群选举:一位为主节点继续服务。当B和B1都失败后,集群将不可用。

Redis Cluster 工作原理

在哨兵sentinel机制中,可以解决redis高可用问题,即当master故障后可以自动将slave提升为

master,从而可以保证redis服务的正常使用,但是无法解决redis单机写入的瓶颈问题,即单机redis写

入性能受限于单机的内存大小、并发数量、网卡速率等因素。

Redis Cluster特点如下:

-

所有Redis节点使用(PING机制)互联,

-

集群中某个节点的是否失效,是由整个集群中超过半数的节点监测都失效,才能算真正的失效

-

客户端不需要proxy即可直接连接redis,应用程序中需要配置有全部的redis服务器IP

-

redis cluster把所有的redis node 平均映射到 0-16383个槽位(slot)上,读写需要到指定的redis

node上进行操作,因此有多少个redis node相当于redis 并发扩展了多少倍,每个redis node 承担16384/N个槽位

5.Redis cluster预先分配16384个(slot)槽位,当需要在redis集群中写入一个key -value的时候,会使用CRC16(key)取余16384之后的值,决定将key写入哪一个槽位从而决定写入哪一个Redis节点上,从而有效解决单机瓶颈。

Redis cluster 基本架构

假如三个主节点分别是:A, B, C 三个节点,采用哈希槽 (hash slot)的方式来分配16384个slot 的话

它们三个节点分别承担的slot 区间可以是

节点A覆盖 0-5460

节点B覆盖 5461-10922

节点C覆盖 10923-16383Redis cluster 主从架构

Redis cluster的架构虽然解决了并发的问题,但是又引入了一个新的问题,每个Redis master的高可用

如何解决?

那就是对每个master 节点都实现主从复制,从而实现 redis 高可用性

搭建集群

创建节点目录

cd /etc/redis/

mkdir -p redis-cluster/redis600{1..6}

for i in {1..6}

do

cp /opt/redis-5.0.7/redis.conf /etc/redis/redis-cluster/redis600$i

cp /opt/redis-5.0.7/src/redis-cli /opt/redis-5.0.7/src/redis-server /etc/redis/redis-cluster/redis600$i

done

开启群集功能

其他5个文件夹的配置文件以此类推修改,注意6个端口都要不一样

cd /etc/redis/redis-cluster/redis6001

vim redis.conf

bind 0.0.0.0 #69行,监听所有网段

protected-mode no #88行,修改,关闭保护模式

port 6001 #92行,修改,redis监听端口,

daemonize yes #136行,以独立进程启动

cluster-enabled yes #832行,取消注释,开启群集功能

cluster-config-file nodes-6001.conf #840行,取消注释,群集名称文件设置

cluster-node-timeout 15000 #846行,取消注释群集超时时间设置

appendonly yes #700行,修改,开启AOF持久化启动redis节点

分别进入那六个文件夹,执行命令:redis-server、redis.conf,来启动redis节点

cd /etc/redis/redis-cluster/redis6001

redis-server redis.conf

for d in {1..6}

do

cd /etc/redis/redis-cluster/redis600$d

redis-server redis.conf

done

ps -ef | grep redisredis-cli --cluster create 127.0.0.1:6001 127.0.0.1:6002 127.0.0.1:6003 127.0.0.1:6004 127.0.0.1:6005 127.0.0.1:6006 --cluster-replicas 1

#六个实例分为三组,每组一主一从,前面的做主节点,后面的做从节点。下面交互的时候 需要输入 yes 才可以创建。

--replicas 1 表示每个主节点有1个从节点。测试集群

redis-cli -p 6001 -c

127.0.0.1:6001> CLUSTER SLOTS