LVS集群---NAT模式与DR模式部署

目录

LVS集群(Linux Virtual server)

集群和分布式

集群 Cluster

LVS负载均衡调度算法

分布式系统

集群和分布式

集群设计原则

集群设计实现

LB Cluster 负载均衡集群

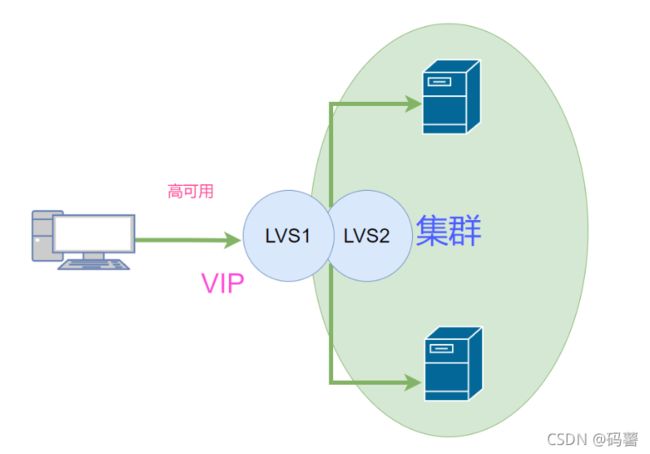

HA 高可用集群实现

Linux Virtual Server简介

LVS介绍

LVS工作原理

LVS集群体系架构

LVS 功能及组织架构

LVS集群类型中的术语

LVS工作模式和相关命令

LVS集群的工作模式

LVS的NAT模式

ipvsadm 工具

ipvsadm 工具选项说明

NAT模式 LVS负载均衡部署

调度服务器

LVS的负载调度算法

DR模式部署

LVS集群(Linux Virtual server)

-

集群概念

-

lvs模型

-

lvs调度算法

-

lvs实现

-

lvs高可用性,负载均衡

集群和分布式

系统性能扩展方式:

-

Scale UP:垂直扩展,向上扩展,增强,性能更强的计算机运行同样的服务

-

Scale Out:水平扩展,向外扩展,增加设备,并行地运行多个服务调度分配问题,Cluster

垂直扩展不再提及:

随着计算机性能的增长,其价格会成倍增长

单台计算机的性能是有上限的,不可能无限制地垂直扩展,多核CPU意味着即使是单台计算机也可以并行的。那么,为什么不一开始就并行化技术?

集群 Cluster

Cluster:集群,为解决某个特定问题将多台计算机组合起来形成的单个系统

Cluster分为三种类型:

-

LB: Load Balancing,负载均衡,多个主机组成,每个主机只承担一部分访问请求

-

HA: High Availiablity,高可用,避免 SPOF(single Point Of failure)

-

HPC: High-performance computing,高性能

MTBF:Mean Time Between Failure 平均无故障时间,正常时间

MTTR:Mean Time To Restoration( repair)平均恢复前时间,故障时间

A = MTBF /(MTBF+MTTR) (0,1):99%,99.5%,99.9%,99.99%,99.999%

SLA:服务等级协议(简称:SLA,全称:service level agreement)。是在一定开销下为保障服

务的性能和可用性,服务提供商与用户间定义的一种双方认可的协定。通常这个开销是驱动提供服

务质量的主要因素。在常规的领域中,总是设定所谓的三个9,四个9来进行表示,当没有达到这

种水平的时候,就会有一些列的惩罚措施,而运维,最主要的目标就是达成这种服务水平。

1年 = 365天 = 8760小时

90 = (1-90%)*365=36.5天

99 = 8760 * 1% = 87.6小时

99.9 = 8760 * 0.1% = 8760 * 0.001 = 8.76小时

99.99 = 8760 * 0.0001 = 0.876小时 = 0.876 * 60 = 52.6分钟

99.999 = 8760 * 0.00001 = 0.0876小时 = 0.0876 * 60 = 5.26分钟

99.9999= (1-99.9999%)*365*24*60*60=31秒

#停机时间又分为两种,一种是计划内停机时间,一种是计划外停机时间,而运维则主要关注计划外停机时间。LVS负载均衡调度算法

#轮询(Round Robin):

将收到的访问请求按照顺序轮流分配给群集中的各节点,均 等地对待每台服务器,而不管服务器实际的连接数和系统负载。

#加权轮询(Weighted Round Robin):

根据调度器设置的权重值来分发请求,权重 值高的节点优先获得任务并且分配的请求越多,这样可以保证性能高的节点承担更 多请求。

#最少连接(Least Connections):

根据真实服务器已建立的连接数进行分配,将收 到的访问请求优先分配给连接数最少的节点。如果所有的服务器节点性能相近,采用这种方式可以更好地均衡负载。

#加权最少连接(Weighted Least Connections):

在服务器节点的性能差异较大的 情况下,调度器可以根据节点服务器负载自动调整权重,权重较高的节点将承担更 大比例的活动连接负载。

#IP_Hash

根据请求来源的IP地址进行Hash计算,得到后端服务器,这样来自同一个IP的请求总是会落到同一台服务器上处理,以致于可以将请求上下文信息存储在这个服务器上,

#url_hash

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。具体没研究过

#fair

采用的不是内建负载均衡使用的轮换的均衡算法,而是可以根据页面大小、加载时间长短智能的进行负载均衡。也就是根据后端服务器时间来分配用户请求,响应时间短的优先分配

分布式系统

分布式存储:Ceph,GlusterFS,FastDFS,MogileFS

分布式计算:hadoop,Spark

分布式常见应用

-

分布式应用-服务按照功能拆分,使用微服务(单一应用程序划分成一组小的服务,服务之间互相协调、互相配合,为用户提供最终价值服务)

-

分布式静态资源--静态资源放在不同的存储集群上

-

分布式数据和存储--使用key-value缓存系统

-

分布式计算--对特殊业务使用分布式计算,比如Hadoop集群

集群和分布式

集群:同一个业务系统,部署在多台服务器上。集群中,每一台服务器实现的功能没有差别,数据和代

码都是一样的。

分布式:一个业务被拆成多个子业务,或者本身就是不同的业务,部署在多台服务器上。分布式中,每

一台服务器实现的功能是有差别的,数据和代码也是不一样的,分布式每台服务器功能加起来,才是完

整的业务。

分布式是以缩短单个任务的执行时间来提升效率的,而集群则是通过提高单位时间内执行的任务数来提升效率。

对于大型网站,访问用户很多,实现一个群集,在前面部署一个负载均衡服务器,后面几台服务器完成

同一业务。如果有用户进行相应业务访问时,负载均衡器根据后端哪台服务器的负载情况,决定由给哪

一台去完成响应,并且一台服务器垮了,其它的服务器可以顶上来。分布式的每一个节点,都完成不同

的业务,如果一个节点垮了,那这个业务可能就会失败集群设计原则

可扩展性—集群的横向扩展能力

可用性—无故障时间 (SLA service level agreement)

性能—访问响应时间

容量—单位时间内的最大并发吞吐量(C10K 并发问题)

集群设计实现

基础设施层面

-

提升硬件资源性能—从入口防火墙到后端 web server 均使用更高性能的硬件资源

-

多域名—DNS 轮询A记录解析

-

多入口—将A记录解析到多个公网IP入口

-

多机房—同城+异地容灾

-

CDN(Content Delivery Network)—基于GSLB(Global Server Load Balance)实现全局负载均衡,如:DNS

业务层面

-

分层:安全层、负载层、静态层、动态层、(缓存层、存储层)持久化与非持久化

-

分割:基于功能分割大业务为小服务

-

分布式:对于特殊场景的业务,使用分布式计算

LB Cluster 负载均衡集群

按实现方式划分

-

硬件

F5 Big-IP(F5服务器负载均衡模块)

Citrix Netscaler

A10 A10

-

软件

lvs:Linux Virtual Server,阿里四层 SLB (Server Load Balance)使用

nginx:支持七层调度,阿里七层SLB使用 Tengine

haproxy:支持七层调度

ats:Apache Traffic Server,yahoo捐助给apache

perlbal:Perl 编写

pound

基于工作的协议层次划分

-

传输层(通用):DNAT 和 DPORT

LVS:

nginx:stream

haproxy:mode tcp

-

应用层(专用):针对特定协议,常称为 proxy server

http:nginx, httpd, haproxy(mode http), ...

fastcgi:nginx, httpd, ...

mysql:mysql-proxy, mycat...

负载均衡的会话保持

-

session sticky:同一用户调度固定服务器

Source IP:LVS sh算法(对某一特定服务而言)

Cookie

-

session replication:每台服务器拥有全部session(复制)

session multicast cluster

-

session server:专门的session服务器(server)

Memcached,Redis

HA 高可用集群实现

keepalived:vrrp协议

Ais:应用接口规范

heartbeat

cman+rgmanager(RHCS)

coresync_pacemaker

Linux Virtual Server简介

LVS介绍

LVS:Linux Virtual Server,负载调度器,内核集成,章文嵩(花名正明), 阿里的四层SLB(Server

Load Balance)是基于LVS+keepalived实现

LVS 官网:http://www.linuxvirtualserver.org/

阿里SLB和LVS:

https://yq.aliyun.com/articles/1803

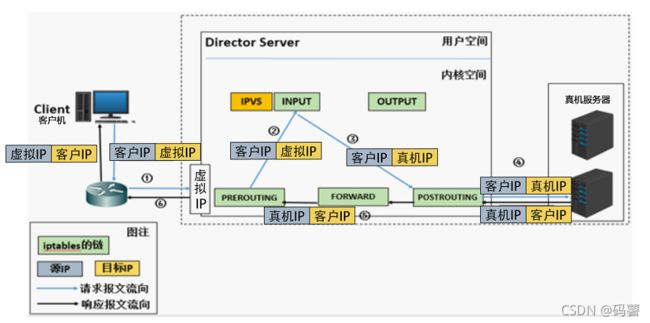

https://github.com/alibaba/LVSLVS工作原理

VS根据请求报文的目标IP和目标协议及端口将其调度转发至某RS,根据调度算法来挑选RS。LVS是内核

级功能,工作在INPUT链的位置,将发往INPUT的流量进行“处理”

[root@localhost ~]#grep -i -C 10 ipvs /boot/config-3.10.0-693.el7.x86_64

CONFIG_NETFILTER_XT_MATCH_CPU=m

CONFIG_NETFILTER_XT_MATCH_DCCP=m

CONFIG_NETFILTER_XT_MATCH_DEVGROUP=m

CONFIG_NETFILTER_XT_MATCH_DSCP=m

CONFIG_NETFILTER_XT_MATCH_ECN=m

CONFIG_NETFILTER_XT_MATCH_ESP=m

CONFIG_NETFILTER_XT_MATCH_HASHLIMIT=m

CONFIG_NETFILTER_XT_MATCH_HELPER=m

CONFIG_NETFILTER_XT_MATCH_HL=m

CONFIG_NETFILTER_XT_MATCH_IPRANGE=m

CONFIG_NETFILTER_XT_MATCH_IPVS=m

CONFIG_NETFILTER_XT_MATCH_LENGTH=m

CONFIG_NETFILTER_XT_MATCH_LIMIT=m

CONFIG_NETFILTER_XT_MATCH_MAC=m

CONFIG_NETFILTER_XT_MATCH_MARK=m

CONFIG_NETFILTER_XT_MATCH_MULTIPORT=m

CONFIG_NETFILTER_XT_MATCH_NFACCT=m

CONFIG_NETFILTER_XT_MATCH_OSF=m

CONFIG_NETFILTER_XT_MATCH_OWNER=m

CONFIG_NETFILTER_XT_MATCH_POLICY=m

CONFIG_NETFILTER_XT_MATCH_PHYSDEV=m

--

CONFIG_IP_SET_HASH_NET=m

CONFIG_IP_SET_HASH_NETPORT=m

CONFIG_IP_SET_HASH_NETIFACE=m

CONFIG_IP_SET_LIST_SET=m

CONFIG_IP_VS=m

CONFIG_IP_VS_IPV6=y

# CONFIG_IP_VS_DEBUG is not set

CONFIG_IP_VS_TAB_BITS=12

#

# IPVS transport protocol load balancing support

#

CONFIG_IP_VS_PROTO_TCP=y

CONFIG_IP_VS_PROTO_UDP=y

CONFIG_IP_VS_PROTO_AH_ESP=y

CONFIG_IP_VS_PROTO_ESP=y

CONFIG_IP_VS_PROTO_AH=y

CONFIG_IP_VS_PROTO_SCTP=y

#

# IPVS scheduler

#

CONFIG_IP_VS_RR=m

CONFIG_IP_VS_WRR=m

CONFIG_IP_VS_LC=m

CONFIG_IP_VS_WLC=m

CONFIG_IP_VS_LBLC=m

CONFIG_IP_VS_LBLCR=m

CONFIG_IP_VS_DH=m

CONFIG_IP_VS_SH=m

CONFIG_IP_VS_SED=m

CONFIG_IP_VS_NQ=m

#

# IPVS SH scheduler

#

CONFIG_IP_VS_SH_TAB_BITS=8

#

# IPVS application helper

#

CONFIG_IP_VS_FTP=m

CONFIG_IP_VS_NFCT=y

CONFIG_IP_VS_PE_SIP=m

#

# IP: Netfilter Configuration

#

CONFIG_NF_DEFRAG_IPV4=m

CONFIG_NF_CONNTRACK_IPV4=m

LVS集群体系架构

LVS集群采用IP负载均衡技术和基于内容请求分发技术。调度器具有很好的吞吐率,将请求均衡地转移到不同的服务器上执行,且调度器自动屏蔽掉服 务器的故障,从而将一组服务器构成一个高性能的、高可用的虚拟服务器。整个服务器集群的结构对客户是透明的,而且无需修改客户端和服务器端的程序。

LVS 功能及组织架构

负载均衡的应用场景为高访问量的业务,提高应用程序的可用性和可靠性。

应用于高访问量的业务

如果您的应用访问量很高,可以通过配置监听规则将流量分发到不同的云服务器 ECS(Elastic

Compute Service 弹性计算服务)实例上。此外,可以使用会话保持功能将同一客户端的请求转发到同

一台后端ECS

扩展应用程序

可以根据业务发展的需要,随时添加和移除ECS实例来扩展应用系统的服务能力,适用于各种Web服务

器和App服务器。

消除单点故障

可以在负载均衡实例下添加多台ECS实例。当其中一部分ECS实例发生故障后,负载均衡会自动屏蔽故

障的ECS实例,将请求分发给正常运行的ECS实例,保证应用系统仍能正常工作

同城容灾 (多可用区容灾)

为了提供更加稳定可靠的负载均衡服务,阿里云负载均衡已在各地域部署了多可用区以实现同地域容

灾。当主可用区出现机房故障或不可用时,负载均衡仍然有能力在非常短的时间内(如:大约30s中

断)切换到另外一个备可用区恢复服务能力;当主可用区恢复时,负载均衡同样会自动切换到主可用区

提供服务。

使用负载均衡时,您可以将负载均衡实例部署在支持多可用区的地域以实现同城容灾。此外,建议您结

合自身的应用需要,综合考虑后端服务器的部署。如果您的每个可用区均至少添加了一台ECS实例,那

么此种部署模式下的负载均衡服务的效率是最高的。

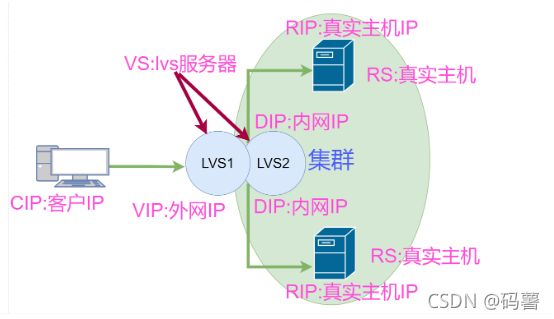

LVS集群类型中的术语

-

VS:Virtual Server,Director Server(DS), Dispatcher(调度器),Load Balancer(lvs服务器)

-

RS:Real Server(lvs), upstream server(nginx), backend server(haproxy)(真实服务器)

-

CIP:Client IP(客户机IP)

-

VIP:Virtual serve IP VS外网的IP

-

DIP:Director IP VS内网的IP

-

RIP:Real server IP (真实IP)

访问流程:CIP <--> VIP == DIP <--> RIP

LVS工作模式和相关命令

LVS集群的工作模式

-

lvs-nat:修改请求报文的目标IP,多目标IP的DNAT

-

lvs-dr:操纵封装新的MAC地址(直接路由)

-

lvs-tun:隧道模式

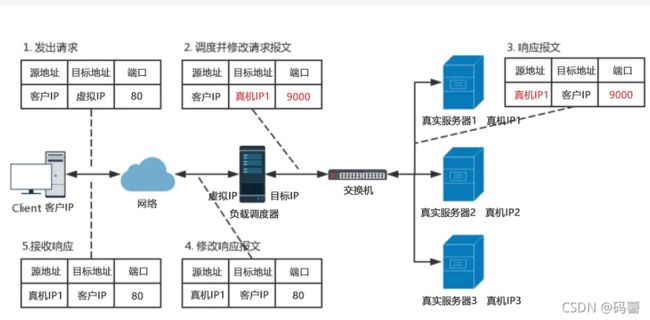

LVS的NAT模式

lvs-nat:本质是多目标IP的DNAT,通过将请求报文中的目标地址和目标端口修改为某处的RS的RIP和

PORT实现转发

(1)RIP和DIP应在同一个IP网络,且应使用私网地址;RS的网关要指向DIP

(2)请求报文和响应报文都必须经由Director转发,Director易于成为系统瓶颈

(3)支持端口映射,可修改请求报文的目标PORT

(4)VS必须是Linux系统,RS可以是任意OS系统

IP隧道

-

RIP和DIP可以不处于同一物理网络中,RS的网关一般不能指向DIP,且RIP可以和公网通信。也就是说集群节点可以跨互联网实现。DIP, VIP, RIP可以是公网地址。

-

RealServer的通道接口上需要配置VIP地址,以便接收DIP转发过来的数据包,以及作为响应的报文源IP。

-

DIP转发给RealServer时需要借助隧道,隧道外层的IP头部的源IP是DIP,目标IP是RIP,而RealServer响应给客户端的IP头部是根据隧道内层的IP头分析得到的,源IP是VIP,目标IP是CIP

-

请求报文要经由Director,但响应不经由Director,响应由RealServer自己完成

-

不支持端口映射

-

RS的OS须支持隧道功能

一般来说,隧道模式常会用来负载调度缓存服务器组,这些缓存服务器一般放置在不同的网络环境,可以就近

折返给客户端。在请求对象不在Cache服务器本地命中的情况下,Cache服务器要向源服务器发送请求,将结

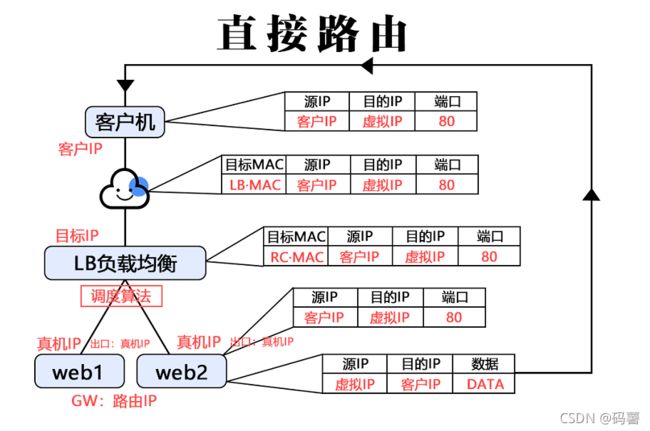

果取回,最后将结果返回给用户。直接路由

直接路由(Direct Routing):简称 DR 模式,采用半开放式的网络结构,与 TUN

模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络。

负载调度器与各节点服务器通过本地网络连接,不需要建立专用的 IP 隧道

直接路由,LVS默认模式,应用最广泛,通过请求报文重新封装一个MAC首部

进行转发,源MAC是DIP所在的接口的MAC,目标MAC是某挑选出的RS的RIP所在接口的MAC地址;源

IP/PORT,以及目标IP/PORT均保持不变

LVS工作模式总结和比较

| NAT | TUN | DR | |

|---|---|---|---|

| 优点 | 端口转换 | WAN | 性能最好 |

| 缺点 | 性能瓶颈 | 服务器支持隧道模式 | 不支持跨网段 |

| 真实服务器要求 | any | Tunneling | Non-arp device |

| 支持网络 | private(私网) | LAN/WAN(私网/公网) | LAN(私网) |

| 真实服务器数量 | low (10~20) | High (100) | High (100) |

| 真实服务器网关 | lvs内网地址 | Own router(网工定义) | Own router(网工定义) |

ipvsadm 工具

ipvsadm 工具选项说明

-A: 添加虚拟服务器

-D: 删除整个虚拟服务器

-s: 指定负载调度算法(轮询: rr、加权轮询: wrr、最少连接: lc、加权最少连接: wlc)

-a: 添加真实服务器(节点服务器)

-d: 删除某一个节点

-t: 指定VIP地址及TCP端口

-r: 指定RIP地址及TCP端口

-m: 表示使用NAT群集模式

-g: 表示使用DR模式

-i: 表示使用TUN模式

一w: 设置权重(权重为0时表示暂停节点)

-p 60: 表示保持长连接60秒

-l: 列表查看 LVS虚拟服务器(默认为查看所有)

-n: 以数字形式显示地址、端口等信息,常与"-l“选项组合使用。ipvsadm -lnNAT模式 LVS负载均衡部署

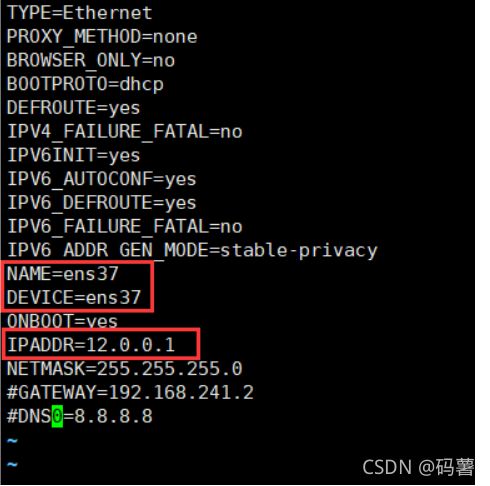

配置环境:

负载调度器:配置双网卡 内网:192.168.91.100(ens33) 外网卡:12.0.0.1(ens37)

二台WEB服务器集群池:192.168.91.101、192.168.91.103

一台NFS共享服务器:192.168.91.105

客户端:部署共享存储(NFS服务器:192.168.241.105)

NFS 是一种基于 TCP/IP 传输的网络文件系统协议,最初由 Sun 公司开发。通过使用 NFS

协议,客户机可以像访问本地目录一样访问远程服务器中的共享资源。对于大多数负载均衡

群集来说,使用 NFS 协议来共享数据存储是比较常见的做法,NFS 也是 NAS 存储设备必然支

持的一种协议。

NFS 服务的实现依赖于 RPC(Remote Process Call,远端过程调用)机制,以完成远程

到本地的映射过程。在 CentOS 7 系统中,需要安装 nfs-utils、rpcbind 软件包来提供 NFS

共享服务,前者用于 NFS 共享发布和访问,后者用于 RPC 支持

[root@localhost ~]#systemctl stop firewalld

[root@localhost ~]#setenforce 0

[root@localhost ~]#yum install nfs-utils rpcbind -y

#安装nfs服务

[root@localhost ~]# systemctl start rpcbind

[root@localhost ~]# systemctl start nfs

#开启服务

[root@localhost ~]#mkdir /opt/kgc /opt/benet

[root@localhost ~]#chmod 777 /opt/kgc/ /opt/benet/

[root@localhost ~]#echo 'this is kgc !' > /opt/kgc/index.html

[root@localhost ~]#echo 'this is benet !' > /opt/benet/index.html

#新建目录,并创建站点文件

[root@localhost ~]#vim /etc/exports

#设置共享策略

/opt/kgc 192.168.241.0/24(rw,sync)

/opt/benet 192.168.241.0/24(rw,sync)

[root@localhost ~]#exportfs -rv

#发布服务

exportfs: duplicated export entries:

exportfs: 192.168.241.0/24:/opt/kgc

exportfs: 192.168.241.0/24:/opt/kgc

exporting 192.168.241.0/24:/opt/kgc

exporting *:/usr/share

[root@localhost ~]# systemctl restart nfs节点服务器

[root@localhost ~]#systemctl stop firewalld

[root@localhost ~]#setenforce 0

[root@localhost ~]#yum install httpd -y

[root@localhost ~]#rpm -qa |grep nfs

[root@localhost ~]#showmount -e 192.168.91.105

#查看nfs服务

Export list for 192.168.91.105:

/opt/benet 192.168.241.0/24

/opt/kgc 192.168.241.0/24

[root@localhost ~]#mount 192.168.241.105:/opt/kgc /var/www/html

#挂载站点

[root@localhost ~]#df

文件系统 1K-块 已用 可用 已用% 挂载点

/dev/mapper/centos-root 10475520 5038360 5437160 49% /

devtmpfs 917600 0 917600 0% /dev

tmpfs 933524 5008 928516 1% /dev/shm

tmpfs 933524 17492 916032 2% /run

tmpfs 933524 0 933524 0% /sys/fs/cgroup

/dev/sda1 5223424 182388 5041036 4% /boot

/dev/sr0 4414592 4414592 0 100% /mnt

tmpfs 186708 40 186668 1% /run/user/0

192.168.241.105:/opt/kgc 10475520 5391104 5084416 52% /var/www/html#第二台

[root@localhost ~]#systemctl stop firewalld

[root@localhost ~]#setenforce 0

[root@localhost ~]#showmount -e 192.168.241.105

Export list for 192.168.241.105:

/opt/benet 192.168.241.0/24

/opt/kgc 192.168.241.0/24

[root@localhost ~]#systemctl start rbcbind

Failed to start rbcbind.service: Unit not found.

[root@localhost ~]#systemctl start rpcbind

[root@localhost ~]#systemctl start nfs

[root@localhost ~]#mount 192.168.241.105:/opt/benet /var/www/html

[root@localhost ~]#df

文件系统 1K-块 已用 可用 已用% 挂载点

/dev/mapper/centos-root 17811456 4749912 13061544 27% /

devtmpfs 917600 0 917600 0% /dev

tmpfs 933524 0 933524 0% /dev/shm

tmpfs 933524 17488 916036 2% /run

tmpfs 933524 0 933524 0% /sys/fs/cgroup

/dev/sda1 1038336 182392 855944 18% /boot

tmpfs 186708 0 186708 0% /run/user/0

tmpfs 186708 12 186696 1% /run/user/42

192.168.241.105:/opt/benet 10475520 5391104 5084416 52% /var/www/html

[root@localhost ~]# vi /etc/fstab

#永久挂载

192.168.241.105:/opt/kgc/ /var/www/html/ nfs defaults,_netdev 0 0

192.168.241.105:/opt/benet/ /var/www/html/ nfs defaults,_netdev 0 0

[root@localhost ~]# mount -a调度服务器

[root@localhost ~]#systemctl stop firewalld

[root@localhost ~]#setenforce 0

添加一个网卡[root@localhost ~]#cd /etc/sysconfig/network-scripts/

[root@localhost network-scripts]#cp ifcfg-ens33 ifcfg-ens37

[root@localhost network-scripts]#vim ifcfg-ens33

#去掉网关

[root@localhost network-scripts]#vim ifcfg-ens37

#去掉网关

systemctl restart network

#重启服务[root@localhost network-scripts]#vim /etc/sysctl.conf

#打开路由转发功能

net.ipv4.ip_forward = 1

[root@localhost network-scripts]#sysctl -p

net.ipv4.ip_forward = 1

#防火墙

[root@localhost network-scripts]#iptables -nL -t nat

#查看策略

[root@localhost network-scripts]#iptables -F

#清空策略

[root@localhost network-scripts]#iptables -t nat -A POSTROUTING -s 192.168.241.0/24 -o ens37 -j SNAT --to 12.0.0.1

#添加策略

[root@localhost network-scripts]#iptables -nL -t nat

#查看策略

Chain PREROUTING (policy ACCEPT)

target prot opt source destination

Chain INPUT (policy ACCEPT)

target prot opt source destination

Chain OUTPUT (policy ACCEPT)

target prot opt source destination

Chain POSTROUTING (policy ACCEPT)

target prot opt source destination

SNAT all -- 192.168.241.0/24 0.0.0.0/0 to:12.0.0.1

[root@localhost network-scripts]#cat /proc/net/ip_vs

[root@localhost network-scripts]#modprobe ip_vs

#加载内核模块

[root@localhost yum.repos.d]#yum install ipvsadm* -y

#安装软件

[root@localhost yum.repos.d]#systemctl start ipvsadm.service

Job for ipvsadm.service failed because the control process exited with error code. See "systemctl status ipvsadm.service" and "journalctl -xe" for details.

/etc/sysconfig/ipvsadm: 没有那个文件或目录

[root@localhost yum.repos.d]#ipvsadm-save >/etc/sysconfig/ipvsadm

#保存配置文件

[root@localhost yum.repos.d]#systemctl start ipvsadm.service

[root@localhost yum.repos.d]#ipvsadm -C

#清空策略

[root@localhost yum.repos.d]#ipvsadm -A -t 12.0.0.1:80 -s rr

#指定IP地址 外网的入口 -s rr 轮询

[root@localhost yum.repos.d]#ipvsadm -a -t 12.0.0.1:80 -r 192.168.241.101:80 -m

#先指定虚拟服务器再添加真实服务器地址,-r:真实服务器地址 -m指定nat模式

[root@localhost yum.repos.d]#ipvsadm -a -t 12.0.0.1:80 -r 192.168.241.103:80 -m

#

[root@localhost yum.repos.d]#ipvsadm

#启动

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP localhost.localdomain:http rr

-> 192.168.241.101:http Masq 1 0 0

-> 192.168.241.103:http Masq 1 0 0

[root@localhost yum.repos.d]#ipvsadm -ln

#查看策略

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 12.0.0.1:80 rr

-> 192.168.241.101:80 Masq 1 0 0

-> 192.168.241.103:80 Masq 1 0 0

时间较长 请耐心等待1分钟后 再刷新LVS的负载调度算法

有四种最常用的:轮询算法(rr)、加权轮询(wrr)、最少轮询(lc)、加权最少轮询(wlc)

1)创建虚拟服务器(注意:NAT模式要两块网卡,调度器的地址是外网口地址)

群集的VIP地址为192.168.80.33,针对TCP 80端口提供负载分流服务,使用的轮询调度算法。对于负载均衡调度器来说,VIP必须是本机实际已启用的IP地址

ipvsadm -A -t 192.168.20.11:80 -s rr

//选项 "-A"表示添加虚拟服务器,"-t"用来指定VIP地址及TCP端口,"-s"用来指定负载调度算法——rr、wrr、lc、wlc

2)添加服务器节点

ipvsadm -a -t 192.168.20.11:80 -r 192.168.80.33:80 -m

ipvsadm -a -t 192.168.20.11:80 -r 192.168.80.44:80 -m//选项 "-a"表示添加真实服务器,"-t"用来指定VIP地址及TCP端口,"-r"用来指定RIP地址及TCP端口,"-m"表示使用NAT群集模式("-g"是DR模式,"-i"是TUN模式)

{ -m参数后面还可以跟-w的参数,这里没有做的"-w"用来设置权重(权重为0时表示暂停节点)}

4)删除服务器节点

ipvsadm -d -r 192.168.90.22:80 -t 192.168.80.88:80//需要从服务器池中删除某一个节点时,使用选项"-d"。执行删除操作必须指定目标对象,包括节点地址、虚拟IP地址。如上所示的操作将会删除LVS群集192.168.80.88中的节点192.168.90.22

若需要删除整个虚拟服务器时,使用选项-D并指定虚拟IP地址即可,无需要指定节点。例如:“ipvsadm -D -t 192.168.80.11:80",则删除此虚拟服务器。

ipvsadm -L //查看节点状态,加个"-n"将以数字形式显示地址、端口信息

ipvsadm-save > /etc/sysconfig/ipvsadm //保存策略

使用导出/导入工具ipvsadm-save/ipvsadm-restore可以保存、恢复LVS策略,方法类似于iptables的规则的导出、导入

DR模式部署

原理解释

客户机发起请求,经过调度服务器(lvs),经过算法调度,去访问真实服务器(RS)

由于不原路返回,客户机不知道,真实主机的ip地址,

所以只能通过调度服务器的外网ip(vip)去反回报文信息。第一次访问完整(不考虑实际问题)

客户端---->外网地址12.0.0.100 12.0.0.100---->客户端

#12.0.0.18-----客户端 客户端会直接丢弃

对每台真实服务器配置外网地址 12.0.0.100

12.0.0.100------>客户端

问题1

IP 地址冲突的

路由器发送ARP请求(广播)

ARP---->广播去找ip地址解析成mac地址

默认使用调度服务器上的外网地址(vip地址)响应,

在真实服务器上修改内核参数

使真实服务器只对自己服务器上的真实IP地址响应ARP解析。

第二次再有访问请求

问题2

路由器上绑定了 真实服务器1的mac信息,

#请求到达真实服务器

在真实服务器上修改内核参数

只对所有服务器真实网卡上的地址进行反馈,解析部署实操

实际操作:

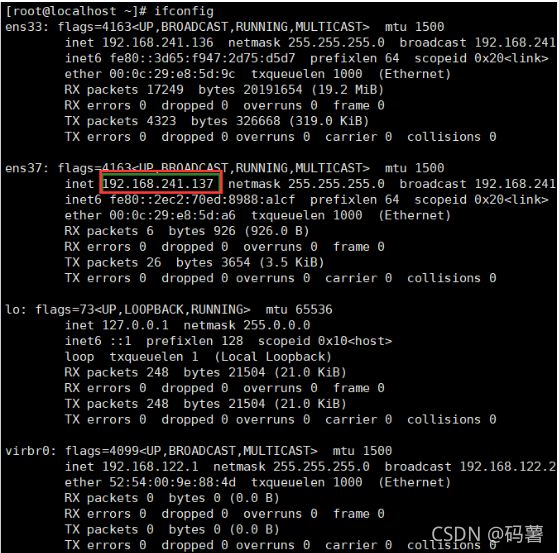

#环境简介

DR 服务器:192.168.241.129

web 服务器1:192.168.241.133

web 服务器2:192.168.241.136

vip(虚拟回环):192.168.241.188

配置DR服务器

1. #关闭防火墙

systemctl stop firewalld.service

setenforce 0

2. #安装ipvsadm工具

yum install ipvsadm.x86_64 -y

3. #配置虚拟IP地址(VIP:192.168.59.188)

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-ens33:0

vim ifcfg-ens33:0

#删除UUID,dns与网关,注意子网

NAME=ens33:0

DEVICE=ens33:0

IPADDR=192.168.59.188

NETMASK=255.255.255.2554. #重启网络服务、启动网卡

systemctl restart network

ifup ifcfg-ens33:0

5. #调整/proc响应参数

#对于 DR 群集模式来说,由于 LVS 负载调度器和各节点需要共用 VIP 地址,应该关闭 Linux 内核的重定向参数响应服务器不是一台路由器,那么它不会发送重定向,所以可以关闭该功能

vi /etc/sysctl.conf

net.ipv4.ip_forward = 0

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

6. #刷新配置

sysctl -p7. #加载模块

modprobe ip_vs

cat /proc/net/ip_vs

8. #配置负载分配策略,并启动服务

ipvsadm-save >/etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

9. #清空ipvsadm,并做策略

##添加真实服务器-a 指定VIP地址及TCP端口-t 指定RIP地址及TCP端口 -r 指定DR模式-g

ipvsadm -C

ipvsadm -A -t 192.168.59.188:80 -s rr

ipvsadm -a -t 192.168.59.188:80 -r 192.168.59.102:80 -g

ipvsadm -a -t 192.168.59.188:80 -r 192.168.59.103:80 -g

10. #保存设置

ipvsadm

ipvsadm -ln

ipvsadm-save >/etc/sysconfig/ipvsadm配置web1(192.168.241.133)

1. #关闭防火墙

systemctl stop firewalld.service

setenforce 0

2. #安装httpd、开启服务

yum install httpd -y

systemctl start httpd

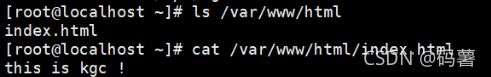

3. #创建一个站点文件

vim /var/www/html/index.html

this is 102

3. #添加回环网卡,修改回环网卡名,IP地址,子网掩码

cd /etc/sysconfig/network-scripts/

cp ifcfg-lo ifcfg-lo:0

vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.59.188

NETMASK=255.255.255.255

NETWORK=127.0.0.0

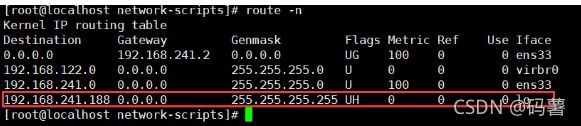

systemctl restart network4. #设置路由

route add -host 192.168.59.188 dev lo:0

route -n5. #开机执行命令

vim /etc/rc.d/rc.local

/usr/sbin/route add -host 192.168.59.188 dev lo:0

chmod +x /etc/rc.d/rc.local

6. #调整 proc 响应参数

#添加系统只响应目的IP为本地IP的ARP请求

#系统不使用原地址来设置ARP请求的源地址,而是物理mac地址上的IP

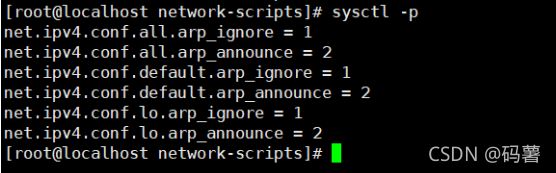

vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

sysctl -p配置web2(192.168.241.136)

1. #关闭防火墙

systemctl stop firewalld.service

setenforce 0

2. #安装httpd、开启服务

yum install httpd -y

systemctl start httpd

3. #创建一个站点文件

vim /var/www/html/index.html

this is 103

3. #添加回环网卡,修改回环网卡名,IP地址,子网掩码

cd /etc/sysconfig/network-scripts/

cp ifcfg-lo ifcfg-lo:0

vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.59.188

NETMASK=255.255.255.255

NETWORK=127.0.0.0

systemctl restart network4. #设置路由

route add -host 192.168.59.188 dev lo:0

route -n5. #开机执行命令

vim /etc/rc.d/rc.local

/usr/sbin/route add -host 192.168.59.188 dev lo:0

chmod +x /etc/rc.d/rc.local

6. #调整 proc 响应参数

#添加系统只响应目的IP为本地IP的ARP请求

#系统不使用原地址来设置ARP请求的源地址,而是物理mac地址上的IP

vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

sysctl -p测试

等一会刷新一下就成功了