使用storcli/storcli64工具配置RAID

storcli

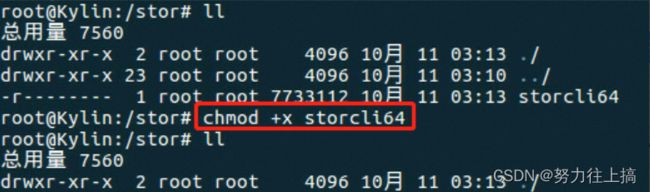

storcli工具上传到服务器任意目录,并使用命令chmod +x storcli64修改文件权限为可执行。

系统下查看Raid卡

[root@localhost:~] lspci | grep LSI

0000:81:00.0 RAID bus controller: Avago (LSI) MegaRAID SAS Invader Controller [vmhba2]

通过命令ln -s /root/storcli64 /usr/bin/storcli来设置软链接,这样后续可以在任意目录下输入storcli执行./ storcli64,和系统命令一样。

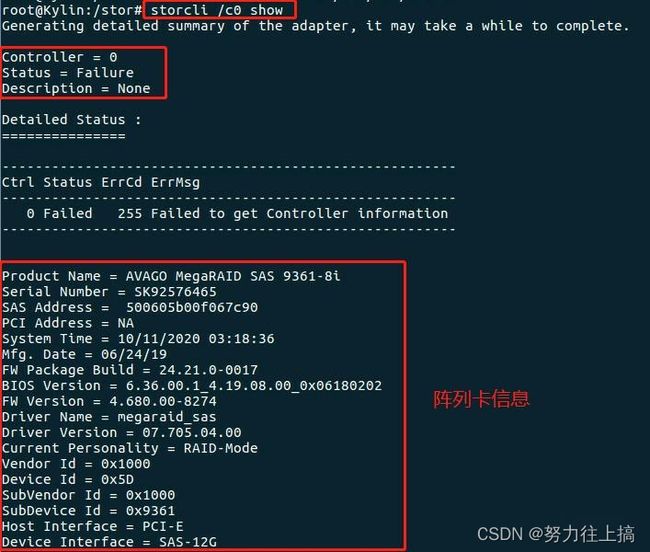

首先使用storcli /c0 show命令查看 RAID 控制器信息,

其中包含磁盘的拓扑结构、RAID信息、物理磁盘配置状态等信息。

注释:

c:Controller,控制器,也就是阵列卡;

e:Enclosure,附件,一般来讲也就是硬盘背板“硬盘笼”;

s:Slot,物理硬盘槽位;

v:Virtual Drive,虚拟硬盘,也就是逻辑卷;

d:Disk Group,硬盘组;

f:Foreign configuration file,外部阵列配置。

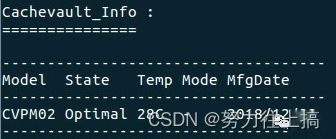

还能看到阵列卡的温度。

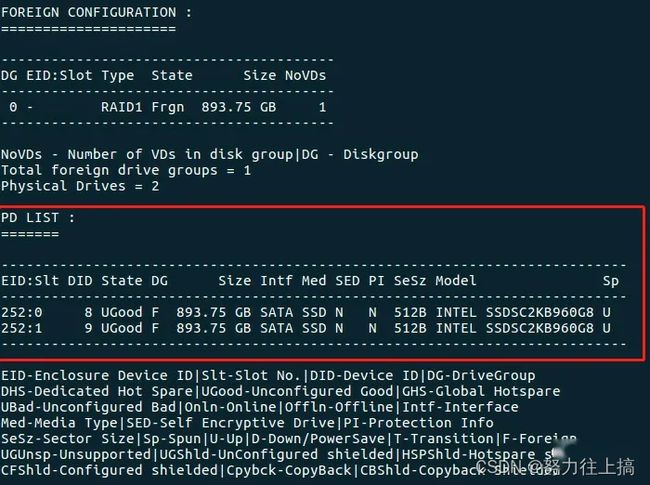

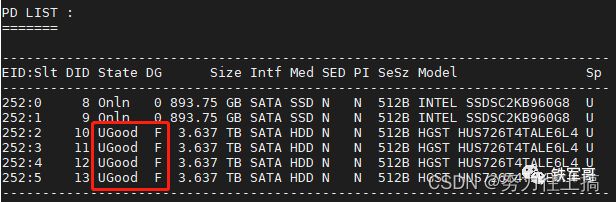

上面是硬盘插槽全空时的回显,在1、2槽位插上两块960G的SSD之后,回显中增加了PD LIST物理磁盘列表,显示如下:

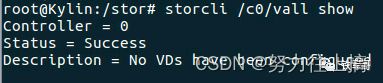

通过命令storcli /c0/vall show来查看RAID逻辑卷的配置情况,当前为未配置RAID。

首次创建RAID

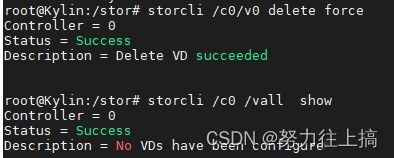

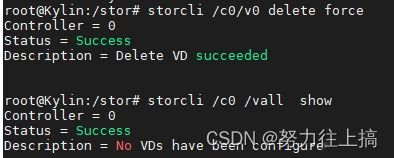

步骤 1:如果原磁盘存在 RAID,需要将 RAID 删除

使用storcli /c0 /vall show命令查看已有的阵列配置信息

如果存在,需要使用storcli /c0 /v0 delete删除相关配置。

如果 vd 包含 MBR 或者用户信息数据,需要加 force 参数强制删除。

步骤 2:创建 RAID

storcli64工具创建RAID的具体使用方法如下:

storcli /cx add vd r[0|1|5|6|00|10|50|60][Size=,,..|all][name=,..]drives=e:s|e:s-x|e:s-x,y[PDperArray=x|auto][SED][pdcache=on|off|default][pi][DimmerSwitch(ds)=default|automatic(auto)|none|maximum(max)|MaximumWithoutCaching(maxnocache)][WT|WB|AWB][nora|ra][direct|cached] [cachevd][Strip=<8|16|32|64|128|256|512|1024>] [AfterVd=X][Spares = [e:]s|[e:]s-x|[e:]s-x,y][force][Cbsize=0|1|2 Cbmode=0|1|2|3|4|7]

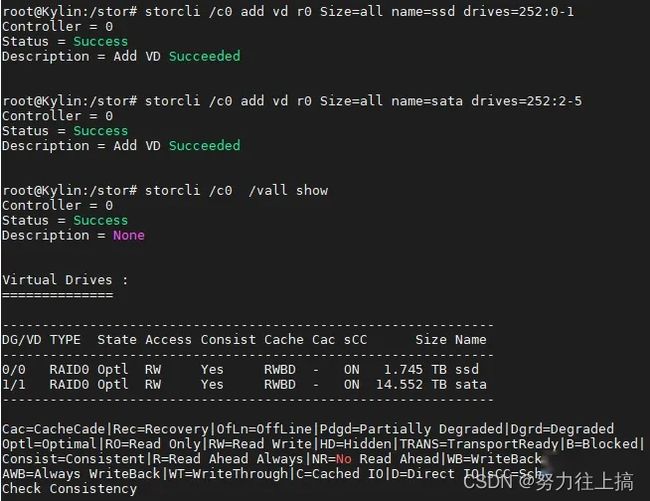

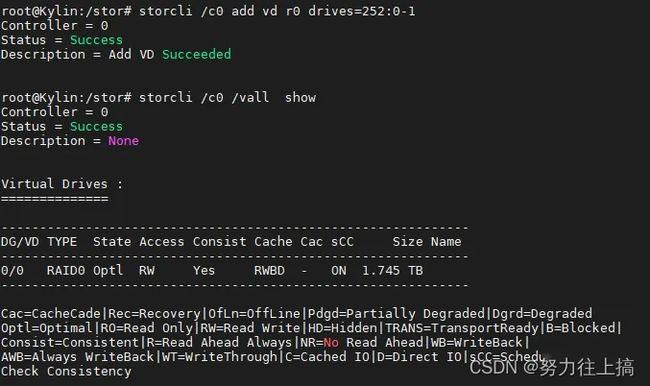

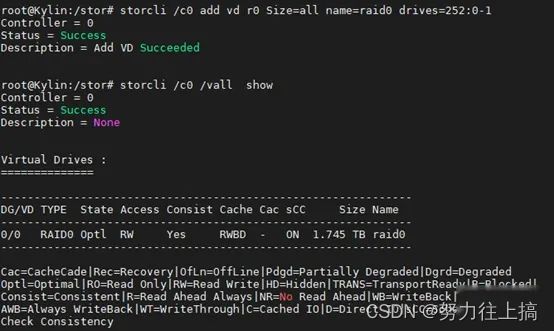

本例中,对1、2操作两个硬盘创建RAID0的操作命令如下:

storcli /c0 add VD r0 drives=252:0,252:1

可以使用该命令直接新建RAID0。

对于一些场景,可能需要使用“Size=all”的配置参数,用于增加磁盘的所有空间到逻辑卷。

还可以通过参数“name=raid0”来指定RAID名称,会在Virtual Drives的Name处显示。

如果配置不想要了,就可以通过storcli /c0/v0 delete force来删除RAID配置。

再新建两组RAID,两块SSD做RAID0,4块SATA盘做raid0,并分别命名。

更换硬盘,重建RAID

实际使用过程中,遇到比较多的就是硬盘故障。介于手头资源有限,一共是2块960G的固态盘,加上4块4T的SATA盘,所以用3块SATA盘做RAID5,另外1块模拟新盘来操作。

首先创建一个3块硬盘的RAID5阵列。

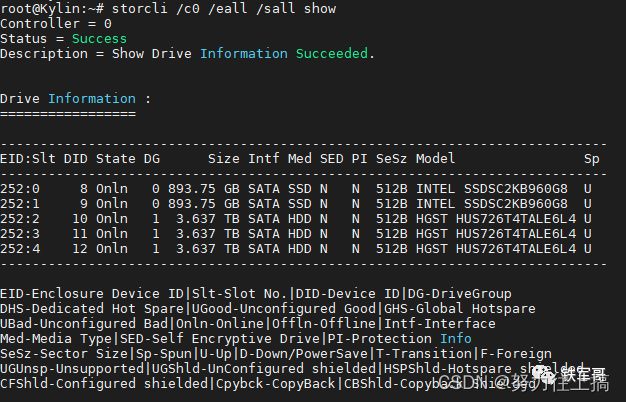

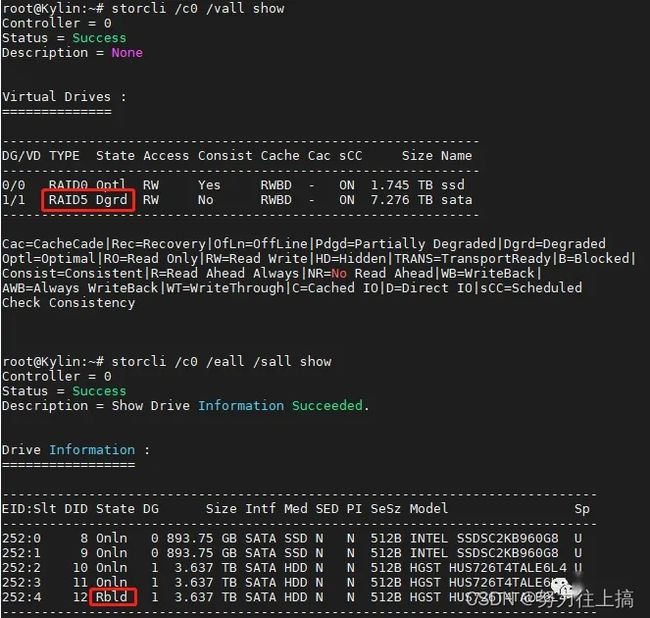

通过命令storcli /c0 /eall /sall show来查看物理磁盘信息。

通过命令storcli /c0 /eall /sall show来查看物理磁盘信息。

磁盘状态描述:

UGood(Unconfigured Good,未配置正常):硬盘状态正常,但还未划分给任何逻辑卷;

UBad(Unconfigured Bad,未配置异常):UGood状态的硬盘出现无法恢复的错误;

Onln(Online,在线):已经设置为某个虚拟硬盘的成员盘,并且处于在线正常可用状态;

Offln(Offline,离线):某个虚拟硬盘的成员盘离线;

Missing,Online状态的硬盘脱离RAID组的状态;

Rbld(Rebuild,重建):硬盘正在重建数据。

拔掉5槽位编号为252:4的硬盘,操作之后使用命令storcli /c0 /vall show来查看阵列信息。发现RAID5阵列状态为Dgrd(degreed,降级),临近故障,参考之前做的硬件RAID测试(硬件RAID横评(上)、硬件RAID横评(下)),RAID5只能接受一块硬盘故障,如果再拔一块盘,则会进入到Failed(故障)状态。

此时,再把备用的6号硬盘作为新盘插到5号槽位,可以看到新插入的磁盘状态为Rbld,正在恢复数据,重建RAID。

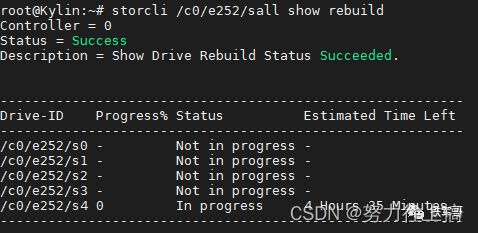

可以通过命令storcli /c0/e252/sall show rebuild 来查看rebuild的进展,不过时间也是真的长,RAID没有数据信息,重建仍然需要4个半小时以上。

删除外部RAID配置

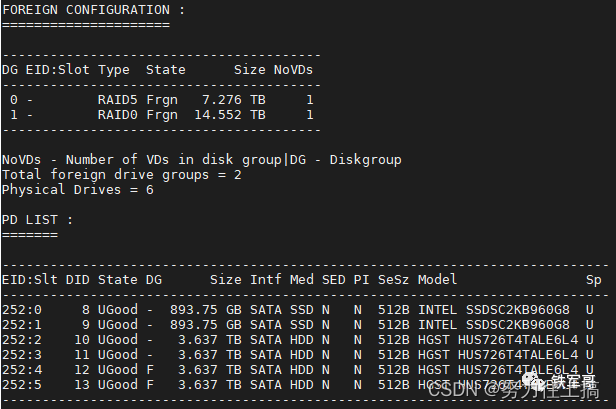

比如在上面的操作中,因为操作顺序问题,5号槽位硬盘曾作为RAID5成员, 6号槽位硬盘曾作为RAID0成员,拔出后保留了之前的RAID相关配置,这部分配置会导致这两块硬盘的DG状态为F(Foreign),无法加入新的虚拟硬盘。

此时,可以使用命令storcli /c0/fall delete删除掉控制器c0的所有外部配置信息,删除后DG状态为空,可以正常使用。

单独替换硬盘

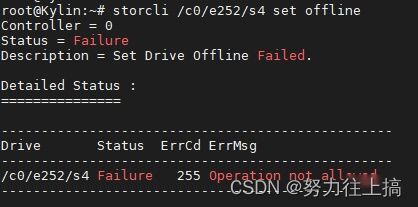

上面操作的是直接替换的场景,如果硬盘仍在使用中,

需要使用命令storcli /c0/e252/s4 set offline将5槽位硬盘设置为离线Offline,

再使用命令storcli /c0/e252/s4 set missing将硬盘设置为missing状态,

之后才可以将原故障硬盘拔出,换上新的硬盘。

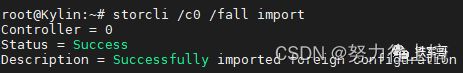

引入外部RAID配置

上面提到了手工指定硬盘状态,对于处于”UBad“状态的硬盘,

可以通过命令storcli /c0 /e252 /s2 set good将其设置为“UGood”状态,方便后续使用。

设置好之后,可以看到硬盘的DG状态显示为F,说明有外部RAID配置。

可以使用命令storcli /c0 show查看外部RAID的详细信息。

此时可以尝试通过命令storcli /c0 /fall import将原有的RAID配置恢复。

再次使用命令storcli /c0 /eall /sall show查看磁盘状态。

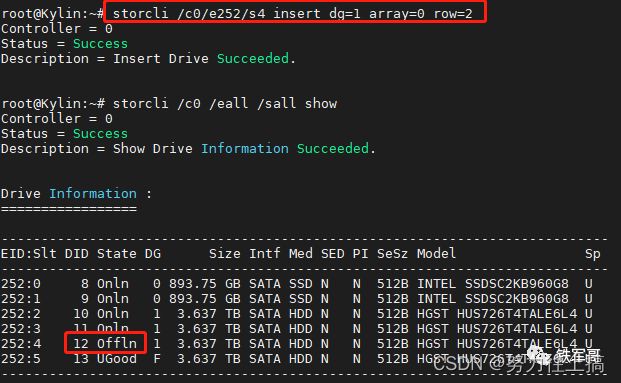

手工重建RAID

如前面操作过程,正常插入新的硬盘之后会自动重建RAID,如果没有自动重建,则需要执行以下操作。

首先确认磁盘位置,从硬盘状态可以看到DG组的值为A,从面板上确认硬盘在第B列、第C行,如硬盘插入到5号槽位,那就是第0列,第2行,对应命令为:storcli /c0 /e252 /s4 insert dg=1 array=0 row=2。

再通过命令storcli /c0/e252/s4 start rebuild来手动触发数据重建,也可以使用pause、resume命令来暂停、继续重建任务。

可以使用命令storcli64 /c0/e252/s4 show rebuild来单独查看4槽位的rebuild进度。

storcli64

1.1 介绍

storcli64可对LSIRAID卡基本操作进行管理,本文主要是对LSIRAID卡常使用到的命令进行介绍

1.2 基本语法

获取控制器号:storcli64 /call show all

/c 控制器号 输出结果中的Controller 值

/v RAID号

/e 背板号 输出结果EID值

/f 外部配置

/s 槽位号 输出结果的Slt值

1.3 系统

查看RAID控制器摘要信息

storcli64 show

查看详细RAID控制器信息

storcli64 show all

查看帮助文档

storcli64 -h

1.4 控制器

查看属性语法:storcli64 /cx show

如查看蜂鸣器状态:strocli64 /c0 show alarm

设置某个属性语法:storcli64 /cx set

如设置蜂鸣器开启:storcli64 /cx set alarm=on

1.5 物理磁盘

可查看磁盘的健康状态,对不健康的磁盘进行替换,设置磁盘状态,设置磁盘初始化,对磁盘进行定位

1.5.1 查看磁盘健康状态

storcli64 -PDList -aALL

对于每块物理磁盘的描述信息,主要关注一下几项:

Slot Number : 表示磁盘的插槽位置,可以根据Slot Number序列值推断是否有磁盘离线

Medai Error Count : 表示磁盘可能错误,可能是磁盘有坏道,这个值不为0值得注意,数值越大,危险系数越高

Other Error Count : 表示磁盘可能存在松动,可能需要重新再插入

Predictive Failure Count : ( 预测性失败统计)

Firmware state : 表示磁盘的状态,可以判断磁盘是否损坏。正常状态是Online, Spun Up

1.5.2 查看磁盘

查看控制器为0 背板为36槽位号为1的磁盘

storcli64 /c0/e36/s1 show

查看控制器0 所有背板及背板上的所有磁盘信息

storcli64 /c0/eall/sall show

查看所有控制器 所有背板 背板上的所有磁盘的详细信息

storcli64 /call/eall/sall show all

1.5.3 设置磁盘状态

设置控制器 0 背板36 槽位号为1的磁盘状态为good

storcli64 /c0/e36/s1 set good

设置控制器 0 背板36 槽位号为1的磁盘状态为offline

storcli64 /c0/e36/s1 set offline

设置控制器为0 背板为36 槽位号为1的磁盘状态为online

storcli64 /c0/e36/s1 set online

1.5.4 磁盘初始化

磁盘在其他系统中使用过磁盘不干净的情况下需对磁盘进行初始化,初始化会清理掉磁盘上的所有数据

查看正在初始化的磁盘

storcli64 /cx/ex/sx show initialization

磁盘开始初始化

storcli64 /cx/ex/sx start initialization

停止磁盘的初始化

storcli64 /cx/ex/sx stop initialization

1.5.5 磁盘定位

开始定位

storcli64 /cx/ex/sx start locate

停止定位

storcli64 /cx/ex/sx stop locate

1.6 RAID

1.6.1 新建RAID

必须含有的参数 RAID类型 RAID大小 RAID名称 和包含的磁盘

storcli64 /cx add RAID r 0|1|5|6|10|50|60 Size=

例子:

使用默认参数创建的RAID5 读策略为ra: Read ahead 写策略wt io策略为direct 条带大小为256

storcli64 /c0 add RAID r5 size=all name=diskarray01 drives=36:15-16,36:18

设置读写策略条带大小的RAID5

storcli64 /c0 add vd r5 size=all name=diskarray01 drives=50:5-7,50:9 awb ra cached strip=256

1.6.2 热备

查看磁盘状态:storcli64 /c0 /eall/sall show 磁盘状态为UGOOD空闲盘,磁盘状态为DHS为专属热备,磁盘状态为GHS为全局热备

添加专属热备

- 获得dgs号 storcli64 /call/vall show 可看到DG及dgs的值为特定的DG配置热备

- 获取空闲磁盘storcli64 /c0 /eall/sall show 磁盘状态为UGOOD

c. 语法storcli64 /cx/ex/sx add hotsparedrive dgs=x

- 例:storcli64 /c0/e3/s6 add hotsparedrive dgs=0 背板为3,槽位为6的磁盘做

dgs为0的RAID的专属热备

添加全局热备

查看空闲磁盘storcli64 /c0 /eall/sall show 磁盘状态为UGOOD

storcli64 /cx/ex/sx add hotsparedrive

如:storcli64 /c0/e3/s6 add hotsparedrive 背板为3,槽位为6的磁盘作为全局热备

删除热备

查看热备盘 storcli64 /c0 /eall/sall show 磁盘状态为DHS,GHS

b. 删除热备盘 storcli /c0/ex/sx delete hotsparedrive

1.6.3 删除RAID

先查看要删除的RAID 查看到对应的VD号 storcli64 /c0/vall show

删除RAID

storcli64 /cx/vx del

例:storcli64 /c0/v1 del 删除虚拟设备号为1的RAID

删除含有用户数据(MBR或者分区信息)的RAID

storcli64 /cx/vx del force

1.6.4 查看RAID

查看控制器上的所有

RAID storcli64 /call/vall show

查看具体的RAID虚拟设备号为1的详细信息

storcli64 /c0/v1 show all

1.6.5 RAID缓存设置

设置写缓存语法:storcli64 /cx/vx set wrcache=wt|wb|awb wt 是关闭缓存wb 在RAID卡没有电池的情况下开启写缓存 awb在RAID卡含有电池的情况下开启写缓存

设置读缓存语法:storcli64 /cx/vx set racache=nora|ra nora不会读缓存里面内容 ra 先读缓存里有的内容

设置io 优先级的语法:storcli64 /cx/vx set iopolicy=direct|cached

开启读缓存

storcli64 /call/v1 set rdcache=ra

开启写缓存

开启写缓存需要先设置IO优先级为缓存 storcli /c0/v1 set iopolicy=cached

storcli64 /call/v1 set wrcache=wb

或者 storcli64 /call/v1 set wrcache=awb

关闭读缓存

storcli64 /call/v1 set rdcache=nora

关闭写缓存

storcli64 /call/v1 set wrcache=wt

1.6.6 RAID初始化

查看快速初始化

storcli64 /cx/vx show init

开启快速初始化

storcli64 /cx/vx start init

开启完全初始化

storcli64 /cx/vx start init full

停止初始化

storcli64 /cx/vx stop init

RAID5(5块以上)和RAID6(6块以上)在进行快速初始化时会转到后台进行初始化

查看后台初始化

storcli64 /cx/vx show bgi

停止初始化

storcli64 /call/v1 stop bgi

挂起初始化

storcli64 /call/v1 suspend bgi

1.6.7 RAID一致性校验

查看初始化

storcli64 /cx/vx show cc

开启初始化

storcli64 /cx/vx start cc

停止初始化

storcli64 /cx/vx stop cc

smartor基本设置下一致性校验 是在特定的时间执行一致性校验,在页面设置即可

LSIRAID卡自带的一致性校验

查看一致性校验执行的具体时间

storcli64 /cx show cc

设置卡自带的一致性校验方式顺序或者并发

storcli64 /cx set consistencycheck=seq|con

关闭卡自带的一致性校验

storcli64 /cx set cc=off

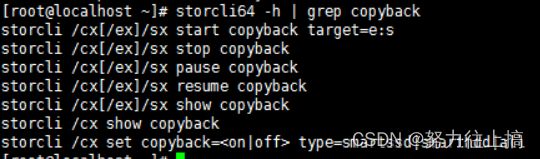

1.6.8 copyback

1.7 日志

storcli64支持的日志

清除所有日志事件

storcli64 /cx clear events

删除TTY(用于故障定位的固件输出信息) 日志

storcli64 /cx delete termlog

将日志信息保存到指定文件

storcli64 /cx show events file=

查看产生日志文件的历史信息

storcli64 /cx show eventloginfo

查看term log 日志配置或者日志信息

storcli64 /cx show termlog type=config|contents

1.8 异常情况

1.8.1 异常断电对初始化影响

RAID0,RAID1,RAID5(小于5块盘)RAID(小于6块盘)RAID10,RAID50,RAID60在重启之后不会再进行初始化

RAID5(5块以上)和RAID6(6块以上)会停止前台初始化,在后台进行初始化,使用命令 storcli64 /c0 show bgi可以查看到

1.8.2 拔盘热备和1块数据盘恢复

将盘插回去 查看磁盘状态 storcli64 /cx/ex/sall show all 磁盘状态为ubad

设置磁盘状态为good storcli64 /c0/ex/sx set good

查看磁盘状态 storcli64 /cx/ex/sx show 磁盘状态为 UGOOD -F

导入磁盘 storcli64 /cx/fall import

查看磁盘状态 storcli64 /cx/ex/sx show 磁盘状态为 UGOOD -

磁盘为可用状态

1.8.3 RAID 以损坏恢复磁盘可用

卸载已损坏raid上建的文件系统:umount …

删除已顺坏raid上的lvm管理映射:

dmsetup remove /dev/p1/* (p1为raid上存储池名)

echo 1 > /sys/block/sdb/device/delete (sdb为实际区下)

删除损坏的raid: storcli64 /cx/vx del

当更换了磁盘,处于UGood状态,需要把磁盘做raid

参考链接:https://www.cnblogs.com/xkus/p/9529995.html

参考连接:https://blog.csdn.net/weixin_42595012/article/details/124701806

https://blog.csdn.net/wxt_hunxiaozi/article/details/122882526