ADPRL - 近似动态规划和强化学习 - Note 8 - 近似策略迭代 (Approximate Policy Iteration)

Note 8 近似策略迭代 Approximate Policy Iteration

近似策略迭代

- Note 8 近似策略迭代 Approximate Policy Iteration

-

- 8.1 通用框架 (A Generic Framework)

-

-

- Lemma 8.1 单调性下的误差约束(Error bound under monotonicity)

- Lemma 8.2 单一近似PI扫描的误差边界 (Error bound of single approximate PI sweep)

- Proposition 8.1 近似PI算法的误差边界 (Error bound of the approximate PI algorithm)

- Proposition 8.2 策略空间收敛下近似PI的误差界线 (Error bounds of approximate PI under convergence in policy space)

-

- 8.2 近似策略评估 (Approximate Policy Evaluation)

-

-

- 定义8.1 近似总成本函数

- Lemma 8.3 近似成本函数的边界

- Proposition 8.3 估计值与真实总成本函数之间的约束

-

- 8.3 近似的策略评估与遍历性 Approximate Policy Evaluation with Ergodicity

-

- 8.3.1 各态历经的MDP(Ergodic MDP)

-

- Assumption 8.1 过渡矩阵 P π P_{\pi} Pπ的各态历经性

- Lemma 8.4 ξ \xi ξ加权范数

- Proposition 8.4 ξ \xi ξ加权范数下的贝尔曼算子的收缩性

- Lemma 8.5 ξ \xi ξ加权范数下的边界

- Proposition 8.5 ξ \xi ξ加权范数下的估计值与真实总成本函数之间的约束

- 8.3.2 平均平方预测贝尔曼误差 (Mean Squared Projected Bellman Error)

-

- Lemma 8.6 非扩张性投影算子 Π Φ \Pi_{\Phi} ΠΦ

- Proposition 8.6. 投影算子 Π Φ \Pi_{\Phi} ΠΦ的收缩性

- Proposition 8.7.

- 8.4 API 补充

-

- 8.4.1 Approximate PI (API)

- 8.4.2 APE via Bellman Residual Minimisation

- 8.4.3 ℓ 2 \ell_{2} ℓ2 Based Bellman Residual Minimisation

- 8.4.4 Recap: Closed form policy evaluation

- 8.4.5 ℓ 2 \ell_{2} ℓ2 Based Bellman Residual Minimisation

- 8.4.6 Approximate PI (API) with LFA + MSBE

- 8.4.7 Approximate PI (API) with LFA + ξ -weighted MSBE \text { Approximate PI (API) with LFA }+\xi \text {-weighted MSBE } Approximate PI (API) with LFA +ξ-weighted MSBE

- 8.4.8 Mean Squared Projected Bellman Error (MSPBE)

- 8.4.9 Approximate PI (API) with LFA + ξ \xi ξ-weighted MSPBE

- 8.4.10 Approximate PI Summary

在Note 7 中,我们介绍了参数化函数近似的概念,以及它在近似值迭代算法中的应用。尽管AVI的收敛特性已被证明是有希望的,但它与原始 V I VI VI算法的内在限制仍然存在。在本节中,我们开发了一个近似策略迭代算法的框架。

8.1 通用框架 (A Generic Framework)

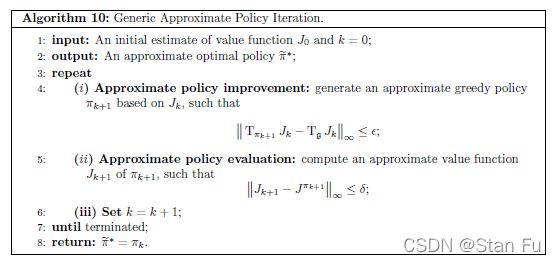

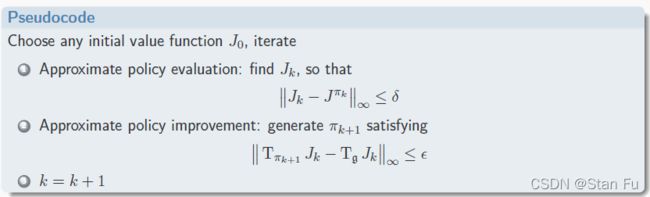

与近似的VI算法类似,我们可以构建一个体系来近似策略评估和策略改进步骤,具体如下

-

对于一个给定的策略 π k \pi_{k} πk,我们的目标是找到真实总成本 J π k J^{\pi_{k}} Jπk的近似值 J k J_{k} Jk,即

∥ J k − J π k ∥ ∞ ≤ δ (8.1) \left\|J_{k}-J^{\pi_{k}}\right\|_{\infty} \leq \delta \tag{8.1} ∥Jk−Jπk∥∞≤δ(8.1)

请注意,真正的总成本 J π k J^{\pi_{k}} Jπk 在一般情况下是无法给定的。这里可以采用贝尔曼残差最小化的思想。 -

通过采用与公式( 7.31 7.31 7.31 )中近似贪婪化步骤相同的策略,我们也可以将其放宽为近似策略改进。也就是说,给定第 k k k个价值函数估计值 J k J_{k} Jk,我们找到一个策略 π k + 1 \pi_{k+1} πk+1,满足以下条件

∥ T π k + 1 J k − T g J k ∥ ∞ ≤ ϵ , (8.2) \left\|\mathrm{T}_{\pi_{k+1}} J_{k}-\mathrm{T}_{\mathfrak{g}} J_{k}\right\|_{\infty} \leq \epsilon, \tag{8.2} ∥Tπk+1Jk−TgJk∥∞≤ϵ,(8.2)

其中 ϵ > 0 \epsilon>0 ϵ>0是不严格策略改进(inexact policy improvement)的准确性。

为了确定近似PI算法的误差界限,我们需要以下两个引理(Lemma)。

Lemma 8.1 单调性下的误差约束(Error bound under monotonicity)

给出一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ},和一个固定的策略 π \pi π。让 J ∈ R K J \in \mathbb{R}^{K} J∈RK中,满足以下条件

T π J ≤ J + c 1 (8.3) \mathrm{T}_{\pi} J \leq J+c \mathbf{1} \tag{8.3} TπJ≤J+c1(8.3)

且有 c > 0 c>0 c>0,那么策略 π \pi π的总成本函数就有如下的约束

J π ≤ J + c 1 − γ 1 (8.4) J^{\pi} \leq J+\frac{c}{1-\gamma} \mathbf{1} \tag{8.4} Jπ≤J+1−γc1(8.4)

Proof.

贝尔曼算子 T π \mathrm{T}_{\pi} Tπ的恒定位移属性意味着对于所有 k ∈ N k \in \mathbb{N} k∈N来说

T π k J ≤ T π k − 1 J + γ k − 1 c 1 (8.5) \mathrm{T}_{\pi}^{k} J \leq \mathrm{T}_{\pi}^{k-1} J+\gamma^{k-1} c \mathbf{1} \tag{8.5} TπkJ≤Tπk−1J+γk−1c1(8.5)

然后我们对任意 k k k构建

T π k J − J = T π k J − T π k − 1 J + T π k − 1 J − … + T π J − J = ∑ t = 1 k ( T π k J − T π k − 1 J ) ≤ ∑ t = 1 k γ t − 1 c 1 (8.6) \begin{aligned} \mathrm{T}_{\pi}^{k} J-J &=\mathrm{T}_{\pi}^{k} J-\mathrm{T}_{\pi}^{k-1} J+\mathrm{T}_{\pi}^{k-1} J-\ldots+\mathrm{T}_{\pi} J-J \\ &=\sum_{t=1}^{k}\left(\mathrm{~T}_{\pi}^{k} J-\mathrm{T}_{\pi}^{k-1} J\right) \\ & \leq \sum_{t=1}^{k} \gamma^{t-1} c \mathbf{1} \end{aligned} \tag{8.6} TπkJ−J=TπkJ−Tπk−1J+Tπk−1J−…+TπJ−J=t=1∑k( TπkJ−Tπk−1J)≤t=1∑kγt−1c1(8.6)

结果是通过 t → ∞ t\rightarrow\infty t→∞而得出的。

Lemma 8.2 单一近似PI扫描的误差边界 (Error bound of single approximate PI sweep)

给定一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ},一个固定的策略 π \pi π,一个在 R K \mathbb{R}^{K} RK中的估计值 J J J,以及两个固定的策略 π \pi π和 π ′ \pi^{\prime} π′,如果以下两个条件在某些 δ ≥ 0 \delta\geq 0 δ≥0和 ϵ ≥ 0 \epsilon\geq 0 ϵ≥0时成立

∥ J − J π ∥ ∞ ≤ δ , and ∥ T π ′ J − T g J ∥ ∞ ≤ ϵ (8.7) \left\|J-J^{\pi}\right\|_{\infty} \leq \delta, \quad \text { and } \quad\left\|\mathrm{T}_{\pi^{\prime}} J-\mathrm{T}_{\mathfrak{g}} J\right\|_{\infty} \leq \epsilon \tag{8.7} ∥J−Jπ∥∞≤δ, and ∥Tπ′J−TgJ∥∞≤ϵ(8.7)

然后我们有

∥ J π ′ − J ∗ ∥ ∞ ≤ γ ∥ J π − J ∗ ∥ ∞ + ϵ + 2 γ δ 1 − γ (8.8) \left\|J^{\pi^{\prime}}-J^{*}\right\|_{\infty} \leq \gamma\left\|J^{\pi}-J^{*}\right\|_{\infty}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \tag{8.8} ∥∥∥Jπ′−J∗∥∥∥∞≤γ∥Jπ−J∗∥∞+1−γϵ+2γδ(8.8)

Proof.

根据 T g \mathrm{T}_{\mathfrak{g}} Tg和 T π ′ \mathrm{T}_{\pi^{\prime}} Tπ′的收缩特性,公式(8.7)中的第一个不等式意味着

∥ T π ′ J − T π ′ J π ∥ ∞ ≤ γ δ , and ∥ T g J − T g J π ∥ ∞ ≤ γ δ (8.9) \left\|\mathrm{T}_{\pi^{\prime}} J-\mathrm{T}_{\pi^{\prime}} J^{\pi}\right\|_{\infty} \leq \gamma \delta, \quad \text { and } \quad\left\|\mathrm{T}_{\mathfrak{g}} J-\mathrm{T}_{\mathfrak{g}} J^{\pi}\right\|_{\infty} \leq \gamma \delta \tag{8.9} ∥Tπ′J−Tπ′Jπ∥∞≤γδ, and ∥TgJ−TgJπ∥∞≤γδ(8.9)

因此

T π ′ J π ≤ T π ′ J + γ δ 1 , and T g J − T g J π ≤ γ δ 1 (8.10) \mathrm{T}_{\pi^{\prime}} J^{\pi} \leq \mathrm{T}_{\pi^{\prime}} J+\gamma \delta \mathbf{1}, \quad \text { and } \quad \mathrm{T}_{\mathfrak{g}} J-\mathrm{T}_{\mathfrak{g}} J^{\pi} \leq \gamma \delta \mathbf{1} \tag{8.10} Tπ′Jπ≤Tπ′J+γδ1, and TgJ−TgJπ≤γδ1(8.10)

类似地,由公式(8.7)中的第二个不等式得出

T π ′ J ≤ T g J + ϵ 1 (8.11) \mathrm{T}_{\pi^{\prime}} J \leq \mathrm{T}_{\mathfrak{g}} J+\epsilon \mathbf{1} \tag{8.11} Tπ′J≤TgJ+ϵ1(8.11)

然后我们得到

T π ′ J π ≤ T π ′ J + γ δ 1 ≤ T g J + ( ϵ + γ δ ) 1 ≤ T g J π + ( ϵ + 2 γ δ ) 1 ≤ J π + ( ϵ + 2 γ δ ) 1 (8.12) \begin{aligned} \mathrm{T}_{\pi^{\prime}} J^{\pi} & \leq \mathrm{T}_{\pi^{\prime}} J+\gamma \delta \mathbf{1} \\ & \leq \mathrm{T}_{\mathfrak{g}} J+(\epsilon+\gamma \delta) \mathbf{1} \\ & \leq \mathrm{T}_{\mathfrak{g}} J^{\pi}+(\epsilon+2 \gamma \delta) \mathbf{1} \\ & \leq J^{\pi}+(\epsilon+2 \gamma \delta) \mathbf{1} \end{aligned} \tag{8.12} Tπ′Jπ≤Tπ′J+γδ1≤TgJ+(ϵ+γδ)1≤TgJπ+(ϵ+2γδ)1≤Jπ+(ϵ+2γδ)1(8.12)

其中,第二个不等式是由于公式(8.11),第三个不等式由公式(8.10)中的第二个不等式得出,最后一个不等式是由于 T g \mathrm{T}_{\mathfrak{g}} Tg的策略改进属性,即 T g J π ≤ T π J π = J π \mathrm{T}_{\mathfrak{g}} J^{\pi} \leq \mathrm{T}_{\pi} J^{\pi}=J^{\pi} TgJπ≤TπJπ=Jπ

根据Lemma 8.1,我们有

J π ′ ≤ J π + ϵ + 2 γ δ 1 − γ 1 (8.13) J^{\pi^{\prime}} \leq J^{\pi}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} 1 \tag{8.13} Jπ′≤Jπ+1−γϵ+2γδ1(8.13)

并进一步将贝尔曼算子 T π ′ T_{\pi^{\prime}} Tπ′应用于不等式的两边,去得到

T π ′ J π ′ = J π ′ ≤ T π ′ J π + ϵ + 2 γ δ 1 − γ γ 1. (8.14) \mathrm{T}_{\pi^{\prime}} J^{\pi^{\prime}}=J^{\pi^{\prime}} \leq \mathrm{T}_{\pi^{\prime}} J^{\pi}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \gamma \mathbf{1} . \tag{8.14} Tπ′Jπ′=Jπ′≤Tπ′Jπ+1−γϵ+2γδγ1.(8.14)

从不等式的两边减去 J ∗ J^{*} J∗,我们得到

J π ′ − J ∗ ≤ T π ′ J π − J ∗ + ϵ + 2 γ δ 1 − γ γ 1 ≤ T g J π + ( ϵ + 2 γ δ ) 1 − J ∗ + ϵ + 2 γ δ 1 − γ γ 1 = T g J π − T g J ∗ + ϵ + 2 γ δ 1 − γ 1 (8.15) \begin{aligned} J^{\pi^{\prime}}-J^{*} & \leq \mathrm{T}_{\pi^{\prime}} J^{\pi}-J^{*}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \gamma \mathbf{1} \\ & \leq \mathrm{T}_{\mathfrak{g}} J^{\pi}+(\epsilon+2 \gamma \delta) \mathbf{1}-J^{*}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \gamma \mathbf{1} \\ &=\mathrm{T}_{\mathfrak{g}} J^{\pi}-\mathrm{T}_{\mathfrak{g}} J^{*}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \mathbf{1} \end{aligned} \tag{8.15} Jπ′−J∗≤Tπ′Jπ−J∗+1−γϵ+2γδγ1≤TgJπ+(ϵ+2γδ)1−J∗+1−γϵ+2γδγ1=TgJπ−TgJ∗+1−γϵ+2γδ1(8.15)

其中,第二个不等式由公式(8.12)中的第三个不等式得出,而平等则是由于最优贝尔曼算子 T g \mathrm{T}_{\mathfrak{g}} Tg的唯一固定点。最后,我们对公式(8.15)应用无穷范数

∥ J π ′ − J ∗ ∥ ∞ ≤ ∥ T g J π − T g J ∗ ∥ ∞ + ϵ + 2 γ δ 1 − γ ≤ γ ∥ J π − J ∗ ∥ ∞ + ϵ + 2 γ δ 1 − γ (8.16) \begin{aligned} \left\|J^{\pi^{\prime}}-J^{*}\right\|_{\infty} & \leq\left\|\mathrm{T}_{\mathfrak{g}} J^{\pi}-\mathrm{T}_{\mathfrak{g}} J^{*}\right\|_{\infty}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \\ & \leq \gamma\left\|J^{\pi}-J^{*}\right\|_{\infty}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \end{aligned} \tag{8.16} ∥∥∥Jπ′−J∗∥∥∥∞≤∥TgJπ−TgJ∗∥∞+1−γϵ+2γδ≤γ∥Jπ−J∗∥∞+1−γϵ+2γδ(8.16)

这就完成了证明。

最后,我们总结出近似PI算法的误差边界如下。

Proposition 8.1 近似PI算法的误差边界 (Error bound of the approximate PI algorithm)

给定一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ},由近似PI方法产生的 π k \pi_{k} πk序列满足以下条件

lim k → ∞ ∥ J π k − J ∗ ∥ ∞ ≤ ϵ + 2 γ δ ( 1 − γ ) 2 . (8.17) \lim _{k \rightarrow \infty}\left\|J^{\pi_{k}}-J^{*}\right\|_{\infty} \leq \frac{\epsilon+2 \gamma \delta}{(1-\gamma)^{2}} . \tag{8.17} k→∞lim∥Jπk−J∗∥∞≤(1−γ)2ϵ+2γδ.(8.17)

Proof.

给定一个任意的 π 0 \pi_{0} π0,Lemma 8.2 8.2 8.2意味着

∥ J π 1 − J ∗ ∥ ∞ ≤ γ ∥ J π 0 − J ∗ ∥ ∞ + ϵ + 2 γ δ 1 − γ (8.18) \left\|J^{\pi_{1}}-J^{*}\right\|_{\infty} \leq \gamma\left\|J^{\pi_{0}}-J^{*}\right\|_{\infty}+\frac{\epsilon+2 \gamma \delta}{1-\gamma} \tag{8.18} ∥Jπ1−J∗∥∞≤γ∥Jπ0−J∗∥∞+1−γϵ+2γδ(8.18)

通过直接的归纳论证,对于任意的 k k k,可以得出

∥ J π k − J ∗ ∥ ∞ ≤ γ k ∥ J π 0 − J ∗ ∥ ∞ + ( ∑ i = 0 k − 1 γ i ) ϵ + 2 γ δ 1 − γ (8.19) \left\|J^{\pi_{k}}-J^{*}\right\|_{\infty} \leq \gamma^{k}\left\|J^{\pi_{0}}-J^{*}\right\|_{\infty}+\left(\sum_{i=0}^{k-1} \gamma^{i}\right) \frac{\epsilon+2 \gamma \delta}{1-\gamma} \tag{8.19} ∥Jπk−J∗∥∞≤γk∥Jπ0−J∗∥∞+(i=0∑k−1γi)1−γϵ+2γδ(8.19)

结果是通过令 k → ∞ k\rightarrow\infty k→∞得出的。

需要注意的是,由近似PI算法产生的策略的误差范围不能保证在策略空间内收敛。也就是说,近似PI算法可以在一组策略中摇摆,见图14。

图14:近似PI算法的潜在收敛模式说明。当误差约束宽松时,近似PI算法产生的策略可能会在几个候选者中摇摆,例如 { π 1 , π 2 , π 3 , π 4 } . \left\{\pi_{1}, \pi_{2}, \pi_{3}, \pi_{4}\right\}. {π1,π2,π3,π4}. 当误差约束足够严格时,产生的策略可能会收敛到一个定值,例如 π 1 \pi_{1} π1。

然而,在某些情况下,该算法可以收敛到一个单一的策略。在Note的其余部分,我们确定了策略收敛时近似PI算法的误差边界。

Proposition 8.2 策略空间收敛下近似PI的误差界线 (Error bounds of approximate PI under convergence in policy space)

给定一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ},让 π ′ \pi^{\prime} π′作为近似PI算法收敛的策略。那么我们有

∥ J π ′ − J ∗ ∥ ∞ ≤ ϵ + 2 γ δ 1 − γ (8.20) \left\|J^{\pi^{\prime}}-J^{*}\right\|_{\infty} \leq \frac{\epsilon+2 \gamma \delta}{1-\gamma} \tag{8.20} ∥∥∥Jπ′−J∗∥∥∥∞≤1−γϵ+2γδ(8.20)

Proof.

让 J ′ ∈ R K J^{\prime} \in \mathbb{R}^{K} J′∈RK是由 π ′ \pi^{\prime} π′的近似策略评估产生的策略,即 J ′ J^{\prime} J′和 π ′ \pi^{\prime} π′满足近似PI算法的条件

∥ J ′ − J π ′ ∥ ∞ ≤ δ , and ∥ T π ′ J ′ − T g J ′ ∥ ∞ ≤ ϵ . (8.21) \left\|J^{\prime}-J^{\pi^{\prime}}\right\|_{\infty} \leq \delta, \quad \text { and }\left\|\mathrm{T}_{\pi^{\prime}} J^{\prime}-\mathrm{T}_{\mathfrak{g}} J^{\prime}\right\|_{\infty} \leq \epsilon \text {. } \tag{8.21} ∥∥∥J′−Jπ′∥∥∥∞≤δ, and ∥Tπ′J′−TgJ′∥∞≤ϵ. (8.21)

那么,我们有

∥ T g J π ′ − J π ′ ∥ ∞ ≤ ∥ T g J π ′ − T g J ′ ∥ ∞ + ∥ T g J ′ − T π ′ J ′ ∥ ∞ + + ∥ T π ′ J ′ − J π ′ ∥ ∞ ≤ γ ∥ J π ′ − J ′ ∥ ∞ + ∥ T g J ′ − T π ′ J ′ ∥ ∞ + + γ ∥ J ′ − J π ′ ∥ ∞ ≤ ϵ + 2 γ δ (8.22) \begin{aligned} \left\|\mathrm{T}_{\mathfrak{g}} J^{\pi^{\prime}}-J^{\pi^{\prime}}\right\|_{\infty} \leq &\left\|\mathrm{T}_{\mathfrak{g}} J^{\pi^{\prime}}-\mathrm{T}_{\mathfrak{g}} J^{\prime}\right\|_{\infty}+\left\|\mathrm{T}_{\mathfrak{g}} J^{\prime}-\mathrm{T}_{\pi^{\prime}} J^{\prime}\right\|_{\infty}+\\ &+\left\|\mathrm{T}_{\pi^{\prime}} J^{\prime}-J^{\pi^{\prime}}\right\|_{\infty} \\ \leq & \gamma\left\|J^{\pi^{\prime}}-J^{\prime}\right\|_{\infty}+\left\|\mathrm{T}_{\mathfrak{g}} J^{\prime}-\mathrm{T}_{\pi^{\prime}} J^{\prime}\right\|_{\infty}+\\ &+\gamma\left\|J^{\prime}-J^{\pi^{\prime}}\right\|_{\infty} \\ \leq & \epsilon+2 \gamma \delta \end{aligned} \tag{8.22} ∥∥∥TgJπ′−Jπ′∥∥∥∞≤≤≤∥∥∥TgJπ′−TgJ′∥∥∥∞+∥TgJ′−Tπ′J′∥∞++∥∥∥Tπ′J′−Jπ′∥∥∥∞γ∥∥∥Jπ′−J′∥∥∥∞+∥TgJ′−Tπ′J′∥∞++γ∥∥∥J′−Jπ′∥∥∥∞ϵ+2γδ(8.22)

其中,第一个不等式来自无穷范数的三角形性质,第二个不等式是由于 T g \mathrm{T}_{\mathfrak{g}} Tg和 T π ′ \mathrm{T}_{\pi^{\prime}} Tπ′的收缩性质,而最后一个不等式仅仅回顾了公式(8.21)中的结果。那么,公式(8.20)中的不等式是对Lemma 3.4的直接应用。

显然,稳定收敛下的近似PI算法的误差界限比被发散的情况要严格得多,特别是当折扣系数 γ \gamma γ接近1时。

8.2 近似策略评估 (Approximate Policy Evaluation)

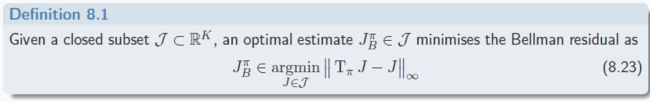

对通用API的收敛特性的分析表明了近似策略评价的性能的重要性。类似于开发AVI的最小化贝尔曼残差的策略也可以应用于策略评估。

定义8.1 近似总成本函数

给定一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},一个固定的策略 π \pi π和一个总成本函数空间 J \mathcal{J} J,总成本函数 J ∈ J J \in \mathcal{J} J∈J的近似总成本函数 J π J^{\pi} Jπ是通过最小化贝尔曼残差给出的,即

J B π ∈ argmin J ∈ J ∥ T π J − J ∥ ∞ . (8.23) J_{B}^{\pi} \in \underset{J \in \mathcal{J}}{\operatorname{argmin}}\left\|\mathrm{T}_{\pi} J-J\right\|_{\infty} . \tag{8.23} JBπ∈J∈Jargmin∥TπJ−J∥∞.(8.23)

通过最小化Bellman残差误差,估计 J B π J_{B}^{\pi} JBπ的误差边界如下。

Lemma 8.3 近似成本函数的边界

给定一个无限范围 M D P { X , U , p , q , γ } M D P\{\mathcal{X}, \mathcal{U}, p, q, \gamma\} MDP{X,U,p,q,γ},让 J π J^{\pi} Jπ为固定的策略 π \pi π的总成本函数。那么,对于任何总成本函数 J ∈ R K J\in \mathbb{R}^{K} J∈RK中,以下不等式成立

∥ J − J π ∥ ∞ ≤ 1 1 − γ ∥ J − T π J ∥ ∞ . (8.24) \left\|J-J^{\pi}\right\|_{\infty} \leq \frac{1}{1-\gamma}\left\|J-\mathrm{T}_{\pi} J\right\|_{\infty} . \tag{8.24} ∥J−Jπ∥∞≤1−γ1∥J−TπJ∥∞.(8.24)

Proof.

直接的有

∥ J − J π ∥ ∞ = ∥ J − T π J + T π J − J π ∥ ∞ = ∥ J − T π J ∥ ∞ + ∥ T π J − J π ∥ ∞ ≤ ∥ J − T π J ∥ ∞ + γ ∥ J − J π ∥ ∞ (8.25) \begin{aligned} \left\|J-J^{\pi}\right\|_{\infty} &=\left\|J-\mathrm{T}_{\pi} J+\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\infty} \\ &=\left\|J-\mathrm{T}_{\pi} J\right\|_{\infty}+\left\|\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\infty} \\ & \leq\left\|J-\mathrm{T}_{\pi} J\right\|_{\infty}+\gamma\left\|J-J^{\pi}\right\|_{\infty} \end{aligned} \tag{8.25} ∥J−Jπ∥∞=∥J−TπJ+TπJ−Jπ∥∞=∥J−TπJ∥∞+∥TπJ−Jπ∥∞≤∥J−TπJ∥∞+γ∥J−Jπ∥∞(8.25)

Proposition 8.3 估计值与真实总成本函数之间的约束

给出一个无限范围 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},一个固定的策略 π \pi π和一个总成本函数空间 J \mathcal{J} J。让 J B π ∈ J J_{B}^{\pi} \in \mathcal{J} JBπ∈J为MSBE问题的全局最小值。那么估计值与真实总成本函数 J π J^{\pi} Jπ之间的误差有如下约束

∥ J B π − J π ∥ ∞ ≤ 1 + γ 1 − γ min J ∈ J ∥ J − J π ∥ ∞ . (8.26) \left\|J_{B}^{\pi}-J^{\pi}\right\|_{\infty} \leq \frac{1+\gamma}{1-\gamma} \min _{J \in \mathcal{J}}\left\|J-J^{\pi}\right\|_{\infty} . \tag{8.26} ∥JBπ−Jπ∥∞≤1−γ1+γJ∈Jmin∥J−Jπ∥∞.(8.26)

Proof.

通过应用无穷范数的三角不等式,我们可以得到

∥ T π J − J ∥ ∞ ≤ ∥ T π J − J π ∥ ∞ + ∥ J π − J ∥ ∞ ≤ ( 1 + γ ) ∥ J − J π ∥ ∞ . (8.27) \begin{aligned} \left\|\mathrm{T}_{\pi} J-J\right\|_{\infty} & \leq\left\|\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\infty}+\left\|J^{\pi}-J\right\|_{\infty} \\ & \leq(1+\gamma)\left\|J-J^{\pi}\right\|_{\infty} . \end{aligned} \tag{8.27} ∥TπJ−J∥∞≤∥TπJ−Jπ∥∞+∥Jπ−J∥∞≤(1+γ)∥J−Jπ∥∞.(8.27)

直截了当地有

∥ T π J B π − J B π ∥ ∞ = min J ∈ J ∥ T π J − J ∥ ∞ ≤ ( 1 + γ ) min J ∈ J ∥ J − J π ∥ ∞ . (8.28) \begin{aligned} \left\|\mathrm{T}_{\pi} J_{B}^{\pi}-J_{B}^{\pi}\right\|_{\infty} &=\min _{J \in \mathcal{J}}\left\|\mathrm{T}_{\pi} J-J\right\|_{\infty} \\ & \leq(1+\gamma) \min _{J \in \mathcal{J}}\left\|J-J^{\pi}\right\|_{\infty} . \end{aligned} \tag{8.28} ∥TπJBπ−JBπ∥∞=J∈Jmin∥TπJ−J∥∞≤(1+γ)J∈Jmin∥J−Jπ∥∞.(8.28)

结合不等式和Lemma 8.3 8.3 8.3中的结果,证明了这一点。

显然,公式(8.23)中给出的MSBE成本在数值上仍然是难以优化的。因此,与AVI类似,我们可以定义以下平均贝尔曼误差(Mean Squared Bellman Error, MSBE) 的最小化问题

J 2 π ∈ argmin J ∈ J ∥ T π J − J ∥ 2 . (8.29) J_{2}^{\pi} \in \underset{J \in \mathcal{J}}{\operatorname{argmin}}\left\|\mathrm{T}_{\pi} J-J\right\|_{2} . \tag{8.29} J2π∈J∈Jargmin∥TπJ−J∥2.(8.29)

如果我们采用贝尔曼算子的矩阵形式表达,并选择函数近似空间为线性,即 T π J = G π + γ P π Φ ⊤ h \mathrm{T}_{\pi} J=G_{\pi}+\gamma P_{\pi} \Phi^{\top} h TπJ=Gπ+γPπΦ⊤h,则有上述问题的近似形式表达

J 2 π = ( W π ⊤ W π ) − 1 W π ⊤ G π (8.30) J_{2}^{\pi}=\left(W_{\pi}^{\top} W_{\pi}\right)^{-1} W_{\pi}^{\top} G_{\pi} \tag{8.30} J2π=(Wπ⊤Wπ)−1Wπ⊤Gπ(8.30)

其中 W π = ( I K − γ P π ) Φ ⊤ W_{\pi}=\left(I_{K}-\gamma P_{\pi}\right) \Phi^{\top} Wπ=(IK−γPπ)Φ⊤。 虽然这个解决方案很简单,也很有保证,但不幸的是,没有任何有意义的误差界限可以用来描述这种近似的质量。

8.3 近似的策略评估与遍历性 Approximate Policy Evaluation with Ergodicity

虽然MSBE最小化问题定义明确,也有简单的数值解,但它继承了DP的性质,即对模型信息的要求。在SDM的各种实际应用中,对没有明确模型的问题的有效解决方案有很大的需求。具体来说,我们研究了一类特殊的MDPs,这使得无模型的DP算法得以发展。

8.3.1 各态历经的MDP(Ergodic MDP)

给定一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ}和一个固定的策略 π \pi π,众所周知,系统转换可以被建模为马尔可夫链。为了通过抽样检索完整的模型信息,必须假设每个状态都可以从任何其他状态到达,因此对状态有一个唯一的静止分布。因此,我们对由底层MDP模型和策略 π \pi π规定的状态转换的马尔可夫链施加以下假设

Assumption 8.1 过渡矩阵 P π P_{\pi} Pπ的各态历经性

给定一个无限范围的MDP { X , U , p , g , γ } \{\mathcal{X}, \mathcal{U}, p, g, \gamma\} {X,U,p,g,γ}和一个固定的策略 π \pi π,由过渡矩阵 P π P_{\pi} Pπ定义的马尔可夫链是各态历经的。

让我们用 ξ i \xi_{i} ξi表示第 i i i个相应状态的概率。各态历经性假设意味着所有 i = 1 , … , K i=1, \ldots, K i=1,…,K的 ξ i \xi_{i} ξi都是正定的,也就是说,马尔科夫链有一个唯一的稳定状态分布。让我们定义 ξ : = [ ξ 1 , … , ξ K ] ⊤ ∈ R K \xi:=\left[\xi_{1}, \ldots, \xi_{K}\right]^{\top} \in \mathbb{R}^{K} ξ:=[ξ1,…,ξK]⊤∈RK, 与 x ∈ R K x \in \mathbb{R}^{K} x∈RK。 ξ \xi ξ与过渡矩阵 P π P_{\pi} Pπ之间的关系的特点是

P π ⊤ ξ = ξ (8.31) P_{\pi}^{\top} \xi=\xi \tag{8.31} Pπ⊤ξ=ξ(8.31)

显然,向量 ξ \xi ξ是 P π ⊤ P_{\pi}^{\top} Pπ⊤的右特征向量,与特征值为1有关。此外,由于 ξ \xi ξ的所有条目都是正的,我们可以将 ξ \xi ξ的加权范数定义为

∥ x ∥ ξ = ∑ k = 1 K ξ i x i 2 (8.32) \|x\|_{\xi}=\sqrt{\sum_{k=1}^{K} \xi_{i} x_{i}^{2}} \tag{8.32} ∥x∥ξ=k=1∑Kξixi2(8.32)

Lemma 8.4 ξ \xi ξ加权范数

给定一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},和一个固定的策略 π \pi π,对于任何 K × K K \times K K×K过渡概率矩阵 P π P_{\pi} Pπ,具有一个不变的分布 ξ = ( ξ 1 , … , ξ n ) \xi=\left(\xi_{1}, \ldots, \xi_{n}\right) ξ=(ξ1,…,ξn),有值为正的组成部分,我们有

∥ P π J ∥ ξ ≤ ∥ J ∥ ξ (8.33) \left\|P_{\pi} J\right\|_{\xi} \leq\|J\|_{\xi} \tag{8.33} ∥PπJ∥ξ≤∥J∥ξ(8.33)

Proof

令 P π = { p i j } P_{\pi}=\left\{p_{i j}\right\} Pπ={pij}, 然后我们得到

∥ P π J ∥ ξ 2 = ∑ i = 1 n ξ i ( ∑ j = 1 n p i j J j ) 2 (definition) ≤ ∑ i = 1 n ξ i ∑ j = 1 n p i j J j 2 (convexity) = ∑ j = 1 n ∑ i = 1 n ξ i p i j J j 2 = ∑ j = 1 n ξ j J j 2 ≤ ∥ J ∥ ξ 2 (definition) (8.34) \begin{array}{rlr} \left\|P_{\pi} J\right\|_{\xi}^{2} & =\sum_{i=1}^{n} \xi_{i}\left(\sum_{j=1}^{n} p_{i j} J_{j}\right)^{2} & \text { (definition) } \\ & \leq \sum_{i=1}^{n} \xi_{i} \sum_{j=1}^{n} p_{i j} J_{j}^{2} & \text { (convexity) } \\ & =\sum_{j=1}^{n} \sum_{i=1}^{n} \xi_{i} p_{i j} J_{j}^{2} & \\ & =\sum_{j=1}^{n} \xi_{j} J_{j}^{2} & \\ \leq & \|J\|_{\xi}^{2} & \text { (definition) } \end{array} \tag{8.34} ∥PπJ∥ξ2≤=∑i=1nξi(∑j=1npijJj)2≤∑i=1nξi∑j=1npijJj2=∑j=1n∑i=1nξipijJj2=∑j=1nξjJj2∥J∥ξ2 (definition) (convexity) (definition) (8.34)

Proposition 8.4 ξ \xi ξ加权范数下的贝尔曼算子的收缩性

给定一个无限的范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},和一个固定的策略 π \pi π,那么贝尔曼算子 T π \mathrm{T}_{\pi} Tπ是模数 γ \gamma γ相对于 ξ \xi ξ加权范数的收缩,即:

∥ T π J − T π J ′ ∥ ξ ≤ γ ∥ J − J ′ ∥ ξ . (8.35) \left\|\mathrm{T}_{\pi} J-\mathrm{T}_{\pi} J^{\prime}\right\|_{\xi} \leq \gamma\left\|J-J^{\prime}\right\|_{\xi} . \tag{8.35} ∥TπJ−TπJ′∥ξ≤γ∥J−J′∥ξ.(8.35)

Proof.

为了简单起见,我们使用贝尔曼算子 T π J : = G π + γ P π J \mathrm{T}_{\pi} J:=G_{\pi}+\gamma P_{\pi} J TπJ:=Gπ+γPπJ的紧凑表示,然后,我们得到

∥ T π J − T π J ′ ∥ ξ = ∥ γ P π ( J − J ′ ) ∥ ξ ≤ γ ∥ J − J ′ ∥ ξ (8.36) \begin{aligned} \left\|\mathrm{T}_{\pi} J-\mathrm{T}_{\pi} J^{\prime}\right\|_{\xi} &=\left\|\gamma P_{\pi}\left(J-J^{\prime}\right)\right\|_{\xi} \\ & \leq \gamma\left\|J-J^{\prime}\right\|_{\xi} \end{aligned} \tag{8.36} ∥TπJ−TπJ′∥ξ=∥γPπ(J−J′)∥ξ≤γ∥J−J′∥ξ(8.36)

这直接来自于Lemma 8.4。

通过采用这一特性,我们可以在 ξ \xi ξ加权范数中定义以下的均方贝尔曼误差(MSBE)。

J β π ∈ argmin J ∈ J ∥ T π J − J ∥ ξ (8.37) J_{\beta}^{\pi} \in \underset{J \in \mathcal{J}}{\operatorname{argmin}}\left\|\mathrm{T}_{\pi} J-J\right\|_{\xi} \tag{8.37} Jβπ∈J∈Jargmin∥TπJ−J∥ξ(8.37)

与第8.2节的分析类似,我们可以推导出MSBE最小化在 ξ \xi ξ加权规范下的误差界限如下。

Lemma 8.5 ξ \xi ξ加权范数下的边界

给定一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},让 J π J^{\pi} Jπ是一个固定策略 π \pi π的总成本函数。那么,对于任何总成本函数 J ∈ R K J \in \mathbb{R}^{K} J∈RK中,以下不等式是成立的

∥ J − J π ∥ ξ ≤ 1 1 − γ ∥ J − T π J ∥ ξ (8.38) \left\|J-J^{\pi}\right\|_{\xi} \leq \frac{1}{1-\gamma}\left\|J-\mathrm{T}_{\pi} J\right\|_{\xi} \tag{8.38} ∥J−Jπ∥ξ≤1−γ1∥J−TπJ∥ξ(8.38)

Proof.

直接的有

∥ J − J π ∥ ξ = ∥ J − T π J + T π J − J π ∥ ξ = ∥ J − T π J ∥ ξ + ∥ T π J − J π ∥ ξ ≤ ∥ J − T π J ∥ ξ + γ ∥ J − J π ∥ ξ (8.39) \begin{aligned} \left\|J-J^{\pi}\right\|_{\xi} &=\left\|J-\mathrm{T}_{\pi} J+\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\xi} \\ &=\left\|J-\mathrm{T}_{\pi} J\right\|_{\xi}+\left\|\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\xi} \\ & \leq\left\|J-\mathrm{T}_{\pi} J\right\|_{\xi}+\gamma\left\|J-J^{\pi}\right\|_{\xi} \end{aligned} \tag{8.39} ∥J−Jπ∥ξ=∥J−TπJ+TπJ−Jπ∥ξ=∥J−TπJ∥ξ+∥TπJ−Jπ∥ξ≤∥J−TπJ∥ξ+γ∥J−Jπ∥ξ(8.39)

Proposition 8.5 ξ \xi ξ加权范数下的估计值与真实总成本函数之间的约束

给出一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},一个固定的策略 π \pi π和一个总成本函数空间 J \mathcal{J} J。让 J B π ∈ J J_{B}^{\pi} \in \mathcal{J} JBπ∈J为MSBE问题的全局最小值。那么估计值与真实总成本函数 J π J^{\pi} Jπ之间的误差有如下约束

∥ J β π − J π ∥ ξ ≤ 1 + γ 1 − γ min J ∈ J ∥ J − J π ∥ ξ . (8.40) \left\|J_{\beta}^{\pi}-J^{\pi}\right\|_{\xi} \leq \frac{1+\gamma}{1-\gamma} \min _{J \in \mathcal{J}}\left\|J-J^{\pi}\right\|_{\xi} . \tag{8.40} ∥∥Jβπ−Jπ∥∥ξ≤1−γ1+γJ∈Jmin∥J−Jπ∥ξ.(8.40)

Proof.

通过应用无穷范数的三角不等式,我们可以得到

∥ T π J − J ∥ ξ ≤ ∥ T π J − J π ∥ ξ + ∥ J π − J ∥ ξ ≤ ( 1 + γ ) ∥ J − J π ∥ ξ . (8.41) \begin{aligned} \left\|\mathrm{T}_{\pi} J-J\right\|_{\xi} & \leq\left\|\mathrm{T}_{\pi} J-J^{\pi}\right\|_{\xi}+\left\|J^{\pi}-J\right\|_{\xi} \\ & \leq(1+\gamma)\left\|J-J^{\pi}\right\|_{\xi} . \end{aligned} \tag{8.41} ∥TπJ−J∥ξ≤∥TπJ−Jπ∥ξ+∥Jπ−J∥ξ≤(1+γ)∥J−Jπ∥ξ.(8.41)

简单地说,我们有

∥ T π J β π − J β π ∥ ξ = min J ∈ J ∥ T π J − J ∥ ξ ≤ ( 1 + γ ) min J ∈ J ∥ J − J π ∥ ξ (8.42) \begin{aligned} \left\|\mathrm{T}_{\pi} J_{\beta}^{\pi}-J_{\beta}^{\pi}\right\|_{\xi} &=\min _{J \in \mathcal{J}}\left\|\mathrm{T}_{\pi} J-J\right\|_{\xi} \\ & \leq(1+\gamma) \min _{J \in \mathcal{J}}\left\|J-J^{\pi}\right\|_{\xi} \end{aligned} \tag{8.42} ∥∥TπJβπ−Jβπ∥∥ξ=J∈Jmin∥TπJ−J∥ξ≤(1+γ)J∈Jmin∥J−Jπ∥ξ(8.42)

将该不等式与 8.5 8.5 8.5的结果结合起来,就完成了证明。

8.3.2 平均平方预测贝尔曼误差 (Mean Squared Projected Bellman Error)

最后,如果我们把自己限制在一个线性函数近似的方案中,我们需要一个正交投影到 J l \mathcal{J}_{l} Jl,相对于 ξ \xi ξ的加权规范。具体来说,我们需要解决以下最小化问题

Π Φ ( J ) : = Φ ⊤ argmin h ∈ R m ∥ J − Φ ⊤ h ∥ ξ 2 (8.43) \Pi_{\Phi}(J):=\Phi^{\top} \underset{h \in \mathbb{R}^{m}}{\operatorname{argmin}}\left\|J-\Phi^{\top} h\right\|_{\xi}^{2} \tag{8.43} ΠΦ(J):=Φ⊤h∈Rmargmin∥∥J−Φ⊤h∥∥ξ2(8.43)

由于最小平方函数是凸的,解决方案的特点是通过解决以下方程 h h h来实现的

Φ Ξ Φ ⊤ h = Φ Ξ J (8.44) \Phi \Xi \Phi^{\top} h=\Phi \Xi J \tag{8.44} ΦΞΦ⊤h=ΦΞJ(8.44)

由于 rk ( Φ ) = m \operatorname{rk}(\Phi)=m rk(Φ)=m,正交投影被明确定义为

Π Φ ( J ) : = Φ ⊤ ( Φ Ξ Φ ⊤ ) − 1 Φ Ξ J (8.45) \Pi_{\Phi}(J):=\Phi^{\top}\left(\Phi \Xi \Phi^{\top}\right)^{-1} \Phi \Xi J \tag{8.45} ΠΦ(J):=Φ⊤(ΦΞΦ⊤)−1ΦΞJ(8.45)

Lemma 8.6 非扩张性投影算子 Π Φ \Pi_{\Phi} ΠΦ

给出一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},和一个固定的策略 π \pi π。那么,投影 Π Φ \Pi_{\Phi} ΠΦ在 ξ − \xi- ξ−范数下是一个非扩张性算子,即。

∥ Π Φ J − Π Φ J ′ ∥ ξ ≤ ∥ J − J ′ ∥ ξ . (8.46) \left\|\Pi_{\Phi} J-\Pi_{\Phi} J^{\prime}\right\|_{\xi} \leq\left\|J-J^{\prime}\right\|_{\xi} . \tag{8.46} ∥ΠΦJ−ΠΦJ′∥ξ≤∥J−J′∥ξ.(8.46)

Proof.

不难发现

∥ Π Φ J − Π Φ J ′ ∥ ξ 2 = ∥ Π Φ ( J − J ′ ) ∥ ξ 2 ≤ ∥ Π Φ ( J − J ′ ) ∥ ξ 2 + ∥ ( I − Π Φ ) ( J − J ′ ) ∥ ξ 2 = ∥ J − J ′ ∥ ξ 2 (8.47) \begin{aligned} \left\|\Pi_{\Phi} J-\Pi_{\Phi} J^{\prime}\right\|_{\xi}^{2} &=\left\|\Pi_{\Phi}\left(J-J^{\prime}\right)\right\|_{\xi}^{2} \\ & \leq\left\|\Pi_{\Phi}\left(J-J^{\prime}\right)\right\|_{\xi}^{2}+\left\|\left(I-\Pi_{\Phi}\right)\left(J-J^{\prime}\right)\right\|_{\xi}^{2} \\ &=\left\|J-J^{\prime}\right\|_{\xi}^{2} \end{aligned} \tag{8.47} ∥ΠΦJ−ΠΦJ′∥ξ2=∥ΠΦ(J−J′)∥ξ2≤∥ΠΦ(J−J′)∥ξ2+∥(I−ΠΦ)(J−J′)∥ξ2=∥J−J′∥ξ2(8.47)

其中最后一个等式由勾股定理得出。证明结束。

Proposition 8.6. 投影算子 Π Φ \Pi_{\Phi} ΠΦ的收缩性

给定一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},和一个固定的策略 π \pi π,那么投影贝尔曼算子 Π Φ T π \Pi_{\Phi} \mathrm{T}_{\pi} ΠΦTπ是相对于 ∥ ⋅ ∥ ξ \|\cdot\|_{\xi} ∥⋅∥ξ的模为 γ \gamma γ的收缩。

Proof.

直接从Lemma 8.6 8.6 8.6中,我们得出结论

∥ Π Φ T π J − Π Φ T π J ′ ∥ ξ ≤ ∥ T π J − T π J ′ ∥ ξ ≤ γ ∥ J − J ′ ∥ ξ . (8.48) \begin{aligned} \left\|\Pi_{\Phi} \mathrm{T}_{\pi} J-\Pi_{\Phi} \mathrm{T}_{\pi} J^{\prime}\right\|_{\xi} & \leq\left\|\mathrm{T}_{\pi} J-\mathrm{T}_{\pi} J^{\prime}\right\|_{\xi} \\ & \leq \gamma\left\|J-J^{\prime}\right\|_{\xi} . \end{aligned} \tag{8.48} ∥ΠΦTπJ−ΠΦTπJ′∥ξ≤∥TπJ−TπJ′∥ξ≤γ∥J−J′∥ξ.(8.48)

这个命题表明,在 J \mathcal{J} J中存在一个唯一的固定点 J ~ π \widetilde{J}_{\pi} J π,从而

J ~ π = Π Φ T π J ~ π . \widetilde{J}_{\pi}=\Pi_{\Phi} \mathrm{T}_{\pi} \tilde{J}_{\pi} . J π=ΠΦTπJ~π.

由于 h ↦ Φ h h \mapsto \Phi h h↦Φh是单射的,因此存在一个唯一的 h π ∈ R m h_{\pi} \in \mathbb{R}^{m} hπ∈Rm,这样 Φ h π = Π Φ T π ( Φ h π ) \Phi h_{\pi}=\Pi_{\Phi} \mathrm{T}_{\pi}\left(\Phi h_{\pi}\right) Φhπ=ΠΦTπ(Φhπ)。这简单地导致了另一个流行的目标函数,即均方投影贝尔曼误差(Mean Squared Projected Bellman Error, MSPBE)。

min h ∈ R m ∥ Φ h − Π Φ T π ( Φ h ) ∥ ξ (8.49) \min _{h \in \mathbb{R}^{m}}\left\|\Phi h-\Pi_{\Phi} \mathrm{T}_{\pi}(\Phi h)\right\|_{\xi} \tag{8.49} h∈Rmmin∥Φh−ΠΦTπ(Φh)∥ξ(8.49)

在下文中,我们描述了最小化MSPBE fucntion的误差界限。

Proposition 8.7.

给定一个无限范围的 M D P { X , U , p , g , γ } M D P\{\mathcal{X}, \mathcal{U}, p, g, \gamma\} MDP{X,U,p,g,γ},和一个固定的策略 π \pi π, 让 h π h_{\pi} hπ满足 Φ h π = Π Φ T π ( Φ h π ) \Phi h_{\pi}=\Pi_{\Phi} \mathrm{T}_{\pi}\left(\Phi h_{\pi}\right) Φhπ=ΠΦTπ(Φhπ)。 那么我们有

∥ J π − Φ ⊤ h π ∥ ξ ≤ 1 1 − γ 2 ∥ J π − Π Φ J π ∥ ξ (8.50) \left\|J^{\pi}-\Phi^{\top} h_{\pi}\right\|_{\xi} \leq \frac{1}{\sqrt{1-\gamma^{2}}}\left\|J^{\pi}-\Pi_{\Phi} J^{\pi}\right\|_{\xi} \tag{8.50} ∥∥Jπ−Φ⊤hπ∥∥ξ≤1−γ21∥Jπ−ΠΦJπ∥ξ(8.50)

Proof.

简单地说,我们有

∥ J π − Φ ⊤ h π ∥ ξ 2 = ∥ J π − Π Φ J π ∥ ξ 2 + ∥ Π Φ J π − Φ ⊤ h π ∥ ξ 2 = ∥ J π − Π Φ J π ∥ ξ 2 + ∥ Π Φ T π J π − Π Φ T π ( Φ ⊤ h π ) ∥ ξ 2 ≤ ∥ J π − Π Φ J π ∥ ξ 2 + γ 2 ∥ J π − Φ ⊤ h π ∥ ξ 2 (8.51) \begin{aligned} \left\|J^{\pi}-\Phi^{\top} h_{\pi}\right\|_{\xi}^{2} &=\left\|J^{\pi}-\Pi_{\Phi} J^{\pi}\right\|_{\xi}^{2}+\left\|\Pi_{\Phi} J^{\pi}-\Phi^{\top} h_{\pi}\right\|_{\xi}^{2} \\ &=\left\|J^{\pi}-\Pi_{\Phi} J^{\pi}\right\|_{\xi}^{2}+\left\|\Pi_{\Phi} \mathrm{T}_{\pi} J^{\pi}-\Pi_{\Phi} \mathrm{T}_{\pi}\left(\Phi^{\top} h_{\pi}\right)\right\|_{\xi}^{2} \\ & \leq\left\|J^{\pi}-\Pi_{\Phi} J^{\pi}\right\|_{\xi}^{2}+\gamma^{2}\left\|J^{\pi}-\Phi^{\top} h_{\pi}\right\|_{\xi}^{2} \end{aligned} \tag{8.51} ∥∥Jπ−Φ⊤hπ∥∥ξ2=∥Jπ−ΠΦJπ∥ξ2+∥∥ΠΦJπ−Φ⊤hπ∥∥ξ2=∥Jπ−ΠΦJπ∥ξ2+∥∥ΠΦTπJπ−ΠΦTπ(Φ⊤hπ)∥∥ξ2≤∥Jπ−ΠΦJπ∥ξ2+γ2∥∥Jπ−Φ⊤hπ∥∥ξ2(8.51)

其中第一个等式由勾股定理产生,第二个等式由构造产生,而这个不等式是由于 Π Φ T π \Pi_{\Phi} \mathrm{T}_{\pi} ΠΦTπ的收缩特性造成的。

当真正的总成本函数 J π J^{\pi} Jπ不在线性函数近似空间内时,即 ∥ J π − Π Φ J π ∥ ξ ≠ 0 \left\|J^{\pi}-\Pi_{\Phi} J^{\pi}\right\|_{\xi} \neq 0 ∥Jπ−ΠΦJπ∥ξ=0,那么 ∥ J π − Φ ⊤ h π ∥ ξ \left\|J^{\pi}-\Phi^{\top} h_{\pi}\right\|_{\xi} ∥∥Jπ−Φ⊤hπ∥∥ξ的误差就会被严重约束,如果 γ \gamma γ接近于1。因此,确保总成本函数位于线性总成本函数近似空间 J \mathcal{J} J至关重要,即 J π ∈ J l J^{\pi}\in \mathcal{J}_{l} Jπ∈Jl。

由于MSBE函数和MSPBE函数都是凸的,这两个函数都能保证全局最小值。因此,研究这两个问题的解决方案的性能是有价值的。为此,我们将误差界线的差异定义为

l ( γ ) : = 1 + γ 1 − γ − 1 1 − γ 2 (8.52) l(\gamma):=\frac{1+\gamma}{1-\gamma}-\frac{1}{\sqrt{1-\gamma^{2}}} \tag{8.52} l(γ):=1−γ1+γ−1−γ21(8.52)

很明显, l ( 0 ) = 0 l(0)=0 l(0)=0。现在我们取 l l l的导数为

l ′ ( γ ) = 2 ( 1 − γ ) 2 + γ ( 1 − γ 2 ) 3 (8.53) l^{\prime}(\gamma)=\frac{2}{(1-\gamma)^{2}}+\frac{\gamma}{\left(\sqrt{1-\gamma^{2}}\right)^{3}} \tag{8.53} l′(γ)=(1−γ)22+(1−γ2)3γ(8.53)

其值对于 γ ∈ [ 0 , 1 ] \gamma\in[0,1] γ∈[0,1]来说总是正的。这一事实意味着差分函数 l l l的函数值从0到1单调地增加。图15中的评价清楚地描述了当 γ \gamma γ接近于1时,MSBE最小化和MSPBE最小化的误差界限之差会变成无穷大。换句话说,最小化MSPBE函数比MSBE函数更有优势。

图15:MSBE最小化和MSPBE最小化的误差界限商。

8.4 API 补充

8.4.1 Approximate PI (API)

- 我们将展示三种不同的APE方法: e l l 2 ell_{2} ell2 MSBE、具有各态历经性的MSBE、具有各态历经性的MSPBE。

- 在E-Bus例子下,在策略改进步骤中没有近似方法。

- 深度强化学习中的策略网络:近似的策略改进。

8.4.2 APE via Bellman Residual Minimisation

- In Policy Iteration, Policy Evaluation (PE) via T π T_{\pi} Tπ leads to a fixed point J π J^{\pi} Jπ . (Quiz 2)

- In Approximate PE, there is a Bellman error since we restrict J J J in a subspace ( Φ ⊤ h ) \left(\Phi^{\top} h\right) (Φ⊤h) if we apply Linear Function Approximation (LFA).

8.4.3 ℓ 2 \ell_{2} ℓ2 Based Bellman Residual Minimisation

- What is the difference between ∥ ⋅ ∥ 2 2 \|\cdot\|_{2}^{2} ∥⋅∥22 and ∥ ⋅ ∥ 2 \|\cdot\|_{2} ∥⋅∥2 ?

- ∥ x ∥ 2 2 = x ⊤ x , ∥ x ∥ 2 = x ⊤ x ( x ∈ R n ) \|x\|_{2}^{2}=x^{\top} x,\|x\|_{2}=\sqrt{x^{\top} x}\left(x \in \mathbb{R}^{n}\right) ∥x∥22=x⊤x,∥x∥2=x⊤x(x∈Rn) .

- Both forms are strict convex, they have the same global minima. We did not make a strict distinction between these two terms since we only focus on the analytical solution.

- Quite different in numerical calculations, e.g., gradient.

- In this exercise, we keep using ∥ ⋅ ∥ 2 2 \|\cdot\|_{2}^{2} ∥⋅∥22 , which is also more consistent with the name ‘Squared’ BE.

8.4.4 Recap: Closed form policy evaluation

Preliminaries: matrix derivation

- Matrix calculus

- Layout conventions: given y ∈ R m , x ∈ R n y \in \mathbb{R}^{m}, x \in \mathbb{R}^{n} y∈Rm,x∈Rn .

Numerator-layout:

Numerator-layout: ∂ y ∂ x : = [ ∂ y 1 ∂ x 1 … ∂ y 1 ∂ x n ⋱ ∂ y m ∂ x 1 … ∂ y m ∂ x n ] ∈ R m × n , ∂ y ∂ x : = [ ∂ y 1 ∂ x 1 … ∂ y m ∂ x 1 ⋱ ∂ y 1 ∂ x n … ∂ y m ∂ x n ] ∈ R n × m , \begin{array}{l} \text { Numerator-layout: } \\ \frac{\partial y}{\partial x}:=\left[\begin{array}{ccc} \frac{\partial y_{1}}{\partial x_{1}} & \ldots & \frac{\partial y_{1}}{\partial x_{n}} \\ & \ddots & \\ \frac{\partial y_{m}}{\partial x_{1}} & \ldots & \frac{\partial y_{m}}{\partial x_{n}} \end{array}\right] \in \mathbb{R}^{m \times n}, \quad \frac{\partial y}{\partial x}:=\left[\begin{array}{ccc} \frac{\partial y_{1}}{\partial x_{1}} & \ldots & \frac{\partial y_{m}}{\partial x_{1}} \\ & \ddots & \\ \frac{\partial y_{1}}{\partial x_{n}} & \ldots & \frac{\partial y_{m}}{\partial x_{n}} \end{array}\right] \in \mathbb{R}^{n \times m}, \end{array} Numerator-layout: ∂x∂y:=⎣⎡∂x1∂y1∂x1∂ym…⋱…∂xn∂y1∂xn∂ym⎦⎤∈Rm×n,∂x∂y:=⎣⎡∂x1∂y1∂xn∂y1…⋱…∂x1∂ym∂xn∂ym⎦⎤∈Rn×m,

- This exercise follows denominator layout convention.

- This exercise has two kinds of matrix derivation:

- The derivative of a scalar y by a vector x : gradient (vector)

- The derivative of a vector y by a vector x : Jaccobian (matrix)

8.4.5 ℓ 2 \ell_{2} ℓ2 Based Bellman Residual Minimisation

- ℓ 2 \ell_{2} ℓ2 least square function:

J 2 π ∈ argmin J ∈ J ∥ T π J − J ∥ 2 2 , where J = Φ ⊤ h . ∥ T π J − J ∥ 2 2 = ∥ J − T π J ∥ 2 2 = ∥ J − G π − γ P π J ∥ 2 2 = ∥ ( I K − γ P π ) Φ ⊤ h − G π ∥ 2 2 \begin{aligned} J_{2}^{\pi} \in \underset{J \in \mathcal{J}}{\operatorname{argmin}} &\left\|\mathrm{T}_{\pi} J-J\right\|_{2}^{2}, \quad \text { where } J=\Phi^{\top} h . \\ \left\|\mathrm{T}_{\pi} J-J\right\|_{2}^{2} &=\left\|J-\mathrm{T}_{\pi} J\right\|_{2}^{2}=\left\|J-G_{\pi}-\gamma P_{\pi} J\right\|_{2}^{2} \\ &=\left\|\left(I_{K}-\gamma P_{\pi}\right) \Phi^{\top} h-G_{\pi}\right\|_{2}^{2} \end{aligned} J2π∈J∈Jargmin∥TπJ−J∥22∥TπJ−J∥22, where J=Φ⊤h.=∥J−TπJ∥22=∥J−Gπ−γPπJ∥22=∥∥(IK−γPπ)Φ⊤h−Gπ∥∥22

- Let W π = ( I K − γ P π ) Φ ⊤ ∈ R K × m W_{\pi}=\left(I_{K}-\gamma P_{\pi}\right) \Phi^{\top} \in \mathbb{R}^{K \times m} Wπ=(IK−γPπ)Φ⊤∈RK×m , we have

∥ T π J − J ∥ 2 2 = ∥ W π h − G π ∥ 2 2 = ( W π h − G π ) T ( W π h − G π ) \begin{aligned} \left\|\mathrm{T}_{\pi} J-J\right\|_{2}^{2} &=\left\|W_{\pi} h-G_{\pi}\right\|_{2}^{2} \\ &=\left(W_{\pi} h-G_{\pi}\right)^{\mathrm{T}}\left(W_{\pi} h-G_{\pi}\right) \end{aligned} ∥TπJ−J∥22=∥Wπh−Gπ∥22=(Wπh−Gπ)T(Wπh−Gπ)

-

Since the least square function is convex, we can get the minima when the derivation equals to zero.

-

Let u = W π h − G π ∈ R K × 1 \mathbf{u}=W_{\pi} h-G_{\pi} \in \mathbb{R}^{K \times 1} u=Wπh−Gπ∈RK×1 , we can get

∂ u ⊤ u ∂ u = 2 u , ∂ u ⊤ u ∂ h = 2 ∂ u ∂ h u , w h e r e ∂ u ∂ h = W π ⊤ (denominator layout) \frac{\partial \mathbf{u}^{\top} \mathbf{u}}{\partial \mathbf{u}}=2 \mathbf{u}, \quad \frac{\partial \mathbf{u}^{\top} \mathbf{u}}{\partial h}=2 \frac{\partial \mathbf{u}}{\partial h} \mathbf{u}, \quad where \frac{\partial \mathbf{u}}{\partial h}=W_{\pi}^{\top} \quad \text{(denominator layout)} ∂u∂u⊤u=2u,∂h∂u⊤u=2∂h∂uu,where∂h∂u=Wπ⊤(denominator layout)

∂ ( W π h − G π ) ⊤ ( W π h − G π ) ∂ h = 2 W π ⊤ ( W π h − G π ) = 0 ∈ R m × 1 ⇒ W π ⊤ W π h − W π ⊤ G π = 0 W π ⊤ W π h = W π ⊤ G π \begin{aligned} \frac{\partial\left(W_{\pi} h-G_{\pi}\right)^{\top}\left(W_{\pi} h-G_{\pi}\right)}{\partial h} &=2 W_{\pi}^{\top}\left(W_{\pi} h-G_{\pi}\right)=0 \in \mathbb{R}^{m \times 1} \\ \Rightarrow \quad W_{\pi}^{\top} W_{\pi} h-W_{\pi}^{\top} G_{\pi} &=0 \\ W_{\pi}^{\top} W_{\pi} h &=W_{\pi}^{\top} G_{\pi} \end{aligned} ∂h∂(Wπh−Gπ)⊤(Wπh−Gπ)⇒Wπ⊤Wπh−Wπ⊤GπWπ⊤Wπh=2Wπ⊤(Wπh−Gπ)=0∈Rm×1=0=Wπ⊤Gπ

- W π ⊤ W_{\pi}^{\top} Wπ⊤ is not a square matrix (non-invertable), so we move ( W π ⊤ W π ) ∈ R m × m \left(W_{\pi}^{\top} W_{\pi}\right) \in \mathbb{R}^{m \times m} (Wπ⊤Wπ)∈Rm×m to the RHS:

h = ( W π ⊤ W π ) − 1 W π ⊤ G π J 2 π = Φ ⊤ h = Φ ⊤ ( W π ⊤ W π ) − 1 W π ⊤ G π \begin{array}{c} h=\left(W_{\pi}^{\top} W_{\pi}\right)^{-1} W_{\pi}^{\top} G_{\pi} \\ J_{2}^{\pi}=\Phi^{\top} h=\Phi^{\top}\left(W_{\pi}^{\top} W_{\pi}\right)^{-1} W_{\pi}^{\top} G_{\pi} \end{array} h=(Wπ⊤Wπ)−1Wπ⊤GπJ2π=Φ⊤h=Φ⊤(Wπ⊤Wπ)−1Wπ⊤