HDFS完全分布式集群搭建与配置

HDFS完全分布式集群搭建与配置

-

- 介绍

-

- HDFS前言

- HDFS的概念和特性

- 整体思路

- 准备工作

- 配置过程

-

- 三台虚拟机都已经完成的步骤

- hadoop-env.sh

- yarn-env.sh

- core-site.xml

- hdfs-site.xml

- mapred-site.xml

- yarn-site.xml

- slaves

- 同步配置

- 环境变量

- 启动集群

-

- hdfs常用命令

- 测试

- 注意事项

介绍

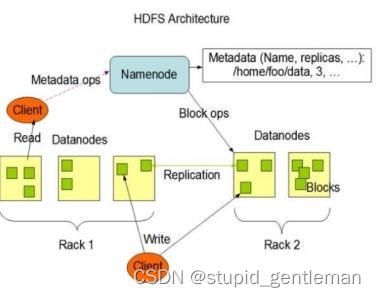

HDFS的组成架构

架构介绍 :

1> NameNode(nn):就是Master,它是一个主管、管理者

(1)管理HDFS的名称空间;

(2)配置副本策略;

(3)管理数据块(block)映射信息;

(4)处理客户端读写请求

2> DataNode:就是Slave。NameNode下达命令,DateNode执行实际操作。

(1)储存实际的数据块;

(2)执行数据块的写/读操作

3> Client:就是客户端

(1)文件切分。文件上传HDFS的时候。Client将文件切分成一个个的Block,然后进行上传;

(2)与NameNode交互,获取文件的位置信息;

(3)与DataNode交互,读取或者写入数据;

(4)Client提供一些命令来管理HDFS;

(5)Client 可以通过一些命令来访问HDFS;

4> Secondary NameNode:并非NameNode的热备。当NameNode挂掉的时候,它并不能马上替换NameNode并提供服务。

(1)辅助NameNode,分担其工作量;

(2)在紧急情况下,可以辅助恢复NameNode

HDFS前言

设计思想:

分而治之:将大文件、大批量文件,分布式存放在大量服务器上,以便于采取分而治之的方式对海量数据进行运算分析;

在大数据系统中作用:

为各类分布式运算框架(如:mapreduce,spark,tez,……)提供数据存储服务

重点概念:文件切块,副本存放,元数据

HDFS的概念和特性

首先,它是一个文件系统,用于存储文件,通过统一的命名空间——目录树来定位文件

其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色;

重要特性如下:

HDFS中的文件在物理上是分块存储(block),块的大小可以通过配置参数( dfs.blocksize)来规定,默认大小在hadoop2.x版本中是128M,老版本中是64M

HDFS文件系统会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件,形如:hdfs://namenode:port/dir-a/dir-b/dir-c/file.data

目录结构及文件分块信息(元数据)的管理由namenode节点承担

——namenode是HDFS集群主节点,负责维护整个hdfs文件系统的目录树,以及每一个路径(文件)所对应的block块信息(block的id,及所在的datanode服务器)

文件的各个block的存储管理由datanode节点承担

---- datanode是HDFS集群从节点,每一个block都可以在多个datanode上存储多个副本(副本数量也可以通过参数设置dfs.replication)

HDFS是设计成适应一次写入,多次读出的场景,且不支持文件的修改

(注:适合用来做数据分析,并不适合用来做网盘应用,因为,不便修改,延迟大,网络开销大,成本太高)

整体思路

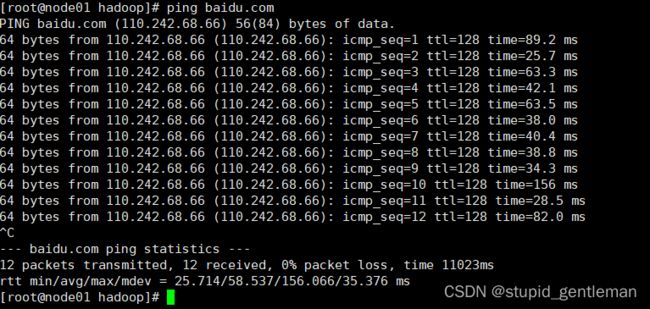

1.准备三台虚拟机(以完成网络配置,主机名配置,主机域名映射,防火墙关闭并关闭重启,ssh免密,安装JDK等等)

2.在node01上安装Hadoop,配置环境变量(修改和配置一些文件,修改时一定小心错一个字母就会失败。)

3.同步配置信息(把在node01上修改的配置文件同步到node02和node03上)

4.在node01上格式化,并启动集群。

5.用jps查看启动情况,并测试上传下载是否能成功。在web端查看。

准备工作

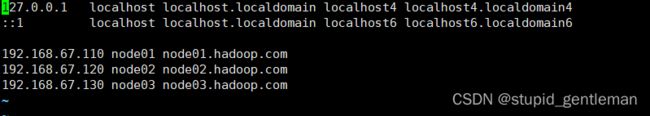

1.检查三台虚拟机网络是否能ping通,主机名是否正确,主机映射是否正确等等准备工作是否做好。

2.创建安装目录

cd /opt

mkdir software

cd software/

mkdir hadoop

cd hadoop/

mkdir hdfs

cd hdfs/

mkdir data

mkdir name

mkdir tmp

输入yum -y install lrzsz代码下载插件,可以直接将压缩包(hadoop-2.9.2.tar.gz)上传到指定文件夹。

回到hadoop目录上传文件

cd /opt/software/hadoop/

rz

可以输入rz上传文件,也可以直接将文件拖到提前cd 到的路径下面就可以上传了。

解压文件

tar -xvzf hadoop-2.9.2.tar.gz

配置过程

三台虚拟机都已经完成的步骤

–网络配置

–主机名配置

–主机域名映射

–防火墙和selinux关闭

–ssh免密

–安装jdk

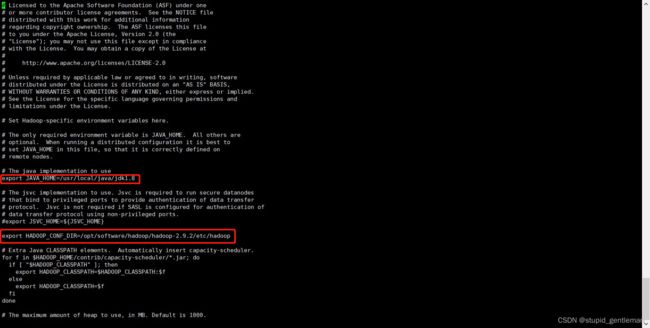

hadoop-env.sh

此处无需配置,只需修改JAVA_HOME值和HADOOP_CONF的值

配置值:

export JAVA_HOME=/usr/local/java/jdk1.8

export HADOOP_CONF_DIR=/opt/software/hadoop/hadoop-2.9.2/etc/hadoop

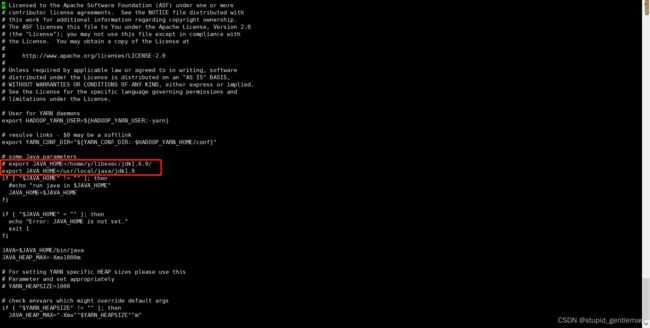

yarn-env.sh

配置yarn-sev.sh时需要新增JAVA_HOME的值。

在# export JAVA_HOME=/home/y/libexec/jdk1.6.0/,在此行下添加JAVA_HOME的值

配置值:

export JAVA_HOME=/usr/local/java/jdk1.8

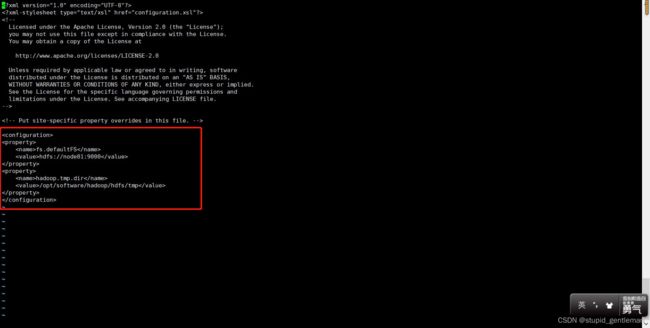

core-site.xml

配置时需要将文件系统节点改成node01。

fs.defaultFS表示指定集群的文件系统类型是分布式文件系统(HDFS),datanode心跳发送到namenode的地址

hadoop.tmp.dir表示hadoop临时文件

配置值:

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/software/hadoop/hdfs/tmp</value>

</property>

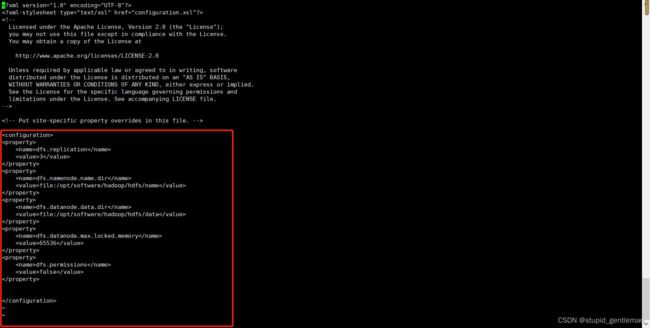

hdfs-site.xml

dfs.replication原本配置是1,修改为3,三副本策略,表示副本数是3

dfs.name.dir和dfs.data.dir配置不变

dfs.datanode.max.locked.memory配置添加,开启缓存,配置值根据自己机器情况配置

dfs.permissions配置添加,值配置false,不开启文件权限

配置值:

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/software/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/software/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.datanode.max.locked.memory</name>

<value>65536</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

注:dfs.datanode.max.locked.memory不一定是65536,需要根据自己机器情况而定,可以使用ulimit-l查询参数,得到的数值是64,表示64k,就是64乘以1024=65536byte

如果是32就是32乘以1024=32768

![]()

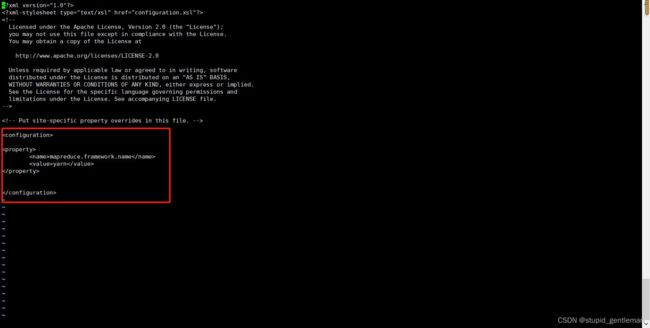

mapred-site.xml

配置时需要把mapred-site.xml.template拷贝成map-site.xml文件进行配置(cp mapred-site.xml.template mapred-site.xml )

mapreduce.framework.name指定资源分配yarn

配置值:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

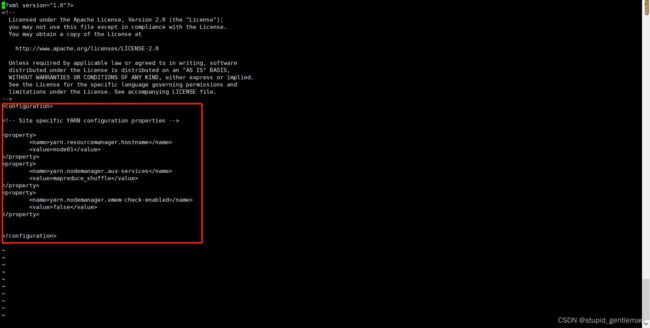

yarn-site.xml

yarn.resourcemanager.hostname:yarn相关资源服务器的主机名,使用node01

yarn.nodemanager.aux-services和MapReduce计算相关

yarn.nodemanager.vmem-check-enabled 关闭虚拟内存检查

配置值:

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

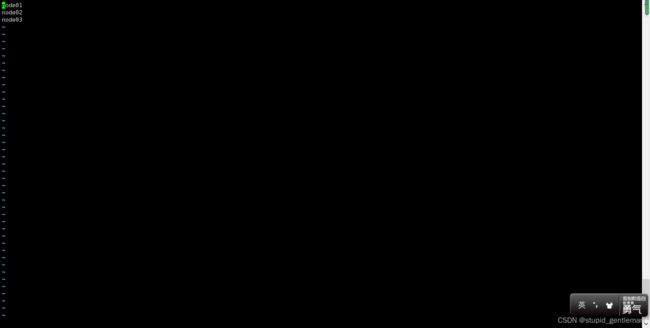

slaves

配置3台主机名,此配置表示三台机器都作为DataNode

配置值:

node01

node02

node03

同步配置

在node02和node03上创建 /opt/software 目录

创建software(mkdir software)

cd /opt/

mkdir software

把node01上的配置同步到node02和node03上

使用scp命令进行同步

cd /opt/software/

scp -r hadoop/ node02:$PWD

scp -r hadoop/ node03:$PWD

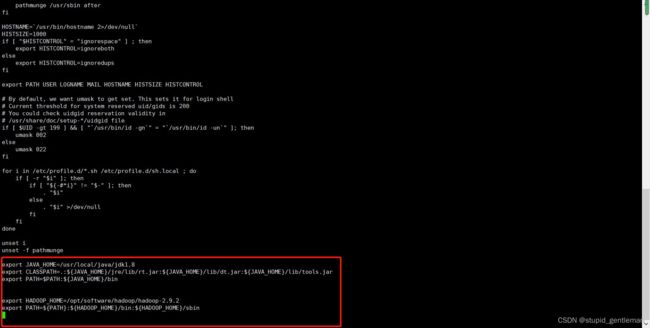

环境变量

之前只在node01上配置了hadoop环境变量,现在需要在node02和node03上添加hadoop环境变量

在node02和node03机器的/etc/profile环境变量中添加hadoop配置

vi /etc/profile

export HADOOP_HOME=/opt/software/hadoop/hadoop-2.9.2

export PATH=${PATH}:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin

添加配置以后记得加载配置文件,使得配置文件生效

source /etc/profile

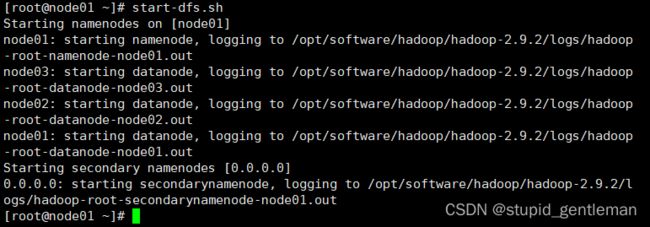

启动集群

在node01上格式化(hdfs namenode -format),只需在node01上启动

start-dfs.sh

如果有多次格式化文件系统,需将DataNode的数据存放目录的版本信息删除以便其保持一致,否则Hadoop会启动失败。

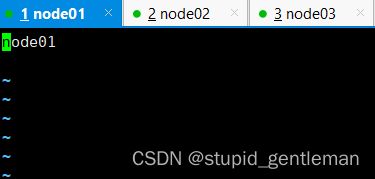

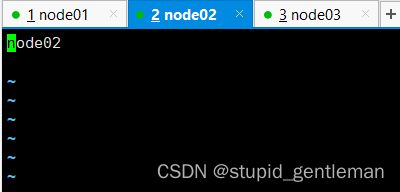

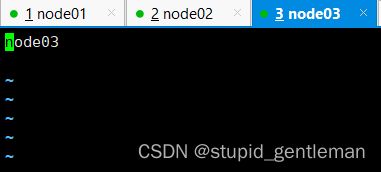

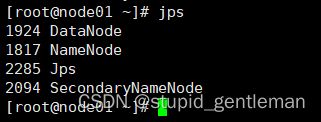

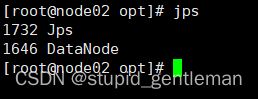

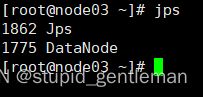

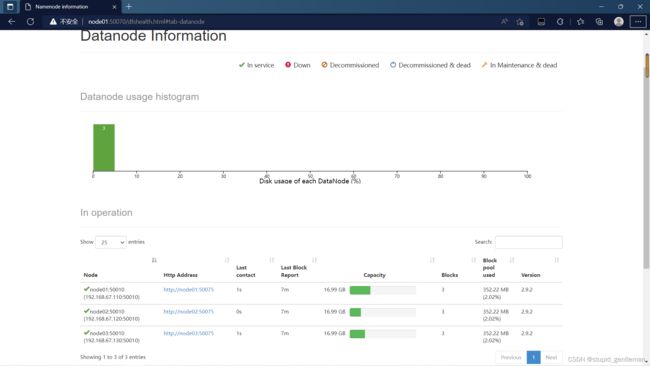

node01上查看是否有3个进程启动(jps),node02,node03上分别有一个进程

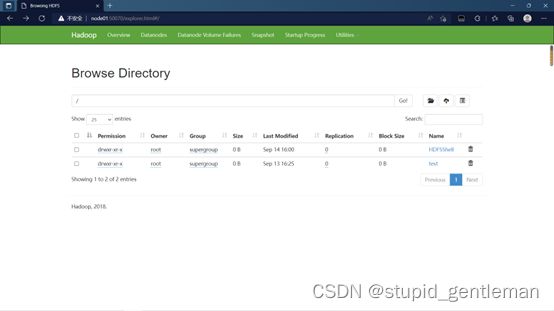

访问web(网址:http://192.168.67.110:50070/ )

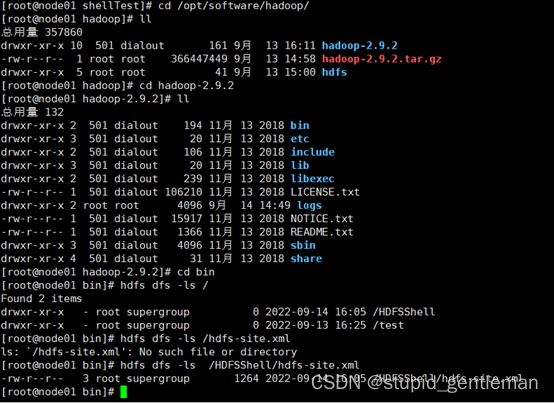

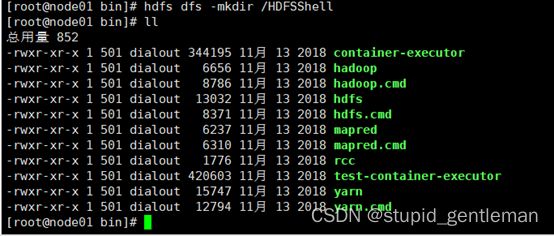

hdfs常用命令

HDFS使用hdfs脚本来进行操作

/opt/software/hadoop/hadoop-2.9.2/bicd

/opt/software/hadoop/hadoop-2.9.2/bin

ls

创建目录(hdfs dfs - mkdir /test)

上传文件(hdfs dfs -put /opt/testData/hdfs/hadoop-2.9.2.tar.gz /test)

解释:上传文件/opt/testData/hdfs/hadoop-2.9.2.tar.gz是指出要上传的文件位置,/test是指出文件上传到哪里

下载文件(hdfs dfs -get /test/hadoop-2.9.2.tar.gz /opt/testData/hdfs/)

解释:下载文件/test/hadoop-2.9.2.tar.gz是指出要下载的文件位置,/opt/testData/hdfs/是指出文件下载到哪个目录下

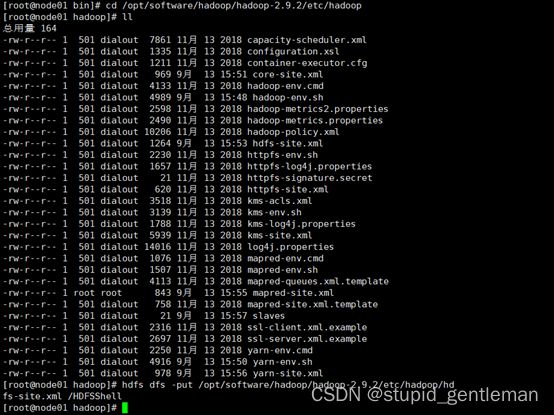

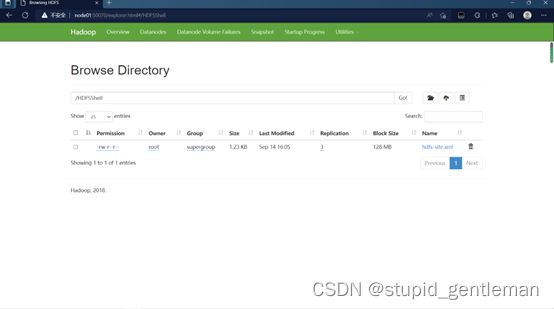

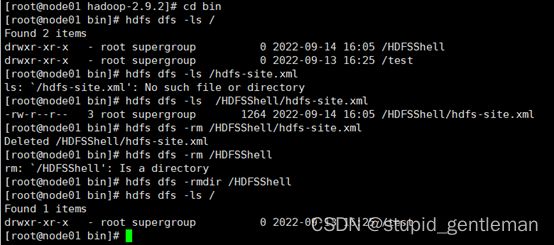

测试

- 创建一个名为HDFSShell的文件夹,并查看根目录(/)

hdfs dfs -mkdir /HDFSShell

2. 将/opt/software/hadoop/hadoop-2.9.2/etc/hadoop/hdfs-site.xml上传到HDFSShell中,并查看HDFSShell目录。

cd /opt/software/hadoop/hadoop-2.9.2/etc/hadoop

hdfs dfs -put /opt/software/hadoop/hadoop-2.9.2/etc/hadoop/hdfs-site.xml /HDFSShell

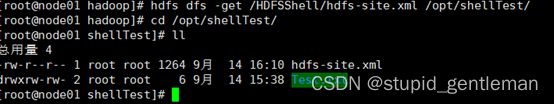

hdfs dfs -get /HDFSShell/hdfs-site.xml /opt/shellTest/

cd /opt/shellTest

ll

- 在hdfs中查看题目2里上传的文件内容。

hdfs dfs -ls /HDFSShell/hdfs-site.xml

hdfs dfs -rm /HDFSShell/hdfs-site.xml

hdfs dfs -rmdir /HDFSShell

hdfs dfs -ls

注意事项

打开配置文件时,需要切换到指定路径。(cd /opt/software/hadoop/hadoop-2.9.2/etc/hadoop)

然后用vi 打开配置文件修改。

做配置文件时大小写,字母不要出错。

…