实时追踪科研动态丨7.12精选新论文,附ChatPaper综述

作为科研人员,每天需要检索和浏览大量的学术文献,以获取最新的科技进展和研究成果。

然而,传统的检索和阅读方式已经无法满足科研人的需求。

ChatPaper,一款集检索、阅读、知识问答于一体的文献知识工具。帮助你快提高检索、阅读论文效率,获取最新领域研究动态,让科研工作更加游刃有余。

结合前沿动态订阅功能,精选arXiv当日热门新论文,形成论文综述,让大家更加快速了解前沿动态。

如果想要对某篇论文进行深入对话,可以直接点击论文链接或者直达ChatPaper页面:https://www.aminer.cn/chat/g/

2023年7月12日精选新论文列表:

1.Efficient 3D Articulated Human Generation with Layered Surface Volumes 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f61e/?f=zh

ChatPaper综述:文指出了在生成式对抗网络中使用现有的3D模型表示方法(如模板网格或体素)存在的问题,这些方法要么速度快但质量有限,要么质量高但渲染速度慢,因此在生成式对抗网络中无法提供高质量的3D模型。作者提出了一种新的3D对象表示方法,即分层表面体积(LSVs),以解决这个问题。LSVs使用多个纹理网格层来表示人体,并使用快速可微分光栅化进行绘制。与传统的单层模板只能表示表面细节的方法不同,LSVs能够自然地捕捉到头发或配饰等细节。LSVs可以被调整,并且在生成式对抗网络中表现出卓越的效率。通过在非结构化、单视图的2D图像数据集上进行训练,LSV-GAN能够生成高质量、视角一致的3D人体模型,而无需使用不一致的2D上采样网络。

2.Self-Supervised Learning with Lie Symmetries for Partial Differential Equations 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f5ff/?f=zh

ChatPaper综述:论文介绍了使用自监督学习和李对称性来学习偏微分方程的问题。目前的算法需要特定场景下的模拟训练数据,而本论文提出从异构数据中学习PDE的通用表示方法,以及应用于自监督学习的联合嵌入方法。该方法在不变任务方面优于基线方法,如回归PDE的系数,同时还改进了神经求解器的时间步进性能。希望这种方法有助于最终开发出适用于PDE的通用基础模型。

3.Differentiable Blocks World: Qualitative 3D Decomposition by Rendering Primitives 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f629/?f=zh

ChatPaper综述:研究论文介绍了一个基于不同iable渲染的方法,使用一组校准图像对场景进行解析,并将其表示为由少量纹理基元构成的中层3D表示。与其他方法不同,该方法直接在图像上操作,通过不同iable渲染将基元建模为纹理超二次网格,并通过图像渲染损失从头开始优化其参数。该方法强调了为每个基元建模透明度的重要性,这对优化至关重要,并且还可以处理不同数量的基元。该方法在DTU的各种场景以及从BlendedMVS和Nerfstudio捕获的真实场景上与现有技术进行了比较,并展示了如何轻松编辑场景或进行物理模拟。

4.EgoVLPv2: Egocentric Video-Language Pre-training with Fusion in the Backbone 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f61f/?f=zh

ChatPaper综述:研究指出现有的自我中心视频-语言预训练框架在视频和语言编码器上是分开的,并且只在精调过程中学习任务特定的跨模态信息,从而限制了统一系统的发展。为了解决这个问题,研究者们提出了第二代自我中心视频-语言预训练(EgoVLPv2),通过直接将跨模态融合引入到视频和语言骨干中,对上一代进行了显著改进。EgoVLPv2在预训练过程中学习强大的视频-文本表示,并在不同的下游任务中灵活高效地重用跨模态注意力模块,从而降低了精调成本。此外,所提出的骨干融合策略比堆叠额外的融合特定层更轻量且计算效率更高。在广泛的视觉语言任务上进行的大量实验证明了EgoVLPv2的有效性,在所有下游任务上都实现了一致的最先进性能,并超过了强基线结果。

5.Test-Time Training on Video Streams 论文详情页

链接:https://www.aminer.cn/pub/64ae259c3fda6d7f0658f2dd/?f=zh

ChatPaper综述:如何在视频流上进行测试时间训练(Test-Time Training)以提高模型性能。在传统的测试时间训练中,模型会在每个测试实例之前使用自监督任务进行训练,例如使用带有掩码自编码器的图像重构。本文将测试时间训练扩展到了流式设置,在这种设置下,多个测试实例(本文中为视频帧)按照时间顺序到达。作者提出的在线测试时间训练(Online TTT)通过使用当前帧和前面一个小窗口的帧对当前模型进行初始化和训练。实验证明,相比于固定模型基线,在线测试时间训练在四个任务上都有显著的性能提升,在三个真实数据集上分别提升了45%和66%。令人惊讶的是,在线测试时间训练还比离线测试时间训练表现更好,尽管离线测试时间训练可以访问更多的信息,即使用整个测试视频的所有帧进行训练。这与之前使用合成视频得出的结论不同。作者将在线测试时间训练的优势概念化为局部性。通过削减实验和基于偏差-方差权衡的理论分析,作者分析了局部性的作用。

6.AutoDecoding Latent 3D Diffusion Models 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f60c/?f=zh

ChatPaper综述:论文介绍了一种新的静态和可动3D资源生成方法,其核心是一个3D自解码器。该3D自解码器框架将从目标数据集中学习的特性嵌入到潜在空间中,然后可以解码为用于呈现一致视觉效果和几何形状的体积表示。然后,论文确定了适当的中间体积潜在空间,并引入了稳健的归一化和反归一化操作,以学习从二维图像或单目视频中的刚性或可动物体到三维扩散的过程。该方法具有足够的灵活性,可以使用现有的相机监督信息,也可以在训练过程中高效地学习相机信息。实验评估表明,该生成方法在各种基准数据集和指标上优于最先进的替代方法,包括合成物体的多视图图像数据集、真实环境中移动人物的视频以及大规模静态物体的真实视频数据集。

7.Collaborative Score Distillation for Consistent Visual Synthesis 论文详情页

链接:https://www.aminer.cn/pub/64ae259c3fda6d7f0658f1f0/?f=zh

ChatPaper综述:论文主要介绍了在复杂的视觉模态中,如何实现一致性地生成一组图像的挑战。传统的大规模文本到图像扩散模型的生成先验可以应用于各种不同的视觉模态,实现新型的生成和编辑应用。然而,当适应这些生成先验到复杂的视觉模态,比如多个图像(例如视频),要实现图像集合的一致性就变得具有挑战性。为了解决这个问题,本文提出了一种新的方法,即协同得分蒸馏(Collaborative Score Distillation,CSD)。CSD基于Stein变分梯度下降(Stein Variational Gradient Descent,SVGD)。具体地,我们建议将多个样本视为SVGD更新中的“粒子”,并结合它们的得分函数来同步蒸馏一组图像的生成先验。因此,CSD实现了在2D图像之间无缝地整合信息,从而实现了多个样本之间的一致的视觉合成。我们展示了CSD在各种任务中的有效性,包括全景图像、视频和3D场景的视觉编辑。我们的结果突显了CSD作为一种通用方法,在增强样本之间一致性方面的能力,从而扩展了文本到图像扩散模型的适用性。

8.Generative Pretraining in Multimodality 论文详情页

链接:https://www.aminer.cn/pub/64ae259c3fda6d7f0658f3b5/?f=zh

ChatPaper综述:模型可以无缝地在多模态环境下生成图像和文本。它可以接受任何单模态或多模态的数据输入,并通过一个全自回归训练过程进行训练。首先,视觉信号被编码成嵌入向量,并与文本标记一起形成交叉输入序列。接着,Emu根据统一的目标进行端到端训练,目标是在多模态序列中对下一个文本标记进行分类或对下一个视觉嵌入进行回归。Emu的这种多模态能力使其能够对各种规模的预训练数据源进行广泛的探索,如交错帧和文本的视频,交错图像和文本的网页,以及大规模的图像-文本对和视频-文本对。Emu可以作为图像到文本和文本到图像任务的通用多模态接口,并支持上下文中的图像和文本生成。在包括图像字幕,视觉问答,视频问答和文本到图像生成等广泛的零样本/小样本任务中,Emu相比最先进的大型多模态模型表现出了出色的性能。另外,通过指令调优,还展示了Emu的多模态助手等扩展能力,并取得了令人印象深刻的表现。

9.Empowering Cross-lingual Behavioral Testing of NLP Models with Typological Features 论文详情页

链接:https://www.aminer.cn/pub/64ae259f3fda6d7f0658f616/?f=zh

ChatPaper综述:文章讨论了针对跨语言行为测试的自然语言处理(NLP)模型的问题,并提出了一种基于语言类型学特征的框架M2C来解决这个问题。作者使用M2C在12种类型学多样的语言中生成了针对模型行为的测试,并评估了最先进的语言模型在这些测试中的表现。结果发现,虽然英语的测试大多数模型都表现出色,但在斯瓦希里语的时间表达和芬兰语的复合所有格等特定类型学特征方面,模型存在泛化失败的问题。作者的研究结果表明需要开发能够解决这些盲点的模型。

10.Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration 论文详情页

链接:https://www.aminer.cn/pub/64ae259c3fda6d7f0658f403/?f=zh

ChatPaper综述:指出了大语言模型(LLMs)在需要领域知识和复杂推理的任务中仍然存在困难。它提出了一种解决方案,即通过与多个角色进行多轮自我协作,将单个LLM转化为认知协同体,从而提升问题解决能力和整体性能。通过根据任务输入动态地识别和模拟不同的角色,这种方法释放了LLMs中认知协同的潜力。研究发现,与使用单个或固定数量的角色相比,给LLMs分配多个细粒度的角色能够更好地提升问题解决能力。该研究还对三个具有挑战性的任务进行了评估,包括知识密集型和推理密集型的任务。与以往仅增强LLMs推理能力的研究(如思维链)不同,这种方法有效地促进了LLMs的内部知识获取能力,减少了产生幻觉,并保持了强大的推理能力。

11.Secrets of RLHF in Large Language Models Part I: PPO 论文详情页

链接:https://www.aminer.cn/pub/64ae259c3fda6d7f0658f2a9/?f=zh

ChatPaper综述:指出了使用大型语言模型进行强化学习与人类反馈(RLHF)的稳定训练存在的问题。根据作者的观察,奖励设计、环境交互和智能体训练的挑战,加上大型语言模型的大量试错成本,给人工智能研究人员在推动技术对齐和安全落地大型语言模型的发展上带来了重大障碍。作者重点强调了PPO算法的内在工作方式,并探讨了构成PPO算法的不同部分对策略智能体训练的影响。他们认为策略约束是PPO算法有效实施的关键因素,并介绍了PPO-max算法作为PPO算法的改进版本,以提高策略模型的训练稳定性。此外,作者还提到了与SFT模型和ChatGPT相比,RLHF在能力上的全面分析。最后,作者强调了缺乏开源实现对于研究大型语言模型对齐所带来的重大挑战,并表示他们将发布技术报告、奖励模型和PPO代码来解决这一问题。

12.One-2-3-45: Any Single Image to 3D Mesh in 45 Seconds without Per-Shape Optimization 论文详情页

链接:https://www.aminer.cn/pub/649e52c5d68f896efae487fc/?f=zh

ChatPaper综述:论文讨论了单图像三维重建的挑战性任务,并提出了一个新方法来解决这个问题。现有的方法通常通过优化神经辐射场来进行二维扩散模型的引导,但是存在优化时间长、三维不一致和几何质量差的问题。作者的方法通过一个前馈过程,将任意物体的单图像输入转换为360度的三维纹理网格。为了处理多视图不一致的预测,作者基于基于SDF(有符号距离场)的可推广神经表面重建方法构建了三维重建模块,并提出了几个重要的训练策略,以实现360度网格的重建。该方法不需要昂贵的优化过程,比现有方法更快地完成三维形状的重建。此外,该方法具有更好的几何形状、更一致的结果,并更贴近输入图像。作者在合成数据和实际图像上验证了该方法的优越性,证明了其在网格质量和运行时间方面的优势。此外,该方法还可以与即用的文本到图像扩散模型结合,无缝支持文本到三维的任务。

13.NILUT: Conditional Neural Implicit 3D Lookup Tables for Image Enhancement 论文详情页

链接:https://www.aminer.cn/pub/6493c733d68f896efad19b14/?f=zh

ChatPaper综述:论文指出了当前学习和应用3D LUTs的方法在速度方面尚可,但在内存效率上存在问题,并且由于实现限制,在移动设备上它们的使用较少。为解决这个问题,论文提出了一种新的方法,即Neural Implicit LUT (NILUT),它是由神经网络参数化的隐式定义的连续3D颜色转换。作者展示了NILUT能够准确地模拟真实的3D LUTs。此外,NILUT可以扩展为将多个风格融合到单个网络中,并具有隐式混合风格的能力。这种新方法具有内存效率高、可控性好的特点,并且可以补充先前的方法,包括学习的图像信号处理器(ISPs)。

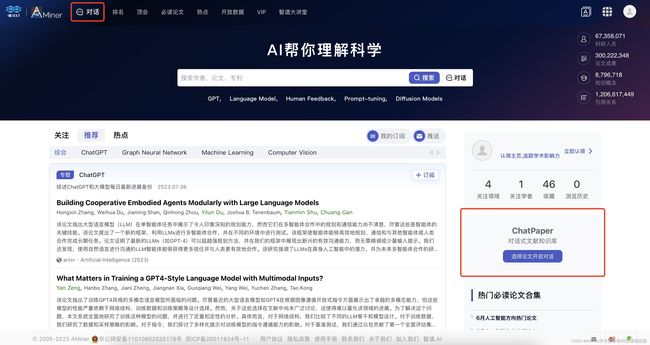

如何使用ChatPaper?

使用ChatPaper的方法很简单,打开AMiner首页,从页面顶部导航栏或者右下角便可进入ChatPaper页面。

在ChatPaper页面中,可以选择基于单篇文献进行对话和基于全库(个人文献库)对话,可选择上传本地PDF或者直接在AMiner上检索文献。