CDH6配置Flink(编译安装)

一、环境

CDH 6.1.1(Hadoop 3.0.0)、Flink 1.10.1、Centos7.4、Maven3.6.3、Scala-2.12和CDH的原生jdk1.8

二、安装包

1.flink1.10.1 tar包

https://archive.apache.org/dist/flink/flink-1.10.1/flink-1.10.1-src.tgz

其他版本可以通过该方法下载资源

2.flink-shaded

https://mirrors.tuna.tsinghua.edu.cn/apache/flink/flink-shaded-10.0/flink-shaded-10.0-src.tgz

3.Maven版本

https://mirror.bit.edu.cn/apache/maven/maven-3/3.6.3/binaries/apache-maven-3.6.3-bin.tar.gz

三、安装Maven

1.下载并解压maven的安装包

命令: tar -xf apache-maven-3.6.3-bin.tar

2.配置maven环境变量

命令:1.vi /etc/profile

2.source /etc/profile

并查看maven是否配置成功,命令:mvn --version

3.修改setting.xml文件(conf目录下)

配置内容如下(注意可能需要删掉前后的标签):

alimaven

central

alimaven

central

central

central

repo2

central

ibiblio

central

jboss-public-repository-group

central

http://repository.jboss.org/nexus/content/groups/public

google-maven-central

central

<!-- 中央仓库在中国的镜像 -->

maven.net.cn

central

四、编译flink-shaded版本

1.解压tar包

命令:tar -xf flink-shaded-10.00-src.tar

2.修改pom.xml文件

命令:vi flink-shaded-10.0/pom.xml

在里面的profiles中添加如下配置参数:

vendor-repos

vendor-repos

<!-- Add vendor maven repositories -->

cloudera-releases

https://repository.cloudera.com/artifactory/cloudera-repos

true

false

<!-- Hortonworks -->

HDPReleases

false true HortonworksJettyHadoop

https://repo.hortonworks.com/content/repositories/jetty-hadoop

false true mapr-releases

false true 3.编译

进入到flink-shaded-10文件夹下执行一下命令:

mvn clean install -DskipTests -Pvendor-repos -Dhadoop.version=3.0.0-cdh6.1.1 -Dscala-2.12 -Drat.skip=true -T10C

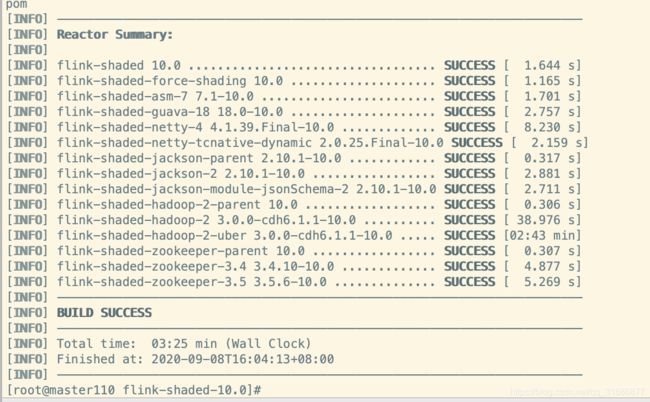

本次编译失败了一次,用时30分钟,网络因素会影响编译速度,如果失败了只需 重新输入该命令,重新编译即可。最后编译成功。

五、编译Flink1.10.1源码

1.解压tar包

命令: tar -xf flink-1.10.1-src.tgz

2.编译

命令:1.cd flink-1.10.1

2.mvn clean install -DskipTests -Dfast -Drat.skip=true -Dhaoop.version=3.0.0-cdh6.1.1 -Pvendor-repos -Dinclude-hadoop -Dscala-2.12 -T10C

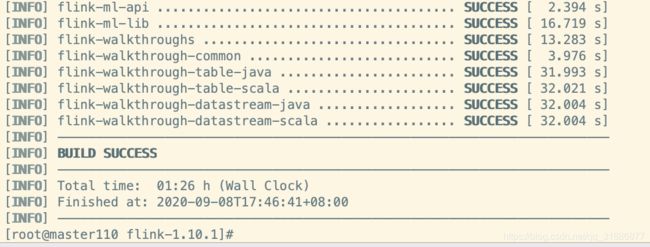

编译结果:build success

第一次在3台公司的集群编译花了56分钟,这次在项目集群编译。所以时间不会短,可以去干点别的,抽空看看有没有断掉。

3.打包编译好的文件

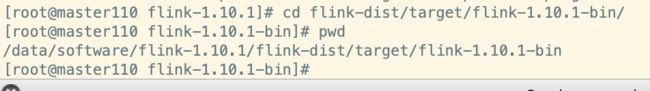

路径:flink-dist/target/flink-1.10.1-bin/

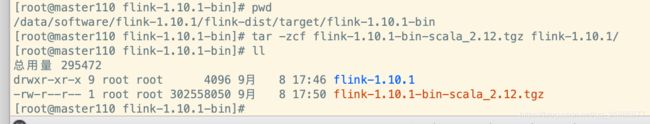

*注意:我们是基于scala2.12编译的,压缩包的名称必须是:flink-1.10.1-bin-scala_2.12.tgz*

打包命令:tar -zcf flink-1.10.1-bin-scala_2.12.tgz flink-1.10.1/

六、制作flink-parcel文件

1.安装git

yum -y install git

2.下载制作包

mkdir -p /data/software/flink

cd /data/software/flink

git clone https://github.com/pkeropen/flink-parcel.git

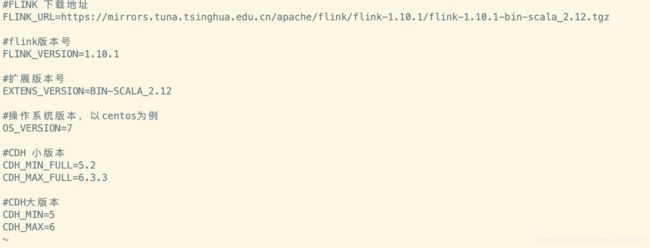

3.修改配置文件 flink-parcel.properties

根据自己的配置情况做修改

命令:cd flink-parcel

vi flink-parcel.properties

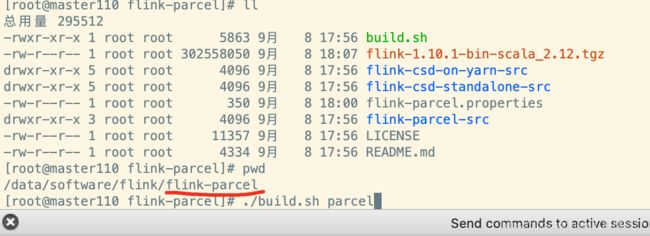

4.生成parcel文件

此时build.sh的权限为-rw-r–r--,需要修改权限,命令:chmod 755 build.sh

5.将上面打包好的***flink-1.10.1-bin-scala_2.12.tgz放到根目录中***

6.编译parcel

命令:./build.sh parcel

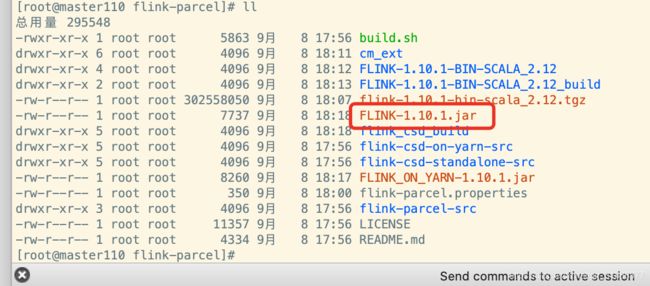

7.生成csd文件

on yarn版本 命令:./build.sh csd_on_yarn

standalone版本 命令:./build.sh csh_standalone

8.将生成的csd文件,复制到cloudera-manager-server服务所在节点的/opt/cloudera/csd目录下

命令: cp FLINK-1.10.1.jar FLINK_ON_YARN-1.10.1.jar /opt/cloudera/csd/

9.将parcel包和manidest.json文件部署到httpd服务中

命令:mkdir /var/www/html/flink-1.10.1

cp FLINK-1.10.1-BIN-SCALA_2.12_build/* /var/www/html/flink-1.10.1/

10.创建repodata,并查看页面是否可以访问

命令:createrepo .

*注意:如果连接访问不了 需要查看httpd服务是否开启或者直接执行 systemctl restart httpd 再刷新页面就可以了*

11.配置parcel存储库

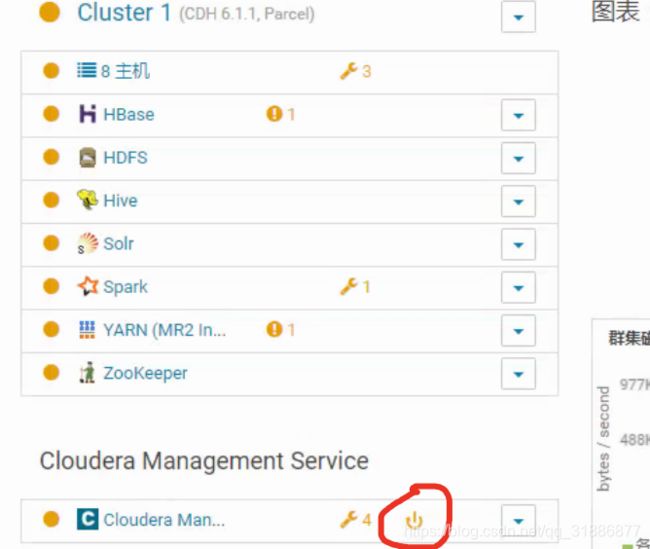

重启cloudera-scm-server,并登录Cloudera Manager管理界面,点击主机,进入parcel界面

命令:systemctl restart cloudera-scm-server

12.添加Flink的parcel地址

新增一栏,添加上六-10中的flink地址

13.重启Cloudera Management Service服务

七、flink下载分发激活

1.界面注意事项

有可能会提示Parcel FLINK-1.10.1-BIN-SCALA_2.12-el7.parcel 的错误:哈希验证失败。如若没有可忽略。

1.文件的哈希值不对,如果不一样就sha1sum后的值更新到.sha文件中

2.如果上图hash值是对的,依然上面的错

命令:vi /etc/httpd/conf/httpd.conf

添加此内容,然后重启httpd服务,命令:systemctl restart httpd

2.下载后点击分配

3.分配后激活

此时,flink可以正常添加服务

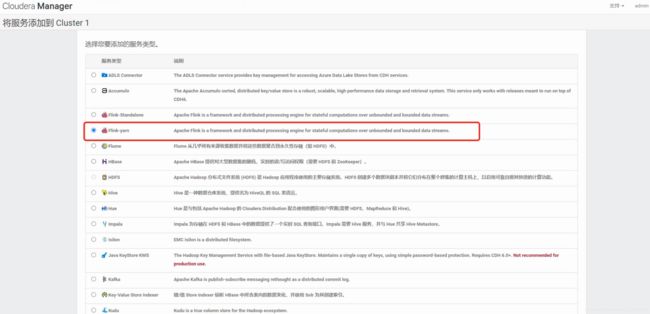

八、部署Flink-yarn服务

如果CDH集群没有应用到kerberos,不要删掉这两个里面的内容,否则安装会失败

添加完成

注意可能出现的问题:Error found before invoking supervisord: ‘getpwnam(): name not found: flink’

![]()

解决方法:在添加Flink-yarn服务所在的节点添加flink用户和角色

命令:groupadd flink

useradd flink -g flink

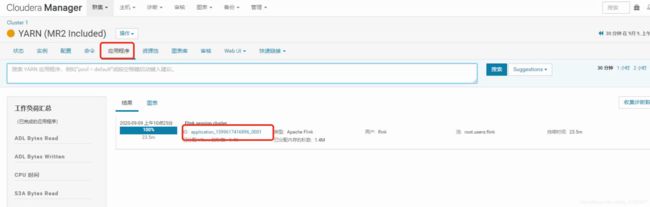

九、登录flink web ui界面

1.进入yarn,点击应用程序,并点击flink的id,进入

此时,可以得知我的flink界面的地址是我的slave3的地址,而不是我的master的地址,端口是8081。需要根据该方式,找到自己的地址和端口号。