20211001:Trick篇-MixConv

论文:MixConv: Mixed Depthwise Convolutional Kernels

论文: https://arxiv.org/abs/1907.09595

代码:https://github.com/linksense/MixNet-PyTorch[非官方]

代码:https://github.com/leaderj1001/Mixed-Depthwise-Convolutional-Kernels [非官方]

Trick:

谷歌出品,轻量化网络,值得学习借鉴

要点记录:

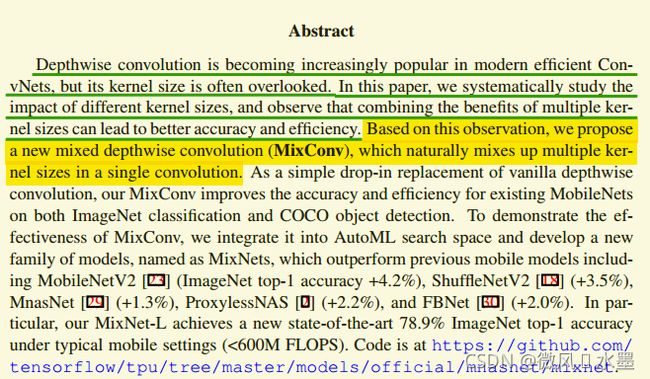

1:开门见山:平常只关注depth-wise有效,却忽略了depth-wise的kernel size问题

-----------------------------------------------------------------------------------------------------------------

要点记录:

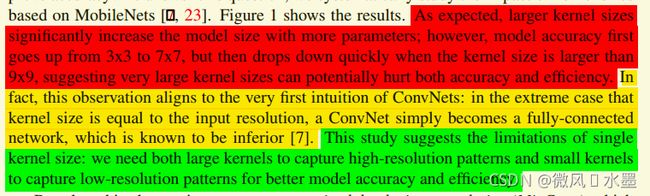

1:很显然,一定程度上,增加kernel size是可以提升acc的,但flops也随之增加。继续增大,精度反而下降。

-----------------------------------------------------------------------------------------------------------------

要点记录:

1:large kernel size具有更多参数,会显著增加模型size。

2:极端情况下,kernel size = input resolution时,ConvNet就变成了一个fully-connected network.

3:即需要large kernel size 来捕获高分辨率patterns,也需要small kernel size来捕获第分辨率patterns。这样的可以均衡精度和效率。

-----------------------------------------------------------------------------------------------------------------

要点记录:

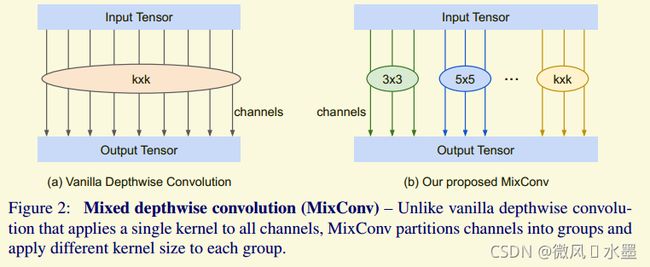

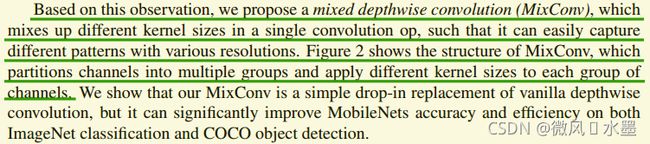

1:上图就是作者提出的MixConv,和Inception的思想很像。对channel分组,分别使用不同大小的卷积核,使得在同一层捕获不同分辨率的patterns.

-----------------------------------------------------------------------------------------------------------------

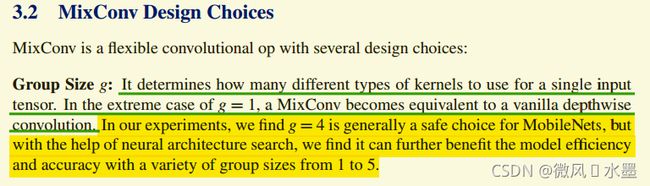

要点记录:

1:Group Size:通过实验发现g=4就很好了。通过NAS发现1-5的变化组合效果更好

-----------------------------------------------------------------------------------------------------------------

要点记录:

1:Kernel Size per Group:从3x3开始,逐步加2。即3x3, 5x5, 7x7...

-----------------------------------------------------------------------------------------------------------------

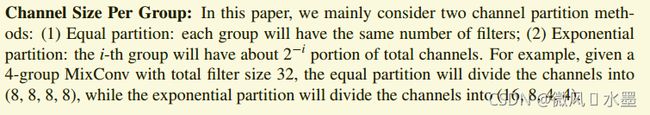

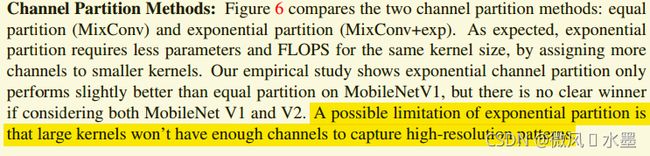

要点记录:

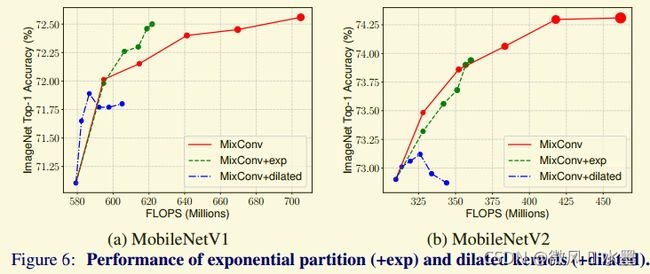

1:Channel Size Per Group:均分就ok。指数划分,造成large kernel size的数目偏少,学习能力下降。

-----------------------------------------------------------------------------------------------------------------

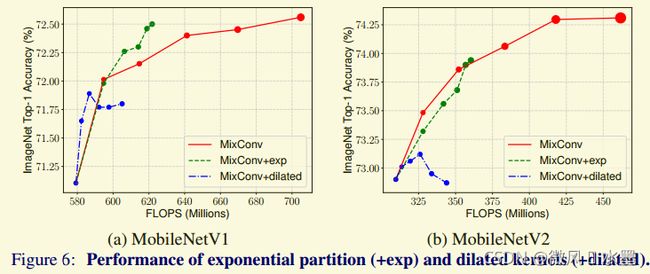

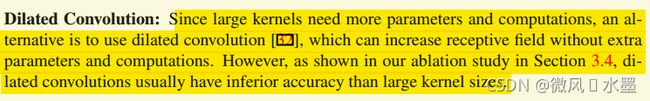

1:Dilated Convolution:大卷积核使用孔洞卷积,容易丢失局部细节,造成精度下降

-----------------------------------------------------------------------------------------------------------------

要点记录:

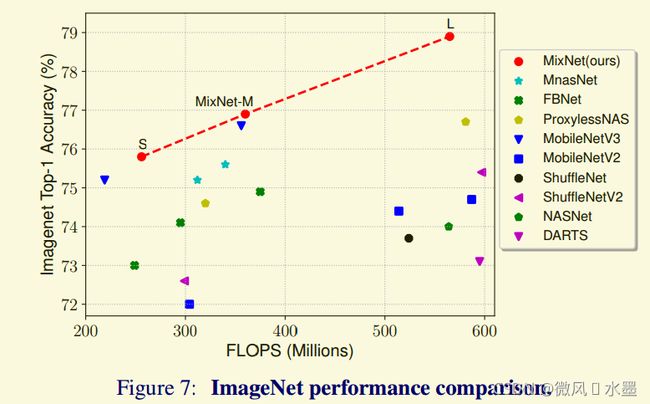

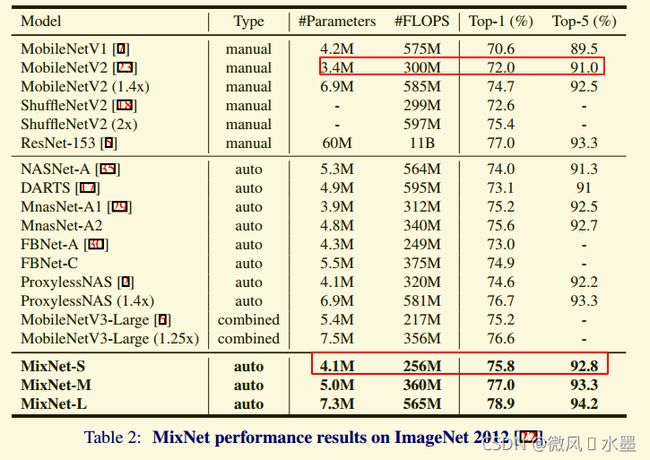

1:从图表上看,效果确实不错,后面在活体任务上验证一下效果

-----------------------------------------------------------------------------------------------------------------

要点记录:

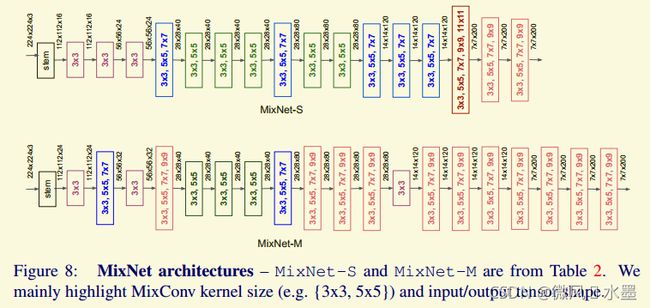

1:网络浅层使用小卷积核来节省计算量;网络深层使用大卷积核来提升精度

-----------------------------------------------------------------------------------------------------------------

要点记录:

1:从这个图上看,确实值的一试。等我验证了,回来补坑。