2023 批量下载公众号文章内容/话题/图片/封面/视频/音频,导出文章pdf,抓取文章数据包含阅读数/点赞数/在看数/留言数...

分享下我开发的几个公众号文章下载工具,持续更新,有问题欢迎反馈。

公众号文章内容/音频/视频下载

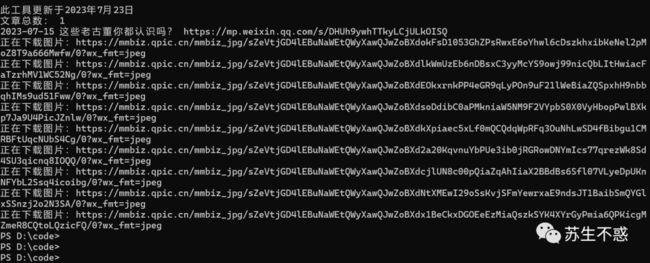

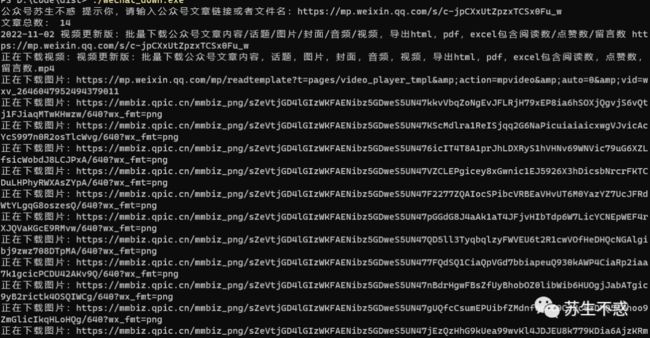

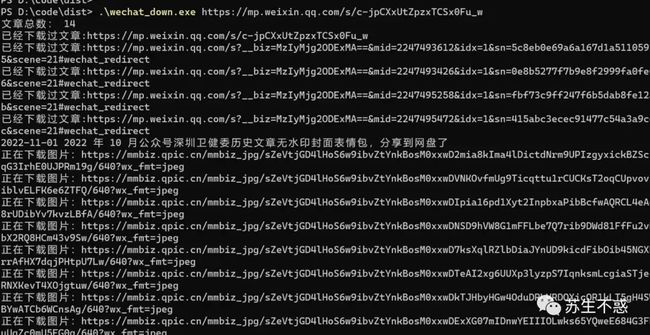

首先在公众号苏生不惑后台回复 公众号 获取工具下载地址,这次增加了下载文件里的公众号文章,打开wechat_down.exe输入文章地址即可下载文章和文章里的文章,比如这篇文章链接视频更新版:批量下载公众号文章内容/话题/图片/封面/音频/视频,导出html,pdf,excel包含阅读数/点赞数/留言数 https://mp.weixin.qq.com/s/c-jpCXxUtZpzxTCSx0Fu_w ,下载效果如图:

图片消息的文章也支持下载了,比如我的这篇文章 这些老古董你都认识吗?

我之前还录制了个视频视频更新版:批量下载公众号文章内容/话题/图片/封面/音频/视频,导出html,pdf,excel包含阅读数/点赞数/留言数 :

下载的音频保存在audio目录,视频保存在video目录,封面保存在cover目录,图片保存在images目录,文章内容保存在html目录。

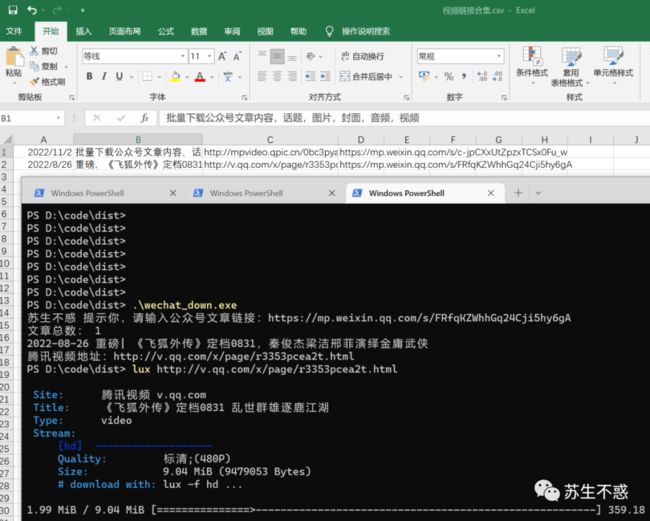

文章里引用的腾讯视频直接下载比较麻烦,所以保存视频链接到excel文件了,可以再复制视频链接用lux之类的工具下载。

下载过的文章链接在文件wechat_list.txt,第2次下载会跳过已经下载过的文章,如果有什么问题可以向我反馈。

公众号话题文章/音频/视频下载

还是在公众号苏生不惑后台回复 公众号 获取工具下载地址,比如这个公众号话题:

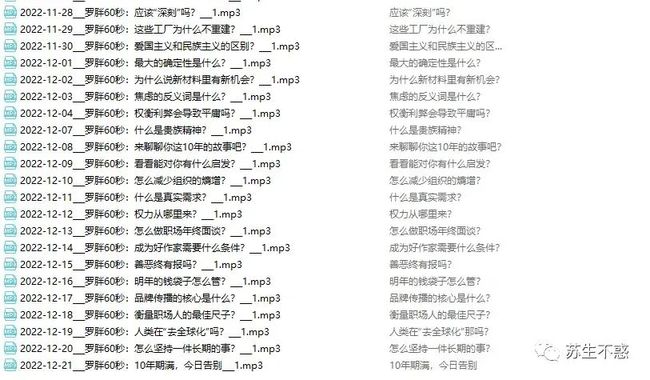

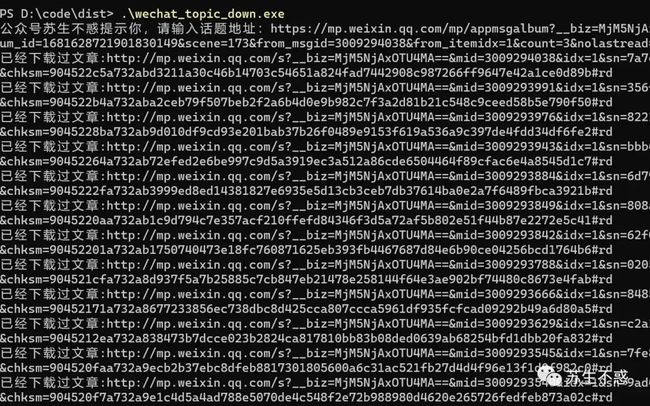

打开wechat_topic_down.exe输入话题链接批量下载话题里的文章,下载效果如图:

音频/视频和文章html都下载了:

下载过的文章链接在文件wechat_topic_list.txt,第2次下载会跳过已经下载过的文章,效果如图:

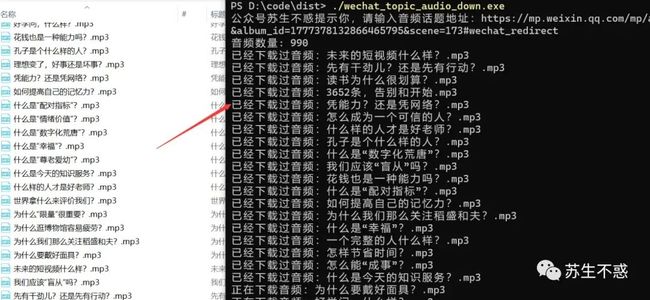

下载过的音频保存在文件wechat_topic_audio_list.txt ,如果第2次下载也会跳过已经下载过的音频,效果如图:

公众号模板文章/音频/视频下载

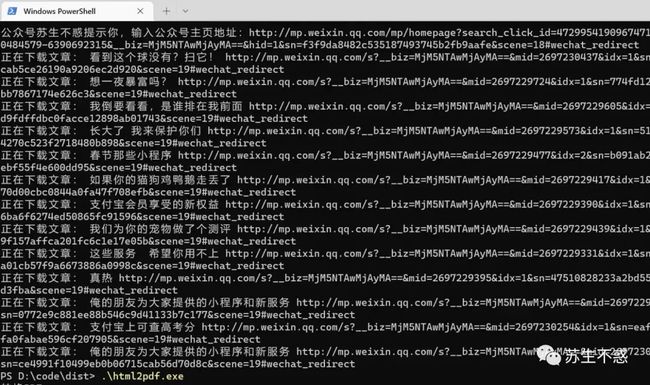

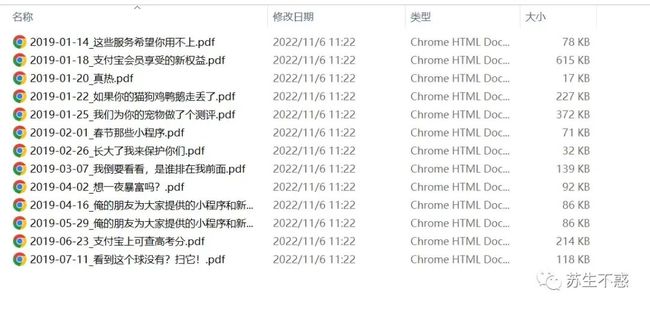

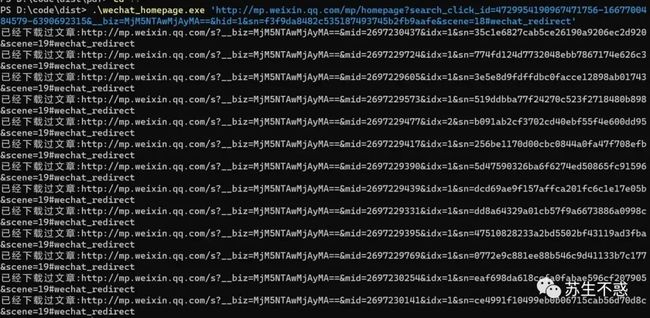

还是在公众号苏生不惑后台回复 公众号 获取工具下载地址,以支付宝这个模板页面为例: 打开wechat_homepage.exe输入地址,下载效果:

打开wechat_homepage.exe输入地址,下载效果:

还生成了一个文章列表excel文件,包含文章日期,文章标题,文章链接和文章封面。

还生成了一个文章列表excel文件,包含文章日期,文章标题,文章链接和文章封面。 第2次下载会跳过已经下载过的文章:

第2次下载会跳过已经下载过的文章:

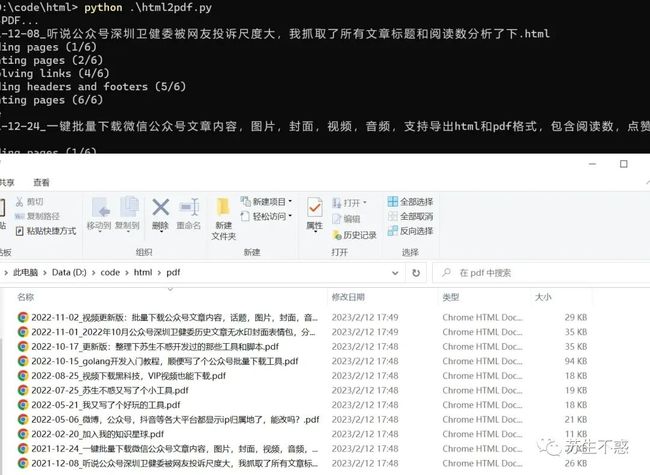

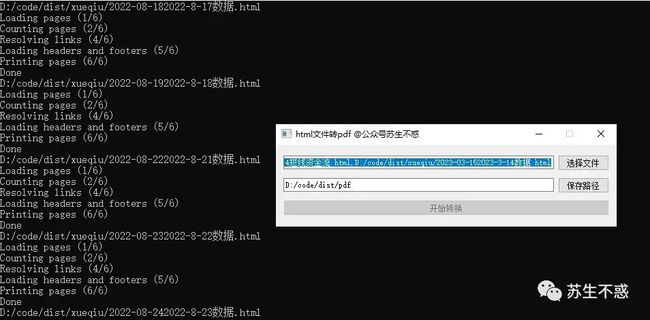

html和pdf转换

上面的工具只下载了文章html,如果想转pdf用我开发的html2pdf.exe可以将html批量转换为pdf,先打开https://wkhtmltopdf.org/downloads.html 下载安装再添加到环境变量,运行html2pdf.exe就可以了,批量转换后的pdf文件保存在pdf目录。 不过现在公众号网页改为动态加载,用这个转换生成的pdf是空白的

不过现在公众号网页改为动态加载,用这个转换生成的pdf是空白的wkhtmltopdf.exe https://mp.weixin.qq.com/s/c-jpCXxUtZpzxTCSx0Fu_w 视频更新版:批量下载公众号文章内容/话题/图片/封面/音频/视频,导出html,pdf,excel包含阅读数/点赞数/留言数.pdf转换生成的pdf是空白的,所以之前我用python写的html2pdf.exe也失效了。

现在是用pyppeteer 转换,不过它依赖chromium:

import pyppeteer.chromium_downloader

print('默认版本:{}'.format(pyppeteer.__chromium_revision__))

print('可执行文件默认路径:{}'.format(pyppeteer.chromium_downloader.chromiumExecutable.get('win64')))

print('win64平台下载链接为:{}'.format(pyppeteer.chromium_downloader.downloadURLs.get('win64')))在可执行文件默认路径新建目录588429,手动下载输出的chrome-win32.zip解压后放进去。

可执行文件默认路径:C:\Users\xxx\AppData\Local\pyppeteer\pyppeteer\local-chromium\588429\chrome-win32\chrome.exe

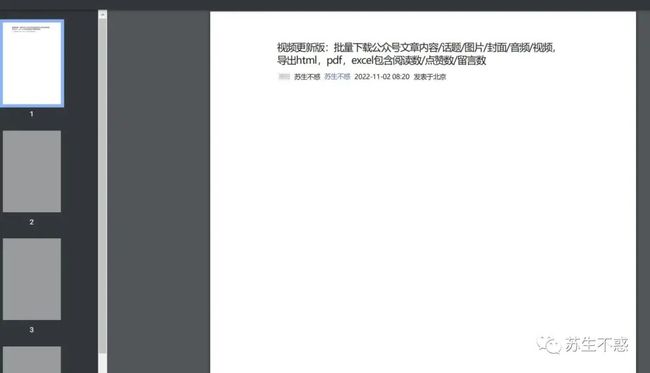

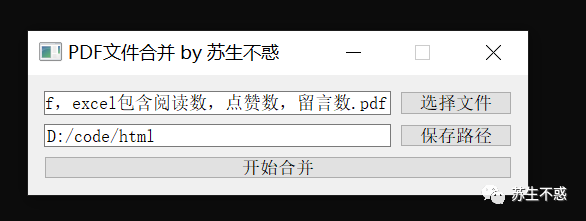

win64平台下载链接为:https://storage.googleapis.com/chromium-browser-snapshots/Win_x64/588429/chrome-win32.zip转换后的pdf就可以用我开发的这个pdf_merge.exe将所有合成一个pdf文件苏生不惑又写了个pdf合并带书签小工具 ,效果:

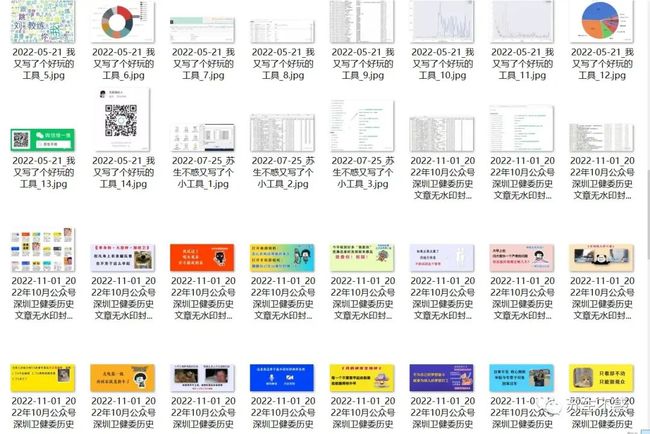

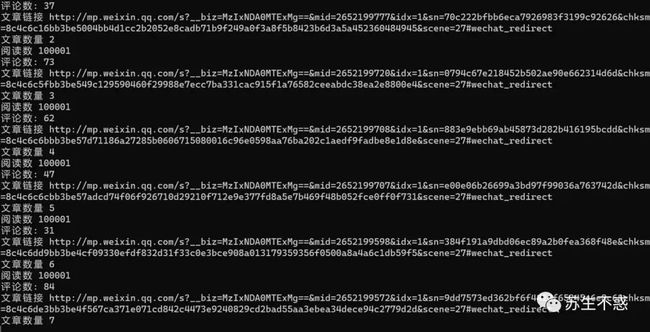

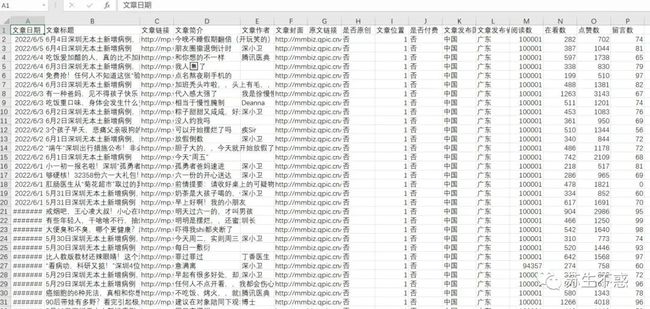

批量下载公众号历史文章内容和数据

上面的工具只能下载部分文章,为了下载一个号的所有文章,我写了个脚本批量下载某个公众号的所有历史文章批量下载公众号文章内容/话题/图片/封面/音频/视频,导出html,pdf,excel包含阅读数/点赞数/在看数/留言数/赞赏数 ,下载效果如图: 下载的excel文章数据包含文章日期,文章标题,文章链接,文章简介,文章作者,文章封面图,是否原创,IP归属地,阅读数,在看数,点赞数,留言数,赞赏次数,视频数,音频数等,比如深圳卫健委2022年的1000多篇文章阅读数都是10万+,excel数据分析见这篇文章2022年过去,抓取公众号阅读数点赞数在看数留言数做数据分析, 以深圳卫健委这个号为例 。

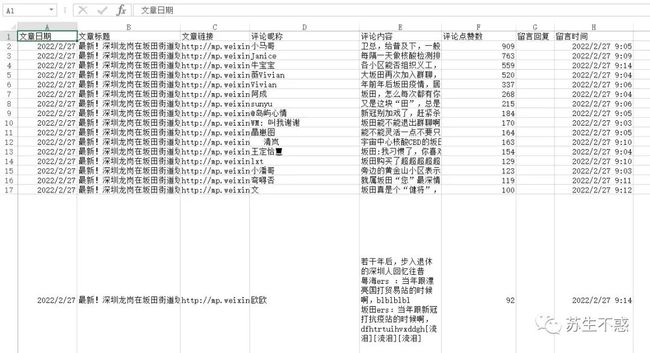

下载的excel文章数据包含文章日期,文章标题,文章链接,文章简介,文章作者,文章封面图,是否原创,IP归属地,阅读数,在看数,点赞数,留言数,赞赏次数,视频数,音频数等,比如深圳卫健委2022年的1000多篇文章阅读数都是10万+,excel数据分析见这篇文章2022年过去,抓取公众号阅读数点赞数在看数留言数做数据分析, 以深圳卫健委这个号为例 。

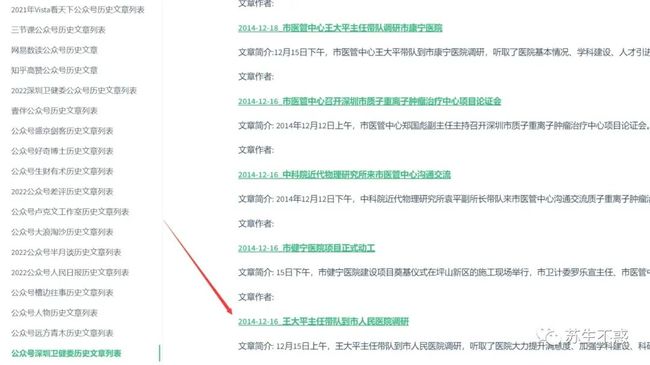

为了方便找文章,部分公众号的历史文章同步到了我的博客https://sushengbuhuo.github.io/blog ,持续更新中,不用在手机上下拉翻历史文章了 ,比如深圳卫健委从2014到2023发布了1万多篇文章,第一篇文章很快找到:

另外每个月我还会更新一次公众号深圳卫健委的封面表情包图,无水印,欢迎收藏 2022 年公众号深圳卫健委所有历史文章无水印封面表情包合集,分享到网盘了,所有封面图的文件名为文章发布日期加标题,方便搜索,在公众号苏生不惑后台回复 封面 获取这个号2019-2023年的所有封面图 。 每篇文章下的留言内容也可以单独导出excel,包含文章日期,文章标题文章链接,留言昵称,留言内容,点赞数,回复和留言时间,比如深圳卫健委在2月份就有1万6千多条留言,如果你有需要下载的公众号或抓取公众号文章数据可以加微信sushengbuhuo联系我。

每篇文章下的留言内容也可以单独导出excel,包含文章日期,文章标题文章链接,留言昵称,留言内容,点赞数,回复和留言时间,比如深圳卫健委在2月份就有1万6千多条留言,如果你有需要下载的公众号或抓取公众号文章数据可以加微信sushengbuhuo联系我。

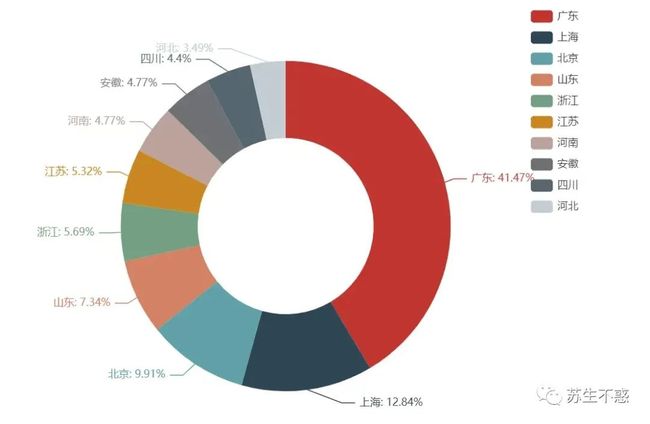

顺便分析下文章留言区的ip归属地,我的公众号留言区广东的小伙伴最多微博/公众号/抖音等各大平台都显示 ip 归属地了,能改吗?

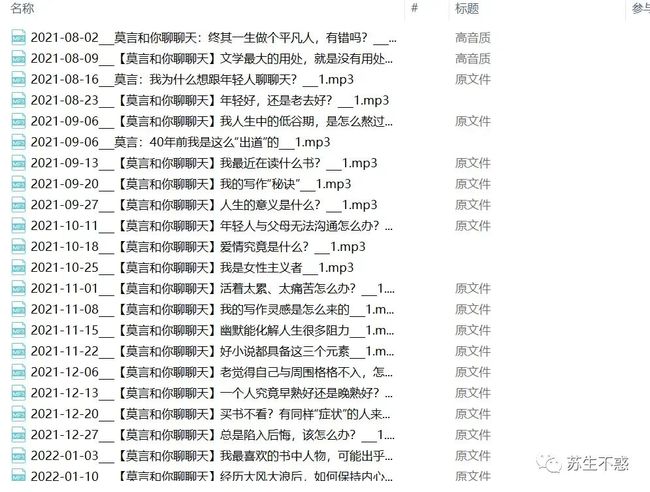

下载所有文章以莫言老师的公众号为例,包括文章内容(含留言),音频和视频 :

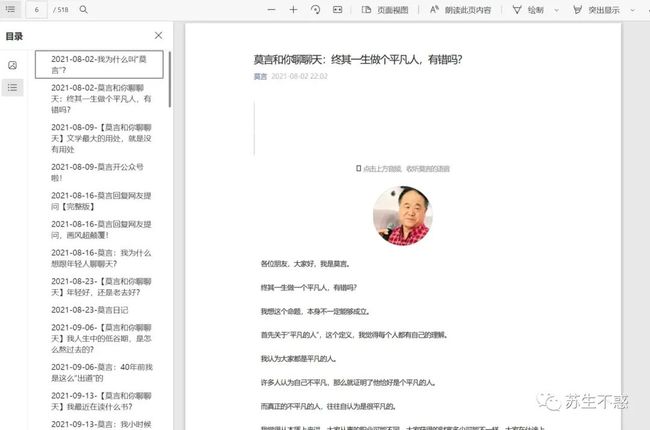

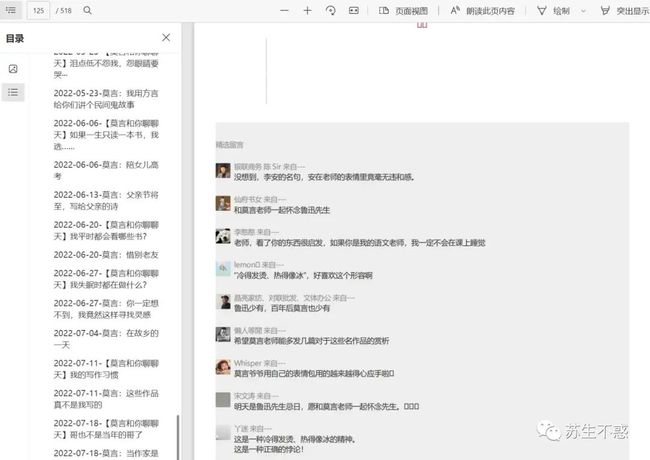

最后将所有文章合并成一个pdf文件(含留言,效果见网盘 https://www.aliyundrive.com/s/Q6L8wUwFZmi ),点击左侧书签跳转到对应文章,在电脑和手机上看方便多了,也不用担心文章被删看不了:

如果文章对你有帮助还请

点赞/在看/分享三连支持下, 感谢各位!