四十三、Kafka的安装部署与基本操作

上篇文章我们简单介绍了一下Kafka相关的知识,这篇文章我们来实际的安装一下Kafka并进行一下基本的操作。关注专栏《破茧成蝶——大数据篇》,查看更多相关的内容~

目录

一、安装Kafka

1.1 安装包准备

1.2 解压

1.3 修改配置文件

1.4 配置环境变量

1.5 分发安装包并配置其余节点的环境变量

1.6 修改其余节点的broker id

1.7 启动Kafka集群

二、Kafka基本操作

一、安装Kafka

1.1 安装包准备

首先需要去Kafka的官网下载Kafka的安装包,请戳这里进行下载。

将下载的好的tar包上传到服务器中,这里我们放到/opt/software目录下:

1.2 解压

解压安装包,并修改名称为kafka:

tar -zxvf ./kafka_2.11-0.11.0.2.tgz -C ../modules/

mv kafka_2.11-0.11.0.2 kafka1.3 修改配置文件

在kafka的config目录下修改server.properties配置文件:

############################# Server Basics #############################

# The id of the broker. This must be set to a unique integer for each broker.

broker.id=0

# Switch to enable topic deletion or not, default value is false

delete.topic.enable=true

############################# Log Basics #############################

# A comma seperated list of directories under which to store log files

log.dirs=/opt/modules/kafka/logs

############################# Zookeeper #############################

# Zookeeper connection string (see zookeeper docs for details).

# This is a comma separated host:port pairs, each corresponding to a zk

# server. e.g. "127.0.0.1:3000,127.0.0.1:3001,127.0.0.1:3002".

# You can also append an optional chroot string to the urls to specify the

# root directory for all kafka znodes.

zookeeper.connect=master:2181,slave01:2181,slave02:2181在kafka目录下新建logs目录用来存放日志信息:

mkdir logs1.4 配置环境变量

vim /etc/profile

##KAFKA_HOME

export KAFKA_HOME=/opt/modules/kafka

export PATH=$PATH:$KAFKA_HOME/bin

source /etc/profile1.5 分发安装包并配置其余节点的环境变量

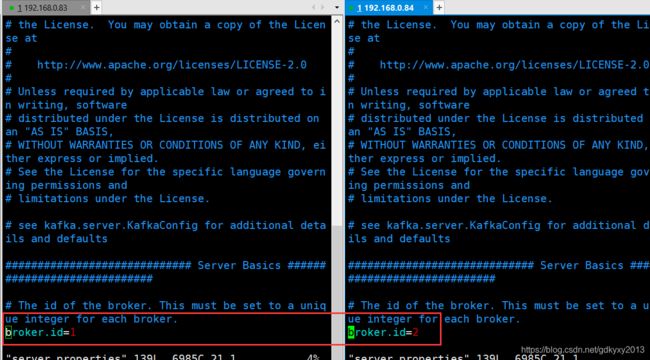

[root@master modules]# xsync kafka/1.6 修改其余节点的broker id

1.7 启动Kafka集群

这里需要注意的是:启动Kafka集群之前,需要先启动Zookeeper,使用如下命令启动Zookeeper:

bin/zkServer.sh start使用如下命令启动Kafka集群:

bin/kafka-server-start.sh -daemon config/server.properties使用如下命令停止Kafka集群:

bin/kafka-server-stop.sh stop二、Kafka基本操作

1、查看集群中的topic

kafka-topics.sh --zookeeper master:2181 --list

2、创建topic

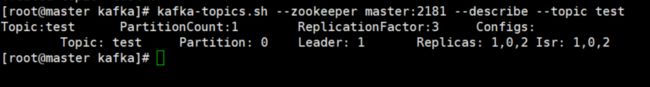

kafka-topics.sh --zookeeper master:2181 --create --replication-factor 3 --partitions 1 --topic test3、查看topic的详细情况

kafka-topics.sh --zookeeper master:2181 --describe --topic test4、生产消费数据

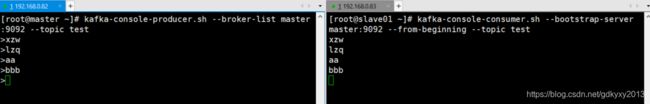

使用如下命令启动生产者:

kafka-console-producer.sh --broker-list master:9092 --topic test使用如下命令启动消费者:

kafka-console-consumer.sh --bootstrap-server master:9092 --from-beginning --topic test生产消费数据如下所示:

其中需要注意的是,--from-beginning参数会把主题中以往所有的数据都读取出来。

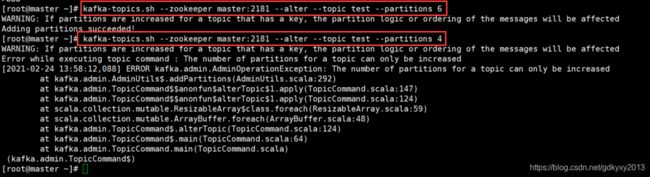

5、修改分区数

kafka-topics.sh --zookeeper master:2181 --alter --topic test --partitions 6这里需要注意的是,分区数只能增加,不能减少。

6、删除topic

kafka-topics.sh --zookeeper master:2181 --delete --topic test

本文到此已经接近尾声了,本文主要讲述了Kafka的安装以及一些基本操作。你们在此过程中遇到了什么问题,欢迎留言,让我看看你们都遇到了哪些问题~