- 【人工智能】大模型的幻觉问题:DeepSeek 的解决策略与实践

蒙娜丽宁

Python杂谈人工智能人工智能

《PythonOpenCV从菜鸟到高手》带你进入图像处理与计算机视觉的大门!解锁Python编程的无限可能:《奇妙的Python》带你漫游代码世界大语言模型(LLM)的“幻觉”问题,即模型生成与事实不符或脱离上下文的内容,是限制其广泛应用的关键挑战之一。本文深入探讨了幻觉问题的成因,包括训练数据的偏差、推理过程中的过度泛化以及缺乏外部验证机制。以DeepSeek系列模型为研究对象,我们分析了其在解

- HCIA-AI人工智能笔记3:数据预处理

噗老师

华为认证人工智能笔记wpf数据处理AI华为认证

统讲解数据预处理的核心技术体系,通过Python/Pandas与华为MindSpore双视角代码演示,结合特征工程优化实验,深入解析数据清洗、标准化、增强等关键环节。一、数据预处理技术全景图graphTDA[原始数据]-->B{数据清洗}B-->B1[缺失值处理]B-->B2[异常值检测]B-->B3[重复值删除]A-->C{特征工程}C-->C1[标准化/归一化]C-->C2[离散化分箱]C--

- PyTorch基础知识讲解(一)完整训练流程示例

苏雨流丰

机器学习pytorch人工智能python机器学习深度学习

文章目录Tutorial1.数据处理2.网络模型定义3.损失函数、模型优化、模型训练、模型评价4.模型保存、模型加载、模型推理Tutorial大多数机器学习工作流程涉及处理数据、创建模型、优化模型参数和保存训练好的模型。本教程向你介绍一个用PyTorch实现的完整的ML工作流程,并提供链接来了解这些概念中的每一个。我们将使用FashionMNIST数据集来训练一个神经网络,预测输入图像是否属于以下

- 机器学习中的贝叶斯网络:如何构建高效的风险预测模型

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型自然语言处理人工智能语言模型编程实践开发语言架构设计

作者:禅与计算机程序设计艺术文章目录机器学习中的贝叶斯网络:如何构建高效的风险预测模型1.背景介绍2.基本概念术语说明2.1马尔科夫随机场(MarkovRandomField)2.2条件随机场(ConditionalRandomField,CRF)2.3变量elimination算法2.4贝叶斯网络3.核心算法原理和具体操作步骤以及数学公式讲解3.1原理介绍1.贝叶斯网络基础2.贝叶斯网络构建风险

- AI进化论:从图灵测试到智能革命的临界点

A达峰绮

人工智能数据处理经验分享AIGCAI人工智能

智能觉醒的起源密码(1943-2010)在曼彻斯特维多利亚大学的实验室里,1948年"Baby"计算机完成人类首个存储程序运行实验时,艾伦·图灵正在构思《计算机器与智能》。这篇划时代论文提出的"模仿游戏"测试,为人工智能奠定了哲学基础。1956年达特茅斯会议上,麦卡锡正式提出"人工智能"概念,当时学界乐观预测"二十年内机器将完成人类所有工作"。神经网络的发展轨迹充满戏剧性:1958年罗森布拉特发明

- AI时代个人财富增长实战指南:从零基础到精通变现的完整路径

A达峰绮

人工智能

(本文基于人工智能技术发展规律,结合互联网经济底层逻辑,为普通从业者构建系统性AI应用框架)一、建立AI认知基础:技术理解与工具掌握技术分类认知人工智能工具分为四大功能模块:自然语言处理(文本生成、对话交互)、计算机视觉(图像视频处理)、数据分析(预测建模)、自动化控制(流程优化)。建议新手首先掌握语言类工具的基础操作,逐步扩展到其他领域。工具操作逻辑通用AI工具通常包含三大核心功能模块:输入界面

- 大语言模型学习路线:从入门到实战

大模型官方资料

语言模型学习人工智能产品经理自然语言处理搜索引擎

大语言模型学习路线:从入门到实战在人工智能领域,大语言模型(LargeLanguageModels,LLMs)正迅速成为一个热点话题。本学习路线旨在为有基本Python编程和深度学习基础的学习者提供一个清晰、系统的大模型学习指南,帮助你在这一领域快速成长。本学习路线更新至2024年02月,后期部分内容或工具可能需要更新。适应人群已掌握Python基础具备基本的深度学习知识学习步骤本路线将通过四个核

- 景联文科技入选中国信通院发布的“人工智能数据标注产业图谱”

景联文科技

科技人工智能

近日,由中国信息通信研究院、中国人工智能产业发展联盟牵头,联合中国电信集团、沈阳市数据局、保定高新区等70多家单位编制完成并发布《人工智能数据标注产业图谱》。景联文科技作为人工智能产业关键环节的代表企业,入选图谱中技术服务板块。图谱按照国家数据局技术创新、行业赋能、生态培育、标准应用、人才就业、数据安全等六个方面任务展开,由上游资源提供方、中游数据标注核心服务方、下游配套支撑方三部分组成。其中上游

- 使用 Milvus 进行向量数据库管理与实践

qahaj

milvus数据库python

技术背景介绍在当今的AI与机器学习应用中,处理和管理大量的嵌入向量是一个常见的需求。Milvus是一个开源向量数据库,专门用于存储、索引和管理深度神经网络以及其他机器学习模型生成的大规模嵌入向量。它的高性能和易用性使其成为处理向量数据的理想选择。核心原理解析Milvus的核心功能体现在其强大的向量索引和搜索能力。它支持多种索引算法,包括IVF、HNSW等,使其能够高效地进行大规模向量的相似性搜索操

- 物理学不存在了?诺贝尔物理学奖颁给了人工智能

资讯新鲜事

人工智能

2024年10月8日,瑞典皇家科学院宣布,将2024年诺贝尔物理学奖授予美国普林斯顿大学教授约翰·J·霍普菲尔德(JohnJ.Hopfield)和加拿大多伦多大学教授杰弗里·E·辛顿(GeoffreyE.Hinton),以表彰他们“在人工神经网络机器学习方面的基础性发现和发明”。辛顿在接受电话采访时表示:“完全没想到”。实话实说,在结果出来前,大家也都没想到。因为在外界预测里,今年的诺贝尔物理学奖

- 今日行情明日机会——20250321

人大博士的交易之路

人工智能区块链数学建模数据挖掘分类涨停回马枪大数据

后续投资机会分析结合2025年3月21日盘面数据(涨停56家,跌停31家),市场呈现结构性分化行情,海洋经济成为绝对主线,机器人概念局部活跃,人工智能表现较弱。以下是具体方向与策略建议:1.海洋经济(核心主线,政策+事件驱动)核心逻辑:板块23家涨停,梯队完整(七板至一板),神开股份(七板)打开高度,叠加海洋资源开发、碳中和政策(如海上风电、深海装备)催化,资金深度介入。大连重工(三板,海洋工程装

- 人工智能革命:技术演进图谱与人类文明重构路径

A达峰绮

人工智能重构经验分享图形绘制数据处理AI

当GPT-4在2023年3月通过注册会计师考试时,其财务分析模块展现的推理能力已超越85%的人类考生。这个标志性事件背后,折射出人工智能正在突破认知型工作的最后防线。我们正在见证的,不仅是技术迭代,更是人类文明范式的根本性转变。一、算力奇点降临:AI基础设施的指数级进化量子计算与神经形态芯片的融合正在重塑算力边界。IBM最新数据显示,其量子体积(QuantumVolume)从2020年的64跃升至

- PHP 爬虫实战:爬取淘宝商品详情数据

EcomDataMiner

php爬虫开发语言

随着互联网技术的发展,数据爬取越来越成为了数据分析、机器学习等领域的重要前置技能。而在这其中,爬虫技术更是不可或缺。php作为一门广泛使用的后端编程语言,其在爬虫领域同样也有着广泛应用和优势。本文将以爬取斗鱼直播数据为例,介绍php爬虫的实战应用。准备工作在开始爬虫之前,我们需要做一些准备工作。首先,需要搭建一个本地服务器环境,推荐使用WAMP、XAMPP等集成化工具,方便部署PHP环境。其次,我

- 比较分析:Windsurf、Cody、Cline、Roo Cline、Copilot 和 通义灵码

张3蜂

开源编程语言与开发技术选型与架构设计copilotc#AI编程

随着人工智能技术的快速发展,开发者工具变得越来越智能化,特别是在代码生成、辅助编程等领域,市面上涌现了多种AI驱动的工具。本文将从开源性、集成能力、功能覆盖范围、支持的编程语言、生态兼容性、成本、学习曲线、响应速度、离线支持以及与.NETCore的适配性等十个维度对以下几种产品进行比较:Windsurf、Cody、Cline、RooCline、Copilot和通义灵码。1.开源性Windsurf:

- 使用Aim追踪LangChain执行

bavDHAUO

langchainpython

在现代人工智能应用中,调试和可视化自动化工作流变得越来越重要,Aim正是为此而生。通过Aim,你可以轻松地追踪LangChain中语言模型(LLM)和工具的输入输出,以及代理的动作,从而在执行过程中快速定位和解决问题。此外,Aim还支持并排比较多个执行流程,使之成为调试中的得力助手。Aim是一个完全开源的项目,你可以在GitHub上找到更多关于Aim的信息。在本文中,我们将展示如何启用和配置Aim

- 利用Python和深度学习方法实现手写数字识别的高精度解决方案——从数据预处理到模型优化的全流程解析

快撑死的鱼

Python算法精解python深度学习开发语言

利用Python和深度学习方法实现手写数字识别的高精度解决方案——从数据预处理到模型优化的全流程解析在人工智能的众多应用领域中,手写数字识别是一项经典且具有重要实际应用价值的任务。随着深度学习技术的飞速发展,通过构建和训练神经网络模型,手写数字识别的精度已经可以达到99%以上。本文将以Python为主要编程语言,结合深度学习的核心技术,详细解析手写数字识别的实现过程,并探讨如何进一步优化模型以提高

- 强化学习中的深度卷积神经网络设计与应用实例

数字扫地僧

计算机视觉cnn人工智能神经网络

I.引言强化学习(ReinforcementLearning,RL)是机器学习的一个重要分支,通过与环境的交互来学习最优策略。深度学习,特别是深度卷积神经网络(DeepConvolutionalNeuralNetworks,DCNNs)的引入,为强化学习在处理高维度数据方面提供了强大工具。本文将探讨强化学习中深度卷积神经网络的设计原则及其在不同应用场景中的实例。II.深度卷积神经网络在强化学习中的

- 腾讯云大模型知识引擎与DeepSeek:打造懒人专属的谷歌浏览器翻译插件

大富大贵7

程序员知识储备1程序员知识储备2程序员知识储备3腾讯云云计算

摘要:随着人工智能技术的飞速发展,越来越多的前沿技术和工具已走入日常生活。翻译工具作为跨语言沟通的桥梁,一直处于技术创新的风口浪尖。本文探讨了腾讯云大模型知识引擎与DeepSeek结合谷歌浏览器插件的可能性,旨在为用户提供一种便捷、高效的翻译体验。通过应用深度学习、自然语言处理和知识图谱技术,该插件不仅能实时翻译网页内容,还能根据上下文进行智能推荐,实现精准的语境转换。本文将详细阐述其设计思路、技

- DeepSeek 模型未来怎么走?技术创新、行业落地全解析!

网罗开发

AI大模型人工智能人工智能职场和发展

网罗开发(小红书、快手、视频号同名) 大家好,我是展菲,目前在上市企业从事人工智能项目研发管理工作,平时热衷于分享各种编程领域的软硬技能知识以及前沿技术,包括iOS、前端、HarmonyOS、Java、Python等方向。在移动端开发、鸿蒙开发、物联网、嵌入式、云原生、开源等领域有深厚造诣。图书作者:《ESP32-C3物联网工程开发实战》图书作者:《SwiftUI入门,进阶与实战》超级个体:CO

- 分享12个国内AI对话聊天的免费网站(含DeepSeek大模型)

码上飞扬

人工智能语言模型DeepSeek

在人工智能领域,基于对话的语言模型已成为当前研究的热点,其中以ChatGPT为代表的模型凭借其卓越的语言理解与交互能力备受瞩目。为帮助用户更好地选择和使用这类AI工具,本文将介绍12个国内可直接体验对话聊天功能的平台,为用户提供实用参考。1、腾讯元宝地址:https://hunyuan.tencent.com/bot/chat腾讯混元大模型是由腾讯全链路自研的通用大语言模型,拥有超千亿参数规模,预

- 《今日AI-人工智能-编程日报》-源自2025年3月21日

小亦编辑部

人工智能

一、AI编程领域最新动态AI编程工具崛起,程序员职业面临挑战Anthropic首席执行官DarioAmodei预言,未来一年内,90%的代码将由AI生成,传统程序员的工作可能被大幅替代。最新发布的AI编程模型(如Claude3.7、Sonnet3.7)在初级开发评估中表现优异,得分率超过60%,部分模型甚至在全球程序员排名中位列前0.1%。字节跳动的Trae海外版接入Claude3.7和GPT-4

- 《今日AI-人工智能-编程日报》-源自2025年3月19日

小亦编辑部

每日AI-人工智能-编程日报人工智能

1.豆包AI编程功能迎来三项重磅升级豆包平台今日宣布其AI编程功能迎来三项重要升级,包括:HTML实时预览:支持用户在编写HTML代码时实时查看网页效果,显著提升前端开发效率,尤其适用于小游戏和网页制作。Python代码直接运行与一键修复:用户可直接运行Python代码,并在出错时一键修复,极大降低了编程门槛,提升了开发效率。生成完整项目:新增生成完整项目的功能,帮助用户快速创建应用程序,缩短开发

- 模拟退火算法:原理、应用与优化策略

尹清雅

算法

摘要模拟退火算法是一种基于物理退火过程的随机搜索算法,在解决复杂优化问题上表现出独特优势。本文详细阐述模拟退火算法的原理,深入分析其核心要素,通过案例展示在函数优化、旅行商问题中的应用,并探讨算法的优化策略与拓展方向,为解决复杂优化问题提供全面的理论与实践指导,助力该算法在多领域的高效应用与创新发展。一、引言在现代科学与工程领域,复杂优化问题无处不在,如资源分配、路径规划、机器学习模型参数调优等。

- 普通人学习AI应该如何入手?2025年最新AI大模型学习路线+全套学习资料,适合新手小白!

小城哇哇

人工智能学习大数据语言模型AI大模型agiai

引言随着人工智能(AI)技术的飞速发展,越来越多的人开始意识到掌握这项技能的重要性。然而,对于许多没有编程背景或数学基础的人来说,进入AI领域似乎是一个遥不可及的梦想。但实际上,通过合理的规划和适当的学习资源,任何人都可以逐步掌握AI的核心知识,并应用到实际工作中去。本文将为普通读者提供一份详细的2025年最新AI大模型学习路线图,并附带一套完整的自学资料,帮助您从零基础起步,顺利开启AI学习之旅

- 知识蒸馏:让大模型“瘦身“而不失智慧的魔术

一休哥助手

人工智能人工智能

引言:当AI模型需要"减肥"在人工智能领域,一个有趣的悖论正在上演:大模型的参数规模每年以10倍速度增长,而移动设备的算力却始终受限。GPT-4的1750亿参数需要价值500万美元的GPU集群运行,但现实中的智能设备可能只有指甲盖大小。这种矛盾催生了一项神奇的技术——知识蒸馏(KnowledgeDistillation),它就像给AI模型进行"脑外科手术",将庞然大物的智慧浓缩到轻量模型中。第一章

- TensorFlow深度学习实战项目:从入门到精通

点我头像干啥

Ai深度学习tensorflow人工智能

引言深度学习作为人工智能领域的一个重要分支,近年来取得了显著的进展。TensorFlow作为Google开源的深度学习框架,因其强大的功能和灵活的架构,成为了众多开发者和研究者的首选工具。本文将带领大家通过一个实战项目,深入理解TensorFlow的使用方法,并掌握深度学习的基本流程。1.TensorFlow简介1.1TensorFlow是什么?TensorFlow是一个开源的机器学习框架,由Go

- 使用大语言模型API在AI应用中的实现

qq_37836323

人工智能语言模型自然语言处理python

随着人工智能技术的迅速发展,大语言模型(LLM)在自然语言处理(NLP)领域的应用越来越广泛。本文将介绍如何使用大语言模型API来实现一些基础的AI应用,并提供一个简单的demo代码,帮助大家更好地理解和使用这些技术。大语言模型API简介大语言模型(如GPT-4)能够理解和生成类似人类的文本。这些模型可以应用于各种任务,包括文本生成、语言翻译、情感分析、对话系统等。为了方便国内用户访问这些强大的模

- 国外7个最佳大语言模型 (LLM) API推荐

幂简集成

API新理念语言模型人工智能自然语言处理

大型语言模型(LLM)API将彻底改变我们处理语言的方式。在深度学习和机器学习算法的支持下,LLMAPI提供了前所未有的自然语言理解能力。通过利用这些新的API,开发人员现在可以创建能够以前所未有的方式理解和响应书面文本的应用程序。下面,我们将比较从Bard到ChatGPT、PaLM等市场上顶级LLMAPI。我们还将探讨整合这些LLM的潜在用例,并考虑其对语言处理的影响。什么是大语言模型(LLM)

- 【深度学习】 PyTorch一文详解

Nerous_

深度学习深度学习pytorch人工智能机器学习python

“PyTorchisadeeplearningframeworkthatprioritizessimplicityandflexibility,makingitthego-tochoiceforbothresearchersanddevelopers.”—Anonymous1.PyTorch简介1.1PyTorch的背景与发展PyTorch是由Facebook人工智能研究院(FAIR)开发的一个开

- 存算一体与存算分离:架构设计的深度解析与实现方案

克里斯蒂亚诺罗纳尔多阿维罗

大数据数据库

随着数据量的不断增大和对计算能力的需求日益提高,存算一体作为一种新型架构设计理念,在大数据处理、云计算和人工智能等领域正逐步引起广泛关注。在深入探讨存算一体之前,我们需要先了解存储和计算的基本概念,以及存算分离和存算一体之间的区别。什么是存算一体?存算一体,顾名思义,是将数据存储与计算资源紧密结合,形成一个统一的架构。在这种架构下,存储和计算不仅在物理层面上结合,更在架构设计上深度融合。具体来说,

- HQL之投影查询

归来朝歌

HQLHibernate查询语句投影查询

在HQL查询中,常常面临这样一个场景,对于多表查询,是要将一个表的对象查出来还是要只需要每个表中的几个字段,最后放在一起显示?

针对上面的场景,如果需要将一个对象查出来:

HQL语句写“from 对象”即可

Session session = HibernateUtil.openSession();

- Spring整合redis

bylijinnan

redis

pom.xml

<dependencies>

<!-- Spring Data - Redis Library -->

<dependency>

<groupId>org.springframework.data</groupId>

<artifactId>spring-data-redi

- org.hibernate.NonUniqueResultException: query did not return a unique result: 2

0624chenhong

Hibernate

参考:http://blog.csdn.net/qingfeilee/article/details/7052736

org.hibernate.NonUniqueResultException: query did not return a unique result: 2

在项目中出现了org.hiber

- android动画效果

不懂事的小屁孩

android动画

前几天弄alertdialog和popupwindow的时候,用到了android的动画效果,今天专门研究了一下关于android的动画效果,列出来,方便以后使用。

Android 平台提供了两类动画。 一类是Tween动画,就是对场景里的对象不断的进行图像变化来产生动画效果(旋转、平移、放缩和渐变)。

第二类就是 Frame动画,即顺序的播放事先做好的图像,与gif图片原理类似。

- js delete 删除机理以及它的内存泄露问题的解决方案

换个号韩国红果果

JavaScript

delete删除属性时只是解除了属性与对象的绑定,故当属性值为一个对象时,删除时会造成内存泄露 (其实还未删除)

举例:

var person={name:{firstname:'bob'}}

var p=person.name

delete person.name

p.firstname -->'bob'

// 依然可以访问p.firstname,存在内存泄露

- Oracle将零干预分析加入网络即服务计划

蓝儿唯美

oracle

由Oracle通信技术部门主导的演示项目并没有在本月较早前法国南斯举行的行业集团TM论坛大会中获得嘉奖。但是,Oracle通信官员解雇致力于打造一个支持零干预分配和编制功能的网络即服务(NaaS)平台,帮助企业以更灵活和更适合云的方式实现通信服务提供商(CSP)的连接产品。这个Oracle主导的项目属于TM Forum Live!活动上展示的Catalyst计划的19个项目之一。Catalyst计

- spring学习——springmvc(二)

a-john

springMVC

Spring MVC提供了非常方便的文件上传功能。

1,配置Spring支持文件上传:

DispatcherServlet本身并不知道如何处理multipart的表单数据,需要一个multipart解析器把POST请求的multipart数据中抽取出来,这样DispatcherServlet就能将其传递给我们的控制器了。为了在Spring中注册multipart解析器,需要声明一个实现了Mul

- POJ-2828-Buy Tickets

aijuans

ACM_POJ

POJ-2828-Buy Tickets

http://poj.org/problem?id=2828

线段树,逆序插入

#include<iostream>#include<cstdio>#include<cstring>#include<cstdlib>using namespace std;#define N 200010struct

- Java Ant build.xml详解

asia007

build.xml

1,什么是antant是构建工具2,什么是构建概念到处可查到,形象来说,你要把代码从某个地方拿来,编译,再拷贝到某个地方去等等操作,当然不仅与此,但是主要用来干这个3,ant的好处跨平台 --因为ant是使用java实现的,所以它跨平台使用简单--与ant的兄弟make比起来语法清晰--同样是和make相比功能强大--ant能做的事情很多,可能你用了很久,你仍然不知道它能有

- android按钮监听器的四种技术

百合不是茶

androidxml配置监听器实现接口

android开发中经常会用到各种各样的监听器,android监听器的写法与java又有不同的地方;

1,activity中使用内部类实现接口 ,创建内部类实例 使用add方法 与java类似

创建监听器的实例

myLis lis = new myLis();

使用add方法给按钮添加监听器

- 软件架构师不等同于资深程序员

bijian1013

程序员架构师架构设计

本文的作者Armel Nene是ETAPIX Global公司的首席架构师,他居住在伦敦,他参与过的开源项目包括 Apache Lucene,,Apache Nutch, Liferay 和 Pentaho等。

如今很多的公司

- TeamForge Wiki Syntax & CollabNet User Information Center

sunjing

TeamForgeHow doAttachementAnchorWiki Syntax

the CollabNet user information center http://help.collab.net/

How do I create a new Wiki page?

A CollabNet TeamForge project can have any number of Wiki pages. All Wiki pages are linked, and

- 【Redis四】Redis数据类型

bit1129

redis

概述

Redis是一个高性能的数据结构服务器,称之为数据结构服务器的原因是,它提供了丰富的数据类型以满足不同的应用场景,本文对Redis的数据类型以及对这些类型可能的操作进行总结。

Redis常用的数据类型包括string、set、list、hash以及sorted set.Redis本身是K/V系统,这里的数据类型指的是value的类型,而不是key的类型,key的类型只有一种即string

- SSH2整合-附源码

白糖_

eclipsespringtomcatHibernateGoogle

今天用eclipse终于整合出了struts2+hibernate+spring框架。

我创建的是tomcat项目,需要有tomcat插件。导入项目以后,鼠标右键选择属性,然后再找到“tomcat”项,勾选一下“Is a tomcat project”即可。具体方法见源码里的jsp图片,sql也在源码里。

补充1:项目中部分jar包不是最新版的,可能导

- [转]开源项目代码的学习方法

braveCS

学习方法

转自:

http://blog.sina.com.cn/s/blog_693458530100lk5m.html

http://www.cnblogs.com/west-link/archive/2011/06/07/2074466.html

1)阅读features。以此来搞清楚该项目有哪些特性2)思考。想想如果自己来做有这些features的项目该如何构架3)下载并安装d

- 编程之美-子数组的最大和(二维)

bylijinnan

编程之美

package beautyOfCoding;

import java.util.Arrays;

import java.util.Random;

public class MaxSubArraySum2 {

/**

* 编程之美 子数组之和的最大值(二维)

*/

private static final int ROW = 5;

private stat

- 读书笔记-3

chengxuyuancsdn

jquery笔记resultMap配置ibatis一对多配置

1、resultMap配置

2、ibatis一对多配置

3、jquery笔记

1、resultMap配置

当<select resultMap="topic_data">

<resultMap id="topic_data">必须一一对应。

(1)<resultMap class="tblTopic&q

- [物理与天文]物理学新进展

comsci

如果我们必须获得某种地球上没有的矿石,才能够进行某些能量输出装置的设计和建造,而要获得这种矿石,又必须首先进行深空探测,而要进行深空探测,又必须获得这种能量输出装置,这个矛盾的循环,会导致地球联盟在与宇宙文明建立关系的时候,陷入困境

怎么办呢?

- Oracle 11g新特性:Automatic Diagnostic Repository

daizj

oracleADR

Oracle Database 11g的FDI(Fault Diagnosability Infrastructure)是自动化诊断方面的又一增强。

FDI的一个关键组件是自动诊断库(Automatic Diagnostic Repository-ADR)。

在oracle 11g中,alert文件的信息是以xml的文件格式存在的,另外提供了普通文本格式的alert文件。

这两份log文

- 简单排序:选择排序

dieslrae

选择排序

public void selectSort(int[] array){

int select;

for(int i=0;i<array.length;i++){

select = i;

for(int k=i+1;k<array.leng

- C语言学习六指针的经典程序,互换两个数字

dcj3sjt126com

c

示例程序,swap_1和swap_2都是错误的,推理从1开始推到2,2没完成,推到3就完成了

# include <stdio.h>

void swap_1(int, int);

void swap_2(int *, int *);

void swap_3(int *, int *);

int main(void)

{

int a = 3;

int b =

- php 5.4中php-fpm 的重启、终止操作命令

dcj3sjt126com

PHP

php 5.4中php-fpm 的重启、终止操作命令:

查看php运行目录命令:which php/usr/bin/php

查看php-fpm进程数:ps aux | grep -c php-fpm

查看运行内存/usr/bin/php -i|grep mem

重启php-fpm/etc/init.d/php-fpm restart

在phpinfo()输出内容可以看到php

- 线程同步工具类

shuizhaosi888

同步工具类

同步工具类包括信号量(Semaphore)、栅栏(barrier)、闭锁(CountDownLatch)

闭锁(CountDownLatch)

public class RunMain {

public long timeTasks(int nThreads, final Runnable task) throws InterruptedException {

fin

- bleeding edge是什么意思

haojinghua

DI

不止一次,看到很多讲技术的文章里面出现过这个词语。今天终于弄懂了——通过朋友给的浏览软件,上了wiki。

我再一次感到,没有辞典能像WiKi一样,给出这样体贴人心、一清二楚的解释了。为了表达我对WiKi的喜爱,只好在此一一中英对照,给大家上次课。

In computer science, bleeding edge is a term that

- c中实现utf8和gbk的互转

jimmee

ciconvutf8&gbk编码

#include <iconv.h>

#include <stdlib.h>

#include <stdio.h>

#include <unistd.h>

#include <fcntl.h>

#include <string.h>

#include <sys/stat.h>

int code_c

- 大型分布式网站架构设计与实践

lilin530

应用服务器搜索引擎

1.大型网站软件系统的特点?

a.高并发,大流量。

b.高可用。

c.海量数据。

d.用户分布广泛,网络情况复杂。

e.安全环境恶劣。

f.需求快速变更,发布频繁。

g.渐进式发展。

2.大型网站架构演化发展历程?

a.初始阶段的网站架构。

应用程序,数据库,文件等所有的资源都在一台服务器上。

b.应用服务器和数据服务器分离。

c.使用缓存改善网站性能。

d.使用应用

- 在代码中获取Android theme中的attr属性值

OliveExcel

androidtheme

Android的Theme是由各种attr组合而成, 每个attr对应了这个属性的一个引用, 这个引用又可以是各种东西.

在某些情况下, 我们需要获取非自定义的主题下某个属性的内容 (比如拿到系统默认的配色colorAccent), 操作方式举例一则:

int defaultColor = 0xFF000000;

int[] attrsArray = { andorid.r.

- 基于Zookeeper的分布式共享锁

roadrunners

zookeeper分布式共享锁

首先,说说我们的场景,订单服务是做成集群的,当两个以上结点同时收到一个相同订单的创建指令,这时并发就产生了,系统就会重复创建订单。等等......场景。这时,分布式共享锁就闪亮登场了。

共享锁在同一个进程中是很容易实现的,但在跨进程或者在不同Server之间就不好实现了。Zookeeper就很容易实现。具体的实现原理官网和其它网站也有翻译,这里就不在赘述了。

官

- 两个容易被忽略的MySQL知识

tomcat_oracle

mysql

1、varchar(5)可以存储多少个汉字,多少个字母数字? 相信有好多人应该跟我一样,对这个已经很熟悉了,根据经验我们能很快的做出决定,比如说用varchar(200)去存储url等等,但是,即使你用了很多次也很熟悉了,也有可能对上面的问题做出错误的回答。 这个问题我查了好多资料,有的人说是可以存储5个字符,2.5个汉字(每个汉字占用两个字节的话),有的人说这个要区分版本,5.0

- zoj 3827 Information Entropy(水题)

阿尔萨斯

format

题目链接:zoj 3827 Information Entropy

题目大意:三种底,计算和。

解题思路:调用库函数就可以直接算了,不过要注意Pi = 0的时候,不过它题目里居然也讲了。。。limp→0+plogb(p)=0,因为p是logp的高阶。

#include <cstdio>

#include <cstring>

#include <cmath&

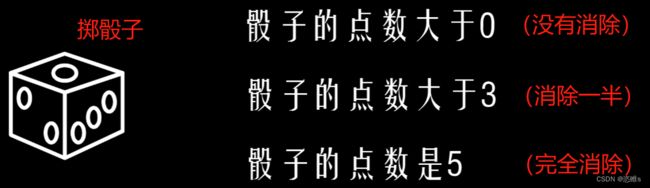

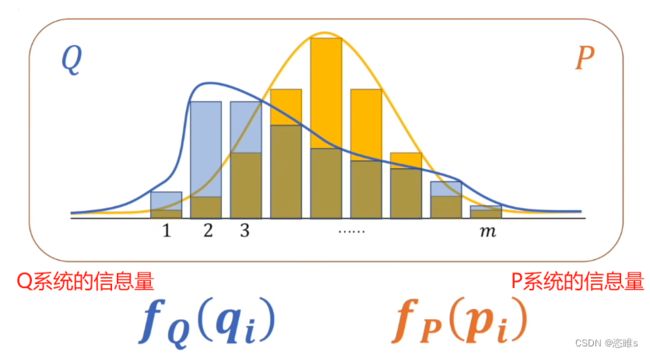

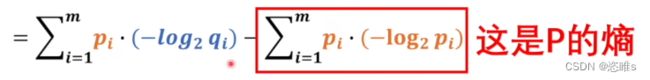

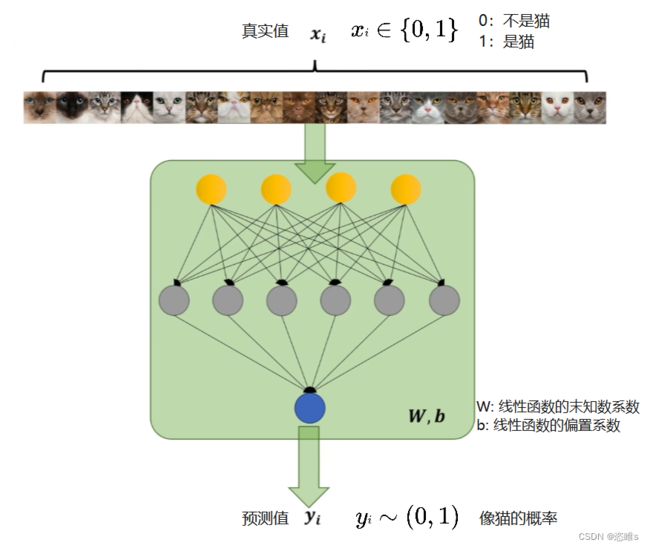

中的n代表输入图片的数量。

中的n代表输入图片的数量。 就应该是

就应该是 是猫和不是猫的概率,

是猫和不是猫的概率, 就应该是

就应该是 是猫和不是猫的概率。

是猫和不是猫的概率。