【MySQL数据库笔记 - 进阶篇】(三)SQL优化

✍个人博客:https://blog.csdn.net/Newin2020?spm=1011.2415.3001.5343

专栏地址:https://blog.csdn.net/Newin2020/article/details/127933422

视频地址:黑马程序员 MySQL数据库入门到精通

专栏定位:这个专栏我将会整理 B 站黑马程序员的 MySQL 入门课程的笔记,大家可以根据笔记辅助听课~

❤️如果有收获的话,欢迎点赞收藏,您的支持就是我创作的最大动力

三、SQL优化

1. 插入数据

insert优化

批量插入

insert into tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');

手动提交事务

start transaction;

insert into tb_test values(1,'Tom'),(2,'Cat'),(3,'Jerry');

insert into tb_test values(4,'Tom'),(5,'Cat'),(6,'Jerry');

insert into tb_test values(7,'Tom'),(8,'Cat'),(9,'Jerry');

commit;

主键顺序插入

主键顺序插入性能高于乱序插入。

主键乱序插入:8 1 9 21 88 2 4 15 89 5 7 3

主键顺序插入:1 2 3 4 5 7 8 9 15 21 88 89

大批量插入数据

如果一次性需要插入大批量数据,使用 insert 语句插入性能较低,此时可以使用 MySQL 数据库提供的 load 指令进行插入。操作如下:

# 客户端连接服务端时,加上参数 --local-infile

mysql --local-infile -u root -p;

# 设置全局参数local_infile为1,开启从本地加载文件导入数据的开关

set global local_infile = 1;

# 执行load指令将准备好的数据,加载到表结构中

load data local infile '/root/sql1.log' into table 'tb_user' fields terminated by ',' lines terminated by '\n';

2. 主键优化

数据组织方式

在 InnoDB 存储引擎中,表数据都是根据主键顺序组织存放的,这种存储方式的表称为索引组织表。

页分裂

页可以为空,也可以填充一半,也可以填充 100% 。每个页包含了 2-N 行数据(如果一行数据过大,会行溢出),根据主键排列。

主键顺序插入

每次页满了就会去开辟新的页,以此类推。

主键乱序插入

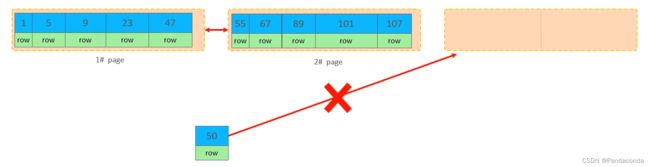

看下面这个例子,如果插入 50 就发现不能直接开辟新的页插入到后面,因为其索引值在第一页和第二页之间。

这就需要将要插入地方的那个页进行分裂,将一部分放到新开辟的那个页当中。

这样就有地方可以插入 50 了,即直接插入到第三页的后面。

最后还需要调整一下顺序,现在第三页需要接到第一页的后面去。

页合并

当删除一行记录时,实际上记录并没有被物理删除,只是记录被标记(flaged)为删除并且它的空间变得允许被其他记录声明使用。

当页中删除的记录达到 MERGE_THRESHOLD(默认为页的 50%),InnoDB 会开始寻找最靠近的页(前或后)看看是否可以将两个页合并以优化空间使用。

注意:

MERGE_THRESHOLD:合并页的阈值,可以自己设置,在创建表或者创建索引时指定。

主键的设计原则

- 满足业务需求的情况下,尽量降低主键的长度。

- 插入数据时,尽量选择顺序插入,选择使用

AUTO_INCREMENT自增主键。 - 尽量不要使用使用

UUID做主键或者是其它自然主键,如身份证号。 - 业务操作,避免对主键的修改。

3. order by优化

情况

(1)Using filesort :通过表的索引或全表扫描,读取满足条件的数据行,然后再排序缓冲区 sort buffer 中完成排序操作,所有不是通过索引直接返回排序结果的都叫 FileSort 排序。

(2)Using index :通过有序索引顺序扫描直接返回有序数据,这种情况即为 using index ,不需要额外排序,操作效率高。

# 没有创建索引时,根据age,phone进行排序会显示Using filesort

explain select id,age,phone from tb_user order by age,phone;

# 创建索引

create index idx_user_age_phone_aa on tb_user(age,phone);

# 创建索引后,根据age,phone进行升序排序会显示Using index

explain select id,age,phone from tb_user order by age,phone;

# 创建索引后,根据age,phone进行降序排序会显示Using index

explain select id,age,phone from tb_user order by age desc,phone desc;

# 根据age,phone进行排序一个升序,一个降序会显示Using filesort

explain select id,age,phone from tb_user order by age asc,phone desc;

# 创建索引

create index idx_user_age_phone_ad on tb_user(age,asc,phone desc);

# 根据age,phone进行排序一个升序,一个降序会显示Using index

explain select id,age,phone from tb_user order by age asc,phone desc;

总结

- 根据排序字段建立合适的索引,多字段排序时,也遵循最左前缀法则。

- 尽量使用覆盖索引。

- 多字段排序,一个升序一个降序,此时需要注意联合索引在创建时的规则(

ASC/DESC) - 如果不可避免的出现

filesort,大数据量排序时,可以适当增大排序缓冲区大小sort_buffer_size(默认256k)。

4. group by优化

在分组操作时,可以通过索引来提高效率。

分组操作时,索引的使用也是满足最左前缀法则的。

# 删除掉目前的联合索引idx_user_pro_age_sta

drop index idx_user_pro_age_sta on tb_user;

# 执行分组操作,根据profession字段分组

explain select profession,count(*) from tb_user group by profession;

# 创建索引

create index idx_user_pro_age_sta on tb_user(profession,age,status);

# 执行分组操作,根据profession字段分组

explain select profession,count(*) from tb_user group by profession;

# 执行分组操作,根据profession字段分组

explain select profession,count(*) from tb_user group by profession,age;

5. limit优化

一个常见又非常头疼的问题是 limit 2000000,10 ,此时需要 MySQL 排序前 2000010 的记录,仅仅返回 2000000 - 2000010 的记录,其他记录丢弃,查询排序的代价非常大。

优化思路: 一般分页查询时,通过创建覆盖索引能够比较好地提高性能,可以通过覆盖索引加子查询形式进行优化。

explain select * from tb_sku t,(select id from tb_sku order by id limit 2000000,10) a where t.id=a.id;

6. count优化

操作

explain select count(*) from tb_user;

MuISAM 引擎把一个表的总行数存放在了磁盘上,因此执行 count(*) 的时候会直接返回这个数,效率很高。

InnoDB 引擎就麻烦了,它执行 count(*) 的时候,需要把数据一行一行地从引擎里面读出来,然后累计计数。

优化思路: 自己计数。

count的几种用法

count() 是一个聚合函数,对于返回的结果集,一行行地判断,如果 count 函数的参数不是 NULL ,累计值就加 1 ,否则不加,最后返回累计值。

用法: count(*)、count(主键)、count(字段)、count(1)

按照效率排序的话,

count(字段) < count(主键id) < count(1) ≈ count(*),所以尽量使用count(*)

7. update优化

尽量根据主键/索引字段进行数据更新。

update student set no='2000100100' where id=1;

update student set no='2000100105' where name='韦一笑';

InnoDB 的行锁是针对索引加的锁,不是针对记录加的锁,并且该索引不能失效,否则会从行锁升级为表锁。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gsOu9G7d-1668737809691)(数据库进阶篇.assets/image-20220827105328352.png)]](http://img.e-com-net.com/image/info8/1ac6ca7649684f2cb01e68bd8af654ff.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MXAUf29W-1668737809698)(数据库进阶篇.assets/image-20220827105739726.png)]](http://img.e-com-net.com/image/info8/57e90f1f3ec94da5977b5c68d31b13cc.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UcCt4brF-1668737809700)(数据库进阶篇.assets/image-20220827105809761.png)]](http://img.e-com-net.com/image/info8/44219f1d83084b49ad9ed2855b72085a.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-q7zBN9za-1668737809702)(数据库进阶篇.assets/image-20220827110131698.png)]](http://img.e-com-net.com/image/info8/775b36a1a56b41119f7fd062efece491.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hdqeiOQp-1668737809704)(数据库进阶篇.assets/image-20220827110145626.png)]](http://img.e-com-net.com/image/info8/c20ab24b96cd497aa72ae89a496c954a.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-C4kOG1Qn-1668737809706)(数据库进阶篇.assets/image-20220827110209529.png)]](http://img.e-com-net.com/image/info8/46e02eae5f9c42f68351181ab2376a1e.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ie5A8wlt-1668737809707)(数据库进阶篇.assets/image-20220827110220197.png)]](http://img.e-com-net.com/image/info8/5b4c52771f0246adb50e768f85971dfb.jpg)