Darknet-yolov3在无gpu下的使用,Darknet相关文件说明,标记工具labellmag的使用,用darknet-yolov3训练自己的数据模型

*免责声明:

1\此方法仅提供参考

2\搬了其他博主的操作方法,以贴上路径.

3*

场景一:Darknet yolov3在无gpu下的使用 环境搭建

场景二:Darknet相关文件说明

场景三:标记工具labellmag的使用

场景四:用darknet-yolov3训练自己的数据模型

.

.

.

.

Darknet yolov3

场景一:Darknet yolov3在无gpu下的使用 环境搭建

windows下:一个比较优质的博文,我是没有成功

参考博文

linux部分

安装虚拟机

(有机会将讲一讲我在windows下进行darknet环境搭建的血泪史)

Centos是默认上不了网的 ,所以需要改下面的地址为yes

vim /etc/sysconfig/network-scripts/ifcfg-ens33

修改完以后,重启虚拟机网络配置

systemctl restart network.service

或者是service network restart

常见的安装

linux中-bash: vim: 未找到命令

yum -y install vim*

yum -y install net-tools

yum install gcc

yum install gcc-c++

yum install -y git

yum -y install wget

下载darknet

git clone https://github.com/pjreddie/darknet

cd darknet

如果你有gpu记得修改Makefile文件,修改以后make,没有gpu,跳过这一步,直接make,当然有也可以直接跳过,

GPU=0

CUDNN=0

OPENCV=0 # gpu主机没有安装,反正也不看图,暂时不影响使用

OPENMP=0

DEBUG=0

...

NVCC=/usr/local/cuda-9.0/bin/nvcc # 原为 NVCC = nvcc,现在重新定位

修改以后

Make

在darknet目录下用./darknet命令测试,是否安装成功,返回以下表示成功

权值下载,放在darknet文件夹下

wget https://pjreddie.com/media/files/yolov3.weights

测试图片

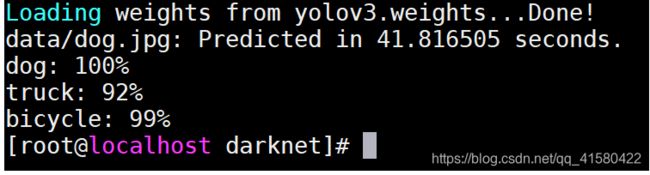

./darknet detect cfg/yolov3.cfg yolov3.weights data/dog.jpg

./darknet detector test cfg/coco.data cfg/yolov3.cfg yolov3.weights data/dog.jpg

./darknet detector demo cfg/coco.data cfg/yolov3.cfg yolov3.weights 加载摄像头

./darknet detector demo cfg/coco.data cfg/yolov3.cfg yolov3.weights

.

.

.

场景二:Darknet相关文件说明

Darknet相关文件说明,注释可能不太准确

Yolov3.cfg可能需要修改的地方

batch=64 (当前显卡显存比较小,就相对调低一下)

subdivisions=16 (注释:进行前项运算,会对当前的batch进行分组,降低显存的占用)

width=608 (图像输入的尺寸)

height=608

channels=3

....

.

.

[yolo]

mask = 6,7,8 #(#表示使用下面的anchors的索引,从0开始)

anchors = 10,13, 16,30, 33,23, 30,61, 62,45, 59,119, 116,90, 156,198, 373,326

classes=80 #(多少个种类)

num=9 #(每一个anchors预定box的数量)

jitter=.3 #(针对数据增强的参数)

ignore_thresh = .7 #(对于预测的检测框同真值进行匹配的时候,如果lou大于阈值,则不参与损失计算,来控制损失计算的规模.一般在0.5--0.7之间)

truth_thresh = 1

random=1 #(1代表采用随机多尺度进行预算,0代表固定尺度)

假如训练coco数据集:需要修改cfg文件夹中中coco.data

classes= 80 #这是类别

train = /home/pjreddie/data/coco/trainvalno5k.txt #(注释 训练数据集的位置)

valid = coco_testdev #(交叉验证集的位置)

#valid = data/coco_val_5k.list

names = data/coco.names #(一一对应)

backup = /home/pjreddie/backup/

eval=coco

如果训练自己的模型,会在backup中生成一个yolov3的yolov.backup,将backup在上面的coco.data中进行配置

Yolov3的训练命令

训练命令:

./darknet detector train cfg/coco.data cfg/yolov3.cfg #(需要修改的地方)

预训练模型

./darknet detector train cfg/coco.data cfg/yolov3.cfg cfg/yolov3_2000.weights

迭代次数的修改,在examples/detector 中 138行的位置进行相应的修改

使用python接口进行测试

记得修改在darknet.py脚本把上面的参数记得改一下

#lib = CDLL("/home/pjreddie/documents/darknet/libdarknet.so", RTLD_GLOBAL)

还有这一个 make以后在darknet文件夹下生成的so文件,记得自己也要修改一下上面的so地址

测试命令,在darknet下:测试命令为:

python python/darknet.py

Opencv的使用:在darknet.py中加入

data=cv2.imread("data/person.jpg")#要训练的图片位置

for i in range(len(r)):

cv2.rectangle(data,(int(r[i][2][0]-r[i][2][2]/2),

int(r[i][2][1]-r[i][2][3]/2)),

(int(r[i][2][0]+r[i][2][2]/2),int(r[i][2][1]+r[i][2][3]/2)) ,

(0,255,0),2)

cv2.imshow("image",data)

cv2.waitKey(0)

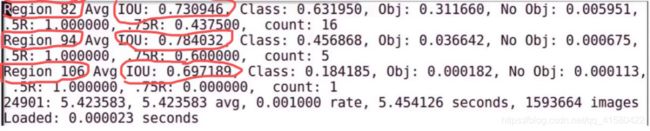

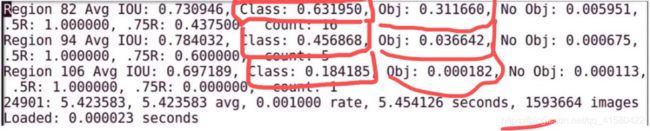

训练日志

Region: 三个不同尺度的上预测到的不同大小的框的参数

这采用了多尺度,如上面的82,94,106

(其中82卷积层为最大的预测尺寸,94为中间)

IOU: 当前已经预测的真实的矩形框和预测的矩形框的

匹配程度

Class: 表示物体分类的准确率,期望该值倾向于1为好.

Obj: 表示当前网络检测到目标的信息,越接近1为好.

NO Obj: 越来越小,但不为零

.5R: 在recall/count中定义,当前模型在所有

subdivision图片中检测出的正样本

与实际样本的比值

Count:当前subdivision中包含正样本的图片的数量

.

.

.

场景三:标记工具labellmag的使用

安装anaconda,安装labellmag

LabelImg的安装出现No module named 'libs.resources’错误

解决方案地址

anaconda命令行进入解压后的文件路径。执行命令:

Pyrcc5 -o resources.py resources.qrc

这句命令的功能是把Qt文件格式转为Python格式。运行成功后再次输入:

python labelImg.py

相关操作学习地址:

B站教学视频

![]()

自己标注的数据集

![]()

.

.

.

场景四:用darknet-yolov3训练自己的数据模型

准备数据集、训练、测试

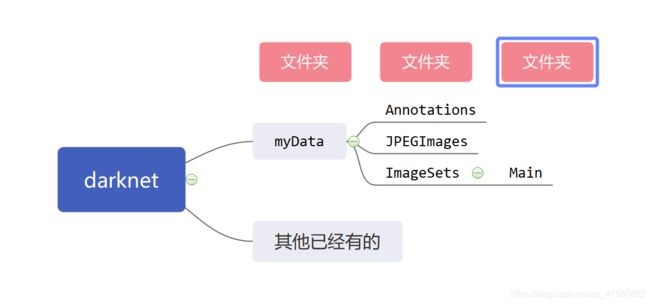

步骤一:在darknet目录下创建myData文件夹,目录结构如下,将之前标注好的图片和xml文件放到对应目录下

myData ...JPEGImages#存放图像 ...Annotations#存放图像对应的xml文件 ...ImageSets/Main # 在ImagSets下创建main文件夹,为了存放下面test.py生成的文件

步骤二:在myData文件夹下创建test.py;运行这个py文件将生成四个文件:train.txt,val.txt,test.txt和trainval.txt。

这里可能出现报错,相应解析在代码下面

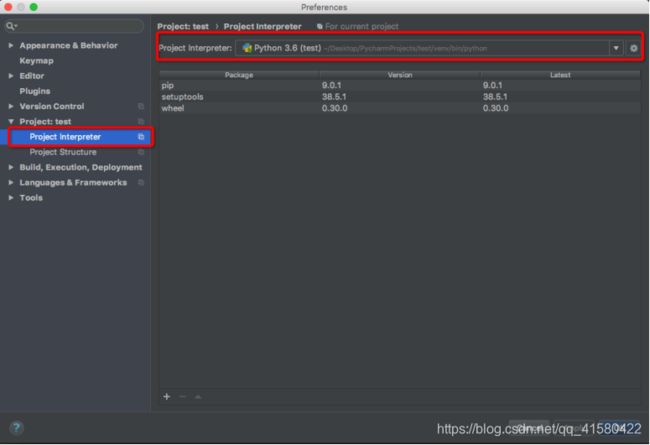

Error:Python interpreter is not selected. Please setup Python

interpreter first.

test.py

import os

import random

trainval_percent = 0.1

train_percent = 0.9

xmlfilepath = 'Annotations'

txtsavepath = 'ImageSets\Main'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open('ImageSets/Main/trainval.txt', 'w')

ftest = open('ImageSets/Main/test.txt', 'w')

ftrain = open('ImageSets/Main/train.txt', 'w')

fval = open('ImageSets/Main/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftest.write(name)

else:

fval.write(name)

else:

ftrain.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

报错解析:

出现这个问题的原因目前知道的有两个:

1、本地环境中没有安装Python,或者远程设置也没有;

2、安装的pycharm的版本和你当前Python的版本不匹配

也会出现这个问题;

步骤三:将数据转换为darknet支持的格式yolov3提供了将VOC数据集转为YOLO训练所需要的格式的代码,在scripts/voc_label.py文件中。这里提供一个修改版本的。在darknet文件夹下新建一个my_lables.py文件,内容如下:

# encoding:gbk

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

# 源代码sets=[('2012', 'train'), ('2012', 'val'), ('2007', 'train'), ('2007', 'val'), ('2007', 'test')]

sets = [('myData', 'train')] # 改成自己建立的myData

classes = ["大", "学", "大学"] # 改成自己的类别

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(year, image_id):

in_file = open('myData/Annotations/%s.xml' % (image_id),encoding="utf-8") # 源代码VOCdevkit/VOC%s/Annotations/%s.xml

out_file = open('myData/labels/%s.txt' % (image_id), 'w',encoding="utf-8") # 源代码VOCdevkit/VOC%s/labels/%s.txt

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

for year, image_set in sets:

if not os.path.exists('myData/labels/'): # 改成自己建立的myData

os.makedirs('myData/labels/')

image_ids = open('myData/ImageSets/Main/%s.txt' % (image_set),encoding="utf-8").read().strip().split()

list_file = open('myData/%s_%s.txt' % (year, image_set), 'w',encoding="utf-8")

for image_id in image_ids:

list_file.write('%s/myData/JPEGImages/%s.jpg\n' % (wd, image_id))

convert_annotation(year, image_id)

list_file.close()

会在./myData目录下生成一个labels文件夹一个txt文(内容是: 类别的编码和目标的相对位置)。

lables文件中的‘txt文件的含义为:

同理如果要生成训练数据

sets=[('myData', 'train')]

改为

sets=[('myData', 'train'), ('myData', 'test')]

具体的每一个值的计算方式是这样的:

假设一个标注的boundingbox的左下角和右上角坐标分别为

(x1,y1)(x2,y2),图像的宽和高分别为w,h

归一化的中心点x坐标计算公式:((x2+x1) / 2.0)/ w

归一化的中心点y坐标计算公式:((y2+y1) / 2.0)/ h

归一化的目标框宽度的计算公式: (x2-x1) / w

归一化的目标框高度计算公式:((y2-y1)/ h

步骤4.修改darknet/cfg下的voc.data和yolov3.cfg文件或者yolov4-custom.cfg

为了保险起见,复制这两个文件,并分别重命名为myvoc.data和myyolov3.cfg

yolov4是yolov4-custom.cfg文件,复制并命名为myyolov4-custom.cfg

修改myvoc.data内容:

classes= 3 ##改为自己的分类个数

##下面都改为自己的路径

train = train = /darknet/myData/myData_train.txt #修改为你的路径,记得删掉这个注释

names = /darknet/myData/myData.names #稍后需要创建这个文件

backup = /darknet/myData/weights #记得在mydata下创建weights文件夹用来保存自己训练的权值文件,或者是backup=backup,这样就会在backup下保存自己训练的结果

myyolov3.cfg的内容:(myyolov4-custom.cfg修改差不多)

搜索yolo, 总共会搜出3个含有yolo的地方。

每个地方都必须要改2处, filters:3*(5+len(classes));

其中:classes: len(classes) = 3,这里以我的工程为例

filters = 24

classes = 3

可修改:random = 1:原来是1,显存小改为0.(是否要多尺度输出。)

[net]

# Testing ### 测试模式

# batch=1

# subdivisions=1

# Training ### 训练模式,每次前向的图片数目 = batch/subdivisions

batch=1

subdivisions=1

width=416 ### 网络的输入宽、高、通道数

height=416

channels=3

momentum=0.9 ### 动量

decay=0.0005 ### 权重衰减

angle=0

saturation = 1.5 ### 饱和度

exposure = 1.5 ### 曝光度

hue=.1 ### 色调

learning_rate=0.001 ### 学习率

burn_in=1000 ### 学习率控制的参数

max_batches = 50200 ### 迭代次数

policy=steps ### 学习率策略

steps=40000,45000 ### 学习率变动步长

因为是训练,所以注释Testing,打开Training,其中 batch=64

每batch个样本更新一次参数。 subdivisions=16

如果内存不够大,将batch分割为subdivisions个子batch,每个子batch的大小为batch/subdivisions。

步骤五:在myData文件夹下新建myData.names文件

里面放入你自己的类识别名称:我的为如下:

大

学

大学

步骤六:先在darknet目录下面下载预训练权重

yolov3预训练权重 darknet53.conv.74

wget https://pjreddie.com/media/files/darknet53.conv.74

yolov4预训练权重yolov4.conv.137

下载的百度云地址:https://pan.baidu.com/share/init?surl=yf0WeEDdg3Xtf2XAOWV1mg

密码:dw15

步骤7:yolov3/4训练自己的数据,记得修改下面的语句,改为自己的

yolov3训练语句:(下面有其他语句)

./darknet detector train cfg/myvoc.data cfg/myyolov3.cfg darknet53.conv.74

yolov4训练语句:(下面有其他语句)

./darknet detector train cfg/myvoc.data cfg/myyolov4-custom.cfg yolov4.conv.137

-map是输出MAP值,可以不加

./darknet detector train cfg/myvoc.data cfg/myyolov4-custom.cfg yolov4.conv.137 -map

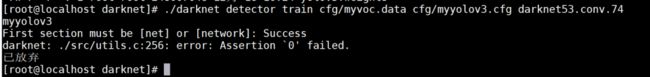

0 Cuda malloc failed

: File exists

darknet: ./src/utils.c:256: error: Assertion `0' failed.

已放弃 (核心已转储)

出现以上原因是因为 计算力不足,一般建议增加cfg文件下的subdivision=*的值

#如果内存不够大,将batch分割为subdivisions个子batch

#上面这两个参数如果电脑内存小,则把batch改小一点,batch越大,训练效果越好

yolov3指定gpu训练,默认使用gpu0

./darknet detector train cfg/myvoc.data cfg/myyolov3.cfg darknet53.conv.74 -gups 0,1,2,3

yolov3从停止处重新训练

./darknet detector train cfg/myvoc.data cfg/myyolov3.cfg darknet53.conv.74 -gups 0,1,2,3 myData/weights/my_yolov3.backup -gpus 0,1,2,3

yolov4从停止处重新训练

在每100次迭代之后,您可以停止,然后从这一点开始培训。例如,在2000次迭代之后,您可以停止训练,然后使用以下命令开始继续训练:

./darknet detector train cfg/myvoc.data cfg/myyolov4-custom.cfg myData/myyolov4-custom_last.weights

每1000次迭代保存一次,并自动保存当前最优模型。

yolov3训练好了,或者是训练过程中会产生权值文件,权值文件的路径在上面的backup配置那里.

yolov3是0-1000每100次保存一次,大于1000,每一万保存一次.保存具体规则在examples/detector.c中:line 138处见,修改记得重新编译

用于画图的训练语句,即生成训练的log文件

./darknet detector train cfg/myvoc.data cfg/myyolov3.cfg darknet53.conv.74 2>1 | tee myData/mytrain_log.txt

测试图片

./darknet detect cfg/myyolov3.cfg weights/my_yolov3.weights 1.jpg

./darknet detector test cfg/myvoc.data cfg/myyolov3.cfg myyolov3_900.weights 5588-1548.jpg

置信度筛选

./darknet detector test cfg/myvoc.data cfg/myyolov3.cfg myyolov3_900.weights 5588-1548.jpg -thresh 0.4

…

测试视频

./darknet detector demo cfg/myvoc.data cfg/myyolov3.cfg myyolov3_900.weights data/1.mp4

测试摄像头

./darknet detector demo cfg/myvoc.data cfg/myyolov3.cfg myyolov3_900.weights

…