netty原理

TCP read write原理

socket 缓冲区

每个 socket 被创建后,都会分配两个缓冲区,输入缓冲区和输出缓冲区。

write()/send() 并不立即向网络中传输数据,而是先将数据写入缓冲区中,再由TCP协议将数据从缓冲区发送到目标机器。一旦将数据写入到缓冲区,函数就可以成功返回,不管它们有没有到达目标机器,也不管它们何时被发送到网络,这些都是TCP协议负责的事情。

TCP协议独立于 write()/send() 函数,数据有可能刚被写入缓冲区就发送到网络,也可能在缓冲区中不断积压,多次写入的数据被一次性发送到网络,这取决于当时的网络情况、当前线程是否空闲等诸多因素,不由程序员控制。

read()/recv() 函数也是如此,也从输入缓冲区中读取数据,而不是直接从网络中读取。

阻塞模式

对于TCP套接字(默认情况下),当使用 write()/send() 发送数据时:

1) 首先会检查缓冲区,如果缓冲区的可用空间长度小于要发送的数据,那么 write()/send() 会被阻塞(暂停执行),直到缓冲区中的数据被发送到目标机器,腾出足够的空间,才唤醒write()/send() 函数继续写入数据。

2) 如果TCP协议正在向网络发送数据,那么输出缓冲区会被锁定,不允许写入,write()/send() 也会被阻塞,直到数据发送完毕缓冲区解锁,write()/send() 才会被唤醒。

3) 如果要写入的数据大于缓冲区的最大长度,那么将分批写入。

4) 直到所有数据被写入缓冲区 write()/send() 才能返回。

当使用 read()/recv() 读取数据时:

1) 首先会检查缓冲区,如果缓冲区中有数据,那么就读取,否则函数会被阻塞,直到网络上有数据到来。

2) 如果要读取的数据长度小于缓冲区中的数据长度,那么就不能一次性将缓冲区中的所有数据读出,剩余数据将不断积压,直到有 read()/recv() 函数再次读取。

3) 直到读取到数据后 read()/recv() 函数才会返回,否则就一直被阻塞。

这就是TCP套接字的阻塞模式。所谓阻塞,就是上一步动作没有完成,下一步动作将暂停,直到上一步动作完成后才能继续,以保持同步性。

注:TCP套接字默认情况下是阻塞模式,也是最常用的。当然也可以更改为非阻塞模式

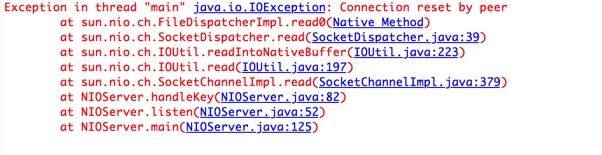

connection reset by peer和broken pipe

broken pipe只出现在调用write的时候。broken pipe的意思是对端的管道已经断开,往往发生在远端把这个读/写管道关闭了,你无法在对这个管道进行读写操作。从tcp的四次挥手来讲,远端已经发送了FIN序号,告诉你我这个管道已经关闭,这时候,如果你继续往管道里写数据,第一次,你会收到一个远端发送的RST信号,如果你继续往管道里write数据,操作系统就会给你发送SIGPIPE的信号,并且将errno置为Broken pipe(32),如果你的程序默认没有对SIGPIPE进行处理,那么程序会中断退出。一般情况下,可以用signal(SIGPIPE,SIG_IGN)忽略这个信号,这样的话程序不会退出,但是write会返回-1并且将errno置为Broken pipe(32)。broken pipe只会出现在往对端已经关闭的管道里写数据的情况下(在收到对端的RST序号后第一次写不会出现broke pipe,而是write返回-1,这时候正确的做法应该是本端也close这个管道,如果继续write,那么就会出现这个错误)。

connection reset by peer:对close的通道先write紧跟着read报connection reset by peer。当我们往一个对端已经close的通道写数据的时候,对方的tcp会收到这个报文,并且反馈一个reset报文,当收到reset报文的时候,继续做select读数据的时候就会抛出Connect reset by peer的异常,从堆栈可以看得出。

BIO通信模型

单一服务器对多客户端。

服务端:每次连接成功一个客户端,则启动一个线程为其服务

public class Server {

public static void main(String[] args) throws IOException {

ServerSocket ss = new ServerSocket(10086);

System.out.println("服务器正常启动。。。");

while(true){

Socket socket = ss.accept();

System.out.println("用户接入成功。。。");

new ServerThread(socket).start();

}

}

}客户端:

public class Client {

private static PrintWriter pw=null;

private static BufferedReader br=null;

private static Socket s;

static Scanner scanner=new Scanner(System.in);

/**

* @param args

*/

public static void main(String[] args) {

try {

Socket s=new Socket(InetAddress.getLocalHost(),5500);

pw=new PrintWriter(new OutputStreamWriter(s.getOutputStream()));

br=new BufferedReader(new InputStreamReader(s.getInputStream()));

while(true){

System.out.println("Client端请输入:");

String str = scanner.next();

pw.println(str);

pw.flush();

String string=br.readLine();

System.out.println("Client读到:"+string);

if(str.equals("exit")){

break;

}

}

}catch (Exception e) {

e.printStackTrace();

}

try {

br.close();

pw.close();

} catch (IOException e1) {

e1.printStackTrace();

}

}

}NIO通信模型

例子:

package com.stevex.app.nio;

import java.io.IOException;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.CharBuffer;

import java.nio.channels.ClosedChannelException;

import java.nio.channels.SelectionKey;

import java.nio.channels.Selector;

import java.nio.channels.ServerSocketChannel;

import java.nio.channels.SocketChannel;

import java.util.Iterator;

public class XiaoNa {

private ByteBuffer readBuffer;

private Selector selector;

public static void main(String[] args){

XiaoNa xiaona = new XiaoNa();

xiaona.init();

xiaona.listen();

}

private void init(){

readBuffer = ByteBuffer.allocate(1024);

ServerSocketChannel servSocketChannel;

try {

servSocketChannel = ServerSocketChannel.open();

servSocketChannel.configureBlocking(false);

//绑定端口

servSocketChannel.socket().bind(new InetSocketAddress(8383));

selector = Selector.open();

servSocketChannel.register(selector, SelectionKey.OP_ACCEPT);

} catch (IOException e) {

e.printStackTrace();

}

}

private void listen() {

while(true){

try{

selector.select();

Iterator ite = selector.selectedKeys().iterator();

while(ite.hasNext()){

SelectionKey key = (SelectionKey) ite.next();

ite.remove();//确保不重复处理

handleKey(key);

}

}

catch(Throwable t){

t.printStackTrace();

}

}

}

private void handleKey(SelectionKey key)

throws IOException, ClosedChannelException {

SocketChannel channel = null;

try{

if(key.isAcceptable()){

ServerSocketChannel serverChannel = (ServerSocketChannel) key.channel();

channel = serverChannel.accept();//接受连接请求

channel.configureBlocking(false);

channel.register(selector, SelectionKey.OP_READ);

}

else if(key.isReadable()){

channel = (SocketChannel) key.channel();

readBuffer.clear();

/*当客户端channel关闭后,会不断收到read事件,但没有消息,即read方法返回-1

* 所以这时服务器端也需要关闭channel,避免无限无效的处理*/

int count = channel.read(readBuffer);

if(count > 0){

//一定需要调用flip函数,否则读取错误数据

readBuffer.flip();

/*使用CharBuffer配合取出正确的数据

String question = new String(readBuffer.array());

可能会出错,因为前面readBuffer.clear();并未真正清理数据

只是重置缓冲区的position, limit, mark,

而readBuffer.array()会返回整个缓冲区的内容。

decode方法只取readBuffer的position到limit数据。

例如,上一次读取到缓冲区的是"where", clear后position为0,limit为 1024,

再次读取“bye"到缓冲区后,position为3,limit不变,

flip后position为0,limit为3,前三个字符被覆盖了,但"re"还存在缓冲区中,

所以 new String(readBuffer.array()) 返回 "byere",

而decode(readBuffer)返回"bye"。

*/

CharBuffer charBuffer = CharsetHelper.decode(readBuffer);

String question = charBuffer.toString();

String answer = getAnswer(question);

channel.write(CharsetHelper.encode(CharBuffer.wrap(answer)));

}

else{

//这里关闭channel,因为客户端已经关闭channel或者异常了

channel.close();

}

}

}

catch(Throwable t){

t.printStackTrace();

if(channel != null){

channel.close();

}

}

}

private String getAnswer(String question){

String answer = null;

switch(question){

case "who":

answer = "我是小娜\n";

break;

case "what":

answer = "我是来帮你解闷的\n";

break;

case "where":

answer = "我来自外太空\n";

break;

case "hi":

answer = "hello\n";

break;

case "bye":

answer = "88\n";

break;

default:

answer = "请输入 who, 或者what, 或者where";

}

return answer;

}

}reactor模型

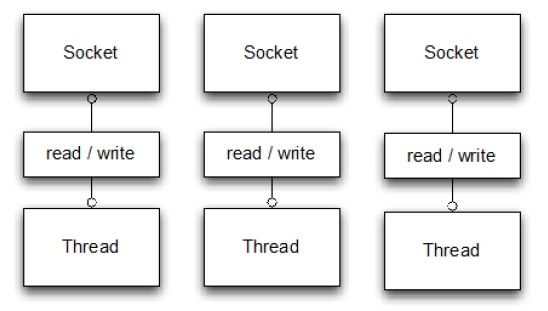

经典的I/O服务设计--BIO模式

流程:

① 服务器端的Server是一个线程,线程中执行一个死循环来阻塞的监听客户端的连接请求和通信。

② 当客户端向服务器端发送一个连接请求后,服务器端的Server会接受客户端的请求,ServerSocket.accept()从阻塞中返回,得到一个与客户端连接相对于的Socket。

③ 构建一个handler,将Socket传入该handler。创建一个线程并启动该线程,在线程中执行handler,这样与客户端的所有的通信以及数据处理都在该线程中执行。当该客户端和服务器端完成通信关闭连接后,线程就会被销毁。

④ 然后Server继续执行accept()操作等待新的连接请求。

-

优点:

① 使用简单,容易编程

② 在多核系统下,能够充分利用了多核CPU的资源。即,当I/O阻塞系统,但CPU空闲的时候,可以利用多线程使用CPU资源。 -

缺点:

该模式的本质问题在于严重依赖线程,但线程Java虚拟机非常宝贵的资源。随着客户端并发访问量的急剧增加,线程数量的不断膨胀将服务器端的性能将急剧下降。

① 线程生命周期的开销非常高。线程的创建与销毁并不是没有代价的。在Linux这样的操作系统中,线程本质上就是一个进程,创建和销毁都是重量级的系统函数。

② 资源消耗。内存:大量空闲的线程会占用许多内存,给垃圾回收器带来压力。;CPU:如果你已经拥有足够多的线程使所有CPU保持忙碌状态,那么再创建更过的线程反而会降低性能。

③ 稳定性。在可创建线程的数量上存在一个限制。这个限制值将随着平台的不同而不同,并且受多个因素制约:a)JVM的启动参数、b)Threa的构造函数中请求的栈大小、c)底层操作系统对线程的限制等。如果破坏了这些限制,那么很可能抛出OutOfMemoryError异常。

④ 线程的切换成本是很高的。操作系统发生线程切换的时候,需要保留线程的上下文,然后执行系统调用。如果线程数过高,不仅会带来许多无用的上下文切换,还可能导致执行线程切换的时间甚至会大于线程执行的时间,这时候带来的表现往往是系统负载偏高、CPU sy(系统CPU)使用率特别高,导致系统几乎陷入不可用的状态。

⑤ 容易造成锯齿状的系统负载。一旦线程数量高但外部网络环境不是很稳定,就很容易造成大量请求的结果同时返回,激活大量阻塞线程从而使系统负载压力过大。

⑥ 若是长连接的情况下并且客户端与服务器端交互并不频繁的,那么客户端和服务器端的连接会一直保留着,对应的线程也就一直存在在,但因为不频繁的通信,导致大量线程在大量时间内都处于空置状态。 -

适用场景:如果你有少量的连接使用非常高的带宽,一次发送大量的数据,也许典型的IO服务器实现可能非常契合。

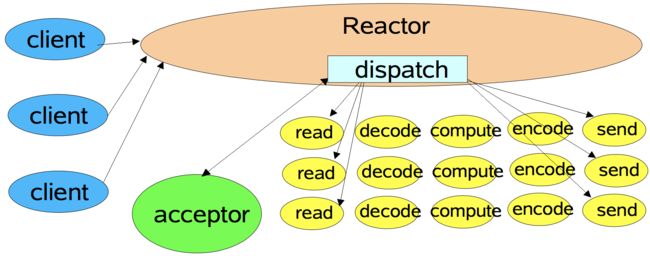

单线程Reactor模式

流程:

① 服务器端的Reactor是一个线程对象,该线程会启动事件循环,并使用Selector来实现IO的多路复用。注册一个Acceptor事件处理器到Reactor中,Acceptor事件处理器所关注的事件是ACCEPT事件,这样Reactor会监听客户端向服务器端发起的连接请求事件(ACCEPT事件)。

② 客户端向服务器端发起一个连接请求,Reactor监听到了该ACCEPT事件的发生并将该ACCEPT事件派发给相应的Acceptor处理器来进行处理。Acceptor处理器通过accept()方法得到与这个客户端对应的连接(SocketChannel),然后将该连接所关注的READ事件以及对应的READ事件处理器注册到Reactor中,这样一来Reactor就会监听该连接的READ事件了。或者当你需要向客户端发送数据时,就向Reactor注册该连接的WRITE事件和其处理器。

③ 当Reactor监听到有读或者写事件发生时,将相关的事件派发给对应的处理器进行处理。比如,读处理器会通过SocketChannel的read()方法读取数据,此时read()操作可以直接读取到数据,而不会堵塞与等待可读的数据到来。

④ 每当处理完所有就绪的感兴趣的I/O事件后,Reactor线程会再次执行select()阻塞等待新的事件就绪并将其分派给对应处理器进行处理。

注意,Reactor的单线程模式的单线程主要是针对于I/O操作而言,也就是所以的I/O的accept()、read()、write()以及connect()操作都在一个线程上完成的。

但在目前的单线程Reactor模式中,不仅I/O操作在该Reactor线程上,连非I/O的业务操作也在该线程上进行处理了,这可能会大大延迟I/O请求的响应。所以我们应该将非I/O的业务逻辑操作从Reactor线程上卸载,以此来加速Reactor线程对I/O请求的响应。

使用工作者线程池

与单线程Reactor模式不同的是,添加了一个工作者线程池,并将非I/O操作从Reactor线程中移出转交给工作者线程池来执行。这样能够提高Reactor线程的I/O响应,不至于因为一些耗时的业务逻辑而延迟对后面I/O请求的处理。

使用线程池的优势:

① 通过重用现有的线程而不是创建新线程,可以在处理多个请求时分摊在线程创建和销毁过程产生的巨大开销。

② 另一个额外的好处是,当请求到达时,工作线程通常已经存在,因此不会由于等待创建线程而延迟任务的执行,从而提高了响应性。

③ 通过适当调整线程池的大小,可以创建足够多的线程以便使处理器保持忙碌状态。同时还可以防止过多线程相互竞争资源而使应用程序耗尽内存或失败。

注意,在上图的改进的版本中,所以的I/O操作依旧由一个Reactor来完成,包括I/O的accept()、read()、write()以及connect()操作。

对于一些小容量应用场景,可以使用单线程模型。但是对于高负载、大并发或大数据量的应用场景却不合适,主要原因如下:

① 一个NIO线程同时处理成百上千的链路,性能上无法支撑,即便NIO线程的CPU负荷达到100%,也无法满足海量消息的读取和发送;

② 当NIO线程负载过重之后,处理速度将变慢,这会导致大量客户端连接超时,超时之后往往会进行重发,这更加重了NIO线程的负载,最终会导致大量消息积压和处理超时,成为系统的性能瓶颈;

多Reactor线程模式

Reactor线程池中的每一Reactor线程都会有自己的Selector、线程和分发的事件循环逻辑。

mainReactor可以只有一个,但subReactor一般会有多个。mainReactor线程主要负责接收客户端的连接请求,然后将接收到的SocketChannel传递给subReactor,由subReactor来完成和客户端的通信。

流程:

① 注册一个Acceptor事件处理器到mainReactor中,Acceptor事件处理器所关注的事件是ACCEPT事件,这样mainReactor会监听客户端向服务器端发起的连接请求事件(ACCEPT事件)。启动mainReactor的事件循环。

② 客户端向服务器端发起一个连接请求,mainReactor监听到了该ACCEPT事件并将该ACCEPT事件派发给Acceptor处理器来进行处理。Acceptor处理器通过accept()方法得到与这个客户端对应的连接(SocketChannel),然后将这个SocketChannel传递给subReactor线程池。

③ subReactor线程池分配一个subReactor线程给这个SocketChannel,即,将SocketChannel关注的READ事件以及对应的READ事件处理器注册到subReactor线程中。当然你也注册WRITE事件以及WRITE事件处理器到subReactor线程中以完成I/O写操作。Reactor线程池中的每一Reactor线程都会有自己的Selector、线程和分发的循环逻辑。

④ 当有I/O事件就绪时,相关的subReactor就将事件派发给响应的处理器处理。注意,这里subReactor线程只负责完成I/O的read()操作,在读取到数据后将业务逻辑的处理放入到线程池中完成,若完成业务逻辑后需要返回数据给客户端,则相关的I/O的write操作还是会被提交回subReactor线程来完成。

注意,所以的I/O操作(包括,I/O的accept()、read()、write()以及connect()操作)依旧还是在Reactor线程(mainReactor线程 或 subReactor线程)中完成的。Thread Pool(线程池)仅用来处理非I/O操作的逻辑。

多Reactor线程模式将“接受客户端的连接请求”和“与该客户端的通信”分在了两个Reactor线程来完成。mainReactor完成接收客户端连接请求的操作,它不负责与客户端的通信,而是将建立好的连接转交给subReactor线程来完成与客户端的通信,这样一来就不会因为read()数据量太大而导致后面的客户端连接请求得不到即时处理的情况。并且多Reactor线程模式在海量的客户端并发请求的情况下,还可以通过实现subReactor线程池来将海量的连接分发给多个subReactor线程,在多核的操作系统中这能大大提升应用的负载和吞吐量。

actor模型

进程间通信方式

- 管道pipe

- 命名管道FIFO

- 信号量(Semaphore):锁机制,信号量的值为正的时候,说明它空闲。所测试的线程可以锁定而使用它。若为0,说明它被占用,测试的线程要进入睡眠队列中,等待被唤醒。

- 消息队列

- 共享内存

- Socket

- 信号(sinal):信号是Linux系统中用于进程之间通信或操作的一种机制,Linux提供了几十种信号,分别代表着不同的意义。

线程间通信方式

- 共享数据

- 消息传递

分布式事务

- 二阶段提交(2PC)

- 三阶段提交(3PC)

- Paxos算法

- 分布式锁

actor

- 背景

- 原理

- 优点、缺点

浅谈Actor并发模型

akka

TODO

五种IO模型

阻塞IO

术语描述:在应用调用recvfrom读取数据时,其系统调用直到数据包到达且被复制到应用缓冲区中或者发送错误时才返回,在此期间一直会等待,进程从调用到返回这段时间内都是被阻塞的称为阻塞IO;

流程:

1、应用进程向内核发起recfrom读取数据。

2、准备数据报(应用进程阻塞)。

3、将数据从内核负责到应用空间。

4、复制完成后,返回成功提示。

![]()

非阻塞IO

术语:非阻塞IO是在应用调用recvfrom读取数据时,如果该缓冲区没有数据的话,就会直接返回一个EWOULDBLOCK错误,不会让应用一直等待中。在没有数据的时候会即刻返回错误标识,那也意味着如果应用要读取数据就需要不断的调用recvfrom请求,直到读取到它数据要的数据为止。

流程:

1、应用进程向内核发起recvfrom读取数据。

2、没有数据报准备好,即刻返回EWOULDBLOCK错误码。

3、应用进程向内核发起recvfrom读取数据。

4、已有数据包准备好就进行一下 步骤,否则还是返回错误码。

5、将数据从内核拷贝到用户空间。

6、完成后,返回成功提示。

多路复用IO

思考一个问题:我们还是把视角放到应用B从TCP缓冲区中读取数据这个环节来。如果在并发的环境下,可能会N个人向应用B发送消息,这种情况下我们的应用就必须创建多个线程去读取数据,每个线程都会自己调用recvfrom 去读取数据。那么此时情况可能如下图:

如上图一样,并发情况下服务器很可能一瞬间会收到几十上百万的请求,这种情况下应用B就需要创建几十上百万的线程去读取数据,同时又因为应用线程是不知道什么时候会有数据读取,为了保证消息能及时读取到,那么这些线程自己必须不断的向内核发送recvfrom 请求来读取数据;

那么问题来了,这么多的线程不断调用recvfrom 请求数据,先不说服务器能不能扛得住这么多线程,就算扛得住那么很明显这种方式是不是太浪费资源了,线程是我们操作系统的宝贵资源,大量的线程用来去读取数据了,那么就意味着能做其它事情的线程就会少。

![]()

总结:复用IO的基本思路就是通过slect或poll、epoll来监控多fd,来达到不必为每个fd创建一个对应的监控线程,从而减少线程资源创建的目的。

import select,socket

server= socket.socket()

server.bind(("localhost",9000))

server.listen(1000)

server.setblocking(False)#设置为非阻塞

inputs= [server,] #一开始只有自己的连接,所以一开始把自己的连接发到列表中

outputs= []

while True:

#exceptional表示如果inputs列表中出现异常,会输出到这个exceptional中

readable,writeable,exceptional= select.select(inputs,outputs,inputs)

# print(readable,writeable,exceptional)

for rin readable:

if ris server: #代表一个新连接

conn,addr= r.accept()

print("来了一个新连接",addr)

inputs.append(conn)#因为这个新建立的连接还没有发数据过来,现在就接收的话程序就报错了

#所以要想实现这个客户端发数据过来时server端能知道,就需要让让select再检测这个conn

else:

data= r.recv(1024)

print("收到数据:",data)

r.send(data)

print("send done....")信号驱动IO

复用IO模型解决了一个线程可以监控多个fd的问题,但是select是采用轮询的方式来监控多个fd的,通过不断的轮询fd的可读状态来知道是否就可读的数据,而无脑的轮询就显得有点暴力,因为大部分情况下的轮询都是无效的,所以有人就想,能不能不要我总是去问你是否数据准备就绪,能不能我发出请求后等你数据准备好了就通知我,所以就衍生了信号驱动IO模型。

于是信号驱动IO不是用循环请求询问的方式去监控数据就绪状态,而是在调用sigaction时候建立一个SIGIO的信号联系,当内核数据准备好之后再通过SIGIO信号通知线程数据准备好后的可读状态,当线程收到可读状态的信号后,此时再向内核发起recvfrom读取数据的请求,因为信号驱动IO的模型下应用线程在发出信号监控后即可返回,不会阻塞,所以这样的方式下,一个应用线程也可以同时监控多个fd。

信号驱动IO,预先在内核中设置一个回调函数,当某个事件发生时,内核使用信号(SIGIO)通知进程来处理(运行回调函数)。 它也可以看成是一种异步IO,因为检测fd是否有数据和是否可读写是在两个流程中做的。

#include

#include

#include

#include

#include

#include

#include

#include

int socket_fd = 0;

void do_sometime(int signal) {

struct sockaddr_in cli_addr;

int clilen = sizeof(cli_addr);

int clifd = 0;

char buffer[256] = {0};

int len = recvfrom(socket_fd, buffer, 256, 0, (struct sockaddr *)&cli_addr,

(socklen_t)&clilen);

printf("Mes:%s", buffer);

sendto(socket_fd, buffer, len, 0, (struct sockaddr *)&cli_addr, clilen);

}

int main(int argc, char const *argv[]) {

socket_fd = socket(AF_INET, SOCK_DGRAM, 0);

struct sigaction act;

act.sa_flags = 0;

act.sa_handler = do_sometime;

sigaction(SIGIO, &act, NULL); // 监听IO事件

struct sockaddr_in servaddr;

memset(&servaddr, 0, sizeof(servaddr));

servaddr.sin_family = AF_INET;

servaddr.sin_port = htons(8888);

servaddr.sin_addr.s_addr = INADDR_ANY;

//设置将要在socket_fd上接收SIGIO的进程

fcntl(socket_fd, F_SETOWN, getpid());

int flags = fcntl(socket_fd, F_GETFL, 0);

flags |= O_NONBLOCK;

flags |= O_ASYNC;

fcntl(socket_fd, F_SETFL, flags);

bind(socket_fd, (struct sockaddr *)&servaddr, sizeof(servaddr));

while (1) sleep(1);

close(socket_fd);

return 0;

}

一般信号驱动io用于udp。

异步IO

其实经过了上面两个模型的优化,我们的效率有了很大的提升,但是我们当然不会就这样满足了,有没有更好的办法,通过观察我们发现,不管是IO复用还是信号驱动,我们要读取一个数据总是要发起两阶段的请求,第一次发送select请求,询问数据状态是否准备好,第二次发送recevform请求读取数据。

![]()

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#define BUFFER_SIZE 1025

void aio_completion_handler(sigval_t sigval)

{

//用来获取读aiocb结构的指针

struct aiocb *prd;

int ret;

prd = (struct aiocb *)sigval.sival_ptr;

printf("hello\n");

//判断请求是否成功

if(aio_error(prd) == 0)

{

//获取返回值

ret = aio_return(prd);

printf("读返回值为:%d\n",ret);

}

}

int main(int argc,char **argv)

{

int fd,ret;

struct aiocb rd;

fd = open("test.txt",O_RDONLY);

if(fd < 0)

{

perror("test.txt");

}

//填充aiocb的基本内容

bzero(&rd,sizeof(rd));

rd.aio_fildes = fd;

rd.aio_buf = (char *)malloc(sizeof(BUFFER_SIZE + 1));

rd.aio_nbytes = BUFFER_SIZE;

rd.aio_offset = 0;

//填充aiocb中有关回调通知的结构体sigevent

rd.aio_sigevent.sigev_notify = SIGEV_THREAD;//使用线程回调通知

rd.aio_sigevent.sigev_notify_function = aio_completion_handler;//设置回调函数

rd.aio_sigevent.sigev_notify_attributes = NULL;//使用默认属性

rd.aio_sigevent.sigev_value.sival_ptr = &rd;//在aiocb控制块中加入自己的引用

//异步读取文件

ret = aio_read(&rd);

if(ret < 0)

{

perror("aio_read");

}

printf("异步读以开始\n");

sleep(1);

printf("异步读结束\n");

return 0;

} 可以看出,阻塞程度:阻塞IO>非阻塞IO>多路复用IO>信号驱动IO>异步IO,效率是由低到高的。

参考

golang tcp write阻塞_socket缓冲区以及阻塞模式详解

java网络编程ServerSocket类 和Socket类的常用构造方法及其方法

Netty-基础篇(1)-网络IO,同步IO&异步IO,阻塞IO&非阻塞IO,BIO&NIO&AIO

Netty入门教程——认识Netty

JAVA NIO 服务器与客户端实现示例(代码1)

NIO学习--Reactor模型

Netty5源码分析(三) -- Channel如何注册OP_ACCEPT, OP_READ, OP_WRITE

Netty 那些事儿 ——— Reactor模式详解

NIO实现Reactor多线程模型--代码

100%弄明白5种IO模型

从tcp原理角度理解Broken pipe和Connection Reset by Peer的区别