使用docker完成minio服务部署扩容备份迁移生产实践文档

一、minio服务扩容方案

当服务器存储空间不足的时候,需要进行扩容,扩容过程中需要短暂停机时间,预计在一小时内能够完成和恢复

统一注意事项

强烈建议为部署中的所有节点选择基本相似的硬件配置。确保硬件(CPU、内存、主板、存储适配器)和软件(操作系统、内核设置、系统服务)在所有节点上保持一致。

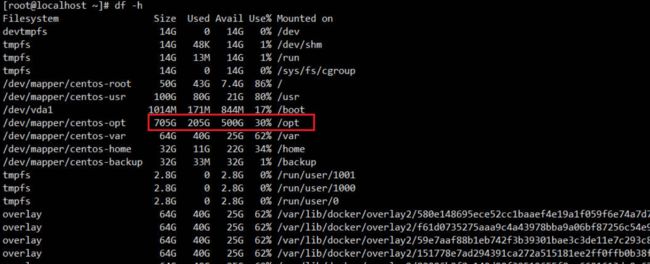

由于文件服务用于文件上传与下载,需要选择一个存储空间大的磁盘(生产环境可能不一样,因此需要检查),查看服务器的最大磁盘空间:df -h 例如

由上图可以看出,/opt 目录磁盘空间最大,检查docker-compose的minio映射目录,若生产磁盘目录也是/opt最大,则用默认的docker-compose;

若生产的最大磁盘目录为其他,例如发现磁盘空间最大根目录为 /usr 则需要修改docker-compose中的对应数据映射目录

# minio集群部署模式下

- /opt/CommandCenter/minio/data1:/data1 [修改为] - /usr/CommandCenter/minio/data1:/data1

- /opt/CommandCenter/minio/data2:/data2 [修改为] - /usr/CommandCenter/minio/data2:/data2

1.1 第一阶段 部署[3]个节点

首先检查部署所在服务器的是否开放 9000、9001 端口,若没有开放则需要开放9000、9001 端口

# 查看开放的端口号,若列表中没有9000、9001则需要开放9000、9001 端口

firewall-cmd --list-ports

#开放9000端口,为minio后端代码访问端口

firewall-cmd --zone=public --add-port=9000/tcp --permanent

#开放9001端口,为minio后台管理界面端口

firewall-cmd --zone=public --add-port=9001/tcp --permanent

# 重启防火墙,使开放端口生效

firewall-cmd --reload

这里以部署3台服务器为示例演示集群部署,生产以实际环境服务器为准:

| 服务器别名 | 服务器ip地址 | 后端代码访问端口号 | 后台管理界面端口号 |

|---|---|---|---|

| minio01 | 16.123.11.16 | 9000 | 9001 |

| minio02 | 16.123.11.15 | 9000 | 9001 |

| minio03 | 16.123.11.14 | 9000 | 9001 |

在【portainer】中分别在【3】台服务器上运行此 docker-compose 文件(集群中每个docker-compose内容稍有不同)即可完 minio 的集群部署;

每台服务器的minio的docker-compose.yml文件为:主要按照实际文件修改: hostname 、 container_name 、 extra_hosts

注意:每台服务器中的 docker-compose.yaml 文件有 hostname 、 container_name 、 extra_hosts属性有区别,集群中每台minio的用户名和密码需要保持一致

version: "3.0"

services:

minio:

# 最新版的minio

image: quay.io/minio/minio

# 这里的 minio0{1...3}代表:部署3个节点(即3台服务器), data{1...2}代表:每个节点分别映射两个存储文件夹

command: server --address ":9000" --console-address ":9001" http://minio0{1...3}/data{1...2}

restart: always

hostname: minio01 # 注意:每个节点修改成不同的名字,与下面的 extra_hosts 保持名称一致

container_name: minio01 # 注意:每个节点修改成不同的名字,与下面的 extra_hosts 保持名称一致

environment:

# 集群中每个节点的用户名和密码需保持一致

MINIO_ROOT_USER: xxxxxx

MINIO_ROOT_PASSWORD: xxxxxxx

MINIO_PROMETHEUS_AUTH_TYPE: public

TZ: Asia/Shanghai

extra_hosts:

# 这里分别填写,集群中每台服务器的ip以及自定义hostname

- "minio01:16.123.11.16"

- "minio02:16.123.11.15"

- "minio03:16.123.11.14"

volumes:

- /opt/CommandCenter/minio/data1:/data1

- /opt/CommandCenter/minio/data2:/data2

#将外边时间直接挂载到容器内部,权限只读

- /etc/localtime:/etc/localtime:ro

#将外面的时间挂载到容器内部,权限只读,容器内不可修改

- /etc/timezone:/etc/timezone:ro

network_mode: "host"

logging:

driver: "json-file"

options:

max-size: "50M"

max-file: "10"

deploy:

resources:

limits:

cpus: "4"

memory: 4096M

reservations:

memory: 2048M

**验证:**部署完成后,在浏览器访问 http://ip:9000 ,ip为集群中的任意一台服务器ip,docker-compose中输入的MINIO_ROOT_USER对应值为用户名,MINIO_ROOT_PASSWORD对应值为密码

登录后选择菜单【Monitoring】—》【Metrics】查看集群情况,Servers对应在线节点数量,Drives代表磁盘在线数量

1.1.1 请检查nginx配置文件中是否包含以下配置,若没有则新增;若新增,则需要重启nginx

# minio 集群中的节点

upstream minioCluster{

server 16.123.11.16:9000; #将127.0.0.1修改为minio服务主节点所在机器IP

server 16.123.11.15:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

server 16.123.11.14:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

}

server {

listen 9002;

server_name 127.0.0.1; #此处填写当前nginx服务所在的服务器ip

client_max_body_size 4096M;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

proxy_pass http://minioCluster;

proxy_set_header x-real-ip $remote_addr;

proxy_set_header x-forwarded-for $proxy_add_x_forwarded_for;

proxy_set_header host $http_host;

}

}

1.2 第二阶段 当存储容量不足的时候,再部署[3]个节点实现扩容

注意:不支持单独添加一个节点组成新的集群

首先检查部署所在服务器的是否开放 9000、9001 端口,若没有开放则需要开放9000、9001 端口

# 查看开放的端口号,若列表中没有9000、9001则需要开放9000、9001 端口

firewall-cmd --list-ports

#开放9000端口,为minio后端代码访问端口

firewall-cmd --zone=public --add-port=9000/tcp --permanent

#开放9001端口,为minio后台管理界面端口

firewall-cmd --zone=public --add-port=9001/tcp --permanent

# 重启防火墙,使开放端口生效

firewall-cmd --reload

这里以部署3台服务器为示例演示集群部署,生产以实际环境服务器为准:

| 服务器别名 | 服务器ip地址 | 后端代码访问端口号 | 后台管理界面端口号 |

|---|---|---|---|

| minio04 | 16.123.11.13 | 9000 | 9001 |

| minio05 | 16.123.11.12 | 9000 | 9001 |

| minio06 | 16.123.11.11 | 9000 | 9001 |

在【portainer】中分别在【3】台服务器上运行此 docker-compose 文件(集群中每个docker-compose内容稍有不同)即可完 minio 的集群部署;

每台服务器的minio的docker-compose.yml文件为:

注意:每台服务器中的 docker-compose.yaml 文件有 hostname 、 container_name 、 extra_hosts属性有区别,集群中每台minio的用户名和密码需要保持一致

注意 **command、extra_hosts、**hostname 、 container_name 对内的变化。

扩容的时候【每个节点(包含之前的节点)】都需要按照此处来修改,然后重新部署每个节点

version: "3.0"

services:

minio:

# minio最新版

quay.io/minio/minio

# 这里的 minio0{1...3}代表:部署3个节点(即2台服务器), data{1...2}代表:每个节点分别映射两个存储文件夹

command: server --address ":9000" --console-address ":9001" http://minio0{1...3}/data{1...2} http://minio0{4...6}/data{1...2}

restart: always

hostname: minio03 # 注意:每个节点修改成不同的名字,与下面的 extra_hosts 保持名称一致

container_name: minio03 # 注意:每个节点修改成不同的名字,与下面的 extra_hosts 保持名称一致

environment:

# 集群中每个节点的用户名和密码需保持一致

MINIO_ROOT_USER: xxxxxxxx

MINIO_ROOT_PASSWORD: xxxxxxxxxx

MINIO_PROMETHEUS_AUTH_TYPE: public

TZ: Asia/Shanghai

extra_hosts:

# 这里分别填写,集群中每台服务器的ip以及自定义hostname

- "minio01:16.123.11.16"

- "minio02:16.123.11.15"

- "minio03:16.123.11.14"

- "minio04:16.123.11.13"

- "minio05:16.123.11.12"

- "minio06:16.123.11.11"

volumes:

- /opt/CommandCenter/minio/data1:/data1

- /opt/CommandCenter/minio/data2:/data2

#将外边时间直接挂载到容器内部,权限只读

- /etc/localtime:/etc/localtime:ro

#将外面的时间挂载到容器内部,权限只读,容器内不可修改

- /etc/timezone:/etc/timezone:ro

network_mode: "host"

logging:

driver: "json-file"

options:

max-size: "50M"

max-file: "10"

deploy:

resources:

limits:

cpus: "4"

memory: 4096M

reservations:

memory: 2048M

**验证:**部署完成后,在浏览器访问 http://ip:9000 ,ip为集群中的任意一台服务器ip,docker-compose中输入的MINIO_ROOT_USER对应值为用户名,MINIO_ROOT_PASSWORD对应值为密码

登录后选择菜单【Monitoring】—》【Metrics】查看集群情况,Servers对应在线节点数量,Drives代表磁盘在线数量

注意:修改nginx的配置,将新增的节点添加到此处,然后重启nginx

# minio 集群中的节点

upstream minioCluster{

server 16.123.11.16:9000; #将127.0.0.1修改为minio服务主节点所在机器IP

server 16.123.11.15:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

server 16.123.11.14:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

server 16.123.11.13:9000; #将127.0.0.1修改为minio服务主节点所在机器IP

server 16.123.11.12:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

server 16.123.11.11:9000; #将127.0.0.1修改为minio服务备节点所在机器IP

}

server {

listen 9002;

server_name 127.0.0.1; #此处填写当前nginx服务所在的服务器ip

client_max_body_size 4096M;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

proxy_pass http://minioCluster;

proxy_set_header x-real-ip $remote_addr;

proxy_set_header x-forwarded-for $proxy_add_x_forwarded_for;

proxy_set_header host $http_host;

}

}

二、minio数据备份与迁移

文件服务为集群部署,自带数据备份功能:

比如部署了N个节点,当存活的节点有 大于 N/2 的节点存活的时候,都能够获取到完整的数据并且提供服务

多节点/驱动器级别的可靠性,具有可配置的容忍度,最多可丢失 1/2 所有节点/驱动器 。

2.1 检查/安装 mc客户端

数据的备份与迁移都依赖于mc客户端,mc客户端源于minio官方,需要确认mc客户端已经安装

# 查看是否安装mc

mc --help

# 若出现命令未发现,则说明mc没有安装,需要安装mc客户端

[root@localhost minio-binaries]# mc --help

-bash: mc: command not found

# 若出现以下命令则说明已经安装,按键盘q键则可以退出

[root@localhost minio-binaries]# mc --help

───────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────── (q)uit/esc

NAME:

mc - MinIO Client for object storage and filesystems.

USAGE:

mc [FLAGS] COMMAND [COMMAND FLAGS | -h] [ARGUMENTS...]

COMMANDS:

alias manage server credentials in configuration file

ls list buckets and objects

mb make a bucket

rb remove a bucket

cp copy objects

mv move objects

rm remove object(s)

mirror synchronize object(s) to a remote site

cat display object contents

head display first 'n' lines of an object

pipe stream STDIN to an object

find search for objects

sql run sql queries on objects

stat show object metadata

tree list buckets and objects in a tree format

du summarize disk usage recursively

retention set retention for object(s)

legalhold manage legal hold for object(s)

support support related commands

license license related commands

share generate URL for temporary access to an object

version manage bucket versioning

ilm manage bucket lifecycle

quota manage bucket quota

encrypt manage bucket encryption config

event manage object notifications

watch listen for object notification events

undo undo PUT/DELETE operations

anonymous manage anonymous access to buckets and objects

tag manage tags for bucket and object(s)

diff list differences in object name, size, and date between two buckets

replicate configure server side bucket replication

admin manage MinIO servers

────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────── 0%

可以通过 在线/离线 模式根据不同的服务器架构安装mc客户端:

在线安装mc客户端:

当服务架构为linux-amd64的时候,安装mc客户端为:

curl https://dl.minio.org.cn/client/mc/release/linux-amd64/mc \

--create-dirs \

-o /usr/local/minio-binaries/mc

chmod +x /usr/local/minio-binaries/mc

export PATH=$PATH:/usr/local/minio-binaries/

mc --help

当服务器架构为linux-arm64的时候,安装mc客户端为:

curl https://dl.minio.org.cn/client/mc/release/linux-arm64/mc \

--create-dirs \

-o /usr/local/minio-binaries/mc

chmod +x /usr/local/minio-binaries/mc

export PATH=$PATH:/usr/local/minio-binaries/

mc --help

离线安装mc客户端:

当服务架构为linux-amd64的时候,安装mc客户端为:

1.创建目标文件夹

mkdir -p /usr/local/minio-binaries

2.从安装包中取出linux-amd64对应的 mc 安装包上传到 /usr/local/minio-binaries 目录下

3.赋予mc客户端执行权限

chmod +x /usr/local/minio-binaries/mc

4.添加环境变量

export PATH=$PATH:/usr/local/minio-binaries/

当服务器架构为linux-arm64的时候,安装mc客户端为:

1.创建目标文件夹

mkdir -p /usr/local/minio-binaries

2.从安装包中取出linux-arm64对应的 mc 安装包上传到 /usr/local/minio-binaries 目录下

3.赋予mc客户端执行权限

chmod +x /usr/local/minio-binaries/mc

4.添加环境变量

export PATH=$PATH:/usr/local/minio-binaries/

2.2 minio数据备份与迁移方案

设置存储服务器别名

# 在安装了mc客户端的服务器上执行设置服务别名

mc alias set minio_A http://127.0.0.1:9002 yourusername youruserpassword

说明:

minio_A 为自定义存储服务器别名

需要将127.0.0.1替换 nginx 的ip或vip(vip优先)

yourusername代表minio的用户名

youruserpassword代表minio的密码

# 查看已经设置的别名

mc alias list

2.2.1 将数据【备份】到本地其他磁盘

# 创建本地备份目录,注意备份目录磁盘空间需要大于本次备份的数据 df -h 查看磁盘空间

mkdir -p /opt/minio/bakdata

# 将minio中存储的数据全部备份到本地

mc cp --recursive minio_A/ /opt/minio/bakdata/

说明 minio_A 自定义的别名

若需要【指定备份某个桶】的数据,则执行 mc cp --recursive minio_A/mybucket/ /opt/minio/bakdata/mybucket/

mybucket为桶的名称

2.2.2 将备份的数据上传到新的minio集群上面

# 这里将minio_A备份的数据,上传到minio_B上面,先设置minio_B的别名

mc alias set minio_B http://127.0.0.1:9002 yourusername youruserpassword

# 查看已经设置的别名

mc alias list

# 查看minio_A服务上面所有桶的名称

mc ls minio_A

# 查看minio_B服务上面所有桶的名称

mc ls minio_B

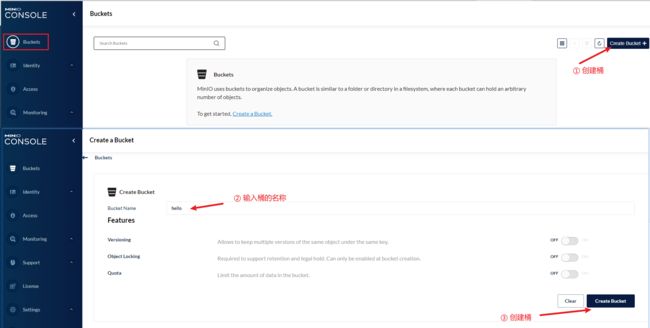

若minio_B中缺少minio_A中的桶数据,则需要登录到新的桶后台新增minio_B中缺少的桶

# 将minio_A备份的[全部]数据,上传到minio_B上面,注意备份文件目录路径需以'/'结尾

mc cp --recursive /opt/minio/bakdata/ minio_B

注意:迁移过程中若出现目录不存在,则登录到新的集群去创建(Bucket `xxxxxxxx` does not exist)

# 将minio_A备份[mybucket桶]的数据,上传到minio_B[mybucket桶]上面,注意备份文件目录路径需以'/'结尾

mc cp --recursive /opt/minio/bakdata/mybucket/ minio_B/mybucket/

注意:迁移过程中若出现目录不存在,则登录到新的集群去创建(Bucket `xxxxxxxx` does not exist)

注意:迁移过程中若出现提示目录不存在,则登录到新的集群去创建(Bucket xxxxxxxx does not exist)

**创建桶:**浏览器登录管理后台 http://ip:9000 ip为新集群中的任意一台minio所在服务的ip,在docker-compose中的 MINIO_ROOT_USER和MINIO_ROOT_PASSWORD分别对应登录的用户名和密码

2.2.3 将一个minio中的数据区【迁移】到另外一个新的minio集群

# 查看minio_A服务上面所有桶的名称

mc ls minio_A

# 查看minio_B服务上面所有桶的名称

mc ls minio_B

若minio_B中缺少minio_A中的桶数据,则需要登录到新的桶后台新增minio_B中缺少的桶

#将服务器A上名为“mybucket”的桶的数据迁移到服务器B的“mybucket”桶中

mc cp --recursive minio_A/mybucket/ minio_B/mybucket/

注意:若提示(Bucket `xxxxxxxx` does not exist)则需要登录到新的集群去创建名为mybucket的桶

#将服务器A上面的所有数据迁移到服务器B上面

mc cp --recursive minio_A minio_B

注意:若提示(Bucket `xxxxxxxx` does not exist)则需要登录到新的集群去创建名为mybucket的桶