LineMarkNet:库位线检测方法

文章:LineMarkNet: Line Landmark Detection for Valet Parking

作者:Zizhang Wu, Fan Wang , Yuanzhu Gan , Tianhao Xu, Weiwei Sun and Rui Tang

编辑:点云PCL

欢迎各位加入知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。

公众号致力于点云处理,SLAM,三维视觉,高精地图等领域相关内容的干货分享,欢迎各位加入,有兴趣的可联系[email protected]。侵权或转载联系微信cloudpoint9527。

摘要

本文旨在实现精确高效的库位线标记检测,这是自动驾驶中长期存在但尚未解决的问题。为此提出了一种深度线段标记检测系统,精心设计了轻量级模块。具体来说,我们首先经验性地设计了四种通用线段标记,包括三种物理线段和一种新颖的心理线段,这四种线段标记对于库位线非常有效。然后,我们开发了一个深度网络(LineMarkNet),用于从全景摄像头中检测线段标记,通过预校准的单应性矩阵,将四个独立摄像头的上下文融合到统一的鸟瞰视图(BEV)空间中,具体地说融合了全景视图特征和BEV特征,然后使用多任务解码器来检测多个线段标记,在对象检测任务中采用基于中心的策略,并设计了图形变换器,以通过分层级图形推理增强视觉变换器的语义分割任务。最后进一步参数化检测到的线段标记,其中一个新颖的滤波后端结合了时间和多视图一致性,以实现平稳和稳定的检测。此外,我们标注了一个大规模数据集以验证我们的方法。实验结果显示,与几种线段检测方法相比,我们的框架实现了更强的性能,并验证了多任务网络在高效进行实时线段标记检测方面的优越性能,同时在Qualcomm 820A平台上保持了卓越的准确性。

主要贡献

图1 代客泊车的四种库位线标记检测:受到工业应用的经验观察启发,我们总结了代客泊车所必需的四个通用线段标记。具体而言,我们提出了三个物理线段标记(a:停车线,b:车道线,c:中央线)和一个心理线段标记(d:静止车辆边界线)。

实验表明LineMarkNet取得了令人印象深刻的性能。然而,由于遮挡我们观察到检测到的线段标记仍然存在噪音,尽管噪音输出并不令人意外,但对于需要高精度的代客泊车来说并不令人满意。因此,为了减少噪音,我们通过一个新颖的滤波后端来完善LineMarkNet的初始输出,滤波后端的思想是通过强化多视图和时间一致性来强化线段标记的多视图和时间一致性,使线段标记在多个鱼眼摄像头和相邻帧之间保持一致。我们的实验表明,我们的后端有效地去除了噪音,实现了平稳稳定的库位线标记检测。在实验中,我们观察到我们的系统实现了准确的库位标记检测。此外精心设计了系统的模块,使其轻量级,既在内存上又在计算上高效。这使我们的线段检测系统能够在Qualcomm 820A平台上实时运行。我们简要总结了我们的贡献如下:

* 我们定义了四种通用且信息丰富的线段标记,包括三种物理线段和一种新颖的心理线段。这四种线段标记对于代客泊车是有效且必要的。

* 我们提出了LineMarkNet,用于从全景摄像头系统中检测线段标记,采用多任务架构。在其中,我们融合了全景视图特征和BEV特征到改进的多任务解码器(语义分割和对象检测),并通过后续的线段拟合模块计算线段参数。

* 我们标注了一个大规模数据集,允许我们训练我们的LineMarkNet,其中包含代客泊车场景中的大量长线段标记。

* 我们进一步提出了一个新颖的滤波后端,用于完善LineMarkNet的初始输出,通过强化多视图和时间一致性来滤除不正确的线段标记。

* 与先前的线段检测方法相比,我们的线段标记检测系统实现了卓越的准确性,同时保持实时性。

内容概述

图2 库位线检测系统 - 我们的系统由LineMarkNet组成,它是一个多任务架构,可以从环视相机中检测多个线段标志,以及一个新颖的过滤后端,用于消除lineMarksNet输出中的检测错误。我们的系统能够有效地检测线段标志,并且同时实时运行。

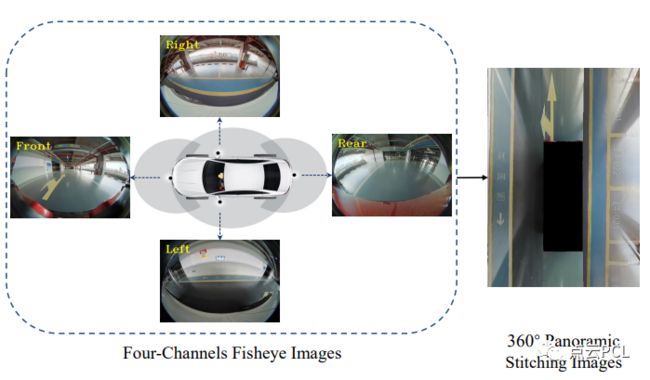

本文引入了一个用于代客泊车的深度线段标志检测系统。如图2所示,该系统由LineMarkNet和一个高效的过滤后端组成,LineMarkNet从环视相机中检测线段标志,而通过过滤LineMarkNet的输出中的噪声和异常值,我们进一步增强了结果。需要注意的是,尽管有两个复杂的组件,但我们的系统非常高效,以至于我们可以在Qualcomm 820A平台上实现实时线段标志检测。具体来说,我们从环视相机中检测线段标志。如图4所示,环视相机系统由四个鱼眼相机组成,具有大视场,使得长线段标志在四幅图像中完全可见。

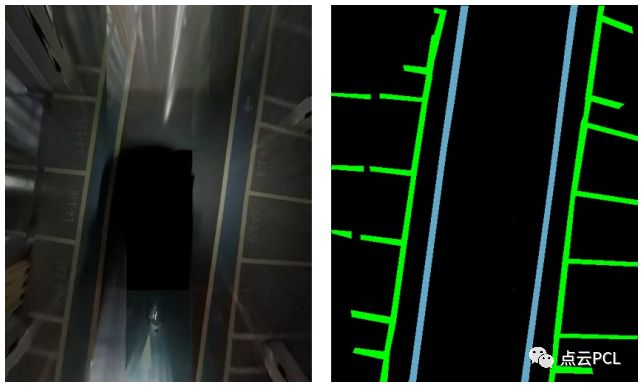

图4 四个环视摄像头的示意图以及从四个环视摄像头图像合成的BEV图像的示例。

为了从周围视图中检测线段标志,我们提出了LineMarkNet,如图3所示,我们采用多任务架构来检测多个线段标志。远距离的上下文信息是检测长线段标志的关键。因此,我们通过校准的单应性将在2D图像平面中提取的信息转换到BEV空间。在某种程度上,我们在BEV空间中检测线段标志。

图3 LineMarkNet的框架 - 该网络以环视鱼眼图像为输入,从而允许在大视场中进行线段标志检测。具体而言,我们在BEV空间中融合了上下文信息,并执行多个任务,其中我们的系统通过语义分割和目标检测任务感知线段标志,并通过后续的线段拟合模块计算线段参数。

此外提出了一个过滤后端,进一步优化了LineMarkNet的结果,尽管来自LineMarkNet的初始检测超越了普通的基线,但线段标志的检测仍然存在噪声,而代客泊车需要非常高的精度,以确保驾驶的安全。为了缓解这个问题,我们建议通过强化多视图和时间上的一致性来优化检测。具体而言,我们的过滤后端鼓励在不同视图和相邻帧之间实现线段标志的一致性检测。因此,我们的系统实现了稳定和一致的线段标志检测,从而使代客泊车中的实际应用成为可能。

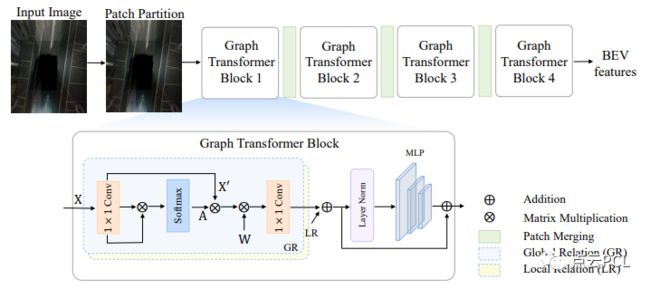

图5 BEV编码器的总体结构。BEV编码器利用图变换器,通过分层级图推理增强了视觉变换器,包括全局和局部关系建模。

多任务解码器包括语义分割任务和目标检测任务,在提取线段记的像素并在不同的后处理之后执行矢量化后输出。

图6 我们解码器的总体结构,包括目标检测解码器和语义分割解码器。

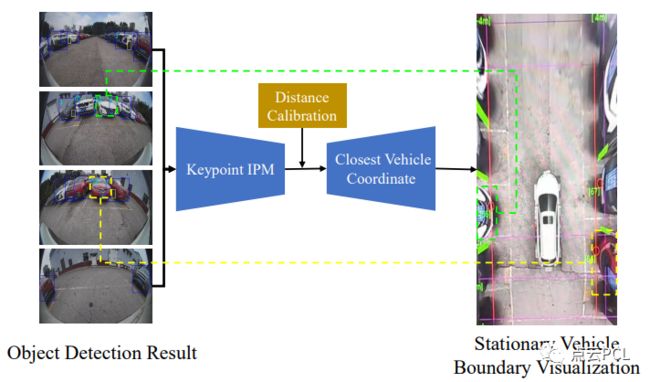

静止车辆边界线对于帮助自动停车车辆更准确地确定可行驶区域非常重要,为了生成它,我们需要从鱼眼图像中检测和定位周围的车辆,然后计算它们的关键点,如图7所示

图7 显示了静止车辆边界生成方法的结构。

实验

首先详细介绍了我们的实验设置,然后提供了定量和定性的结果,以验证我们的方法的有效性。还展示了关于我们的方法不同组成部分的消融研究,结果表明,我们的方法实现了有效而高效的线段标志检测。

数据:为了验证我们的方法,我们收集了一个大规模的数据集,用于停车场线路标志的检测。该数据集包括14万个训练样本和40万个测试样本。

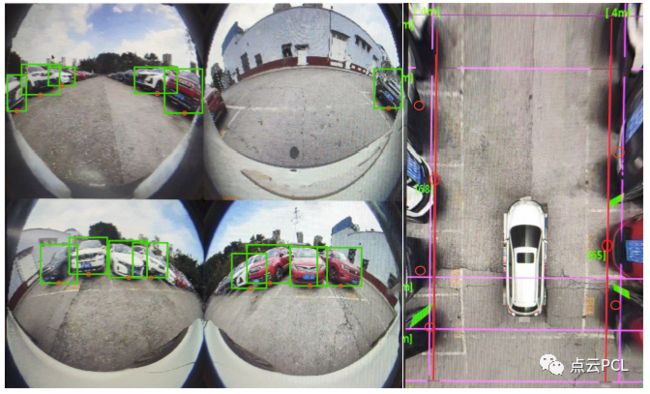

图8 环视图图像中静止车辆的标注示例,为静止汽车标注了边界框,通过这些边界框我们训练了静止车辆边界线检测模块。

使用了环视摄像机系统拍摄图像,如图4所示,每个样本由四张鱼眼图像组成,图像分辨率为1280×960。为了训练我们的系统,我们对数据集进行了两种类型的标注 - 即静止车辆的边界框(如图8所示)和BEV空间中线地标的像素级标签地图(如图9所示)。需要注意的是,静止车辆边界线的检测依赖于车辆边界框的关键点(底部中点),因此静止车辆边界线的标注与静止车辆的边界框标注相同。

图9:BEV图像中线标的示例标注,以像素级的方式标注线段标志。

准确性评估:我们使用误检率(FD)和漏检率(MD)来评估线路标志检测的准确性。如表1所示,我们的方法在测试集中实现了非常低的MD和FD,我们实现了低于3%的较低FD和低于1%的较低MD,适用于所有类型的线段标志。

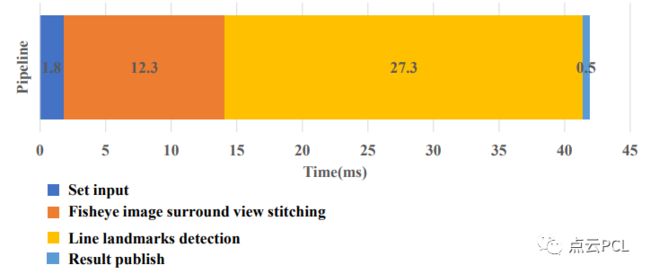

如图10所示,我们估算了我们系统中耗时较长的部分的运行时间。

图10 显示了我们在Qualcomm 820A平台上的系统运行时间。

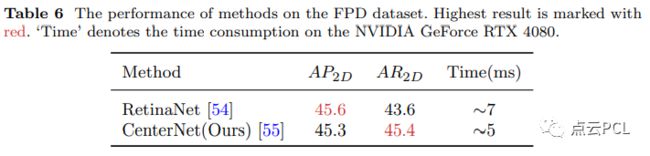

表6,显示了不同方法在FPD数据集上的性能。

失败案例:图12展示了一些失败案例。图12(a)说明了当线状地标与车辆的行进方向垂直时,该方法会失败。如图12(b)、(c)和(d)所示,我们的方法在极端恶劣的光线条件下(例如,暗光环境)无法检测到中央线、停车线、车道线和静止车辆的边界线。

图12 失败案例 - (a) 线段地标与车辆行驶方向垂直;(b) 在光线条件差的情况下的中央线;(c) 在光线条件差的情况下的停车线和静止车辆的边界线;(d) 在光线条件差的情况下的车道线。

总结

在这项工作提出了一个适用而高效的停车位线段检测系统,为了验证我们的方法,我们进一步提出了一个基准,其中定义了四种类型的线段地标,为各种停车场的自动驾驶提供了基础。实验结果表明,我们的系统在低成本计算平台上实时运行的同时,实现了低错误率的检测。尽管我们取得了令人鼓舞的结果,但错误率仍然不为零,而完美的性能对于实际的代客泊车至关重要。

资源

自动驾驶及定位相关分享

【点云论文速读】基于激光雷达的里程计及3D点云地图中的定位方法

自动驾驶中基于光流的运动物体检测

基于语义分割的相机外参标定

综述:用于自动驾驶的全景鱼眼相机的理论模型和感知介绍

高速场景下自动驾驶车辆定位方法综述

Patchwork++:基于点云的快速、稳健的地面分割方法

PaGO-LOAM:基于地面优化的激光雷达里程计

多模态路沿检测与滤波方法

多个激光雷达同时校准、定位和建图的框架

动态的城市环境中杆状物的提取建图与长期定位

非重复型扫描激光雷达的运动畸变矫正

快速紧耦合的稀疏直接雷达-惯性-视觉里程计

基于相机和低分辨率激光雷达的三维车辆检测

用于三维点云语义分割的标注工具和城市数据集

ROS2入门之基本介绍

固态激光雷达和相机系统的自动标定

激光雷达+GPS+IMU+轮速计的传感器融合定位方案

基于稀疏语义视觉特征的道路场景的建图与定位

自动驾驶中基于激光雷达的车辆道路和人行道实时检测(代码开源)

用于三维点云语义分割的标注工具和城市数据集

更多文章可查看:点云学习历史文章大汇总

SLAM及AR相关分享

TOF相机原理介绍

TOF飞行时间深度相机介绍

结构化PLP-SLAM:单目、RGB-D和双目相机使用点线面的高效稀疏建图与定位方案

开源又优化的F-LOAM方案:基于优化的SC-F-LOAM

【开源方案共享】ORB-SLAM3开源啦!

【论文速读】AVP-SLAM:自动泊车系统中的语义SLAM

【点云论文速读】StructSLAM:结构化线特征SLAM

SLAM和AR综述

常用的3D深度相机

AR设备单目视觉惯导SLAM算法综述与评价

SLAM综述(4)激光与视觉融合SLAM

Kimera实时重建的语义SLAM系统

SLAM综述(3)-视觉与惯导,视觉与深度学习SLAM

易扩展的SLAM框架-OpenVSLAM

高翔:非结构化道路激光SLAM中的挑战

基于鱼眼相机的SLAM方法介绍

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入知识星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享与合作方式:微信“cloudpoint9527”(备注:姓名+学校/公司+研究方向) 联系邮箱:[email protected]。

为分享的伙伴们点赞吧!