【翻译】CVPR2022: Pyramid Grafting Network for One-Stage High ResolutionSaliency Detection

论文来源:CVPR 2022 北航&鹏城实验室

论文地址:https://arxiv.org/pdf/2204.05041.pdf

论文代码:GitHub - iCVTEAM/PGNet: Pyramid Grafting Network for One-Stage High Resolution Saliency Detection. CVPR 2022

摘要:

最近基于深度神经网络的显着目标检测(SOD)方法取得了显着的性能。然而,由于采样深度和感受野大小之间的矛盾,大多数为低分辨率输入设计的现有 SOD 模型在高分辨率图像上表现不佳。为了解决这一矛盾,我们提出了一种新的单阶段框架,称为金字塔嫁接网络(PGNet),使用transformer和 CNN 主干从不同分辨率的图像中独立提取特征,然后将特征从transformer分支移植到 CNN 分支。提出了一种基于注意力的跨模型移植模块(CMGM),使 CNN 分支能够在解码过程中以不同的源特征为指导,更全面地结合破碎的详细信息。此外,我们设计了一个注意力引导损失(AGL)来明确监督 CMGM 生成的注意力矩阵,以帮助网络更好地与来自不同模型的注意力交互。我们提供了一个新的超高分辨率显着性检测数据集 UHRSD,其中包含 5,920 张 4K-8K 分辨率的图像。据我们所知,它是高分辨率 SOD 任务在数量和分辨率上最大的数据集,可用于未来研究的训练和测试。在 UHRSD 和广泛使用的 SOD 数据集上进行的充分实验表明,与最先进的方法相比,我们的方法实现了卓越的性能。

图 1. 不同方法的结果比较。 (a) 输入图像。 (b) ground truth。 (c) 直接输入到基于 Resnet18 的 FPN。 (d) 下采样然后输入到基于 Swin 变换器的 FPN。 (e) 我们的。

1. 介绍

显着对象检测 (SOD) [1, 5] 旨在识别和分割特定场景中最有吸引力的对象。作为预处理步骤,它广泛应用于各种计算机视觉任务,例如光场分割 [21, 41]、实例分割 [47] 和视频对象分割 [13, 42]。

最近,基于深度神经网络的显着目标检测方法取得了显著成就[3,9,14,19,26,29]。然而,大多数现有的 SOD 方法在特定的输入低分辨率范围(例如,224 × 224、384 × 384)内表现良好。随着图像采集设备(如智能手机)的快速发展,人们可获取的图像分辨率(如1080p、2K和4K)已经远远超出了现有显着性检测方法可以直接适应的范围。如图1(c)所示,我们将高分辨率图像直接输入到常用的网络中,以Resnet-18为骨干,对比ground truth图1(b)表明分割结果不完整,很多细节区域丢失。为了减少计算消耗和内存使用,现有方法通常对输入图像进行下采样,然后对输出结果进行上采样以恢复原始分辨率,如图 1(d)所示。这个挑战是由于大多数低分辨率的 SOD 网络都是以 Encoder-Decoder 风格设计的,随着输入分辨率的急剧增加,提取的特征大小增加,但网络确定的感受野是固定的,使得相对感受野较小,最终导致无法捕获对 SOD 任务至关重要的全局语义。由于直接处理无法应对高分辨率带来的挑战,近年来出现了许多专门为高分辨率输入而设计的方法。有两种代表性的高分辨率 SOD 方法(HRSOD [40]、DHQSOD [30])。 HRSOD将整个过程分为全局阶段、局部阶段和重组阶段,其中全局阶段对局部阶段和加工过程提供指导。 DHQSOD 将 SOD 任务分解为分类任务和回归任务,这两个任务通过它们提出的 trimap 和不确定性损失连接起来。它们生成具有清晰边界的相对较好的显着图。

然而,上述两种方法都使用多阶段架构,将 SOD 分为语义(低分辨率)和详细(高分辨率)阶段。这导致了两个新问题:(1)阶段之间的上下文语义转移不一致。前一阶段得到的中间图被输入到最后一阶段,同时错误也被传递下去。此外,由于没有足够的语义支持,最后阶段的细化可能会继承甚至放大先前的错误,这意味着最终的显着图严重依赖于低分辨率网络的性能。 (2)耗时。与单阶段方法相比,多阶段方法不仅难以并行,而且存在参数数量增加的潜在问题,从而使其速度变慢。

基于现有高分辨率方法的上述缺陷,我们提出了一个新的视角,即由于单个网络中的特定特征不能同时解决感受野和细节保留的悖论,而是可以分别提取两组不同空间的特征。大小,然后将信息从一个分支移植到另一个分支。在本文中,我们重新考虑了双分支架构,并设计了一种用于高分辨率显着性检测的新型单阶段深度神经网络,称为金字塔嫁接网络 (PGNet)。如图 1 (e) 所示,我们使用 Resnet 和 Transformer 作为我们的编码器,并行提取具有双空间大小的特征。 Transformer 分支首先对 FPN 风格的特征进行解码,然后在两个分支的特征图具有相似空间大小的阶段将全局语义信息传递给 Resnet 分支。我们称这个过程为特征嫁接。最终,Resnet 分支使用嫁接的特征完成解码过程。与经典的 FPN 相比,我们以更低的成本构建了更高的特征金字塔。为了更好地跨两种不同类型的模型进行嫁接特征,我们设计了基于注意力机制的跨模型嫁接模块(CMGM),并提出了注意力引导损失来进一步指导嫁接。考虑到有监督的深度学习方法需要大量的高质量数据,我们提供了迄今为止数量最多的 4K 分辨率 SOD 数据集(UHRSD),以促进未来的高分辨率显着目标检测研究。

我们的主要贡献可以总结如下:

1. 我们提出了第一个名为 PGNet 的用于高分辨率显着目标检测的单阶段框架,它使用交错连接来捕获连续语义和丰富的细节。

2.我们引入Cross-Model Grafting Module 将信息从transformer 分支传输到CNN 分支,这使得CNN 不仅可以继承全局信息,还可以弥补两者共同的缺陷。此外,我们设计了注意力引导损失来进一步促进特征嫁接。

3.我们提供了一个新的具有挑战性的超高分辨率显着性检测数据集 (UHRSD),其中包含超过 4K 分辨率的各种场景的 5,920 张图像和相应的逐像素显着性注释,这是可用的最大的高分辨率显着性数据集。

4.现有数据集和我们的数据集的实验结果表明,我们的方法在准确性和速度方面优于最先进的方法。

2. 相关工作

在过去的几十年中,已经提出了大量的传统方法来解决显着性检测问题[12,38,39]。然而,这些方法只关注底层特征,忽略了丰富的语义信息,导致在复杂场景下性能不稳定。更多细节可以在[1]中找到。

2.1 基于深度学习的显着性检测

最近,由于深度神经网络的应用,显着性检测取得了显着进展[18,33,36,37,44]。侯等人。 [11]和陈等人。 [4] 使用深度卷积网络作为编码器来提取多级特征并设计各种模块以 FPN 风格融合它们。马等人。 [23] 和徐等人。 [37] 通过尝试各种特征连接路径来避免语义稀释,同时抑制细节丢失。此外,魏等人。 [33] 通过显式监督边缘像素生成具有清晰边界的显着图。变压器在视觉中的广泛使用也导致了显着性检测的新进展。刘等人。 [20] 使用 T2T-vit 作为主干,设计了一个具有纯 transfomer架构的多任务解码器来执行 RGB 和 RGB-D 显着性检测。然而,这些方法是为低分辨率场景设计的,不能直接应用于高分辨率场景。

2.2 高分辨率SOD

如今,专注于高分辨率 SOD 方法已经成为趋势。曾等人。 [40] 提出了一种高分辨率显着目标检测范式,使用 GSN 提取语义信息,使用 APS 引导 LRN 优化局部细节,最后使用 GLFN 进行预测融合。他们还贡献了第一个高分辨率显着对象检测数据集(HRSOD)。唐等人。 [30] 建议将显着目标检测分解为两个任务。他们首先设计 LRSCN 以在低分辨率下捕获足够的语义并生成 trimap。通过引入不确定性损失,设计的 HRRN 可以使用低分辨率数据集细化第一阶段生成的 trimap。但是,两者都使用多阶段架构,导致推理速度慢,难以满足一些现实世界的应用场景。一个更严重的问题是网络之间的语义不连贯。因此,我们的目标是设计一个单阶段深度网络来消除上述缺陷。

3. UHR 显着性检测数据集

可用的 SOD 数据集。现有的常见 SOD 数据集通常分辨率较低(低于 500 × 500 )。更重要的是,它们在训练高分辨率网络和评估高质量分割结果方面存在以下缺点。首先,图像的低分辨率导致细节信息不足。其次,注释边缘的质量很差[40]。最后,对更精细的注释水平不满意,特别是对于如图 2 (f) 所示处理草率的硬壳注释。唯一已知的高分辨率数据集是 HRSOD [40]。然而,HRSOD 中高分辨率图像的数量是有限的。

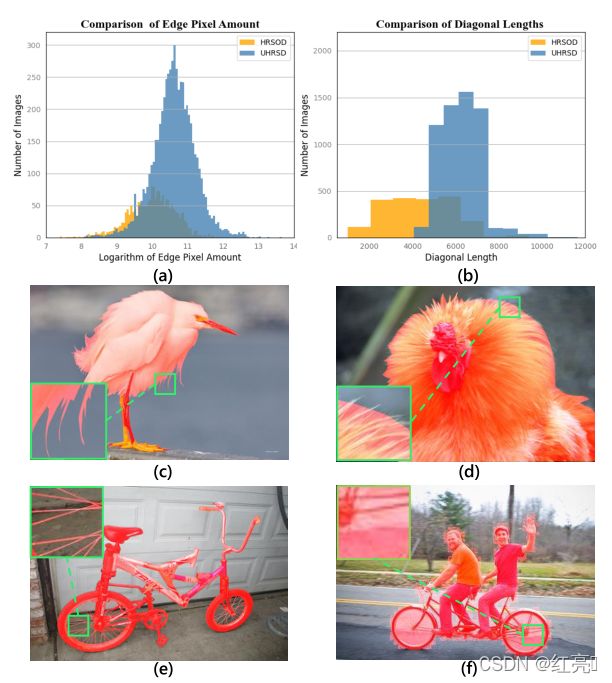

UHRSD 数据集。对于监督学习,训练数据显然很重要。在此之前,唯一可用的高分辨率训练集只有 1,610 张图像,我们通过实验发现仅对其进行训练很容易对其数据分布进行过拟合,从而显着影响模型的泛化能力。如果将低分辨率数据集混合在一起进行训练,则会引入大量噪声,影响高分辨率模型的性能。为了缓解 SOD 缺乏高分辨率数据集的问题,我们贡献了超高分辨率显着性检测 (UHRSD) 数据集,共有 5,920 张 4K(3840 × 2160)或更高分辨率的图像,包括 4,932 张用于训练的图像和 988 张用于测试的图像。从具有免费版权的网站(例如 Flickr Pixabay)中手动选择了总共 5,920 张图像。我们的数据集在图像场景方面是多种多样的,具有各种大小的复杂和简单的显着对象的平衡。构建过程中的多个参与者,以确保显着注释的准确性。图 2 说明了我们 UHRSD 的优越性。如图 2 (a) (b) 直方图所示,UHRSD 数据集比 HRSOD 数据集大得多,据我们所知,它是可用的最大数据集。在训练高分辨率深度神经网络时,大规模大大缓解了上述问题。此外,直方图图 2(b) 显示 UHRSD 中的图像大小远远超过现有的高分辨率数据集。不仅如此,图 2(a) 显示我们图像边缘的像素数量也远远超过现有的高分辨率数据集,这意味着 UHRSD 具有更丰富和更具挑战性的边缘细节。最后,通过图 2(c)-(f) 之间的比较,很明显 UHRSD 对困难案例的标注水平也比现有的高分辨率数据集和低分辨率数据集都更好。

图 2. 不同方法的结果比较。 (a) 我们的 UHRSD 和 HRSOD 之间边缘像素数量的对数比较。 (b) 我们的 UHRSD 和 HRSOD [40] 之间的对角线长度比较 (c) 我们的 UHRSD 样本。 (d) HRSOD 的样本。 (e) 来自我们 UHRSD 的样本。 (f) 来自 DUTS-TE 的样本。放大观看效果最佳。

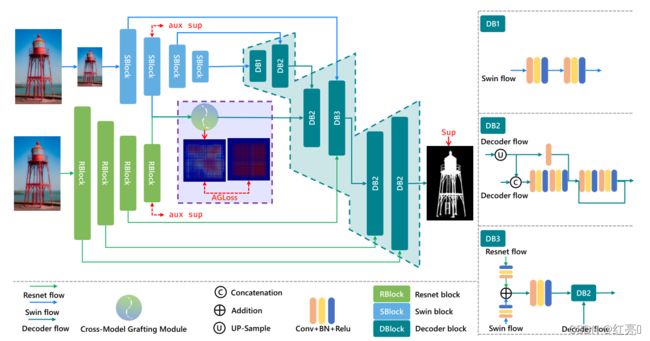

图 3. 提出的 Pyramid Grafting Network 概述。双分支分别使用 Resnet 和 Swin transformer作为编码器。 DBn是具有n个输入特征的Decoder块,具体结构如右侧所示。两个辅助监督用于监督第4.4节中提到的 RP 和 SP。

4. 方法

4.1 交错嫁接框架

所提出网络的架构如图 3 所示。可以看出,该网络由两个编码器和一个解码器组成。为了更好地执行两个编码器各自的任务,选择 Swin Transformer 和 Resnet-18 作为编码器。这种组合的选择是出于平衡效率和有效性的考虑。一方面,Transformer 编码器能够在低分辨率的情况下获得准确的全局语义信息,而卷积编码器可以在高分辨率输入的情况下获得丰富的细节。另一方面,不同模型提取的特征的可变性可能是互补的,以更准确地识别显着性。

在编码过程中,两个编码器被输入不同分辨率的图像,以分别并行捕获全局语义信息和详细信息。解码阶段可以分为三个子阶段,首先是 Swin 解码,其次是嫁接特征解码,最后是交错结构的 Resnet 解码。在第二个子阶段解码的特征是从跨模型移植模块(CMGM)产生的,其中全局语义信息从 Swin 分支移植到 Resnet 分支。 CMGM 还会处理一个名为 CAM 的矩阵以进行监督。回顾整个过程,我们通过两个下金字塔使用交错连接结构构建了一个更高的特征金字塔,如图1所示。换句话说,网络以较低的计算成本实现了更深的采样深度,以适应高分辨率带来的输入挑战。

4.2 特征提取器

针对高分辨率输入产生的大量计算消耗和内存使用,我们选择 Resnet-18 [10] 和 Swin-B [22] 作为我们的主干,以平衡性能和效率。对于 Resnet-18 编码器,将生成五个特征图,我们将其表示为 R。由顶部 7×7 层提取的特征图提供有限的性能提升,但消耗大量计算工作,尤其是对于高分辨率输入。因此,R 中使用的特征可以表示为![]() 。由于每个阶段都进行了下采样,对于输入大小 H × W ,特征

。由于每个阶段都进行了下采样,对于输入大小 H × W ,特征![]() 的大小为

的大小为![]() ,其中

,其中![]() 是特征的通道。我们删除了最后一个阶段,同时采用了 Swin 转换器的补丁嵌入特征,它生成了 4 个特征,表示为

是特征的通道。我们删除了最后一个阶段,同时采用了 Swin 转换器的补丁嵌入特征,它生成了 4 个特征,表示为![]() 。由于在transformer中嵌入dim是固定的,输入大小为224×224,S中的特征大小为

。由于在transformer中嵌入dim是固定的,输入大小为224×224,S中的特征大小为![]() 对于 S4,i = 1、2、3 和 14 × 14 × 512。 R5的空间大小接近S2,因此我们选择在这里嫁接特征。

对于 S4,i = 1、2、3 和 14 × 14 × 512。 R5的空间大小接近S2,因此我们选择在这里嫁接特征。

图 4. 通过 CMGM 消除错误的示例。 (a)(b) 是图像和ground truth掩码。 (c) 和 (d) 分别是从 Transformer 分支和 Resnet 分支生成的显着错误图。 (e) 显示了从 CMGM 生成的误差图。

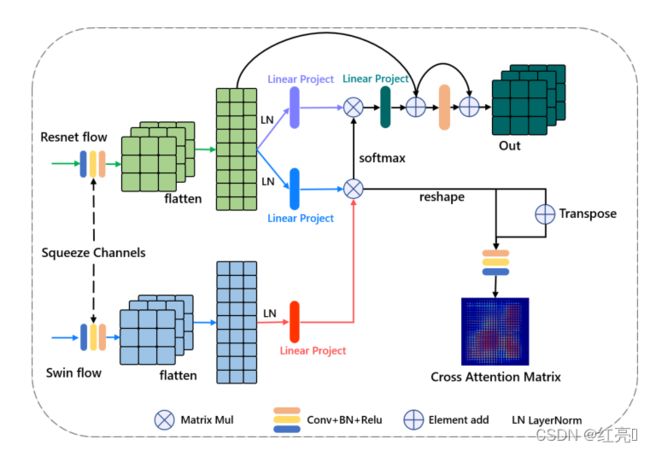

图 5. 跨模型嫁接模块的架构。

4.3 跨模型嫁接模块

我们提出了跨模型移植模块(CMGM)来移植由两个不同编码器提取的特征![]() 和

和 ![]() 。对于特征

。对于特征![]() ,由于 transformer 能够远距离捕获信息,它具有对显着性检测很重要的全局语义信息。相比之下,CNN 在提取局部信息方面表现良好,因此 fR5 具有相对丰富的细节。然而,由于特征大小和感受野之间的矛盾,在

,由于 transformer 能够远距离捕获信息,它具有对显着性检测很重要的全局语义信息。相比之下,CNN 在提取局部信息方面表现良好,因此 fR5 具有相对丰富的细节。然而,由于特征大小和感受野之间的矛盾,在![]() 中背景中会有很多噪声。对于某个区域的显着预测,不同特征生成的预测大致可以概括为三种情况:(a)都对,(b)其中一些对,(c)都错。使用诸如加法和乘法之类的元素操作的现有融合方法可能适用于前两种情况。然而,逐元素操作和卷积操作只关注有限的局部信息,导致融合方法很难弥补常见的错误。与特征融合相比,CMGM 重新计算 Resnet 特征和 Transformer 特征之间的逐点关系,将全局语义信息从 Transformer 分支转移到 Resnet 分支,从而弥补常见错误。我们通过

中背景中会有很多噪声。对于某个区域的显着预测,不同特征生成的预测大致可以概括为三种情况:(a)都对,(b)其中一些对,(c)都错。使用诸如加法和乘法之类的元素操作的现有融合方法可能适用于前两种情况。然而,逐元素操作和卷积操作只关注有限的局部信息,导致融合方法很难弥补常见的错误。与特征融合相比,CMGM 重新计算 Resnet 特征和 Transformer 特征之间的逐点关系,将全局语义信息从 Transformer 分支转移到 Resnet 分支,从而弥补常见错误。我们通过![]() 计算误差图, 其中 G 是 ground truth,P 是不同分支或 CMGM 生成的显着预测图。如图 4 所示,CMGM 按预期纠正了常见错误。

计算误差图, 其中 G 是 ground truth,P 是不同分支或 CMGM 生成的显着预测图。如图 4 所示,CMGM 按预期纠正了常见错误。

具体来说,在 CMGM 中,它首先将![]()

![]() 展平为

展平为![]() ,并对

,并对 ![]() 做同样的事情得到

做同样的事情得到![]() 。受多头自注意力机制的启发,我们分别对它们进行层归一化和线性投影,得到

。受多头自注意力机制的启发,我们分别对它们进行层归一化和线性投影,得到![]() 和

和![]() 。我们通过矩阵乘法得到Z,过程可以表示如下:

。我们通过矩阵乘法得到Z,过程可以表示如下:

然后我们将 Z 输入到线性投影层,并将其重新整形为![]() 的大小,然后再输入卷积层。过程中进行了两个快捷连接,如图 5 所示。此外,在交叉注意过程中,我们基于 Y 生成交叉注意矩阵,可以表示为:

的大小,然后再输入卷积层。过程中进行了两个快捷连接,如图 5 所示。此外,在交叉注意过程中,我们基于 Y 生成交叉注意矩阵,可以表示为:

CAM 的详细用法可以在 Sec. 4.4中找到。

4.4 注意力引导损失

为了让 CMGM 更好地服务于将信息从 Transformer 分支传输到 Renset 分支的目的,我们设计了 Attention Guided Loss 来明确地监督 Cross Attention Matrix。我们认为交叉注意矩阵应该类似于从ground truth生成的注意矩阵,因为显着特征应该具有更高的相似性,换句话说,点积应该具有更大的激活值。如图 6 所示,给定大小为 H × W 的显着图 M,我们首先将其展平为大小为1× HW 的![]() 。然后我们对

。然后我们对![]() 进行矩阵乘法,得到对应的注意力矩阵

进行矩阵乘法,得到对应的注意力矩阵![]() 。该过程可以表示为

。该过程可以表示为![]() = F (M) 并且

= F (M) 并且![]() 的值可以表示为

的值可以表示为

然后我们使用变换F(·)来构造![]() ,

,![]() ,

,![]() ,其中G是ground truth map,RP和SP分别是从特征

,其中G是ground truth map,RP和SP分别是从特征![]() 和

和![]() 生成的显着预测图。我们提出了基于加权二元交叉熵 (wBCE) 的注意力引导损失来监督从 CMGM 生成的交叉注意力矩阵 CAM,如图 5 所示。BCE [6] 可以写成:

生成的显着预测图。我们提出了基于加权二元交叉熵 (wBCE) 的注意力引导损失来监督从 CMGM 生成的交叉注意力矩阵 CAM,如图 5 所示。BCE [6] 可以写成:

其中 ![]() 是像素 (x, y) 的 ground truth标签,

是像素 (x, y) 的 ground truth标签,![]() 是预测地图中的预测概率,它们都在 [0, 1] 范围内。那么我们的

是预测地图中的预测概率,它们都在 [0, 1] 范围内。那么我们的![]() 可以表示为:

可以表示为:

其中 β 是调整权重 ω 的超参数,每个像素上的![]() 被赋予权重

被赋予权重![]() 。权重 ω 的使用有两个目的:(1)由于矩阵乘法,正负样本不平衡的程度是平方的。(2)如第 4.32节所述,我们要纠正两个分支共有的错误。当 βω 等于 0 时,方程6变成通常的二元交叉熵损失

。权重 ω 的使用有两个目的:(1)由于矩阵乘法,正负样本不平衡的程度是平方的。(2)如第 4.32节所述,我们要纠正两个分支共有的错误。当 βω 等于 0 时,方程6变成通常的二元交叉熵损失![]() 。权重 ω 可以通过以下方式计算:

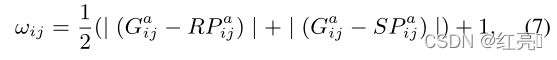

。权重 ω 可以通过以下方式计算:

其中 ![]() 和

和![]() 是上面定义的 RP 和 SP 的注意力矩阵。

是上面定义的 RP 和 SP 的注意力矩阵。

更重要的是,我们还应用了广泛使用的 IoU 损失 [24] 来更加关注图像的全局结构,如 [27] 所建议的那样。 IoU loss ![]() 可以参考补充材料。最后,我们的总损失可以表示为:

可以参考补充材料。最后,我们的总损失可以表示为:

图6:注意力矩阵的构建。该操作用于为建议的 AGL 创建目标和权重。

5. 实验

5.1 数据集和评估指标

高分辨率数据集。可用的高分辨率数据集是 UHRSD(4,932 张图像用于训练和 988 张用于测试)、HRSOD [40](1,610 张图像用于训练和 400 张用于测试)。其次是 [30, 40],我们也使用 DA VIS-S 进行评估。

低分辨率数据集。 DUTS-TR [31] 用于训练模型。此外,我们还在广泛使用的基准数据集上评估了我们的方法:ECSSD [38] 有 1,000 张图像,DUT-OMRON [39] 有 5,168 张图像,PASCALS [17] 有 850 张图像,DUTS-TE [31] 有 5,019 张图像和 HKU-IS [16] 有 4,447 张图像。

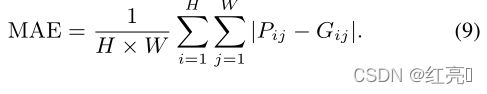

评估指标。我们使用以下指标来评估所有方法的性能。首先,平均绝对误差 (MAE),定义为Eq.(9) 其中 P 是预测图,G 是ground truth。第二个是![]() ,可以通过

,可以通过![]() 计算,其中

计算,其中 ![]() 设置为 0.3,如 [2] 中建议的那样。然后我们采用结构相似性度量 (

设置为 0.3,如 [2] 中建议的那样。然后我们采用结构相似性度量 (![]() ) [7] 和 E-measure(

) [7] 和 E-measure(![]() ) [8] 以及许多其他方法 [23, 32]。最后,为了更好地评估高分辨率显着性检测中重要的边界质量[30, 40],我们采用边界位移误差(BDE)来评估高分辨率数据集的结果,其中较低的值意味着更好的边界质量.

) [8] 以及许多其他方法 [23, 32]。最后,为了更好地评估高分辨率显着性检测中重要的边界质量[30, 40],我们采用边界位移误差(BDE)来评估高分辨率数据集的结果,其中较低的值意味着更好的边界质量.

5.2 实施细节

我们使用 Pytorch [25] 来实现我们的模型,并使用两个 RTX 2080Ti GPU 来加速训练。我们分别选择 Resnet-18 [10] 和 Swin-B 224 [22] 作为卷积分支和变压器分支的主干。通过使用随机梯度下降(SGD)对整个网络进行端到端训练。我们将 Swin 主干的最大学习率设置为 0.003,其他的设置为 0.03。训练过程中学习率先增加后衰减,Momentum和权重衰减分别设置为0.9和0.0005。 Batchsize 设置为 16,最大 epoch 设置为 32。对于数据增强,我们使用随机翻转、裁剪和多尺度输入图像 [27、30、44]。为了进行公平比较并充分展示我们 UHRSD 的属性,我们采用三种可用数据集的组合来训练我们的模型:(1) DUTS-TR (2) DUTS-TR+HRSOD-TR (3) UHRSD-TR+ HRSOD-TR。在测试过程中,每个图像都被调整为 1024 × 1024,然后在没有任何后处理的情况下馈入网络(例如 CRF [15])。

表 1. 在最大 F-measure、MAE、Emeasure、S-measure 和 BDE 方面与最先进的 SOD 模型在五个基准数据集上的定量比较。最好的两个结果分别以红色和绿色显示。 D:在 DUTS-TR 上训练,HD:在 DUTS-TR 和 HRSOD-TR 上训练,UH:在 UHRSD-TR 和 HRSOD-TR 上训练。最好的两个结果是红色和绿色字体。

图 7. 我们的方法和 SOTA 方法之间的视觉比较。前四行来自我们的 UHRSD-TE,接下来的两行来自 HRSOD-TE。放大观看效果最佳。

5.3 与最先进技术的比较

我们将我们提出的 PGNet 与 11 种 SOTA 方法进行比较,包括 CPD [34]、SCRN [35]、DASNet [43]、F3Net [32]、GCPA [4]、ITSD [46]、LDF [33]、CTD [45] , PFS [23], HRSOD [40], DHQSOD [30],其中 HRSOD 和 DHQSOD 专为高分辨率显着目标检测而设计。上述所有方法都使用 Resnet-50 [10] 作为主干,除了 HRSOD 使用 VGG16 [28]。并且所有这些都在 DUTS-TR [31] 数据集上进行了训练,除了 HRSOD-DH 和 DHQSOD-DH 等标记的数据集(HRSOD [40] 和 DUTS-TR)上进行了训练。为了公平比较,我们使用可用的实现或作者提供的显着图。值得注意的是表1中的空行的原因是其中一个目前不可用,另一个与我们的测试环境不一致。

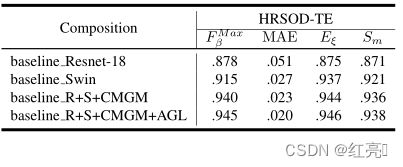

表 2. 不同架构和组成的比较

表3.不同移植特性的性能。![]() 表示在4.2中定义的

表示在4.2中定义的![]() 的第i个特征,与Si相似。

的第i个特征,与Si相似。

定量比较。如上所述,为了公平比较,我们使用了三种训练集设置。可以在选项卡中看到。如表1 所示,仅 DUTS-TR 或 DUTS-TR 和 HRSOD-TR 混合的训练结果在高分辨率和低分辨率测试集上都大大超过了 SOTA。当使用混合数据集 DUTSHRSOD 时,我们的方法在高分辨率数据集上得到了显着改进。高分辨率和低分辨率数据的分布可能存在差异。 UHRSD-HRSOD 混合数据集的训练结果进一步支持了这一点,其中高分辨率数据集的性能显着提高,尤其是对于 UHRSD-TE。这表明高分辨率数据集不同于低分辨率数据集的标注偏差对有监督的高分辨率显着性检测方法具有促进作用,这就是为什么具有高质量标注的高分辨率训练数据需求量很大的原因。

视觉比较。为了展示高分辨率数据集的特点和我们的方法在其上的优越性,图 7 显示了我们与其他人的视觉比较的代表性示例。可以看出,我们的方法可以很好地捕捉细节并产生清晰的边界(第 1 行和第 2 行)。除了高质量边界之外,高分辨率 SOD 的另一个重要方面是能够分割具有小结构的对象,这些小结构在低分辨率情况下很容易被忽略(第 3、5 和 6 行)。这也证明了我们的方法使该过程成为一级的优越性。更重要的是,我们的方法即使在一些极其复杂的场景中也能很好地工作,比如第 4 行。

5.4 消融实验

为了更好地说明所提出的高分辨率图像方法的性质,消融研究基于 Ours-UH 的设置,该设置在混合数据集 UHRSD-TR 和 HRSOD-TR 上进行训练。

组合的消融研究。为了证明所提出的特征嫁接方法(包括 CMGM 和 AGL)的有效性,我们在表2中报告了定量性能。 baseline Resnet-18 和 baseline Swin 分别代表广泛使用的 U 形网络,分别具有 Resnet-18 主干和 Swin 主干。从第 3 行可以看出,我们提出的交错架构和跨模型嫁接模块继承了这两个模型的优势。更重要的是,在AGL的引导下,性能得到了进一步的提升。

移植位置的消融研究。为了研究嫁接位置对网络性能的影响,我们使用不同的嫁接特征对进行了一系列实验。如表中所示。如图 3 所示,从两个编码器的最后一级对齐开始,随着交错层数的增加,性能逐渐提高,直到在![]() 对达到最佳。这可能是由于特征图的空间大小。当尺寸接近时,从两个模型中提取的特征中的空间信息相互对应,从而促进了特征嫁接。

对达到最佳。这可能是由于特征图的空间大小。当尺寸接近时,从两个模型中提取的特征中的空间信息相互对应,从而促进了特征嫁接。

6. 局限

我们的方法对于一阶段高分辨率显着性检测简单快速,但训练过程对 GPU 内存使用要求仍然很高,导致训练成本高。更重要的是,虽然我们的方法与之前的 SOD 方法相比已经有了更高的输入分辨率,但输入分辨率并不是无限的。对于 4K 等过高的分辨率,在输入之前需要先对图像进行下采样。

7. 结论

在本文中,我们提出了用于单阶段高分辨率显着目标检测的金字塔嫁接网络。所提出的交错嫁接模式有效地利用了两个现有不同编码器中的每一个的优点。此外,提出的 Cross-Model Grafting Modules 和 Attention Guided Loss 相互配合,继承了 CNN 和 transformer 的优点并弥补了共同的缺陷。值得注意的是,我们贡献了第一个 4K 分辨率 SOD 数据集,用于推进高分辨率 SOD 的未来研究。大量实验表明,我们的方法不仅优于最先进的方法,而且能够快速准确地产生高分辨率的显着性预测。