【大数据】Hadoop 生态系统及其组件

Hadoop 生态系统及其组件

- 1.Hadoop 生态系统的组成

- 2.Hadoop 生态系统简介

-

- 2.1 HDFS

- 2.2 MapReduce

- 2.3 YARN

- 2.4 Hive

- 2.5 Pig

- 2.6 HBase

- 2.7 HCatalog

- 2.8 Avro

- 2.9 Thrift

- 2.10 Drill

- 2.11 Mahout

- 2.12 Sqoop

- 2.13 Flume

- 2.14 Ambari

- 2.15 Zookeeper

- 2.16 Oozie

1.Hadoop 生态系统的组成

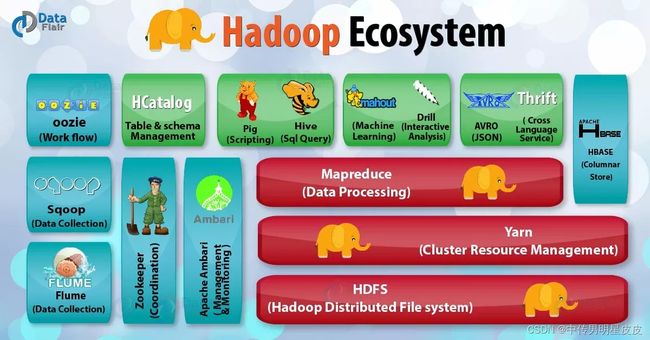

本篇文章将向大家介绍 Hadoop 生态系统的不同组件。也正是因为这些组件,使得 Hadoop 如此强大。通过学习 HDFS 和 HDFS组件、MapReduce、YARN、Hive、Pig、HBase 和 HBase组件、HCatalog、Avro、Thrift、Drill、Mahout、Sqoop、Flume、Ambari、Zookeeper 和 OOzie 等 Hadoop 生态系统组件,深入了解 Hadoop 生态系统。

2.Hadoop 生态系统简介

2.1 HDFS

HDFS 是一个基于 Java 的 Hadoop 分布式文件系统(Hadoop Distributed File System),是 Hadoop 生态系统中最重要的组成部分。HDFS 是 Hadoop 的主要存储系统,为大数据提供可扩展的、高容错的、可靠的和具有成本效益的数据存储。

HDFS 被设计用来部署在低廉的硬件上,在许多安装中已经被设为默认配置。它提供高吞吐量来访问应用程序的数据,适合那些有着超大数据集的应用程序。Hadoop 通过类似 Shell 的命令与 HDFS 直接交互。

HDFS 有两个主要组件:NameNode 和 DataNode。

NameNode 也被称为主节点,但它并不存储实际的数据或数据集。NameNode 存储的是元数据,即文件的权限、某一上传文件包含哪些 Block 块、Bolck 块保存在哪些 DataNode 上等细节信息。它由文件和目录组成。

NameNode 的任务:

- 管理文件系统的命名空间;

- 控制客户端对文件的访问;

- 操作文件命名空间的文件或目录操作,如打开,关闭,重命名等。

(2)DataNode

DataNode 负责将实际数据存储在 HDFS 中,并负责来自文件系统客户的读写请求。在启动时,每个 Datanode 连接到其相应的 Namenode 并进行握手。命名空间 ID 和 DataNode 的软件版本的验证是通过握手进行的。当发现不匹配时,DataNode 会自动关闭。

DataNode 的任务

- DataNode 管理存储的数据。

- DataNode 同时还要执行块的创建、删除,以及来自 NameNode 的块复制指令。

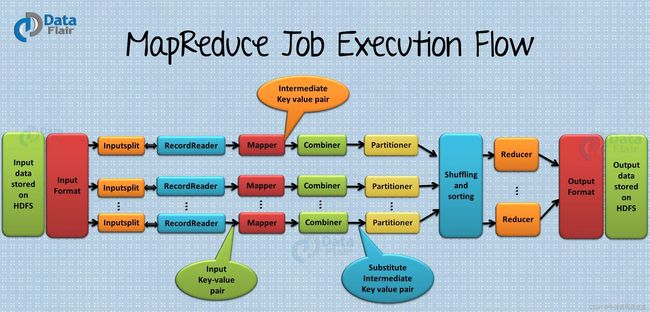

2.2 MapReduce

MapReduce 是 Hadoop 生态系统的核心组件,提供数据处理。MapReduce 是一个软件框架,用于轻松编写应用程序,处理存储在 Hadoop 分布式文件系统中的大量结构化和非结构化数据。

MapReduce 程序具有并行性质,因此对于使用集群的多台机器进行大规模数据分析非常有用,提高了计算速度和可靠性。

MapReduce 的每个阶段都有键值对作为输入和输出。Map 函数获取一组数据并将其转换为另一组数据,其中各个元素被分解为元组(键/值对)。函数将 Map 的输出作为输入,并根据键来组合这些数据元组,相应地修改键的值。

MapReduce的特点

- 简单性:MapReduce 作业很容易运行。应用程序可以用任何语言编写,如 Java、C++ 和 Python。

- 可扩展性:MapReduce 可以处理 PB 级的数据。

- 速度:通过并行处理,需要几天才能解决的问题,通过 MapReduce 在几小时和几分钟内就能解决。

- 容错性:MapReduce 会照顾到故障。如果一份数据不可用,另一台机器有一份相同密钥对的副本,可以用来解决相同的子任务。

2.3 YARN

YARN(Yet Another Resource Negotiator)作为一个 Hadoop 生态系统的组件,它提供了资源管理。YARN 也是 Hadoop 生态系统中最重要的组件之一。YARN 被称为 Hadoop 的操作系统,因为它负责管理和监控工作负载。它允许多个数据处理引擎(如实时流和批处理)来处理存储在一个平台上的数据。

- 灵活性:除了 MapReduce(批处理),还能实现其他专门的数据处理模式,如交互式和流式。由于 YARN 的这一特点,其他应用程序也可以在 Hadoop2 中与 MapReduce 程序一起运行。

- 效率:由于许多应用程序在同一个集群上运行,因此,Hadoop 的效率提高了,而对服务质量没有太大影响。

- 共享:提供一个稳定、可靠、安全的基础,并在多个工作负载中共享操作服务。

2.4 Hive

Hive 是一个开源的数据仓库系统,用于查询和分析存储在 Hadoop 文件中的大型数据集。Hive 主要做三个功能:数据汇总、查询和分析。

Hive 使用的语言称为 HiveQL(HQL),与 SQL 类似。HiveQL 自动将类似 SQL 的查询翻译成 MapReduce 作业,并在Hadoop上执行。

- Metastore:元数据存储。

- 驱动:管理 HiveQL 语句的生命周期。

- 查询编译器:将 HiveQL 编译成有向无环图(DAG)。

- Hive 服务器:提供一个 Thrift 接口和 JDBC / ODBC 服务器。

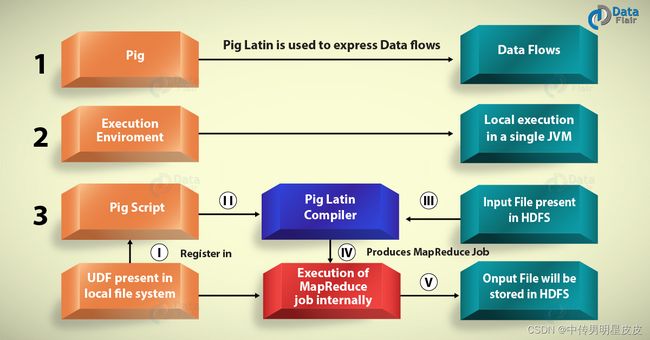

2.5 Pig

Pig 是一个高级语言平台,用于分析和查询存储在 HDFS 中的巨大数据集。Pig 作为 Hadoop 生态系统的一个组成部分,使用 PigLatin 语言,它与 SQL 非常相似。它的任务包括加载数据,应用所需的过滤器并以所需的格式转储数据。对于程序的执行,Pig 需要 Java 运行环境。

- 可扩展性:为了进行特殊的处理,用户可以创建自己的功能。

- 优化机会:Pig 允许系统自动执行优化,这使得用户可以关注语义而不是效率。

- 处理所有种类的数据:Pig 既能分析结构化的数据,也能分析非结构化的数据。

2.6 HBase

HBase 是 Hadoop 生态系统的一个组成部分,它是一个分布式数据库,被设计用来在可能有数十亿行和数百万列的表中存储结构化数据。HBase 是一个建立在 HDFS 之上,可扩展的、分布式的 NoSQL 数据库。HBase 提供实时访问 HDFS 中的数据的读取或写入。

HBase 有两个组件,即 HBase Master 和 RegionServer。

(1)HBase Master

- 它不是实际数据存储的一部分,但在所有 RegionServer 之间协商负载平衡。

- 维护和监控 Hadoop 集群。

- 执行管理(创建、更新和删除表的界面)。

- 控制故障转移。

- 处理DDL操作。

(2)RegionServer

- 处理来自客户端的读、写、更新、删除请求。

- RegionServer 进程在 Hadoop 集群的每个节点上运行。RegionServer 运行在 HDFS 的 DateNode 上。

2.7 HCatalog

HCatalog 是 Hadoop 的一个表和存储管理层。HCatalog 支持 Hadoop 生态系统中的不同组件,如MapReduce、Hive 和 Pig,以方便从集群中读写数据。HCatalog 是 Hive 的一个关键组件,使用户能够以任何格式和结构存储他们的数据。默认情况下,HCatalog 支持 RCFile、CSV、JSON、sequenceFile 和 ORC 文件格式。

2.8 Avro

Acro 是 Hadoop 生态系统的一部分,是一个最流行的数据序列化系统,为 Hadoop 提供 数据序列化和数据交换服务。这些服务可以一起使用,也可以独立使用。大数据可以使用 Avro 交换用不同语言编写的程序。

使用序列化服务,程序可以将数据序列化为文件或消息。它将数据定义和数据一起存储在一个消息或文件中,使得程序可以很容易地动态理解存储在 Avro 文件或消息中的信息。

- Avro 模式:它依靠模式进行序列化 / 反序列化。Avro 需要模式来进行数据的写入 / 读取。当 Avro 数据存储在一个文件中时,它的模式也随之存储。因此,文件可以在以后被任何程序处理。

- 动态类型化:它指的是在不生成代码的情况下进行序列化和反序列化。它是对代码生成的补充,在 Avro 中,静态类型的语言可以作为一种可选的优化。

2.9 Thrift

Thrift 是一个用于可扩展的跨语言服务开发的软件框架,同时是一种用于 RPC(远程程序调用)通信的接口定义语言。Hadoop 做了大量的 RPC 调用,因此有可能出于性能或其他原因使用 Thrift。

2.10 Drill

Hadoop 生态系统组件的主要目的是大规模数据处理,包括结构化和半结构化数据。Drill 是一个低延迟的 分布式查询引擎,旨在扩展到几千个节点并查询 PB 级的数据。Drill 是第一个具有无模式模型的分布式 SQL 查询引擎。

Drill 有专门的内存管理系统,可以消除垃圾回收,优化内存分配和使用。Drill 与 Hive 发挥得很好,允许开发者重用他们现有的 Hive 部署。

- 可扩展性:Drill 在各层提供可扩展的架构,包括查询层、查询优化和客户端 API。我们可以根据企业的具体需求来扩展任何一层。

- 灵活性:Drill 提供了一个分层的列式数据模型,可以表示复杂的、高度动态的数据,并允许高效的处理。

- 动态模式发现:Drill 不要求数据的模式或类型规范,以便开始查询执行过程。相反,Drill 以称为记录批次的单位开始处理数据,并在处理过程中即时发现模式。

- Drill 分散的元数据:与其他 SQL Hadoop 技术不同,Drill 没有集中的元数据要求。Drill 用户不需要为了查询数据而在元数据中创建和管理表。

2.11 Mahout

Mahout 是用于创建可扩展的机器学习算法和数据挖掘库的开源框架。一旦数据被存储在 HDFS 中,Mahout 提供了数据科学工具来自动寻找这些大数据集中有意义的模式。

Mahout的算法包括

- 聚类

- 协同过滤

- 分类

- 频繁模式挖掘

2.12 Sqoop

Sqoop 将数据从外部来源导入相关的 Hadoop 生态系统组件,如 HDFS、Hbase 或 Hive。它还可以将数据从 Hadoop 导出到其他外部来源。Sqoop 与关系型数据库一起工作,如 Teradata、Netezza、Oracle、MySQL。

- 从大型机导入顺序数据集:Sqoop 满足了将数据从大型机转移到 HDFS 的日益增长的需求。

- 直接导入 ORC 文件:改善压缩和轻量级索引,提高查询性能。

- 平行数据传输:实现更快的性能和最佳的系统利用率。

- 高效的数据分析:通过将结构化数据和非结构化数据结合在读取数据湖的模式上,提高数据分析的效率。

- 快速的数据拷贝:从外部系统到 Hadoop。

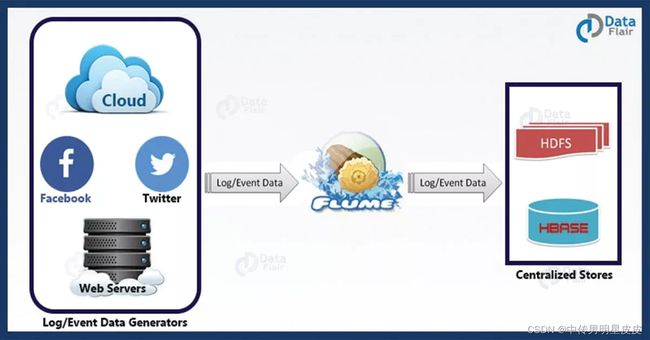

2.13 Flume

Flume 有效地收集、汇总和移动大量的数据,并将其从原点送回 HDFS。它是容错和可靠的机制。Flume 允许数据从源头流入 Hadoop 环境。它使用一个简单的可扩展的数据模型,允许在线分析应用。使用 Flume,我们可以从多个服务器立即获得数据到 Hadoop。

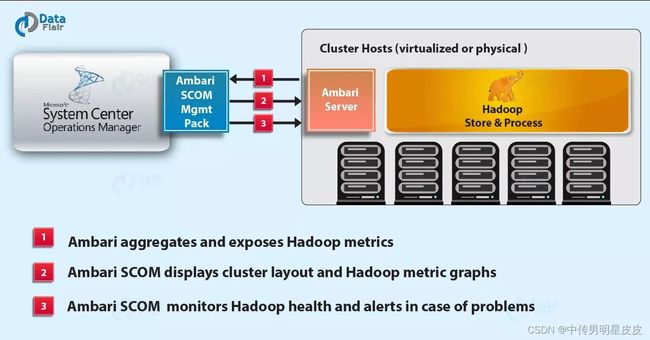

2.14 Ambari

Ambari 是一个用于配置、管理、监控和保护 Apache Hadoop 集群的管理平台。由于 Ambari 提供了一致的、安全的操作控制平台,Hadoop 管理变得更加简单。

Ambari的特点

- 简化安装、配置和管理:Ambari 轻松有效地创建和管理大规模的集群。

- 集中的安全设置:Ambari 减少了在整个平台上管理和配置集群安全的复杂性。

- 高度的可扩展性和可定制性:Ambari 具有高度的可扩展性,可将定制服务纳入管理。

- 对集群健康的全面可视性:Ambari 通过整体的监控方法,确保集群的健康和可用。

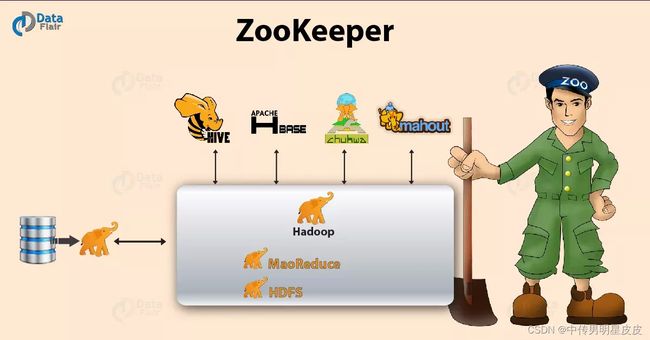

2.15 Zookeeper

Zookeeper 用于维护配置信息、命名、提供分布式同步和提供组服务。Zookeeper 管理和协调一个大型的机器集群。

Zookeeper 的特点:

- 快速:Zookeeper 在对数据的读取比写入更常见的工作负载中是快速的。理想的读 / 写比率是 10 : 1 10:1 10:1。

- 有序:Zookeeper 维护所有事务的记录。

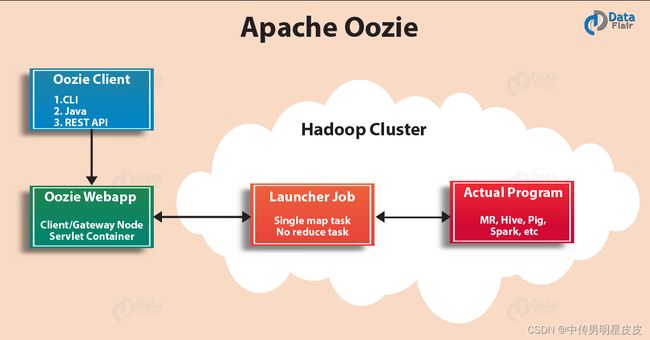

2.16 Oozie

Oozie 是一个工作流调度系统,用于管理 Apache Hadoop 作业。Oozie 将多个作业按顺序组合成一个逻辑的工作单元。Oozie 框架与 Apache Hadoop 栈完全集成,以 YARN 为架构中心,支持 Apache MapReduce、Pig、Hive 和 Sqoop 的 Hadoop 作业。

在 Oozie 中,用户可以创建工作流的有向无环图,它可以在 Hadoop 中并行和顺序运行。Oozie 是可扩展的,可以管理 Hadoop 集群中成千上万的工作流的及时执行。Oozie 也是非常灵活的。人们可以轻松地启动、停止、暂停和重新运行工作。它甚至可以跳过一个特定的故障节点,或在 Oozie 中重新运行它。

Oozie 作业有两种基本类型

- Oozie 工作流:它用于存储和运行由 Hadoop 作业组成的工作流,例如 MapReduce、pig、Hive。

- Oozie 协调员:它根据预定的时间表和数据的可用性来运行工作流作业。

参考:https://data-flair.training/blogs/hadoop-ecosystem-components/