(2023,GPT-4V,LLM,LMM,功能和应用)大型多模态模型的黎明:GPT-4V(ision) 的初步探索

The Dawn of LMMs: Preliminary Explorations with GPT-4V(ision)

公众号:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料)

目录

0. 摘要

1. 简介

1.1 动机和概述

1.2 我们探索 GPT-4V 的方法

1.3 如何阅读本报告?

2. GPT-4V 的输入模式

2.1 纯文本输入

2.2 单个图文对

2.3 交错的图像文本输入

3. GPT-4V 的工作模式及提示技术

3.1 遵循文本说明

3.2 视觉指针和视觉参考提示(visual referring prompting)

3.3 视觉+文字提示

3.4 上下文小样本学习(In-context Few-shot Learning)

4. 视觉语言能力

4.1 不同领域的图像描述

4.2 目标定位、计数和密集标题

4.3 多模态知识和常识

4.4 场景文本、表格、图表和文档推理

4.5 多语言多模态理解

4.6 视觉编码能力

5. 与人类的交互:视觉参考提示

5.1 理解输入指针

5.2 视觉参考提示

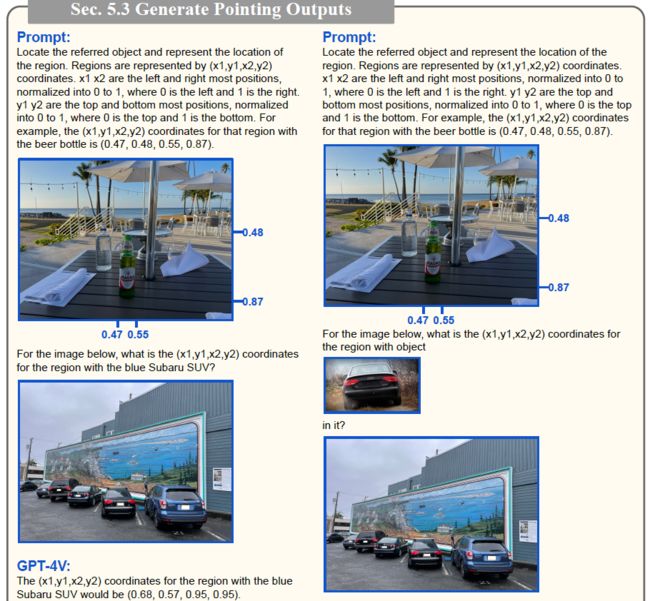

5.3 生成指针

6. 时间和视频理解

6.1 多图排序

6.2 视频理解

6.3 用于基本时间理解的视觉参考提示

7. 抽象视觉推理与智商测试

7.1 抽象视觉刺激

7.2 零件和对象的发现和关联

7.3 韦克斯勒成人智力量表

7.4 Raven的渐进矩阵

8. 情商测试

8.1 从面部表情读出情绪

8.2 理解视觉内容如何激发情感

8.3 情绪条件输出

9. 新兴应用亮点

9.1 找不同

9.2 工业

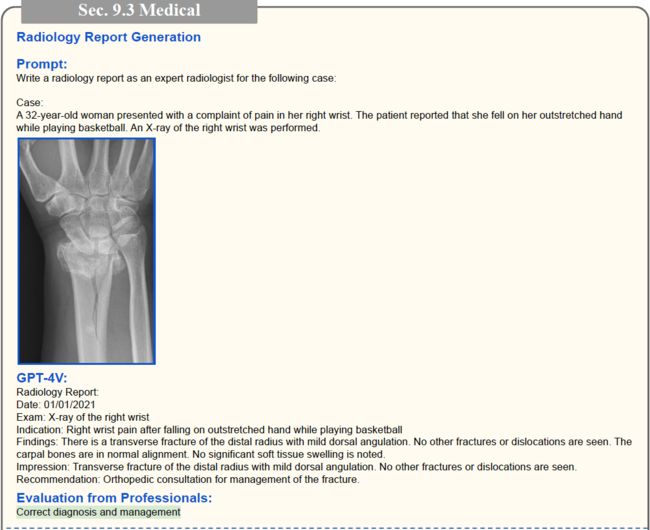

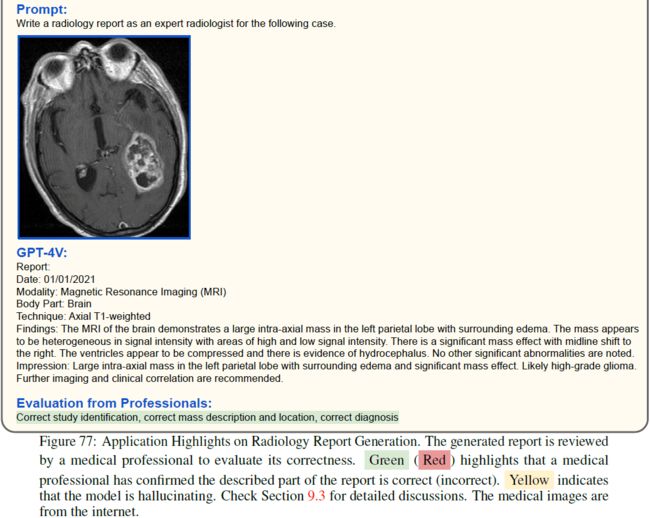

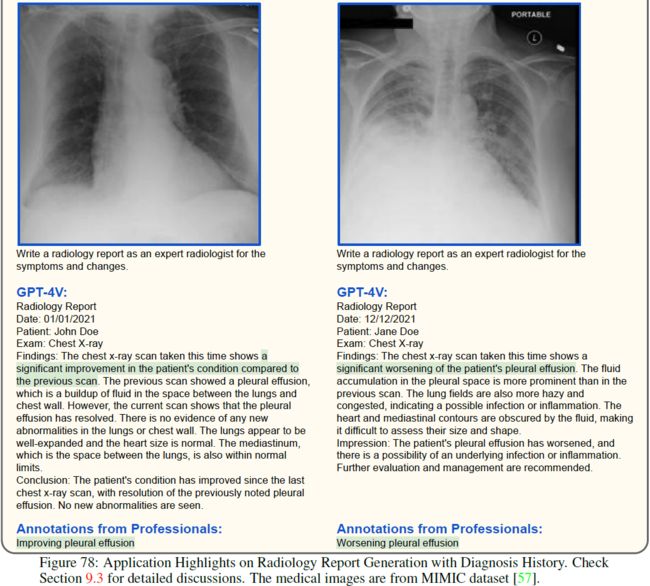

9.3 医疗

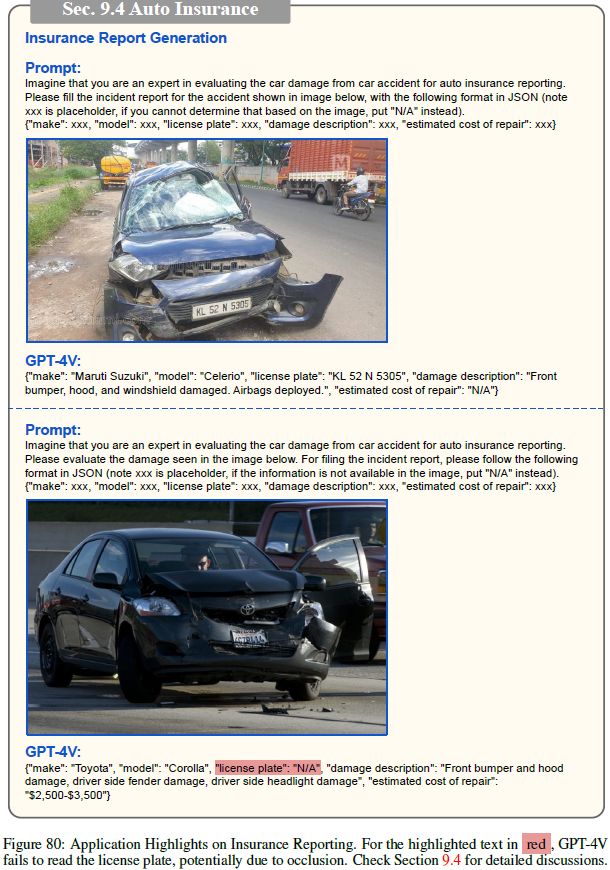

9.4 汽车保险

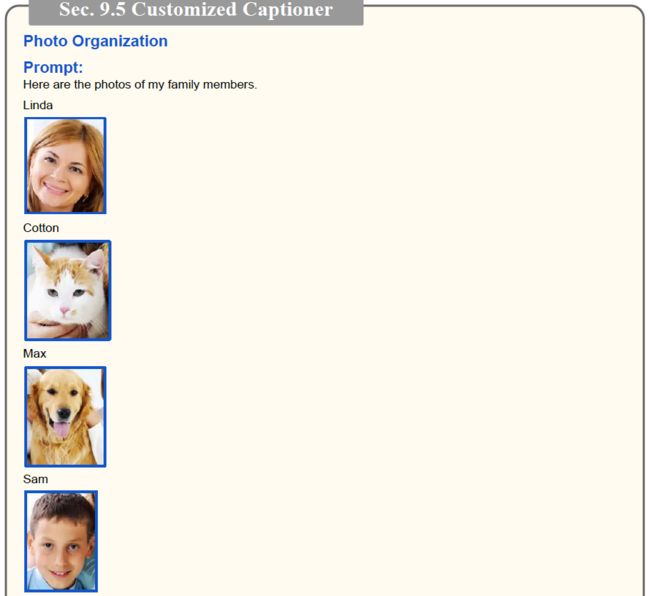

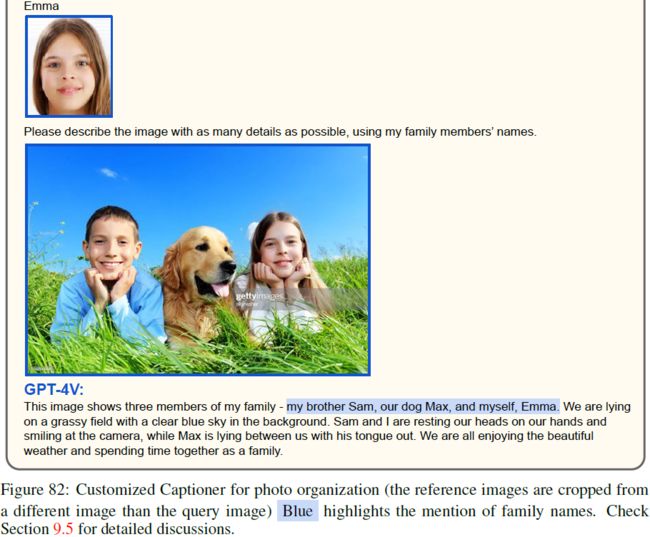

9.5 定制标题

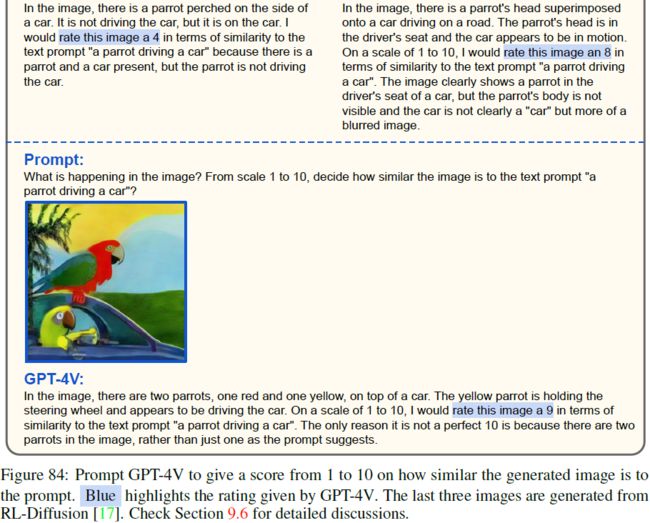

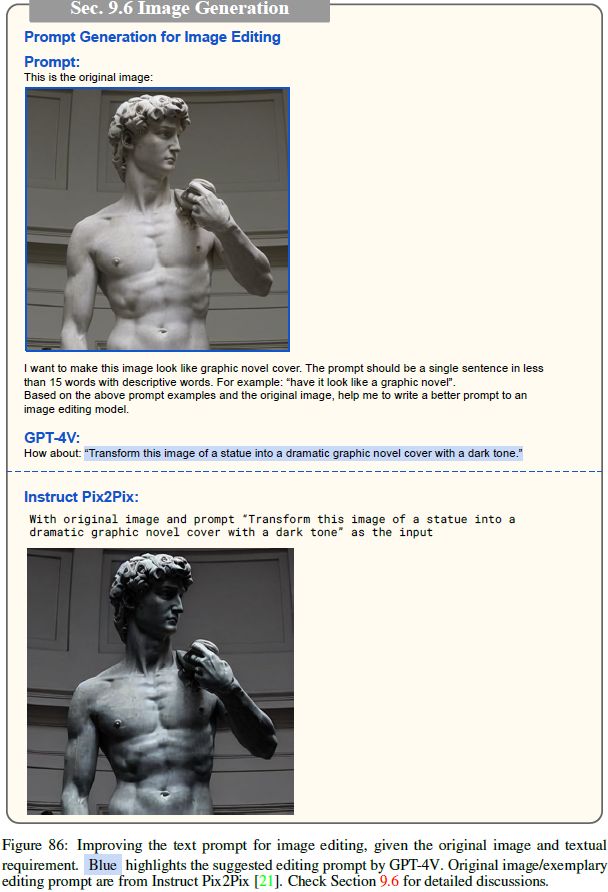

9.6 图像生成

9.7 具象代理(Embodied Agent)

9.8 GUI导航 (图太多了 92-119,请参考原论文)

10. LMM 强大的代理

10.1 多模态插件

10.2 多模态链

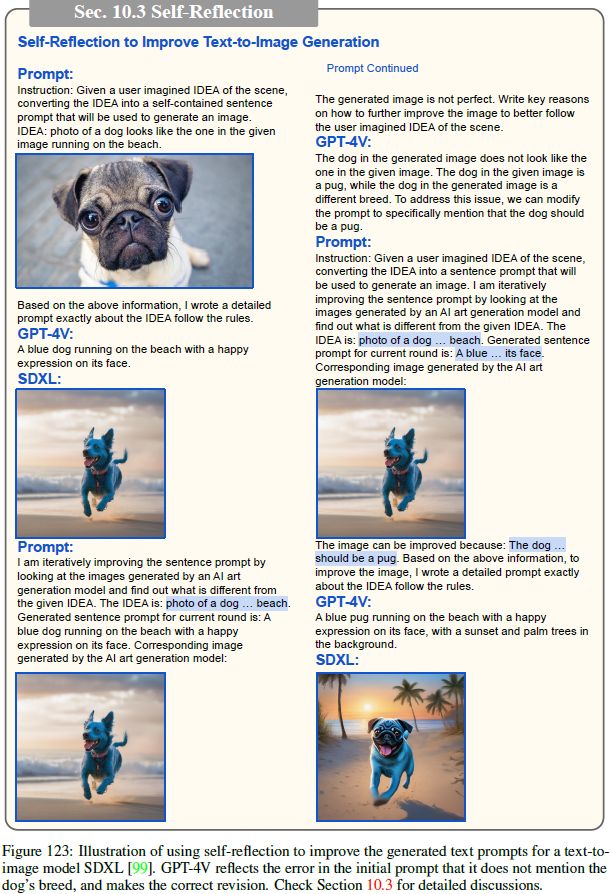

10.3 反思(Self-Reflection)

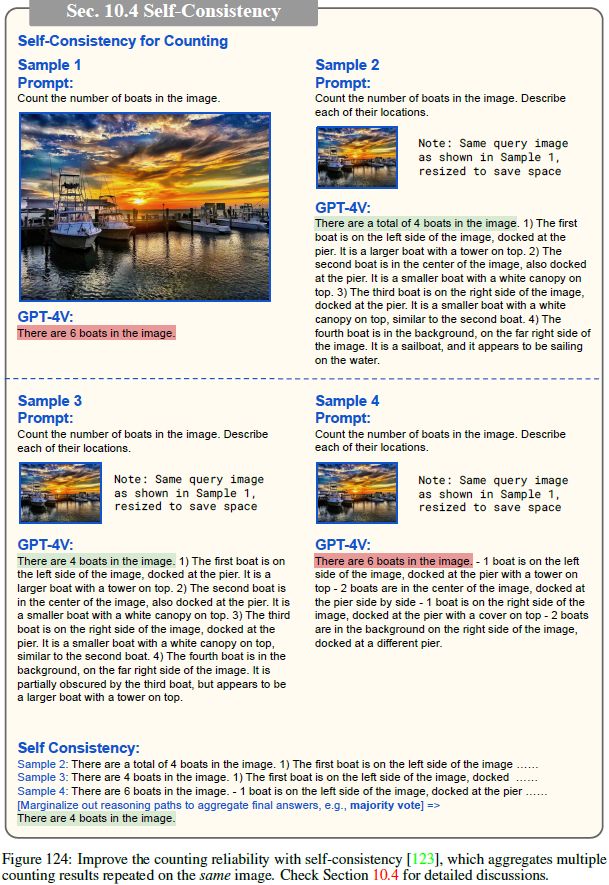

10.4 自洽性

10.5 检索增强的 LMM

11. 结论

11.1 总结和结论

11.2 迈向未来的 LMM

S. 总结

S.1 主要贡献

S.2 基于四个问题展开探索

0. 摘要

大型多模态模型 (Large multimodal models,LMM) 通过视觉理解等多感官技能扩展大型语言模型 (large language models,LLM),以实现更强大的通用智能。 在本文中,我们分析最新模型 GPT-4V(ision)(本报告探讨了具有视觉功能的 GPT-4V(ision),并将该模型称为 “GPT-4V”,遵循 OpenAI 报告 [95, 94]。 我们将该模型的纯文本版本称为 “GPT-4(no vision)” [94]),以加深对 LMM 的理解。 分析重点关注 GPT-4V 可以执行的有趣任务,包括测试样本来探究 GPT-4V 功能的质量和通用性、其支持的输入和工作模式,以及提示模型的有效方法。 在探索 GPT-4V 的方法中,我们策划和组织了一系列精心设计的定性样本,涵盖各个领域和任务。 对这些样本的观察表明,GPT-4V 在处理任意交错的多模态输入方面具有前所未有的能力,并且其功能的通用性共同使 GPT-4V 成为强大的多模态通用系统。 此外,GPT-4V 独特的理解输入图像上绘制的视觉标记的能力可以催生新的人机交互方法,例如视觉参考提示(visual referring prompting)。 我们在报告最后深入讨论了基于 GPT-4V 的系统的新兴应用场景和未来研究方向。 我们希望这一初步探索能够激发未来对下一代多模态任务制定的研究,开发和增强 LMM 解决现实问题的新方法,并更好地理解多模态基础模型。

1. 简介

1.1 动机和概述

大型语言模型 (LLM) [22,94,27,10,116,50] 的突破在各个领域和任务中表现出了卓越的多功能性和能力。

- 该领域的下一个发展是大型多模态模型 (LMM),旨在通过集成多感官技能(multi-sensory skills)来扩展 LLM 的功能,以实现更强大的通用智能。

- 鉴于视觉在人类感官中的主导地位 [30, 55],许多 LMM 研究都是从扩展视觉能力开始的。 初步研究调查要么微调视觉编码器以与冻结的预训练 LLM [118,6,67,52,39,12,45,150,75,32,139] 保持一致,要么使用视觉语言模型把视觉输入转换为 LLM 可以理解的文本描述 [142,134,124,51,106,135]。

- 然而,大多数现有模型 [12,45,150,75,32,65] 的模型和数据规模有限,可能限制了各种有趣能力的出现。 因此,目前尚不清楚基于最先进的(state-of-the-art,SOTA) LLM (例如 GPT-4(no vision)[94] 和 PaLM [27, 10])开发的 LMM 的现状和新兴多模态能力如何。

- 在本文中,我们报告了我们对 GPT-4V(早期版本)的初步探索,GPT-4V 是一种最先进的视觉 LMM,基于 SOTA LLM 构建,并使用大规模多模态数据进行训练。

我们对 GPT-4V 的探索以以下问题为指导:

1) GPT-4V支持哪些输入和工作模式?

- 多模态模型的通用性不可避免地要求系统能够处理不同输入模态的任意组合。

- GPT-4V 在理解和处理输入图像、子图像、文本、场景文本和视觉指针的任意组合方面表现出前所未有的能力。

- 我们还证明,GPT-4V 很好地支持了 LLM 中观察到的测试时技术,包括指令遵循 [96]、思想链(chain-of-thoughts) [129, 63]、上下文中的小样本学习 [22] 等。

2) GPT-4V 在不同领域和任务上的功能质量和通用性如何?

- 我们对涵盖广泛领域和任务的查询(query)进行采样,以了解 GPT-4V 的功能,包括开放世界视觉理解、视觉描述、多模态知识、常识、场景文本理解、文档推理、编码、时间推理、抽象推理、情感理解 , 还有很多。

- GPT-4V 在许多实验领域表现出了令人印象深刻的人类水平的能力。

3) 有效使用和提示 GPT-4V 的方法有哪些?

- GPT-4V 擅长理解像素空间编辑,例如在输入图像上绘制的视觉指针和场景文本。

- 受这种功能的启发,我们讨论了“视觉参考提示 (visual referring prompting)”,它直接编辑输入图像来指示感兴趣的任务。

- 视觉参考提示可以与其他图像和文本提示无缝地一起使用,为说明和示例演示提供细致入微的界面。

4) 未来有哪些有前景的方向?

- 鉴于 GPT-4V 跨领域和任务的强大能力,我们询问多模态学习以及更广泛的人工智能的下一步是什么。

- 我们将我们的思考和探索分为两个角度,即需要关注的新兴新颖应用场景和基于 GPT-4V 的系统的未来研究方向。

- 我们提出我们的初步探索以启发未来的研究。

以上述问题为指导,我们全面整理并列出了我们探索的定性结果。

- 该报告包含最少的定量基准结果,而是主要包含精选的有趣的定性示例。

- 尽管不那么严格,但这种设计允许在固定容量下提供涵盖广泛领域、任务、工作模式和提示技术的更全面的分析。

- 我们相信,这些有组织的探索将激发未来在新兴新颖应用、下一代多模式任务制定以及开发基于 LMM 的先进智能系统方面的工作。

1.2 我们探索 GPT-4V 的方法

本报告的目标。

- 评估系统的标准方法是将其与一系列精心设计的数据集进行基准测试,每个数据集代表一个特定的领域和任务。

- 挑战之一是一些现有的基准可能不再适合评估 LMM。 例如,LMM 的图像标题输出比图像标题基准数据集 [24] 中的基本事实要丰富得多,并且包含更详细的描述。

- 还缺乏有关 GPT-4V 大规模预训练的公开信息,这可能违反某些现有数据集的训练测试设置并使这些基准数据无效。 因此,将评估限制在现有的基准和指标上可能会无意中缩小 GPT-4V 的评估范围。

- 制定下一代评估任务和基准的综合列表将是理想的最终解决方案。 然而,由于需要付出巨大的努力,我们将这些留作未来的工作。

本文重点关注使用定性结果来代替定量基准测试,以了解 GPT-4V 的新功能和潜在的新兴用例。

- 我们的目标是发现并预览 GPT-4V 可能已经具备的功能,尽管这些新颖的功能可能尚不完全可靠。

- 我们希望这一系列的探索能够激发未来的研究,为下一代多模式任务建立定量基准,使现有基准现代化,进一步提高模型性能和系统可靠性,并在新兴用例中激发创新。

- 接下来,我们将深入研究探索 GPT-4V 方法的核心设计。

样本选择指导。

- 本报告重点介绍定性结果以展示 GPT-4V 的潜在能力,而不是提供全面的定量基准结果。 这自然引发了所展示示例的可靠性问题。

- 本报告中的示例可能需要仔细调整指令以增强 GPT-4V 的相应功能。

- 应该注意的是,一些复杂的情况可能仅适用于专门设计的提示。 因此,所展示的功能可能无法在不同的样本中始终有效。

- 本报告的主要目的不是仅展示可靠的功能,而是为读者提供我们发现的 GPT-4V 潜在功能的列表,否则这些功能可能会在几次不成功的试验后被忽视。

样本选择以防止训练中仅仅记忆。

- 定性报告 [23] 中的一个基本设计考虑因素是仅通过记忆训练样本的响应或根据指令和上下文示例的提示进行有根据的猜测来辨别模型的真实能力。

- 我们仔细控制输入提示中的图像和文本,以防止它们在 GPT-4V 训练期间被看到。

- 我们从头开始生成原始文本 query,并尝试使用无法在线访问或时间戳超过 2023 年 4 月的图像。

- 我们将指出特定样本不符合此标准的情况,例如故意使用来自特定视觉的样本 - 语言数据集。

- 除了确保样本不可见之外,我们还将理由查询(rationale query)纳入流程中。 这些 query 旨在探测模型的推理过程,从而验证 GPT-4V 是否拥有预测功能。

默认工作模式。

- 正如后面第 3 节详细介绍的,GPT-4V 在不同的工作模式下都能有效工作,包括带指令的零样本学习、上下文中的少样本学习等。

- 其中,本报告不是关注上下文中的小样本学习,而是关注零样本指令调优。这种设计是为了防止上下文示例中潜在的信息泄漏。

- 虽然上下文中的少数示例可以提高性能和可靠性,但它们并不能始终如一地产生新功能。

- 因此,我们将零样本指定为演示的默认工作模式,并减少上下文示例的使用,以尽量减少示例对评估能力的影响。

1.3 如何阅读本报告?

本报告记录了计算机视觉和视觉语言多模态领域的研究人员对 GPT-4V 的探索。

- 它主要面向相关学科的研究人员,他们希望获得对 LMM 功能的定性印象并了解其与传统视觉语言模型的区别。

- 该报告还为那些人工智能或计算机科学可能超出其专业范围的专业人士编写,以帮助他们概念化 LMM 可以在其不同专业领域内提高其熟练程度的方法。

我们围绕指导我们探索的四个核心问题概述了该报告。

除了概述和目录之外,我们还提供了图表列表。 该列表列举了报告中详细介绍的定性示例,作为帮助读者导航到他们感兴趣的场景的附加工具。

![]()

2. GPT-4V 的输入模式

本节总结了 GPT-4V 支持的输入,即,作为具有纯文本输入的单模态语言模型,可选地仅使用单个图像来获取单个图像-文本对,以及可选地仅使用多个图像输入来获取交错的图像-文本对。 接下来我们重点介绍这些不同输入模式下的代表性用例。

2.1 纯文本输入

GPT-4V 强大的语言能力使其能够作为具有纯文本输入的有效单模态语言模型 [35,101,22]。 GPT-4V 仅使用文本进行输入和输出操作,能够执行各种语言和编码任务。 我们建议读者参考 GPT-4 技术报告 [94],全面深入地分析 GPT-4V 的语言和编码能力,以及与GPT-4(无视觉)的比较。

2.2 单个图文对

GPT-4V 是最新的大型多模态模型,以图像和文本作为输入来生成文本输出。

- GPT-4V 与现有的通用视觉语言模型 [8, 77, 69, 7, 66, 115, 113, 148, 25, 78, 42, 70, 54, 61, 68, 125, 26, 133, 38, 6, 121, 43, 37, 151, 65] 符合,可以将单个图像文本对或单个图像作为输入来执行各种视觉和视觉语言任务,例如图像识别 [34]、对象定位 [146]、图像标题[24]、视觉问答 [11]、视觉对话 [33]、密集标题 [59] 等等。

- 我们注意到,图像-文本对中的文本可以用作用于标题的诸如 “描述图像” 之类的指令,也可以用作查询输入(如视觉问答中的问题)。

- 与现有技术相比,GPT-4V 的卓越智能体现在其显着增强的性能和通用性。 第 4 节详细介绍了其在各个领域的多模式能力的综合分析。

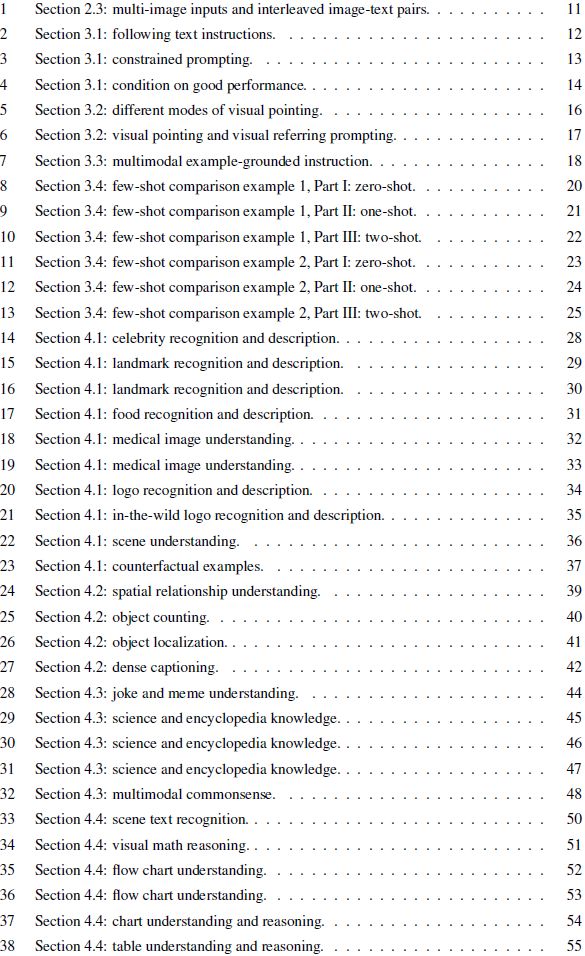

2.3 交错的图像文本输入

GPT-4V 处理灵活交错的图像文本输入的能力进一步增强了其通用性。

- 交错的图像文本输入可以以视觉为中心,例如带有简短问题或说明的多个图像,也可以以文本为中心,例如带有两个插入图像的长网页,或者图像和文本的平衡混合。

- 这种混合输入模式为各种应用提供了灵活性。 例如,它可以计算多个收据图像所缴纳的总税款,如图 1 所示。它还可以处理多个输入图像并提取查询信息。 GPT-4V 还可以有效地关联交错图像文本输入中的信息,例如查找菜单上的啤酒价格、计算啤酒数量以及返回总成本,如图 1 所示。

- 除了直接应用程序之外,还可以处理交错图像 -文本输入作为上下文小样本学习和其他高级测试时提示技术的基本组成部分,从而进一步提高了 GPT-4V 的通用性。

- 我们将在下一节(第 3 节)中展示这些有趣的新颖用法。

3. GPT-4V 的工作模式及提示技术

3.1 遵循文本说明

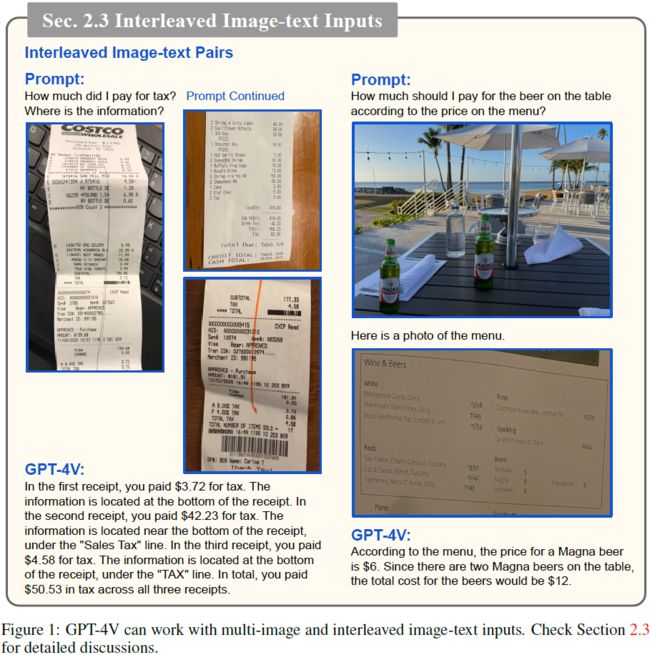

GPT-4V 的一项独特优势是其通用性,部分是通过其理解和遵循文本指令的强大能力来实现的[96,91,127,104]。

- 指令提供了一种自然的方式来定义和定制任意视觉语言用例所需的输出文本。图 2 显示了对句子长度和要使用的单词进行限制的图像描述示例。

- 或者,在输入方面,GPT-4V 可以理解执行具有挑战性任务的详细指令,例如通过提供中间步骤的指令,使 GPT-4V 能够更好地解释抽象推理问题。

- 从指令中学习新任务的能力在适应各种未见过的应用和任务方面显示出巨大的潜力,如第 9 节所述。

- 与最近的研究 [6,12,45,150,75,32] 一样,本小节中讨论的指令大多采用文本格式,提供感兴趣任务的语言描述。

- 我们将在第 3.3 节稍后讨论 GPT-4V 遵循多模式基于示例的指令的独特功能。

此外,我们展示了文本指令如何在塑造 GPT-4V 的响应中发挥重要作用,采用了 LLM 文献 [2, 149] 中采用的两种技术,(i)“约束提示”,以便 GPT-4V 以某种格式响应; (ii) “以良好性能为条件”,明确要求 GPT-4V 具有良好的性能。

约束提示。

- 在图3中,我们提示GPT-4V读取图像中的文本并以特定的 JSON 格式返回信息。

- 尽管 GPT-4V 在从驾驶执照中提取相应信息时出现了一些错误,但响应仅限于文本指令中指定的 JSON 格式。

- 我们在第 9 节中将这种技术用于某些应用场景。

以性能良好为条件。

- 关于 LLM 的一项观察是,LLM 不想成功 [9]。 相反,他们想要模仿具有一系列性能品质的训练集。

- 如果用户希望成功完成分配给模型的任务,则用户应该明确提出要求,这已被证明对提高 LLM 的性能很有用 [149]。 在 LMM 的背景下,我们也有类似的观察结果。

- 在图 4 中,我们比较了模型对不同计数文本指令的响应。 我们从一个简单明了的提示开始:“数一下图像中苹果的数量。” 然而,GPT-4V 错误地计算出图像中总共有 12 个苹果。

- 为了提高其性能,我们通过添加短语 “让我们逐步思考” 来探索 [63] 中用于 LLM 的零样本思想链的使用 。 尽管 GPT-4V 的预测步数总体上是正确的,但对最终计数没有多大帮助,因为它仍然得出“12 个苹果”的错误答案。

- 接下来,我们将指令修改为 “让我们逐行数苹果”,这与视觉输入更相关。 虽然 GPT-4V 提供了正确的总计数,但它在计算第二/第三行时会出错。

- 当我们进一步将指令扩展为 “先数一共有多少行苹果,然后数每行的苹果,最后相加得到总数” 时,最终答案与正确答案的偏差就更大了(15 对比 11)。

- 最后,模仿在 [149] 中用于 LLM 的 “让我们一步一步地解决这个问题,以确保我们得到正确的答案。” ,我们设计了如下提示:“你是计算图像中事物的专家。 让我们逐行数一下下图中苹果的数量,以确保我们得到正确的答案。” 我们提示中的第一句话要求 GPT-4V 承担计数专家的角色,第二句话明确指示 GPT-4V 成功。 通过这种设计,GPT-4V 成功返回每行的正确答案以及总计数。

- 在整篇论文中,我们在各种场景中都采用了这种技术,以获得更好的性能。

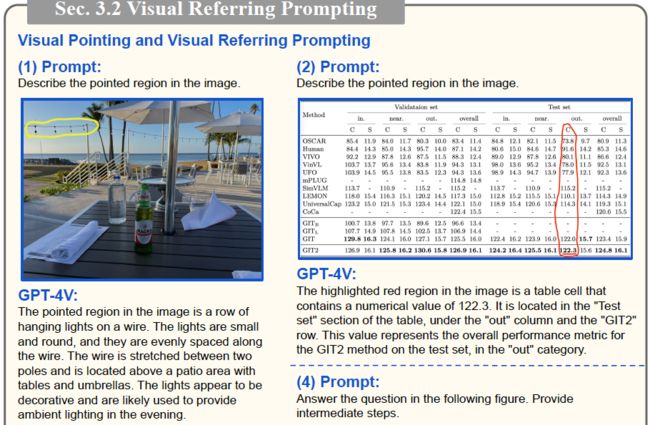

3.2 视觉指针和视觉参考提示(visual referring prompting)

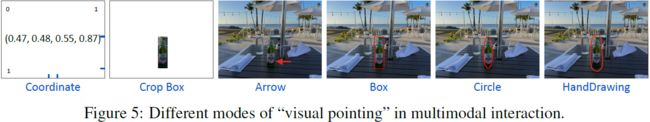

指针是人与人交互的一个基本方面 [84]。

- 为了提供可比较的交互渠道,研究了各种形式的 “指针” 来指代任意感兴趣的空间区域。 例如,如图 5 所示,“指针” 可以表示为数字空间坐标(例如框坐标和图像裁剪),或覆盖在图像像素上的视觉标记(例如箭头、框、圆圈和手绘图)。

- 我们观察到 GPT-4V 在理解直接绘制在图像上的视觉指针方面特别强。 鉴于在图像上绘图的灵活性,此功能可以用作未来野外人机交互的自然方法[85,110,150]。

- 为此,我们探索了一种名为视觉参考提示(visual referring prompting)的新提示方法,人们可以编辑输入图像的像素空间来指定所需的目标,例如绘制视觉指针或手写场景文本。

- 如图 6 所示,视觉参考提示会编辑图像像素,而不是传统的文本提示,以执行感兴趣的任务。 例如,它可以是一个简单的基础描述,重点描述所指出的对象,同时保持对全局图像上下文的理解,如图 6 (1,2) 所示。

- 视觉参考提示还支持其他新颖的用例,例如将指针的对象与场景文本中写入的索引相关联(图 6 (3)),或者解决在查询的边缘或角度附近提出的问题(图 6 (4))。

- 第 5 节将更详细地讨论视觉引用提示。

![]()

3.3 视觉+文字提示

视觉参考提示可以与其他图像文本提示顺利地结合使用,呈现出一个细致入微的界面,简洁地代表感兴趣的问题。

- 图 7 提供了两个示例,展示了 GPT-4V 提示的灵活性,特别是它在集成不同输入格式以及将指令与输入中的示例无缝混合方面的熟练程度。

- GPT-4V 的通用性和灵活性导致了对多模式指令的类似人类的理解以及前所未有的适应未见过任务的能力。

集成的多模态指令输入。

- 现有模型通常对如何格式化交错图像文本输入有隐式约束,例如,上下文中的小样本学习(in-context few-shot learning)需要图像文本对共享与查询输入类似的格式。

- 相比之下,GPT-4V 显示了处理图像、子图像、文本、场景文本和视觉指针的任意组合的通用性。 例如,为了说明图 7 中的“添加一条线”模式,可以像子图 (1) 中那样用圆圈指向矩阵图像中的第一列,或者像子图 (2) 中那样将子图像放在一行内。

- 类似地,对于输入查询,可以像子图(1)中那样呈现带有问题的大图作为场景文本,或者像子图(2)中那样输入文本和子图像的混合。

- 与 GPT-4V 的灵活性相比,现有的多模态模型在如何结合图像和文本以及可以处理的图像数量方面受到严格限制,从而对模型的能力和通用性造成了限制。

基于示例的多模式指令。

- 除了支持更灵活的输入格式之外,与指令遵循模式(instruction-following mode)和上下文中的小样本学习相比,GPT-4V 的通用性还开辟了更有效的方式来说明要执行的任务。

- 指令遵循技术 [96,91,127,104] 最初是为 NLP 任务提出的,直观地专注于纯粹文本格式的任务指令。文本指令与视觉查询输入松散相关,因此可能无法提供清晰的任务演示。

- 虽然上下文中的少样本学习 [22,118,6] 提供了包含图像和文本的测试时示例,但这些示例必须与推理查询的格式完美一致,这使得它们的合并变得复杂且冗长。 此外,上下文示例通常与指令分开使用,要求模型推断任务目标,从而损害演示的有效性。

- 相比之下,GPT-4V 理解多模式指令的能力使任务演示能够基于相应的上下文示例,从而更有效地说明感兴趣的任务。 例如,在图 7 中,“查找第一列中的图样” 的指令与演示示例中的关键步骤(即(1)中的圆圈图样和(2)中的相应子图)结合,可以简化了学习过程并提高模型的性能。 这种方法也反映了人类的学习过程,涉及抽象指令与直观示例的结合。

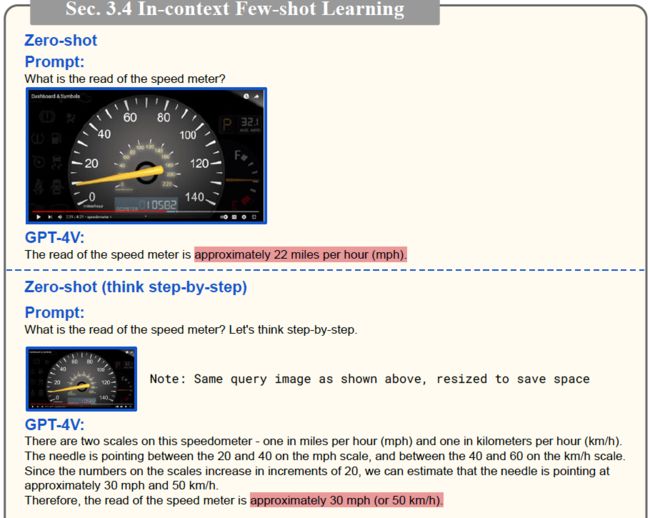

3.4 上下文小样本学习(In-context Few-shot Learning)

上下文中的小样本学习是 LLM 中观察到的另一种有趣的新兴能力 [22,36,128,31]。

- 也就是说,LLM 可以通过在推理时预先考虑一些上下文中的示例来生成所需的输出,而无需更新参数。 这些示例与输入查询具有相同的格式,并作为演示来说明所需的输出。最近在多模态模型 [118,6,52,39,144] 中观察到类似的能力,其中输入查询是格式化的图像文本对。

- 作为指令调整的补充,上下文学习通过在测试期间提供具有相同格式的上下文示例来 “教导” 模型执行新任务。

- 我们通过一些引人注目的例子展示了 GPT-4V 的上下文中的小样本学习能力。 我们强调,在某些情况下,具有足够数量示例的上下文中的小样本学习变得至关重要,特别是当零样本或单样本指令方法不足时。

- 图 8-10 探讨了涉及读取速度计(speed meter)的具有挑战性的场景。

- 图 8 显示了 GPT-4V 在来自一个视频的速度计的屏幕截图上的零样本性能。 尽管多次尝试以零样本方式提示 GPT-4V,但它很难准确读取图像中显示的当前速度。 它生成的预测(22/30/40 英里/小时)与人类实际读取的 “大约 9 英里/小时” 存在显着偏差。

- 即使使用 1-shot 上下文示例(如图 9 所示),使用不相似的示例(图 9a)或相似的示例(图 9b),GPT-4V 仍然无法准确定位左侧的两个数字 和黄色指针的右侧。

- 相比之下,图 10 表明,当提供 2 个上下文示例(其中一个与查询图像相似,另一个不相似)时,GPT-4V 通过识别指针接近 10 英里/小时但还没有完全达到,来成功预测速度为 “大约 9 英里/小时”。

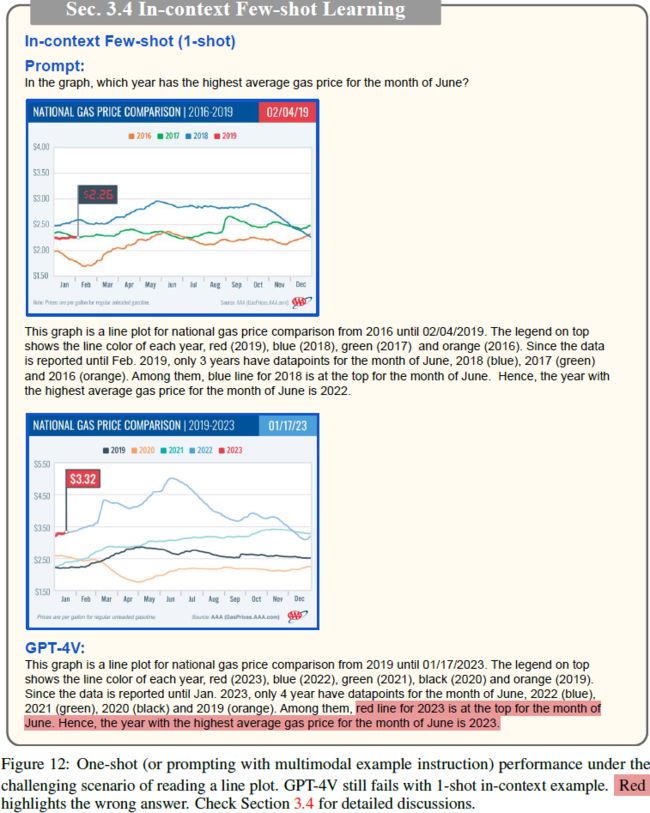

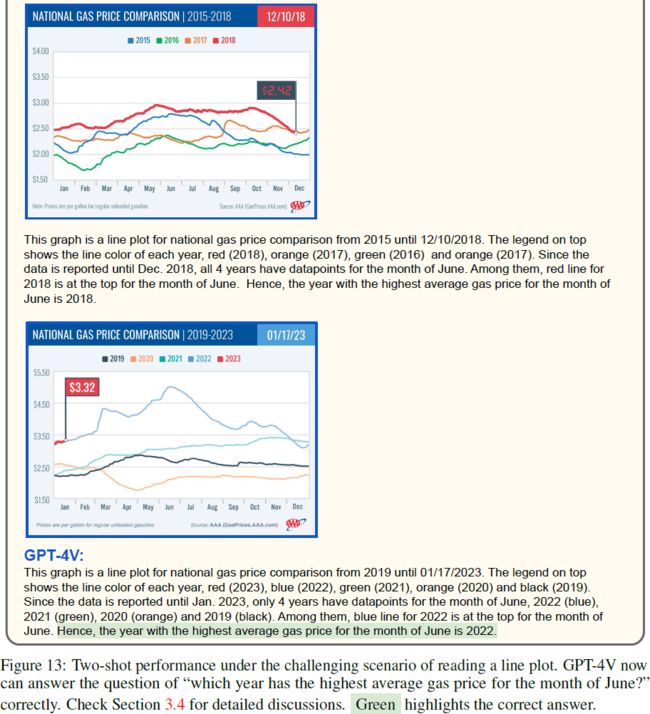

图 11-13 展示了在复杂线图上进行推理的零样本、1 样本和 2 样本性能之间的比较。

- 我们在这里探讨的示例具有很大的难度,因为它涉及多跳(multi-hop)推理。 要回答 “图中哪一年 6 月平均 Gas 价格最高” 的问题,需要至少经过四个步骤:(i) 在 x 轴上定位 6 月,(ii) ) 比较 6 月份每条线的数据点,(iii) 识别具有最高值的线的颜色,以及 (iv) 将颜色与顶部图例中的相应年份相匹配。 这些步骤中的任何一个失败都会导致错误的预测。

- 如图 11 所示,即使以零样本方式提示 “文本指令,逐步思考”,GPT-4V 也无法正确地将颜色与图例中的年份关联起来。 此外,它还被图中突出显示的 3.32 美元的 Gas 价格分散了注意力。

- 同样,在图 12 中,尽管 GPT-4V 在阅读图例方面显示出一些改进(与零样本相比,更正了 2021 年和 2022 年的相应颜色),但它仍然坚持以 2023 年作为平均 Gas 价格最高的年份来回答,尽管该图表仅包含截至 2023 年 1 月 17 日的数据点。

- 然而,当我们在图 13 中引入另一个上下文示例时,GPT-4V 最终得出正确答案 (2022) 并提供解释其推理过程的中间步骤,类似于上下文示例中所示的演示。

这些概念验证示例生动地证明了上下文中的小样本学习对于提高 LMM 性能的重要性。

- 这种方法是微调的可行替代方案,类似于 LLM [22,36,128,31] 中的观察结果。

- 尽管上下文中的小样本学习对于 LMM 实现更好的性能非常重要,但我们在本报告中限制了它的使用,以防止潜在的信息泄漏或来自上下文示例的不需要的提示。

- 我们还将小样本学习增益的定量评估留给未来的研究。

4. 视觉语言能力

理解和描述视觉信息在人类认知中起着至关重要的作用。 在本节中,我们将研究如何利用 GPT-4V 来理解和解释视觉世界。

4.1 不同领域的图像描述

我们通过提供单个图像-文本对作为输入来访问模型的功能和通用性。 我们提示 GPT-4V 生成涵盖下列各种主题的自然语言描述。

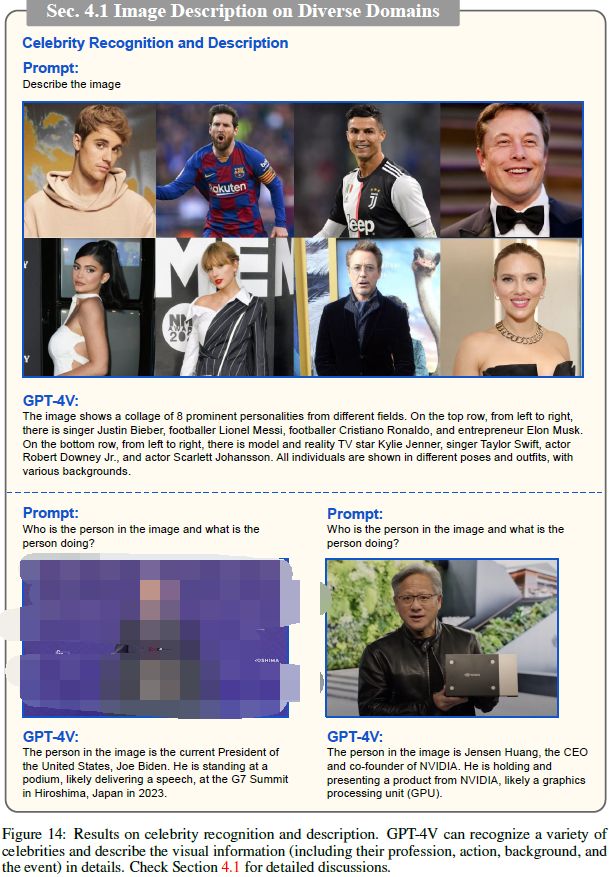

名人识别。

- 由于其固有的可变性,识别人类外表 [46, 76] 提出了重大挑战。

- 为了评估 GPT-4V 识别和描述名人的能力,我们通过提供文本提示 “描述图像” 以及输入的名人图像来进行实验。

- 在图 14 的顶行中,我们观察到 GPT-4V 准确地识别了八位名人,尽管他们的背景和领域各不相同。

- 此外,当我们提出更具体的查询 “图像中的人是谁,这个人在做什么?”(如图 14 的底行所示)时,GPT-4V 会理解现任美国总统正在 2023 年七国集团峰会上发表演讲。 这说明了该模型概括和处理新场景的能力,例如 2023 年 G7 峰会,但该场景并不属于其训练数据。

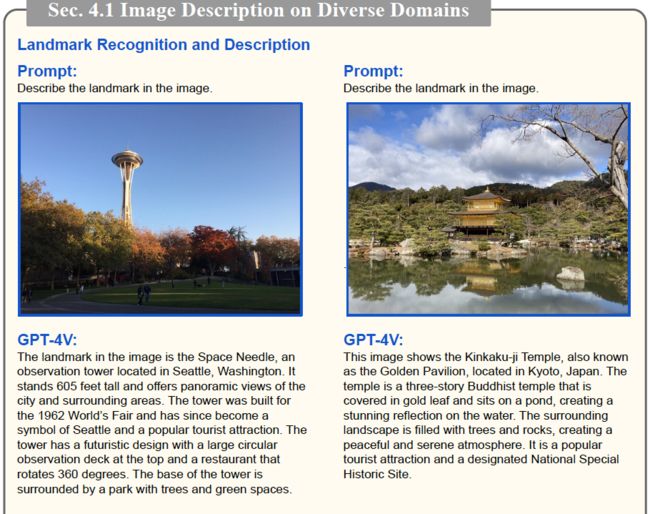

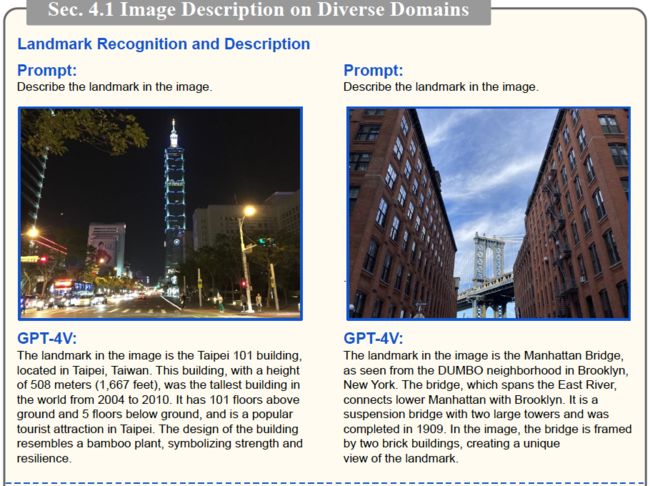

地标识别。

- 由于视点变化、照明条件、遮挡和季节变化等因素,地标的外观呈现出相当大的变化。 识别这些变化下的地标需要模型能够很好地概括并处理广泛的视觉外观 [145, 4]。

- 在实验中,我们采用简单的文本提示 “描述图像中的地标” 来测试模型的能力。

- 如图 15-16 所示,GPT-4V 为每个测试图像生成准确且开放式的描述。 例如,它可以准确识别位于华盛顿州西雅图的太空针塔,了解该塔是为 1962 年世界博览会而建造的,并已成为该城市的象征。

- 我们对其他测试照片也有类似的观察结果。 生成的描述超越了简单的标签或通用短语,提供了生动而详细的叙述,捕捉了地标的本质。

食物识别。

- 识别食物或菜肴是一项令人着迷的任务 [19, 90],但由于外观范围广泛以及其他物体或重叠成分造成的潜在遮挡,因此处理起来可能具有挑战性。

- 在我们的实验中,我们采用简单的文本提示,要求系统 “描述菜肴的名称”,以进行测试。

- 图17展示了 GPT-4V 对各种菜肴的准确识别。此外,GPT-4V 可以有效捕捉图像中的复杂细节,使其能够识别菜肴中的特定成分、装饰或烹饪技术。

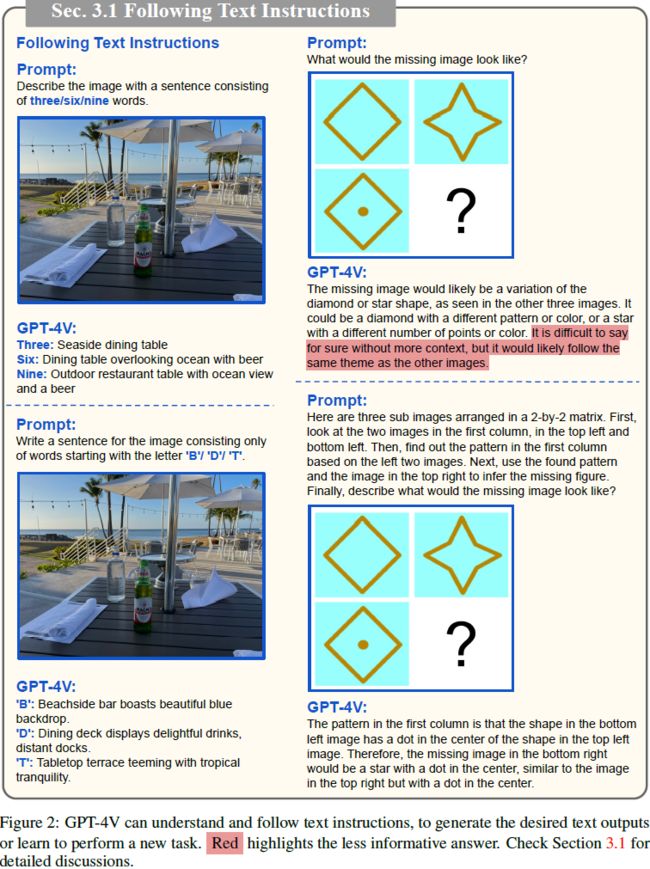

![]()

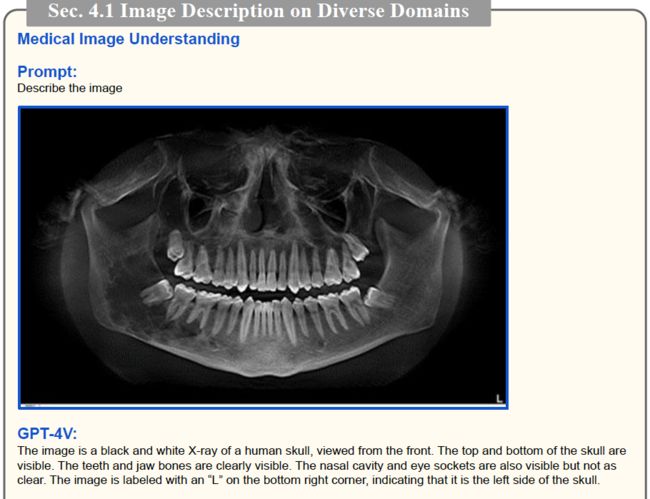

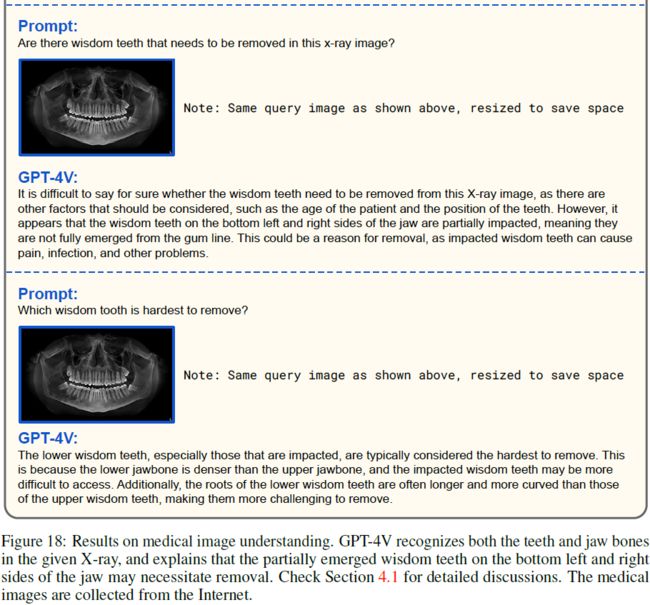

医学图像理解。

- 由于患者群体和成像设备的不同,X 射线和 CT 扫描等医学图像可能存在很大的差异。 此外,解释这些图像的视觉内容需要专业知识。

- 在图 18 中,我们通过提供提示 “描述图像” 来访问 GPT-4V 的性能。结果表明,GPT-4V 可以识别给定 X 射线中的牙齿和颌骨。此外,当我们提示 “这张X光图像中是否有需要拔除的智齿?” GPT-4V 通过视觉上下文进行推理,并解释下颌左下方和右下方的智齿没有完全从牙龈线中露出,这可能是拔除的原因。

- 我们还使用其他医学图像进行测试,如图 19 所示。对于这些实验,我们使用诸如 “出了什么问题?” ,或者“ 看看 CT 扫描,告诉我出了什么问题。” 之类的提示。观察结果表明,GPT-4V 可以识别常见情况,例如琼斯骨折(Jones fracture)。 它还可以根据肺部 CT 扫描指出潜在的问题。

- 实验证明了 GPT-4V 对医学图像的基本理解。 我们在 9.3 节中讨论 GPT-4V 在医学领域的应用。

Logo 识别。

- 我们考察了 GPT-4V 的标志识别能力。

- 在图 20 中,我们通过提供文本提示 “描述图像” 来启动实验。GPT-4V 准确识别了图像中描绘的三个徽标。然后我们继续提出一个更具体的问题,“详细描述徽标”,GPT-4V 提供了详细的描述,分别包括每个徽标的设计、风格和表示。

- 将评估扩展到更具挑战性的野外场景,如图 21 所示,我们尝试使用可能部分遮挡、扭曲或位于杂乱背景中的徽标。我们使用文本提示 “详细描述图像和徽标” 进行野外实验。 如图 21 所示,GPT-4V 在困难场景下展现出强大的标识理解能力。

- 值得注意的是,GPT-4V 还可以提供新颖或新兴徽标和图标的描述,例如最近发布的 Microsoft 365 Copilot。

场景理解。

- 场景理解[72,29,147]是计算机视觉中的一项重要任务。

- 我们通过提供简单的查询 “描述图像” 来检查模型的功能。

- 在图22中,GPT-4V 能够描述道路以及车辆的位置和颜色。 它还可以读取标志并注意这条道路的速度限制。

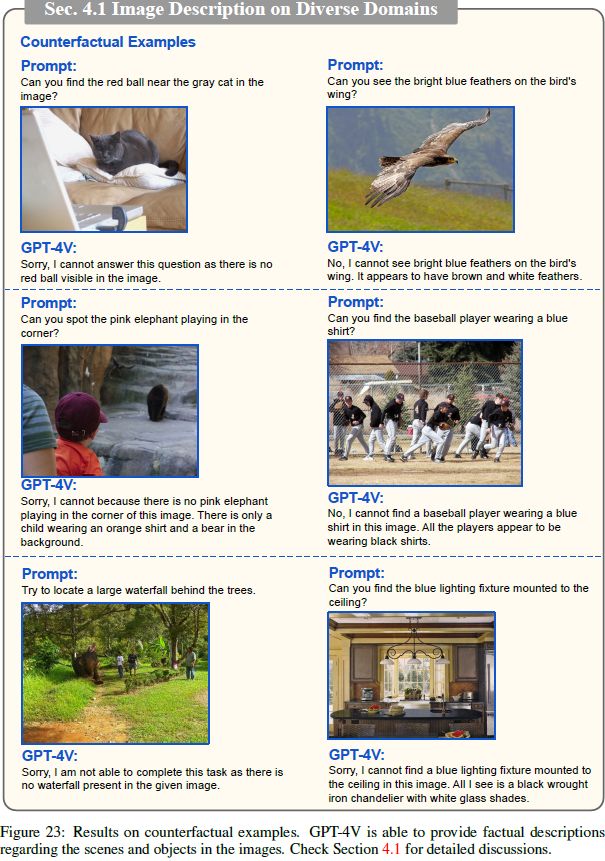

反事实的例子。我们通过从 [74] 中随机选择反事实的例子来进行实验。 在图 23 中,我们观察到 GPT-4V 在遇到误导性问题或指令时正确描述了图像内容。

4.2 目标定位、计数和密集标题

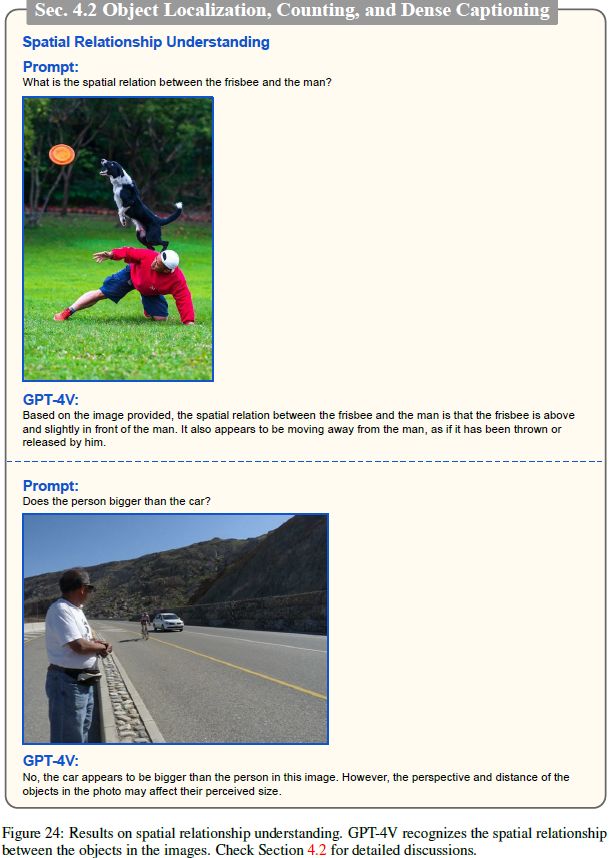

空间关系理解。

- 理解图像中人和物体之间的空间关系是视觉智能的一个重要方面 [58, 13]。

- 在图 24 中,GPT-4V 展示了这方面有前景的功能。 它可以识别飞盘和图像中的人之间的空间关系。 它还可以识别图像中人和汽车之间的空间关系,并指出相机视角可能会影响他们感知的尺寸。

物体计数。

- 图 25 突出显示了我们对 GPT-4V 在对象计数方面的能力的探索。 在我们的实验中,我们使用文本提示 “计算图像中 X 的数量” 来评估其性能。

- 结果表明,GPT-4V 可以成功计算图像中存在的物体(例如苹果、橙子和人)的数量。

- 然而,当物体被遮挡或场景混乱时,就会出现挑战,这可能会导致计数过程中的错误。

- 在图 25 的左下角,GPT-4V 识别了 12 个人,但正确答案应该是 11。这可能是由于我们在本实验中使用的文本提示有限,需要进一步研究提示技术。

目标定位。

- 目标定位 [146,72,48] 是计算机视觉领域的一个基本挑战。

- 在我们的初步实验中,我们通过使用简单的文本提示 “使用边界框定位图像中的每个人” 来解决此任务。我们的目标定位实验的初步结果如图 26 所示。

- 研究结果表明,GPT-4V 展示了以文本格式生成边界框坐标的能力。 但是,需要注意的是,生成的边界框坐标并不准确。

- 当场景或背景相对简单且不那么混乱时,可以观察到有希望的定位结果。

- 需要进一步的提示技术来增强更复杂和拥挤的环境中的对象定位性能。

密集标题。

- 密集标题 [59, 79] 涉及为给定图像中的每个感兴趣区域生成详细描述。

- 这项视觉语言领域的高级任务通常需要一个集成多个专家的复杂系统,例如对象检测器、名人识别模型和图像标题模型。

- 为了探索 GPT-4V 在密集标题方面的能力,我们使用了指令提示,如图 27 所示。

- 结果非常令人鼓舞,因为 GPT-4V 成功定位和识别图像中的个体,然后为图像中的每个科学家提供简洁的描述。

4.3 多模态知识和常识

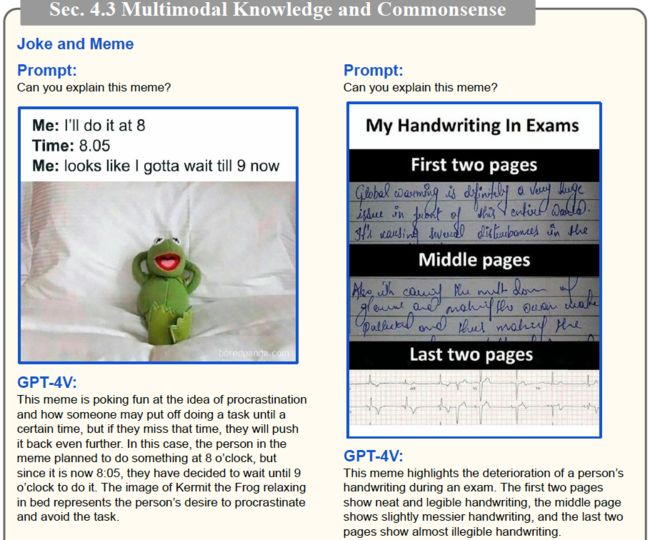

笑话和 meme。

- 笑话和 meme 通常引用特定事件、流行文化或互联网趋势。理解这些需要熟悉相关背景和文化知识。

- 掌握视觉元素、它们与文本的关系以及预期的幽默效果可能是一项复杂的任务 [94]。 此外,meme 通常是用户生成的,这使得它们高度多样化且不断扩展。

- 为了评估 GPT-4V 在该领域的能力,我们向 GPT-4V 输入一对 meme 和文本提示。 示例文本提示包括 “你能解释一下这个模因吗?” 以及 “这张照片有什么有趣的地方?”

- 图 28 显示了示例结果。我们观察到 GPT-4V 具有从视觉和文本模式收集信息的卓越能力,然后理解 meme 中嵌入的幽默。

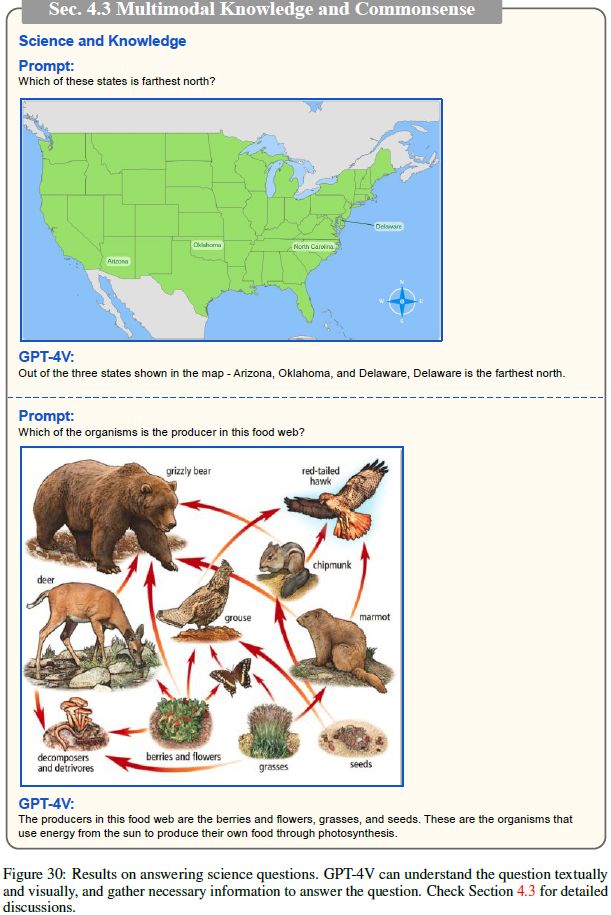

科学和知识。

- 我们进一步研究了 GPT-4V 在需要用科学知识进行推理的任务中的能力 [80]。

- 我们通过提供文本提示问题和相应的图像来进行实验。 这些问题涵盖广泛的主题,包括地理、物理、生物学和地球科学。

- 在图 29-31 中,我们观察到 GPT-4V 能够根据视觉上下文正确回答科学问题。

- 例如,在图 29 的底行中,GPT-4V 识别了样品 A 和样品 B 的平均粒子速度。通过考虑粒子速度、动能和温度之间的关系,GPT-4V 正确回答了问题。

- 再例如,如图 30 的底行所示,GPT-4V 考虑图中显示的视觉箭头来识别特定食物网中的生产者。

- 此外,如图 31 所示,当我们提供更具体的提示时,例如 “假设您是老师,请用图来解释 X”,我们观察到生成的答案采用教程格式并逐步解释主题 。

多模态常识。

- 在图 32 中,我们访问了 GPT-4V 在多模态常识推理中的能力 [141, 49]。

- 在我们的实验中,我们观察到 GPT-4V 有效地利用图像中呈现的边界框作为视觉提示(例如,[person1] 和 [person2])来识别个体执行的操作。

- 如图 32 中的第二个示例所示,根据 [person1] 和 [person2] 所穿的礼服以及场景中存在的花卉装饰,可以推断他们正在参加婚礼。

- 此外,当我们提供更具体的输入提示时,例如 “假设你是一名侦探,你能从视觉线索中推断出什么?”,GPT-4V 展示了辨别图像中众多细致入微的视觉线索的能力,并提供了一个合理假设的列表。

4.4 场景文本、表格、图表和文档推理

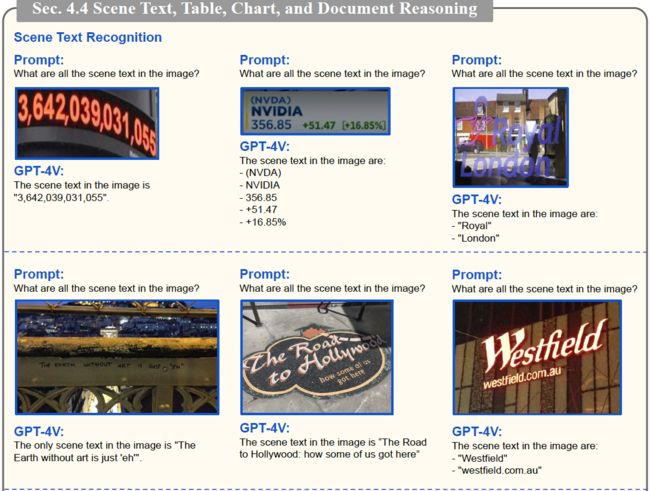

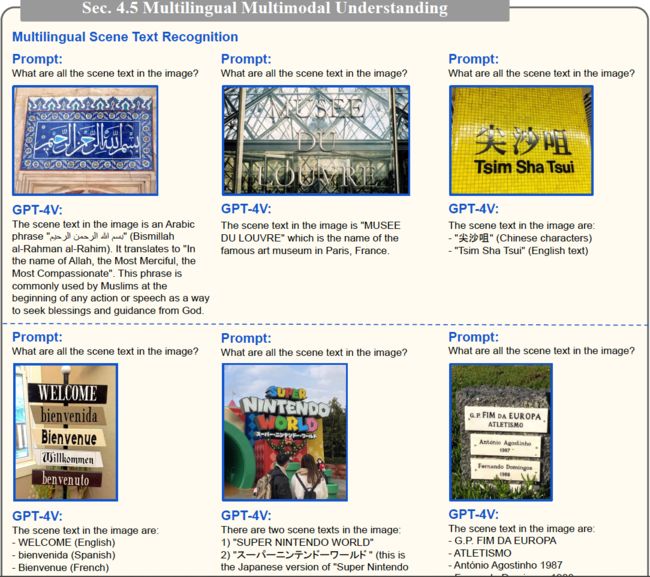

场景文本识别。

- 阅读和理解图像中的场景文本是视觉语言中的一项重要任务 [111–113, 16]。

- 在我们的实验中,我们利用输入提示 “图像中的所有场景文本是什么?” 来研究 GPT-4V 识别场景文本的能力。

- 图 33 显示了示例结果。我们观察到 GPT-4V 可以准确识别各种场景中的场景文本,包括手写文本和打印文本。

- 在第 4.5 节中,我们提出了多语言场景的进一步结果。

视觉数学推理。

- 在图 34 中,GPT-4V 展示了其解决视觉数学问题的能力。

- 在我们的实验中,我们观察到 GPT-4V 能够从图像中提取基本信息。 例如,在图 34 中,GPT-4V 正确识别了直角三角形(或正交三角形)的存在,并确定 AB 为 4 个单位,BC 为 3 个单位。

- 此外,我们注意到 GPT-4V 倾向于以结构良好的方式提出解决方案,逐步解决问题,从而展示其提供清晰解释的能力。

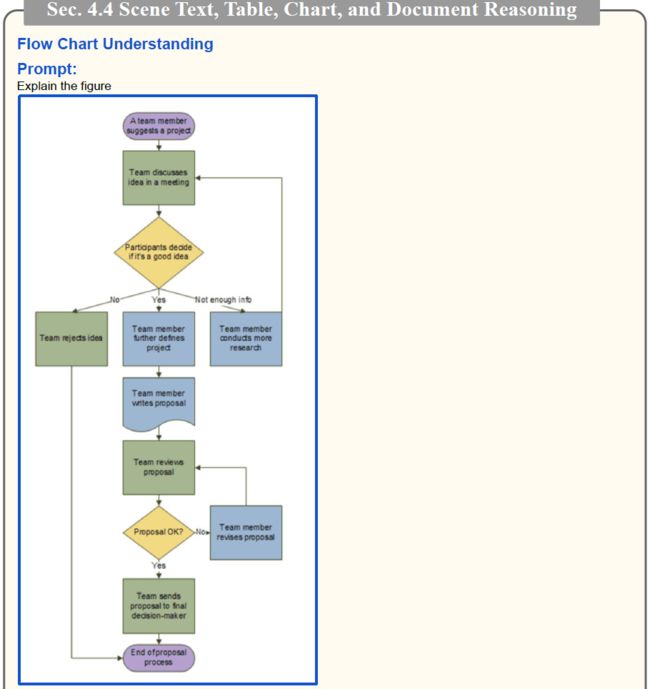

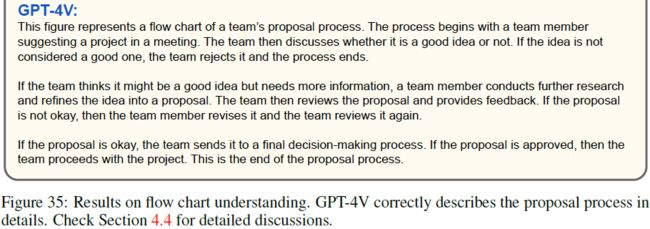

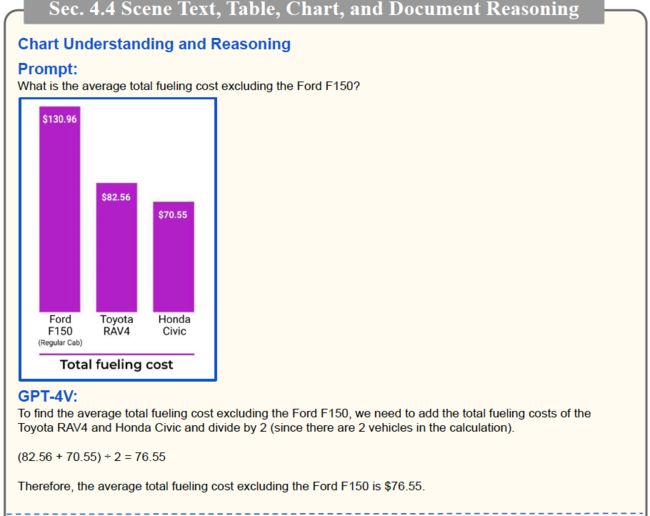

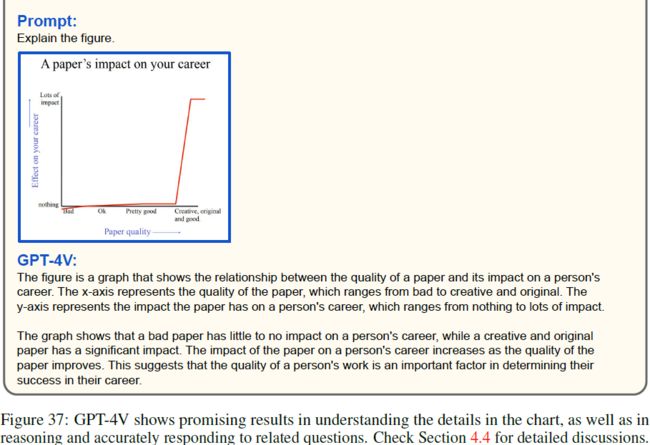

图表理解和推理。

- 我们进一步研究 GPT-4V 的图表理解和推理能力。图 35-37 显示了示例结果。 在我们的初步探索中,GPT-4V 展现了提供图表详细描述的能力。

- 例如,在图 35 中,模型正确地解释了从开始到结束的提案过程。

- 在图 36 中,模型不仅理解给定流程图,还将详细信息转换为 Python 代码。

- 在图 37 的底行中,GPT-4V 显示了对 x 轴和 y 轴的清晰理解,并解释了图表中呈现的关键见解。

- 此外,在我们的实验中,我们观察到 GPT-4V 可以根据图表回答问题。 在图 37 的顶行中,GPT-4V 正确计算了除 Ford F150 之外的平均总加油成本。

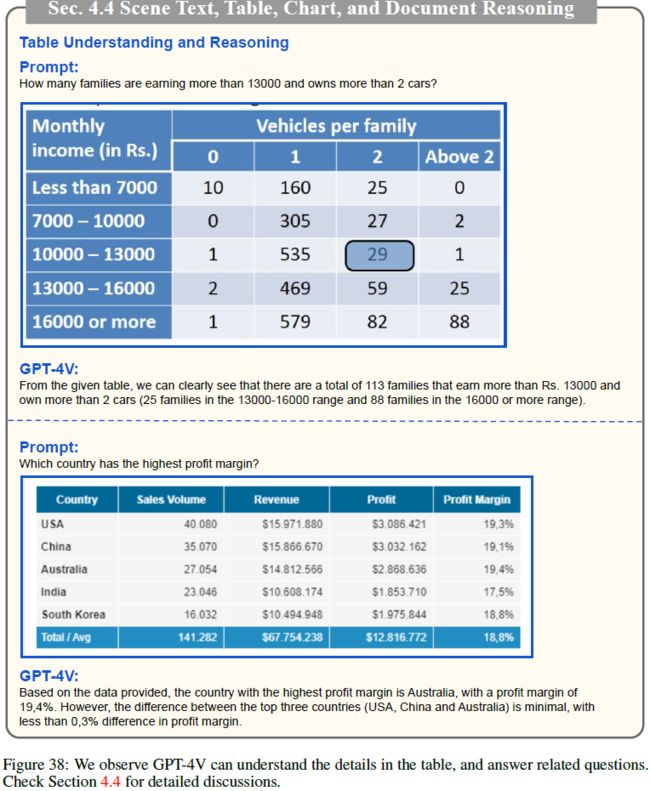

表格理解和推理。

- 在图 38 中,我们展示了对表格理解和推理的初步调查。

- 与图表实验的结果类似,GPT-4V 在理解表格中的细节以及推理和准确回答相关问题方面显示出有希望的结果。

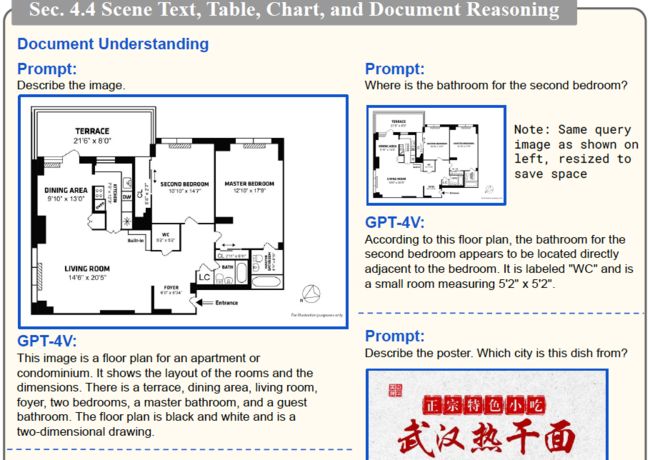

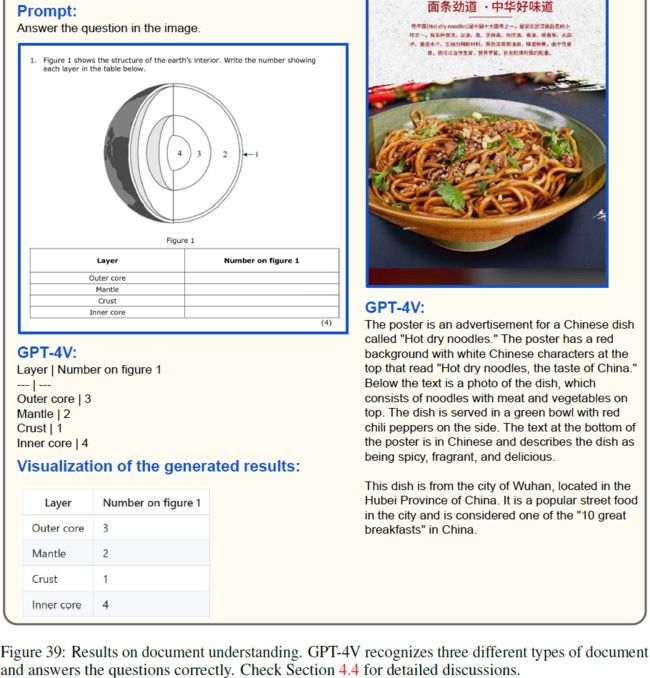

文档理解。

- 图 39 显示了各种类型文档(例如平面图、海报和试卷)的结果。

- 我们观察到 GPT-4V 表现出对文档的理解并提供了合理的回应。

- 例如,它可以准确识别平面图中第二间卧室的浴室位置。

- 它还识别出中国菜“热干面”,并通过场景文本将其与武汉市联系起来。

- 此外,GPT-4V 能够阅读试卷。 它准确地重建了 Markdown 中的表格,然后用正确的答案填充表格。

- 我们在 4.6 节中对其编码能力进行了更多探索。

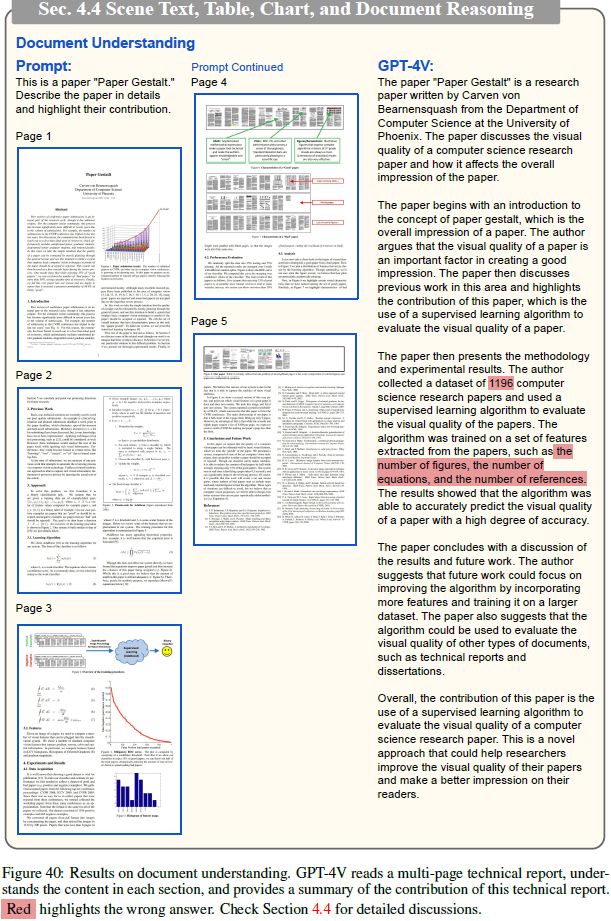

在图 40 中,我们通过提供包含多个页面作为输入的技术报告 [119] 来探索更具挑战性的案例。

- 在我们有限的探索中,GPT-4V 表现出了令人印象深刻的结果。 通过考虑跨多个页面的上下文,它正确地描述了主要思想和他们提出的方法。

- 然而,它偶尔可能会错过一些实现细节。 请注意,数据集应包含 1196+665=1861 个示例,提取的特征应包括定向梯度直方图 (HOG)。

- 我们相信,探索更先进的提示技术(例如逐步思考或采用上下文中的小样本方法)而不是同时向模型提示所有页面,可能会提高模型的性能。

4.5 多语言多模态理解

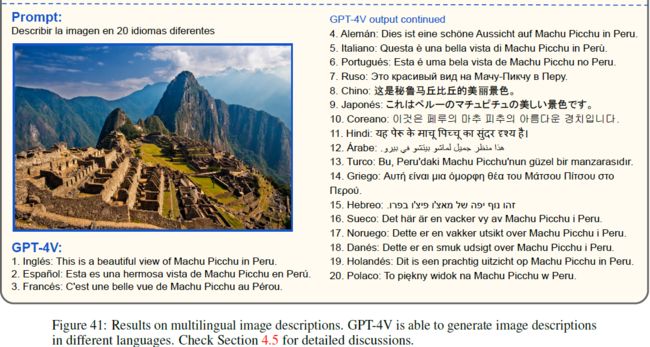

我们评估 GPT-4V 理解多种语言和模式的能力。

- 首先,我们通过评估没有场景文本的自然图像来探索此功能,如图 41 所示。

- 在该图的第一行中,我们分别提供中文、法语和捷克语的输入文本提示 “描述图像”。 GPT-4V能够识别不同语言的输入文本提示,并生成相应语言的正确图像描述。

- 在图 41 的第二行中,我们提供英文输入文本提示并指定输出语言。 GPT-4V 遵循指令并以所需语言生成正确的描述。

- 在图 41 的底行中,我们提供了西班牙语的输入提示,并要求 GPT-4V 生成 20 种不同语言的图像描述。 我们观察到 GPT-4V 可以处理不同语言的输入和输出文本。

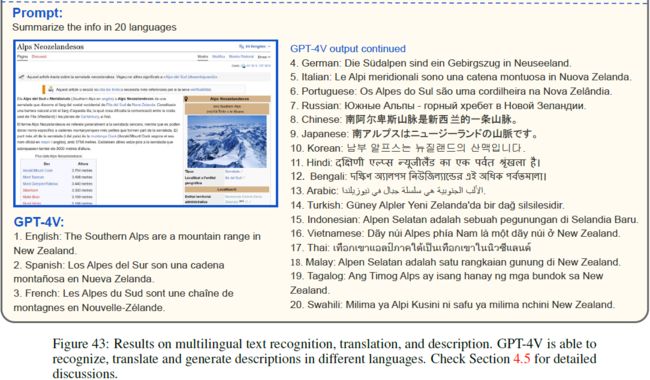

此外,我们探索了涉及多语言场景文本识别的场景,其中输入图像可能包含各种语言的场景文本。

- 如图 42 所示,GPT-4V 正确识别和理解来自不同场景的场景文本。

- 如图 43 的前两行所示,我们观察到 GPT-4V 可以识别场景文本,并将其翻译为不同的语言。

- 在图 43 的底行中,我们提供了加泰罗尼亚语维基百科网站的屏幕截图,并指示 GPT-4V 以 20 种不同语言总结信息。 GPT-4V 不仅可以识别加泰罗尼亚语文本,还可以生成精确的摘要并将其翻译成不同的语言。 这展示了 GPT-4V 理解和翻译多语言场景文本的能力。

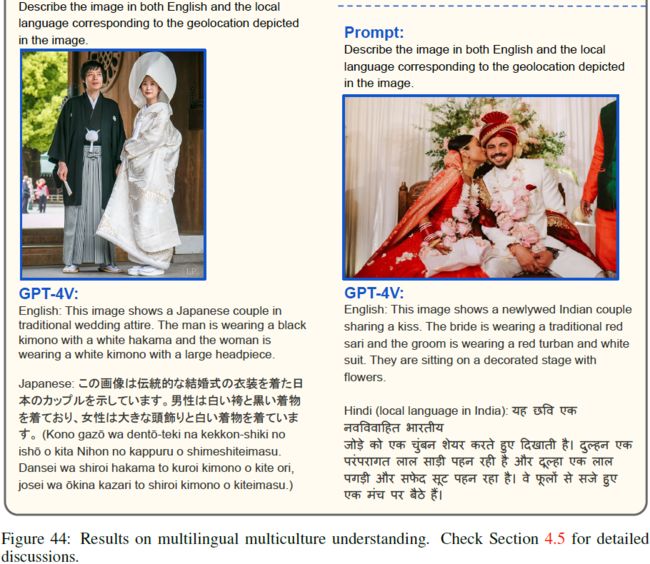

我们还探讨了多元文化理解的能力 [140, 73]。

- 图 44 显示了此类场景中的示例结果。

- 我们观察到 GPT-4V 能够理解文化的细微差别,并为给出的婚礼图像生成合理的多语言描述。

在我们的探索中,我们发现 GPT-4V 可以无缝理解并正确生成不同语言的描述,凸显了其在处理不同语言环境方面的多功能性。

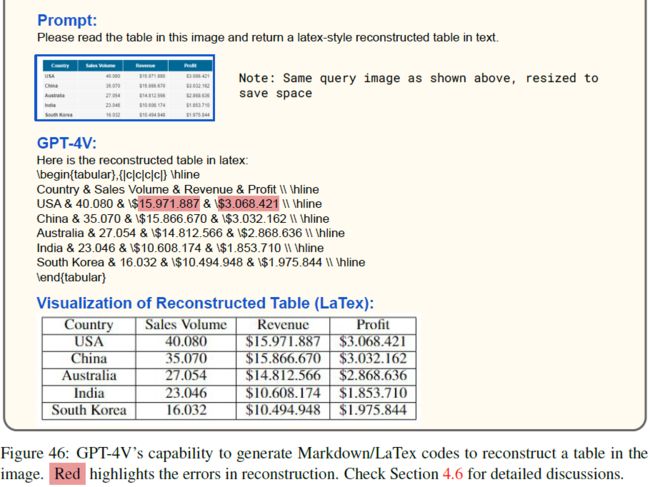

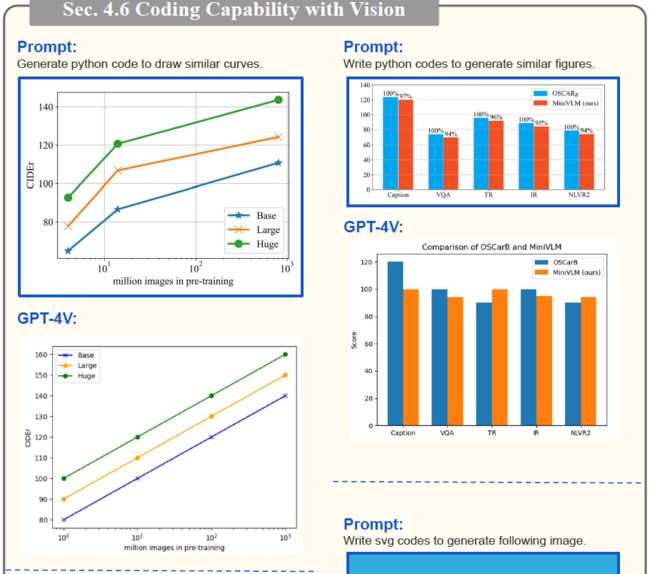

4.6 视觉编码能力

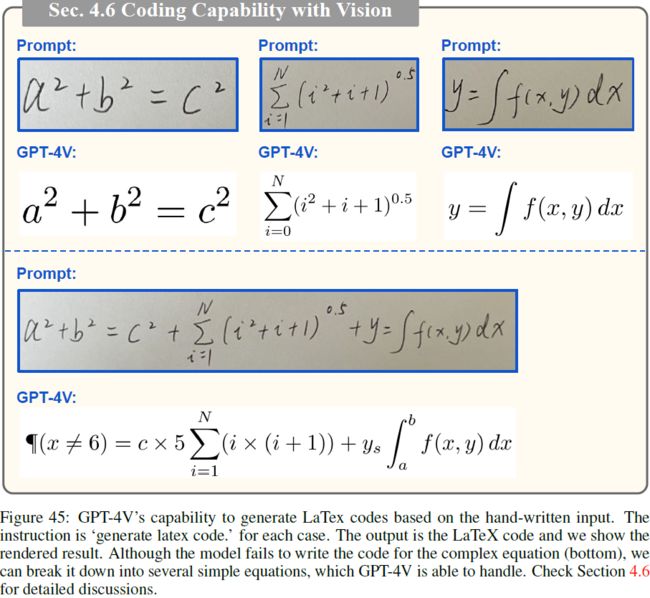

图 45 说明了基于手写数学方程生成 LaTeX 代码的能力。

- 该功能可以帮助用户更高效地在 LaTeX 中编写方程。

- 尽管该模型无法为较长的方程生成代码,但它可以有效地处理较短的方程。

- 通过将较长的方程分解为较短的成分,该模型能够生成适当的代码。

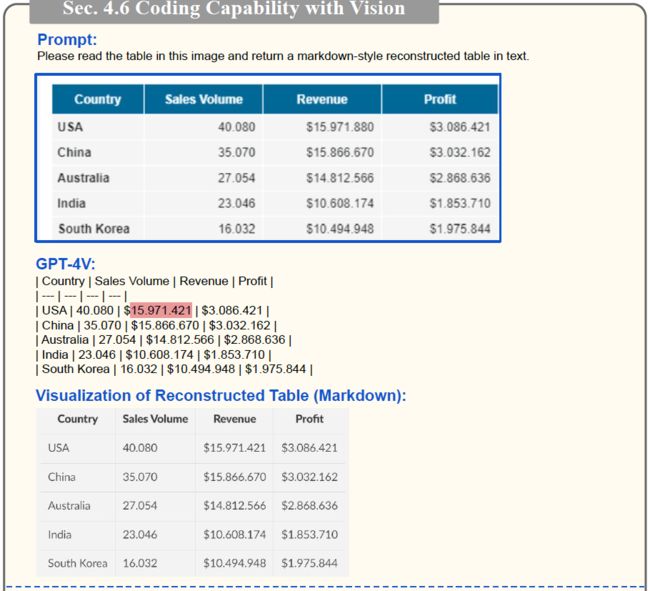

图 46 进一步演示了 GPT-4V 如何将输入图像中的表格重建为 MarkDown/LaTex 代码。

图 47 显示了用 Python、TikZ 和 SVG 编写代码来复制输入图形的示例。 尽管生成的输出不完全匹配,但布局相似,并且可以轻松修改代码以满足特定需求。

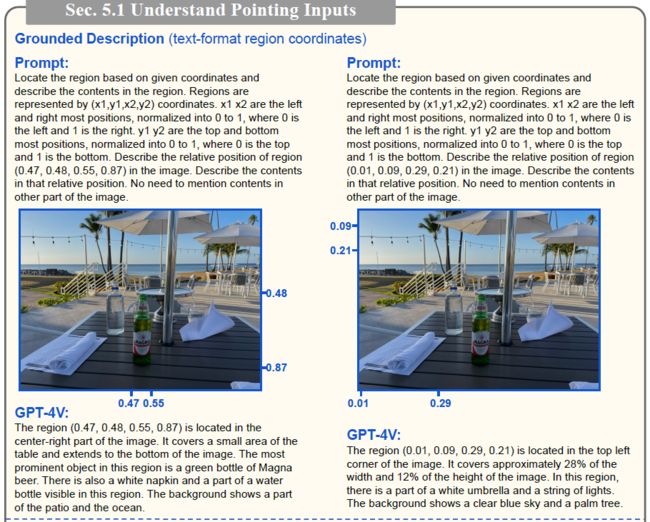

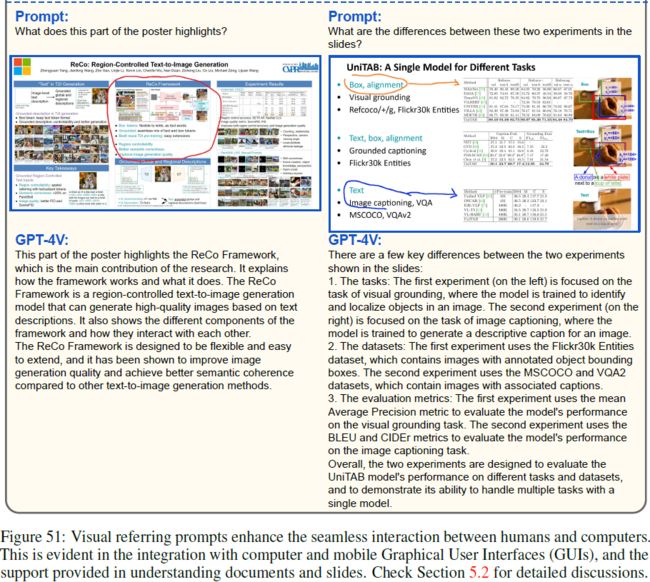

5. 与人类的交互:视觉参考提示

指向特定的空间位置是多模态系统人机交互的一项基本能力,例如进行基于视觉的对话。

- 如 5.1 节所示,GPT-4V 可以很好地理解直接绘制在图像上的视觉指针。 基于这一观察,我们提出了一种新颖的模型交互方法,名为 “视觉参考提示”。 其核心思想是直接编辑图像像素空间来绘制视觉指针或场景文本作为人类参考指令,如图 50 所示。

- 我们在 5.2 节中详细介绍了它的用法和优点。

- 最后,第 5.3 节探讨了如何让 GPT-4V 生成视觉指针输出以与人类交互。

- 这些视觉指针对于人类和机器来说都可以直观地生成和理解,使其成为人机交互的良好渠道。

5.1 理解输入指针

如图 48 所示,

- GPT-4V 可以理解直接覆盖在图像上作为指针的不同类型的视觉标记,例如圆圈、方框和手绘图。 这种能力有助于 GPT-4V 生成基础标题,这是一个已知的挑战性问题,让传统的视觉语言模型 [121] 生成专注于特定感兴趣区域的视觉描述。

- 密集标题方法 [59, 131] 使用裁剪框或掩模区域来生成局部描述,但通常会忽略全局图像上下文并产生次优描述。

- 视觉指针提供了一种自然的方式来指示感兴趣的区域,同时保持全局图像上下文。 例如,左上角的示例重点提供了对尖头麦格纳啤酒的全面描述,同时还提到了啤酒瓶放在桌子上的全局图像上下文。

覆盖在图像上的视觉指针的直观替代方案是以数字文本格式表示的区域坐标。

- 如图 49 所示,GPT-4V 可以理解开箱即用的坐标,通过文本标记实现空间参考的能力,而无需像之前的视觉语言模型 [122, 136] 那样进行额外的框标记微调。

- 尽管功能很有前途,但我们注意到我们当前的提示在空间上不太精确。 例如,在图 49 的左上示例中,GPT-4V 提到了周围的物体餐巾和水瓶,即使该区域中只有啤酒瓶 (0.47、0.48、0.55、0.87)。

- 总体而言,就我们实验的提示而言,与文本坐标相比,GPT-4V 在使用重叠视觉指针进行提示时工作更可靠。 这种独特的能力促使我们探索一种新的提示方法,即视觉参考提示。

5.2 视觉参考提示

受 GPT-4V 强大的视觉指向和场景文本理解能力的启发,我们探索了一种与 GPT-4V 交互的新方法,即视觉参考提示。

- 视觉参考提示是一种补充技术,它不是编辑文本空间的传统提示技术,而是直接编辑输入图像的像素空间以进行人机交互。

- 这种视觉提示可以提供与图像更细致、更全面的交互,从而有可能释放模型更广泛的响应。 例如:

- 在图 50 (1) 中,GPT-4V自然地将箭头指向的对象与给定的对象索引相关联,从而简化了剩余的视觉推理和文本输出;

- 在 (2) 中,GPT-4V 理解图像上写的问题并指出相应的边缘或角度,为基础视觉对话提供细致入微的界面;

- 在 (3) 中,人类可以指向图形内部的任意区域,以帮助 GPT-4V 更好地理解复杂的文档和图表;

- 在 (4) 中,该模式可以简洁地表示为箭头和场景文本 “+点”,因此有助于GPT-4V预测下一张图像。

- 作为对松散地基于图像的文本提示的补充,视觉参考提示提供了一种新颖的交互方法,可以促进各种用例,并在图 51 和第 9 节中进行了额外的演示。

5.3 生成指针

5.1 节讨论了 GPT-4V 理解人类生成的视觉指针的能力。 一个自然的问题是:GPT-4V 能否生成自己的指针,从而促进人机交互中的闭环交互过程?

图 52 探讨了通过让 GPT-4V 预测文本格式的区域坐标来生成视觉指针。

- 我们提示 GPT-4V 基于文本(例如 “蓝色斯巴鲁 SUV” 的文本)或参考图像(例如 “黑色奥迪轿车” 的图像)引用的对象。

- 与 GPT-4V 理解坐标输入的观察结果类似,该模型对空间位置有一个粗略的理解,但对于实验中使用的提示并不准确。 例如,在图 52 的 “绘图可视化” 中,GPT-4V 可以大致识别查询中提到的蓝色 SUV 和黑色轿车,但它很难创建紧密贴合的边界框。

- 我们观察到,在提示中包含基于示例的指令有助于 GPT-4V 理解坐标的定义,并随后生成更好的指向输出。

虽然生成的指针可能无法完美覆盖查询区域,但它们仍然为模型交互、解释和帮助多步骤视觉推理提供了有价值的工具。

- 具体来说,人类可以解释指针输出,以更好地理解 GPT-4V 的参考,或者由 GPT-4V 本身解释,以基于先前的输出进行进一步推理。 如图 52 底部所示,GPT-4V 能够解释其生成的指针,并根据图 48 中的提示提供基础描述。

- 此外,GPT-4V 本身的迭代指针生成和理解可以帮助复杂的多点视觉推理任务。GPT-4V 能够解构问题,生成不同的视觉标记,以迭代地关注每个子步骤的不同图像区域,最终整理信息以制定最终答案。

6. 时间和视频理解

在本节中,我们讨论时间和视频理解能力。

- 尽管 GPT-4V 主要以图像作为输入,但评估其对时间序列和视频内容的理解仍然是其整体评估的一个重要方面。

- 这是因为现实世界的事件会随着时间的推移而展开,而人工智能系统理解这些动态过程的能力对于现实世界的应用程序至关重要。 时间预测、时间排序、时间定位、时间推理和基础的时间理解等功能有助于衡量模型在理解事件序列、预测未来事件以及随时间的上下文分析活动方面的熟练程度,所有这些都在一系列静态图像中进行。

- 尽管 GPT-4V 以图像为中心,但它能够以类似于人类理解的方式理解视频和时间序列。 为了增强 GPT-4V 等复杂人工智能模型的多功能性和适用性,这方面的测试对其开发和完善至关重要。

- 对于本节即将进行的实验,我们将使用多个选定的视频帧作为输入来测试模型理解时间序列和视频内容的能力。

6.1 多图排序

在本小节中,我们将证明 GPT-4V 可以准确理解和分析视频帧序列。

- 在逐帧分析中,GPT-4V 可以识别活动发生的场景,从而提供更深入的上下文理解。

- 如图 53 所示,该模型不仅仅局限于识别环境; 它还准确地解释了视频中个人所执行的动作。 GPT-4V 可以理解各种人体姿势的顺序和背景,并智能地将它们与正在进行的活动关联起来。 通过了解识别之外的姿势变化,GPT-4V 可以从人类运动和动作的微妙之处中获取意义。

- 由于这种详细的理解水平,GPT-4V 可以捕捉视频中发生的事情的本质,提供丰富而细致的见解,而不仅仅是识别对象和场景。

6.2 视频理解

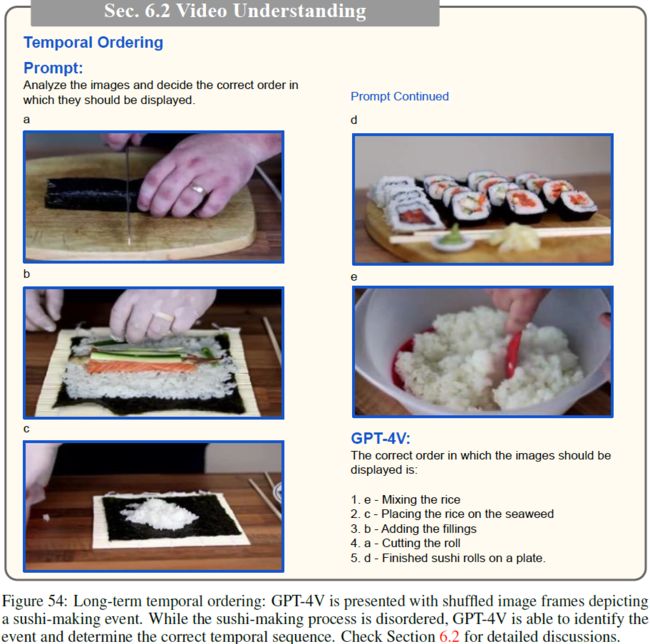

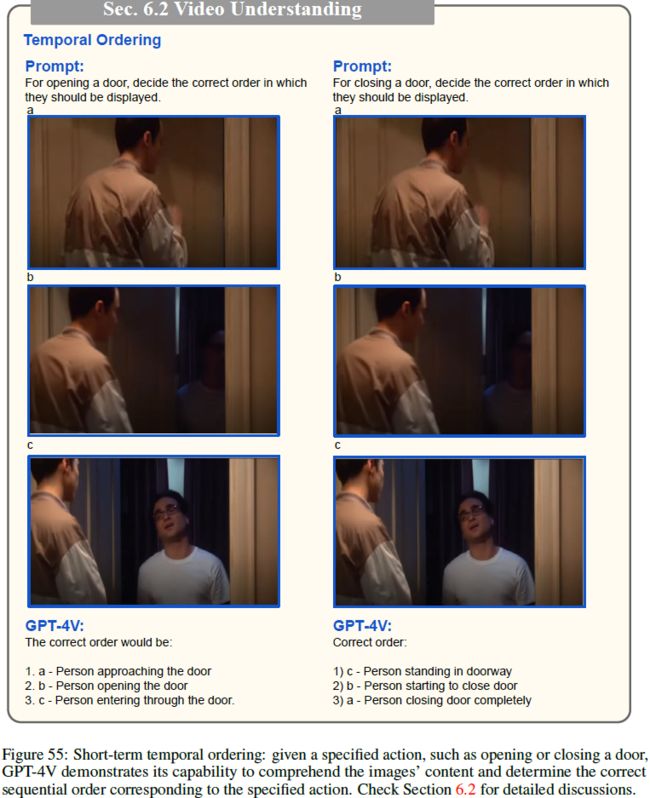

时间排序。

- 时间顺序是时间常识的关键要素,也是 GPT-4V 能力评估的重要组成部分。 这包括为模型提供一系列打乱的图像,并衡量其辨别因果关系以及时间进程的能力。 对此类关系的理解需要能够以逻辑连贯且时间准确的方式重新排序序列。

- 图 54 说明了长期时间排序的示例,其中 GPT-4V 呈现有一系列描绘寿司制作事件的打乱图像帧。 尽管存在混乱,GPT-4V 仍能有效识别事件并确定寿司制作过程的适当时间顺序。

- 此外,图 55 提供了短期时间排序的示例。 给定指定的动作,例如打开或关闭门,GPT-4V 展示了其理解图像内容并确定事件的正确顺序的能力。

- 这些例子凸显了 GPT-4V 在时间常识方面的能力,增强了其准确理解长期和短期序列的能力。

时间预测。

- 我们展示了 GPT-4V 在给定一组初始帧的情况下预测未来事件的能力。长期和短期的例子用于验证这种预测未来事件的能力。

- 图 56 的左侧以足球点球为例说明了 GPT-4V 预测短期事件的能力。 由于它对比赛的固有结构和规则的理解,在给出前几帧的情况下,它可以准确地预测踢球者和守门员的典型下一步动作。

- 此外,如图 56 右侧所示,寿司准备序列说明了 GPT-4V 的长期预测能力。 通过根据视觉线索了解活动,GPT-4V 不仅可以识别寿司准备过程中的当前进度,还可以准确预测后续步骤,展示了其在较长时间内解释和预测复杂的多步骤过程的能力。

- 这种短期和长期时间预测的结合使 GPT-4V 能够捕获和理解具有不同时间结构和复杂性的活动。

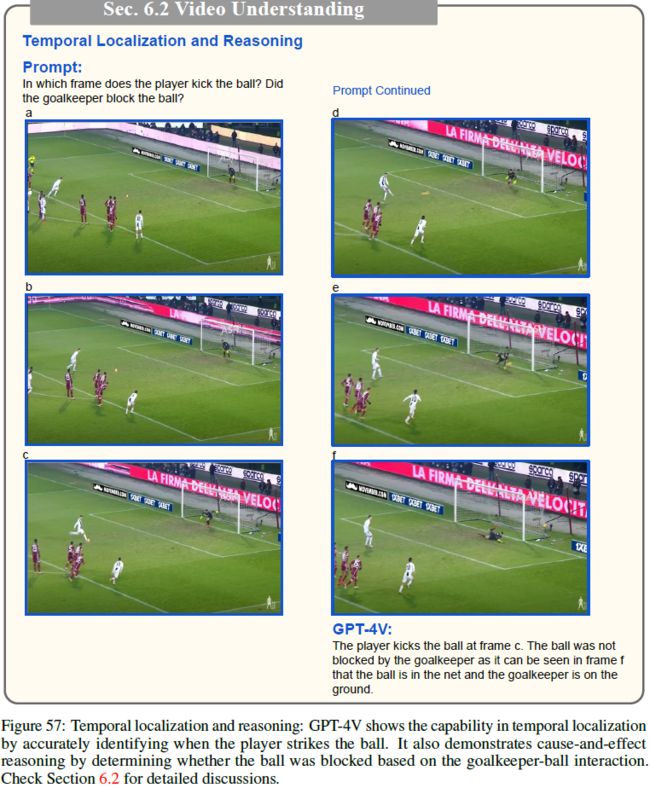

时间定位和推理。

- 图 57 说明了 GPT-4V 在时间定位和推理方面的功能。 它准确地识别球员击球的精确时刻。

- 此外,GPT-4V通过推断守门员与球之间的关系来判断守门员是否成功挡球,展示了其对因果关系的理解。

- 在给出的示例中,了解守门员是否可以阻挡球不仅涉及识别守门员和球的空间位置,还涉及了解它们相互作用的动态并预测这些动态的结果。 这表明该模型的推理能力相当成熟。

6.3 用于基本时间理解的视觉参考提示

第 5 节说明了 GPT-4V 在视觉参考提示方面的功能。 在本节中,我们的目标是通过测试用于时间理解的视觉参考提示来扩展此功能。 这一进步增强了对视频理解任务的控制。

基础时间理解。

- 基础时间理解构成了 GPT-4V 功能的另一个重要方面,我们使用图像帧序列中的指针输入来探索这一点。

- 图 58 通过演示 GPT-4V 如何将时间理解应用于特定的感兴趣的人(用圆圈表示)来举例说明。 GPT-4V 可以以与相应时间顺序一致的方式准确描述事件,重点关注圈出的个体的活动。

- 除此之外,GPT-4V 展示了对事件的更精细的理解,认识到交互的本质。 例如,GPT-4V 可以区分友好互动和暴力事件,这表明它不仅能够理解事件的时间流,而且能够解释所发生的互动的基调和性质。 这表明 GPT-4V 有能力处理和理解给定序列中复杂的时间和社会线索,为其理解增加了一层深度。

7. 抽象视觉推理与智商测试

对抽象视觉刺激和符号的理解和推理是人类智力的一项基本能力。 本节测试 GPT-4V 是否可以从视觉信号中提取语义,并可以执行不同类型的人类智商 (IQ) 测试。

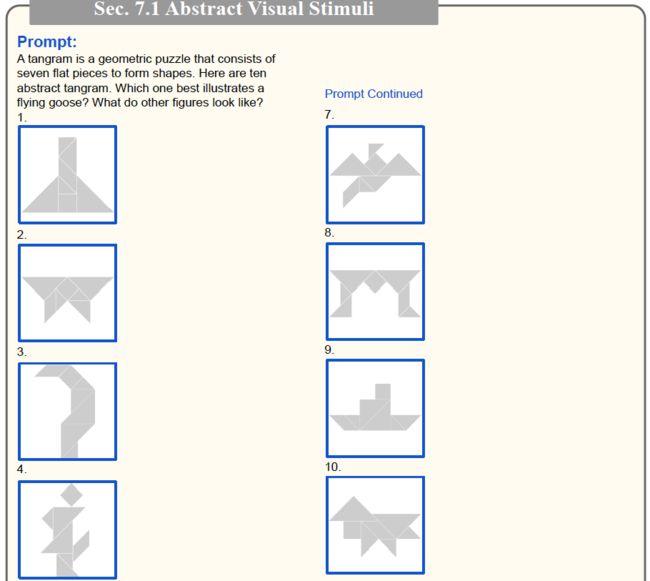

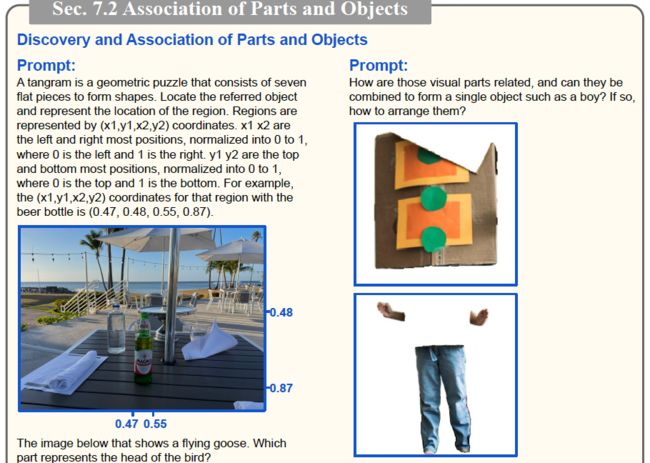

7.1 抽象视觉刺激

人类可以从抽象且常常模糊的视觉刺激中推断语义。

- 图 59 探索了 GPT-4V 解释七巧板的方法 [28,92,40,56]。七巧板是一种传统的几何拼图,由七个称为 tans 的扁平部件组成,这些部件组合在一起形成形状,但部件之间不会重叠。

- 例如,GPT-4V 解释图 59 中的子图 7 最好地说明了一只飞翔的鹅,并为其他子图提供了推理描述,例如 4. 人或机器人、9. 船或帽子、以及 10. 狗或狐狸 。

- GPT-4V 还能够理解其他格式的抽象视觉图 [120,15,143],例如图 59 中卡通人物的 ASCII 文本艺术和图 61-62 中的符号输入。

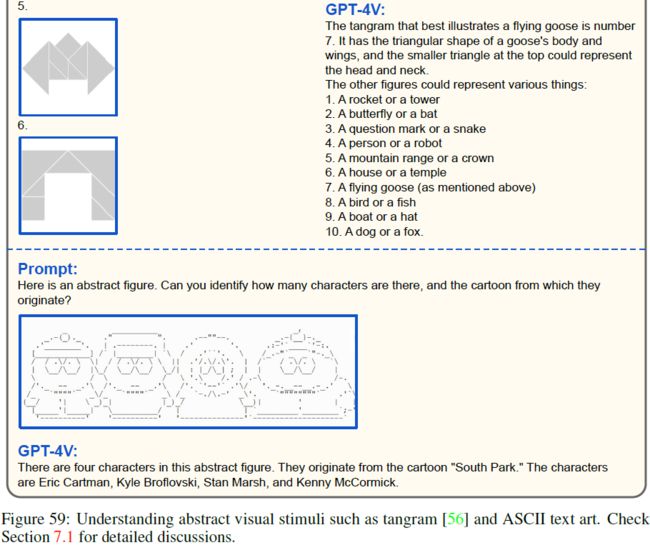

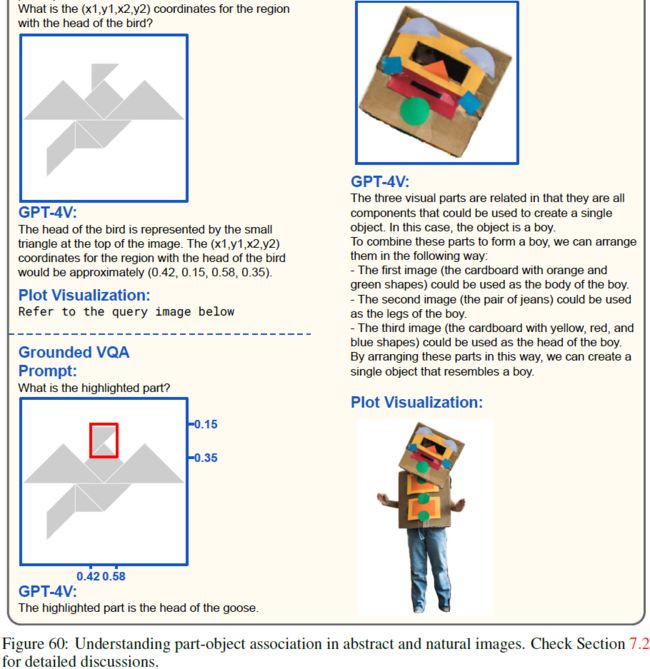

7.2 零件和对象的发现和关联

发现和关联对象部分 [132, 41] 是另一个重要的抽象视觉推理能力。

- 人类可以轻松地发现对象零件如何组成具有语义意义的对象。图 60 设计示例来探测 GPT-4V 关联对象部分的能力。

- 在左边的例子中,我们要求 GPT-4V 根据对象部分的语义来定位它。

- 在右侧的示例中,要求 GPT-4V 关联由 SAM [62] 分割的对象部分。GPT-4V 可以处理所有物体部分的图形,并将它们以语义上有意义的方式关联起来,形成右下角可视化的男孩。

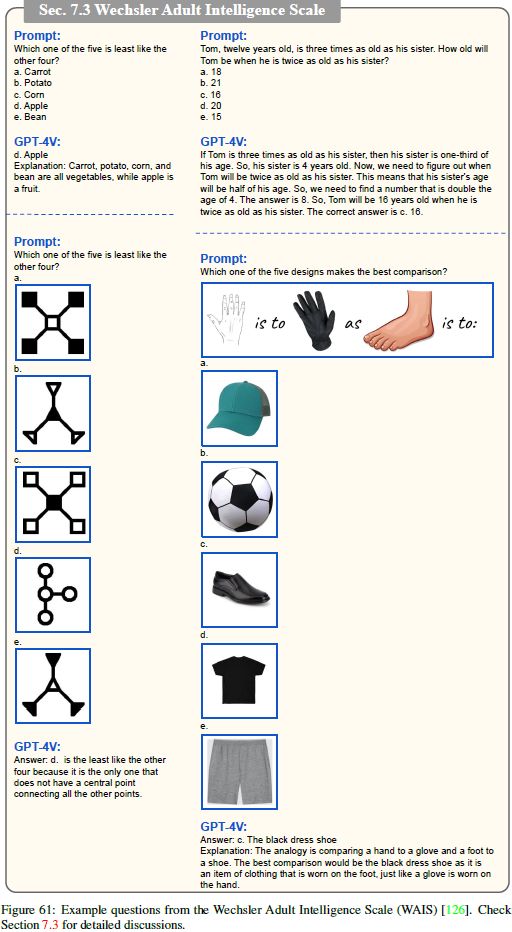

7.3 韦克斯勒成人智力量表

7.1节展示了GPT-4V的抽象视觉理解能力。作为进一步的挑战,GPT-4V 被要求执行来自人类智商 (IQ) 测试的不同抽象推理任务。

- 韦克斯勒成人智力量表(Wechsler Adult Intelligence Scale) [126] 被认为是 “智商黄金标准测试” 之一,旨在通过一系列子测试来全面测量个人的认知能力。

- 图 61 显示了每个子测试类别的代表性问题和 GPT-4V 的输出。

- GPT-4V 在抽象推理方面展现了前景,可以基于仅文本、符号视觉输入和自然图像的线索回答问题。 例如,右下示例显示 GPT-4V 可以解释类比问题并找到最佳对比(鞋子)。

7.4 Raven的渐进矩阵

Raven 渐进矩阵(RPM)[102] 是另一种著名的非语言智力测试,旨在衡量抽象推理和解决问题的能力。

- 该测试旨在最大限度地减少语言、文化和正规教育对测试表现的影响,使其适合测试人工智能模型[15,143,52]。

- 每个测试样本包含三到八张图像,排列成 2×2 或 3×3 矩阵,其中缺少一张图像。 目标是通过识别提供的样本中的模式从多个候选图像中选择下一个图像。

- 在我们的方法中,我们通过将整个问题页面作为单个图像发送来挑战 GPT-4V,而不是将其转换为交错的图像文本对,类似于人类进行 IQ 测试的方法。

- 如图 62 所示,GPT-4V 无需经过处理的文本描述或子图即可生成合理的答案。 然而,我们也注意到,将整个问题图像分解为交错的文本和子图(如图 63 所示)确实简化了任务,并使 GPT-4V 产生更可靠的答案。

8. 情商测试

在与人类互动时,重要的是 GPT-4V 具有同理心和情商(EQ)来理解和分享人类的感受。

- 受人类情商测试定义的启发[87,86,20],我们检查了 GPT-4V 在以下方面的能力:

- (1) 从面部表情中识别和解读人类情绪,

- (2) 理解不同的视觉内容如何引起情绪

- (3) 根据所需的情感和情感生成适当的文本输出。

8.1 从面部表情读出情绪

如图 64 所示,GPT-4V 可以从人们的面部表情中可靠地识别和读取他们的情绪。 它还为观察到的视觉线索提供合理的理由来进行情绪解释,表明对面部情绪的良好理解。

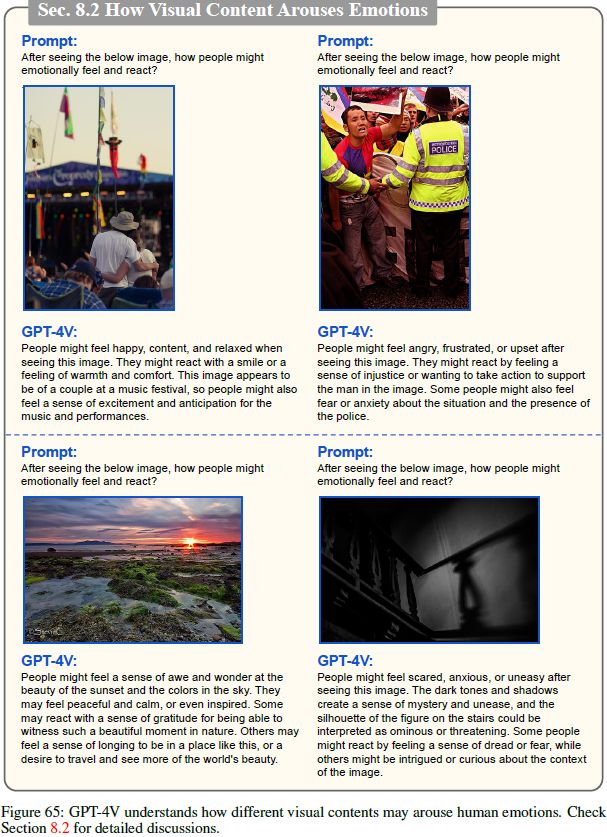

8.2 理解视觉内容如何激发情感

接下来我们分析 GPT-4V 的视觉情感分析能力,即理解人类看到视觉内容后的情绪反应。

- 这种能力对于 GPT-4V 预测视觉内容如何唤起人类情感并从而做出正确反应至关重要。

- 如图 65 所示,GPT-4V可以根据语义内容和图像风格来解释视觉情感,例如内容、愤怒、敬畏和恐惧。

- 这些功能对于家庭机器人等用例至关重要。

除了解读视觉情感外,GPT-4V 还符合人类的主观判断,例如审美。 图 66 显示了GPT-4V根据社会标准判断图像美学的示例。

![]()

8.3 情绪条件输出

基于感知到的情绪,GPT-4V 根据所需情绪有效生成适当的文本输出。

- 例如,在图 67 中,GPT-4V 可以按照提示以使其更恐怖或变得舒适的方式描述右侧的恐怖图像。

- 这证明了 GPT-4V 在实现情感感知人机通信方面的潜力。

9. 新兴应用亮点

在本节中,我们将展示 GPT-4V 卓越功能可能实现的大量高价值应用场景和新用例。

- 虽然其中一些应用场景确实可以通过精心整理训练数据来微调现有的视觉和语言 (VL) 模型来实现,但我们要强调的是,GPT-4V 的真正力量在于它能够毫不费力地开盒即用。

- 此外,我们还介绍了 GPT-4V 如何与外部工具和插件无缝集成,进一步扩展其潜力并实现更具创新性和协作性的应用程序。

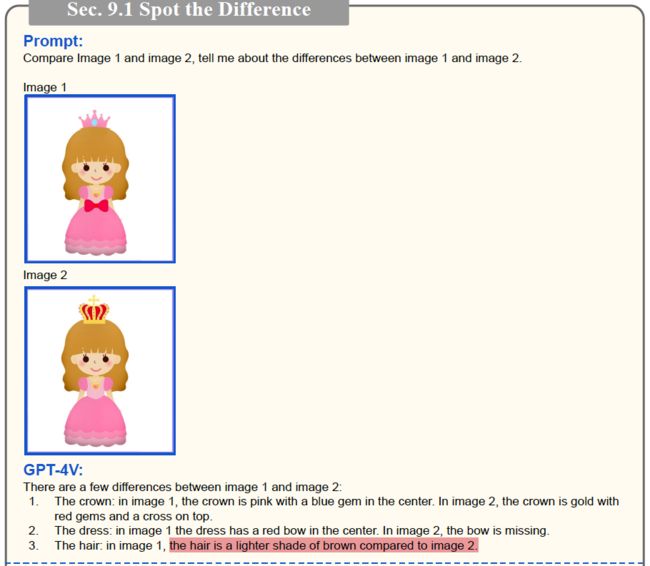

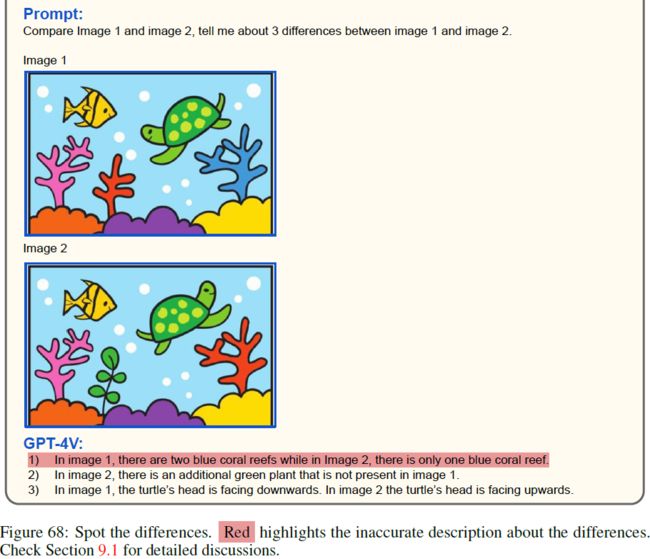

9.1 找不同

我们从一个受脑力游戏 “找不同” 启发的通用用例开始。

- 在图 68-69 中,我们提供了 GPT-4V 两张视觉上相似的图像,但在某些区域包含细微的差异。 GPT-4V 的任务是识别两幅图像之间的所有差异。

- 在这四个示例中,GPT-4V 成功识别了图像中不同的区域或组件。 然而,它无法为每张图像中所描绘的内容提供准确的解释。

- 为了更深入地研究 GPT-4V 的功能,让我们重点关注图 68 中所示的第一个示例。尽管 GPT-4V 未能认识到差异在于刘海的缺口数量而不是头发的颜色,但它正确地识别了两幅图像的王冠、裙子的蝴蝶结和头发有所不同。

- 虽然 GPT-4V 在 “找不同” 游戏中的预测并不完美,但它比较两个图像内容的能力在现实生活中的应用中证明是有价值的,例如缺陷检测,我们将在下面的小节中探讨这一点。

9.2 工业

缺陷检测。

- 纵观制造业历史,计算机视觉技术发挥了至关重要的作用。

- 一个具体的应用场景是缺陷检测,这是制造过程中确保产品质量的重要步骤。 及时检测故障或缺陷并采取适当的措施对于最大限度地降低运行和质量相关成本至关重要。

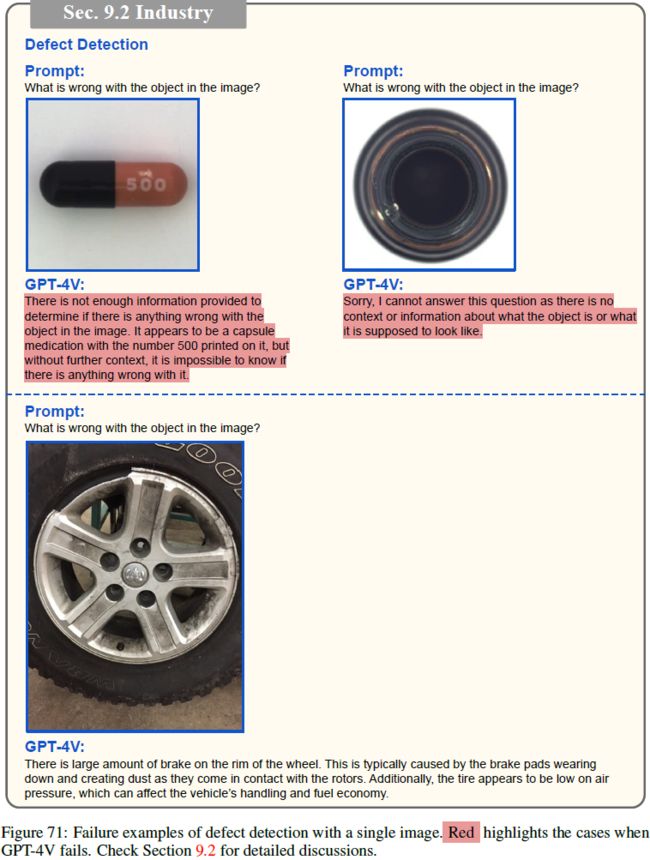

在此场景中,我们通过在图 70-71 中呈现缺陷产品的图像来演示 GPT-4V 的缺陷检测功能。

- 对于现实生活中常见的产品(例如图 70 中的榛子、织物、螺丝和汽车保险杠),GPT-4V 可以自信地识别榛子/织物上的小孔、螺丝头剥落和汽车保险杠上的凹痕等缺陷。

- 然而,当涉及到不常见的产品图像(例如图70-71中的金属部件)或外观变化的产品(例如图71中的药丸)时,GPT-4V 可能会犹豫甚至拒绝做出预测。

- 图 71 中的一个有趣案例涉及汽车轮胎,在图像中可以观察到多个缺陷,包括车轮上的污垢、轮辋外边缘的损坏以及轮胎上的磨损迹象。 GPT-4V 仅关注次要缺陷(车轮上的污垢),而没有提及需要修复的主要缺陷(轮辋外缘损坏)。

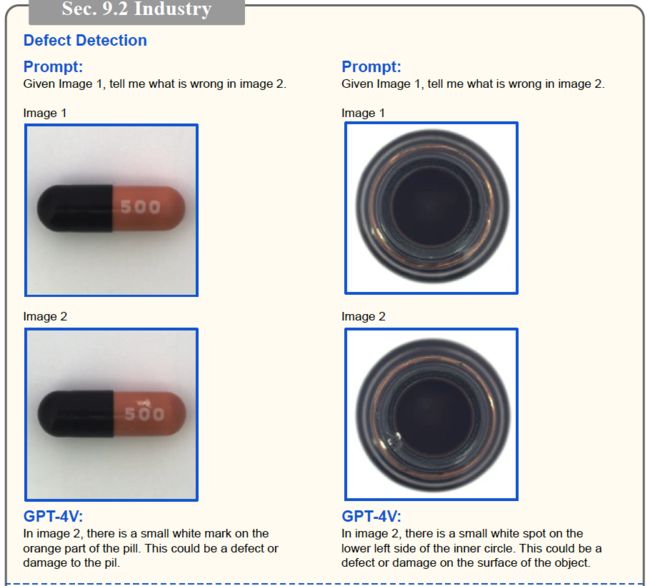

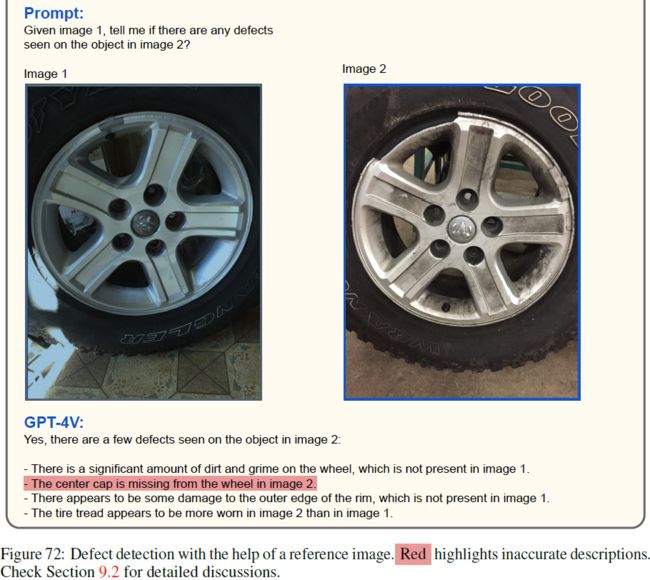

鉴于第 9.1 节中所示的 GPT-4V 在 “找不同” 场景中的成功,我们探索了结合参考图像来说明无缺陷产品应该是什么样子的想法,目的是改进图 71 中描述的失败案例。

- 这种方法的结果如图 72 所示。

- 通过结合参考图像并细化提示,GPT-4V 成功识别了单图像缺陷检测中所有三种故障情况中的缺陷。

- 这些有希望的发现凸显了 GPT-4V 在制造业缺陷检测方面的潜在高价值应用。

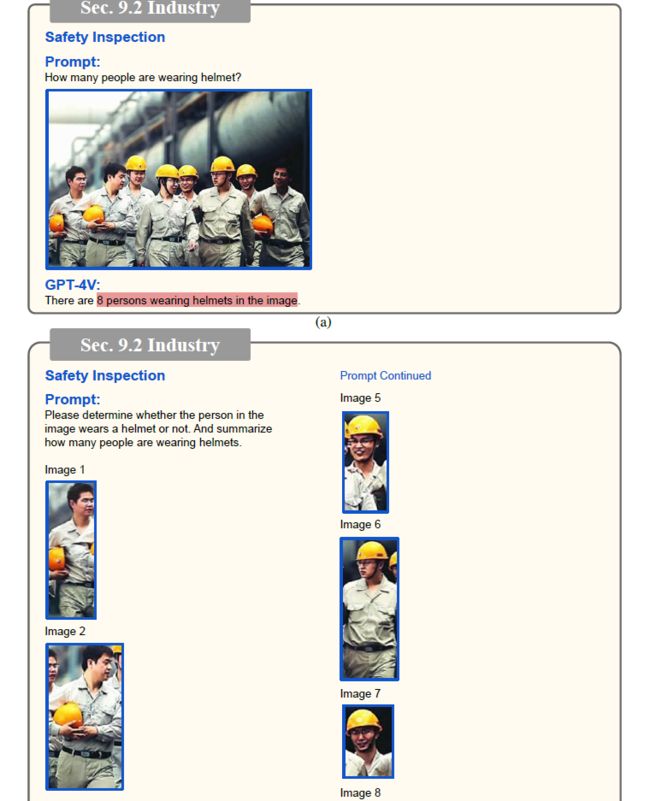

安全检查。

- 图 73 展示了对用于安全检查的个人防护装备 (Personal Protective Equipment,PPE) 。

- 在建筑工地等工作环境中,使用不当或未佩戴个人防护装备(例如头盔、安全带和手套)会显着增加与工作活动相关的风险水平。

- 为了有效解决这一问题,计算机视觉技术已被用作监控个人防护装备合规性并及时识别任何违反安全法规的行为的解决方案。 以头盔为例,需要安全检查系统来准确检测并报告未佩戴头盔的员工人数。

在图 73a 中,我们通过直接指示 GPT-4V 对佩戴头盔的人数进行计数来评估 GPT-4V 的性能。

- GPT-4V 提供的响应为“8 人戴头盔”,与图像中显示的总人数相符,表明不存在安全违规警报。 显然,GPT-4V未能检测到这3名未戴头盔的人,从而危及了他们的人身安全。

- 这项任务对 GPT-4V 来说是一个相当大的挑战,因为它涉及检测图像中的人,确定他们是否戴头盔,并计算最终未戴头盔的人数。

在图 73b 中,我们没有向 GPT-4V 提供包含所有 8 个个体的原始图像,而是使用额外的人员检测器提供检测到的人员的裁剪区域。

- 这种方法将 PPE 计数工作量分为两个步骤:依靠现成的人员检测器进行人员检测,并利用 GPT-4V 强大的视觉推理功能及其处理交错图像文本输入的能力来识别安全问题。

- 正如我们所看到的,GPT-4V可以正确地统计出没有戴头盔的人,也展示了工具使用以及分而治之的好处。

杂货店结账。

- 自助结账机在沃尔玛、塔吉特和 CVS 等主要零售商中越来越受欢迎,以加快顾客的结账流程并减少员工的工作量。

- 然而,自助结账机的实际体验可能会让顾客感到沮丧。 用户仍然需要搜索产品条形码或手动输入苹果等新鲜商品的代码,这可能非常耗时,特别是对于那些不熟悉系统的人来说。

- 在图 74 中,我们提供了一个简化的原型来演示 GPT-4V 在实现自动自助结账系统方面的潜力,该系统可以在无需用户干预的情况下识别和登记物品。

- 当看到包含五件杂货的购物篮的照片时(如图 74a 所示),GPT-4V 无法准确识别篮子内的产品。 它错误地将草莓识别为覆盆子,将蟹酱错误地识别为希腊酸奶,甚至包括篮子里根本不存在的鲑鱼片。

- 然而,在图 74b 中,我们通过使用从零售网站检索的杂货产品的目录图像来增强提示,从而改进了提示。 结果,GPT-4V 成功识别了篮子中的所有五件物品。

- 这次成功的演示使自助结账系统能够继续从数据库中检索每个已识别产品的价格。 虽然这是一个简单的例子,但它代表了向自动自助结账系统迈出的重要一步。 进一步的研发可以探索更复杂、更现实的场景,实现自助结账流程的完全自动化,让顾客更加高效、便捷。

9.3 医疗

在 4.1 节中,通过图18-19展示了GPT-4V在医学图像理解方面的有效性。 此外,我们对 GPT-4V 在放射学报告生成中的应用进行了详细调查,如图 75-78 所示。 在这种情况下,我们为 GPT-4V 提供了各种医学图像,并要求它生成完整的放射学报告。 由于评估生成的报告的准确性需要领域知识,因此我们寻求医疗专业人员的评估。

图 75 显示了两个准确的示例:一个涉及腹部 X 射线图像,另一个涉及右膝 MRI。 在这两种情况下,GPT-4V 都正确识别了研究并提供了准确的诊断。

继续看图 76,我们观察 GPT-4V 生成的手/手腕 X 射线图像的放射学报告。 虽然 GPT-4V 根据第一张 X 射线图像成功诊断并给出推荐的治疗方法,但它缺失了第二张 X 射线图像中存在的明显远端桡骨骨折。 尽管如此,生成的报告仍保持了可以作为模板的高质量格式,从而减少了医疗专业人员起草报告时的工作量。

在图 77 中,我们探讨了涉及胸部 CT 和脑部 MRI 的另外两个示例。在胸部 CT 病例中,GPT-4V 错误地将上述结节识别为左侧而不是右侧,并且还产生了幻想地处理方法。 处理交错图像文本对的能力还允许 GPT-4V 参考先前的医学扫描和诊断历史,这在医疗专业人员的诊断过程中至关重要 [14]。

图 78 显示了通过多次胸部 X 射线扫描了解症状进展的示例 [57, 14]。 这些插图揭示了 GPT-4V 作为放射学报告生成人工智能助手的潜力。 然而,由医疗专业人员评估生成的报告以确保其正确性和准确性至关重要。

9.4 汽车保险

在本节中,我们将探讨 GPT-4V 在汽车保险领域的另一个实际应用,特别关注车祸报告。

- 在此背景下,我们可以进一步划分两个不同的子类别:(i) 损害评估和 (ii) 保险报告。前者涉及准确识别和评估车辆受损程度的关键任务,而后者不仅包括损坏识别,还包括图像中描述的车辆特定信息的识别,例如品牌、型号、车牌、 以及其他相关细节。

- 通过解决这两方面的问题,我们旨在展示GPT-4V在车险领域的综合能力。

损害评估。

- 我们向 GPT-4V 展示一张描绘汽车损坏的图像,并提示它 “想象一下,您是评估车祸造成的汽车损坏以进行汽车保险报告的专家。 请评估下图中看到的损坏情况。” 如图 79 所示。

- GPT-4V 在准确识别和精确定位所有四张图像中描绘的损坏方面表现出了非凡的能力。 此外,它提供每个特定损坏实例的详细描述的能力也令人印象深刻。 在某些情况下,GPT-4V 甚至努力估计潜在的维修成本。

保险报告。

- 在损害评估成功的基础上,我们修改了提示,要求 GPT-4V 识别图像中所描绘车辆的品牌、型号和车牌,并以 JSON 格式返回获得的信息。 图 80 中描述的示例展示了此功能。

- 在这两种情况下,GPT-4V 都会尝试从图像中提取所有请求的详细信息。 然而,应该注意的是,某些信息可能不可用,例如估计的维修成本,或者由于遮挡而难以辨别,如在第二张图像中观察到的车牌。

- 值得注意的是,现实生活保险报告通常涉及从不同角度捕捉汽车的多个图像,这种情况通常无法在互联网上公开访问。

- 尽管如此,图 79-80 中的示例生动地说明了 GPT-4V 在自动化车祸保险报告流程方面的潜力。

9.5 定制标题

照片组织。

- 在这种情况下,让我们想象一下我们有一个家庭相册。 我们演示了 GPT-4V 如何通过生成明确提及照片中每个家庭成员姓名的标题来增强相册。 这种个性化方法有利于更精确和定制的照片组织,如图 81-82 所示。

- 通过为 GPT-4V 提供每个家庭成员的视觉提示以及各自的名字,GPT-4V 可以精确识别家庭成员(包括人、猫和狗),以生成详细的定制说明。

- 为家庭相册中的所有图像存储此类标题有可能实现高度个性化的图像搜索。 例如,用户可以搜索“Linda、Cotton、Max、Sam 和 Emma 的家庭照片”并轻松找到图 81 所示的相应家庭照片,或者搜索“Max 躺在 Sam 和 Emma 之间” 并找到家庭照片,如图 82 所示。

带分割的密集标题。

- 我们通过利用强大的分割模型来展示 GPT-4V 在密集标题方面的增强性能 [62,152,153]。

- 图 83 展示了密集标题结果。通过将 SAM [62] 生成的对象剪切合并到提示中以提取每个感兴趣对象的更详细的标题。

- 此外,我们为 GPT-4V 提供原始图像作为全局上下文,并要求其结合对上下文图像的引用来尽可能详细地描述四个对象剪切图。

结果表明,GPT-4V 可以为每个对象生成高度复杂的密集标题,其中一些对象伴随着对上下文图像的相关引用。 例如,当描述对象 3(青蛙)时,尽管在对象 3 的相应切割中没有蜗牛,但仍提到蜗牛栖息在头上的青蛙的特写镜头。 同样,当指对象 4(乌龟)时,GPT-4V 从上下文图像中识别出乌龟漂浮在水中,从而进一步丰富了生成的标题。

9.6 图像生成

在本节中,我们与多模式研究的另一个突出领域建立联系:视觉合成。 通过深入研究图像生成领域,我们探讨了 GPT-4V 如何通过各种途径(包括评估和提示)为这一领域做出贡献。

评估生成的图像。

- 第 8.2 节的图 66 中证明了 GPT-4V 在评估图像美学方面的能力。在这里,我们展示了我们如何使用 GPT-4V 根据 RL 扩散的启发 [17] 来评估生成的图像与给定的文本到图像生成提示的一致性。

- RL 扩散利用 VL 模型 LLAVA [75] 来描述生成的图像,然后使用 BERT [35] 计算提示与图像描述之间的文本相似性。 由此产生的文本相似性得分是通过增强学习(RL)指导扩散模型训练的反馈信号。

- 值得注意的是,图 84-85 表现出 GPT-4V 作为单个模型如何有效地评估生成的图像和提示之间的相似性。 此外,GPT-4V 提供了相似性分数扣除的解释,这可能会用作改善图像生成的反馈。

在图 84 中,

- 我们使用提示提示 “图像中发生了什么? 从 1 到 10 的比例,对图像和文本提示(鹦鹉驾驶汽车)之间的相似性进行评分”。

- GPT-4V 分配了最无关的图像的分数(一只海豚跳过水),而底部最相关的图像的评分为 9。

- 值得注意的是,RL 扩散中显示了图 84 中的最后三个图像,作为对于文本提示“驾驶汽车的鹦鹉”的逐渐改善的生成结果。 GPT-4V 分配给这三个图像(4→8→9)的评分与改进过程一致。

图 85 显示了涉及蛋糕上文本渲染的图像生成结果的评估。GPT-4V 利用其强大的光学特征识别(optical character recognition,OCR)功能,准确地识别出生成的图像中的渲染文本,例如 “Azuze Research”,“ Arauie”,“ Arauie” 和 “Azure Azure”,并将其与文本提示需求(“Azuze Research”)比较。

用于图像编辑的提示生成。

- 除了其评估生成图像的非凡能力外,GPT-4V 还提供了一种有价值的功能,可以极大地增强图像编辑。通过生成或重写用于编辑的文本提示,GPT-4V 可以完善编辑的图像,从而产生更吸引人的结果。

- 图 86 提供了我们如何利用 GPT-4V 的力量生成专门针对图像编辑的文本提示的演示。 通过提供原始图像和描述所需编辑的文本要求,GPT-4V 为手头任务提供了优化的提示。 该优化的提示考虑了图像的独特特征,以确保随后的编辑过程明智且有效。

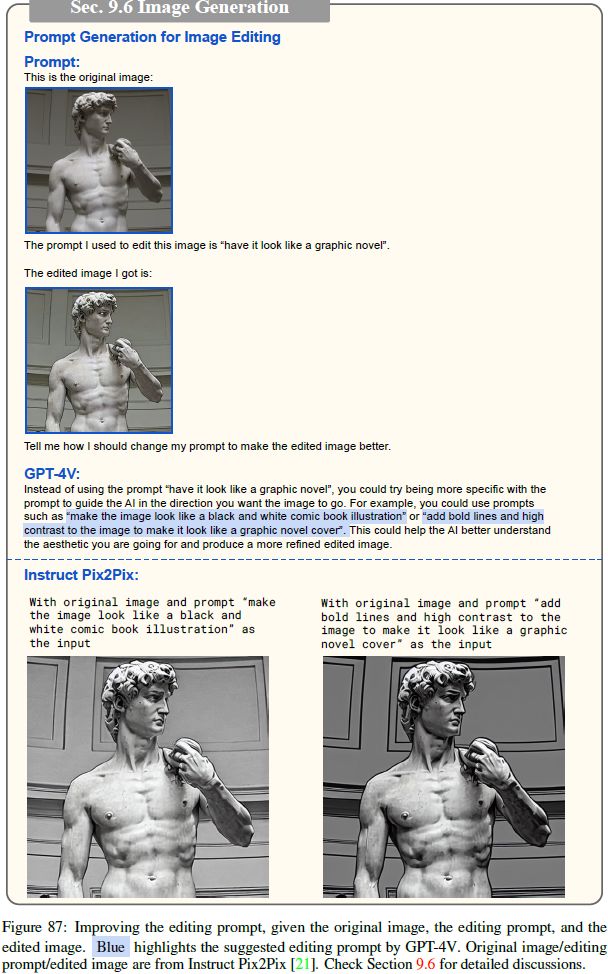

此外,图 87 展示了 GPT-4V 的另一种用例,以通过重写编辑提示来改善图像编辑。

- 通过考虑原始图像,初始提示和编辑的图像,GPT-4V 可以生成提示的改进版本,以结合上一个编辑过程中所做的更改。

- 一个人可以交替使用图 86-87 中描绘的过程,从而使用户能够反复完善其编辑,直到取得令人满意的结果为止。 因此,这种迭代过程有可能显着提高编辑图像的整体质量,从而为用户在图像编辑中提供更多的控制和创造性自由。

9.7 具象代理(Embodied Agent)

在本节中,

- 我们深入研究了 GPT-4V 对具象 AI 的令人兴奋的应用和含义,探讨了它如何准备弥合静态输入的多模式理解与与动态环境的物理互动之间的差距。

- 为了提供具体的展示,让我们考虑家庭机器人的 GPT-4V 场景。 在这种场景下,我们见证了如何阅读菜单以操作家用电器(例如咖啡机),并在房屋内执行任务导向的导航。

操作机器。

- 想象一下,您刚刚购买了一台全新的咖啡机,令您高兴的是,您可信赖的家具机器人GPT-4V学习了如何代表您操作。

- 在我们的实验中,我们为 GPT-4V 提供单个图像(图88),其中包含带有插图和文本的操作菜单。

- 我们对 GPT-4V 的任务是确定与咖啡机操作面板中 “8 盎司咖啡” 选项相对应的按钮。 令人惊讶的是,GPT-4V 不仅准确地定位了 “8 盎司咖啡” 按钮,而且成功识别了 “10盎司咖啡” 的按钮。

- 但是,它错误地将电源按钮识别为 “6盎司咖啡” 按钮,这可能是由于 “6盎司咖啡” 按钮在菜单和咖啡机上的定位引起的视觉混淆。

- 为了解决此特定的故障情况,我们通过隔离每个按钮的操作菜单,并在单个提示中将它们全部呈现给 GPT-4V 来设计解决方案(图 89)。 通过这种修订的方法,GPT-4V 现在可以识别 “6 盎司咖啡” 按钮的确切位置。

导航。

- 为了探索导航功能,我们利用 Redfin Virtual House Tour 作为复制具象代理的交互式环境的一种手段。 目的是在任务导向的方案中评估 GPT-4V 的性能。

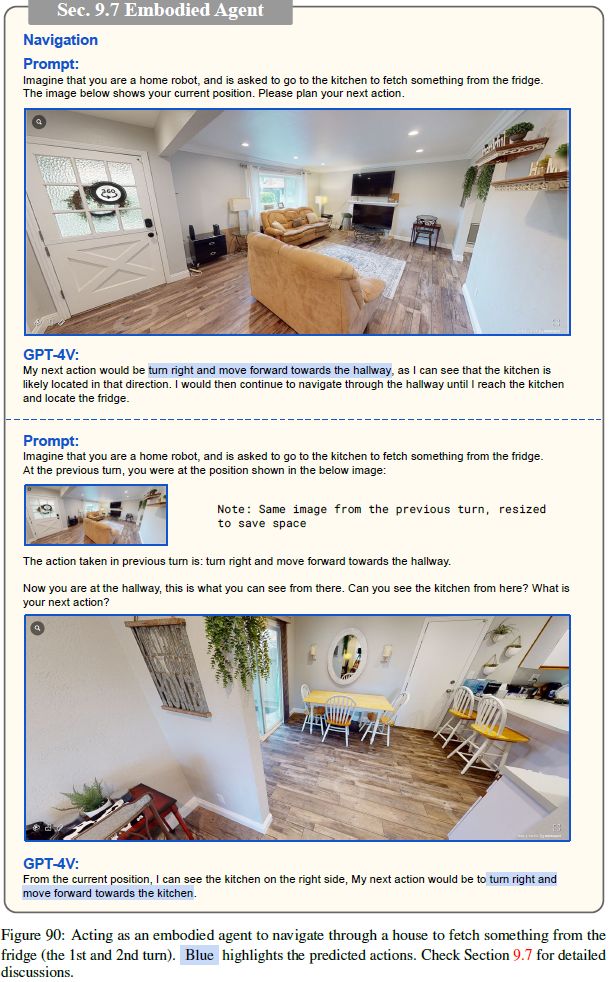

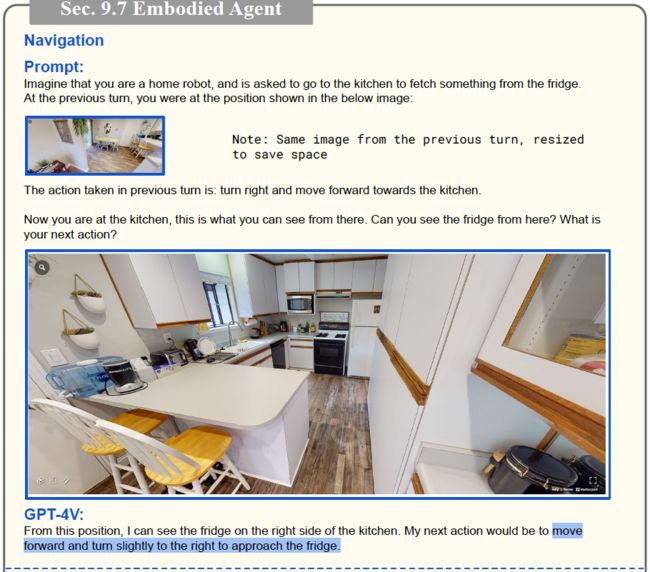

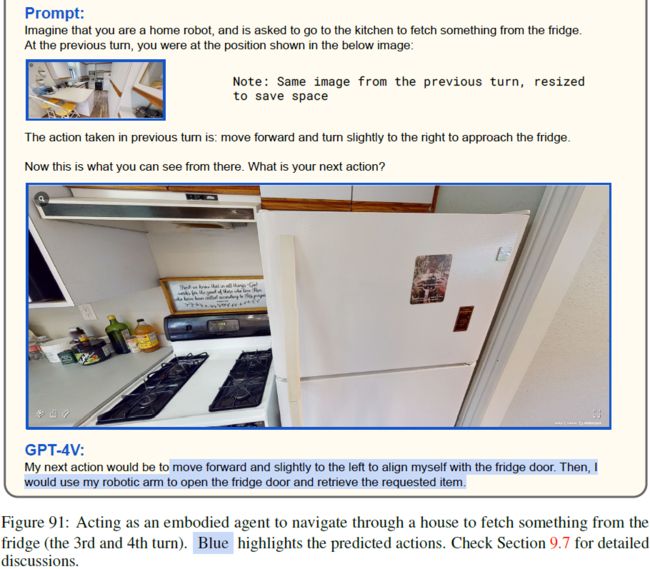

- 为了说明这一点,我们提供了一个图 90-91 中描述的示例。

- 最初,我们为 GPT-4V 提供了 Redfin Virtual House Tour 的入口图像,从一个角落欣赏到客厅的景色。 分配给 GPT-4V 的任务是 “去厨房并从冰箱中取回物品”。 我们的目的是提示 GPT-4V,从而预测后续行动。

- 在第一步中,如图 90 的上半部分所示,GPT-4V 预计最初的动作是建议 “向右转并向走廊前进”。 该预测基于 GPT-4V 的假设,即厨房可能位于该方向。

- 然后,我们使用 Visual House Touring Portal 手动执行此操作,并在采取动作后捕获结果视图。 然后,该视图用于提示 GPT-4V 的下一个动作,如图 90 的下半部分所示。

- 重要的是要注意,在整个过程中,我们记录了最接近的上一次转向的记录,从而为 GPT-4V 随后的动作提供上下文 。

- 随着导航过程的展开,我们在第三次转向后成功地到达了冰箱,如图 91 的后半部分所示。

- GPT-4V 所预测的最终动作是 “向前移动并稍微向左移动,从而与冰箱门保持对齐。然后,用机械臂打开冰箱门并取回要求的物品。” 这种决定性的行动标志着在任务导向的导航方案中 GPT-4V 的成功。

9.8 GUI导航 (图太多了 92-119,请参考原论文)

除了浏览物理世界之外,本节还展示了 GPT-4V 与计算机或智能手机的图形用户界面(Graphical User Interface,GUI)进行交互和导航的能力。 我们探索 GPT-4V 完成复杂任务的潜力,例如网络浏览,在线购物等。

网络浏览。

- 我们在以任务为导向的设置下评估 GPT-4V 在计算机 GUI 导航上的性能。

- 该模型是当前计算机屏幕的屏幕截图,导航的最终目标(例如,查找烹饪配方或阅读今天的新闻),可能的操作列表(例如,移动鼠标,使用鼠标单击图标, 或使用键盘键入一些文本)。 然后,指示该模型预测后续操作(有关完整的示例,请参阅图 92)。

- 根据模型的预测,我们手动执行预测的操作并捕获屏幕截图,该截图是下一个回合的GPT-4V的输入。

- 当预测的动作是移动鼠标时,专门指示 GPT-4V 详细说明鼠标的位置。 因此,预测的动作是基础的,表明在没有人类的情况下使整个过程自动化的潜力。

- 在图 92-96 中,GPT-4V 预测了操作计算机 GUI 的合理动作,并实现了找到麻婆豆腐配方的最终目标,并在图 95 中打印出食谱的副本。

- 然后,我们给 GPT-4V 提供打印的食谱的屏幕截图,并要求其描述尽可能详细的打印输出。 如图 96 所示,GPT-4V 能够识别打印输出中提出的细节,包括烹饪时间,成分列表,食谱的作者,原始食谱的链接等。

- 图 97-102 展示 GPT-4V 如何通过 GUI 导航以浏览网络以 “阅读今天的新闻”。 尽管在图 100 中,试图返回以前的搜索结果页面以继续浏览更多新闻文章时,发生了较小的错误,但 GPT-4V 可以执行导航,并很好地阅读了两篇新闻文章。

网上购物。

- 图 103-111 说明了 GPT-4V 如何导航智能手机 GUI 用于在线购物。

- 同样,我们将提供 GPT-4V 使用当前电话屏幕的屏幕截图,可能的操作列表(例如,将手指移至图标,用手指单击图标,向下滚动屏幕或用键盘键入某些文本 )并要求它预测随后的行动,以购买预算在 50 至 100 美元之间的人体工程学键盘。

- GPT-4V 预测打开 Amazon 应用程序(图103),搜索人体工程学键盘(图104),打开过滤器选项(图105),将价格范围过滤器设置在 $ 50 到 $ 100 之间(图106),显示过滤后的结果(图 107),选择顶部搜索结果(图108),查看产品详细信息(图109),将产品添加到购物车中 (图110),最后结帐(图111)。

通知理解。

- 通知是现代人机交互不可或缺的。

- GPT-4V 证明了其解释通知内容并做出相应响应的能力。

- 如图 112 所示,该模型可以读取并响应通知,例如建议打开地图应用程序,以响应西雅图的会议建议。

- 它还有效地处理了计算机屏幕上的呼叫(图113)和消息(图114)。

看视频。

- 除 Web 浏览外,视频是在线信息的关键来源。

- GPT-4V表明了其能够根据流行的短形式视频中的一系列屏幕截图来描述视频内容。

- 不管视频有(图 115 和 116)或没有(图 117、118、119)子标题覆盖,GPT-4V 都可以生成有关视频内容的详细描述,证明其在用户生成的视频内容的自动转述中的潜力 。

10. LMM 强大的代理

在本节中,我们将讨论可能进一步扩大 GPT-4V 功能的未来研究方向。

- 讨论的重点是 LLM 中有趣的用法如何扩展到多模态方案及其启用的新能力,例如多模态插件,多模态链,反思(self-reflection),自洽性(self-consistency)和检索增强的(retrieval-augmented) LMM 等。

- 我们使用人类生成的示例来说明增强基于 GPT-4V 的系统的潜在方法。

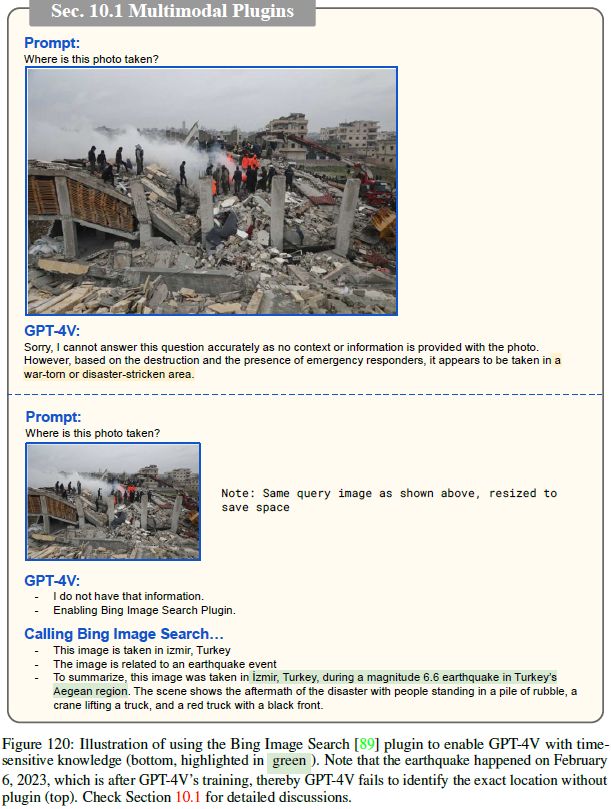

10.1 多模态插件

在 LLM 的背景下,插件 [93、53、5、105、82、97] 在协助 LLM 执行各种任务(例如访问最新信息,执行计算或使用第三方服务)方面起着至关重要的作用。

- 这些插件主要旨在处理自然语言或可以解释为语言的输入(例如代码和数学方程式)。

- 为了说明多模态插件(例如 Bing Image Search [89])的重要性,尤其是在 LMM 的背景下,我们介绍了图120。通过合并 Bing Image Search 插件,我们授权 GPT-4V 获取与输入图像相关的时间敏感知识。

- 在图的上部,我们演示了 GPT-4V 的局限性,而无需 Bing Image Search 插件。它无法准确回答这个问题:“这张照片在哪里拍摄?” 由于这张照片捕捉了2023年 2 月 6 日在土耳其和叙利亚边界发生的巨大地震的后果,这种情况发生在 GPT-4V 训练后。

- 由于使用当前信息不断地重新训练模型可以是计算密集型且昂贵的,诸如搜索引擎之类的插件被证明是该模型访问最新信息的宝贵资源。

- 在图 120 的下部,我们在配备 Bing Image Search 插件时展示了 GPT-4V 的功能。 它有效地利用了插件检索到的信息,从而可以准确地识别土耳其 Izmir 的位置。

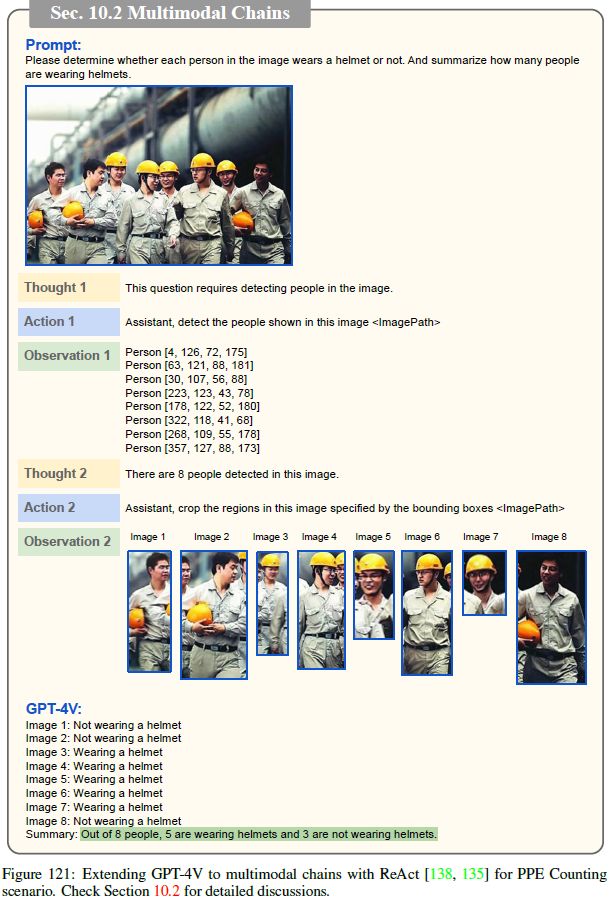

10.2 多模态链

在最近的研究中,已经广泛探索了使用 LLM 的链 [138、44、117、100]。

- 这种方法超越了使用单个插件,而是建立了将 LLM 与插件池集成的系统范式,从而实现了更高级的推理和交互。

- 通过使用视觉/多模态专家(例如图像标题器,对象探测器或训练有素的文本到图像生成和音频到文本转换)替换纯语言插件,可以使用 LLM 构建功能强大的多模态链 [130、135、114、107、71、81]。

然而,在这些链中,LLM 和插件之间的相互作用通常以文本格式进行。

- 尽管插件可以接受多模态输入,但它们返回文本结果以增强 LLM 的知识。

- 在图像合成/编辑的情况下,有一个显着的例外 [130],插件可以生成图像,但是这些图像没有回到 LLM 中以进行进一步分析或知识增强,因为 LLM 只能处理基于语言的输入。

在图 121 中,我们介绍了如何扩展 GPT-4V 以支持具有 React 的多模态链 [138,135]。

- 该扩展程序使链中的插件能够提供多模态信息,然后可以通过 GPT-4V 共同处理这些信息,以在 PPE 计数等方案中实现高级推理。

- 图 121 中所示的整个链式过程被分为两轮(思想,动作和观察),每一轮涉及特定插件的激活。

- 在第一轮中,GPT-4V 推断人的检测对于计算戴头盔的人数是必要的(思想 1)。 因此,它调用了人检测器工具(动作 1),并为图像中每个检测人员(观察 1)接收边界框的坐标。

- 在第二轮中,根据获得的边界框信息,GPT-4V 推断图像中总共有 8 人(思想 2)。 然后,它利用图像裁剪工具根据每个人的相应边界框坐标(动作 2)裁剪单个图像。 最终的输出(观察 2)由 8 个标记的图像组成,从图像 1 到图像 8 。

- GPT-4V随后确定这些图像中的每个人是否戴着头盔,并总结了戴头盔的总人数。

总体而言,LMM 与多模态插件的这种集成利用了语言和视觉能力的优势,为增强推理和互动开辟了新的可能性。 多模态链的灵活性可以对多模态数据进行更全面的理解和分析,并有可能提高各种应用中的性能。

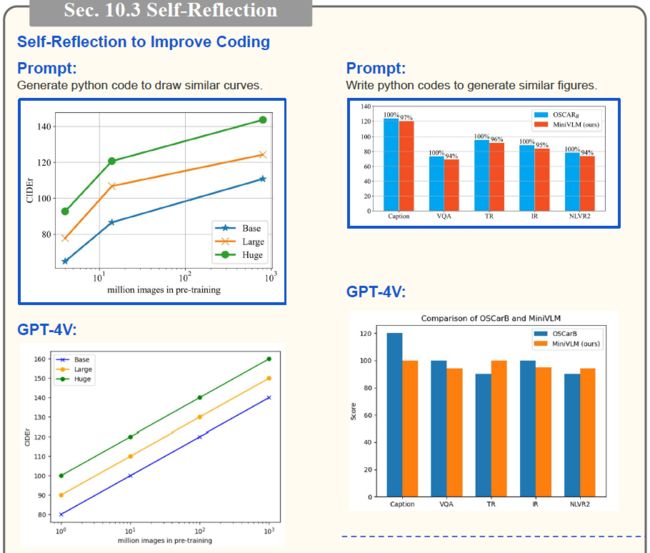

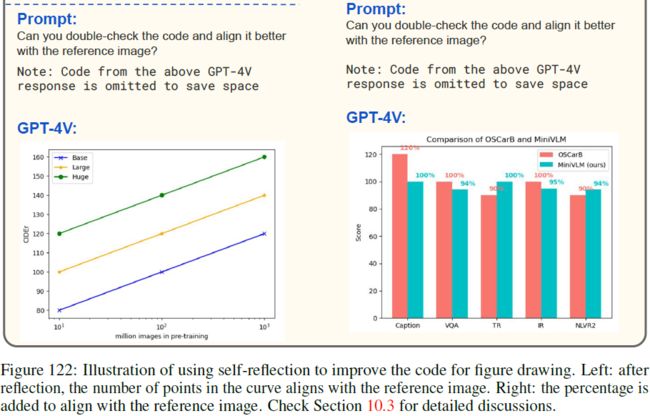

10.3 反思(Self-Reflection)

图 122 展示了利用反思 [109,83,60] 来改善图 47 中所示的结果。

- 如我们所见,反思的结果与参考图像更好地对齐。 例如,在左侧,数据点的数量从 4 纠正到 3,而在右侧,将百分比添加回栏上方。

- 尽管结果仍然不完全相同,但很明显反思可以促进手动打磨。

- 图 123 显示了反思改善文本到图像模型 [99] 提示生成的另一个例子 。

10.4 自洽性

自洽性 [123] 是一种解码策略,可以汇总多个采样的输出以产生最终答案,例如多数投票。

- 从边缘化到汇总的最终答案,Tree-of-Thoughts [137] 表明,可以将自洽的想法应用于中间思想,以提高 LLM 推理性能。

- 图 124 展示了在用于计数问题的 GPT-4V 上使用自洽的结果。 我们通过要求 GPT-4V 多次计数相同的图像(进行多次运行(样本 2-4)或重述输入文本指令(样本 1,2))来采样多个计数结果。

- 然后,该示例以简单的多数投票来汇总 “4 艘船” 的最终答案。

- 我们将自洽 LMM 的全面探索留给未来的作品。

10.5 检索增强的 LMM

检索增强的 LMM [88,64,47,18,108,98] 通过将相关信息检索和集成到提示中来增强文本生成。

- 当需要专门的任务信息时,该技术特别有效,例如高度专业的专家领域中的专家知识,可能与 LLM 内存不同的最新信息以及用户与用户不同的可自定义信息。

- 我们认为检索增强在 LMM 中继续起着至关重要的作用。

- 图 74 显示了帮助杂货结帐的检索增强的 LMM 的示例。 由于每个商店中生产的 图像-文本-价格 三元组都不同,因此从商店的数据库中检索并产生正确的结帐信息是有益的。

- 同样,在图 81 的 “自定义标题” 方案中,我们认为该系统可以自动从专辑中检索家庭成员的照片并实现自定义标题。

11. 结论

11.1 总结和结论

在本报告中,我们的主要重点是在各种应用场景中探测 GPT-4V。

- 这些发现揭示了其出色的功能,其中一些尚未在现有方法中进行调查或证明。

- 尽管我们努力揭示尽可能多的此类功能,但我们承认我们的展示可能并不详尽。

- 然而,该报告可以作为未来研究的参考,旨在探索 GPT-4V 的其他用途,加深对 LMM 的理解,并构建更强大的 LMM。

11.2 迈向未来的 LMM

GPT 模型的弱点和局限性已在相关报告 [94,95,23] 中进行了广泛讨论。 在本节中,我们简要专注于介绍未来研究方向的看法。

诸如 GPT-1,GPT-2 和 GPT-3 之类的模型主要充当 文本输入-文本输出 的系统,仅能处理自然语言。 GPT-4(no vision)在文本理解和生成中表现出无与伦比的能力,而 GPT-4V 也表现出强大的理解图像域的能力。

作为自然的进展,LMM 应该能够生成交织的图像文本内容,例如生成包含文本和图像的生动教程,以实现全面的多模态内容理解和生成。 此外,结合其他模态(例如视频,音频和其他传感器数据)对于扩展 LMM 的功能是有益的。

关于学习过程,当前方法主要依赖于组织良好的数据,例如 图像-标签 或 图像-文本 数据集。 但是,更通用的模型可能能够从各种来源(包括在线 Web 内容,甚至是现实世界的物理环境)中学习,以促进持续的自我进化。

S. 总结

S.1 主要贡献

大型多模态模型 (Large multimodal models,LMM) 通过视觉理解等多感官技能扩展大型语言模型 (large language models,LLM),以实现更强大的通用智能。

本文的主要贡献:

- 分析最新的具有视觉功能的模型 GPT-4V(ision),重点关注 GPT-4V 可以执行的有趣任务,包括测试样本来探究 GPT-4V 功能的质量和通用性、其支持的输入和工作模式,以及提示模型的有效方法。

- 对精心设计的定性样本的观察表明,GPT-4V 在处理任意交错的多模态输入方面具有前所未有的能力,并且其功能的通用性共同使 GPT-4V 成为强大的多模态通用系统。

- GPT-4V 独特的理解输入图像上绘制的视觉标记的能力可以催生新的人机交互方法,例如,视觉参考提示(visual referring prompting)。

- 最后深入讨论了基于 GPT-4V 的系统的新兴应用场景和未来研究方向。

S.2 基于四个问题展开探索

本文对 GPT-4V 的探索以以下 4 个问题为指导:

1) GPT-4V支持哪些输入和工作模式?

输入模式。

- 纯文本输入:仅使用文本进行输入和输出操作,能够执行各种语言和编码任务。

- 单个图像-文本对:可以将单个图像文本对或单个图像作为输入来执行各种视觉和视觉语言任务,例如图像识别、对象定位、图像标题、视觉问答、视觉对话、密集标题等等。

- 交错的图像文本输入:交错的图像文本输入可以以视觉为中心,也可以以文本为中心。这种混合输入模式为各种应用提供了灵活性。

工作模式。

- 遵循文本说明:指令提供了一种自然的方式来定义和定制任意视觉-语言用例所需的输出文本。例如,限制输出格式,或者以 “良好性能” 为条件明确要求 GPT-4V 具有良好的性能。

- 视觉指针和视觉参考提示:编辑输入图像的像素空间(绘制视觉指针或手写场景文本)来指定所需的目标,以执行感兴趣的任务。指针可以表示为数字空间坐标,或覆盖在图像像素上的视觉标记。

- 视觉+文字提示:GPT-4V 可以处理图像、子图像、文本、场景文本和视觉指针的任意组合。

- 上下文小样本学习:在推理时预先考虑一些上下文中的示例来生成所需输出,而无需更新参数。 这些示例与输入 query 具有相同的格式,并作为演示来说明所需的输出。相比于只有文本提示的 zero-shot,从 1-shot 到 2-shot 可以急剧地提升性能。

2) GPT-4V 在不同领域和任务上的功能质量和通用性如何?

不同领域的图像描述:名人识别、地标识别、食物识别、医学图像理解、logo 识别、场景理解、反事实的例子(在遇到误导性问题或指令时正确描述图像内容)。

目标定位、计数和密集标题。

- 空间关系理解:GPT-4V 可以识别图像中人和汽车之间的空间关系,并指出相机视角可能会影响他们感知的尺寸。

- 物体计数。

- 目标定位:例如,生成边界框坐标。

- 密集标题:为给定图像中的每个感兴趣区域生成详细描述。通常需要一个集成多个专家的复杂系统,例如对象检测器、名人识别模型和图像标题模型。

多模态知识和常识。

- 笑话和 meme:通常引用特定事件、流行文化或互联网趋势。理解这些需要熟悉相关背景和文化知识。

- 科学和知识:用科学知识(例如,地理、物理、生物学和地球科学)进行推理。

- 多模态常识:进行多模态常识推理。

场景文本、表格、图表和文档推理。

- 场景文本识别:阅读和理解图像中的文本。

- 视觉数学推理:解决输入图像中的数学问题。

- 图表理解和推理:在理解图表的基础上进行进一步操作,例如,将详细信息转换为 Python 代码,或解释了图表中呈现的关键见解。

- 表格理解和推理:理解表格中的细节并推理和准确回答相关问题。

- 文档理解:理解各种类型文档(例如平面图、海报和试卷)并进行进一步操作。

多语言多模态理解。例如:

- 识别不同语言的输入文本提示,并生成相应语言的正确图像描述。

- 识别场景文本,并将其翻译为不同的语言。

- 理解文化的细微差别,并为给出的图像生成合理的多语言描述。

视觉编码能力。例如:

- 基于手写数学方程生成 LaTeX 代码。

- 将输入图像中的表格重建为 MarkDown/LaTex 代码。

- 用 Python、TikZ 和 SVG 编写代码来复现输入图形。

3) 有效使用和提示 GPT-4V 的方法有哪些?

视觉参考提示。

- 直接编辑图像像素空间来绘制视觉指针或场景文本作为人类参考指令。

- GPT-4V 还可自动生成指针,从而促进人机交互中的闭环交互过程。

- 当图像中有多个目标时,识别并剪切出每个目标,然后分别进行处理可以提升性能。

时间和视频理解:时间预测、时间排序、时间定位、时间推理和基础的时间理解等功能有助于衡量模型在理解事件序列、预测未来事件以及随时间的上下文分析活动。

抽象视觉推理与智商测试:从视觉信号中提取语义,并可以执行不同类型的人类智商 (IQ) 测试。

情商测试: 在与人类互动时,重要的是 GPT-4V 具有同理心和情商(EQ)来理解和分享人类的感受。

4) 未来有哪些有前景的方向?

尽管本文努力揭示尽可能多的功能,但这些展示可能并不详尽。

找不同:识别两幅相似图像之间的所有差异。基于此,可以有更多的扩展应用。

工业:缺陷检测、安全检查(例如,是否佩戴防护装备)、杂货店结账(数据库检索辅助)

医疗:理解医学图像,并生成完整的报告(诊断、治疗方案等)。

汽车保险:进行损害评估,生成保险报告。前者涉及准确识别和评估车辆受损程度,而后者不仅包括损坏识别,还包括图像中描述的车辆特定信息的识别,例如品牌、型号、车牌、 以及其他相关细节。

定制标题:GPT-4V 可以为图像中每个对象生成高度复杂的密集标题,其中一些对象伴随着对上下文图像的相关引用。

图像生成:评估生成图像(例如,提示与图像描述之间的文本相似性)、基于提示的图像编辑。

具象代理:操作机器、导航(机器人在室内的行进路线)。

GUI 导航:与计算机或智能手机的图形用户界面(GUI)进行交互和导航,以完成复杂任务,例如网络浏览,在线购物,通知理解,看视频并转述等。

还可将 LLM 中有趣的用法扩展为多模态方案,例如

- 多模态插件:例如,为已完成训练的模型添加搜索引擎,从而获取最新信息。

- 多模态链:多步骤迭代处理问题。通过使用视觉/多模态专家(例如图像标题器,对象探测器或训练有素的文本到图像生成和音频到文本转换)替换纯语言插件,可以使用 LLM 构建功能强大的多模态链。

- 反思:利用反思来改善结果。

- 自洽性:汇总多个采样的输出以产生最终答案。

- 检索增强的 LMM :例如,杂货店结帐。