基于ITOP4412开发板的实时视频监控系统实现

实时视频监控系统实现

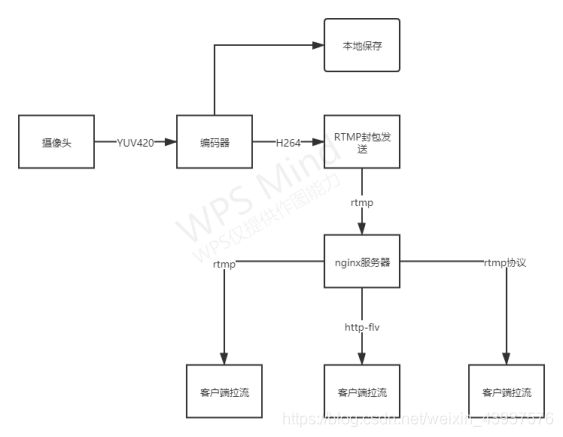

设计一种RTMP嵌入式监控系统,该系统基于服务器/客户端模式,用户使用PC机或者使用移动设备通过网络实时监控观测对象。系统基于ITOP4412开发板,通过V4L2接口从摄像头采集YUV420格式的视频,通过X264对视频数据进行编码,然后通过RTMP协议发送至支持了rtmp的nginx流媒体服务器,然后客户端使用potplayer从服务器拉流显示。测试结果表明客户端播放器能够流畅地播放视频数据,系统稳定可靠。

V4L2----->X264----->RTMP------>nginx------>potplayer

一、开发环境

1、开发板硬件参数

itop4412 开发板

(1)计算能力

CPU采用EXYNOS4412,四核Cortex-A9架构,主频为1.4Ghz-1.6GHz;

(2)内存能力

采用1GB 双通道DDR3内存

(3)网络能力

使用DM9621网卡,百兆网卡

(4)IO能力

采用4GB EMMC

2、摄像头参数

OV5640摄像头 500W像素

输出格式,支持YUV420、YUV422、YUV444

3、操作系统

使用的是linux操作系统

二、相关技术简介

1、V4L2

V4L2是Video for linux2的简称,为linux中关于视频设备的内核驱动。在Linux中,视频设备是设备文件,可以像访问普通文件一样对其进行读写。

应用程序通过V4L2框架,对摄像头进行操作,如 设置摄像头的频率、图像参数、查看摄像头支持的配置等等;在使用V4L2框架采集摄像头时,主要步骤 1、打开设备;2、对设备进行配置;3、设置数据采集方式;4、处理数据;5、关闭设备。

2、RTMP

RTMP是Real Time Messaging Protocol(实时消息传输协议)的首字母缩写。该协议基于TCP,是一个协议族,包括RTMP基本协议及RTMPT/RTMPS/RTMPE等多种变种。RTMP是一种设计用来进行实时数据通信的网络协议,主要用来在Flash/AIR平台和支持RTMP协议的流媒体/交互服务器之间进行音视频和数据通信。支持该协议的软件包括Adobe Media Server/Ultrant Media Server/red5等。RTMP与HTTP一样,都属于TCP/IP四层模型的应用层。

3、H.264

H.264技术是目前在视频编码压缩中采用的最为普遍的一种技术。由于H.264拥有更低的码率,与MPEG2和MPEG4 ASP等压缩技术相比,在同等图像质量下,采用H.264技术压缩后的数据量只有MPEG2的1/8,MPEG4的1/3。H.264在具有高压缩比的同时还拥有高质量流畅的图像,正因为如此,经过H.264压缩的视频数据,在网络传输过程中所需要的带宽更少,也更加经济;并且它的容错能力也很强,网络适应能力非常好。

在本设计中,对于动态变化不明显的视频,H.264显示出了非常强大的压缩能力,使得网络带宽大大减少。本设计只是用了H.264的编码部分,使用目前最为流行,性能最好的X264作为编码器

4 、YUV图像

常用的YUV元素图像格式有YUV422格式和YUV420格式。与RGB相比YUV422的大小是其2/3,而YUV420是其1/2。在YUV422格式中,按照U、V分量在时空上的排列顺序不同,可以将他们分为YUYV、YVYU、UYVY、VYUY四种不同的排列方式;在YUV420格式中,又分为I420(YU12)、YV12、NV12、NV21。

按照YUV的排列方式的不同又可以分为打包格式(packet)和平面格式(planner),对于packet格式 上面的YUYV就是典型的packet格式,具体区别见下图

5、nginx流媒体服务器

nginx本身是一个非常出色的HTTP服务器,但是并不支持流媒体协议,但是可以通过使用开源的nginx-http-flv-module模块来支持,nginx-http-flv-module是在nginx-rtmp-module基础上开发的一个直播模块,解决了nginx-rtmp-module的一些bug,并且完美兼容,支持HTTP-FLV方式的直播,支持GOP缓存,以减少首屏等待时间,支持虚拟主机功能等等

三、系统整体架构

本设计参考目前流行的流媒体解决方案,基于linux平台,利用V4L2(Video for linux2)框架,对OV5640摄像头进行操作,采集YUV420格式的数据,然后通过X264对每一帧YUV420数据进行编码,然后通过RTMP协议进行封包推流至nginx服务器。然后客户端使用vlc

、potplayer等播放器进行拉流,其中使用效果较好的是potplayer,由于vlc设有缓冲区相对于potplayer有较大的延时。

子模块划分

1、数据采集模块

使用V4L2框架对摄像头进行操作,主要步骤其实就是1、打开摄像头、2、对摄像头进行配置,3、设置数据采集方式;例如使用mmap内存映射,4、对数据进行操作;5、关闭设备。

在这里,对数据的操作是,从视频输出队列获取到的数据直接交给H264编码器进行编码

2、数据压缩模块

这部分主要是对编码器的初始化,以及配置,因为实时监控需要的编码延迟要求较高,所以在x264_param_default_preset(&en->param, “ultrafast”, “zerolatency”); 中选择了

zerolatency配置选项,能够有效的降低编码延迟,然后就是在编码速度上选择了“ultrafast”,就是最快编码速度,这样的结果是降低了编码质量;因为itop4412开发板性能有限,在使用更高编码质量时,大大降低了帧率,使用veryfast时只有15fps;其次就是因为是实时监控要求实时性,不管用户什么时候拉流都能快速的解码出画面,这样就要求GOP序列的长度必须要短,在这里是30fps一个GOP序列也就是编码一个I帧,作为实时传输时,B帧的个数为0;然后就是设置比特率(码率),这里码率控制采用了平均码率,根据H264码流在每一个I帧前面都必须要有SPS、PPS序列,所以在配置完编码器后,便可直接解析出SPS

、PPS序列的信息将其保存到缓冲区,在发送时于I帧之前发送即可;

编码阶段本设计采用了数据量较小的YUV420格式,在编码之前需要将Y、U、V分量分离出来依次存入picture.img.plane[0]、picture.img.plane[1]、picture.img.plane[2]中然后进行编码即可,解析H264裸流,如果该帧被编码为I帧便将标志位置为1,以便区分

3、本地保存模块

本模块主要是将编码后的H264数据流写入到文件中去,根据H264码流依次写入分隔符(0x00 00 00 01) sps分隔符pps分隔符 I帧 分隔符P帧 分隔符 P帧也就是一个RBSP单元,然后在每一个I帧之前都需要有sps和pps;与网络传输的区别就是,在网络传输时添加了NAL单元

RBSP单元

![]()

网络传输添加NAL头

网络传输需要对H.264裸流进行封包

4、RTMP协议推流模块

首先是对RTMP的初始化,如分配内存初始化设置,开启输出模式, 然后就是连接服务器,连接流。

接下来便是封包阶段这里封包采用如下结构,封包完毕之后便是推流阶段;

因为在解码时,客户端首先会根据sps、pps 信息获取视频参数,所以在每一个I帧之前都必须要有sps、pps数据,所以在发送I帧之前,将sps、pps包数据发送至服务器即可

四、源代码

在这里先贴出核心代码,其余等后续整理在发出来

1、数据采集

/*************************************************************************

> File Name: camer.c

> 作者:YJK

> Mail: [email protected]

> Created Time: 2020年11月18日 星期三 14时17分50秒

************************************************************************/

#include"./include/camer.h"

#include 2、x264编码

/*************************************************************************

> File Name: x264_encoder.c

> 作者:YJK

> Mail: [email protected]

> Created Time: 2020年11月27日 星期五 16时18分39秒

************************************************************************/

#include "include/x264_encoder.h"

#include 3、RTMP推流和写入文件

/*************************************************************************

> File Name: rtmp_send.c

> 作者:YJK

> Mail: [email protected]

> Created Time: 2020年12月03日 星期四 15时02分31秒

************************************************************************/

#include五、系统测试

服务器使用的是添加了nginx-http-flv-module模块的nginx,播放器使用PotPlayer或者VLC都可以,不过VLC默认是有缓冲区的所以看着延时会比较高大概2~3s的样子,但是使用PotPlayer的话延时在1s以内(局域网),

首屏进入的话

PotPlayer 10s左右

VLC 5s左右

测试的时候发现推流4.66小时的时候会断开连接

原因是 RTMP协议在处理扩展时间戳的时候有个bug,也就是只用了3个字节大小来存储时间戳,当时间戳超过0FFFFFF时,应该使用扩展时间戳的也就是最大为0xFFFFFFFF

在这里我更新了RTMP的版本之前使用的是2.3 现在使用2.4已经不存在上述问题

目前摄像头已经跑了24小时,这是今天早上八点连接的一直没有中断过;

理论上时间戳的最大值是0xFFFFFFFF,也就是可以用49天

目前项目已开源至 github

https://github.com/745506980/V4L2-to-Rtmp.git

有什么问题欢迎大家讨论,共同进步