Redis:Feed流之Timeline的实现

当我们关注了用户后,这个用户发了动态,那么我们应该把这些数据推送给用户,这个需求,其实我们又把他叫做Feed流,关注推送也叫做Feed流,直译为投喂。为用户持续的提供“沉浸式”的体验,通过无限下拉刷新获取新的信息。

Feed流

对于传统的模式的内容解锁:我们是需要用户去通过搜索引擎或者是其他的方式去解锁想要看的内容

对于新型的Feed流的的效果:不需要我们用户再去推送信息,而是系统分析用户到底想要什么,然后直接把内容推送给用户,从而使用户能够更加的节约时间,不用主动去寻找。

对于新型的Feed流的的效果:不需要我们用户再去推送信息,而是系统分析用户到底想要什么,然后直接把内容推送给用户,从而使用户能够更加的节约时间,不用主动去寻找。

Feed流产品有两种常见模式:

Timeline:不做内容筛选,简单的按照内容发布时间排序,常用于好友或关注。例如朋友圈

- 优点:信息全面,不会有缺失。并且实现也相对简单

- 缺点:信息噪音较多,用户不一定感兴趣,内容获取效率低

智能排序:利用智能算法屏蔽掉违规的、用户不感兴趣的内容。推送用户感兴趣信息来吸引用户

- 优点:投喂用户感兴趣信息,用户粘度很高,容易沉迷

- 缺点:如果算法不精准,可能起到反作用

本文采用Timeline的模式

Timeline模式

该模式的实现方案有三种:

我们本次针对好友的操作,采用的就是Timeline的方式,只需要拿到我们关注用户的信息,然后按照时间排序即可,因此采用Timeline的模式。该模式的实现方案有三种:

- 拉模式

- 推模式

- 推拉结合

拉模式

该模式的核心含义就是:当张三和李四和王五发了消息后,都会保存在自己的邮箱中,假设赵六要读取信息,那么他会从读取他自己的收件箱,此时系统会从他关注的人群中,把他关注人的信息全部都进行拉取,然后在进行排序

- 优点:比较节约空间,因为赵六在读信息时,并没有重复读取,而且读取完之后可以把他的收件箱进行清楚。

- 缺点:比较延迟,当用户读取数据时才去关注的人里边去读取数据,假设用户关注了大量的用户,那么此时就会拉取海量的内容,对服务器压力巨大。

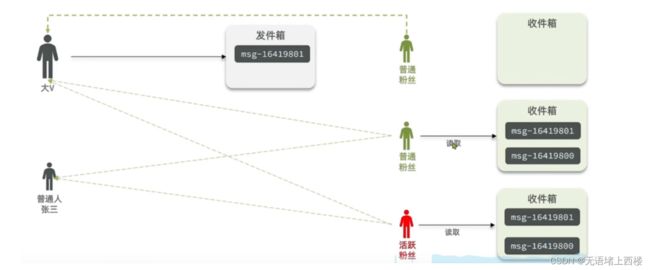

推模式

推模式

推模式是没有写邮箱的,当张三写了一个内容,此时会主动的把张三写的内容发送到他的粉丝收件箱中去,假设此时李四再来读取,就不用再去临时拉取了

- 优点:时效快,不用临时拉取

- 缺点:内存压力大,假设一个大V写信息,很多人关注他, 就会写很多分数据到粉丝那边去

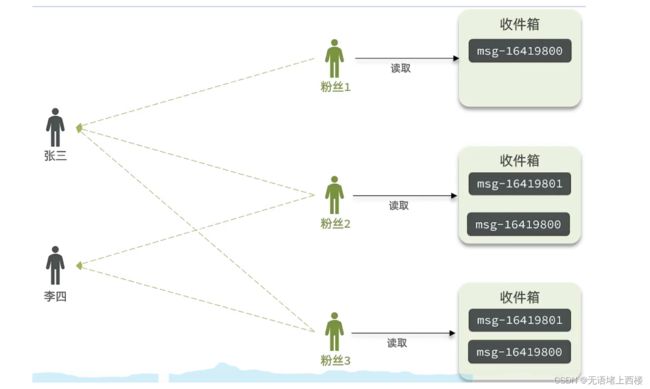

推拉结合模式

推拉结合模式

推拉模式是一个折中的方案,站在发件人这一段,如果是个普通的人,那么我们采用写扩散的方式,直接把数据写入到他的粉丝中去,因为普通的人他的粉丝关注量比较小,所以这样做没有压力,如果是大V,那么他是直接将数据先写入到一份到发件箱里边去,然后再直接写一份到活跃粉丝收件箱里边去,现在站在收件人这端来看,如果是活跃粉丝,那么大V和普通的人发的都会直接写入到自己收件箱里边来,而如果是普通的粉丝,由于他们上线不是很频繁,所以等他们上线时,再从发件箱里边去拉信息。

推送实例

我们在保存完发布内容后,获得到当前发布者的粉丝,然后把数据推送到粉丝的redis中去。

@Override

public Result saveBlog(Blog blog) {

// 1.获取登录用户

UserDTO user = UserHolder.getUser();

blog.setUserId(user.getId());

// 2.保存发布内容

boolean isSuccess = save(blog);

if(!isSuccess){

return Result.fail("发布内容失败!");

}

// 3.查询发布者的所有粉丝 select * from tb_follow where follow_user_id = ?

List follows = followService.query().eq("follow_user_id", user.getId()).list();

// 4.推送发布d给所有粉丝

for (Follow follow : follows) {

// 4.1.获取粉丝id

Long userId = follow.getUserId();

// 4.2.推送

String key = FEED_KEY + userId;

stringRedisTemplate.opsForZSet().add(key, blog.getId().toString(), System.currentTimeMillis());

}

// 5.返回id

return Result.ok(blog.getId());

} Feed流的滚动分页

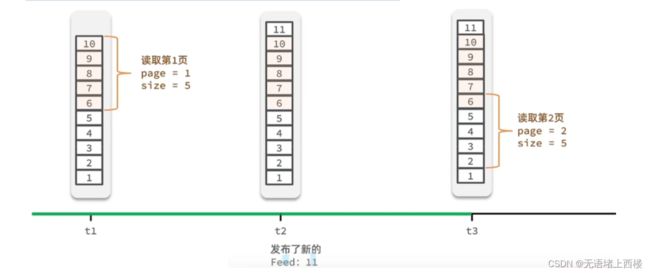

Feed流中的数据会不断更新,所以数据的角标也在变化,因此不能采用传统的分页模式。

传统了分页在feed流是不适用的,因为我们的数据会随时发生变化

假设在t1 时刻,我们去读取第一页,此时page = 1 ,size = 5 ,那么我们拿到的就是10~6 这几条记录,假设现在t2时候又发布了一条记录,此时t3 时刻,我们来读取第二页,读取第二页传入的参数是page=2 ,size=5 ,那么此时读取到的第二页实际上是从6 开始,然后是6~2 ,那么我们就读取到了重复的数据,所以feed流的分页,不能采用原始方案来做。

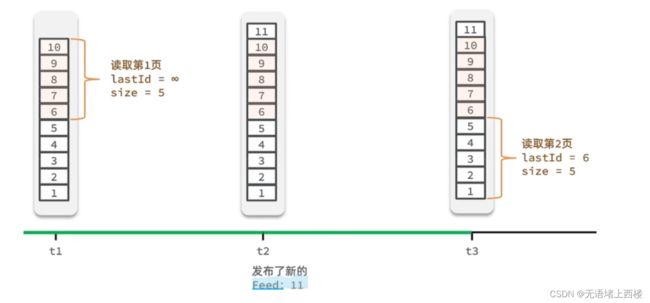

Feed流的滚动分页

我们需要记录每次操作的最后一条,然后从这个位置开始去读取数据

举个例子:我们从t1时刻开始,拿第一页数据,拿到了10~6,然后记录下当前最后一次拿取的记录,就是6,t2时刻发布了新的记录,此时这个11放到最顶上,但是不会影响我们之前记录的6,此时t3时刻来拿第二页,第二页这个时候拿数据,还是从6后一点的5去拿,就拿到了5-1的记录。我们这个地方可以采用sortedSet来做,可以进行范围查询,并且还可以记录当前获取数据时间戳最小值,就可以实现滚动分页了

实现分页查询推送

具体操作如下:

- 每次查询完成后,我们要分析出查询出数据的最小时间戳,这个值会作为下一次查询的条件

- 我们需要找到与上一次查询相同的查询个数作为偏移量,下次查询时,跳过这些查询过的数据,拿到我们需要的数据

综上:我们的请求参数中就需要携带 lastId:上一次查询的最小时间戳 和偏移量这两个参数。

这两个参数第一次会由前端来指定,以后的查询就根据后台结果作为条件,再次传递到后台。

返回值实体类

@Data

public class ScrollResult {

private List list;

private Long minTime;

private Integer offset;

}Controller

@GetMapping("/of/follow")

public Result queryBlogOfFollow(

@RequestParam("lastId") Long max, @RequestParam(value = "offset", defaultValue = "0") Integer offset){

return blogService.queryBlogOfFollow(max, offset);

}ServiceImpl

public Result queryBlogOfFollow(Long max, Integer offset) {

// 1.获取当前用户

Long userId = UserHolder.getUser().getId();

// 2.查询收件箱 ZREVRANGEBYSCORE key Max Min LIMIT offset count

String key = FEED_KEY + userId;

Set> typedTuples = stringRedisTemplate.opsForZSet()

.reverseRangeByScoreWithScores(key, 0, max, offset, 2);

// 3.非空判断

if (typedTuples == null || typedTuples.isEmpty()) {

return Result.ok();

}

// 4.解析数据:blogId、minTime(时间戳)、offset

List ids = new ArrayList<>(typedTuples.size());

long minTime = 0; // 2

int os = 1; // 2

for (ZSetOperations.TypedTuple tuple : typedTuples) { // 5 4 4 2 2

// 4.1.获取id

ids.add(Long.valueOf(tuple.getValue()));

// 4.2.获取分数(时间戳)

long time = tuple.getScore().longValue();

if(time == minTime){

os++;

}else{

minTime = time;

os = 1;

}

}

// 获取相同minTime 次数

os = minTime == max ? os : os + offset;

// 5.根据id查询blog

String idStr = StrUtil.join(",", ids);

List blogs = query().in("id", ids).last("ORDER BY FIELD(id," + idStr + ")").list();

for (Blog blog : blogs) {

// 5.1.查询blog有关的用户

queryBlogUser(blog);

// 5.2.查询blog是否被点赞

isBlogLiked(blog);

}

// 6.封装并返回

ScrollResult r = new ScrollResult();

r.setList(blogs);

r.setOffset(os);

r.setMinTime(minTime);

return Result.ok(r);

}