(初学者强烈推荐)Ubuntu 配置hadoop 超详细教程(全过程)

引言

本文的教程仅为个人的操作经验所写,每个人下载的版本不一样,所以会出现不同的情况异常等,如有问题可询问博主或百度查找解决方法。

本机的配置环境如下:

hadoop(3.3.1)

jdk版本(jdk-8)

Linux(64位)

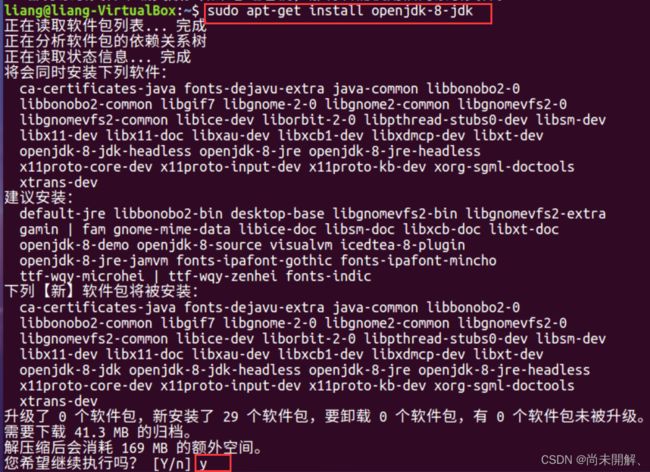

1、安装jdk

在Ubuntu中用压缩包安装jdk较为麻烦,需要配置系统环境变量和配置文件,一步出错可能无法使用。所以本文在Ubuntu中使用命令安装jdk。其他方法安装jdk也可。

打开终端

执行以下命令:

sudo apt-get install openjdk-8-jdk输入y回车,等待安装完成

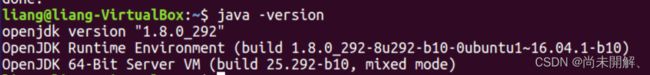

java -version安装完成后用 java -version 检验是否安装成功,如果如下图则安装成功

当想要卸载jdk则使用以下命令:sudo apt remove openjdk*

打开环境文件

sudo gedit ~/.bashrc

文件顶部加入以下语句并保存

sudo apt-get install openjdk-8-jdk 命令安装的jdk默认路径为 /usr/lib/jvm/java-8-openjdk-amd64

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64 #目录要换成自己jdk所在目录

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH 使环境生效

source ~/.bashrc 使用 echo $JAVA_HOME 显示JAVA_HOME即为成功![]()

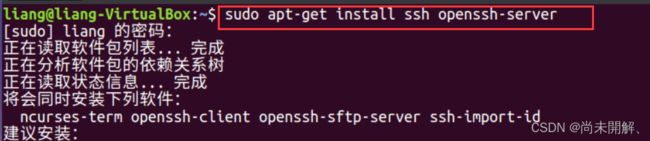

2、安装ssh免密码登录

sudo apt-get install ssh openssh-server安装完毕后,在终端中依次进行继以下命令操作

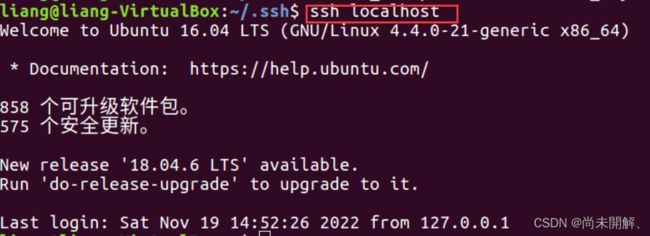

cd ~/.ssh/生成密钥

ssh-keygen -t rsa 将秘钥加入到授权中

cat id_rsa.pub >> authorized_keys再验证ssh localhost 如下图,不用密码登录即为成功。

3、安装hadoop

1)安装hadoop并解压

镜像下载链接https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-3.3.1/

下载好的压缩包传到 /usr/local/目录下

使用如下命令解压缩Hadoop安装包:

tar -zxvf hadoop-3.1.1.tar.gz

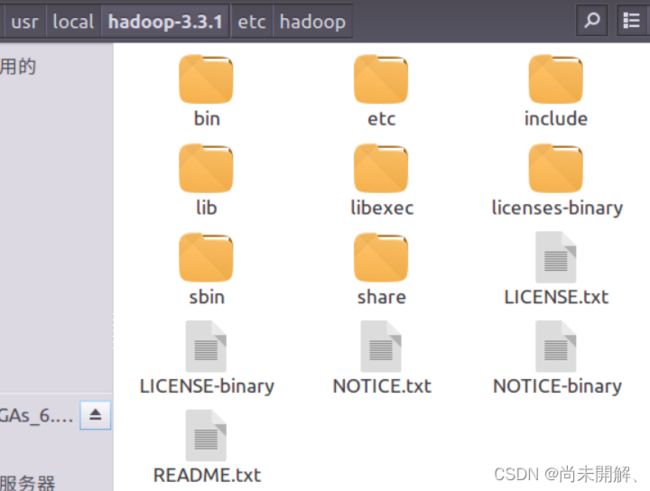

解压完成之后进入hadoop-3.1.1文件内容如下:

2) 配置相关文件

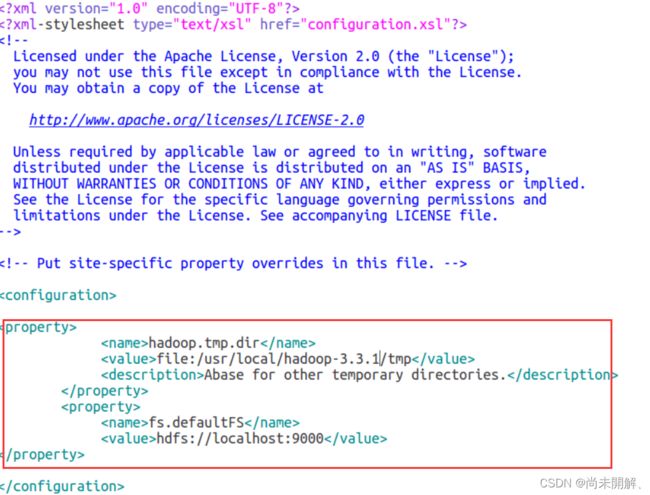

core-site.xml

打开/etc中的core-site.xml 文件,加入如下语句并保存

hadoop.tmp.dir

file:/usr/local/hadoop-3.3.1/tmp

Abase for other temporary directories.

fs.defaultFS

hdfs://localhost:9000

注意其中路径要修改为自己的

hdfs-site.xml

和上面一样,打开/etc中的hdfs-site.xml 文件,加入如下语句并保存

dfs.replication

1

dfs.namenode.name.dir

file:/usr/local/hadoop-3.3.1/tmp/dfs/name

dfs.datanode.data.dir

file:/usr/local/hadoop-3.3.1/tmp/dfs/data

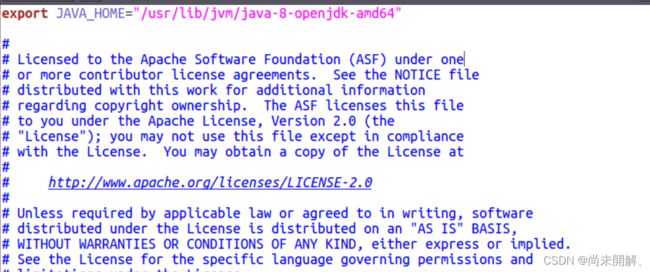

hadoop-env.sh

查看你的 jdk安装目录

echo $JAVA_HOME

打开 hadoop-env.sh 文件配置如下并保存:

export JAVA_HOME="/usr/lib/jvm/java-8-openjdk-amd64" # 根据自己的路径写4、运行hadoop

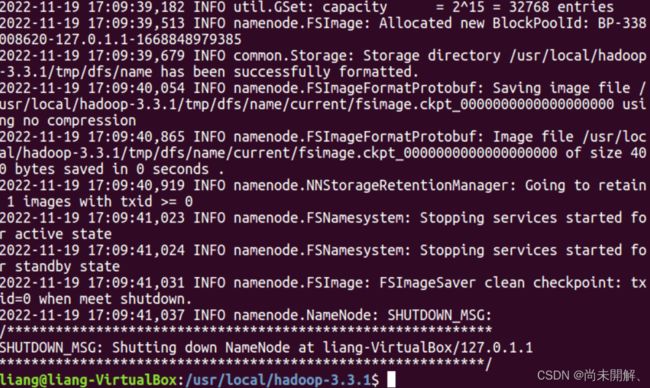

1)首先初始化HDFS系统

在hadop3.3.0目录下使用如下命令进行初始化:

bin/hdfs namenode -format成功后如下图:

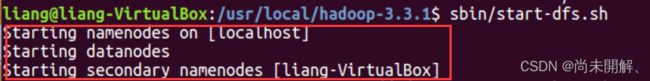

2)开启NameNode和DataNode守护进程

继续运行如下命令开启hadoop

sbin/start-dfs.sh成功如下图:

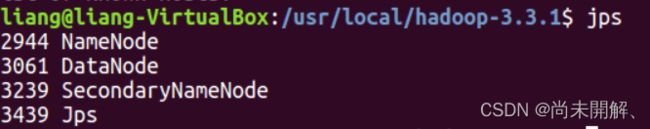

3)查看jps进程信息

jps

如下图即为成功

关闭hadoop使用命令 sbin/stop-dfs.sh

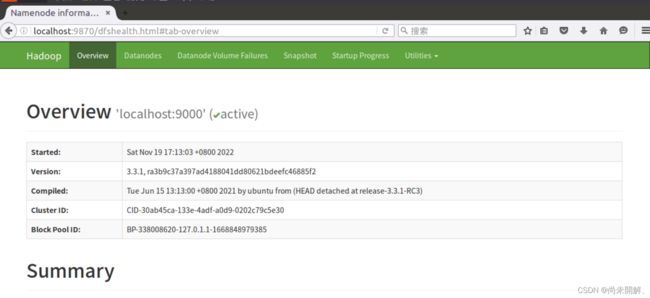

打开浏览器输入http://localhost:9870,成功打开

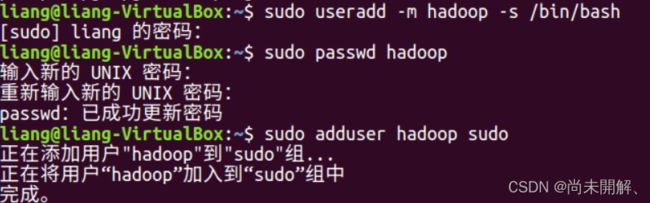

4)创建hadoop用户组

使用/bin/bash作为shell sudo useradd -m hadoop -s /bin/bash

设置密码 sudo passwd hadoop

添加hadoop至管理员权限 sudo adduser hadoop sudo

5、配置yarn

搭建前请保证已经搭建好了HDFS的环境,即配置好所上内容。

1)终端输入hostname查看主机名

hostname2)打开/etc下yarn-site.xml,在在configuration标签中加入如下,注意主机名要修改为自己的

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

liang-VirtualBox

3)打开mapred-site.xml 文件,配置如下(在configuration标签中间加入)

mapreduce.framework.name

yarn

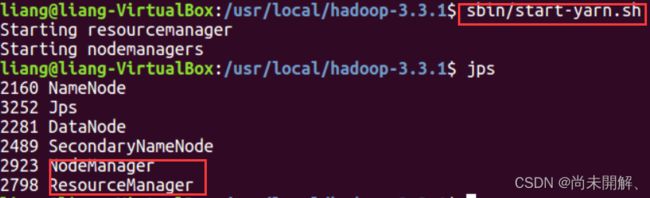

4)输入命令启动yarn

sbin/start-yarn.sh

jps查看进程信息多了两个东西

成功启动如下图

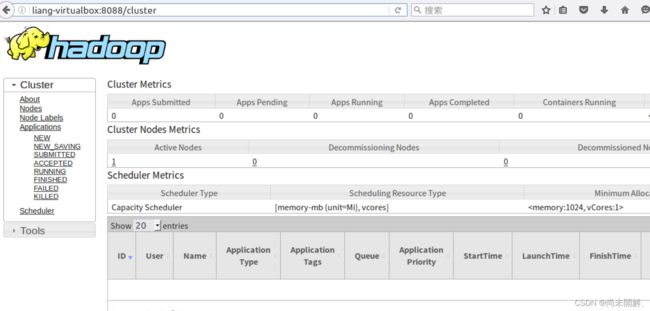

在浏览器输入主机名:8088 打开成功

6、配置JobHistory(可不配)

JobHistory用来记录已经finished的mapreduce运行日志,日志信息存放于HDFS目录中,默认情况下没有开启此功能,需要在mapred-site.xml、yarn-site.xml配置,并手动启动

mapred-site.xml添加如下配置(在configuration标签中间加入)

mapreduce.jobhistory.address

主机名:10020

MapReduce JobHistory Server IPC host:port

mapreduce.jobhistory.webapp.address

主机名:19888

MapReduce JobHistory Server Web UI host:port

mapreduce.jobhistory.done-dir

/history/done

mapreduce.jobhistory.intermediate-done-dir

/history/done_intermediate

yarn-site.xml添加如下配置(在configuration标签中间加入)

yarn.log-aggregation-enable

true

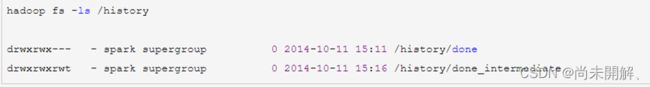

hadoop fs -ls /history查看历史记录

开启history进程

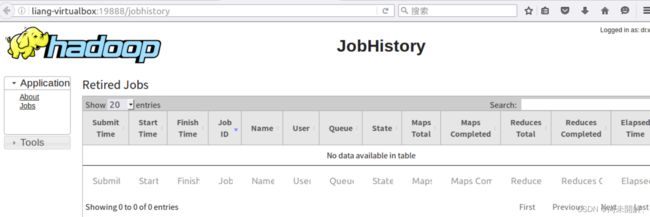

mapred --daemon start historyserver通过浏览器访问 主机名:19888

成功如下图

至此,hadoop全部配置完成,可下载eclipse进行wordcount等运算实验。

如有任何疑问,请留言,尽仅有所学帮助。