Zookeeper

1 概述

1.1 啥啊

Zookeeper 是一个开源的分布式的,为分布式框架提供协调服务的 Apache 项目

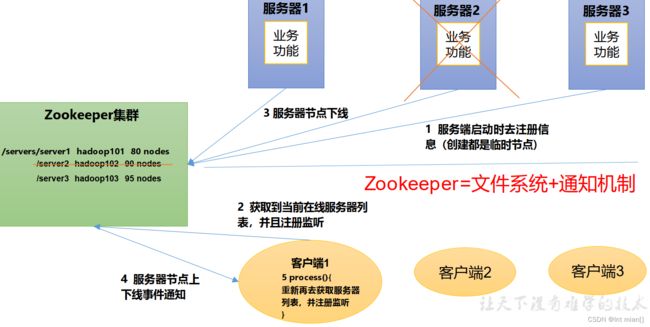

Zookeeper从设计模式角度来理解:是一个基于观察者模式设计的分布式服务管理框架,它负责存储和管理大家都关心的数据,然后接受观察者的注册,一旦这些数据的状态发生变化,Zookeeper就将负责通知已经在Zookeeper上注册的那些观察者做出相应的反应。

1.2 架构

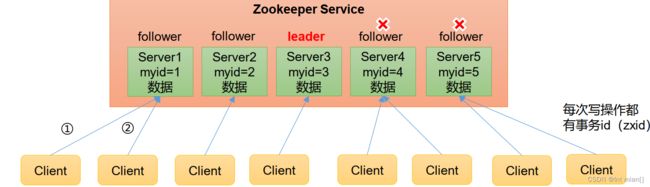

1)Zookeeper:一个领导者(Leader),多个跟随者(Follower)组成的集群。

2)集群中只要有半数以上节点存活,Zookeeper集群就能正常服务。所以Zookeeper适合安装奇数台服务器。

3)全局数据一致:每个Server保存一份一模一样的数据副本,Client无论连接到哪个Server,数据都是一致的。

4)更新请求顺序执行,来自同一个Client的更新请求按其发送顺序依次执行。

5)数据更新原子性,一次数据更新要么成功,要么失败。

6)实时性,在一定时间范围内,Client能读到最新数据。

1.3 文件结构

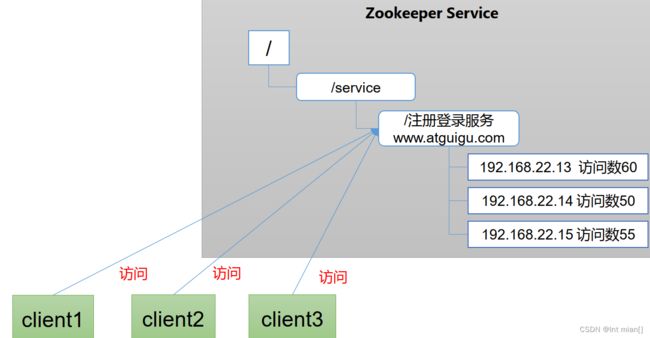

每个节点称做一个 ZNode。每一个 ZNode 默认能够存储 1MB 的数据,每个 ZNode 都可以通过其路径唯一标识。

1.3.1 节点类型(持久/短暂/有序号/无序号)

短暂(Ephemeral):客户端和服务器端断开连接后,创建的节点自己删除

持久(Persistent):客户端和服务器端断开连接后,创建的节点不删除

1.3.2 写数据流程

给Leader

1.4 应用场景

提供的服务包括:统一命名服务、统一配置管理、统一集群管理、服务器节点动态上下线、软负载均衡等。

1.4.1统一命名服务

在分布式环境下,经常需要对应用/服务进行统一命名,便于识别。例如:IP不容易记住,而域名容易记住。

1.4.2 统一配置管理

分布式环境下,配置文件同步非常常见。

- 一般要求一个集群中,所有节点的配置信息是一致的,比如 Kafka 集群。

- 对配置文件修改后,希望能够快速同步到各个节点上。

配置管理可交由ZooKeeper实现。

- 可将配置信息写入ZooKeeper上的一个Znode。

- 各个客户端服务器监听这个Znode。

- 一旦Znode中的数据被修改,ZooKeeper将通知各个客户端服务器。

1.4.3 统一集群管理

ZooKeeper可以实现实时监控节点状态变化

- 可将节点信息写入ZooKeeper上的一个ZNode。

- 监听这个ZNode可获取它的实时状态变化

1.4.4 服务器节点动态上下线

客户端能实时洞察到服务器上下线的变化

1.4.5 软负载均衡

在Zookeeper中记录每台服务器的访问数,让访问数最少的服务器去处理最新的客户端请求

1.5 安装部署

1.5.1 流程

学kafka的时候安装

Apache ZooKeeper

安装地址:https://archive.apache.org/dist/zookeeper/zookeeper-3.5.7/apache-zookeeper-3.5.7-bin.tar.gz

解压

tar -zxvf kafka_2.12-3.0.0.tgz -C /export/server/改配置

cd config

cp zoo_sample.cfg zoo.cfg

vim zoo.cfg

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

dataDir=/export/server/zookeeper-3.5.7/zkdata

# 这里和server.几 和下面的myid匹配上

# 2888是正常leader端口,3888是备用端口

server.1=hadoop1:2888:3888

server.2=hadoop2:2888:3888

server.3=hadoop3:2888:3888

:wq在设置的dataDir目录下创建一个名字叫myid的文件(必须叫myid!!!)

写入一个数(几都行,只要三个集群别一样)

[root@hadoop1 zkdata]# echo 1 > myid

[root@hadoop2 zkdata]# echo 2 > myid

[root@hadoop3 zkdata]# echo 3 > myid

fenfa

1.5.2 zoo.cfg配置解毒

# The number of milliseconds of each tick

# 每个滴答的毫秒数 心跳

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

# 初始同步阶段可以占用的心跳数 到了没连上就失败

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

# 在发送请求和获得确认之间可以传递的心跳数

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

# 快照所在的目录。不使用/ tmp为存储、/ tmp这里只是例子的缘故。

dataDir=/export/server/zookeeper-3.5.7/zkdata

# the port at which the clients will connect

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

# 客户端连接的最大数量。如果需要处理更多客户端,请增加此值

#maxClientCnxns=60

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

# 在开启自动督促之前,请务必阅读管理员指南的维护部分。

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

# dataDir中要保留的快照数量

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

# 清除任务间隔(小时) 设置为“0”表示禁用自动清除功能

#autopurge.purgeInterval=1

1.5.3 原神启动

hadoop1启动

[root@hadoop1 zookeeper-3.5.7]# bin/zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /export/server/zookeeper-3.5.7/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

[root@hadoop1 zookeeper-3.5.7]# bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /export/server/zookeeper-3.5.7/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Error contacting service. It is probably not running.

一看状态居然失败了?因为另外两个没启动,不过半没法选出来leader

hadoop2/3也启动

bin/zkServer.sh start

现在hadoop1状态

[root@hadoop1 zookeeper-3.5.7]# bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /export/server/zookeeper-3.5.7/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Mode: follower

[root@hadoop2 zookeeper-3.5.7]# bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /export/server/zookeeper-3.5.7/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Mode: leader(hadoop2成leader了)

[root@hadoop3 zookeeper-3.5.7]# bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /export/server/zookeeper-3.5.7/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Mode: follower

1.5.4 批量启动脚本

#!/bin/bash

case $1 in

start)

for i in hadoop1 hadoop2 hadoop3

do

echo ---------------- zookeeper $i start ----------------

ssh $i "/export/server/zookeeper-3.5.7/bin/zkServer.sh start"

echo -----------------------------------------------------

done

;;

stop)

for i in hadoop1 hadoop2 hadoop3

do

echo ---------------- zookeeper $i stop ----------------

ssh $i "/export/server/zookeeper-3.5.7/bin/zkServer.sh stop"

echo -----------------------------------------------------

done

;;

status)

for i in hadoop1 hadoop2 hadoop3

do

echo ---------------- zookeeper $i status ----------------

ssh $i "/export/server/zookeeper-3.5.7/bin/zkServer.sh status"

echo ------------------------------------------------------

done

;;

*)

echo "Usage: $0 {start|stop|status}"

;;

esac

echo done !!! \\\(\^\o\^\)\/\~ \\\(\^\o\^\)\/\~ \\\(\^\o\^\)\/\~chmod 777 zk

1.5.5 IDEA幻景

保证 hadoop102、hadoop103、hadoop104 服务器上 Zookeeper 集群服务端启动。

Maven添加pom文件

org.apache.logging.log4j

log4j-core

2.8.2

org.apache.zookeeper

zookeeper

3.5.7

resources下创建log4j.properties

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n1.6 客户端命令

1.6.1 ls

bin/zkCli.sh -server hadoop1:2181

1.6.2 create

[zk: hadoop1:2181(CONNECTED) 2] create /yuanshen "keli"

Created /yuanshen

[zk: hadoop1:2181(CONNECTED) 3] create /yuanshen/daoqi "wanye"

Created /yuanshen/daoqi

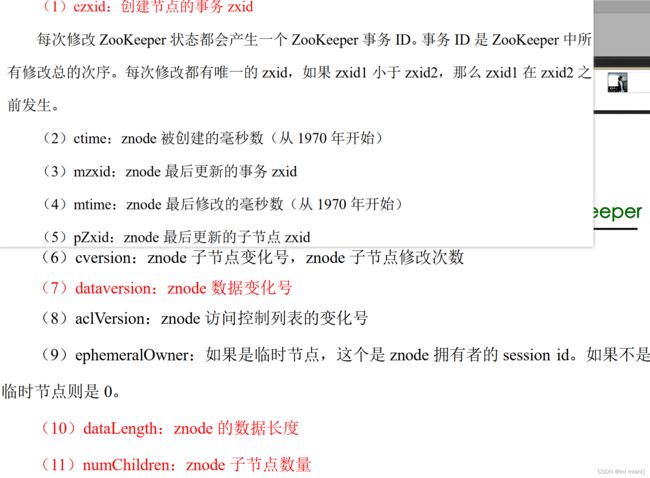

[zk: hadoop1:2181(CONNECTED) 4] get /yuanshen(每个节点的属性值?)

keli

[zk: hadoop1:2181(CONNECTED) 5] get -s /yuanshen

keli

cZxid = 0x900000004

ctime = Mon Oct 23 16:42:43 CST 2023

mZxid = 0x900000004

mtime = Mon Oct 23 16:42:43 CST 2023

pZxid = 0x900000005

cversion = 1

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 4

numChildren = 1[zk: hadoop1:2181(CONNECTED) 6] create -s /yuanshen/liyue "zhongli"

Created /yuanshen/liyue0000000001

带序号的可以重复名创建,没序号的不能创建重复(带序号的 -s,临时-e)[zk: hadoop1:2181(CONNECTED) 9] set /yuanshen/liyue0000000001 "shenhe"(改属性)

1.6.3 delete

[zk: hadoop1:2181(CONNECTED) 15] delete /yuanshen/liyue0000000001

[zk: hadoop1:2181(CONNECTED) 16] deleteall /yuanshen

[zk: hadoop1:2181(CONNECTED) 17] ls /

[kafka, zookeeper]

1.7 监听器原理

客户端注册监听它关心的目录节点,当目录节点发生变化(数据改变、节点删除、子目录节点增加删除)时,ZooKeeper 会通知客户端。监听机制保证 ZooKeeper 保存的任何的数据的任何改变都能快速的响应到监听了该节点的应用程序。

1)首先要有一个main()线程

2)在main线程中创建Zookeeper客户端,这时就会创建两个线程,一个负责网络连接通信(connet),一个负责监听(listener)。

3)通过connect线程将注册的监听事件发送给Zookeeper。

4)在Zookeeper的注册监听器列表中将注册的监听事件添加到列表中。

5)Zookeeper监听到有数据或路径变化,就会将这个消息发送给listener线程。

6)listener线程内部调用了process()方法。

例子:

都启动客户端,hadoop3上设置监听

get -w /yuanshen

hadoop2对属性进行改变,hadoop3显示

WATCHER::

WatchedEvent state:SyncConnected type:NodeDataChanged path:/yuanshen

注意:在hadoop103再多次修改/sanguo的值,hadoop104上不会再收到监听。因为注册一次,只能监听一次。想再次监听,需要再次注册。

1.7.1 实例代码

import org.apache.zookeeper.*;

import org.apache.zookeeper.data.Stat;

import org.junit.Before;

import sun.net.idn.Punycode;

import java.io.IOException;

import java.nio.charset.StandardCharsets;

import java.util.List;

import org.junit.Test;

public class zkClient {

private final String server = "hadoop1:2181,hadoop2:2181,hadoop3:2181";

private final int sessionTimeout = 5000;

private ZooKeeper zkClient;

@Before

public void init() throws IOException {

zkClient = new ZooKeeper(server, sessionTimeout, new Watcher() {

@Override

public void process(WatchedEvent watchedEvent) {

// 收到事件之后的逻辑

List children = null;

try {

children = zkClient.getChildren("/", true);

for (String child:children){

System.out.println(child);

}

} catch (Exception e) {

e.printStackTrace();

}

}

});

}

@Test

public void create() throws InterruptedException, KeeperException {

String s = zkClient.create("/yuanshen", "ye".getBytes(), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

}

@Test

public void getChildren() throws InterruptedException {

try {

List children = zkClient.getChildren("/", true);

for (String child: children){

System.out.println(child);

}

} catch (Exception e) {

e.printStackTrace();

}

Thread.sleep(100*1000);

}

// 判断 znode 是否存在

@Test

public void exist() throws Exception {

Stat stat = zkClient.exists("/atguigu", false);

System.out.println(stat == null ? "not exist" : "exist");

}

} 尚硅谷给ye讲迷了,这里每个监听语句都会在这里阻塞,true表示会循环监听,就这么一句话讲的弯弯绕绕的

2 案例

2.1 服务器动态上下线监听案例

某分布式系统中,主节点可以有多台,可以动态上下线,任意一台客户端都能实时感知到主节点服务器的上下线。

服务端

package org.example.zk;

import org.apache.zookeeper.*;

import java.io.IOException;

public class Servers {

String servers = "hadoop1:2181,hadoop2:2181,hadoop3:2181";

int SessionTimeout = 2000;

ZooKeeper zk = null;

String parentNode = "/server";

public void getConnect() throws IOException {

zk = new ZooKeeper(servers, SessionTimeout, new Watcher() {

@Override

public void process(WatchedEvent event) {

}

});

}

public void registServer(String hostname) throws InterruptedException, KeeperException {

String create = zk.create(parentNode+"/server", hostname.getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL_SEQUENTIAL);

System.out.println(hostname +" is online "+ create);

}

public void business(String hostname) throws Exception{

System.out.println(hostname + " is working ...");

Thread.sleep(Long.MAX_VALUE);

}

public static void main(String[] args) throws Exception {

// 1获取 zk连接

Servers server = new Servers();

server.getConnect();

// 2 利用 zk连接注册服务器信息

server.registServer(args[0]);

// 3 启动业务功能

server.business(args[0]);

}

}

客户端

package org.example.zk;

import org.apache.zookeeper.WatchedEvent;

import org.apache.zookeeper.Watcher;

import org.apache.zookeeper.ZooKeeper;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class Clients {

private static String connectString = "hadoop1:2181,hadoop2:2181,hadoop3:2181";

private static int sessionTimeout = 2000;

private ZooKeeper zk = null;

private String parentNode = "/servers";

// 创建到 zk的客户端连接

public void getConnect() throws IOException {

zk = new ZooKeeper(connectString, sessionTimeout, new Watcher() {

@Override

public void process(WatchedEvent event) {

// 再次启动监听

try {

getServerList();

} catch (Exception e) {

e.printStackTrace();

}

}

});

}

// 获取服务器列表信息

public void getServerList() throws Exception {

// 1获取服务器子节点信息,并且对父节点进行监听

List children = zk.getChildren(parentNode, true);

// 2存储服务器信息列表

ArrayList servers = new ArrayList<>();

// 3遍历所有节点,获取节点中的主机名称信息

for (String child : children) {

byte[] data = zk.getData(parentNode + "/" + child, false, null);

servers.add(new String(data));

}

// 4打印服务器列表信息

System.out.println(servers);

}

// 业务功能

public void business() throws Exception{

System.out.println("client is working ...");

Thread.sleep(Long.MAX_VALUE);

}

public static void main(String[] args) throws Exception {

// 1获取 zk连接

Clients client = new Clients();

client.getConnect();

// 2获取 servers的子节点信息,从中获取服务器信息列表

client.getServerList();

// 3业务进程启动

client.business();

}

}

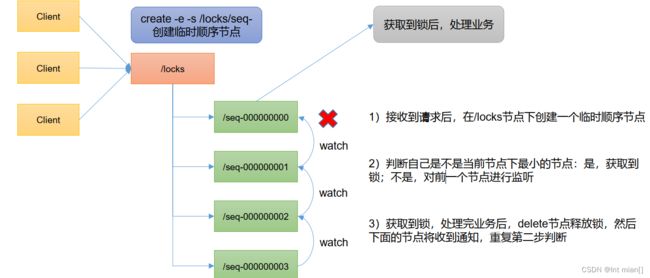

2.2 分布式锁

"进程 1"在使用该资源的时候,会先去获得锁,"进程 1"获得锁以后会对该资源保持独占,这样其他进程就无法访问该资源,"进程 1"用完该资源以后就将锁释放掉,让其他进程来获得锁,那么通过这个锁机制,我们就能保证了分布式系统中多个进程能够有序的访问该临界资源。那么我们把这个分布式环境下的这个锁叫作分布式锁。

package org.example.zk;

import org.apache.zookeeper.*;

import org.apache.zookeeper.data.Stat;

import java.io.IOException;

import java.util.Collections;

import java.util.List;

import java.util.concurrent.CountDownLatch;

public class Lock {

// zookeeper server 列表

private String connectString = "hadoop1:2181,hadoop2:2181,hadoop3:2181";

// 超时时间

private int sessionTimeout = 2000;

private ZooKeeper zk;

private String rootNode = "locks";

private String subNode = "seq-";

// 当前 client等待的子节点

private String waitPath;

//ZooKeeper连接

private CountDownLatch connectLatch = new CountDownLatch(1);

//ZooKeeper节点等待

private CountDownLatch waitLatch = new CountDownLatch(1);

// 当前 client创建的子节点

private String currentNode;

// 和 zk 服务建立连接,并创建根节点

public Lock() throws IOException,

InterruptedException, KeeperException {

zk = new ZooKeeper(connectString, sessionTimeout, new Watcher() {

@Override

public void process(WatchedEvent event) {

// 连接建立时, 打开 latch, 唤醒 wait在该 latch 上的线程

if (event.getState() == Event.KeeperState.SyncConnected){

connectLatch.countDown();

}

// 发生了 waitPath的删除事件

if (event.getType() == Event.EventType.NodeDeleted && event.getPath().equals(waitPath)){

waitLatch.countDown();

}

}

});

// 等待连接建立

connectLatch.await();

//获取根节点状态

Stat stat = zk.exists("/" + rootNode, false);

//如果根节点不存在,则创建根节点,根节点类型为永久节点

if (stat == null) {

System.out.println("根节点不存在");

zk.create("/" + rootNode, new byte[0],

ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

}

}

// 加锁方法

public void zkLock() {

try {

//在根节点下创建临时顺序节点,返回值为创建的节点路径

currentNode = zk.create("/" + rootNode + "/" + subNode,

null, ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL);

// wait一小会, 让结果更清晰一些

Thread.sleep(10);

// 注意, 没有必要监听"/locks"的子节点的变化情况

List childrenNodes = zk.getChildren("/" +

rootNode, false);

// 列表中只有一个子节点, 那肯定就是 currentNode , 说明client获得锁

if (childrenNodes.size() == 1) {

return;

} else {

//对根节点下的所有临时顺序节点进行从小到大排序

Collections.sort(childrenNodes);

//当前节点名称

String thisNode = currentNode.substring(("/" +

rootNode + "/").length());

//获取当前节点的位置

int index = childrenNodes.indexOf(thisNode);

if (index == -1) {

System.out.println("数据异常");

} else if (index == 0) {

// index == 0, 说明 thisNode 在列表中最小, 当前client获得锁

return;

} else {

// 获得排名比 currentNode 前 1位的节点

this.waitPath = "/" + rootNode + "/" +

childrenNodes.get(index - 1);

// 在 waitPath 上注册监听器, 当 waitPath 被删除时,zookeeper 会回调监听器的 process方法

zk.getData(waitPath, true, new Stat());

//进入等待锁状态

waitLatch.await();

return;

}

}

} catch (Exception e) {

e.printStackTrace();

}

}

// 解锁方法

public void zkUnlock() {

try {

zk.delete(this.currentNode, -1);

} catch (InterruptedException | KeeperException e) {

e.printStackTrace();

}

}

}

package org.example.zk;

import org.apache.zookeeper.KeeperException;

import java.io.IOException;

public class LockTest {

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

// 创建分布式锁 1

final Lock lock1 = new Lock();

// 创建分布式锁 2

final Lock lock2 = new Lock();

new Thread(new Runnable() {

@Override

public void run() {

// 获取锁对象

try {

lock1.zkLock();

System.out.println("线程 1 获取锁");

Thread.sleep(5 * 1000);

lock1.zkUnlock();

System.out.println("线程 1 释放锁");

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

new Thread(new Runnable() {

@Override

public void run() {

// 获取锁对象

try {

lock2.zkLock();

System.out.println("线程 2 获取锁");

Thread.sleep(5 * 1000);

lock2.zkUnlock();

System.out.println("线程 2 释放锁");

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

}

}

2.3 Curator 框架实现分布式锁

package org.example.zk;

import org.apache.curator.RetryPolicy;

import org.apache.curator.framework.CuratorFramework;

import org.apache.curator.framework.CuratorFrameworkFactory;

import org.apache.curator.framework.recipes.locks.InterProcessLock;

import org.apache.curator.framework.recipes.locks.InterProcessMutex;

import org.apache.curator.retry.ExponentialBackoffRetry;

public class Curator {

private String rootNode = "/locks";

// zookeeper server 列表

private String connectString =

"hadoop102:2181,hadoop103:2181,hadoop104:2181";

// connection超时时间

private int connectionTimeout = 2000;

// session 超时时间

private int sessionTimeout = 2000;

public static void main(String[] args) {

new Curator().test();

}

// 测试

private void test() {

// 创建分布式锁 1

final InterProcessLock lock1 = new InterProcessMutex(getCuratorFramework(), rootNode);

// 创建分布式锁 2

final InterProcessLock lock2 = new InterProcessMutex(getCuratorFramework(), rootNode);

new Thread(new Runnable() {

@Override

public void run() {

// 获取锁对象

try {

lock1.acquire();

System.out.println("线程 1 获取锁");

// 测试锁重入

lock1.acquire();

System.out.println("线程 1 再次获取锁");

Thread.sleep(5 * 1000);

lock1.release();

System.out.println("线程 1 释放锁");

lock1.release();

System.out.println("线程 1 再次释放锁");

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

new Thread(new Runnable() {

@Override

public void run () {

// 获取锁对象

try {

lock2.acquire();

System.out.println("线程 2 获取锁");

// 测试锁重入

lock2.acquire();

System.out.println("线程 2 再次获取锁");

Thread.sleep(5 * 1000);

lock2.release();

System.out.println("线程 2 释放锁");

lock2.release();

System.out.println("线程 2 再次释放锁");

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

}

// 分布式锁初始化

public CuratorFramework getCuratorFramework (){

//重试策略,初试时间 3秒,重试 3 次

RetryPolicy policy = new ExponentialBackoffRetry(3000, 3);

//通过工厂创建 Curator

CuratorFramework client = CuratorFrameworkFactory.builder()

.connectString(connectString)

.connectionTimeoutMs(connectionTimeout)

.sessionTimeoutMs(sessionTimeout)

.retryPolicy(policy).build();

//开启连接

client.start();

System.out.println("zookeeper 初始化完成...");

return client;

}

}

3 面试内容

3.1 选举机制

半数机制,超过半数的投票通过,即通过。

(1)第一次启动选举规则:

投票过半数时,服务器 id 大的胜出

(2)第二次启动选举规则:

①EPOCH 大的直接胜出

②EPOCH 相同,事务 id 大的胜出

③事务 id 相同,服务器 id 大的胜出

3.2 生产集群安装多少 zk 合适?

安装奇数台。

生产经验:

⚫ 10 台服务器:3 台 zk;

⚫ 20 台服务器:5 台 zk;

⚫ 100 台服务器:11 台 zk;

⚫ 200 台服务器:11 台 zk