LLMs之Agent之AutoGen:AutoGen的简介、安装、使用方法之详细攻略

LLMs之Agent之AutoGen:AutoGen的简介、安装、使用方法之详细攻略

目录

AutoGen的简介、安装、使用方法

1、多Agent对话框架

2、AutoGen的对话流程

3、增强的LLM推理

AutoGen的安装

1、安装

2、快速测试

AutoGen的使用方法

1、基础用法

(1)、启动两个代理之间的自动聊天来解决任务

AutoGen的简介、安装、使用方法

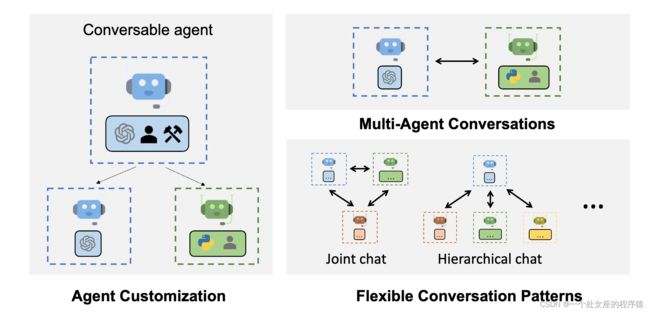

2023年9月30日左右,微软正式开源AutoGen,这是一个框架,允许开发具有多个Agent的LLM应用程序,这些Agent可以相互交流以解决任务。AutoGen的Agent是可定制的、可对话的,并可以无缝地允许人类参与。它们可以在使用LLM、人类输入和工具的各种模式下运行。

>> AutoGen使基于多Agent对话构建下一代LLM应用程序变得更加轻松。它简化了复杂LLM工作流程的协调、自动化和优化。它最大程度地提高了LLM模型的性能并克服了它们的弱点。

>> 它支持复杂工作流的多种对话模式。开发人员可以使用可定制和可对话的Agent来构建涵盖对话自治、Agent数量和Agent对话拓扑的各种对话模式。

>> 它提供了一系列具有不同复杂性的工作系统。这些系统涵盖了各种领域和复杂度的应用程序。这展示了AutoGen如何轻松支持多样化的对话模式。

>> AutoGen提供了增强的LLM推理。它提供了简单的性能调整,以及API统一和缓存等实用工具,以及高级用法模式,如错误处理、多配置推理、上下文编程等。

AutoGen由Microsoft、宾夕法尼亚州立大学和华盛顿大学的合作研究支持。

相关文档:AutoGen | AutoGen

GitHub地址:GitHub - microsoft/autogen: Enable Next-Gen Large Language Model Applications. Join our Discord: https://discord.gg/pAbnFJrkgZ

1、多Agent对话框架

AutoGen通过通用多Agent对话框架实现了下一代LLM应用程序。它提供了可定制和可对话的Agent,集成了LLM、工具和人类。通过自动化多个有能力的Agent之间的聊天,人们可以轻松地使它们共同执行任务,无需人类反馈,包括需要使用代码的工具的任务。这种用例的特点包括:

>> 多Agent对话:AutoGenAgent可以相互交流以解决任务。这使得可以开发比单个LLM更复杂和复杂的应用程序成为可能。

>> 定制:AutoGenAgent可以定制以满足应用程序的特定需求。这包括选择要使用的LLM、允许的人类输入类型和要使用的工具。

>> 人类参与:AutoGen可以无缝地允许人类参与。这意味着人类可以根据需要提供输入和反馈给Agent。

2、AutoGen的对话流程

3、增强的LLM推理

AutoGen还有助于最大程度地利用诸如ChatGPT和GPT-4之类昂贵LLM的效用。它提供了增强的LLM推理,具有调整、缓存、错误处理和模板等强大功能。例如,您可以通过自己的调整数据、成功指标和预算来优化LLM生成。

# perform tuning

config, analysis = autogen.Completion.tune(

data=tune_data,

metric="success",

mode="max",

eval_func=eval_func,

inference_budget=0.05,

optimization_budget=3,

num_samples=-1,

)

# perform inference for a test instance

response = autogen.Completion.create(context=test_instance, **config)请在此功能的更多代码示例中查找更多信息。

地址:AutoGen - Automated Multi Agent Chat | AutoGen

AutoGen的安装

1、安装

AutoGen要求Python版本>= 3.8。可以使用pip安装:

pip install pyautogen安装时只安装了最小的依赖项,没有额外选项。您可以根据您的需求安装额外的选项。

在代码执行方面,强烈建议安装python docker包,并使用docker。

有关LLM推理配置,请查看常见问题解答。

地址:Frequently Asked Questions | AutoGen

2、快速测试

第一步,点击下面的链接使用Github Codespace,在GitHub Codespaces中打开

地址:https://codespaces.new/microsoft/autogen?quickstart=1

第二步,将OAI_CONFIG_LIST_sample复制到/notebook文件夹,命名为OAI_CONFIG_LIST,并设置正确的配置。

第三步,开始使用笔记本!

AutoGen的使用方法

1、基础用法

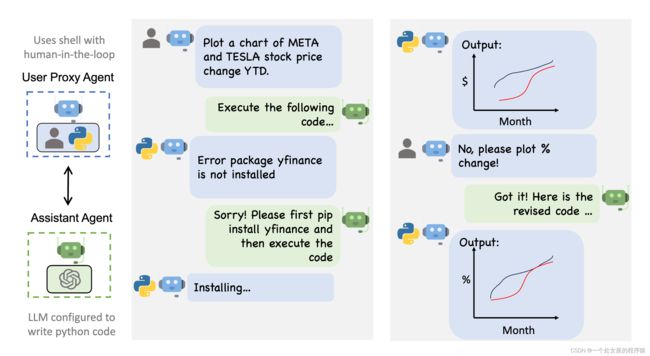

(1)、启动两个代理之间的自动聊天来解决任务

from autogen import AssistantAgent, UserProxyAgent, config_list_from_json

# Load LLM inference endpoints from an env variable or a file

# See https://microsoft.github.io/autogen/docs/FAQ#set-your-api-endpoints

# and OAI_CONFIG_LIST_sample

config_list = config_list_from_json(env_or_file="OAI_CONFIG_LIST")

# You can also set config_list directly as a list, for example, config_list = [{'model': 'gpt-4', 'api_key': ''},]

assistant = AssistantAgent("assistant", llm_config={"config_list": config_list})

user_proxy = UserProxyAgent("user_proxy", code_execution_config={"work_dir": "coding"})

user_proxy.initiate_chat(assistant, message="Plot a chart of NVDA and TESLA stock price change YTD.")

# This initiates an automated chat between the two agents to solve the task

python test/twoagent.py